適用於: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

秘訣

在 Microsoft Fabric 中試用 Data Factory,這是適用於企業的全方位分析解決方案。 Microsoft Fabric 涵蓋從數據移動到數據科學、即時分析、商業智慧和報告等所有專案。 瞭解如何 免費啟動新的試用版 !

在這個教學課程中,您會使用 Azure 入口網站來建立資料處理站。 然後,您可以使用資料複製工具來建立管線,根據從 Azure Blob 儲存體到 Azure Blob 儲存體的時間分割檔案名稱,以累加方式複製新檔案。

附註

如果您不熟悉 Azure Data Factory,請參閱 Azure Data Factory 簡介。

在本教學課程中,您會執行下列步驟:

- 建立資料處理站。

- 使用複製資料工具建立管線。

- 監視管線和活動執行。

先決條件

- Azure 訂用帳戶:如果您沒有 Azure 訂用帳戶,請在開始之前建立 免費帳戶 。

- Azure 儲存體帳戶:使用 Blob 儲存體作為來源與接收資料存放區。 如果您沒有 Azure 記憶體帳戶,請參閱 建立記憶體帳戶中的指示。

在 Blob 儲存體中建立兩個容器

請執行下列步驟,為本教學課程準備 Blob 儲存體。

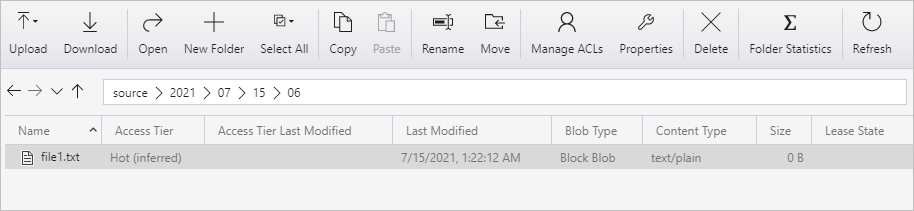

建立名為 source的容器。 在容器中建立資料夾路徑為 2021/07/15/06 。 建立空的文字檔,並將它命名為 file1.txt。 將 file1.txt 上傳至記憶體帳戶中資料夾路徑 來源/2021/07/15/06 。 您可以使用各種工具來執行這些工作,例如 Azure 記憶體總管。

附註

請使用您的 UTC 時間調整資料夾名稱。 例如,如果目前的 UTC 時間是 2021 年 7 月 15 日上午 6:10,您可以依據來源/{Year}/{Month}/{Day}/{Hour}/{Hour}/{Hour}, 的規則,建立資料夾路徑作為 source/2021/07/06/ 。

建立名為 destination 的容器。 您可以使用各種工具來執行這些工作,例如 Azure 記憶體總管。

建立 Data Factory

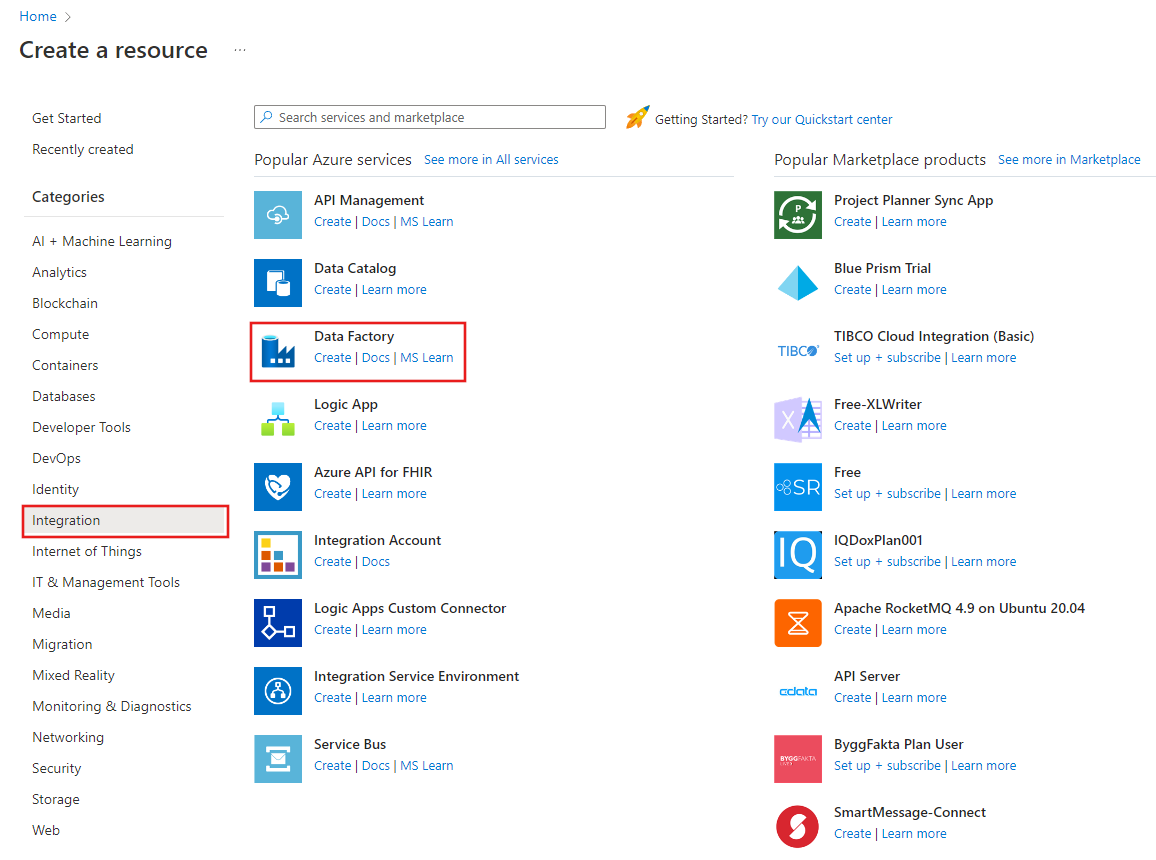

在頂端功能表上,選取 [建立資源>分析>Data Factory ] :

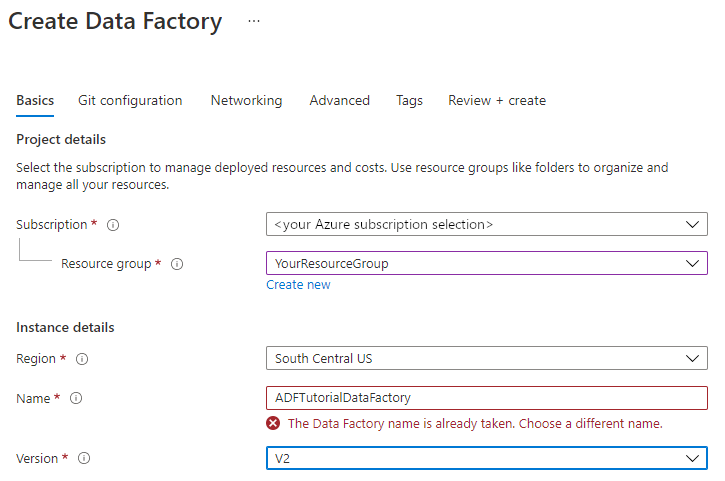

在 [ 新增數據處理站] 頁面上的 [ 名稱] 底下,輸入 ADFTutorialDataFactory。

資料處理站的名稱必須是「全域唯一」的名稱。 您可能會收到下列錯誤訊息:

如果您收到有關名稱值的錯誤訊息,請輸入不同的資料處理站名稱。 例如,使用 您的名稱ADFTutorialDataFactory。 如需 Data Factory 成品的命名規則,請參閱 Data Factory 命名規則。

選取要在其中建立新資料工廠的 Azure 訂用帳戶。

針對 [資源群組],採取下列其中一個步驟︰

一。 選取 [使用現有的] ,然後從下拉式清單選取現有的資源群組。

b。 選取 [建立新的] ,然後輸入資源群組的名稱。

若要瞭解資源群組,請參閱 使用資源群組來管理您的 Azure 資源。

在 [版本] 下,選取 [V2] 作為版本。

在 [位置] 下,選取資料處理站的位置。 只有受到支援的位置會顯示在下拉式清單中。 資料處理站所使用的資料存放區 (例如 Azure 儲存體和 SQL Database) 和計算 (例如 Azure HDInsight) 可位於其他地區和區域。

選取 [建立]。

建立完成之後, 就會顯示Data Factory 首頁。

若要在個別索引標籤中啟動 Azure Data Factory 使用者介面 (UI),請在 [開啟Azure Data Factory Studio] 圖格上選取 [開啟]。

![Azure Data Factory 的首頁,具有 [開啟 Azure Data Factory Studio] 圖格。](../reusable-content/ce-skilling/azure/media/data-factory/data-factory-home-page.png)

使用複製資料工具建立管線

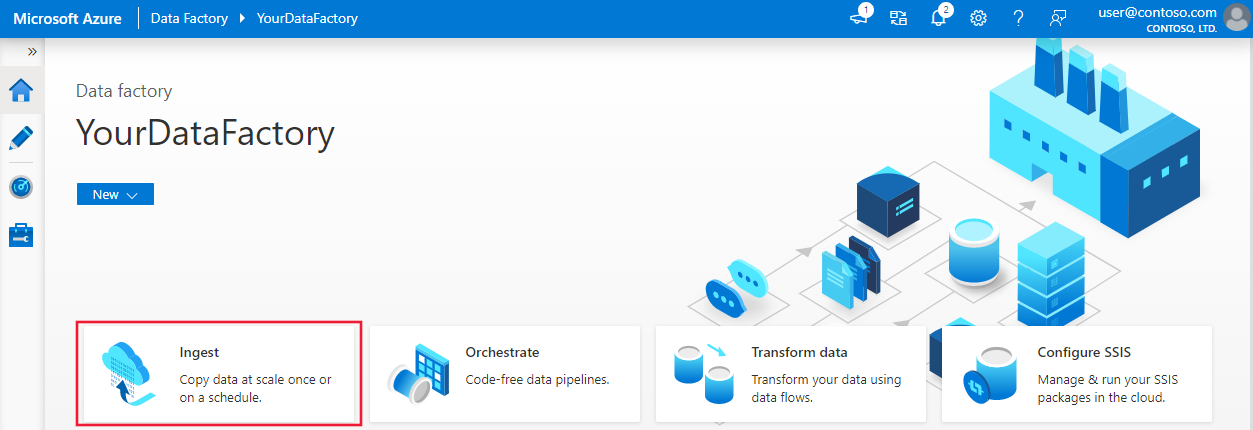

在 Azure Data Factory 首頁上,選取 [擷取] 標題以啟動資料複製工具。

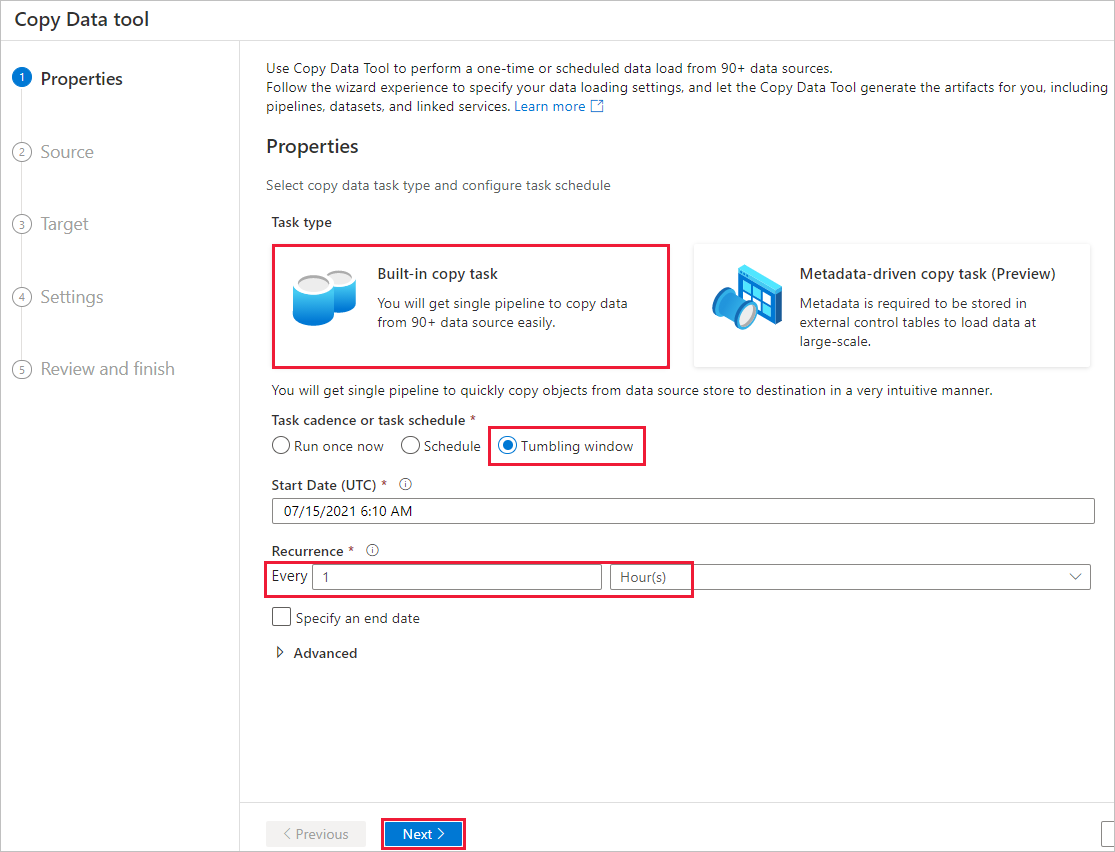

在 [屬性] 頁面上,採取下列步驟:

在 [工作類型] 下方,選擇 [內建複製工作]。

在 [工作步調或工作排程] 下方,選取 [輪轉視窗]。

在 [定期] 下方,輸入 [1 小時]。

選取 [下一步] 。

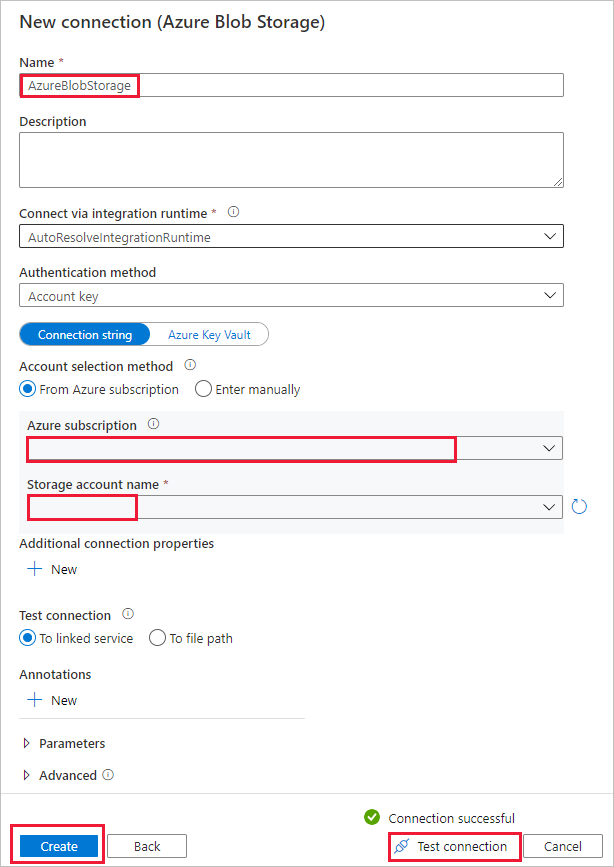

在 [來源資料存放區] 頁面上,完成下列步驟:

一。 選取 [+ 新增連線] 以新增連線。

b。 從資源庫選取 [Azure Blob 儲存體],然後選取 [繼續]。

c. 在 [新增連線 (Azure Blob 儲存體)] 頁面上,輸入連線的名稱。 選取您的 Azure 訂用帳戶,然後從 [儲存體帳戶名稱] 清單中選取您的儲存體帳戶。 測試 [連線],然後選取 [建立]。

d. 在 [來源資料存放區] 頁面上,選取 [連線] 區段中新建立的連線。

e. 在 [檔案或資料夾] 區段中,瀏覽並選取 [來源] 容器,然後選取 [確定]。

f。 在 [檔案載入行為] 下方,選取 [累加載入:時間分割的資料夾/檔案名稱]。

g. 將動態資料夾路徑寫入 為 source/{year}/{month}/{day}/{hour}/,並變更格式,如下列螢幕快照所示。

h. 勾選 [二進位副本],然後選取 [下一步]。

![顯示 [源數據存放區] 頁面設定的螢幕快照。](media/tutorial-incremental-copy-partitioned-file-name-copy-data-tool/source-data-store-page.png)

在 [目的地資料存放區] 頁面上,完成下列步驟:

選取與資料來源存放區相同儲存體帳戶的 [AzureBlobStorage]。

瀏覽並選取 [目的地] 資料夾,然後選取 [確定]。

將動態資料夾路徑寫入 目的地/{year}/{month}/{day}/{hour}/,並變更格式,如下列螢幕快照所示。

選取 [下一步] 。

![顯示 [目的地資料存放區] 頁面設定的螢幕快照。](media/tutorial-incremental-copy-partitioned-file-name-copy-data-tool/destination-data-store.png)

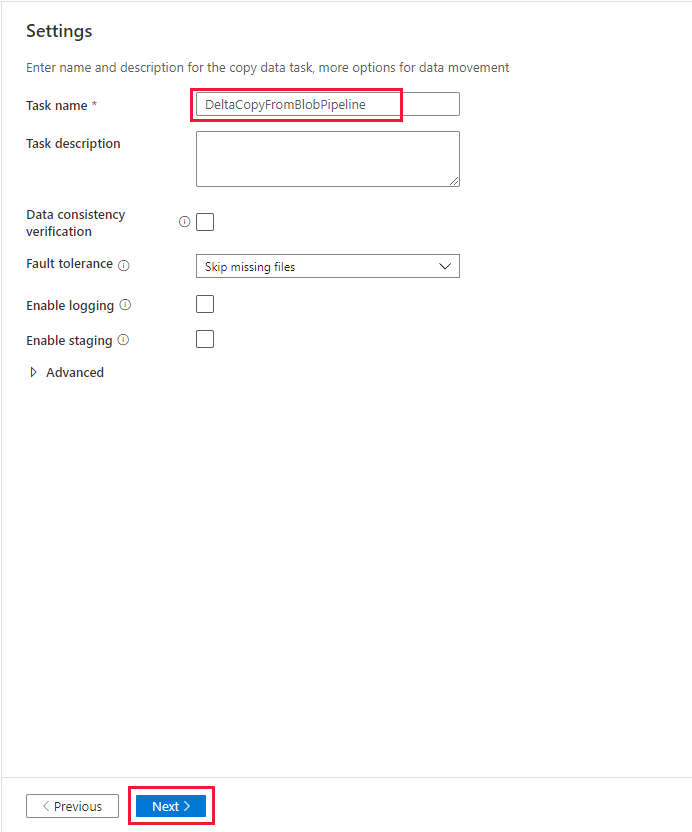

在 [ 設定 ] 頁面上的 [ 工作名稱] 下,輸入 DeltaCopyFromBlobPipeline,然後選取 [ 下一步]。 Data Factory 使用者介面會使用指定的工作名稱建立管線。

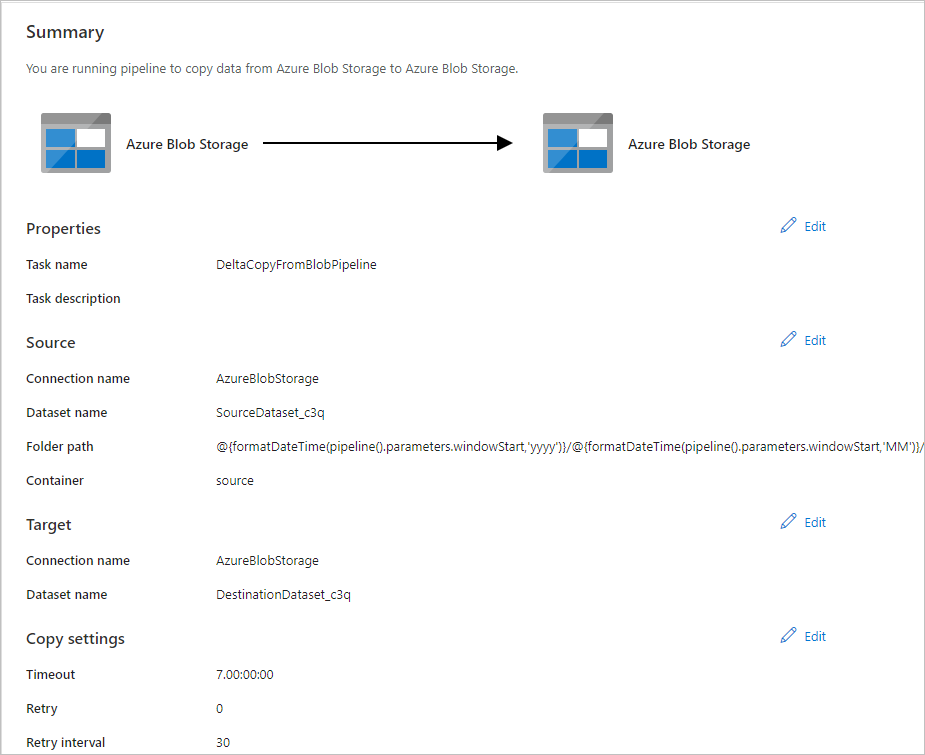

在 [摘要] 頁面上檢閱設定,然後選取 [下一步]。

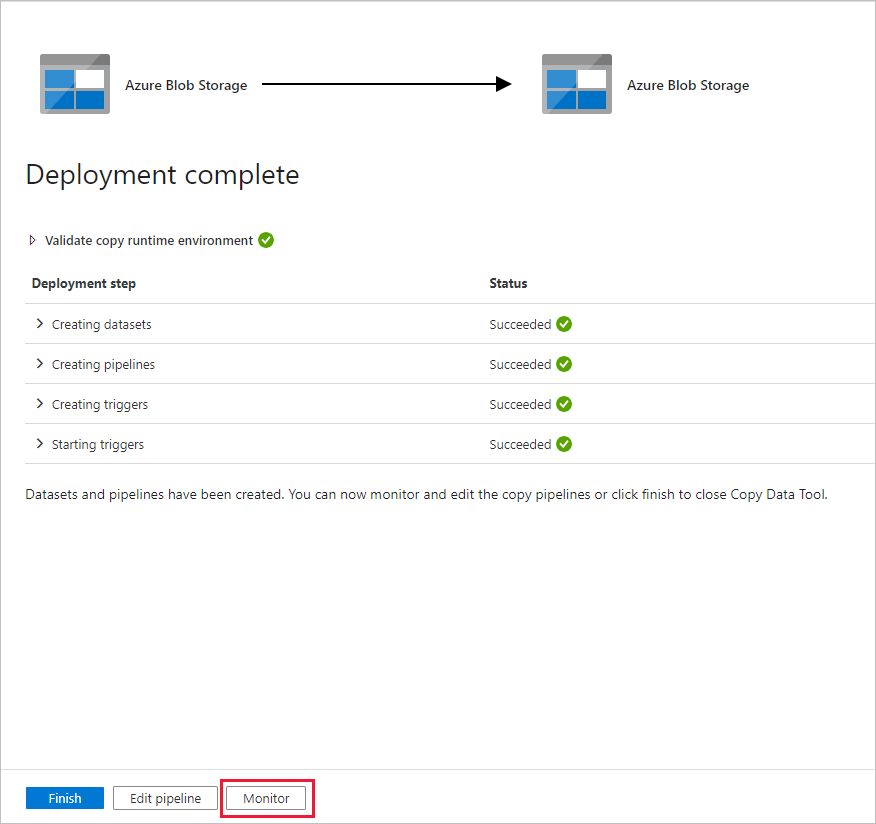

在 [ 部署] 頁面上,選取 [ 監視 ] 以監視管線 (工作)。

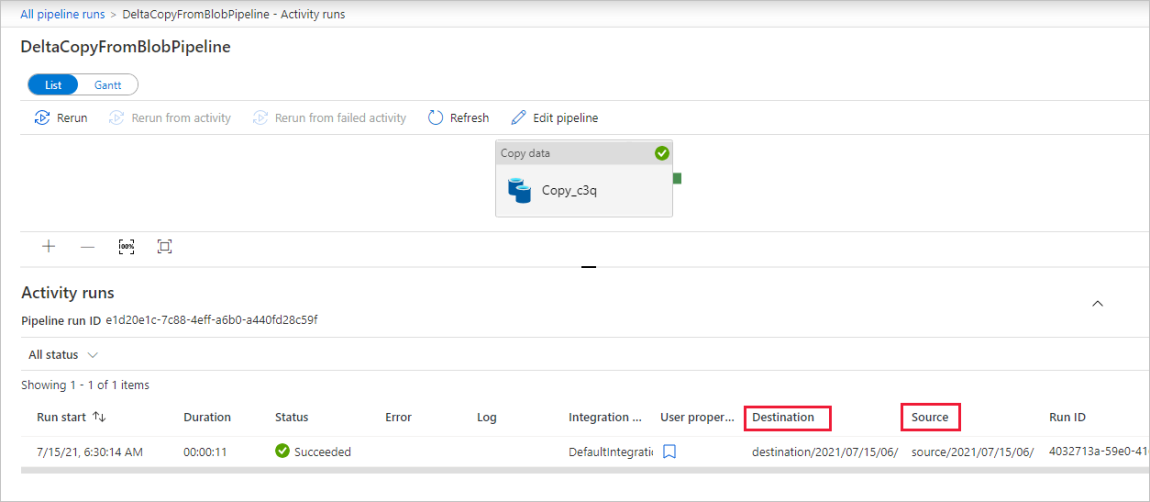

請注意,系統會自動選取左側的 [監視] 索引標籤。 當管線觸發時,您需要等待管線執行 (大約一小時後)。 執行時,選取管線名稱連結 DeltaCopyFromBlobPipeline 以檢視活動執行詳細數據或重新執行管線。 選取 [重新整理] 可重新整理清單。

![顯示 [管線執行] 窗格的螢幕擷取畫面。](media/tutorial-incremental-copy-partitioned-file-name-copy-data-tool/monitor-pipeline-runs-1.png)

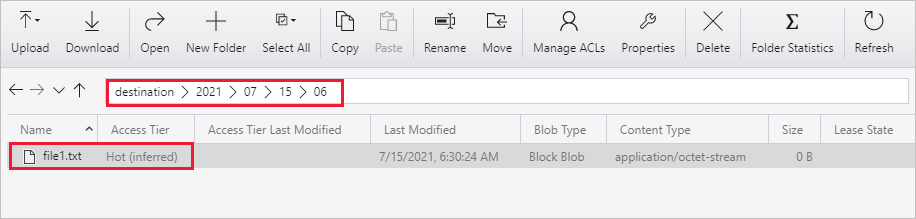

管線中只有一個活動 (複製活動),所以您只會看到一個項目。 調整 來源 和 目的地 數據行的數據行寬度(如有必要),以顯示更多詳細數據,您可以看到來源檔案 (file1.txt) 已從 source/2021/07/15/06/ 複製到 目的地/2021/07/15/06/ 具有相同檔名。

您也可以使用 Azure 儲存體總管 (https://storageexplorer.com/) 來掃描檔案,以確認檔案名稱相同。

建立另一個空白文字檔,使用新名稱為file2.txt。 將 file2.txt 檔案上傳至記憶體帳戶中的資料夾路徑 來源/2021/07/07/15/07 。 您可以使用各種工具來執行這些工作,例如 Azure 記憶體總管。

附註

您可能會注意到需要建立新的資料夾路徑。 請使用您的 UTC 時間調整資料夾名稱。 例如,如果目前的 UTC 時間為 2021 年 7 月 15 日上午 7:30, 2021 年 15 日,您可以依據 {Year}/{Month}/{Day}/{Hour}//07/ 的規則,將資料夾路徑建立為 source/2021/07/07/ 。

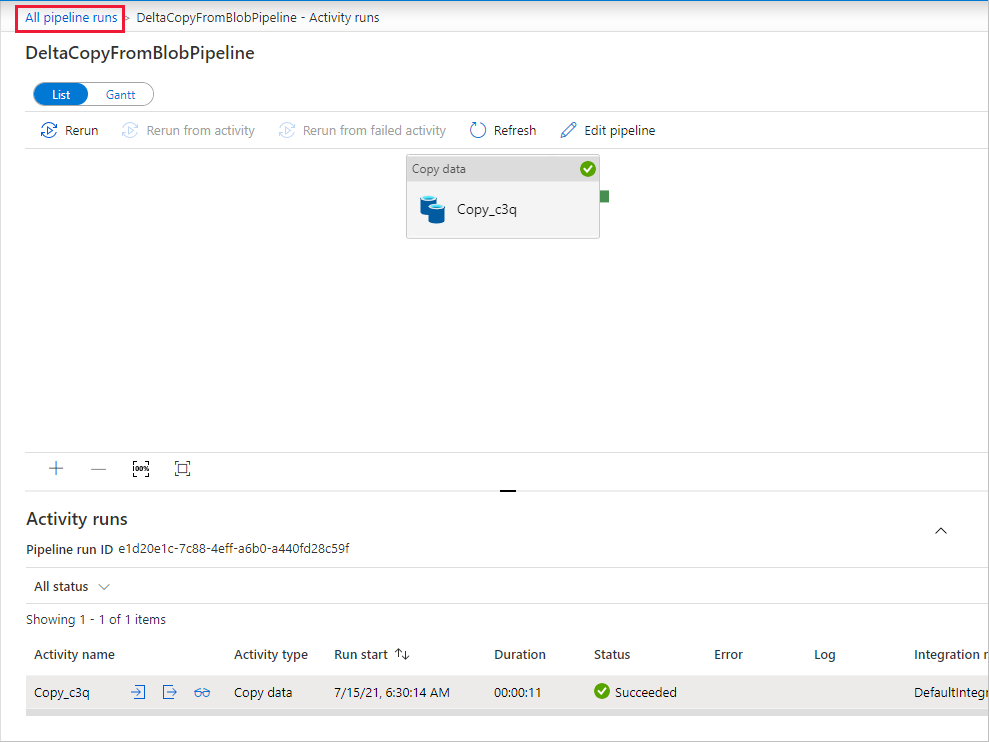

若要回到 [管線執行] 檢視,請選取 [所有管線執行],然後等待一小時後自動觸發相同的管線。

針對第二個管線執行選取新的 DeltaCopyFromBlobPipeline 連結,然後執行相同的動作以檢閱詳細資料。 您會看到來源檔案 (file2.txt) 已從 source/2021/07/15/07/ 複製到 destination/2021/07/15/07/,並保持相同的檔名。 您也可以使用 Azure 儲存體總管 (https://storageexplorer.com/) 來掃描 [目的地] 容器中的檔案,以確認檔案名稱相同。

相關內容

進入下列教學課程,以了解如何在 Azure 上使用 Spark 叢集來轉換資料: