Fabric 數據工程 Visual Studio (VS) Code 延伸模組完全支援 Fabric 中的建立、讀取、更新和刪除 #CRUD Spark 作業定義作業。 建立 Spark 工作定義之後,您可以上傳更多參考的程式庫、提交執行 Spark 工作定義的請求,以及檢查執行歷程記錄。

建立 Spark 工作定義

若要建立 Spark 工作定義:

在 VS Code 總管中,選取 [建立 Spark 作業定義] 選項。

輸入初始必要欄位:名稱、參考的 Lakehouse 和預設 Lakehouse。

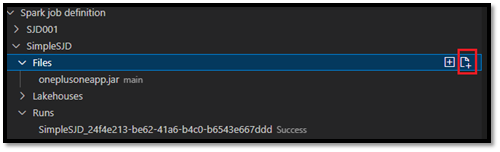

請求程序和新建立的 Spark 工作定義的名稱顯示在 VS Code 總管中的 [Spark 工作定義] 根節點下。 在 Spark 工作定義名稱節點下,有三個子節點:

- 檔案:主要定義文檔和其他參考的程式庫的清單。 您可以從此清單上傳新檔案。

-

Lakehouse:此 Spark 工作定義所參考的所有 Lakehouse 清單。 該清單中標示了預設 Lakehouse,您可以透過相對路徑

Files/…, Tables/…加以存取。 - 執行:此 Spark 工作定義的執行歷程記錄及每個執行的工作狀態的清單。

將主要定義檔案上傳至參考的程式庫

若要上傳或覆寫主要定義檔案,請選取 [新增主要檔案] 選項。

若要上傳主要定義檔案所參考的程式庫檔案,請選取 [新增程式庫檔案] 選項。

上傳檔案之後,可以按下 [更新檔案] 選項並上傳新的檔案來覆寫該檔案,也可以透過 [刪除] 選項來刪除該檔案。

提交執行要求

若要提交從 VS Code 執行 Spark 工作定義的要求:

在要執行的 Spark 工作定義名稱右邊的選項中選取 [執行 Spark 工作] 選項。

提交要求之後,總管清單中的 [執行] 節點中會顯示新的 Apache Spark 應用程式。 可以選取 [取消 Spark 工作] 選項來取消執行工作。

在 Fabric 入口網站中開啟 Spark 工作定義

您可以選取 [在瀏覽器中開啟] 選項,在 Fabric 入口網站中開啟 Spark 工作定義製作頁面。

也可以選取已完成執行旁的 [在瀏覽器中開啟],來查看該執行的詳細監視器頁面。

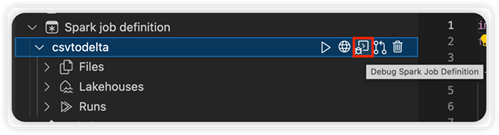

偵錯 Spark 工作定義原始程式碼 (Python)

如果 Spark 工作定義是使用 PySpark (Python) 建立的,您可以下載主要定義檔案和參考檔案的.py 指令碼,並在 VS Code 中偵錯來源指令碼。

若要下載原始程式碼,請選取 Spark 工作定義右邊的 [偵錯 Spark 工作定義] 選項。

下載完成之後,原始程式碼的資料夾會自動開啟。

當出現提示時,選取 [信任作者]。 (此選項只會在您第一次開啟資料夾時出現。如果您未選取此選項,則無法偵錯或執行來源指令碼。若要了解詳細資訊,請參閱<Visual Studio Code 工作區信任安全性>)。

如果您之前已下載了原始程式碼,則系統會提示您確認是否要以新下載的原始程式碼覆寫本機版本。

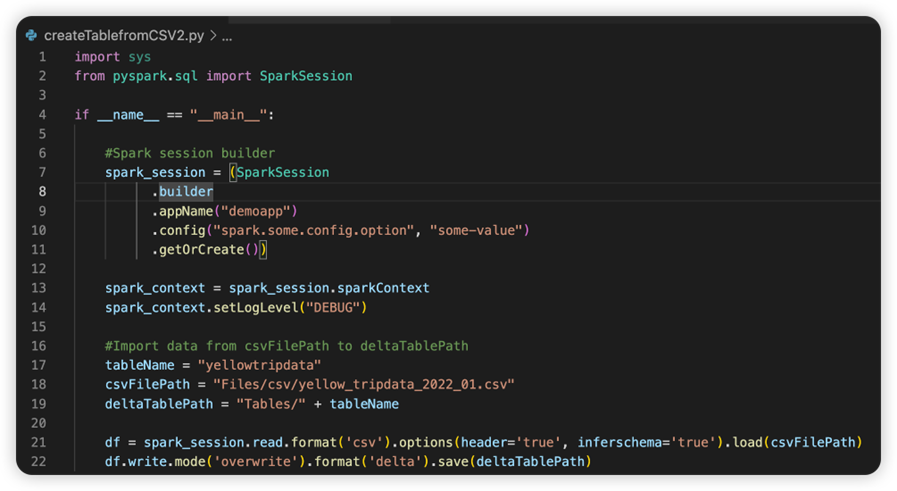

注意

在來源指令碼的根資料夾中,系統會建立名為 conf 的子資料夾。 在此資料夾中,名為 lighter-config.json 的檔案中包含遠端執行所需的一些系統中繼資料。 請勿對其進行任何變更。

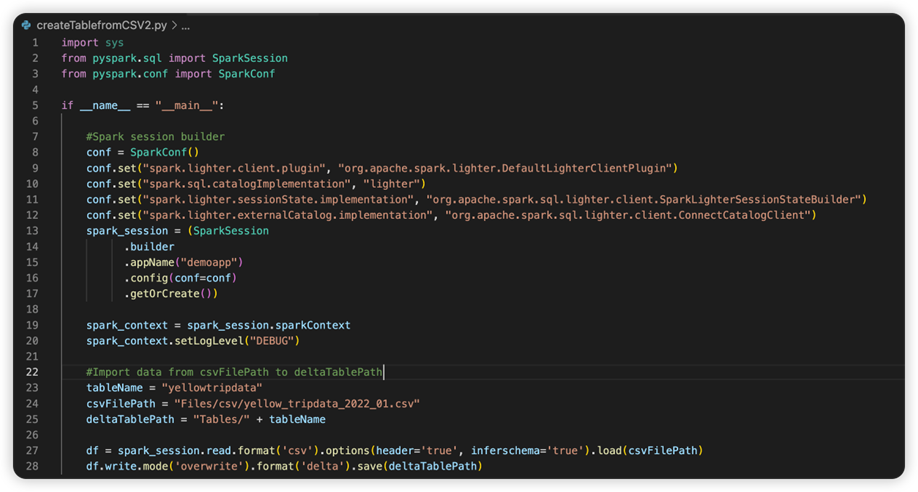

名為 sparkconf.py 的檔案中包含您需要新增以設定 SparkConf 物件的程式碼片段。 若要啟用遠端偵錯,請確定 SparkConf 物件已正確設定。 下圖顯示了原始程式碼的原始版本。

下圖為拷貝並貼上程式碼片段之後更新的原始程式碼。

使用必要的組態更新原始程式碼之後,必須挑選正確的 Python 解釋器。 請務必從 synapse-spark-kernel conda 環境中選取已安裝的解釋器。

編輯 Spark 工作定義屬性

您可以編輯 Spark 工作定義的詳細屬性,例如命令列引數。

選取 [更新 SJD 組態] 選項以開啟 settings.yml 檔案。 現有的屬性會填入此檔案的內容。

更新並儲存 .yml 檔案。

選取右上角的 [發佈 SJD 屬性] 選項,以將變更同步回遠端工作區。

![VS Code 總管的螢幕擷取畫面,顯示選取 [建立 Spark 作業定義] 選項的位置。](media/vscode/create-sjd.png)

![VS Code 總管的螢幕擷取畫面,顯示選取 [新增主要檔案] 選項的位置。](media/vscode/upload-main-def.png)

![VS Code 總管的螢幕擷取畫面,顯示在哪裡可以找到 [更新檔案] 和 [刪除] 選項。](media/vscode/update-file.png)

![VS Code 總管的螢幕擷取畫面,顯示選取 [執行 Spark 作業] 的位置。](media/vscode/submit-sjd-run.png)

![VS Code 瀏覽器的螢幕擷取畫面,其中包含列在 [執行] 節點下的新 Spark 應用程式,並顯示 [取消 Spark 應用程式] 選項所在位置。](media/vscode/cancel-sjd-run.png)

![VS Code Explorer 的螢幕擷取畫面,顯示選取 [在瀏覽器中開啟] 選項的位置。](media/vscode/open-sjd-in-browser.png)

![螢幕擷取畫面顯示選取 Spark 作業定義的 [更新 SJD 設定] 選項的位置。](media/vscode/edit-sjd-property.png)

![螢幕擷取畫面顯示選取 Spark 作業定義的 [發佈 SJD 屬性] 選項的位置。](media/vscode/push-sjd-property.png)