備註

Fabric Runtime 2.0 目前正處於實驗預覽階段。 更多資訊請參閱 限制與備註。

Fabric Runtime 與 Microsoft Fabric 生態系統進行無縫整合,為由 Apache Spark 驅動的資料工程與資料科學專案提供穩健環境。

本文介紹 Fabric Runtime 2.0 實驗版(預覽版),這是為 Microsoft Fabric 大數據運算設計的最新執行環境。 它突顯了使本次版本成為可擴展分析與先進工作負載重要進展的關鍵功能與元件。

Fabric Runtime 2.0 包含以下元件與升級,旨在提升您的資料處理能力:

- Apache Spark 4.0

- 作業系統:Azure Linux 3.0 (Mariner 3.0)

- 爪哇:21

- Scala:2.13

- Python:3.12

- 三角洲湖:4.0

啟用運行環境 2.0

你可以在工作區層級或環境項目層級啟用 Runtime 2.0。 使用 workspace 設定,將 Runtime 2.0 作為你工作區中所有 Spark 工作負載的預設值。 或者,你可以建立一個 Runtime 2.0 的環境項目,用於特定筆記本或 Spark 工作定義,這樣可以覆蓋工作區的預設值。

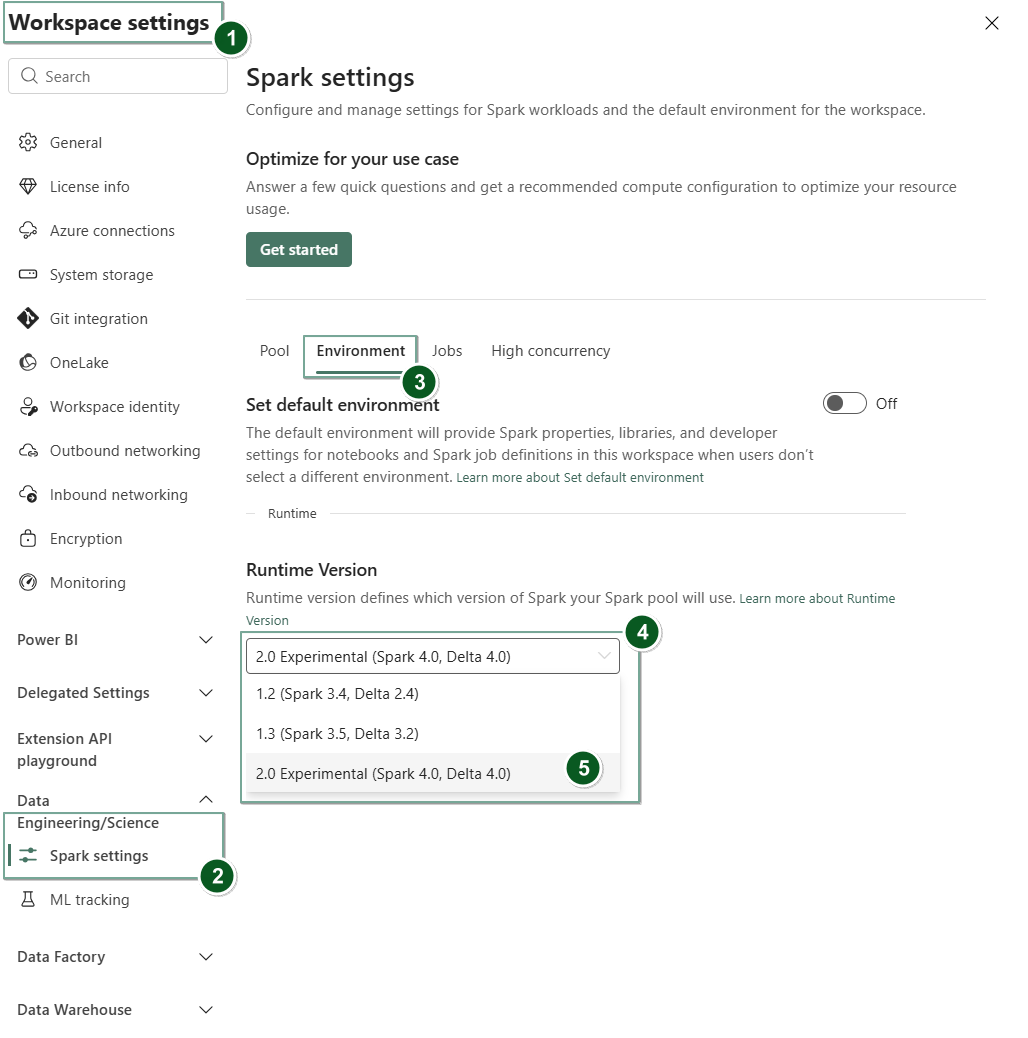

在 Workspace 設定中啟用 Runtime 2.0

要將 Runtime 2.0 設為整個工作區的預設:

流覽至網狀架構 工作區內的 工作區設定索引卷標。

到 資料工程/科學 分頁,選擇 Spark 設定。

選取環境索引標籤。

在 執行時版本 下拉選單中,選擇 2.0 實驗版(Spark 4.0、Delta 4.0), 並儲存你的變更。 此動作會將 Runtime 2.0 設定為你工作區的預設執行時。

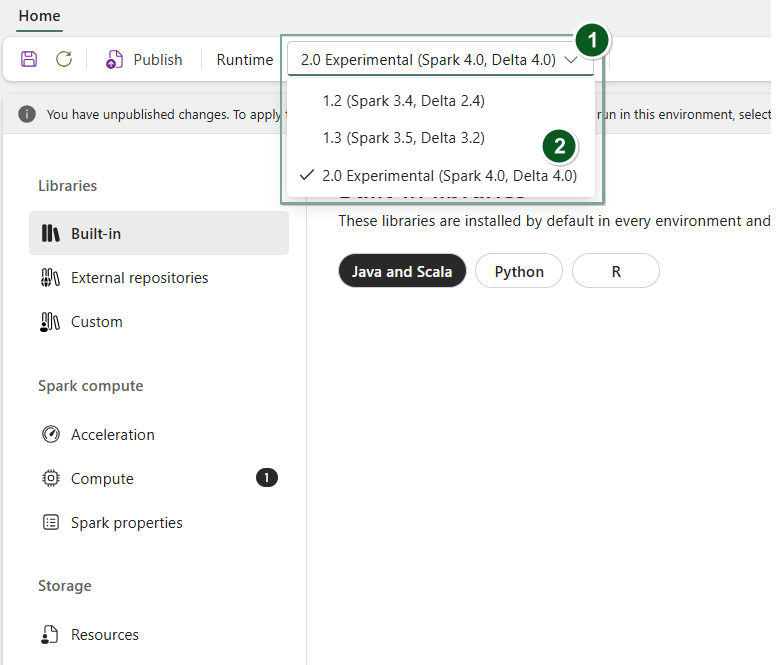

在環境項目中啟用執行時 2.0

要使用 Runtime 2.0 搭配特定的筆記本或 Spark 工作定義:

建立一個新的環境項目,或者開啟一個已存在的。

在執行時間下拉選單中,選擇 2.0 實驗(Spark 4.0、Delta 4.0),

Save並Publish選擇你的變更。這很重要

Spark 2.0 的啟動大約需要 2 到 5 分鐘,因為起始池不包含在早期實驗版本中。

接著,你可以將這個 環境元素與你的

Notebook或Spark Job Definition搭配使用。

你現在可以開始嘗試 Fabric Runtime 2.0 引入的最新改進與功能(Spark 4.0 和 Delta Lake 4.0)。

實驗公開預覽

Fabric 執行時 2.0 的實驗預覽階段,讓你能提前取得來自 Spark 4.0 和 Delta Lake 4.0 的新功能與 API。 預覽版讓你能立即使用最新的 Spark 強化功能,確保未來如 Java、Scala 和 Python 等版本的變更能順利銜接與過渡。

小提示

如需最新資訊、變更的詳細清單,以及 Fabric 執行時間的特定版本資訊,請檢查並訂閱 Spark 執行階段版本和更新。

限制與註解

Fabric Runtime 2.0 目前處於實驗性公開預覽階段,設計讓使用者能在開發或測試環境中探索並試驗 Spark 與 Delta Lake 的最新功能與 API。 雖然此版本提供核心功能存取,但仍有某些限制:

你可以使用 Spark 4.0 會話、在筆記本中寫程式碼、排程 Spark 工作定義,並搭配 PySpark、Scala 和 Spark SQL 使用。 不過,在這個早期版本中並不支援 R 語言。

你可以直接在程式碼裡用 pip 和 conda 安裝函式庫。 你可以透過筆記本中的 %%configure 選項和 Spark 工作定義(SJD)來設定 Spark。

你可以用 Delta Lake 4.0 讀寫 Lakehouse,但一些進階功能如 V-order、以原生方式寫入 Parquet、自動壓縮整理、優化寫入、低洗牌合併、合併、結構演化和時間旅行,這些都未包含在這個早期版本中。

Spark Advisor 目前無法使用。 不過,這個早期版本支援了像 Spark UI 和日誌這類監控工具。

目前,在這個早期版本中,資料科學整合功能(包括 Copilot)以及連接器(包括 Kusto、SQL Analytics、Cosmos DB 和 MySQL Java Connector)均不受支援。 PySpark 環境中不支援資料科學函式庫。 PySpark 只支援基本的 Conda 架構,包含單獨的 PySpark,沒有額外的函式庫。

在這個早期版本中,不支援與環境項目和 Visual Studio Code 的整合。

它不支援使用 WASB 或 ABFS 協定讀寫資料至通用用途 v2(GPv2)Azure 儲存帳戶。

備註

在 Ideas 平台分享你對 Fabric Runtime 的回饋。 務必說明你所指的版本和發行階段。 我們重視社群回饋,並根據投票優先改進,確保符合用戶需求。

重點摘要

Apache Spark 4.0

Apache Spark 4.0 作為 4.x 系列的首個版本,標誌著一個重要的里程碑,體現了充滿活力的開源社群的集體努力。

在此版本中,Spark SQL 大幅擴充了強大的新功能,旨在提升 SQL 工作負載的表現力與多樣性,例如 VARIANT 資料型別支援、SQL 使用者定義函式、會話變數、管道語法及字串排序。 PySpark 持續致力於功能廣度與整體開發體驗,帶來原生繪圖 API、新的 Python 資料來源 API、對 Python UDTF 的支援,以及 PySpark UDF 的統一剖析,並有許多其他改進。 結構化串流隨著關鍵新增功能而演進,提供更強的控制與易於除錯,特別是引入了 Arbitrary State API v2,以提供更靈活的狀態管理,以及 State Data Source,使除錯更為便利。

您可以在這裡檢查完整清單和詳細變更:https://spark.apache.org/releases/spark-release-4-0-0.html。

備註

在 Spark 4.0 中,SparkR 已被棄用,未來版本可能會被移除。

三角洲湖 4.0

Delta Lake 4.0 標誌著大家共同承諾讓 Delta Lake 能跨平台互通、更易操作且效能提升。 Delta 4.0 是一個里程碑式的版本,包含強大的新功能、效能優化及未來開放資料湖屋的基礎強化。

你可以在這裡查看完整清單及 Delta Lake 3.3 與 4.0 引入的詳細變更: https://github.com/delta-io/delta/releases/tag/v3.3.0 https://github.com/delta-io/delta/releases/tag/v4.0.0。

這很重要

Delta Lake 4.0 專屬功能仍屬實驗性質,僅適用於 Spark 體驗,如筆記本和 Spark 工作定義。 如果你需要在多個 Microsoft Fabric 工作負載中使用相同的 Delta Lake 資料表,就不要啟用那些功能。 想了解更多哪些協定版本與功能在所有 Microsoft Fabric 體驗中相容,請閱讀 Delta Lake 表格格式互通性。