Dataflow Gen2 中資料目的地的內部部署資料閘道考慮

本文嘗試列出在 Dataflow Gen2 中使用資料閘道與資料目的地案例時的限制和考慮。

評估逾時

使用閘道和資料目的地功能的資料流僅限於評估或重新整理一小時的時間。

如需進一步瞭解這項限制的相關資訊,請參閱疑難排解內部部署的資料閘道一文。

埠 1433 的網路問題

搭配內部部署的資料閘道使用 Microsoft Fabric Dataflow Gen2 時,您可能會遇到資料流程重新整理程序的問題。 當閘道無法連線到資料流預備 Lakehouse,以便在將資料複製到所需的資料目的地之前先讀取資料,就會發生根本問題。 不論所使用的資料目的地類型為何,都可能發生此問題。

在整體資料流重新整理期間,資料表重新整理可以顯示為「成功」,但活動區段會顯示為 「失敗」。 作用 WriteToDatabaseTableFrom_... 的錯誤詳細資料表示下列錯誤:

Mashup Exception Error: Couldn't refresh the entity because of an issue with the mashup document MashupException.Error: Microsoft SQL: A network-related or instance-specific error occurred while establishing a connection to SQL Server. The server was not found or was not accessible. Verify that the instance name is correct and that SQL Server is configured to allow remote connections. (provider: TCP Provider, error: 0 - An attempt was made to access a socket in a way forbidden by its access permissions.) Details: DataSourceKind = Lakehouse;DataSourcePath = Lakehouse;Message = A network-related or instance-specific error occurred while establishing a connection to SQL Server. The server was not found or was not accessible. Verify that the instance name is correct and that SQL Server is configured to allow remote connections. (provider: TCP Provider, error: 0 - An attempt was made to access a socket in a way forbidden by its access permissions.);ErrorCode = -2146232060;Number = 10013

注意

從架構的觀點來看,資料流引擎會使用輸出 HTTPS (埠 443) 端點將資料寫入 Lakehouse。 不過,從 Lakehouse 讀取資料需要使用 TDS 通訊協定 (TCP over port 1433)。 此通訊協定可用來將資料從預備 Lakehouse 複製到資料目的地。 這說明當資料目的地活動失敗時,資料表載入步驟成功的原因,即使兩個 Lakehouse 都位於相同的 OneLake 實例中也一樣。

疑難排解

若要對此問題進行疑難排解,請執行下列步驟:

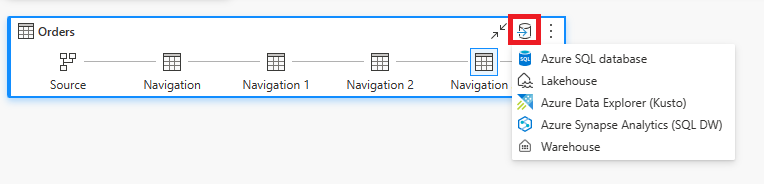

確認資料流已設定為資料目的地。

確認資料流重新整理失敗,資料表重新整理顯示為 「成功」 ,且活動顯示為 「失敗」。

檢閱活動

WriteToDatabaseTableFrom_...的錯誤詳細資料,其中提供所發生錯誤的相關信息。

解決方案:在執行閘道的伺服器上設定新的防火牆規則

閘道伺服器和/或客戶 Proxy 伺服器上的防火牆規則必須更新,才能允許從閘道伺服器到下列端點的輸出流量。 如果您的防火牆不支援通配符,請使用來自 Azure IP 範圍和服務標籤的 IP 位址。 請注意,每個月都必須保持同步。

- 通訊協定: TCP

- 端點:*.datawarehouse.pbidedicated.windows.net、*.datawarehouse.fabric.microsoft.com、*.dfs.fabric.microsoft.com

- [連接埠]:1433

注意

在某些情況下,特別是當容量位於非最接近閘道的區域時,可能需要設定防火牆以允許存取多個端點(*cloudapp.azure.com)。 需要這項調整,才能容納在這些條件下可能發生的重新導向。 如果目的地為 *.cloudapp.azure.com 的流量未受到規則攔截,您也可以在防火牆中允許 資料區的IP位址 。

如果您想要將端點的範圍縮小到工作區中實際 OneLake 實例的範圍(而不是通配符 *.datawarehouse.pbidedicated.windows.net),可以流覽至 [網狀架構] 工作區,找出該 URL,然後 DataflowsStagingLakehouse選取 [檢視詳細資料]。 然後,複製並貼上 SQL 連接字串。

整個端點名稱類似於以下範例:

x6eps4xrq2xudenlfv6naeo3i4-l27nd6wdk4oephe4gz4j7mdzka.datawarehouse.pbidedicated.windows.net

因應措施:在不同的內嵌和載入資料流中分割資料流

如果您無法更新防火牆規則,您可以將資料流分割成兩個不同的資料流。 第一個資料流負責將資料內嵌至預備 Lakehouse。 第二個資料流負責將資料從預備 Lakehouse 載入資料目的地。 此因應措施不理想,因為它需要使用兩個不同的資料流,但它可以當做暫時解決方案使用,直到防火牆規則可以更新為止。

若要實施此因應措施,請遵循以下步驟:

![[光纖] 工作區的螢幕快照,其中已選取省略號,並強調 [檢視詳細資料] 選項。](media/gateway-considerations-output-destination/staging.png)

![Power Query 編輯器的螢幕快照,其中已選取 [取得資料] 選項,並強調 [資料流連接器] 選項。](media/gateway-considerations-output-destination/get-data-dataflow-connector.png)

![[取得資料] 對話框的螢幕快照,其中已選取 [資料流連接器] 選項。](media/gateway-considerations-output-destination/dataflow-connector-get-data.png)