Power BI 數據流可讓您連線、轉換、合併及散發數據以進行下游分析。 數據流中的關鍵元素是重新整理程式,它會套用您在數據流中撰寫的轉換步驟,並更新專案本身中的數據。

若要瞭解運行時間、效能,以及您是否充分利用數據流,您可以在重新整理數據流之後下載重新整理記錄。

瞭解重新整理

有兩種類型的重新整理適用於資料流:

完整,這會執行數據的完整排清和重載。

累加式(僅限進階),它會根據您設定的時間型規則來處理數據子集,以篩選方式表示。 日期數據行上的篩選會將數據動態分割成 Power BI 服務中的範圍。 設定累加式重新整理之後,數據流會自動改變查詢以包含依日期篩選。 您可以使用 Power Query 中的 進階編輯器 來編輯自動產生的查詢,從而微調或自訂您的更新。 如果您自備 Azure Data Lake Storage,您可以根據您設定的重新整理原則來查看數據的時間配量。

注意

若要深入瞭解累加式重新整理及其運作方式,請參閱 使用累加式重新整理搭配數據流。

累加式重新整理可讓Power BI中的大型數據流具有下列優點:

第一次重新整理之後的重新整理速度較快,原因如下:

- Power BI 會重新整理使用者指定的最後 N 個 分割區(分割區可以是日/週/月等等),或

- Power BI 只會重新整理需要重新整理的數據。 例如,只更新 10 年語意模型中過去五天的資料。

- 只要您指定要檢查變更的數據行,Power BI 只會重新整理已變更的數據。

不再需要維護與不穩定系統的持續連線,資料刷新變得更加可靠。

減少資源耗用量 - 重新整理的數據較少,可減少記憶體和其他資源的整體耗用量。

在可能的情況下,Power BI 會在分割區上使用平行處理,這可能會導致更快速的重新整理。

在這些重新整理案例中,如果重新整理失敗,則數據不會更新。 您的數據可能已過時,直到最新的重新整理完成,或者您可以手動重新整理數據,然後可以完成而不會發生錯誤。 重新整理發生在分割區或實體上,因此,如果累加式重新整理失敗,或實體發生錯誤,則不會發生整個重新整理交易。 另一種方式是,如果數據流的數據分割(累加式重新整理原則)或實體失敗,則整個重新整理作業會失敗,而且不會更新任何數據。

瞭解並優化重新整理

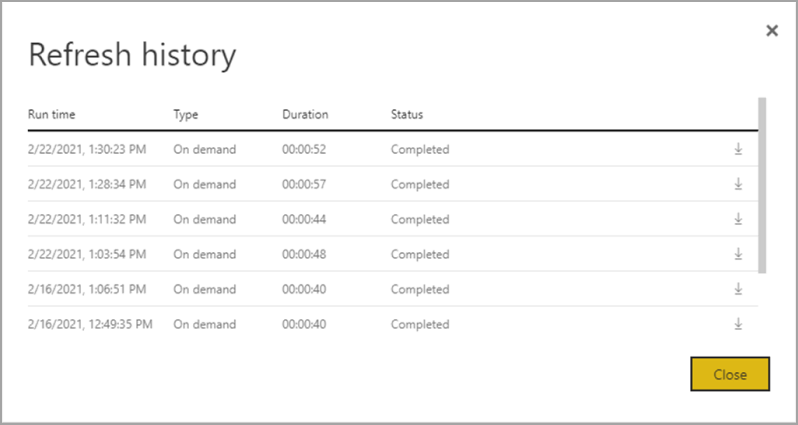

若要進一步了解數據流重新整理作業的執行方式,請流覽至其中一個數據流,檢閱數據流 重新整理記錄。 選取數據流的 更多選項(...)。 然後選擇 [設定] > [重新整理記錄]。 您也可以在 [工作區]中選取數據流。 然後選擇 [[其他選項][...] > [重新整理記錄]。

更新記錄 提供了刷新概覽,包括類型——依需求 或排程 、持續時間及執行狀態。 若要查看 CSV 檔案形式的詳細數據,請選取重新整理描述數據列最右邊的下載圖示。 下載的 CSV 包含下表所述的屬性。 進階重新整理會根據額外的計算和數據流功能,與位於共用容量上的 Pro 型數據流提供更多資訊。 因此,下列某些計量僅適用於 Premium。

| 項目 | 描述 | Pro | 進階 |

|---|---|---|---|

| 要求日期為 | 已排程時間重新整理,或立即按兩下 [當地時間] 重新整理。 | ✔ | ✔ |

| 數據流名稱 | 數據流的名稱。 | ✔ | ✔ |

| 數據流重新整理狀態 | 針對實體,狀態可以是已完成、失敗或略過。 鏈接實體之類的使用案例是人們可能看到略過的原因。 | ✔ | ✔ |

| 實體名稱 | 數據表名稱。 | ✔ | ✔ |

| 分區名稱 | 此項目取決於數據流是否為高級版本,以及 Pro 是否顯示為 NA,因為它不支援累加式重新整理。 Premium 會顯示 FullRefreshPolicyPartition 或 IncrementalRefreshPolicyPartition-[DateRange]。 | ✔ | |

| 更新狀態 | 個別實體或分割區的刷新狀態,提供正在被刷新數據的時間片段的狀態。 | ✔ | ✔ |

| 開始時間 | 在 Premium 中,此項目是數據流排隊等待處理實體或分割區的時間。 如果數據流具有相依性,而且需要等候上游數據流的結果集開始處理,這個時間可能會有所不同。 | ✔ | ✔ |

| 結束時間 | 結束時間是數據流實體或分割區完成的時間,如果適用的話。 | ✔ | ✔ |

| 期間 | 數據流重新整理的總耗時以 HH:MM:SS 表示。 | ✔ | ✔ |

| 已處理的數據列 | 針對指定的實體或分割區,數據流引擎掃描或寫入的數據列數目。 此項目根據您執行的作業,可能並不會總是包含數據。 未使用計算引擎時,或當您使用閘道作為數據處理時,可能會省略數據。 | ✔ | |

| 已處理的位元組 | 針對指定的實體或分割區,數據流引擎所寫入的數據,以位元組表示。 在此特定數據流上使用閘道時,不會提供此資訊。 |

✔ | |

| 最大提交量 (KB) | Max Commit 是峰值提交記憶體,可用於在系統運行中診斷 M 查詢未優化時的記憶體不足失敗。 當您在此特定數據流上使用閘道時,不會提供此資訊。 |

✔ | |

| 處理器時間 | 對於指定的實體或分割區,以 HH:MM:SS 格式表示的時間是資料流引擎執行轉換所花費的。 當您在此特定數據流上使用閘道時,不會提供此資訊。 |

✔ | |

| 等候時間 | 針對特定實體或分割區,根據 Premium 容量的工作負載,實體在等待狀態中所花費的時間。 | ✔ | |

| 計算引擎 | 針對指定的實體或分割區,如何在重新整理作業中使用計算引擎的詳細資訊。 這些值為: - 不適用 -摺疊 -快取 - 快取 + 折疊 本文稍後會更詳細地說明這些元素。 |

✔ | |

| 錯誤 | 如果適用,每個實體或分割區會描述詳細的錯誤訊息。 | ✔ | ✔ |

數據流重新整理指引

重新整理統計數據提供您可用來優化及加速數據流效能的寶貴資訊。 在下列各節中,我們會說明一些案例、要注意的事項,以及如何根據提供的資訊進行優化。

配器

在相同的工作區中使用數據流可讓您直接協調流程。 例如,您可能在單一工作區中有數據流 A、B 和 C,並像 A > B > C 一樣鏈結。如果您重新整理來源 (A),下游實體也會重新整理。 不過,如果您重新整理 C,則必須獨立重新整理其他元素。 此外,如果您在數據流 B 中新增數據源(未包含在 A 中),數據不會重新整理為協調流程的一部分。

您可能想要將那些不適合由Power BI執行的受控協調流程的項目串聯在一起。 在這些案例中,您可以使用 API 和/或使用 Power Automate。 您可以參考 API 檔 和 PowerShell 腳本,以程式設計方式重新整理。 Power Automate 連接器可讓您執行此程式,而不需要撰寫任何程序代碼。 您可以看到 詳細範例,其中包含 循序更新的特定逐步說明。

監測

使用本文稍早所述的增強式重新整理統計數據,您可以取得詳細的每個數據流重新整理資訊。 但是,如果您想要查看具有全租使用者或全工作區重新整理概觀的數據流,或許可以建置監視儀錶板,您可以使用 API 或 Power Automate 範本。 同樣地,對於 傳送簡單或複雜通知等使用案例,您可以使用Power Automate連接器,或使用 API 建置自己的自定義應用程式。

逾時錯誤

優化執行擷取、轉換和載入(ETL)程序所需的時間是最佳的做法。 在 Power BI 中,適用下列情況:

- 某些連接器具有您可以設定的明確逾時設定。 如需詳細資訊,請參閱 Power Query 中的連接器。

- 在使用 Power BI Pro 的情況下,Power BI 數據流可能會遇到實體或數據流本身內長時間執行的查詢逾時問題。 Power BI Premium 工作區中並不存在該限制。

逾時指引

Power BI Pro 數據流的逾時閾值如下:

- 個別實體層級的兩小時。

- 整個數據流層級的三小時。

例如,如果您有一個包含三個資料表的資料流,則每個個別資料表的處理時間都不得超過兩小時,且如果總持續時間超過三小時,整個資料流就會逾時。

如果您遇到逾時情況,請考慮優化您的數據流查詢,並嘗試在來源系統上實施 查詢折疊。

另外,請考慮升級至 Premium Per User,這樣就不會受到這些逾時限制的影響,並且由於包含許多 Power BI Premium Per User 功能,能提供更高的效能。

持續時間長

複雜或大型數據流可能需要更多時間來重新整理,因為數據流的優化效能不佳。 下列各節提供減少長時間重新整理的方法指引。

長時間刷新持續時間指引

改善數據流長時間重新整理持續時間的第一個步驟,是根據 最佳做法建置數據流。 值得注意的模式包括:

- 針對稍後在其他轉換中使用的數據,請使用 鏈接實體。

- 使用計算實體 快取數據,減少來源系統上的數據載入和數據擷取負擔。

- 將數據分割成 暫存數據流, 和 轉換數據流,將 ETL 分成不同的數據流。

- 優化擴充資料表作業。

- 請遵循 指引來處理複雜數據流。

接下來,它有助於評估您是否可以使用累加式重新整理。

使用 增量更新 能提升效能。 請務必在提交查詢以進行重新整理作業時,將數據分割篩選推送至來源系統。 若要向下推送篩選表示數據源應該支持查詢折疊,或者您可以透過函式或其他方法表達商業規則,以協助Power Query消除和篩選檔案或資料夾。 大部分支援 SQL 查詢的數據源都支持查詢折疊,而某些 OData 摘要也支持篩選。

不過,一般檔案、Blob 和 API 等數據源通常不支持篩選。 如果數據源後端不支持篩選,則無法下推。 在這種情況下,混搭引擎會進行調整,並本地套用過濾器,這可能需要從資料源擷取完整的語義模型。 此作業可能會導致增量刷新變慢,而如果使用 Power BI 服務或內部部署數據閘道,資源可能會耗盡。

假設每個數據源各層級的查詢折疊支援,您應該執行驗證,以確保篩選邏輯包含在來源查詢中。 為了簡化此動作,Power BI 會嘗試為您執行此驗證,並搭配 Power Query 線上版 的步驟折疊指示器。 其中許多優化是在設計階段的體驗,但在刷新發生後,您有機會分析和優化刷新性能。

最後,請考慮優化您的環境。 您可以藉由相應增加容量、調整數據閘道大小,以及使用下列優化來減少網路等待時間,以優化 Power BI 環境:

使用 Power BI Premium 或 Premium Per User 可用的容量時,您可以藉由增加 Premium 實例或將內容指派給不同的容量來提升效能。

每當 Power BI 需要存取無法直接透過因特網存取的數據時,就需要閘道。 您可以在內部部署伺服器上或虛擬機上安裝 內部部署資料閘道。

- 若要瞭解閘道工作負載和大小調整建議,請參閱 內部部署資料閘道大小調整。

- 也評估將數據先帶入暫存數據流,並使用連結和計算的實體來參考下游數據。

網路延遲可能會影響重新整理效能,因為它會增加請求到達 Power BI 服務以及回應傳遞所需的時間。 Power BI 中的租用戶會指派給特定區域。 若要判斷租戶所在的位置,請參閱 尋找組織的預設區域。 當租戶的使用者存取 Power BI 服務時,其請求始終會被路由至該區域。 當要求到達Power BI服務時,服務接著可能會傳送額外的要求,例如,傳送至基礎數據源或數據閘道,這也會受限於網路等待時間。

- Azure 速度測試等工具會提供用戶端與 Azure 區域之間的網路延遲指示。 一般而言,若要將網路等待時間的影響降到最低,請盡量讓數據源、網關和 Power BI 叢集保持接近。 最好居住在相同區域。 如果網路等待時間是個問題,請嘗試將閘道和數據源放在雲端裝載的虛擬機內,以更接近Power BI 叢集。

高處理器時間

如果您看到高處理器時間,您可能會有未折疊的昂貴轉換。 處理器時間過高可能是因為您已套用的步驟數目或者您所進行的轉換類型。 所有這些可能性都可能導致較高的重新整理時間。

高處理器使用時間的指導方針

優化高處理器時間有兩個選項。

首先,使用數據源本身內的查詢折疊,這應該會直接減少數據流計算引擎的負載。 數據源內的查詢折疊可讓來源系統執行大部分的工作。 然後,數據流就可以以來源的原生語言傳遞查詢,而不必在初始查詢之後執行記憶體中的所有計算。

並非所有數據源都可以執行查詢折疊,即使可能進行查詢折疊,也可能有執行無法折疊至來源之特定轉換的數據流。 在這種情況下,增強型計算引擎 是 Power BI 引進的功能,可特別針對轉換提升效能 25 倍。

使用計算引擎將效能最大化

雖然 Power Query 在查詢折疊方面擁有設計時間的可見性,但計算引擎欄位會提供有關內部引擎使用狀態的詳細資訊。 當您有複雜的數據流並在記憶體中進行轉換時,運算引擎會有所幫助。 在這種情況下,增強的刷新統計數據會很有幫助,因為計算引擎欄會提供是否使用引擎本身的詳細信息。

下列各節提供使用計算引擎及其統計數據的指引。

警告

在設計階段,編輯器中的摺疊指示器可能顯示出從另一個數據流取用數據時,查詢不會摺疊。 檢查來源數據流中的增強計算功能是否已啟用,以確保啟用了來源數據流上的折疊。

計算引擎狀態的指引

啟用增強型計算引擎並瞭解各種狀態很有幫助。 在內部,增強型計算引擎會使用 SQL 資料庫來讀取和儲存數據。 最好在這裡對查詢引擎執行轉化操作。 下列段落提供各種情況,以及每個案例的指導方針。

NA - 此狀態表示未使用計算引擎,因為:

- 您使用的是 Power BI Pro 數據流。

- 您已明確關閉計算引擎。

- 您在資料來源上使用查詢折疊。

- 您正在執行無法利用用來加速查詢的 SQL 引擎的複雜轉換。

如果您遇到長時間的延遲,但仍然取得 NA的狀態,請確保其已 開啟,且沒有意外被關閉。 建議的模式是先使用 暫存數據流 將數據初步放入 Power BI 服務,然後在暫存數據流之後,基於此數據建置數據流。 該模式可以減輕來源系統的負載,並結合計算引擎,提高轉換速度和性能。

快取 - 如果您看到 快取 狀態,數據流數據會儲存在計算引擎中,並可作為另一個查詢的一部分來參考。 如果您將其當做連結實體使用,則這種情況很理想,因為計算引擎會快取該數據以供下游使用。 快取的資料不需要在同一個資料流中刷新多次。 如果您想要將它用於 DirectQuery,這種情況也可能很理想。

當進行快取時,對初始擷取產生的效能影響會在相同工作區的同一數據流或不同數據流中得到回報。

如果您的實體持續時間很大,請考慮關閉計算引擎。 若要快取實體,Power BI 會將它寫入記憶體和 SQL。 如果是單次使用的實體,則效能提升可能不足以彌補雙重擷取的代價。

折疊 - 折疊表示資料流能夠用 SQL 運算來讀取資料。 計算實體會使用 SQL 中的數據表來讀取數據,而使用的 SQL 與查詢的建構相關。

當您使用內部部署或雲端數據源時,如果您先將數據載入暫存數據流並在此數據流中引用該數據,則會顯示折疊狀態。 此狀態僅適用於參考另一個實體的實體。 這表示您的查詢是在 SQL 引擎之上執行,而且它們有可能透過 SQL 計算來改善。 若要確保 SQL 引擎處理您的轉換,請使用支援 SQL 折疊的轉換,例如合併(聯結)、依匯總進行分組,以及在查詢編輯器中附加(聯集)動作。

快取 + 折疊 - 當您看到 快取 + 折疊時,很可能是因為數據重新整理已經被優化。這是因為您有一個實體同時參考另一個實體,並且也被另一個上游實體參考。 此作業也會在 SQL 之上執行,因此,SQL 計算也有可能改善。 若要確定您獲得最佳效能,請在查詢編輯器中使用支援 SQL 折疊的轉換,例如合併(聯結)、分組、依匯總和附加 (union) 動作。

計算引擎效能優化的指引

下列步驟可讓工作負載觸發計算引擎,進而一律改善效能。

相同工作區中的計算和鏈接實體:

針對 匯入,請專注於儘快將數據放入儲存空間,只有在篩選條件能減少整體語意模型大小時才使用篩選。 將您的轉換邏輯與此步驟分開。 接下來,將您的轉換和商業規則分成相同工作區中的個別數據流。 使用連結或計算實體。 這麼做可讓引擎啟用和加速計算。 簡單來說,這就像在廚房準備食物一樣:食物準備通常是一個獨立且不同的步驟,與收集原料分開,並且是將食物放入烤箱的前提。 同樣地,您必須先將您的邏輯個別準備好,才能利用計算引擎。

請確定您執行折疊的作業,例如合併、聯結、轉換,以及 其他。

計算引擎開啟時,但效能緩慢:

當計算引擎已啟動但效能欠佳時,請執行以下步驟進行調查:

- 限制存在於整個工作區的計算和關聯實體。

- 如果您在啟用計算引擎時進行初始重新整理,數據會寫入資料湖 並緩存在快取 中。 此雙寫入會導致重新整理速度變慢。

- 如果您有數據流連結至多個數據流,請務必排程來源數據流的重新整理,讓它們不會同時重新整理。

考慮和限制

Power BI Pro 授權的數據流每天最多可重新整理 8 次。