التعلم العميق باستخدام تنبؤ AutoML

تركز هذه المقالة على أساليب التعلم العميق للتنبؤ بالسلاسل الزمنية في AutoML. يمكن العثور على إرشادات وأمثلة لنماذج تنبؤ التدريب في AutoML في مقالة التنبؤ بالسلاسل الزمنية لإعداد AutoML الخاص بنا.

وقد أحدث التعلم العميق تأثيرا كبيرا في مجالات تتراوح من نمذجة اللغة إلى طي البروتين، من بين العديد من المجالات الأخرى. كما استفاد التنبؤ بالسلاسل الزمنية من التطورات الأخيرة في تكنولوجيا التعلم العميق. على سبيل المثال، تتميز نماذج الشبكة العصبية العميقة (DNN) بشكل بارز في أفضل النماذج أداء من التكرارات الرابعةوالخامسة لمسابقة تنبؤ Makridakis البارزة.

في هذه المقالة، سنصف بنية وتشغيل نموذج TCNForecaster في AutoML لمساعدتك على تطبيق النموذج على السيناريو الخاص بك على أفضل نحو.

مقدمة إلى TCNForecaster

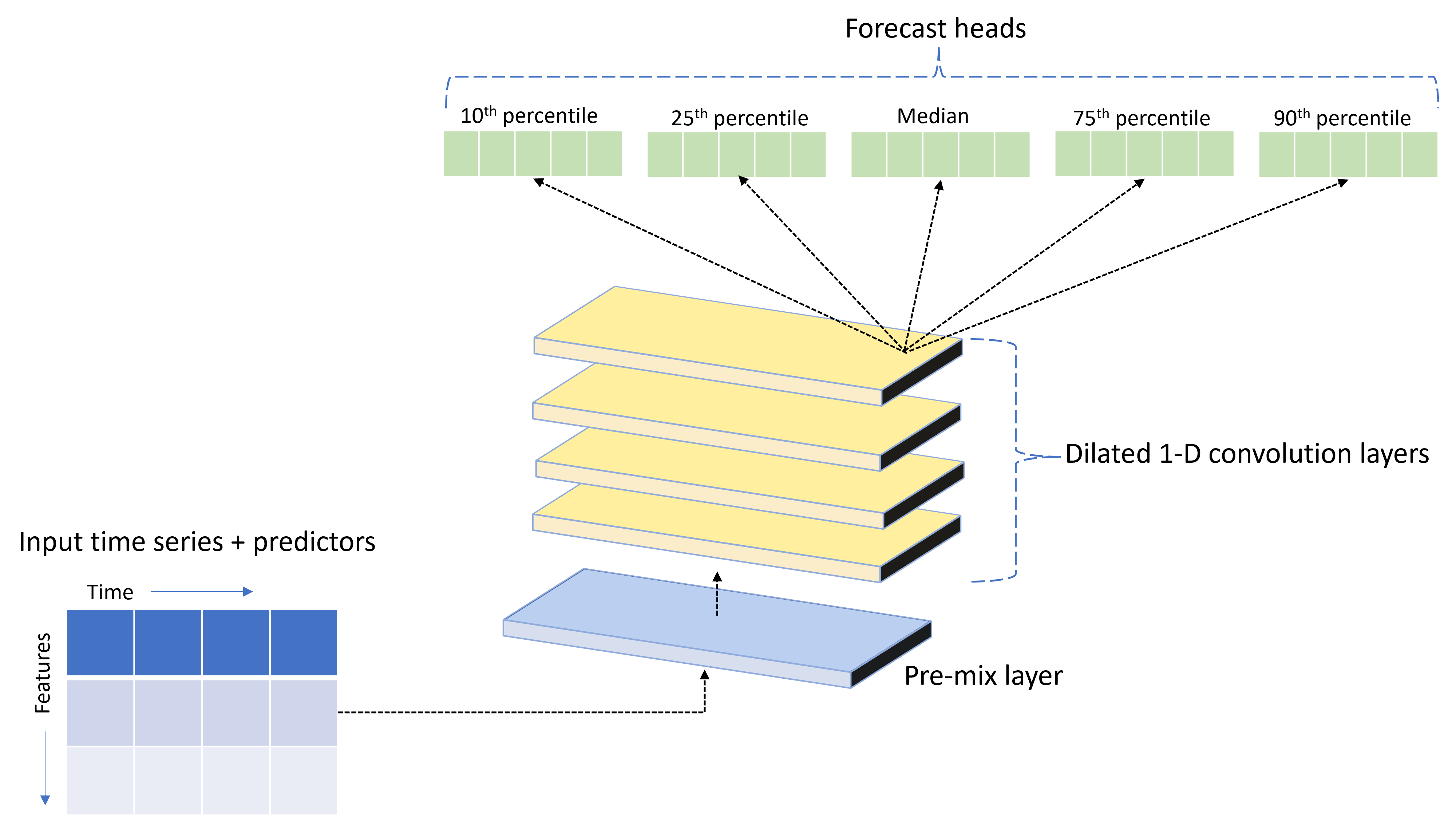

TCNForecaster هي شبكة التفافية زمنية، أو TCN، والتي تحتوي على بنية DNN مصممة خصيصا لبيانات السلاسل الزمنية. يستخدم النموذج البيانات التاريخية لكمية مستهدفة، جنبا إلى جنب مع الميزات ذات الصلة، لإجراء تنبؤات افتراضية للهدف حتى أفق تنبؤ محدد. تعرض الصورة التالية المكونات الرئيسية لبنية TCNForecaster:

يحتوي TCNForecaster على المكونات الرئيسية التالية:

- طبقة ما قبل المزج التي تخلط سلسلة وقت الإدخال وبيانات الميزات في صفيف من قنوات الإشارة التي سيعالجها المكدس الالتفافي.

- مكدس من طبقات الالتفاف الموسعة التي تعالج صفيف القناة بشكل تسلسلي؛ تعالج كل طبقة في المكدس إخراج الطبقة السابقة لإنتاج صفيف قناة جديد. تحتوي كل قناة في هذا الإخراج على مزيج من الإشارات المصفاة بالالتفاف من قنوات الإدخال.

- مجموعة من وحدات التنبؤ الرئيسية التي تجمع إشارات الإخراج من طبقات الالتفاف وتنشئ تنبؤات بالكمية المستهدفة من هذا التمثيل الكامن. تنتج كل وحدة رئيسة تنبؤات تصل إلى الأفق للحصول على تقدير كمي لتوزيع التنبؤ.

الالتفاف السببي الموسع

العملية المركزية ل TCN هي التفاف سببي متمدد على طول البعد الزمني لإشارة الإدخال. بشكل بديهي، يمزج الالتفاف القيم معا من نقاط زمنية قريبة في الإدخال. النسب في الخليط هي النواة، أو الأوزان، من الالتفاف في حين أن الفصل بين النقاط في الخليط هو التكتل. يتم إنشاء إشارة الإخراج من الإدخال عن طريق تمرير النواة في الوقت المناسب على طول الإدخال وتراكم الخليط في كل موضع. الالتفاف السببي هو واحد حيث تخلط النواة فقط قيم الإدخال في الماضي بالنسبة لكل نقطة إخراج، ما يمنع الإخراج من "النظر" إلى المستقبل.

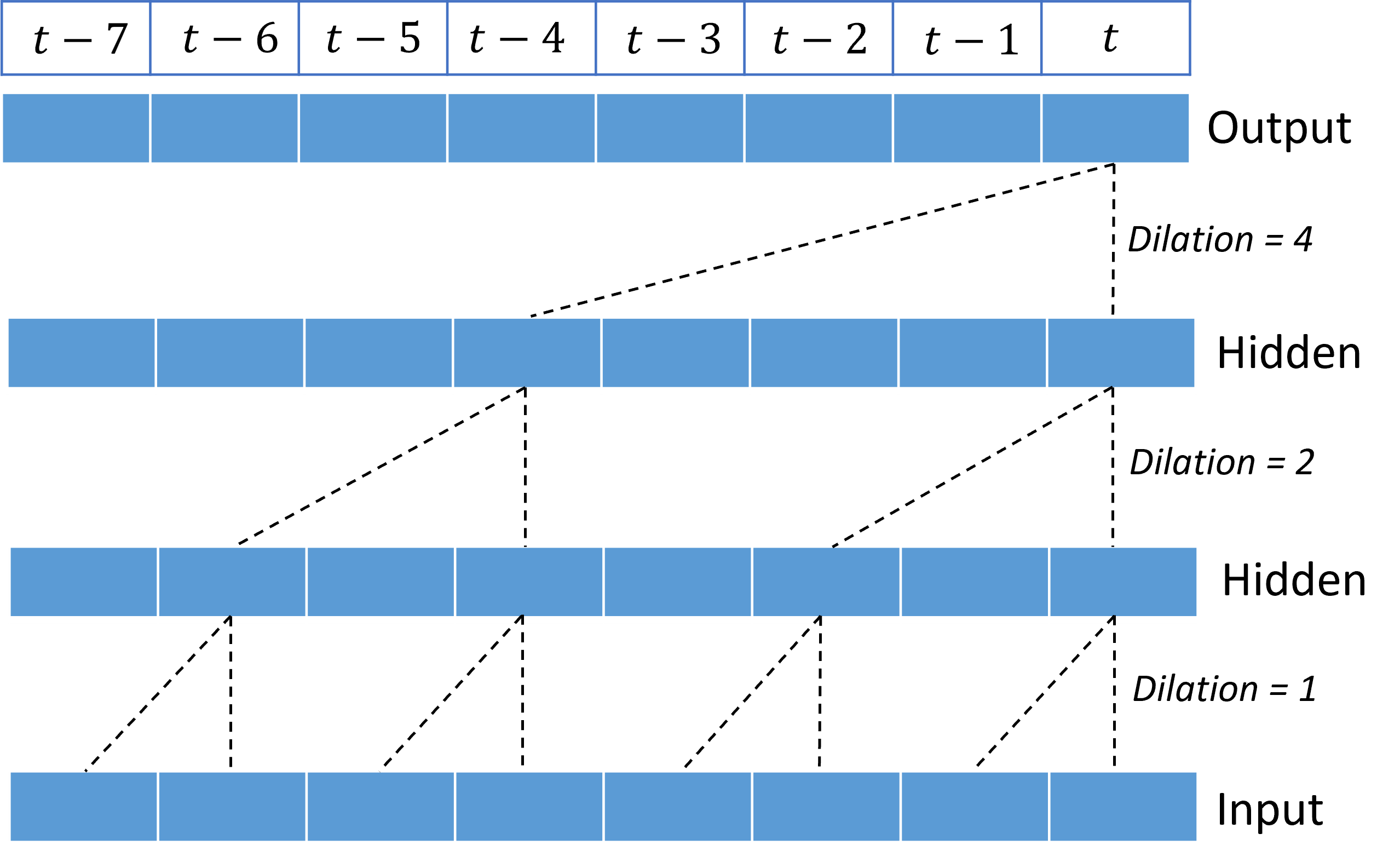

يمنح التكديس الالتفافات الموسعة TCN القدرة على نمذجة الارتباطات على مدى فترات طويلة في إشارات الإدخال مع أوزان نواة قليلة نسبيا. على سبيل المثال، تعرض الصورة التالية ثلاث طبقات مكدسة مع نواة ثنائية الوزن في كل طبقة وعوامل التكبير المتزايدة بشكل كبير:

تعرض الخطوط المتقطعة المسارات عبر الشبكة التي تنتهي على الإخراج في وقت $t$. تغطي هذه المسارات آخر ثماني نقاط في الإدخال، مما يوضح أن كل نقطة إخراج هي دالة للنقاط الثمانية الأحدث نسبيا في الإدخال. يسمى طول التاريخ، أو "التطلع إلى الوراء"، الذي تستخدمه الشبكة الالتفافية لإجراء تنبؤات الحقل المتقبل ويتم تحديده بالكامل بواسطة بنية TCN.

بنية TCNForecaster

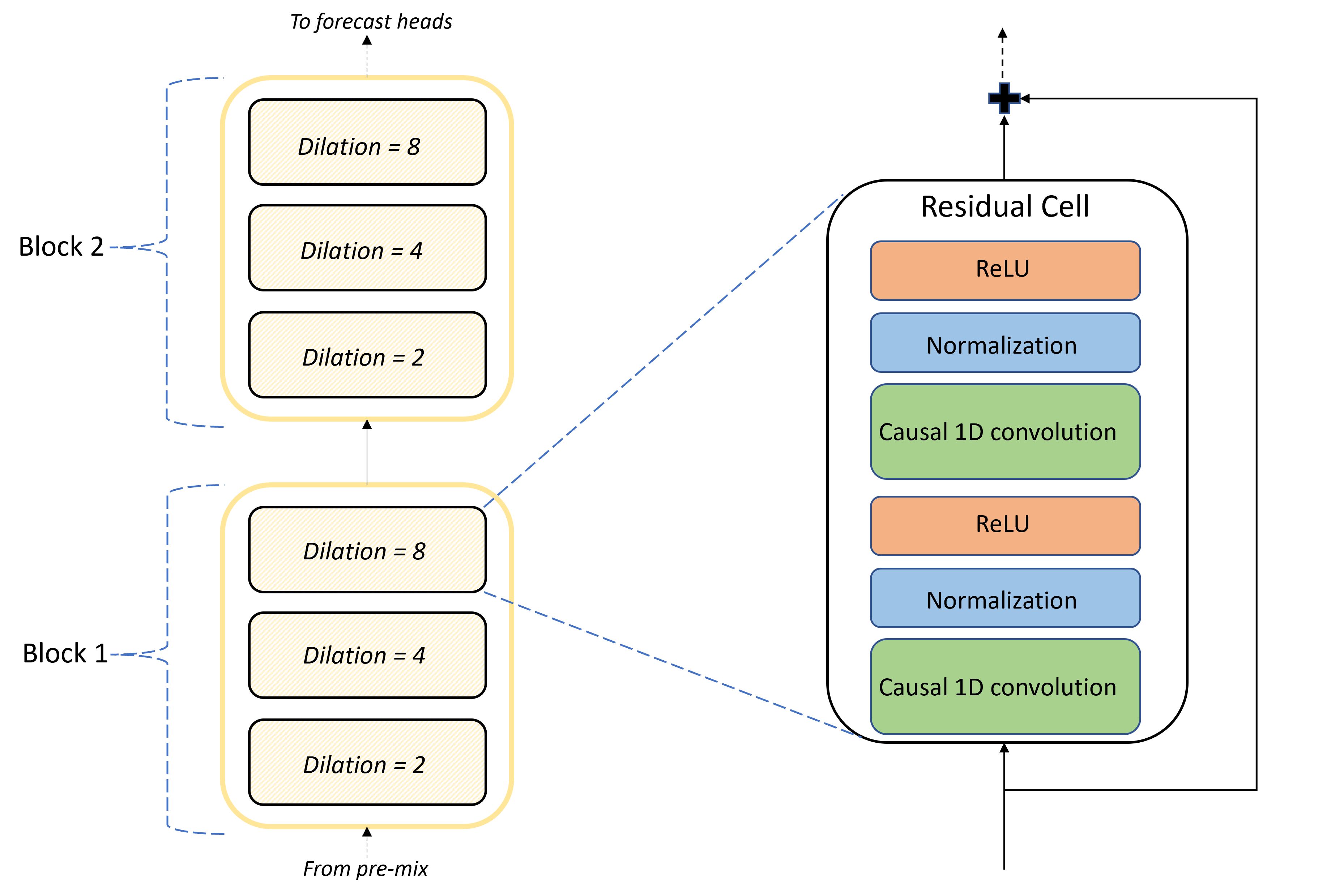

جوهر بنية TCNForecaster هو مكدس الطبقات الالتفافية بين المزيج المسبق ورؤوس التنبؤ. ينقسم المكدس منطقيا إلى وحدات مكررة تسمى الكتل التي تتكون بدورها من خلايا متبقية. تطبق الخلية المتبقية الالتفافات السببية في تميمة معينة جنبا إلى جنب مع التطبيع والتنشيط غير الخطي. والأهم من ذلك، تضيف كل خلية متبقية ناتجها إلى إدخالها باستخدام ما يسمى بالاتصال المتبقي. وقد تبين أن هذه الاتصالات تفيد تدريب DNN، ربما لأنها تسهل تدفق معلومات أكثر كفاءة من خلال الشبكة. تظهر الصورة التالية بنية الطبقات الالتفافية لشبكة مثال مع كتلتين وثلاث خلايا متبقية في كل كتلة:

يتحكم عدد الكتل والخلايا، بالإضافة إلى عدد قنوات الإشارة في كل طبقة، في حجم الشبكة. يتم تلخيص المعلمات المعمارية ل TCNForecaster في الجدول التالي:

| المعلمة | الوصف |

|---|---|

| $n_{b}$ | عدد الكتل في الشبكة؛ وتسمى أيضا العمق |

| $n_{c}$ | عدد الخلايا في كل كتلة |

| $n_{\text{ch}}$ | عدد القنوات في الطبقات المخفية |

يعتمد الحقل المتقبل على معلمات العمق ويتم منحه بواسطة الصيغة ،

$t_{\text{rf}} = 4n_{b}\left(2^{n_{c}} - 1\right) + 1.$

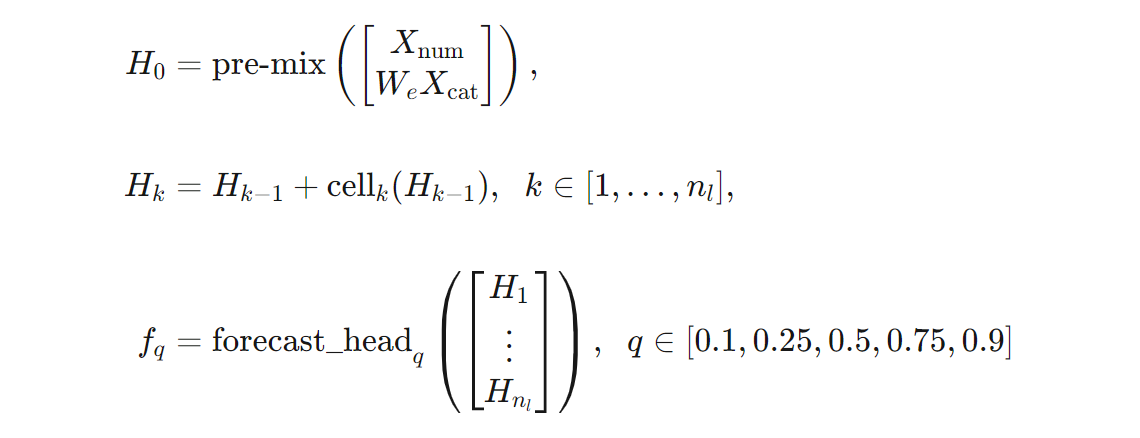

يمكننا إعطاء تعريف أكثر دقة لبنية TCNForecaster من حيث الصيغ. دع $X$ صفيف إدخال حيث يحتوي كل صف على قيم ميزات من بيانات الإدخال. يمكننا تقسيم $X$ إلى صفائف ميزات رقمية وفئة، $X_{\text{num}}$ $X_{\text{cat}}$. ثم، يتم إعطاء TCNForecaster بواسطة الصيغ،

حيث $W_{e}$ عبارة عن مصفوفة تضمين للميزات الفئوية، $n_{l} = n_{b}n_{c}$ هو العدد الإجمالي للخلايا المتبقية، يشير $H_{k}$ إلى مخرجات الطبقة المخفية، $f_{q}$ هي مخرجات تنبؤ لكميات معينة لتوزيع التنبؤ. للمساعدة في الفهم، توجد أبعاد هذه المتغيرات في الجدول التالي:

| المتغير | الوصف | الأبعاد |

|---|---|---|

| $X$ | صفيف الإدخال | $n_{\text{input}} \times t_{\text{rf}}$ |

| $H_{i}$ | إخراج الطبقة المخفية $i=0,1,\ldots,n_{l}$ | $n_{\text{ch}} \times t_{\text{rf}}$ |

| $f_{q}$ | إخراج التنبؤ $q$ الكمي | $h$ |

في الجدول، $n_{\text{input}} = n_{\text{features}} + 1$، عدد متغيرات التنبؤ/الميزات بالإضافة إلى الكمية المستهدفة. تنشئ رؤوس التنبؤ جميع التنبؤات حتى الأفق الأقصى، $h$، في تمريرة واحدة، لذلك TCNForecaster هو تنبؤ مباشر.

TCNForecaster في AutoML

TCNForecaster هو نموذج اختياري في AutoML. لمعرفة كيفية استخدامه، راجع تمكين التعلم العميق.

في هذا القسم، سنصف كيفية إنشاء AutoML لنماذج TCNForecaster مع بياناتك، بما في ذلك تفسيرات المعالجة المسبقة للبيانات والتدريب والبحث عن النموذج.

خطوات المعالجة المسبقة للبيانات

ينفذ AutoML العديد من خطوات المعالجة المسبقة على بياناتك للتحضير لتدريب النموذج. يصف الجدول التالي هذه الخطوات بالترتيب الذي يتم تنفيذه:

| الخطوة | الوصف |

|---|---|

| تعبئة البيانات المفقودة | حساب القيم المفقودة وثغرات المراقبة واختياريا وسادة أو إسقاط سلسلة زمنية قصيرة |

| إنشاء ميزات التقويم | قم بزيادة بيانات الإدخال بميزات مشتقة من التقويم مثل يوم الأسبوع، واختياريا، العطلات لبلد/منطقة معينة. |

| ترميز البيانات الفئوية | سلاسل ترميز التسمية والأنواع الفئوية الأخرى؛ يتضمن ذلك جميع أعمدة معرف السلسلة الزمنية. |

| التحويل الهدف | تطبيق وظيفة اللوغاريتم الطبيعية اختياريا على الهدف اعتمادا على نتائج اختبارات إحصائية معينة. |

| التسوية | تسوية درجة Z لجميع البيانات الرقمية؛ يتم إجراء التسوية لكل ميزة ولكل مجموعة سلاسل زمنية، كما هو محدد بواسطة أعمدة معرف السلسلة الزمنية. |

يتم تضمين هذه الخطوات في مسارات تحويل AutoML، لذلك يتم تطبيقها تلقائيا عند الحاجة في وقت الاستدلال. في بعض الحالات، يتم تضمين العملية العكسية إلى خطوة في مسار الاستدلال. على سبيل المثال، إذا طبق AutoML تحويل $\log$ على الهدف أثناء التدريب، يتم أس التنبؤات الأولية في البنية الأساسية لبرنامج ربط العمليات التجارية للاستدلال.

التدريب

يتبع TCNForecaster أفضل ممارسات تدريب DNN الشائعة للتطبيقات الأخرى في الصور واللغة. يقسم AutoML بيانات التدريب المعالجة مسبقا إلى أمثلة يتم تبديلها ودمجها في دفعات. تعالج الشبكة الدفعات بالتسلسل، باستخدام الانتشار الخلفي والنزول العشوائي لتحسين أوزان الشبكة فيما يتعلق بوظيفة الخسارة. يمكن أن يتطلب التدريب العديد من المرور عبر بيانات التدريب الكاملة؛ تسمى كل تمريرة فترة.

يسرد الجدول التالي ويصف إعدادات الإدخال ومعلمات تدريب TCNForecaster:

| إدخال التدريب | الوصف | القيمة |

|---|---|---|

| بيانات التحقق من الصحة | جزء من البيانات التي يتم الاحتفاظ بها من التدريب لتوجيه تحسين الشبكة والتخفيف من التجهيزات. | يوفرها المستخدم أو يتم إنشاؤها تلقائيا من بيانات التدريب إذا لم يتم توفيرها. |

| المقياس الأساسي | المقياس المحسوب من تنبؤات القيمة الوسيطة على بيانات التحقق من الصحة في نهاية كل فترة تدريب؛ يستخدم للإيقاف المبكر واختيار النموذج. | تم اختياره من قبل المستخدم؛ متوسط الخطأ التربيعي للجذر الذي تمت تسويته أو متوسط الخطأ المطلق العادي. |

| فترات التدريب | الحد الأقصى لعدد الفترات التي سيتم تشغيلها لتحسين وزن الشبكة. | 100; قد ينهي منطق الإيقاف المبكر التلقائي التدريب في عدد أقل من الفترات. |

| الصبر في الإيقاف المبكر | عدد الفترات التي يجب انتظار تحسين المقاييس الأساسية قبل إيقاف التدريب. | 20 |

| دالة الخسارة | الوظيفة الموضوعية لتحسين وزن الشبكة. | بلغ متوسط الخسارة الكمية أكثر من 10 و25 و50 و75 و90 التنبؤات المئوية. |

| حجم الدُفعة | عدد الأمثلة في دفعة. يحتوي كل مثال على أبعاد $n_{\text{input}} \times t_{\text{rf}}$ للإدخل $h$ للإخراج. | يتم تحديدها تلقائيا من العدد الإجمالي للأمثلة في بيانات التدريب؛ القيمة القصوى 1024. |

| تضمين الأبعاد | أبعاد مساحات التضمين للميزات الفئوية. | قم بتعيين تلقائيا إلى الجذر الرابع لعدد القيم المميزة في كل ميزة، مقربا إلى أقرب عدد صحيح. يتم تطبيق الحدود بقيمة 3 كحد أدنى وقيمة قصوى 100. |

| بنية الشبكة* | المعلمات التي تتحكم في حجم الشبكة وشكلها: العمق وعدد الخلايا وعدد القنوات. | يتم تحديده بواسطة بحث النموذج. |

| أوزان الشبكة | المعلمات التي تتحكم في خليط الإشارة والتضمينات الفئوية وأوزان نواة الالتفاف وتعيينات التنبؤ بالقيم. | تمت تهيئتها عشوائيا، ثم تحسينها فيما يتعلق بوظيفة الخسارة. |

| معدل التعلم* | يتحكم في مقدار أوزان الشبكة التي يمكن تعديلها في كل تكرار للانحدار المتدرج؛ خفض ديناميكيا بالقرب من التقارب . | يتم تحديده بواسطة بحث النموذج. |

| نسبة التسرب* | يتحكم في درجة تسوية التسرب المطبقة على أوزان الشبكة. | يتم تحديده بواسطة بحث النموذج. |

يتم تحديد المدخلات التي تم وضع علامة نجمية عليها (*) بواسطة بحث المعلمة التشعبية الموضح في القسم التالي.

بحث النموذج

يستخدم AutoML أساليب بحث النموذج للعثور على قيم المعلمات الفائقة التالية:

- عمق الشبكة، أو عدد الكتل الالتفافية،

- عدد الخلايا لكل كتلة،

- عدد القنوات في كل طبقة مخفية،

- نسبة التسرب لتسوية الشبكة،

- معدل التعلم.

يمكن أن تختلف القيم المثلى لهذه المعلمات بشكل كبير اعتمادا على سيناريو المشكلة وبيانات التدريب، لذلك يدرب AutoML العديد من النماذج المختلفة ضمن مساحة قيم المعلمات الفائقة ويختار أفضل نموذج وفقا لدرجة القياس الأساسية على بيانات التحقق من الصحة.

يحتوي البحث النموذجي على مرحلتين:

- يقوم AutoML بإجراء بحث عبر 12 نموذج "معلم". نماذج المعالم ثابتة ويتم اختيارها لامتداد مساحة المعلمة الفائقة بشكل معقول.

- يستمر AutoML في البحث من خلال مساحة المعلمة الفائقة باستخدام بحث عشوائي.

ينتهي البحث عند استيفاء معايير الإيقاف. تعتمد معايير الإيقاف على تكوين مهمة التدريب على التنبؤ، ولكن بعض الأمثلة تتضمن حدودا زمنية وحدودا على عدد تجارب البحث التي يجب إجراؤها ومنطق الإيقاف المبكر عندما لا يتحسن مقياس التحقق من الصحة.

الخطوات التالية

- تعرف على كيفية إعداد AutoML لتدريب نموذج التنبؤ بالسلاسل الزمنية.

- تعرف على منهجية التنبؤ في AutoML.

- استعرض الأسئلة المتداولة حول التنبؤ في AutoML.

الملاحظات

قريبًا: خلال عام 2024، سنتخلص تدريجيًا من GitHub Issues بوصفها آلية إرسال ملاحظات للمحتوى ونستبدلها بنظام ملاحظات جديد. لمزيد من المعلومات، راجع https://aka.ms/ContentUserFeedback.

إرسال الملاحظات وعرضها المتعلقة بـ