التشغيل السريع: تحويل البيانات باستخدام تعريف مهمة Apache Spark

في هذا التشغيل السريع، ستستخدم Azure Synapse Analytics لإنشاء تدفق باستخدام تعريف مهمة Apache Spark.

المتطلبات الأساسية

- اشتراك Azure: إذا لم يكن لديك اشتراك Azure، قم بإنشاءحساب Azure مجانيقبل أن تبدأ.

- مساحة عمل Azure Synapse: أنشئ مساحة عمل Synapse باستخدام مدخل Microsoft Azure باتباع الإرشادات الموجودة في التشغيل السريع: إنشاء مساحة عمل Synapse.

- تعريف مهمة Apache Spark: أنشئ تعريف مهمة Apache Spark في مساحة عمل Synapse باتباع الإرشادات الموجودة في البرنامج التعليمي: إنشاء تعريف مهمة Apache Spark في Synapse Studio.

انتقل إلى Synapse Studio

بعد إنشاء مساحة عمل Azure Synapse، لديك طريقتان لفتح استوديو Synapse:

- افتح مساحة عمل Synapse في مدخل Azure. حدد فتح على بطاقة Open Synapse Studio ضمن Getting started.

- افتح Azure Synapse Analytics وقم بتسجيل الدخول إلى مساحة العمل الخاصة بك.

في هذا التشغيل السريع، نستخدم مساحة العمل المسماة "sampletest" كمثال. سينقلك تلقائياً إلى الصفحة الرئيسية لـ Synapse Studio.

قم بإنشاء مسار مع تعريف وظيفة Apache Spark

تحتوي التدفقات على التدفق المنطقي لتنفيذ مجموعة من الأنشطة. في هذا القسم، ستقوم بإنشاء مسار يحتوي على نشاط تعريف وظيفة Apache Spark.

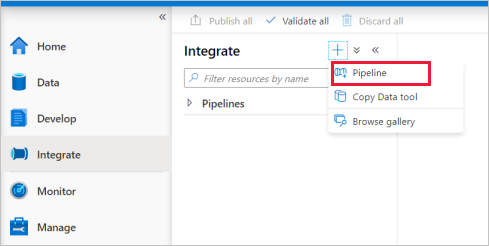

انتقل إلى علامة التبويب Integrate . حدد رمز علامة الجمع بجوار رأس التدفقات وحدد Pipeline.

في صفحة إعدادات Properties لمسار التدفق، أدخل demo لـ Name.

ضمن Synapse في جزء Activities، اسحب Spark job definition على لوحة مسار التدفق.

تعيين لوحة تعريف مهمة Apache Spark

بمجرد إنشاء تعريف وظيفة Apache Spark، سيتم إرسالك تلقائياً إلى لوحة تعريف وظيفة Spark.

الإعدادات العامة

حدد وحدة تعريف وظيفة الSpark على اللوحة القماشية.

في علامة التبويب General، أدخل sample لـ Name.

(خيار) يمكنك أيضاً إدخال وصف.

المهلة: الحد الأقصى لمقدار الوقت الذي يمكن فيه تشغيل النشاط. الافتراضي سبعة أيام، وهو أيضاً الحد الأقصى لمقدار الوقت المسموح به. التنسيق على شكل D.HH:MM:SS.

Retry: الحد الأقصى لعدد محاولات إعادة المحاولة.

Retry interval: عدد الثواني بين كل محاولة لإعادة المحاولة.

Secure output: عند تحديده، لن يتم تسجيل ناتج النشاط في التسجيل.

Secure input: عند تحديده، لن يتم تسجيل المدخلات من النشاط في التسجيل.

علامة التبويب الإعدادات

في هذه اللوحة، يمكنك الرجوع إلى تعريف وظيفة Spark للتشغيل.

قم بتوسيع قائمة تعريف وظيفة Spark، يمكنك اختيار تعريف وظيفة Apache Spark موجود. يمكنك أيضاً إنشاء تعريف وظيفة Apache Spark جديد عن طريق تحديد الزر New للإشارة إلى تعريف وظيفة Spark المراد تشغيله.

(اختياري) يمكنك ملء المعلومات الخاصة بتعريف مهمة Apache Spark. إذا كانت الإعدادات التالية فارغة، فسيتم تشغيل إعدادات تعريف وظيفة Spark نفسها؛ إذا لم تكن الإعدادات التالية فارغة، فستحل هذه الإعدادات محل إعدادات تعريف وظيفة Spark نفسها.

الخاصية الوصف ملف التعريف الرئيسي الملف الرئيسي المستخدم للوظيفة. حدد ملف PY/JAR/ZIP من التخزين لديك. يمكنك تحديد ملف التحميل لتحميل الملف إلى حساب تخزين.

العينة:abfss://…/path/to/wordcount.jarمراجع من المجلدات الفرعية عند فحص المجلدات الفرعية من المجلد الجذر لملف التعريف الرئيسي، ستتم إضافة هذه الملفات كملفات مرجعية. سيتم مسح المجلدات المسماة "jars" أو "pyFiles" أو "files" أو "archives" ضوئيا، ويكون اسم المجلدات حساسا لحالة الأحرف. اسم الفئة الرئيسية المعرف المؤهل بالكامل أو الفئة الرئيسية الموجودة في ملف التعريف الرئيسي.

العينة:WordCountوسيطات سطر الأوامر يمكنك إضافة وسيطات سطر الأوامر بالنقر على الزر New. تجدر الإشارة إلى أن إضافة وسيطات سطر الأوامر ستتجاوز وسيطات سطر الأوامر المحددة بواسطة تعريف وظيفة Spark.

نموذج:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultتجمع Apache Spark يمكنك تحديد تجمع Apache Spark من القائمة. مرجع التعليمات البرمجية ل Python ملفات تعليمات Python البرمجية الإضافية المستخدمة للرجوع إليها في ملف التعريف الرئيسي.

وهو يدعم تمرير الملفات (.py و.py3 .zip) إلى الخاصية "pyFiles". سيتجاوز خاصية "pyFiles" المحددة في تعريف وظيفة Spark.الملفات المرجعية ملفات إضافية تستخدم كمرجع في ملف التعريف الرئيسي. ديناميكي تخصيص المنفذين يعيّن هذا الإعداد خاصية التخصيص الديناميكي في تكوين Spark لتخصيص منفذي تطبيق Spark. حد المنفذين الحد الأدنى لعدد المنفذين الذين سيتم تخصيصهم في مجموعة Spark المحددة للوظيفة. Max executors الحد الأقصى لعدد المنفذين الذين سيتم تخصيصهم في مجموعة Spark المحددة للوظيفة. حجم برنامج التشغيل عدد النوى والذاكرة التي سيتم استخدامها لبرنامج التشغيل في تجمع Apache Spark المحدد لهذه المهمة. تكوين Spark حدد قيم خصائص Spark configuration المدرجة في الموضوع: Spark Configuration - خصائص التطبيق . يمكن للمستخدمين استخدام التكوين الافتراضي والتكوين المخصص.

يمكنك إضافة محتوى ديناميكي بالنقر على الزر Add Dynamic Content أو بالضغط على مفتاح الاختصار Alt+Shift+D . في صفحة Add Dynamic Content، يمكنك استخدام أي مجموعة من التعبيرات والوظائف ومتغيرات النظام للإضافة إلى المحتوى الديناميكي.

علامة تبويب خصائص المستخدم

يمكنك إضافة خصائص لنشاط تعريف وظيفة Apache Spark في هذه اللوحة.

الخطوات التالية

تقدم إلى المقالات التالية للتعرف على دعم Azure Synapse Analytics: