Použití služby Azure Data Factory k migraci dat z AmazonU S3 do Azure Storage

PLATÍ PRO: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

Azure Data Factory poskytuje výkonný, robustní a nákladově efektivní mechanismus pro migraci dat ve velkém měřítku z AmazonU S3 do Azure Blob Storage nebo Azure Data Lake Storage Gen2. Tento článek obsahuje následující informace pro datové inženýry a vývojáře:

- Výkon

- Odolnost kopírování

- Zabezpečení sítě

- Architektura řešení vysoké úrovně

- Osvědčené postupy implementace

Výkon

ADF nabízí bezserverovou architekturu, která umožňuje paralelismus na různých úrovních, což vývojářům umožňuje vytvářet kanály, které plně využívají šířku pásma sítě a IOPS úložiště a šířku pásma k maximalizaci propustnosti přesunu dat pro vaše prostředí.

Zákazníci úspěšně migrovali petabajty dat sestávajících ze stovek milionů souborů z AmazonU S3 do Azure Blob Storage s trvalou propustností 2 GB/s a vyšší.

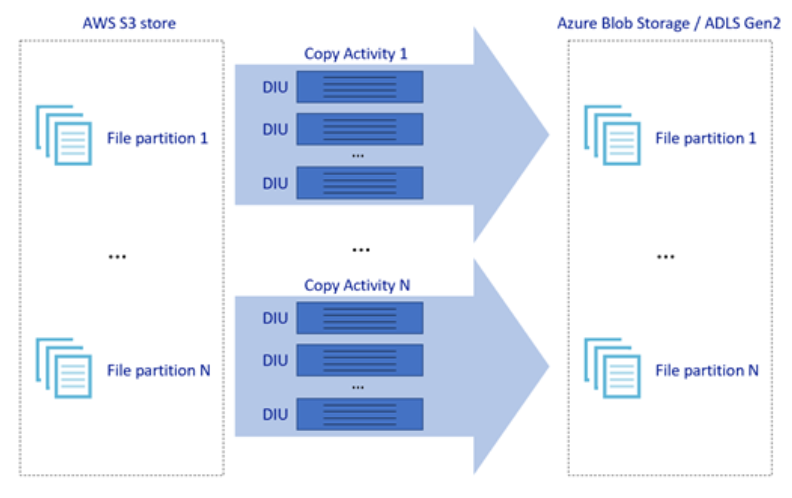

Výše uvedený obrázek ukazuje, jak můžete dosáhnout velkých rychlostí přesunu dat prostřednictvím různých úrovní paralelismu:

- Jedna aktivita kopírování může využívat škálovatelné výpočetní prostředky: při použití prostředí Azure Integration Runtime můžete zadat až 256 jednotek DIU pro každou aktivitu kopírování bezserverovým způsobem. Při použití místního prostředí Integration Runtime můžete ručně vertikálně navýšit kapacitu počítače nebo škálovat na více počítačů (až na čtyři uzly) a jedna aktivita kopírování rozdělí svoji sadu souborů napříč všemi uzly.

- Jedna aktivita kopírování čte z úložiště dat a zapisuje se do úložiště dat pomocí více vláken.

- Tok řízení ADF může paralelně spouštět více aktivit kopírování, například pomocí smyčky For Each.

Odolnost

V rámci jednoho spuštění aktivity kopírování má ADF integrovaný mechanismus opakování, aby mohl zpracovávat určitou úroveň přechodných selhání v úložištích dat nebo v podkladové síti.

Při binárním kopírování z S3 do objektu blob a z S3 do ADLS Gen2 služba ADF automaticky provádí kontrolní body. Pokud spuštění aktivity kopírování selhalo nebo vypršel časový limit, při následném opakování se kopírování obnoví z posledního bodu selhání místo toho, aby začínalo od začátku.

Zabezpečení sítě

Ve výchozím nastavení ADF přenáší data z AmazonU S3 do Azure Blob Storage nebo Azure Data Lake Storage Gen2 pomocí šifrovaného připojení přes protokol HTTPS. HTTPS poskytuje šifrování přenášených dat a zabraňuje odposlouchávání a útokům typu man-in-the-middle.

Pokud nechcete, aby se data přenášela přes veřejný internet, můžete dosáhnout vyššího zabezpečení přenosem dat přes privátní partnerský vztah mezi AWS Direct Připojení a Azure ExpressRoute. Informace o tom, jak toho dosáhnout, najdete v architektuře řešení v další části.

Architektura řešení

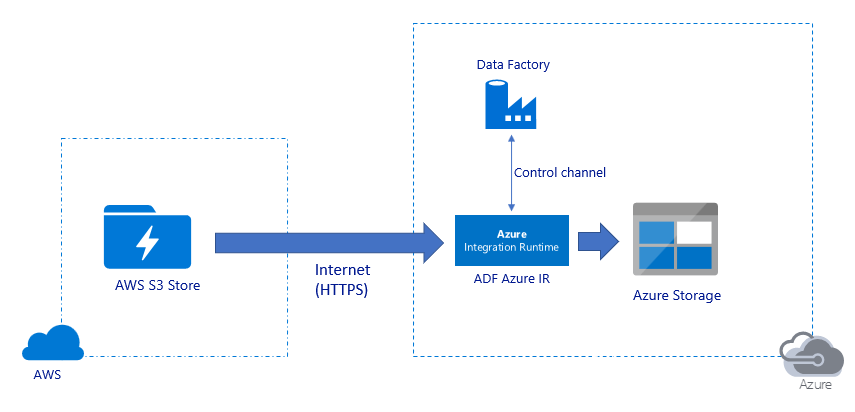

Migrace dat přes veřejný internet:

- V této architektuře se data bezpečně přenášejí pomocí protokolu HTTPS přes veřejný internet.

- Zdrojový Amazon S3 i cílová služba Azure Blob Storage nebo Azure Data Lake Storage Gen2 jsou nakonfigurované tak, aby povolovaly provoz ze všech síťových IP adres. Podívejte se na druhou architekturu, na kterou se odkazuje později na této stránce, jak můžete omezit přístup k síti na konkrétní rozsah IP adres.

- Kapacitu koňské síly můžete snadno škálovat bezserverově, abyste plně využili šířku pásma sítě a úložiště, abyste získali nejlepší propustnost pro vaše prostředí.

- Pomocí této architektury je možné dosáhnout počáteční migrace snímků i rozdílové migrace dat.

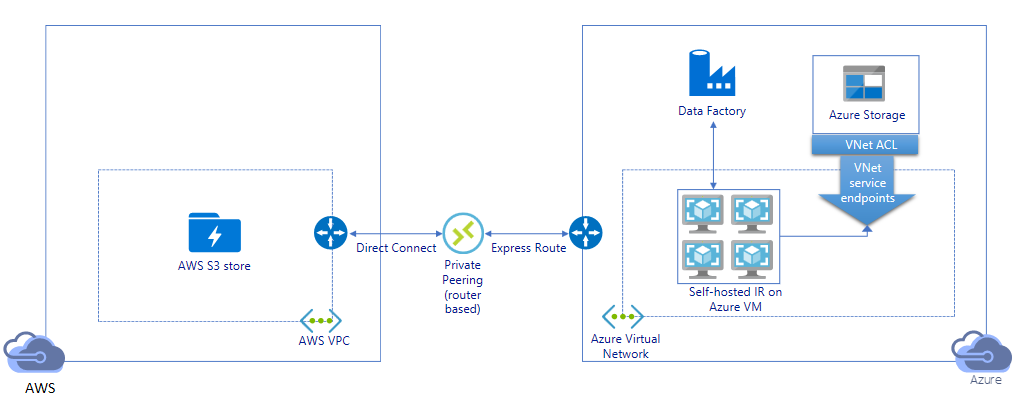

Migrace dat přes privátní propojení:

- V této architektuře se migrace dat provádí přes privátní partnerský vztah mezi AWS Direct Připojení a Azure ExpressRoute, aby data nikdy neprošla přes veřejný internet. Vyžaduje použití AWS VPC a virtuální sítě Azure.

- K dosažení této architektury je potřeba nainstalovat místní prostředí Integration Runtime ADF na virtuální počítač s Windows ve vaší virtuální síti Azure. Můžete ručně vertikálně navýšit kapacitu virtuálních počítačů ir v místním prostředí nebo škálovat na více virtuálních počítačů (až na čtyři uzly), abyste plně využili vstupně-výstupních operací za sekundu a šířku pásma sítě a úložiště.

- Pomocí této architektury je možné dosáhnout počáteční migrace dat snímků i rozdílové migrace dat.

Osvědčené postupy implementace

Ověřování a správa přihlašovacích údajů

- Pokud se chcete ověřit u účtu Amazon S3, musíte pro účet IAM použít přístupový klíč.

- Pro připojení ke službě Azure Blob Storage se podporuje více typů ověřování. Použití spravovaných identit pro prostředky Azure se důrazně doporučuje: založený na automaticky spravované identifikaci ADF v Microsoft Entra ID, umožňuje konfigurovat kanály bez zadání přihlašovacích údajů v definici propojené služby. Případně se můžete ověřit ve službě Azure Blob Storage pomocí instančního objektu, sdíleného přístupového podpisu nebo klíče účtu úložiště.

- Pro připojení k Azure Data Lake Storage Gen2 se podporuje také více typů ověřování. Použití spravovaných identit pro prostředky Azure se důrazně doporučuje, i když se dá použít i instanční objekt nebo klíč účtu úložiště.

- Pokud nepoužíváte spravované identity pro prostředky Azure, důrazně doporučujeme ukládat přihlašovací údaje ve službě Azure Key Vault , aby bylo snazší centrálně spravovat a obměňovat klíče bez úprav propojených služeb ADF. Toto je také jeden z osvědčených postupů pro CI/CD.

Počáteční migrace dat snímků

Datový oddíl se doporučuje zejména při migraci více než 100 TB dat. Pokud chcete data rozdělit, pomocí nastavení předpony vyfiltrujte složky a soubory v AmazonU S3 podle názvu a každá úloha kopírování ADF může najednou zkopírovat jeden oddíl. Pro zajištění lepší propustnosti můžete souběžně spouštět několik úloh kopírování ADF.

Pokud některé úlohy kopírování selžou kvůli přechodnému problému se sítí nebo úložištěm dat, můžete znovu spustit neúspěšnou úlohu kopírování a znovu načíst konkrétní oddíl z AWS S3. Všechny ostatní úlohy kopírování, které načítají další oddíly, nebudou ovlivněny.

Rozdílová migrace dat

Nejvýkonnější způsob, jak identifikovat nové nebo změněné soubory z AWS S3, je použití konvence vytváření názvů s časovým oddílem – když jsou data v AWS S3 čas rozdělena s informacemi o časovém řezu v názvu souboru nebo složky (například /yyyy/mm/dd/file.csv), může váš kanál snadno zjistit, které soubory nebo složky se mají přírůstkově kopírovat.

Pokud data v AWS S3 nejsou čas rozdělená na oddíly, může ADF identifikovat nové nebo změněné soubory podle hodnoty LastModifiedDate. Funguje to tak, že ADF prohledá všechny soubory z AWS S3 a zkopíruje jenom nový a aktualizovaný soubor, jehož časové razítko poslední změny je větší než určitá hodnota. Pokud máte v S3 velký počet souborů, může počáteční kontrola souborů trvat dlouhou dobu bez ohledu na to, kolik souborů odpovídá podmínce filtru. V takovém případě doporučujeme nejprve rozdělit data pomocí stejného nastavení předpony pro počáteční migraci snímků, aby kontrola souborů probíhala paralelně.

Scénáře, které vyžadují místní prostředí Integration Runtime na virtuálním počítači Azure

Bez ohledu na to, jestli migrujete data přes privátní propojení, nebo chcete povolit konkrétní rozsah IP adres na bráně firewall Amazon S3, musíte na virtuální počítač Azure s Windows nainstalovat místní prostředí Integration Runtime.

- Doporučená konfigurace pro každý virtuální počítač Azure je Standard_D32s_v3 s 32 virtuálními procesory a 128 GB paměti. Během migrace dat můžete sledovat využití procesoru a paměti virtuálního počítače IR, abyste zjistili, jestli potřebujete virtuální počítač dále vertikálně navýšit, abyste dosáhli lepšího výkonu nebo vertikálně snížit kapacitu virtuálního počítače, abyste ušetřili náklady.

- Horizontální navýšení kapacity můžete také rozšířit přidružením až čtyř uzlů virtuálních počítačů k jednomu místnímu prostředí IR. Jedna úloha kopírování spuštěná v místním prostředí IR automaticky rozdělí sadu souborů a paralelně zkopíruje všechny uzly virtuálních počítačů. Pro zajištění vysoké dostupnosti doporučujeme začít se dvěma uzly virtuálních počítačů, abyste se vyhnuli jedinému bodu selhání během migrace dat.

Omezování rychlosti

Osvědčeným postupem je provedení poc výkonu se reprezentativní ukázkovou datovou sadou, abyste mohli určit odpovídající velikost oddílu.

Začněte s jedním oddílem a jednou aktivitou kopírování s výchozím nastavením DIU. Postupně zvyšte nastavení DIU, dokud nedosáhnete limitu šířky pásma sítě nebo vstupně-výstupních operací za sekundu a šířky pásma úložišť dat, nebo jste dosáhli maximálního počtu 256 DIU povolených u jedné aktivity kopírování.

Dále postupně zvyšte počet souběžných aktivit kopírování, dokud nedosáhnete limitů vašeho prostředí.

Pokud narazíte na chyby omezování hlášené aktivitou kopírování ADF, snižte nastavení souběžnosti nebo DIU v ADF nebo zvažte zvýšení limitů šířky pásma nebo IOPS sítě a úložišť dat.

Odhad ceny

Poznámka:

Jedná se o hypotetický příklad cen. Vaše skutečné ceny závisí na skutečné propustnosti ve vašem prostředí.

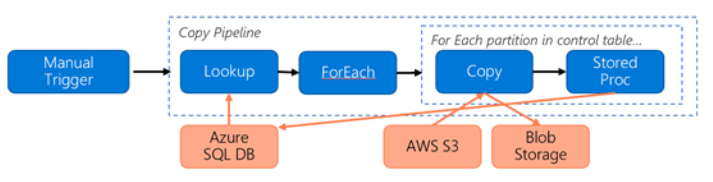

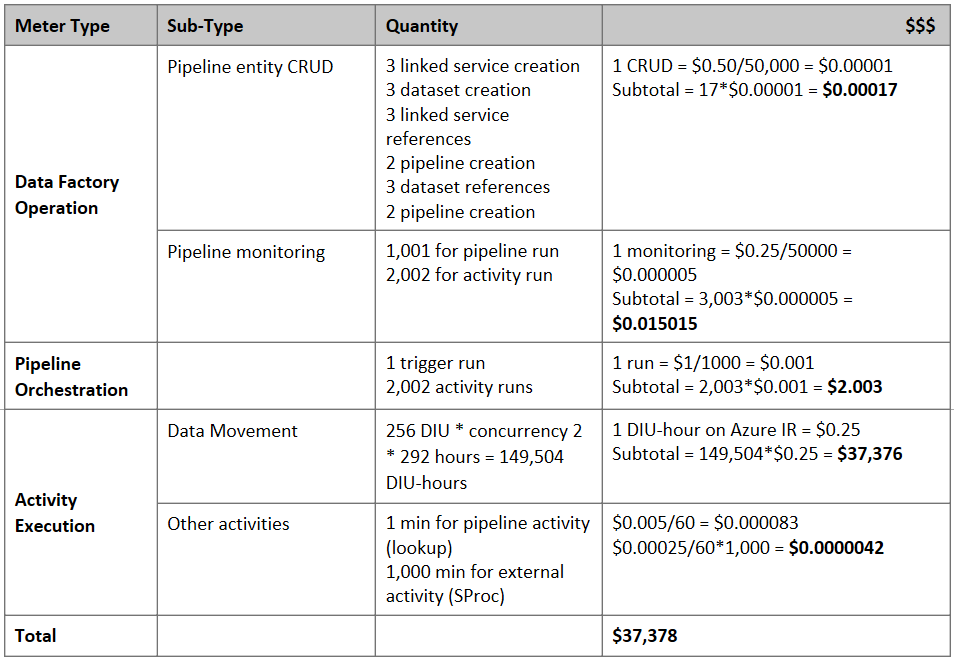

Vezměte v úvahu následující kanál vytvořený pro migraci dat z S3 do služby Azure Blob Storage:

Předpokládejme následující:

- Celkový objem dat je 2 PB

- Migrace dat přes HTTPS s využitím první architektury řešení

- 2 PB je rozděleno do 1 kB oddílů a každá kopie přesune jeden oddíl.

- Každá kopie je nakonfigurovaná s DIU=256 a dosahuje propustnosti 1 GB/s.

- Souběžnost ForEach je nastavená na 2 a agregovaná propustnost je 2 GB/s.

- Dokončení migrace trvá celkem 292 hodin.

Tady je odhadovaná cena na základě výše uvedených předpokladů:

Další odkazy

- Konektor Amazon Simple Storage Service

- Konektor služby Azure Blob Storage

- Konektor Azure Data Lake Storage Gen2

- průvodce laděním výkonu aktivita Copy

- Vytvoření a konfigurace místního prostředí Integration Runtime

- Vysoká dostupnost a škálovatelnost místního prostředí Integration Runtime

- Aspekty zabezpečení přesunu dat

- Ukládání přihlašovacích údajů ve službě Azure Key Vault

- Přírůstkové kopírování souboru na základě názvu souboru rozděleného podle času

- Kopírování nových a změněných souborů na základě funkce LastModifiedDate

- Stránka s cenami ADF

Template

Tady je šablona , se kterou můžete začít migrovat petabajty dat sestávajících ze stovek milionů souborů z AmazonU S3 do Azure Data Lake Storage Gen2.