Zóny a kontejnery Data Lake

Před vstupem do datového jezera je důležité naplánovat datovou strukturu. Pokud máte plán, můžete efektivně používat zabezpečení, dělení a zpracování.

Přehled datových jezer najdete v tématu Přehled služby Azure Data Lake Storage pro analýzy v cloudovém měřítku.

Přehled

Vaše tři účty data lake by se měly srovnat s typickými vrstvami data lake.

| Číslo jezera | Vrstvy | Číslo kontejneru | Název kontejneru |

|---|---|---|---|

| 1 | Nezpracováno | 1 | Přistání |

| 1 | Nezpracováno | 2 | Shody |

| 2 | Obohacený | 1 | Standardizované |

| 2 | Uspořádáno | 2 | Datové produkty |

| 3 | Vývoj | 1 | Analytický sandbox |

| 3 | Vývoj | # | Primární číslo úložiště Synapse |

Předchozí tabulka ukazuje standardní počet kontejnerů, které doporučujeme pro cílovou zónu dat. Výjimkou tohoto doporučení je, pokud jsou pro data v kontejneru vyžadovány různé zásady obnovitelného odstranění. Tyto požadavky určují, jestli potřebujete více kontejnerů.

Poznámka

V každé cílové zóně dat jsou znázorněna tři datová jezera. Datové jezero se nachází ve třech účtech Data Lake, několika kontejnerech a složkách, ale představuje jedno logické datové jezero pro vaši cílovou zónu dat.

V závislosti na vašich požadavcích můžete chtít konsolidovat nezpracované, rozšířené a kurátorované vrstvy do jednoho účtu úložiště. Zachovejte další účet úložiště s názvem "vývoj" pro uživatele dat, aby mohli přinést další užitečné datové produkty.

Další informace o oddělení účtů Data Lake najdete v tématu Účty úložiště v logickém datovém jezeře.

Povolte Azure Storage pomocí funkce hierarchického prostoru názvů, která umožňuje efektivně spravovat soubory. Funkce hierarchického prostoru názvů uspořádá objekty a soubory v rámci účtu do hierarchie adresářů a vnořených podadresářů. Tato hierarchie je uspořádaná stejným způsobem jako systém souborů v počítači.

Když váš modul pro příjem dat nebo aplikace pro onboarding zaregistruje nový systém záznamů, vytvoří požadované složky v kontejnerech v nezpracovaných, obohacených a standardizovaných datových vrstvách. Pokud zdrojová datová aplikace ingestuje data, tým datové aplikace potřebuje k vytvoření složek a skupin zabezpečení tým cílové zóny dat. Zadejte název instance nebo spravovanou identitu do správné skupiny a přiřaďte úroveň oprávnění. Zdokumentujte tento proces pro cílové zóny dat a týmy datových aplikací.

Další informace o týmech najdete v tématu Vysvětlení rolí a týmů pro analýzy v cloudovém měřítku v Azure.

Každý datový produkt by měl mít v kontejneru datových produktů dvě složky, které vlastní váš datový produktový tým.

V rozšířené vrstvě standardizovaného kontejneru existují dvě složky na zdrojový systém rozdělené klasifikací. Díky této struktuře může váš tým samostatně ukládat data s různými klasifikacemi zabezpečení a dat a přiřazovat jim různý přístup k zabezpečení.

Váš standardizovaný kontejner potřebuje obecnou složku pro důvěrná nebo nižší data a citlivou složku pro osobní údaje. Řízení přístupu k těmto složkám pomocí seznamů řízení přístupu (ACL). Můžete vytvořit datovou sadu se všemi odebranými osobními údaji a uložit ji do obecné složky. Můžete mít jinou datovou sadu, která zahrnuje všechny osobní údaje ve složce s citlivými osobními údaji.

Kombinace seznamů ACL a skupin Microsoft Entra omezuje přístup k datům. Tyto seznamy a skupiny řídí, k jakým jiným skupinám mají a nemají přístup. Vlastníci dat a týmy datových aplikací můžou schválit nebo odmítnout přístup k datovým prostředkům.

Další informace naleznete v tématu Správa přístupu k datům a Omezená data.

Upozorňující

Některé softwarové produkty nepodporují připojení kořene kontejneru Data Lake. Z tohoto omezení by každý kontejner data lake v nezpracovaných, kurátorovaných, obohacených a vývojových vrstvách měl obsahovat jednu složku, která se rozdělí do více složek. Pečlivě nastavte oprávnění ke složce. Když vytvoříte novou složku z kořenového adresáře, výchozí seznam ACL nadřazeného adresáře určuje výchozí seznam ACL podřízeného adresáře a přístup k seznamu ACL. Seznam ACL podřízeného souboru nemá výchozí seznam ACL.

Další informace najdete v tématu Seznamy řízení přístupu (ACL) v Azure Data Lake Storage Gen2.

Nezpracovaná vrstva nebo datové jezero jedna

Nezpracovanou vrstvu si můžete představit jako nádrž, která ukládá data v přirozeném a původním stavu. Je nefiltrovaný a neověřený. Data můžete uložit v původním formátu, jako je JSON nebo CSV. Nebo může být nákladově efektivní uložit obsah souboru jako sloupec ve komprimovaném formátu souboru, jako je Avro, Parquet nebo Databricks Delta Lake.

Tato nezpracovaná data jsou neměnná. Ponechte nezpracovaná data zamknutá a pokud udělíte oprávnění všem uživatelům, automatizovaným nebo lidským uživatelům, ujistěte se, že jsou jen pro čtení. Tuto vrstvu můžete uspořádat pomocí jedné složky na zdrojový systém. Udělte každému procesu příjmu dat přístup k zápisu jenom ke své přidružené složce.

Při načítání dat ze zdrojových systémů do nezpracované zóny se můžete rozhodnout:

- Úplné načtení pro extrahování úplné datové sady.

- Rozdílové načtení pro načtení pouze změněná data

Označte zvolený vzor načítání ve struktuře složek, abyste zjednodušili použití pro uživatele dat.

Nezpracovaná data ze zdrojovýchsystémůch Každý proces příjmu dat by měl mít přístup k zápisu pouze ke své přidružené složce.

Rozdíly mezi úplným zatížením a rozdílovými zatíženími jsou:

Úplné načtení – dokončení dat ze zdroje je možné připojit, pokud:

- Objem dat ve zdroji je malý.

- Zdrojový systém neudržuje pole časového razítka, které identifikuje, jestli byla data přidána, aktualizována nebo odstraněna.

- Zdrojový systém pokaždé přepíše úplná data.

Rozdílové načtení – Přírůstková data ze zdroje se dají připojit, pokud:

- Objem dat ve zdroji je velký.

- Zdrojový systém udržuje pole časového razítka, které identifikuje, jestli byla data přidána, aktualizována nebo odstraněna.

- Zdrojový systém vytváří a aktualizuje soubory o změnách dat.

Nezpracované datové jezero se skládá z kontejnerů pro přistání a shodu. Každý kontejner používá 100% povinnou strukturu složek specifickou pro svůj účel.

Rozložení cílového kontejneru

Cílový kontejner je vyhrazený pro nezpracovaná data z rozpoznané zdrojového systému. Modul pro příjem dat nebo zdrojově sladěná datová aplikace načte data, která nejsou v původním podporovaném formátu.

.

|-Landing

|--Log

|---{Application Name}

|--Master and Reference

|---{Source System}

|--Telemetry

|---{Source System}

|----{Application}

|--Transactional

|---{Source System}

|----{Entity}

|-----{Version}

|------Delta

|-------{date (ex. rundate=2019-08-22)}

|------Full

Kontejner shody s nezpracovanou vrstvou

Nezpracovaná vrstva obsahuje data odpovídající kvalitě dat. Při kopírování dat do cílového kontejneru se zpracování dat a výpočetní prostředí aktivuje ke zkopírování dat z cílového kontejneru do kontejneru shody. V této první fázi se data převedou do formátu delta lake a převedou se do vstupní složky. Při spuštění kvality dat se záznamy, které předávají, zkopírují do výstupní složky. Záznamy, které selžou, přistanou do chybové složky.

.

|-Conformance

|--Log

|---{Application Name}

|--Master and Reference

|---{Source System}

|--Telemetry

|---{Source System}

|----{Application}

|--Transactional

|---{Source System}

|----{Entity}

|-----{Version}

|------Delta

|-------Input

|--------{date (ex. rundate=2019-08-22)}

|-------Output

|--------{date (ex. rundate=2019-08-22)}

|-------Error

|--------{date (ex. rundate=2019-08-22)}

|------Full

|-------Input

|--------{date (ex. rundate=2019-08-22)}

|-------Output

|--------{date (ex. rundate=2019-08-22)}

|-------Error

|--------{date (ex. rundate=2019-08-22)}

Tip

Zamyslete se nad scénáři, ve kterých možná budete muset znovu sestavit analytickou platformu od začátku. Zvažte nejpodrobnější data, která potřebujete k opětovnému sestavení podřízených úložišť dat pro čtení. Ujistěte se, že máte pro klíčové komponenty zavedený plán provozní kontinuity a zotavení po havárii.

Rozšířená vrstva nebo datové jezero dvě

Rozšířenou vrstvu si můžete představit jako filtrační vrstvu. Odstraňuje nečistoty a může také zahrnovat obohacení.

Kontejner standardizace obsahuje systémy záznamů a hlavních serverů. Složky jsou nejprve segmentovány podle oblasti předmětu a pak podle entity. Data jsou k dispozici ve sloučených tabulkách rozdělených do oddílů, které jsou optimalizované pro využití analýz.

Standardizovaný kontejner

.

|-Standardized

|--Log

|---{Application Name}

|--Master and Reference

|---{Source System}

|--Telemetry

|---{Source System}

|----{Application}

|--Transactional

|---{Source System}

|----{Entity}

|-----{Version}

|------General

|--------{date (ex. rundate=2019-08-22)}

|-------Sensitive

|--------{date (ex. rundate=2019-08-22)}

Poznámka

Tato datová vrstva se považuje za stříbrnou vrstvu nebo zdroj dat pro čtení. Data v této vrstvě nemají žádné transformace kromě kvality dat, převodu delta lake a zarovnání datového typu.

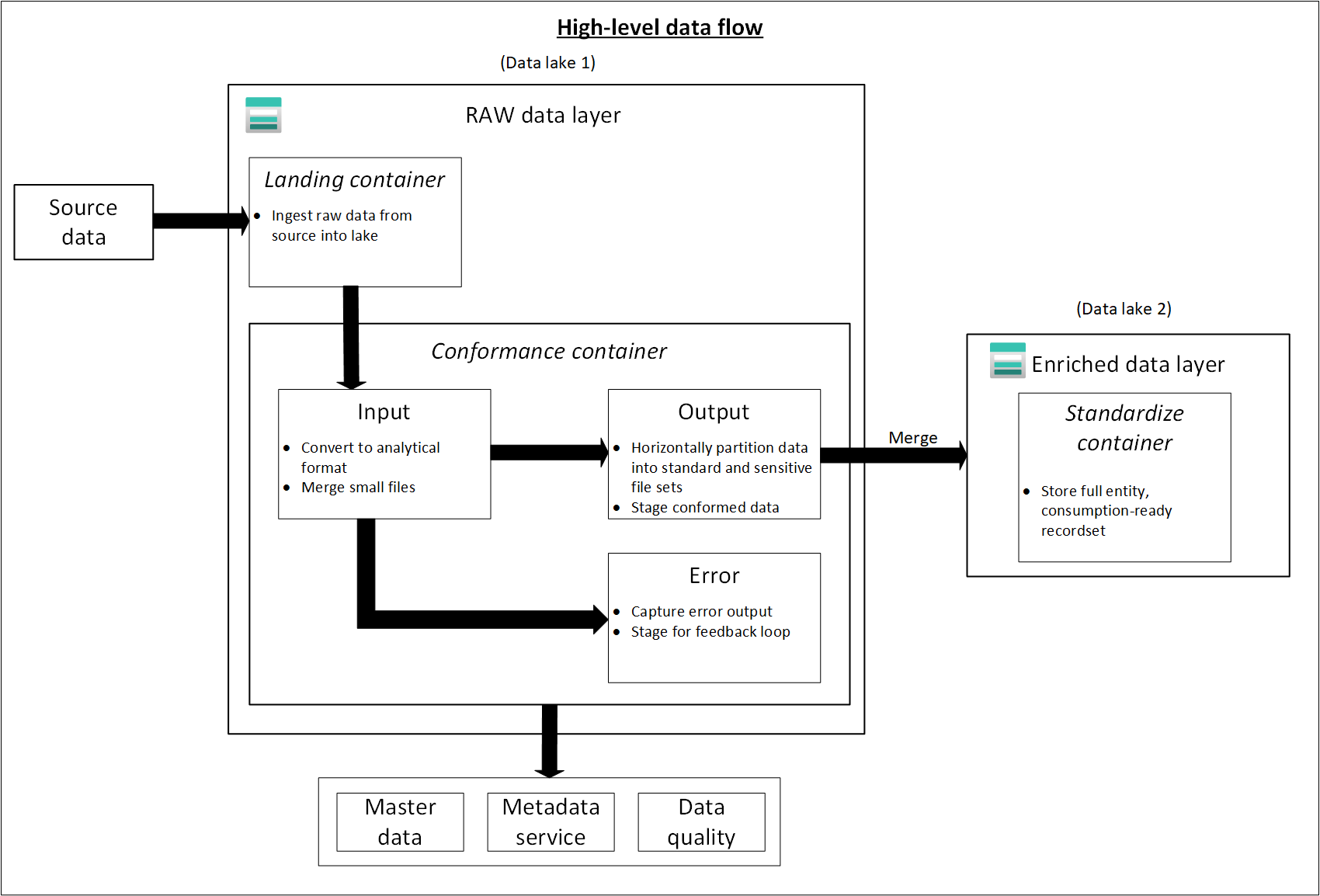

Následující diagram znázorňuje tok datových jezer a kontejnerů ze zdrojových dat do standardizovaného kontejneru.

Kurátorovaná vrstva nebo datové jezero dvě

Vaše kurátorovaná vrstva je vrstva spotřeby. Je optimalizovaná pro analýzy místo příjmu nebo zpracování dat. Kurátorovaná vrstva může ukládat data do denormalizovaných datových mart nebo hvězdicových schémat.

Data z vašeho standardizovaného kontejneru se transformují na vysoce hodnotné datové produkty, které se obsluhují příjemcům dat. Tato data mají strukturu. Může se obsluhovat příjemcům, jako jsou poznámkové bloky datových věd, nebo prostřednictvím jiného úložiště dat pro čtení, jako je Azure SQL Database.

Pomocí nástrojů, jako je Spark nebo Data Factory, můžete provádět dimenzionální modelování místo toho, abyste je prováděli v databázovém stroji. Toto použití nástrojů se stává klíčovým bodem, pokud chcete, aby vaše jezero bylo jediným zdrojem pravdy.

Pokud modelujete mimo své jezero, možná budete chtít publikovat modely zpět do jezera kvůli konzistenci. Tato vrstva není náhradou za datový sklad. Jeho výkon obvykle není vhodný pro responzivní řídicí panely nebo koncové uživatele a interaktivní analýzy uživatelů. Tato vrstva je nejvhodnější pro interní analytiky a datové vědce, kteří provozují rozsáhlé, improvizované dotazy nebo analýzy nebo pro pokročilé analytiky, kteří nemají potřeby generování sestav s časovým měřítkem. Vzhledem k tomu, že náklady na úložiště jsou ve vašem datovém jezeře nižší než u datového skladu, může být nákladově efektivní udržovat podrobná a nízká data ve vašem jezeře. Ukládejte agregovaná data do skladu. Tyto agregace můžete vygenerovat pomocí Sparku nebo Azure Data Factory. Před načtením do datového skladu je zachovejte do datového jezera.

Datové prostředky v této zóně jsou obvykle vysoce řízené a dobře zdokumentované. Přiřaďte oprávnění podle oddělení nebo funkce a uspořádejte oprávnění podle skupiny příjemců nebo datového tržiště.

Kontejner datových produktů

.

|-{Data Product}

|---{Entity}

|----{Version}

|-----General

|-------{date (ex. rundate=2019-08-22)}

|------Sensitive

|-------{date (ex. rundate=2019-08-22)}

Tip

Když přistanete data do jiného úložiště dat pro čtení, jako je Azure SQL Database, ujistěte se, že máte kopii těchto dat umístěnou ve kurátorovaných datech. Vaši uživatelé datového produktu se řídí hlavním úložištěm dat pro čtení nebo instancí služby Azure SQL Database, ale můžou také zkoumat data pomocí dalších nástrojů, pokud data zpřístupníte ve vašem datovém jezeře.

Vývojová vrstva nebo data lake three

Příjemci dat můžou přinést další užitečné datové produkty spolu s daty přijatými do vašeho standardizovaného kontejneru.

V tomto scénáři může vaše datová platforma těmto příjemcům přidělit oblast analytického sandboxu. V sandboxu můžou generovat cenné přehledy pomocí kurátorovaných dat a datových produktů, které přinášejí. Pokud například tým datových věd chce určit nejlepší strategii umístění produktů pro novou oblast, může přinést další datové produkty, jako jsou demografické údaje zákazníků a údaje o využití, z podobných produktů v této oblasti. Tým může využít přehledy o prodeji s vysokou hodnotou z těchto dat k analýze vhodné a nabízené strategie na trhu produktů.

Poznámka

Oblast izolovaného prostoru analýzy je pracovní oblastí pro jednotlivce nebo malou skupinu spolupracovníků. Složky oblasti sandboxu mají speciální sadu zásad, které brání pokusům o použití této oblasti jako součásti produkčního řešení. Tyto zásady omezují celkové dostupné úložiště a dobu uložení dat.

Tyto datové produkty jsou obvykle neznámé kvality a přesnosti. Jsou stále kategorizovány jako datové produkty, ale jsou dočasné a relevantní pouze pro skupinu uživatelů, která data používá.

Jakmile tyto datové produkty zraly, může vaše firma tyto datové produkty propagovat do kurátorované datové vrstvy. Pokud chcete, aby vaše datové produktové týmy odpovídaly za nové datové produkty, poskytněte týmům vyhrazenou složku ve kurátorované zóně dat. Můžou ukládat nové výsledky do složky a sdílet je s ostatními týmy ve vaší organizaci.

Poznámka

Pro každý pracovní prostor Azure Synapse, který vytvoříte, použijte data Lake three k vytvoření kontejneru, který se použije jako primární úložiště. Tento kontejner zastaví, aby pracovní prostory Azure Synapse zasahovaly do limitů propustnosti kurátorovaných a obohacených zón.

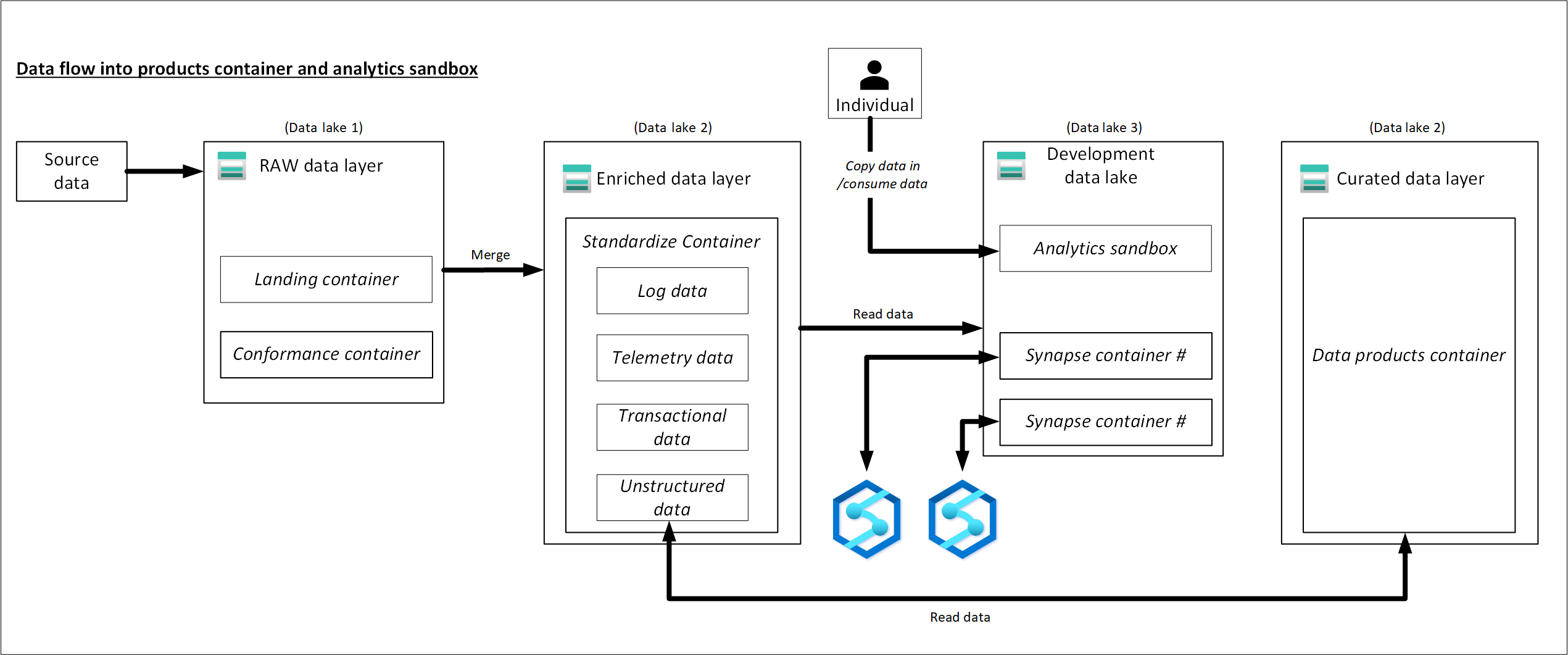

Příklad toku dat do produktů a analytického sandboxu

Následující diagram zkompiluje informace v tomto článku a ukazuje, jak data procházejí datovými produkty a analytickým sandboxem.