Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Důležité

Azure Cosmos DB for PostgreSQL se už pro nové projekty nepodporuje. Tuto službu nepoužívejte pro nové projekty. Místo toho použijte jednu z těchto dvou služeb:

Azure Cosmos DB for NoSQL můžete použít pro distribuované databázové řešení navržené pro vysoce škálovatelné scénáře s 99,999% smlouvou o úrovni služeb (SLA), okamžitým automatickým škálováním a automatickým převzetím služeb při selhání napříč několika oblastmi.

Použijte funkci Elastic Clusters služby Azure Database for PostgreSQL pro horizontálně dělené PostgreSQL pomocí opensourcového rozšíření Citus.

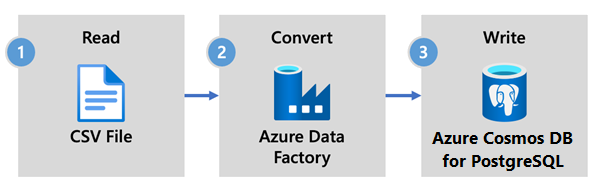

Azure Data Factory je cloudová služba ETL a integrace dat. Umožňuje vytvářet pracovní postupy řízené daty pro přesun a transformaci dat ve velkém měřítku.

Pomocí služby Data Factory můžete vytvářet a plánovat pracovní postupy řízené daty (označované jako kanály), které ingestují data z různorodých úložišť dat. Pipelines se můžou spouštět na místě, v Azure nebo u jiných poskytovatelů cloudu pro analýzy a vytváření sestav.

Data Factory obsahuje datovou jímku pro službu Azure Cosmos DB for PostgreSQL. Jímka dat umožňuje přenést data (relační, NoSQL, soubory data Lake) do tabulek Azure Cosmos DB for PostgreSQL pro ukládání, zpracování a vytváření sestav.

Důležité

Služba Data Factory v současnosti nepodporuje privátní koncové body pro službu Azure Cosmos DB for PostgreSQL.

Data Factory pro příjem dat v reálném čase

Tady jsou klíčové důvody, proč si vybrat Azure Data Factory pro příjem dat do služby Azure Cosmos DB for PostgreSQL:

- Snadné použití – nabízí vizuální prostředí bez kódu pro orchestraci a automatizaci přesunu dat.

- Výkon – využívá plnou kapacitu základní šířky pásma sítě až do 5 GiB/s propustnosti.

- Integrované konektory – Integruje všechny zdroje dat s více než 90 integrovanými konektory.

- Nákladově efektivní – podporuje průběžné platby, plně spravovanou bezserverovou cloudovou službu, která se škáluje na vyžádání.

Postup použití služby Data Factory

V tomto článku vytvoříte datový kanál pomocí uživatelského rozhraní služby Data Factory. Datový kanál v této datové továrně kopíruje data z Azure Blob Storage do databáze. Seznam úložišť dat, která jsou podporovaná jako zdroje a jímky, najdete v tabulce podporovaných úložišť dat.

Ve službě Data Factory můžete pomocí aktivity kopírování kopírovat data mezi úložišti dat umístěnými místně a v cloudu do služby Azure Cosmos DB for PostgreSQL. Pokud se službou Data Factory začínáte, tady je stručný průvodce, jak začít:

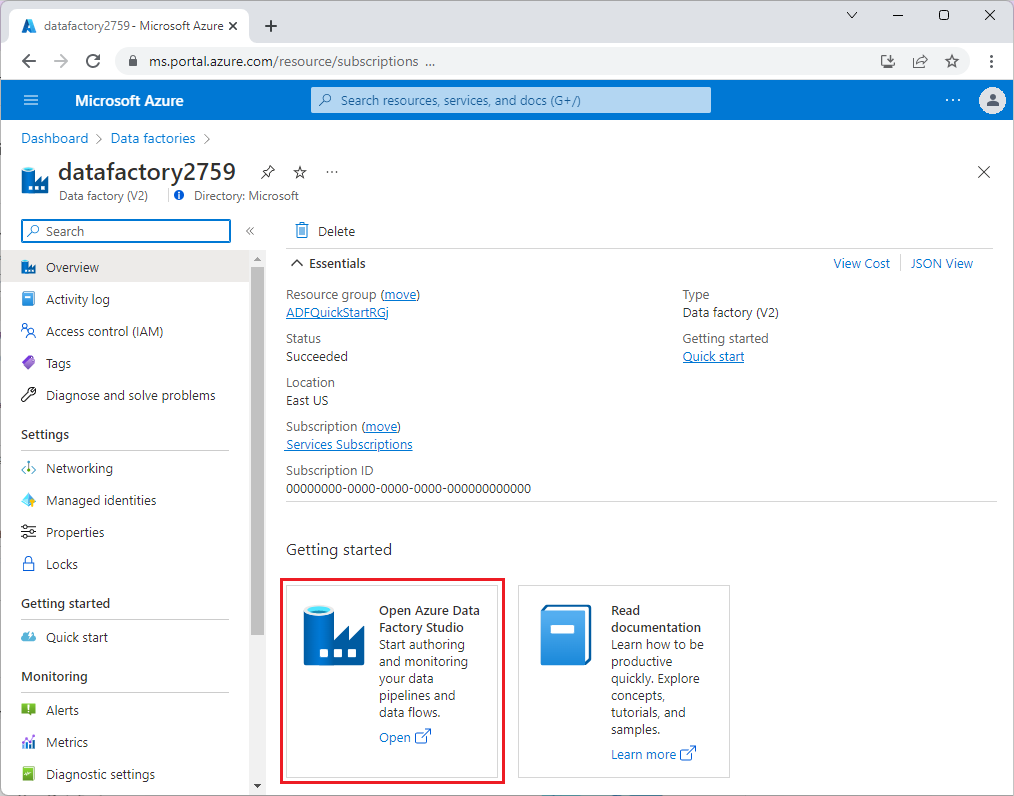

Po zřízení služby Data Factory přejděte do datové továrny a spusťte Azure Data Factory Studio. Zobrazí se domovská stránka služby Data Factory, jak je znázorněno na následujícím obrázku:

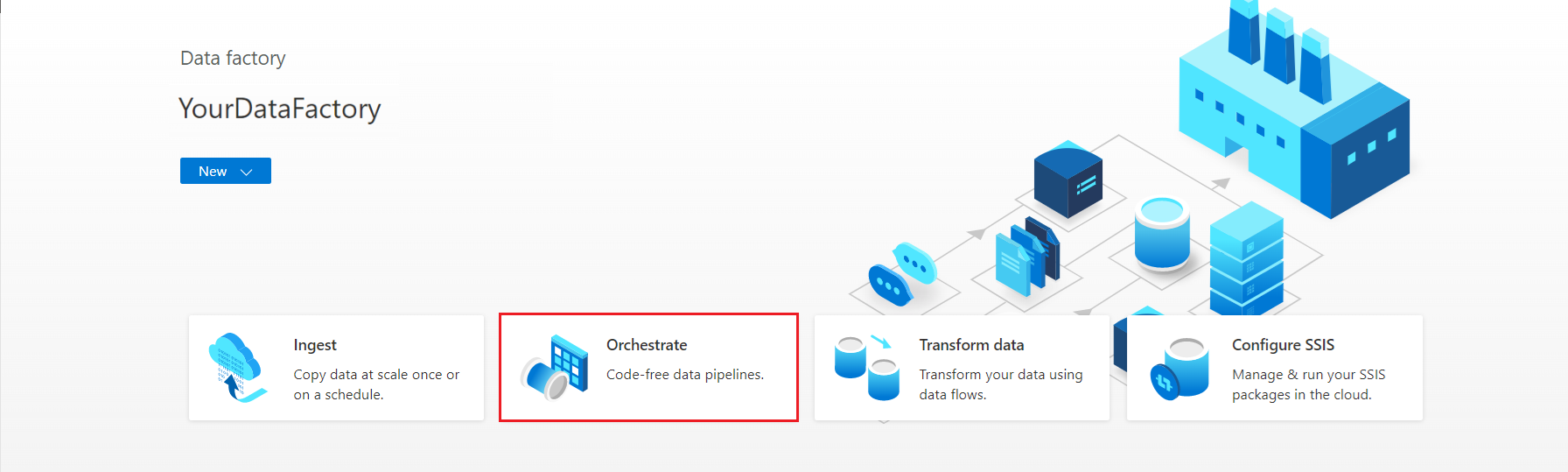

Na domovské stránce aplikace Azure Data Factory Studio vyberte Orchestrate.

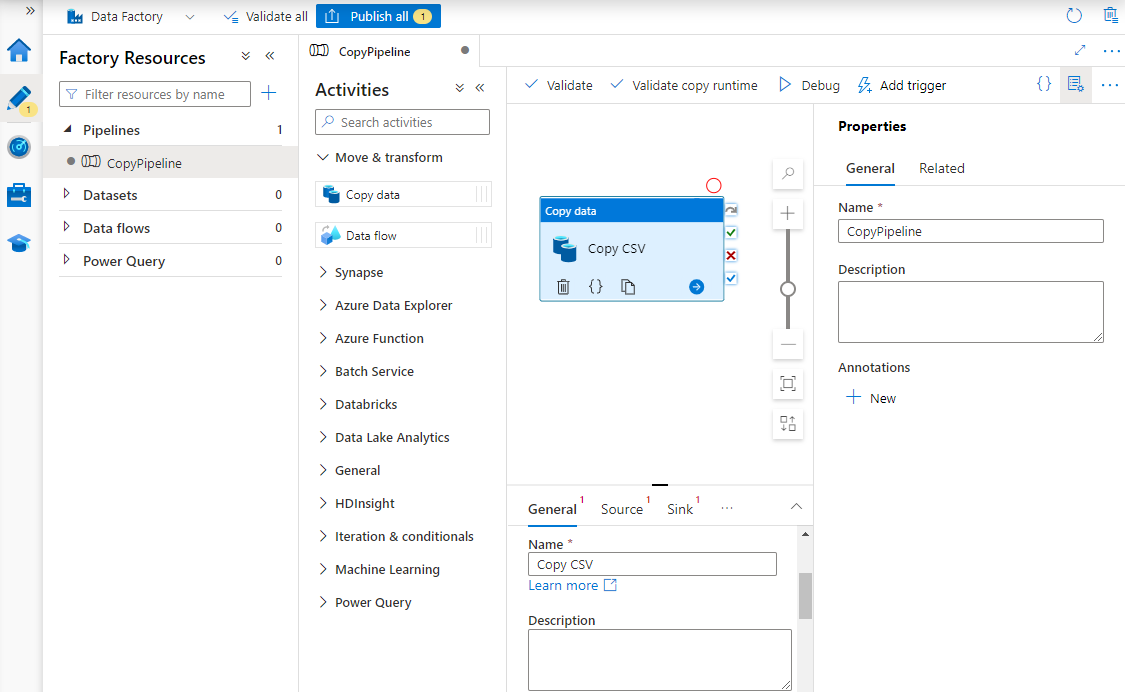

V části Vlastnosti zadejte název kanálu.

V sadě nástrojů Aktivity rozbalte kategorii Přesunout a transformovat a přetáhněte aktivitu Kopírování dat na plochu návrháře potrubí. V dolní části podokna návrháře na kartě Obecné zadejte název aktivity kopírování.

Konfigurovat zdroj.

Na stránce Aktivity vyberte kartu Zdroj. Vyberte Možnost Nový a vytvořte zdrojovou datovou sadu.

V dialogovém okně Nová datová sada vyberte Azure Blob Storage a pak vyberte Pokračovat.

Zvolte typ formátu dat a pak vyberte Pokračovat.

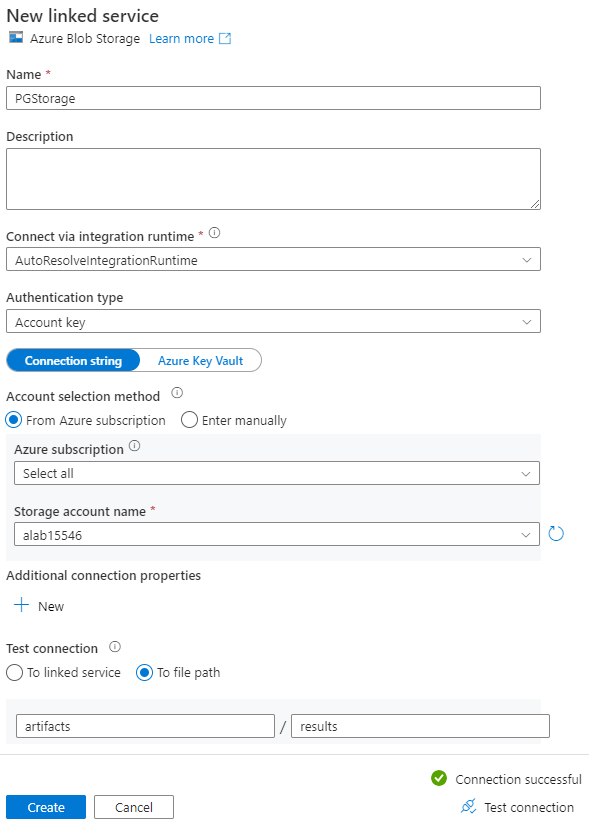

Na stránce Nastavit vlastnosti v části Propojená služba vyberte Nový.

Na stránce Nová propojená služba zadejte název propojené služby a ze seznamu Název účtu úložiště vyberte svůj účet.

V části Test připojení vyberte Do souborové cesty, zadejte kontejner a adresář, ke kterému se chcete připojit, a pak vyberte Test připojení.

Výběrem možnosti Vytvořit uložte konfiguraci.

Na obrazovce Nastavit vlastnosti vyberte OK.

Konfigurace jímky

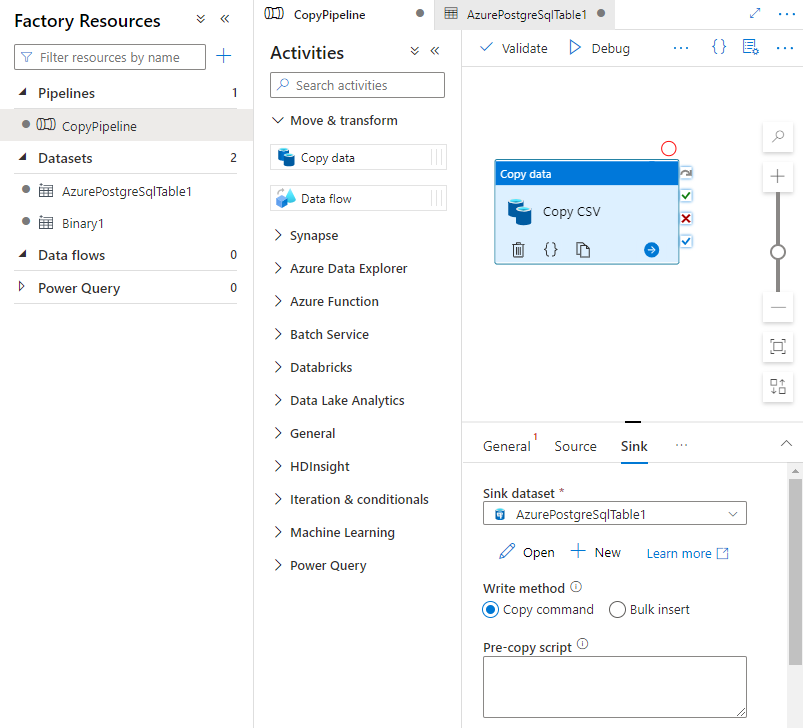

Na stránce Aktivity vyberte kartu Jímka. Vyberte Nové k vytvoření datové sady jímky.

V dialogovém okně Nová datová sada vyberte Azure Database for PostgreSQL a pak vyberte Pokračovat.

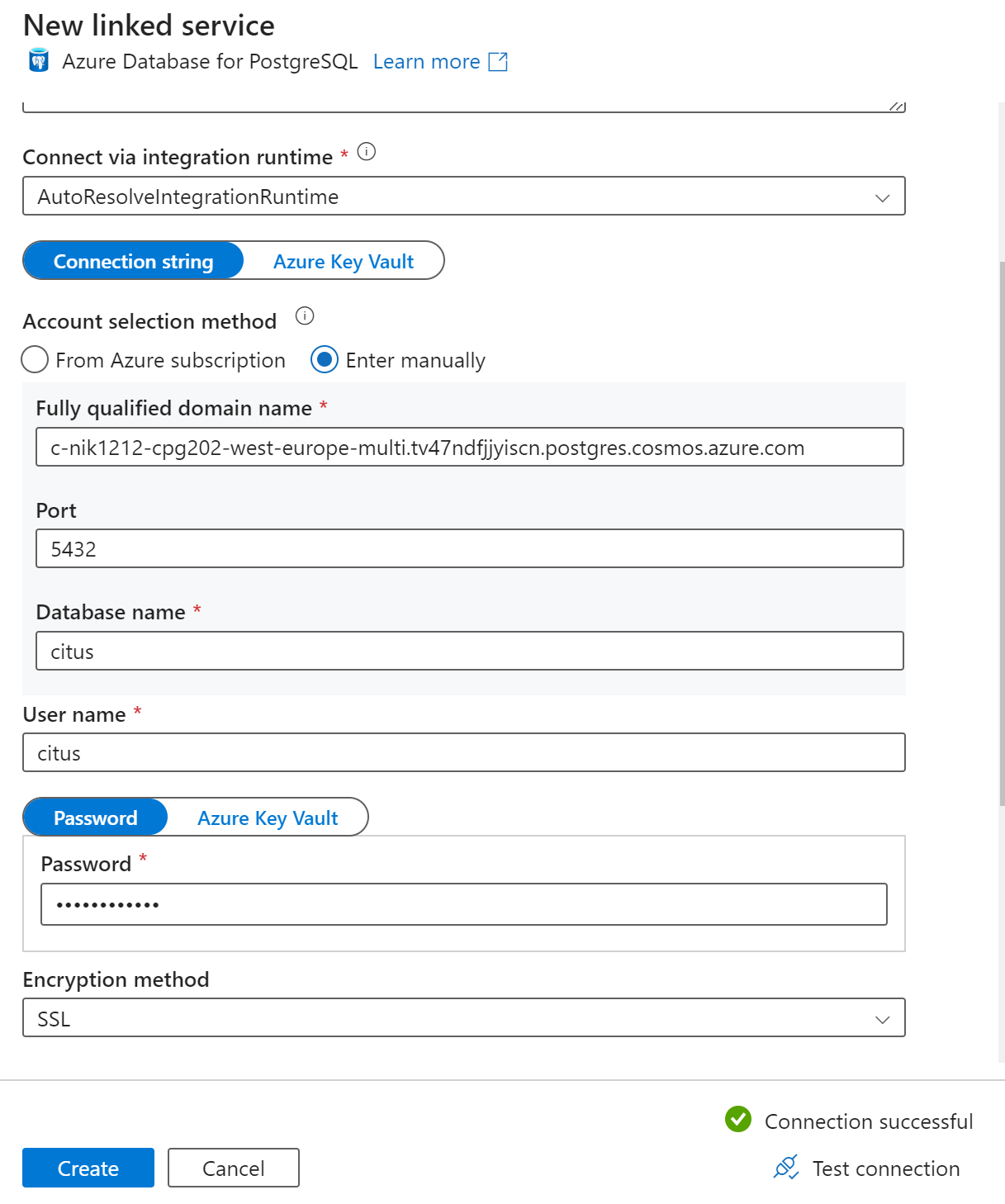

Na stránce Nastavit vlastnosti v části Propojená služba vyberte Nový.

Na stránce Nová propojená služba zadejte název propojené služby a v metodě výběru účtu vyberte Zadat ručně.

Do pole plně kvalifikovaný název domény zadejte jméno koordinátora vašeho clusteru. Název koordinátora můžete zkopírovat ze stránky Přehled vašeho clusteru Azure Cosmos DB for PostgreSQL.

Ponechte výchozí port 5432 v poli Port pro přímé připojení ke koordinátorovi nebo ho nahraďte portem 6432 pro připojení ke spravovanému portu PgBouncer .

Zadejte název databáze v clusteru a zadejte přihlašovací údaje pro připojení k němu.

V rozevíracím seznamu Metoda šifrování vyberte PROTOKOL SSL.

Výběrem Test připojení v dolní části panelu ověřte konfiguraci příjemce.

Výběrem možnosti Vytvořit uložte konfiguraci.

Na obrazovce Nastavit vlastnosti vyberte OK.

Na kartě Jímka na stránce Aktivity vyberte Otevřít vedle rozevíracího seznamu Datová sada jímky a vyberte název tabulky v cílovém clusteru, ve kterém chcete ingestovat data.

V části Zapisovat metodu vyberte Kopírovat příkaz.

Na panelu nástrojů nad plátnem vyberte Ověřit a ověřte nastavení kanálu. Opravte všechny chyby, znovu proveďte ověření a ujistěte se, že je pipeline úspěšně ověřena.

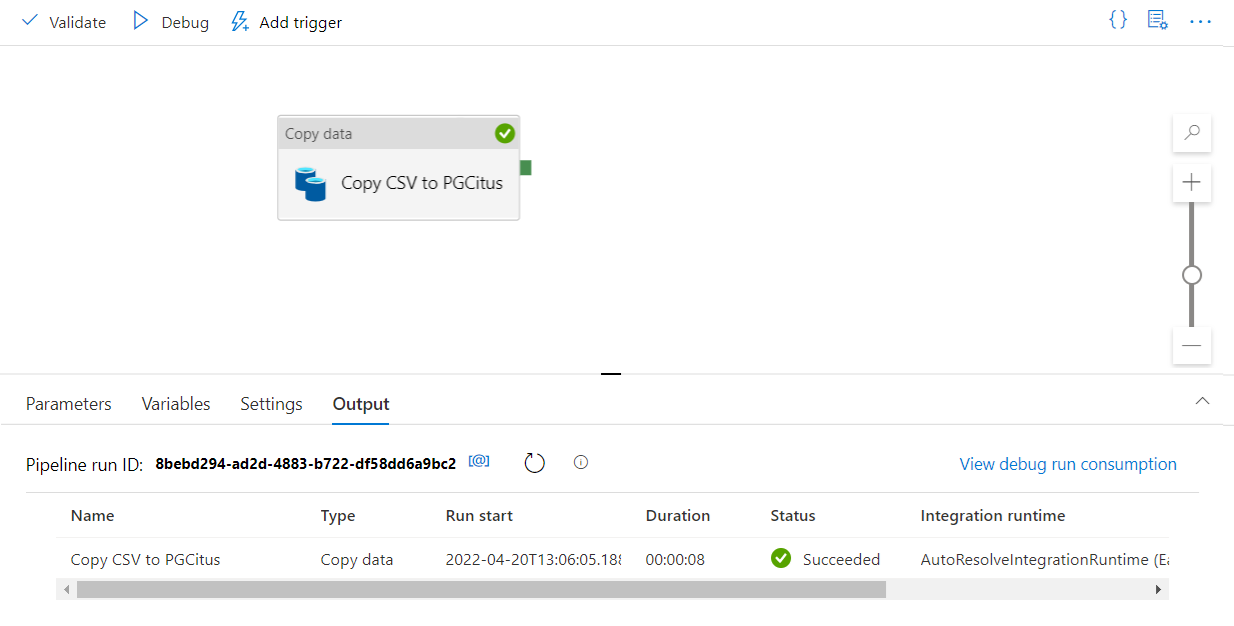

Výběrem možnosti Ladit na panelu nástrojů spusťte pipeline.

Jakmile se potrubí úspěšně spustí, vyberte na horním panelu nástrojů možnost Publikovat vše. Tato akce publikuje entity (datové sady a kanály), které jste vytvořili ve službě Data Factory.

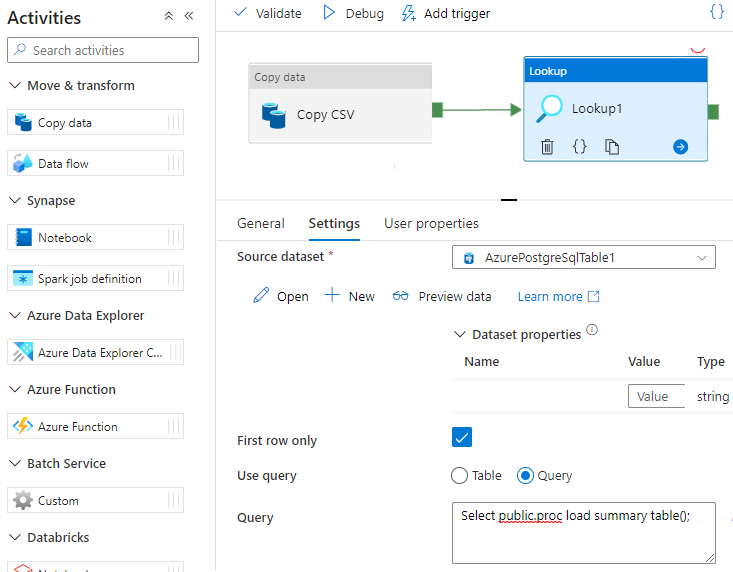

Volání uložené procedury v aplikaci Data Factory

V některých konkrétních scénářích můžete chtít volat uloženou proceduru nebo funkci pro přesun agregovaných dat z pracovní tabulky do souhrnné tabulky. Služba Data Factory nenabízí aktivitu uložených procedur pro službu Azure Cosmos DB for PostgreSQL, ale jako alternativní řešení můžete použít aktivitu Vyhledávání s dotazem k volání uložené procedury, jak je znázorněno níže:

Další kroky

- Zjistěte, jak vytvořit řídicí panel v reálném čase pomocí služby Azure Cosmos DB for PostgreSQL.

- Zjistěte, jak přesunout úlohu do služby Azure Cosmos DB for PostgreSQL.