Nasazení systému SAP HANA se škálováním na více instancí s pohotovostním uzlem na virtuálních počítačích Azure pomocí služby Azure NetApp Files v Red Hat Enterprise Linuxu

Tento článek popisuje, jak nasadit vysoce dostupný systém SAP HANA v konfiguraci se škálováním na více systémů s pohotovostním režimem na virtuálních počítačích Azure Red Hat Enterprise Linux pomocí služby Azure NetApp Files pro sdílené svazky úložiště.

V ukázkových konfiguracích, příkazech instalace atd. je instance HANA 03 a ID systému HANA je HN1. Příklady jsou založené na HANA 2.0 SP4 a Red Hat Enterprise Linuxu pro SAP 7.6.

Poznámka:

Tento článek obsahuje odkazy na termíny, které už Microsoft nepoužívá. Když se tyto podmínky odeberou ze softwaru, odebereme je z tohoto článku.

Než začnete, projděte si následující poznámky a dokumenty SAP:

- Dokumentace ke službě Azure NetApp Files

- SAP Note 1928533 zahrnuje:

- Seznam velikostí virtuálních počítačů Azure podporovaných pro nasazení softwaru SAP

- Důležité informace o kapacitě pro velikosti virtuálních počítačů Azure

- Podporované kombinace softwaru SAP a operačního systému (OS) a databází

- Požadovaná verze jádra SAP pro Windows a Linux v Microsoft Azure

- SAP Note 2015553: Uvádí požadavky pro nasazení softwaru SAP s podporou SAP v Azure

- SAP Note [2002167] doporučil nastavení operačního systému pro Red Hat Enterprise Linux.

- SAP Note 2009879 obsahuje pokyny PRO SAP HANA pro Red Hat Enterprise Linux

- SAP Note 3108302 obsahuje pokyny PRO SAP HANA pro Red Hat Enterprise Linux 9.x

- SAP Note 2178632: Obsahuje podrobné informace o všech metrikách monitorování hlášených pro SAP v Azure.

- SAP Note 2191498: Obsahuje požadovanou verzi agenta hostitele SAP pro Linux v Azure.

- SAP Note 2243692: Obsahuje informace o licencování SAP v Linuxu v Azure

- SAP Note 1999351: Obsahuje další informace o řešení potíží pro rozšíření rozšířeného monitorování Azure pro SAP.

- SAP Note 1900823: Obsahuje informace o požadavcích na úložiště SAP HANA

- Wikiweb komunity SAP: Obsahuje všechny požadované poznámky SAP pro Linux.

- Plánování a implementace virtuálních počítačů Azure pro SAP v Linuxu

- Nasazení virtuálních počítačů Azure pro SAP v Linuxu

- Nasazení DBMS pro Azure Virtual Machines pro SAP v Linuxu

- Obecná dokumentace k RHEL

- Dokumentace ke službě RHEL specifická pro Azure:

- Svazky NFS v4.1 ve službě Azure NetApp Files pro SAP HANA

Přehled

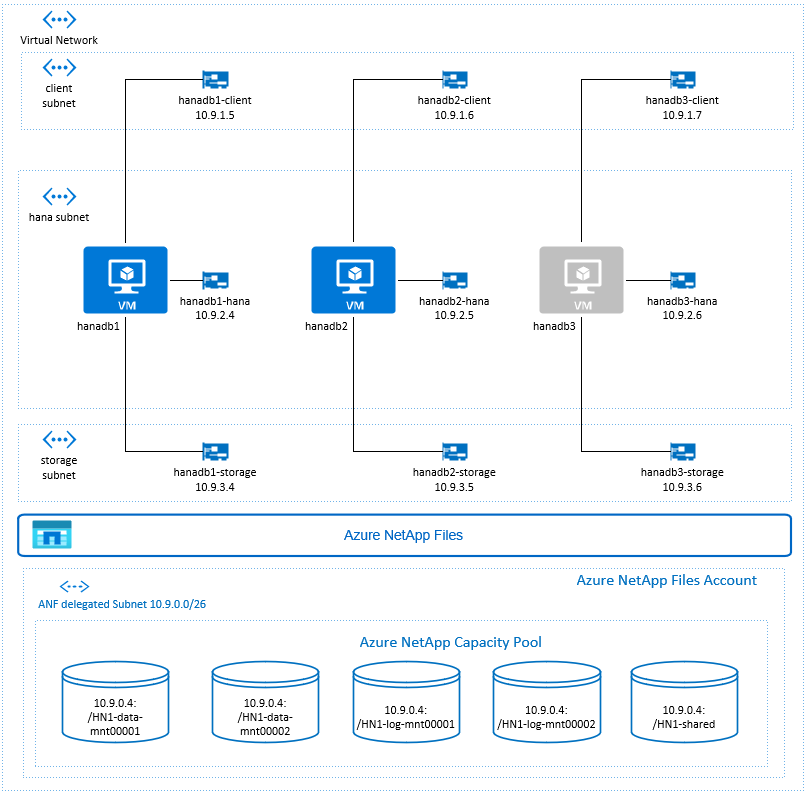

Jednou z metod dosažení vysoké dostupnosti HANA je konfigurace automatického převzetí služeb při selhání hostitele. Pokud chcete nakonfigurovat automatické převzetí služeb při selhání hostitele, přidáte do systému HANA jeden nebo více virtuálních počítačů a nakonfigurujete je jako pohotovostní uzly. Pokud dojde k selhání aktivního uzlu, pohotovostní uzel automaticky převezme. V zobrazené konfiguraci virtuálních počítačů Azure dosáhnete automatického převzetí služeb při selhání pomocí systému souborů NFS ve službě Azure NetApp Files.

Poznámka:

Pohotovostní uzel potřebuje přístup ke všem databázovým svazkům. Svazky HANA musí být připojené jako svazky NFSv4. Vylepšený mechanismus uzamykání na základě zapůjčení souboru v protokolu NFSv4 se používá k I/O ořezání.

Důležité

Pokud chcete vytvořit podporovanou konfiguraci, musíte nasadit data HANA a svazky protokolů jako svazky NFSv4.1 a připojit je pomocí protokolu NFSv4.1. Konfigurace automatického převzetí služeb při selhání hostitele HANA s pohotovostním uzlem se u NFSv3 nepodporuje.

V předchozím diagramu, který se řídí doporučeními pro síť SAP HANA, jsou v jedné virtuální síti Azure reprezentovány tři podsítě:

- Pro komunikaci klientů

- Komunikace se systémem úložiště

- Pro interní komunikaci mezi uzly HANA

Svazky Azure NetApp jsou v samostatné podsíti delegovány do služby Azure NetApp Files.

V tomto příkladu konfigurace jsou podsítě:

client10.9.1.0/26storage10.9.3.0/26hana10.9.2.0/26anf10.9.0.0/26 (delegovaná podsíť do Služby Azure NetApp Files)

Nastavení infrastruktury Služby Azure NetApp Files

Než budete pokračovat v nastavení infrastruktury Služby Azure NetApp Files, seznamte se s dokumentací k Azure NetApp Files.

Služba Azure NetApp Files je dostupná v několika oblastech Azure. Zkontrolujte, jestli vybraná oblast Azure nabízí Azure NetApp Files.

Informace o dostupnosti služby Azure NetApp Files podle oblasti Azure najdete v tématu Dostupnost služby Azure NetApp Files podle oblasti Azure.

Důležitá poznámka

Při vytváření svazků Azure NetApp Files pro SAP HANA se škálováním na více instancí s využitím scénářů uzlů mějte na paměti důležité aspekty popsané ve svazcích NFS v4.1 ve službě Azure NetApp Files pro SAP HANA.

Určení velikosti databáze HANA ve službě Azure NetApp Files

Propustnost svazku Azure NetApp Files je funkce velikosti svazku a úrovně služby, jak je uvedeno na úrovni služby pro Azure NetApp Files.

Při navrhování infrastruktury pro SAP HANA v Azure pomocí Azure NetApp Files mějte na paměti doporučení ve svazcích NFS verze 4.1 ve službě Azure NetApp Files pro SAP HANA.

Konfigurace v tomto článku se zobrazí s jednoduchými svazky Azure NetApp Files.

Důležité

V produkčních systémech, kde je výkon klíčem, doporučujeme vyhodnotit a zvážit použití skupiny svazků aplikací Azure NetApp Files pro SAP HANA.

Nasazení prostředků Azure NetApp Files

Následující pokyny předpokládají, že jste už nasadili virtuální síť Azure. Prostředky Azure NetApp Files a virtuální počítače, ve kterých se připojí prostředky Azure NetApp Files, musí být nasazené ve stejné virtuální síti Azure nebo ve virtuálních sítích Azure v partnerském vztahu.

Podle pokynů v části Vytvoření účtu NetApp vytvořte ve vybrané oblasti Azure účet NetApp.

Podle pokynů v tématu Nastavení fondu kapacity Služby Azure NetApp Files nastavte fond kapacity Služby Azure NetApp Files.

Architektura HANA uvedená v tomto článku používá jeden fond kapacity Azure NetApp Files na úrovni služby Ultra. Pro úlohy HANA v Azure doporučujeme použít úroveň služby Azure NetApp Files Ultra nebo Premium.

Delegujte podsíť do služby Azure NetApp Files, jak je popsáno v pokynech v části Delegování podsítě do služby Azure NetApp Files.

Svazky Azure NetApp Files nasaďte podle pokynů v tématu Vytvoření svazku NFS pro Azure NetApp Files.

Při nasazování svazků nezapomeňte vybrat verzi NFSv4.1 . Nasaďte svazky v určené podsíti Azure NetApp Files. IP adresy svazků Azure NetApp se přiřazují automaticky.

Mějte na paměti, že prostředky Azure NetApp Files a virtuální počítače Azure musí být ve stejné virtuální síti Azure nebo v partnerských virtuálních sítích Azure. Například HN1-data-mnt00001, HN1-log-mnt00001 atd., jsou názvy svazků a nfs://10.9.0.4/ HN1-data-mnt00001, nfs://10.9.0.4/ HN1-log-mnt00001 atd., jsou cesty k souborům svazků Azure NetApp Files.

- volume HN1-data-mnt00001 (nfs://10.9.0.4/ HN1-data-mnt00001)

- volume HN1-data-mnt00002 (nfs://10.9.0.4/ HN1-data-mnt00002)

- volume HN1-log-mnt000001 (nfs://10.9.0.4/ HN1-log-mnt00001)

- volume HN1-log-mnt00002 (nfs://10.9.0.4/ HN1-log-mnt00002)

- sdílený svazek HN1 (sdílený nfs://10.9.0.4/ HN1)

V tomto příkladu jsme použili samostatný svazek Azure NetApp Files pro každou data HANA a svazek protokolu. Pro cenově optimalizovanou konfiguraci v menších nebo neproduktivnějších systémech je možné umístit všechna data na jeden svazek a všechny protokoly se připojují na jiný svazek.

Nasazení virtuálních počítačů s Linuxem prostřednictvím webu Azure Portal

Nejprve je potřeba vytvořit svazky Azure NetApp Files. Pak proveďte následující kroky:

Vytvořte podsítě virtuální sítě Azure ve vaší virtuální síti Azure.

Nasaďte virtuální počítače.

Vytvořte další síťová rozhraní a připojte síťová rozhraní k odpovídajícím virtuálním počítačům.

Každý virtuální počítač má tři síťová rozhraní, která odpovídají třem podsítím virtuální sítě Azure (

clientstorageahana).Další informace najdete v tématu Vytvoření virtuálního počítače s Linuxem v Azure s několika kartami síťového rozhraní.

Důležité

U úloh SAP HANA je klíčová nízká latence. Pokud chcete dosáhnout nízké latence, ve spolupráci se zástupcem Microsoftu se ujistěte, že jsou virtuální počítače a svazky Azure NetApp Files nasazené v těsné blízkosti. Pokud onboardujete nový systém SAP HANA, který využívá službu Azure NetApp Files pro SAP HANA, odešlete potřebné informace.

Další pokyny předpokládají, že jste už vytvořili skupinu prostředků, virtuální síť Azure a tři podsítě virtuální sítě Azure: clientstorage a hana. Když nasadíte virtuální počítače, vyberte podsíť klienta, aby klientské síťové rozhraní bylo primárním rozhraním na virtuálních počítačích. Budete také muset nakonfigurovat explicitní trasu do delegované podsítě Azure NetApp Files prostřednictvím brány podsítě podsítě úložiště.

Důležité

Ujistěte se, že vybraný operační systém má certifikaci SAP pro SAP HANA na konkrétních typech virtuálních počítačů, které používáte. Seznam typů certifikovaných virtuálních počítačů a verzí operačního systému SAP HANA pro tyto typy najdete na webu platforem IaaS pro SAP HANA. Kliknutím na podrobnosti o uvedeném typu virtuálního počítače získáte úplný seznam vydaných verzí operačního systému s podporou SAP HANA pro tento typ.

Vytvořte pro SAP HANA sadu dostupnosti. Nezapomeňte nastavit doménu maximální aktualizace.

Pomocí následujících kroků vytvořte tři virtuální počítače (hanadb1, hanadb2, hanadb3):

a. Použijte image Red Hat Enterprise Linuxu v galerii Azure, která je podporovaná pro SAP HANA. V tomto příkladu jsme použili obrázek RHEL-SAP-HA 7.6.

b. Vyberte dříve vytvořenou sadu dostupnosti pro SAP HANA.

c. Vyberte podsíť virtuální sítě Azure klienta. Vyberte akcelerovanou síť.

Při nasazování virtuálních počítačů se automaticky vygeneruje název síťového rozhraní. V těchto pokynech pro zjednodušení se podíváme na automaticky generovaná síťová rozhraní, která jsou připojená k podsíti virtuální sítě Azure klienta, jako hanadb1-client, hanadb2-client a hanadb3-client.

Vytvořte tři síťová rozhraní, jedno pro každý virtuální počítač, pro

storagepodsíť virtuální sítě (v tomto příkladu hanadb1-storage, hanadb2-storage a hanadb3-storage).Vytvořte tři síťová rozhraní, jedno pro každý virtuální počítač, pro

hanapodsíť virtuální sítě (v tomto příkladu hanadb1-hana, hanadb2-hana a hanadb3-hana).Pomocí následujících kroků připojte nově vytvořená virtuální síťová rozhraní k odpovídajícím virtuálním počítačům:

a. Na webu Azure Portal přejděte na virtuální počítač.

b. V levém podokně vyberte Virtuální počítače. Vyfiltrujte název virtuálního počítače (například hanadb1) a pak vyberte virtuální počítač.

c. V podokně Přehled vyberte Zastavit a uvolněte virtuální počítač.

d. Vyberte Sítě a pak připojte síťové rozhraní. V rozevíracím seznamu Připojit síťové rozhraní vyberte již vytvořená síťová rozhraní pro podsítě

storageahanapodsítě.e. Zvolte Uložit.

f. Opakujte kroky b až e pro zbývající virtuální počítače (v našem příkladu hanadb2 a hanadb3).

g. Prozatím nechte virtuální počítače v zastaveném stavu. Dále povolíme akcelerované síťové služby pro všechna nově připojená síťová rozhraní.

Pomocí následujících kroků povolte akcelerované síťové rozhraní pro další síťová rozhraní a

storagehanapodsítě:a. Otevřete Azure Cloud Shell na webu Azure Portal.

b. Spuštěním následujících příkazů povolte akcelerované síťové služby pro další síťová rozhraní, která jsou připojená k podsítím

storageahanapodsítím.az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb1-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb2-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb3-storage --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb1-hana --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb2-hana --accelerated-networking true az network nic update --id /subscriptions/your subscription/resourceGroups/your resource group/providers/Microsoft.Network/networkInterfaces/hanadb3-hana --accelerated-networking trueSpusťte virtuální počítače následujícím postupem:

a. V levém podokně vyberte Virtuální počítače. Vyfiltrujte název virtuálního počítače (například hanadb1) a pak ho vyberte.

b. V podokně Přehled vyberte Start.

Konfigurace a příprava operačního systému

Pokyny v dalších částech jsou předponou jednoho z následujících:

- [A]: Platí pro všechny uzly.

- [1]: Platí pouze pro uzel 1.

- [2]: Platí pouze pro uzel 2.

- [3]: Platí pouze pro uzel 3.

Nakonfigurujte a připravte operační systém pomocí následujících kroků:

[A] Udržujte soubory hostitele na virtuálních počítačích. Zahrňte položky pro všechny podsítě. Do tohoto příkladu byly přidány

/etc/hostsnásledující položky.# Storage 10.9.3.4 hanadb1-storage 10.9.3.5 hanadb2-storage 10.9.3.6 hanadb3-storage # Client 10.9.1.5 hanadb1 10.9.1.6 hanadb2 10.9.1.7 hanadb3 # Hana 10.9.2.4 hanadb1-hana 10.9.2.5 hanadb2-hana 10.9.2.6 hanadb3-hana[A] Přidejte síťovou trasu, aby komunikace se službou Azure NetApp Files přechádla přes síťové rozhraní úložiště.

V tomto příkladu se použije

Networkmanagerke konfiguraci další síťové trasy. Následující pokyny předpokládají, že síťové rozhraní úložiště jeeth1.

Nejprve určete název připojení pro zařízeníeth1. V tomto příkladu jeWired connection 1název připojení pro zařízeníeth1.# Execute as root nmcli connection # Result #NAME UUID TYPE DEVICE #System eth0 5fb06bd0-0bb0-7ffb-45f1-d6edd65f3e03 ethernet eth0 #Wired connection 1 4b0789d1-6146-32eb-83a1-94d61f8d60a7 ethernet eth1Pak nakonfigurujte další trasu do delegované sítě Azure NetApp Files přes

eth1.# Add the following route # ANFDelegatedSubnet/cidr via StorageSubnetGW dev StorageNetworkInterfaceDevice nmcli connection modify "Wired connection 1" +ipv4.routes "10.9.0.0/26 10.9.3.1"Pokud chcete změny aktivovat, restartujte virtuální počítač.

[A] Nainstalujte balíček klienta systému souborů NFS.

yum install nfs-utils[A] Připravte operační systém pro spuštění SAP HANA v Azure NetApp s NFS, jak je popsáno v poznámce SAP 3024346 – linuxové jádro Nastavení pro NetApp NFS. Vytvořte konfigurační soubor /etc/sysctl.d/91-NetApp-HANA.conf pro nastavení konfigurace NetApp.

vi /etc/sysctl.d/91-NetApp-HANA.conf # Add the following entries in the configuration file net.core.rmem_max = 16777216 net.core.wmem_max = 16777216 net.ipv4.tcp_rmem = 4096 131072 16777216 net.ipv4.tcp_wmem = 4096 16384 16777216 net.core.netdev_max_backlog = 300000 net.ipv4.tcp_slow_start_after_idle=0 net.ipv4.tcp_no_metrics_save = 1 net.ipv4.tcp_moderate_rcvbuf = 1 net.ipv4.tcp_window_scaling = 1 net.ipv4.tcp_timestamps = 1 net.ipv4.tcp_sack = 1[A] Vytvořte konfigurační soubor /etc/sysctl.d/ms-az.conf s dalšími nastaveními optimalizace.

vi /etc/sysctl.d/ms-az.conf # Add the following entries in the configuration file net.ipv6.conf.all.disable_ipv6 = 1 net.ipv4.tcp_max_syn_backlog = 16348 net.ipv4.conf.all.rp_filter = 0 sunrpc.tcp_slot_table_entries = 128 vm.swappiness=10

Tip

Vyhněte se nastavení net.ipv4.ip_local_port_range a net.ipv4.ip_local_reserved_ports explicitně v konfiguračních souborech sysctl, aby agent hostitele SAP mohl spravovat rozsahy portů. Další podrobnosti najdete v poznámkách SAP 2382421.

[A] Upravte nastavení sunrpc podle doporučení v poznámkách SAP 3024346 – linuxové jádro Nastavení pro NetApp NFS.

vi /etc/modprobe.d/sunrpc.conf # Insert the following line options sunrpc tcp_max_slot_table_entries=128[A] Red Hat pro konfiguraci HANA

Nakonfigurujte RHEL podle popisu v 2292690 SAP Note, 2455582, 2593824 a 2447641 Red Hat Note.

Poznámka:

Pokud instalujete HANA 2.0 SP04, budete muset nainstalovat balíček

compat-sap-c++-7, jak je popsáno v poznámce SAP 2593824, před instalací SAP HANA.

Připojení svazků Azure NetApp Files

[A] Vytvořte přípojné body pro svazky databáze HANA.

mkdir -p /hana/data/HN1/mnt00001 mkdir -p /hana/data/HN1/mnt00002 mkdir -p /hana/log/HN1/mnt00001 mkdir -p /hana/log/HN1/mnt00002 mkdir -p /hana/shared mkdir -p /usr/sap/HN1[1] Vytvořte adresáře specifické pro uzly pro /usr/sap ve sdíleném HN1.

# Create a temporary directory to mount HN1-shared mkdir /mnt/tmp # if using NFSv3 for this volume, mount with the following command mount 10.9.0.4:/HN1-shared /mnt/tmp # if using NFSv4.1 for this volume, mount with the following command mount -t nfs -o sec=sys,nfsvers=4.1 10.9.0.4:/HN1-shared /mnt/tmp cd /mnt/tmp mkdir shared usr-sap-hanadb1 usr-sap-hanadb2 usr-sap-hanadb3 # unmount /hana/shared cd umount /mnt/tmp[A] Ověřte nastavení domény NFS. Ujistěte se, že je doména nakonfigurovaná jako výchozí doména Azure NetApp Files, tj.

defaultv4iddomain.comže mapování je nastavené na nikoho.Důležité

Nezapomeňte na virtuálním počítači nastavit doménu

/etc/idmapd.confNFS tak, aby odpovídala výchozí konfiguraci domény ve službě Azure NetApp Files:defaultv4iddomain.comPokud dojde k neshodě mezi konfigurací domény v klientovi NFS (tj. virtuálním počítači) a serverem NFS, tj. konfigurací Azure NetApp, zobrazí se oprávnění pro soubory na svazcích Azure NetApp připojených k virtuálním počítačům jakonobody.sudo cat /etc/idmapd.conf # Example [General] Domain = defaultv4iddomain.com [Mapping] Nobody-User = nobody Nobody-Group = nobody[A] Ověřte

nfs4_disable_idmapping. Měla by být nastavená na Y. Pokud chcete vytvořit adresářovou strukturu, ve kterénfs4_disable_idmappingse nachází, spusťte příkaz mount. Adresář v adresáři /sys/modules nebudete moct vytvořit ručně, protože přístup je vyhrazený pro jádro nebo ovladače.# Check nfs4_disable_idmapping cat /sys/module/nfs/parameters/nfs4_disable_idmapping # If you need to set nfs4_disable_idmapping to Y mkdir /mnt/tmp mount 10.9.0.4:/HN1-shared /mnt/tmp umount /mnt/tmp echo "Y" > /sys/module/nfs/parameters/nfs4_disable_idmapping # Make the configuration permanent echo "options nfs nfs4_disable_idmapping=Y" >> /etc/modprobe.d/nfs.confDalší podrobnosti o tom, jak změnit

nfs4_disable_idmappingparametr naleznete v tématu https://access.redhat.com/solutions/1749883.[A] Připojte sdílené svazky Azure NetApp Files.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-data-mnt00001 /hana/data/HN1/mnt00001 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-data-mnt00002 /hana/data/HN1/mnt00002 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-log-mnt00001 /hana/log/HN1/mnt00001 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-log-mnt00002 /hana/log/HN1/mnt00002 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 10.9.0.4:/HN1-shared/shared /hana/shared nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount all volumes sudo mount -aU úloh, které vyžadují vyšší propustnost, zvažte použití

nconnectmožnosti připojení, jak je popsáno ve svazcích NFS verze 4.1 ve službě Azure NetApp Files pro SAP HANA. Zkontrolujte, jestlinconnectazure NetApp Files ve vaší verzi Linuxu podporuje.[1] Připojte svazky specifické pro uzly na hanadb1.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb1 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[2] Připojte svazky specifické pro uzly na hanadb2.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb2 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[3] Připojte svazky specifické pro uzly na hanadb3.

sudo vi /etc/fstab # Add the following entries 10.9.0.4:/HN1-shared/usr-sap-hanadb3 /usr/sap/HN1 nfs rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 0 0 # Mount the volume sudo mount -a[A] Ověřte, že jsou všechny svazky HANA připojené k protokolu NFS verze NFSv4.

sudo nfsstat -m # Verify that flag vers is set to 4.1 # Example from hanadb1 /hana/data/HN1/mnt00001 from 10.9.0.4:/HN1-data-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/log/HN1/mnt00002 from 10.9.0.4:/HN1-log-mnt00002 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/data/HN1/mnt00002 from 10.9.0.4:/HN1-data-mnt00002 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/log/HN1/mnt00001 from 10.9.0.4:/HN1-log-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /usr/sap/HN1 from 10.9.0.4:/HN1-shared/usr-sap-hanadb1 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4 /hana/shared from 10.9.0.4:/HN1-shared/shared Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.9.3.4,local_lock=none,addr=10.9.0.4

Instalace

V tomto příkladu pro nasazení SAP HANA v konfiguraci horizontálního navýšení kapacity s pohotovostním uzlem s Azure jsme použili HANA 2.0 SP4.

Příprava na instalaci HANA

[A] Před instalací HANA nastavte kořenové heslo. Po dokončení instalace můžete kořenové heslo zakázat. Spustit jako

rootpříkazpasswd.[1] Ověřte, že se můžete přihlásit přes SSH k hanadb2 a hanadb3 bez výzvy k zadání hesla.

ssh root@hanadb2 ssh root@hanadb3[A] Nainstalujte další balíčky, které jsou vyžadovány pro HANA 2.0 SP4. Další informace najdete v 2593824 SAP Note.

yum install libgcc_s1 libstdc++6 compat-sap-c++-7 libatomic1[2], [3] Změňte vlastnictví SAP HANA

dataalogadresářů na adm hn1.# Execute as root sudo chown hn1adm:sapsys /hana/data/HN1 sudo chown hn1adm:sapsys /hana/log/HN1[A] Dočasně zakažte bránu firewall, aby nenarušovala instalaci HANA. Po dokončení instalace HANA ji můžete znovu povolit.

# Execute as root systemctl stop firewalld systemctl disable firewalld

Instalace HANA

[1] Nainstalujte SAP HANA podle pokynů v průvodci instalací a aktualizací SAP HANA 2.0. V tomto příkladu nainstalujete SAP HANA se škálováním na více instancí s hlavním serverem, jedním pracovním procesem a jedním pohotovostním uzlem.

a. Spusťte program hdblcm z instalačního softwarového adresáře HANA.

internal_networkPoužijte parametr a předejte adresní prostor pro podsíť, který se používá pro interní komunikaci mezi uzly HANA../hdblcm --internal_network=10.9.2.0/26b. Na příkazovém řádku zadejte následující hodnoty:

- Pro volbu akce: zadejte 1 (pro instalaci)

- Pro další součásti pro instalaci: zadejte 2, 3

- Instalační cesta: Stiskněte Enter (výchozí nastavení /hana/shared)

- Pro místní název hostitele: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- V části Chcete přidat hostitele do systému?: Zadejte y

- Pro přidání názvů hostitelů oddělených čárkami: zadejte hanadb2, hanadb3

- Pro kořenové uživatelské jméno [root]: Stisknutím klávesy Enter přijměte výchozí nastavení.

- Pro role hostitele hanadb2: zadejte 1 (pro pracovní proces).

- Pro skupinu převzetí služeb při selhání hostitele pro hostitele hanadb2 [výchozí]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro číslo oddílu úložiště pro hostitele hanadb2 [<<přiřadit automaticky>>]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro skupinu pracovních procesů pro hostitele hanadb2 [výchozí]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro výběr rolí pro hostitele hanadb3 zadejte 2 (v pohotovostním režimu).

- Pro skupinu převzetí služeb při selhání hostitele pro hostitele hanadb3 [výchozí]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro skupinu pracovních procesů pro hostitele hanadb3 [výchozí]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro ID systému SAP HANA: zadejte HN1.

- Jako číslo instance [00]: zadejte 03.

- Pro místní skupinu pracovních procesů hostitele [výchozí]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro výběr využití systému / Zadejte index [4]: zadejte 4 (pro vlastní)

- Pro umístění datových svazků [/hana/data/HN1]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro umístění svazků protokolů [/hana/log/HN1]: Stisknutím klávesy Enter přijměte výchozí nastavení.

- Chcete-li omezit maximální přidělení paměti? [n]: zadejte n

- Pro název hostitele certifikátu pro hostitele hanadb1 [hanadb1]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro název hostitele certifikátu pro hostitele hanadb2 [hanadb2]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- Pro název hostitele certifikátu pro hostitele hanadb3 [hanadb3]: Stisknutím klávesy Enter přijměte výchozí hodnotu.

- V případě systému Správa istrator (hn1adm) Heslo: zadejte heslo.

- Pro uživatele systémové databáze (systém) Heslo: zadejte heslo systému.

- Pro potvrzení hesla uživatele systémové databáze (systém): zadejte heslo systému.

- Chcete-li po restartování počítače restartovat systém? [n]: zadejte n

- Do you want to continue (y/n): Validate the summary and if everything looks good, enter y

[1] Ověření global.ini

Zobrazte soubor global.ini a ujistěte se, že je zavedená konfigurace interní komunikace mezi uzly SAP HANA. Ověřte část komunikace. Měl by mít adresní prostor pro

hanapodsíť alisteninterfaceměl by být nastavený na.internalhodnotu . Ověřte oddíl internal_hostname_resolution. Měl by mít IP adresy pro virtuální počítače HANA, které patří dohanapodsítě.sudo cat /usr/sap/HN1/SYS/global/hdb/custom/config/global.ini # Example #global.ini last modified 2019-09-10 00:12:45.192808 by hdbnameserve [communication] internal_network = 10.9.2.0/26 listeninterface = .internal [internal_hostname_resolution] 10.9.2.4 = hanadb1 10.9.2.5 = hanadb2 10.9.2.6 = hanadb3[1] Přidejte mapování hostitele, aby se zajistilo, že se IP adresy klienta používají pro komunikaci klientů. Přidejte oddíl

public_host_resolutiona přidejte odpovídající IP adresy z podsítě klienta.sudo vi /usr/sap/HN1/SYS/global/hdb/custom/config/global.ini #Add the section [public_hostname_resolution] map_hanadb1 = 10.9.1.5 map_hanadb2 = 10.9.1.6 map_hanadb3 = 10.9.1.7[1] Restartujte SAP HANA a aktivujte změny.

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StopSystem HDB sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StartSystem HDB[1] Ověřte, že klientské rozhraní bude používat IP adresy z

clientpodsítě pro komunikaci.# Execute as hn1adm /usr/sap/HN1/HDB03/exe/hdbsql -u SYSTEM -p "password" -i 03 -d SYSTEMDB 'select * from SYS.M_HOST_INFORMATION'|grep net_publicname # Expected result "hanadb3","net_publicname","10.9.1.7" "hanadb2","net_publicname","10.9.1.6" "hanadb1","net_publicname","10.9.1.5"Informace o tom, jak ověřit konfiguraci, najdete v tématu SAP Note 2183363 – Konfigurace interní sítě SAP HANA.

[A] Znovu povolte bránu firewall.

Zastavení HANA

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StopSystem HDBOpětovné povolení brány firewall

# Execute as root systemctl start firewalld systemctl enable firewalldOtevření potřebných portů brány firewall

Důležité

Vytvořte pravidla brány firewall, která povolí komunikaci mezi uzly HANA a klientský provoz. Požadované porty jsou uvedené na portech TCP/IP všech produktů SAP. Následující příkazy jsou jen příkladem. V tomto scénáři s použitým systémovým číslem 03.

# Execute as root sudo firewall-cmd --zone=public --add-port={30301,30303,30306,30307,30313,30315,30317,30340,30341,30342,1128,1129,40302,40301,40307,40303,40340,50313,50314,30310,30302}/tcp --permanent sudo firewall-cmd --zone=public --add-port={30301,30303,30306,30307,30313,30315,30317,30340,30341,30342,1128,1129,40302,40301,40307,40303,40340,50313,50314,30310,30302}/tcpSpuštění HANA

sudo -u hn1adm /usr/sap/hostctrl/exe/sapcontrol -nr 03 -function StartSystem HDB

Pokud chcete optimalizovat SAP HANA pro základní úložiště Azure NetApp Files, nastavte následující parametry SAP HANA:

max_parallel_io_requests128async_read_submitonasync_write_submit_activeonasync_write_submit_blocksvše

Další informace najdete v tématu Konfigurace zásobníku vstupně-výstupních operací pro SAP HANA.

Počínaje systémy SAP HANA 2.0 můžete nastavit parametry v

global.inisouboru . Další informace najdete v 1999930 SAP Note.U systémů SAP HANA 1.0 s aktualizací SPS12 a starších je možné tyto parametry nastavit během instalace, jak je popsáno v 2267798 SAP Note.

Úložiště používané službou Azure NetApp Files má omezení velikosti souboru 16 terabajtů (TB). SAP HANA implicitně neví o omezení úložiště a při dosažení limitu velikosti souboru o velikosti 16 TB se automaticky nevytvoří nový datový soubor. Když se SAP HANA pokusí zvětšit soubor nad 16 TB, výsledkem tohoto pokusu budou chyby a nakonec dojde k chybovému ukončení indexového serveru.

Důležité

Chcete-li zabránit, aby se SAP HANA pokusila zvětšit datové soubory nad rámec limitu 16 TB subsystému úložiště, nastavte následující parametry v

global.inisouboru .

Testování převzetí služeb při selhání SAP HANA

Simulace chybového ukončení uzlu na pracovním uzlu SAP HANA Postupujte následovně:

a. Před simulací chybového ukončení uzlu spusťte následující příkazy jako adm hn1a zaznamenejte stav prostředí:

# Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - | # Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREENb. Pokud chcete simulovat chybové ukončení uzlu, spusťte na pracovním uzlu následující příkaz, který je v tomto případě hanadb2 :

echo b > /proc/sysrq-triggerc. Monitorujte systém pro dokončení převzetí služeb při selhání. Po dokončení převzetí služeb při selhání zachyťte stav, který by měl vypadat takto:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GRAY hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | no | info | | | 2 | 0 | default | default | master 2 | slave | worker | standby | worker | standby | default | - | | hanadb3 | yes | info | | | 0 | 2 | default | default | master 3 | slave | standby | slave | standby | worker | default | default |Důležité

Když uzel zaznamená panice jádra, vyhněte se zpožděním převzetí služeb při selhání SAP HANA nastavením

kernel.panicna 20 sekund na všech virtuálních počítačích HANA. Konfigurace se provádí v/etc/sysctlsouboru . Pokud chcete změnu aktivovat, restartujte virtuální počítače. Pokud se tato změna neprovádí, převzetí služeb při selhání může trvat 10 nebo více minut, když u uzlu dochází k panice jádra.Ukončete názvový server následujícím způsobem:

a. Před testem zkontrolujte stav prostředí spuštěním následujících příkazů jako adm hn1:

#Landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - | # Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREENb. Na aktivním hlavním uzlu, který je v tomto případě hanadb1, spusťte následující příkazy jako adm hn1:

hn1adm@hanadb1:/usr/sap/HN1/HDB03> HDB killPohotovostní uzel hanadb3 převezme hlavní uzel. Tady je stav prostředku po dokončení testu převzetí služeb při selhání:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GRAY # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | no | info | | | 1 | 0 | default | default | master 1 | slave | worker | standby | worker | standby | default | - | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | info | | | 0 | 1 | default | default | master 3 | master | standby | master | standby | worker | default | default |c. Restartujte instanci HANA na hanadb1 (to znamená na stejném virtuálním počítači, kde byl názvový server zabit). Uzel hanadb1 se znovu připojí k prostředí a zachová svoji pohotovostní roli.

hn1adm@hanadb1:/usr/sap/HN1/HDB03> HDB startPo spuštění SAP HANA na hanadb1 můžete očekávat následující stav:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | no | info | | | 1 | 0 | default | default | master 1 | slave | worker | standby | worker | standby | default | - | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | yes | info | | | 0 | 1 | default | default | master 3 | master | standby | master | standby | worker | default | default |d. Znovu ukončete názvový server na aktuálně aktivním hlavním uzlu (to znamená na uzlu hanadb3).

hn1adm@hanadb3:/usr/sap/HN1/HDB03> HDB killNode hanadb1 obnoví roli hlavního uzlu. Po dokončení testu převzetí služeb při selhání bude stav vypadat takto:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GRAY hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | no | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - |e. Spusťte SAP HANA na hanadb3, který bude připravený sloužit jako pohotovostní uzel.

hn1adm@hanadb3:/usr/sap/HN1/HDB03> HDB startPo spuštění SAP HANA na hanadb3 vypadá stav takto:

# Check the instance status sapcontrol -nr 03 -function GetSystemInstanceList & python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus GetSystemInstanceList OK hostname, instanceNr, httpPort, httpsPort, startPriority, features, dispstatus hanadb2, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN hanadb3, 3, 50313, 50314, 0.3, HDB|HDB_STANDBY, GREEN hanadb1, 3, 50313, 50314, 0.3, HDB|HDB_WORKER, GREEN # Check the landscape status python /usr/sap/HN1/HDB03/exe/python_support/landscapeHostConfiguration.py | Host | Host | Host | Failover | Remove | Storage | Storage | Failover | Failover | NameServer | NameServer | IndexServer | IndexServer | Host | Host | Worker | Worker | | | Active | Status | Status | Status | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | Config | Actual | | | | | | | Partition | Partition | Group | Group | Role | Role | Role | Role | Roles | Roles | Groups | Groups | | ------- | ------ | ------ | -------- | ------ | --------- | --------- | -------- | -------- | ---------- | ---------- | ----------- | ----------- | ------- | ------- | ------- | ------- | | hanadb1 | yes | ok | | | 1 | 1 | default | default | master 1 | master | worker | master | worker | worker | default | default | | hanadb2 | yes | ok | | | 2 | 2 | default | default | master 2 | slave | worker | slave | worker | worker | default | default | | hanadb3 | no | ignore | | | 0 | 0 | default | default | master 3 | slave | standby | standby | standby | standby | default | - |

Další kroky

- Plánování a implementace virtuálních počítačů Azure pro SAP

- Nasazení virtuálních počítačů Azure pro SAP

- Nasazení DBMS pro Azure Virtual Machines pro SAP

- Svazky NFS v4.1 ve službě Azure NetApp Files pro SAP HANA

- Informace o vytvoření vysoké dostupnosti a plánování zotavení po havárii SAP HANA na virtuálních počítačích Azure najdete v tématu Vysoká dostupnost SAP HANA na virtuálních počítačích Azure.