Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Poznámka:

Prostředí Fabric Runtime 2.0 je aktuálně ve fázi experimentální verze Preview. Další informace najdete v omezeních a poznámkách.

Prostředí Fabric Runtime poskytuje bezproblémovou integraci v ekosystému Microsoft Fabric a nabízí robustní prostředí pro projekty přípravy dat a datových věd využívajících Apache Spark.

Tento článek představuje prostředí Fabric Runtime 2.0 Experimentální (Preview), nejnovější modul runtime navržený pro výpočty velkých objemů dat v Microsoft Fabric. Zvýrazňuje klíčové funkce a komponenty, díky kterým je tato verze významným krokem vpřed pro škálovatelné analýzy a pokročilé úlohy.

Modul Fabric Runtime 2.0 obsahuje následující komponenty a upgrady navržené tak, aby zlepšily možnosti zpracování dat:

- Apache Spark 4.0

- Operační systém: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta Lake: 4.0

Povolení modulu runtime 2.0

Modul runtime 2.0 můžete povolit na úrovni pracovního prostoru nebo na úrovni položky prostředí. Pomocí nastavení pracovního prostoru použijte modul runtime 2.0 jako výchozí pro všechny úlohy Sparku ve vašem pracovním prostoru. Případně vytvořte položku prostředí s modulem runtime 2.0, který se použije s konkrétními poznámkovými bloky nebo definicemi úloh Sparku, což přepíše výchozí nastavení pracovního prostoru.

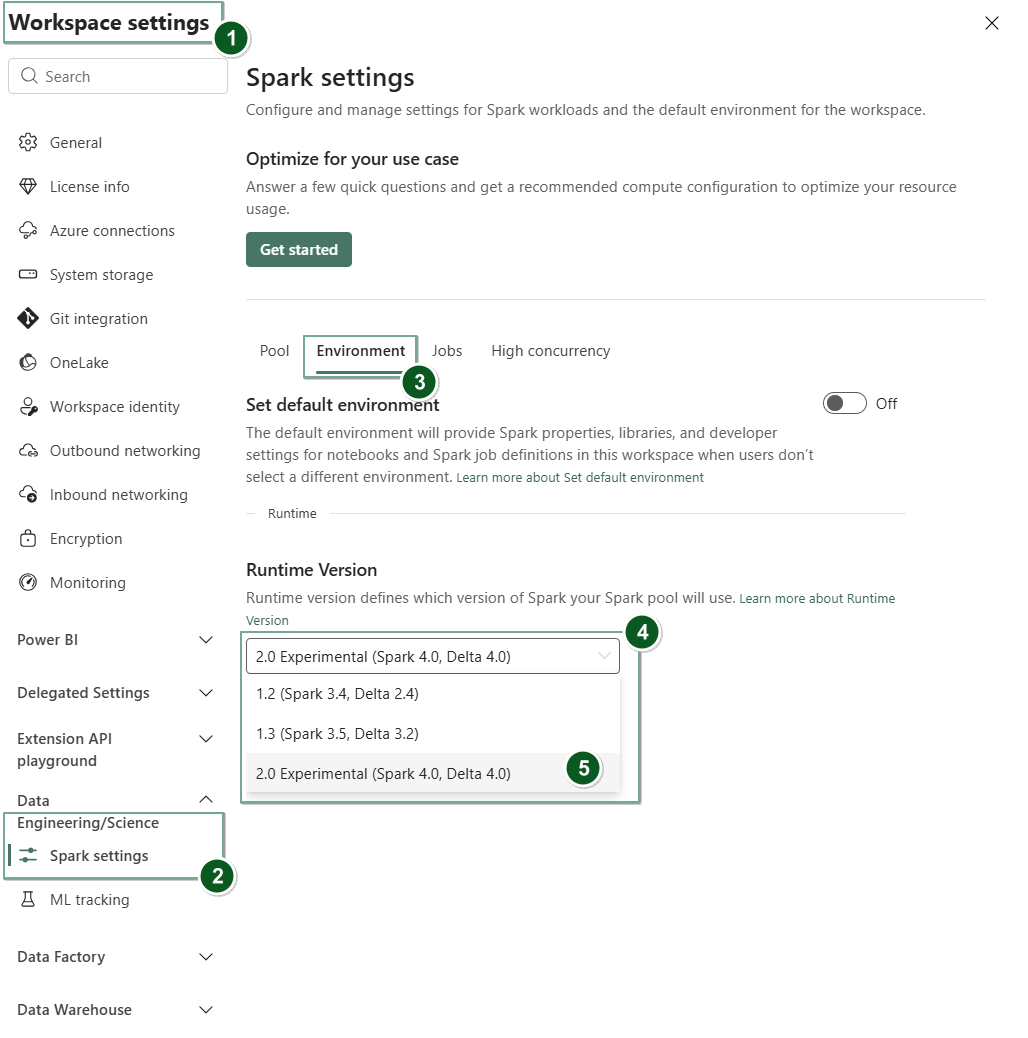

Povolení modulu runtime 2.0 v nastavení pracovního prostoru

Nastavení modulu runtime 2.0 jako výchozího pro celý pracovní prostor:

V pracovním prostoru Fabric přejděte na kartu Nastavení pracovního prostoru.

Přejděte na kartu Datové inženýrství/Věda a vyberte Nastavení Sparku.

Vyberte kartu Prostředí.

V rozevíracím seznamu Verze modulu runtime vyberte 2.0 Experimentální (Spark 4.0, Delta 4.0) a uložte změny. Tato akce nastaví modul runtime 2.0 jako výchozí modul runtime pro váš pracovní prostor.

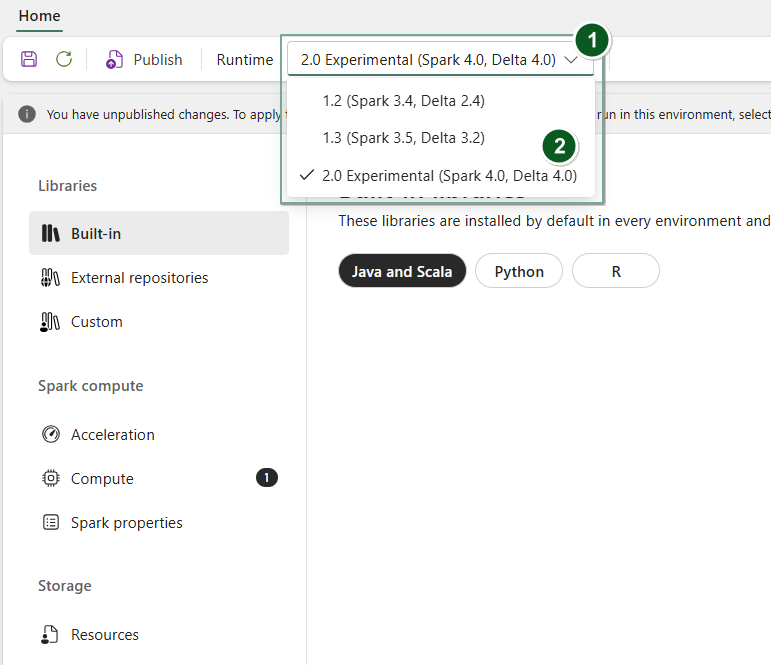

Povolení modulu runtime 2.0 v položce prostředí

Použití modulu runtime 2.0 s konkrétními poznámkovými bloky nebo definicemi úloh Sparku:

Vytvořte novou položku prostředí nebo otevřete existující.

V rozevíracím seznamu Runtime zvolte 2.0 Experimentální (Spark 4.0, Delta 4.0)

SaveaPublishuložte vaše změny.Důležité

Spuštění relací Sparku 2.0 může trvat přibližně 2 až 5 minut, protože startovní pooly nejsou součástí rané experimentální verze.

Dále můžete tuto položku Prostředí použít se svým

NotebookneboSpark Job Definition.

Teď můžete začít experimentovat s nejnovějšími vylepšeními a funkcemi zavedenými v prostředí Fabric Runtime 2.0 (Spark 4.0 a Delta Lake 4.0).

Experimentální verze Public Preview

Experimentální fáze Preview modulu Fabric Runtime 2.0 poskytuje dřívější přístup k novým funkcím a rozhraním API ze Sparku 4.0 i Delta Lake 4.0. Verze Preview umožňuje okamžitě používat nejnovější vylepšení založená na Sparku a zajistit plynulou připravenost a přechod pro budoucí změny, jako jsou novější verze Java, Scala a Python.

Návod

Aktuální informace najdete v podrobném seznamu změn a konkrétních poznámkách k verzi pro moduly runtime Fabric, zkontrolujte a přihlaste se k odběru verzí a aktualizací modulu Spark Runtime.

Omezení a poznámky

Prostředí Fabric Runtime 2.0 je aktuálně ve fázi experimentální verze Public Preview navržené pro uživatele, aby mohli zkoumat a experimentovat s nejnovějšími funkcemi a rozhraními API ze Sparku a Delta Lake ve vývojových nebo testovacích prostředích. I když tato verze nabízí přístup k základním funkcím, existují určitá omezení:

Můžete použít relace Sparku 4.0, psát kód v poznámkových blocích, plánovat definice úloh Sparku a používat s PySpark, Scala a Spark SQL. V této dřívější verzi se ale jazyk R nepodporuje.

Knihovny můžete nainstalovat přímo do kódu pomocí pip a conda. Nastavení Sparku můžete nastavit prostřednictvím možností %%configure v poznámkových blocích a definicích úloh Sparku (SJD).

Do Lakehouse můžete číst a zapisovat pomocí Delta Lake 4.0, ale některé pokročilé funkce, jako jsou V-order, nativní zápis do souboru Parquet, automatická kompakce, optimalizace zápisu, sloučení s nízkým přesunutím dat, sloučení, vývoj schématu a časová rekurze nejsou v této rané verzi zahrnuty.

Spark Advisor je momentálně nedostupný. V této rané verzi se ale podporují monitorovací nástroje, jako je uživatelské rozhraní Sparku a protokoly.

Funkce, jako jsou integrace datové vědy, Copilot a konektory, mezi něž patří Kusto, SQL Analytics, Cosmos DB a MySQL Java Connector, nejsou v současné době v této rané verzi podporovány. Knihovny datových věd nejsou podporovány v prostředích PySpark. PySpark funguje jenom se základním nastavením Conda, který zahrnuje PySpark sám bez dalších knihoven.

Integrace s položkou prostředí a editorem Visual Studio Code se v této dřívější verzi nepodporují.

Nepodporuje čtení a zápis dat do účtů Azure Storage pro obecné účely v2 (GPv2) s protokoly WASB nebo ABFS.

Poznámka:

Podělte se o svůj názor na prostředí Fabric Runtime na platformě Ideas. Nezapomeňte zmínit verzi a fázi vydání, na kterou odkazujete. Vážíme si zpětné vazby komunity a upřednostňujeme vylepšení na základě hlasů, abychom zajistili, že splňujeme potřeby uživatelů.

Hlavní přednosti

Apache Spark 4.0

Apache Spark 4.0 označuje významný milník jako úvodní vydání v sérii 4.x, které ztělesňuje kolektivní úsilí živé opensourcové komunity.

V této verzi je Spark SQL výrazně rozšířen o výkonné nové funkce navržené tak, aby zvýšily výraznost a všestrannost pro úlohy SQL, jako je podpora datových typů VARIANT, uživatelem definované funkce SQL, proměnné relace, syntaxe kanálu a kolace řetězců. PySpark se neustále věnuje funkční šíře i celkovému vývojářskému zážitku a přináší nativní rozhraní API pro vykreslování, nové rozhraní API pro zdroje dat Pythonu, podporu uživatelsky definovaných tabulkových funkcí (UDTF) v Pythonu a sjednocenou profilaci pro uživatelem definované funkce (UDF) v PySpark spolu s mnoha dalšími vylepšeními. Strukturované streamování se vyvíjí s klíčovými doplňky, které poskytují větší kontrolu a snadné ladění, zejména zavedení rozhraní API libovolného stavu v2 pro flexibilnější správu stavu a zdroj dat o stavu pro snadnější ladění.

Můžete zkontrolovat úplný seznam a podrobné změny zde: https://spark.apache.org/releases/spark-release-4-0-0.html.

Poznámka:

Ve Sparku 4.0 je SparkR zastaralý a může se odebrat v budoucí verzi.

Delta Lake 4.0

Delta Lake 4.0 označuje kolektivní závazek, že Delta Lake bude interoperabilní napříč formáty, bude snazší pracovat s a výkonnější. Delta 4.0 je milníková verze, která obsahuje výkonné nové funkce, optimalizace výkonu a základní vylepšení pro budoucnost otevřených datových jezer.

Můžete zkontrolovat úplný seznam a podrobné změny zavedené v Delta Lake 3.3 a 4.0 zde: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Důležité

Specifické funkce Delta Lake 4.0 jsou experimentální a pracují jenom na prostředíCh Sparku, jako jsou poznámkové bloky a definice úloh Sparku. Pokud potřebujete použít stejné tabulky Delta Lake napříč několika úlohami Microsoft Fabric, nepovolujte tyto funkce. Další informace o tom, které verze protokolů a funkce jsou kompatibilní ve všech prostředích Microsoft Fabric, najdete v tématu Interoperabilita formátů tabulek Delta Lake.

Související obsah

- Runtimy Apache Spark v prostředí Fabric – přehled, verzování a podpora vícero runtime

- Průvodce migrací Spark Core

- Průvodce migrací sql, datových sad a datových rámců

- Průvodce migrací strukturovaného streamování

- Průvodce migrací MLlib (Machine Learning)

- Průvodce migrací PySpark (Python ve Sparku)

- Průvodce migrací SparkR (R ve Sparku)