Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Tyto návody představují kompletní end-to-end scénář v prostředí pro datové vědy Fabric. Pokrývají každý krok, od

- Příjem dat

- Čištění dat

- Příprava dat

na

- Trénování modelu strojového učení

- Generování přehledů

a pak proberete využití těchto přehledů pomocí vizualizačních nástrojů – například Power BI.

Lidé, kteří jsou noví v Microsoft Fabric, by měli navštívit Co je Microsoft Fabric?.

Úvod

Životní cyklus projektu datových věd obvykle zahrnuje tyto kroky:

- Vysvětlení obchodních pravidel

- Získání dat

- Prozkoumání, vyčištění, příprava a vizualizace dat

- Trénování modelu a sledování experimentu

- Určení skóre modelu a generování přehledů

Kroky často postupují iterativně. Cíle a kritéria úspěchu jednotlivých fází závisí na spolupráci, sdílení dat a dokumentaci. Prostředí pro datové vědy infrastruktury zahrnuje několik nativních funkcí, které umožňují bezproblémovou spolupráci, získávání dat, sdílení a spotřebu.

Tyto kurzy vás umístí do role datového vědce, který musí prozkoumat, vyčistit a transformovat datovou sadu, která obsahuje stav četnosti změn 10 000 bankovních zákazníků. Pak vytvoříte model strojového učení, který předpovídá, kteří zákazníci banky pravděpodobně odejdou.

V kurzech provedete následující aktivity:

- Použití poznámkových bloků Fabric pro scénáře datových věd

- Použijte Apache Spark pro načítání dat do fabric lakehouse.

- Načtení existujících dat z tabulek Delta lakehouse

- Vyčištění a transformace dat pomocí nástrojů založených na Apache Sparku a Pythonu

- Vytváření experimentů a spuštění pro trénování různých modelů strojového učení

- Použití MLflow a uživatelského rozhraní Fabric k registraci a sledování natrénovaných modelů

- Spuštění skóringu ve velkém měřítku a uložení předpovědí a výsledků odvozování do datového úložiště

- Použití DirectLake k vizualizaci předpovědí v Power BI

Architektura

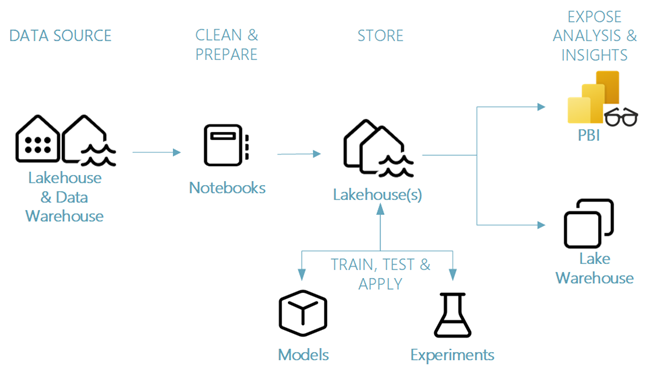

Tato série kurzů představuje zjednodušený komplexní scénář datových věd zahrnující:

- Příjem dat z externího zdroje dat

- Zkoumání a čištění dat

- Trénování a registrace modelu strojového učení

- Dávkové vyhodnocování a ukládání předpovědí

- Vizualizace výsledků předpovědi v Power BI

Různé komponenty scénáře datových věd

Zdroje dat – k ingestování dat pomocí Fabric se můžete snadno a rychle připojit ke službám Azure Data Services, dalším cloudovým platformám a místním datovým zdrojům. S poznámkovými bloky Fabric můžete importovat data z těchto prostředků:

- Vestavěné datové sklady jezerního typu

- Datové sklady

- Sémantické modely

- Různé zdroje dat Apache Sparku

- Různé zdroje dat, které podporují Python

Tato série kurzů se zaměřuje na příjem a načítání dat z jezera.

Prozkoumání, vyčištění a příprava – Prostředí datové vědy v platformě Fabric podporuje čištění, transformaci, zkoumání/analýzu a generování funkcí dat. Používá integrované prostředí Sparku a nástroje založené na Pythonu – například knihovnu Data Wrangler a SemPy. Tento kurz předvádí zkoumání dat pomocí seaborn knihovny Pythonu a čištění a přípravu dat pomocí Apache Sparku.

Modely a experimenty – Pomocí prostředků infrastruktury můžete trénovat, vyhodnocovat a vyhodnocovat modely strojového učení pomocí integrovaných experimentů. Pro registraci a nasazení modelů a sledování experimentů nabízí MLflow bezproblémovou integraci s platformou Fabric jako způsob modelování položek. K vytváření a sdílení obchodních přehledů nabízí Fabric další funkce pro predikci modelu ve velkém měřítku (PREDICT).

Storage – Fabric standardizuje na Delta Lake, což znamená, že všechny engine Fabric mohou pracovat se stejnou datovou sadou uloženou v datovém skladu typu lakehouse. V této vrstvě úložiště můžete ukládat strukturovaná i nestrukturovaná data, která podporují ukládání na základě souborů i tabulkového formátu. K datovým sadám a uloženým souborům můžete snadno přistupovat prostřednictvím všech položek prostředí Fabric – například k poznámkovým blokům a kanálům.

Zveřejnění analýzy a přehledů – Power BI, špičkový nástroj business intelligence, může využívat data lakehouse pro generování sestav a vizualizací. V prostředcích poznámkového bloku, nativních knihovnách vizualizací v Pythonu nebo Sparku

matplotlibseabornplotly- atd.

může vizualizovat data zachovaná v jezeře. Knihovna SemPy podporuje také vizualizaci dat. Tato knihovna podporuje integrované bohaté vizualizace specifické pro úlohy pro

- Sémantický datový model

- Závislosti a jejich porušení

- Případy použití klasifikace a regrese