Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

I denne artikel kan du se, hvordan du opretter brugerdefinerede Apache Spark-grupper i Microsoft Fabric til dine analysearbejdsbelastninger. Apache Spark-puljer giver dig mulighed for at oprette skræddersyede beregningsmiljøer baseret på dine krav, så du får optimal ydeevne og ressourceforbrug.

Angiv minimum- og maksimumnoder for automatisk skalering. Systemet henter og udfaser noder, efterhånden som dit jobs beregningsbehov ændres, så skaleringen er effektiv, og ydeevnen forbedres. Spark-puljer justerer antallet af eksekutorer automatisk, så du ikke behøver at indstille dem manuelt. Systemet ændrer antallet af udførere baseret på datamængde og jobberegningsbehov, så du kan fokusere på dine arbejdsbelastninger i stedet for justering af ydeevne og ressourcestyring.

Tips

Når du konfigurerer Spark-puljer, bestemmes nodestørrelsen af kapacitetsenheder (CU), som repræsenterer den beregningskapacitet, der er tildelt hver node. Du kan finde flere oplysninger om nodestørrelser og CU i afsnittet Indstillinger for nodestørrelse i denne vejledning.

Forudsætninger

Hvis du vil oprette en brugerdefineret Spark-pulje, skal du sørge for, at du har administratoradgang til arbejdsområdet. Kapacitetsadministratoren aktiverer indstillingen Tilpassede arbejdsområdepuljer i afsnittet Spark Compute i indstillingerne for kapacitetsadministrator. Du kan finde flere oplysninger under Spark Compute-indstillinger for strukturkapaciteter.

Opret brugerdefinerede Spark-puljer

Sådan opretter eller administrerer du den Spark-gruppe, der er knyttet til dit arbejdsområde:

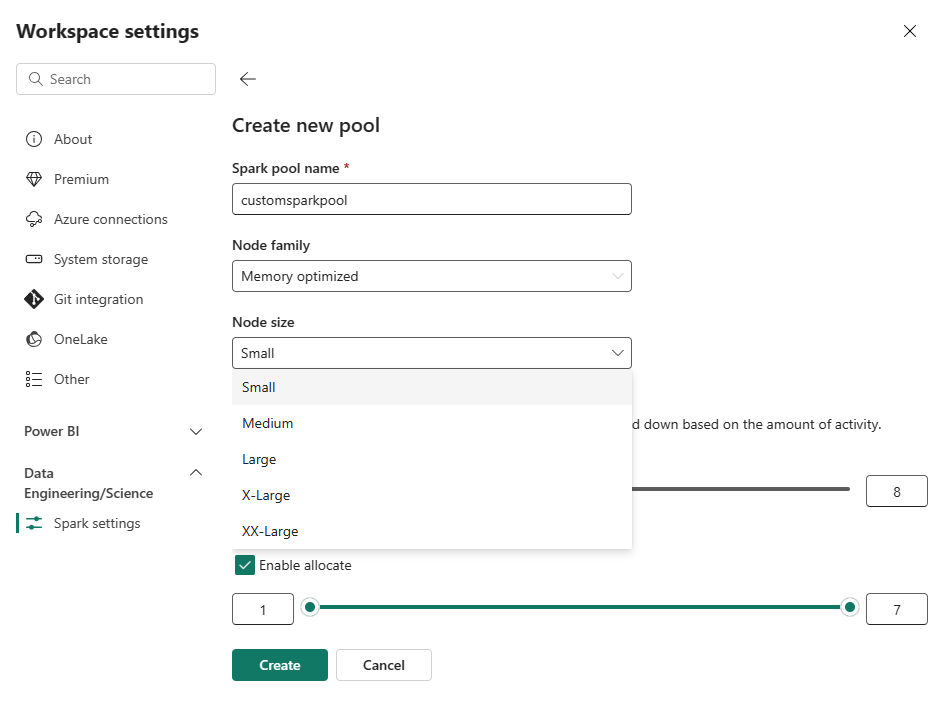

Gå til dit arbejdsområde, og vælg Indstillinger for arbejdsområde.

Vælg indstillingen

Data Engineering/Science for at udvide menuen, og vælg derefter Spark-indstillinger .Vælg indstillingen

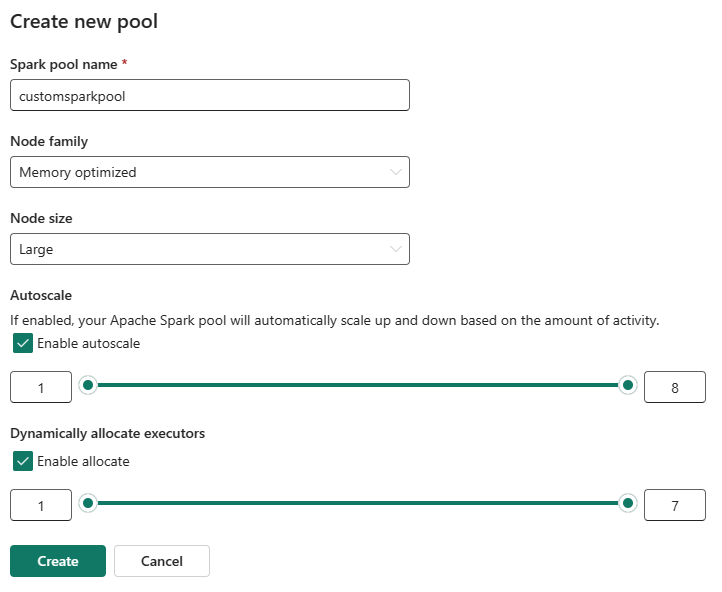

Ny pulje. På skærmen Opret gruppe skal du navngive din Spark-pulje. Vælg også Node-serien, og vælg en Nodestørrelse blandt de tilgængelige størrelser (Lille, Mellem, Stor, X-Storog XX-Stor) baseret på beregningskrav til dine arbejdsbelastninger. Du kan angive den mindste nodekonfiguration for dine brugerdefinerede puljer til 1. Da Fabric Spark giver restorable tilgængelighed for klynger med en enkelt node, behøver du ikke at bekymre dig om jobfejl, tab af session under fejl eller over betaling af beregning for mindre Spark-job.

Du kan aktivere eller deaktivere automatisk skalering for dine brugerdefinerede Spark-puljer. Når automatisk skalering er aktiveret, henter gruppen dynamisk nye noder op til den maksimale nodegrænse, der er angivet af brugeren, og trækker dem derefter tilbage efter udførelse af jobbet. Denne funktion sikrer bedre ydeevne ved at justere ressourcer baseret på jobkravene. Du har tilladelse til at tilpasse størrelsen på de noder, der passer til de kapacitetsenheder, der er købt som en del af Fabric-kapacitets-SKU'en.

Du kan justere antallet af eksekverere ved hjælp af en skyder. Hver eksekvering er en Spark-proces, der kører opgaver og indeholder data i hukommelsen. Stigende eksekvering kan forbedre parallelitet, men det øger også størrelsen og opstartstiden for klyngen. Du kan også vælge at aktivere dynamisk eksekvering af eksekvering for din Spark-gruppe, hvilket automatisk bestemmer det optimale antal eksekveringsfiler inden for den brugerdefinerede maksimale grænse. Denne funktion justerer antallet af eksekveringsprogrammer baseret på datamængde, hvilket resulterer i forbedret ydeevne og ressourceudnyttelse.

Disse brugerdefinerede puljer har en standardvarighed for automatisk pause på 2 minutter, efter at tidsperioden for inaktivitet var udløbet. Når varigheden af autopausen er nået, udløber sessionen, og klyngerne er ikke allokeret. Du faktureres på baggrund af antallet af noder og den varighed, som de brugerdefinerede Spark-puljer bruges til.

Seddel

Brugerdefinerede Spark-puljer i Microsoft Fabric understøtter i øjeblikket en maksimal nodegrænse på 200. Når du konfigurerer automatisk skalering eller angiver manuelle nodeantal, skal du sørge for, at dine minimums- og maksimumværdier forbliver inden for denne grænse. Overskridelse af denne grænse vil resultere i valideringsfejl under oprettelse eller opdatering af puljen.

Indstillinger for nodestørrelse

Når du konfigurerer en brugerdefineret Spark-pulje, skal du vælge mellem følgende nodestørrelser:

| Nodestørrelse | vCores | Hukommelse (GB) | Beskrivelse |

|---|---|---|---|

| Lille | 4 | 32 | Til lette udviklings- og testopgaver. |

| Mellem | 8 | 64 | Til generelle arbejdsbelastninger og typiske operationer. |

| Stor | 16 | 128 | Til hukommelseskrævende opgaver eller store databehandlingsjob. |

| X-stor | 32 | 256 | Til de mest krævende Spark-arbejdsbelastninger, der kræver betydelige ressourcer. |

Relateret indhold

- Få mere at vide i den offentlige dokumentation til Apache Spark .

- Kom i gang med administrationsindstillinger for Spark-arbejdsområde i Microsoft Fabric.