Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

Notat

Fabric Runtime 2.0 er i øjeblikket i en eksperimentel forhåndsvisning. For mere information, se begrænsningerne og noterne.

Fabric Runtime leverer problemfri integration i Microsoft Fabric-økosystemet og tilbyder et robust miljø for data engineering og data science-projekter drevet af Apache Spark.

Denne artikel introducerer Fabric Runtime 2.0 Experimental (Preview), den nyeste runtime designet til big data-beregninger i Microsoft Fabric. Den fremhæver de vigtigste funktioner og komponenter, der gør denne udgivelse til et betydeligt skridt fremad for skalerbar analyse og avancerede arbejdsbelastninger.

Fabric Runtime 2.0 indeholder følgende komponenter og opgraderinger, der er designet til at forbedre dine databehandlingsmuligheder:

- Apache Spark 4.0

- Operativsystem: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta Lake: 4,0

Aktiver Runtime 2.0

Du kan aktivere Runtime 2.0 enten på arbejdsområdeniveau eller miljøobjektniveau. Brug arbejdsområde-indstillingen til at anvende Runtime 2.0 som standard for alle Spark-arbejdsbelastninger i dit arbejdsområde. Alternativt kan du oprette et Environment-element med Runtime 2.0, som kan bruges med specifikke notebooks eller Spark-jobdefinitioner, hvilket tilsidesætter workspace-standarden.

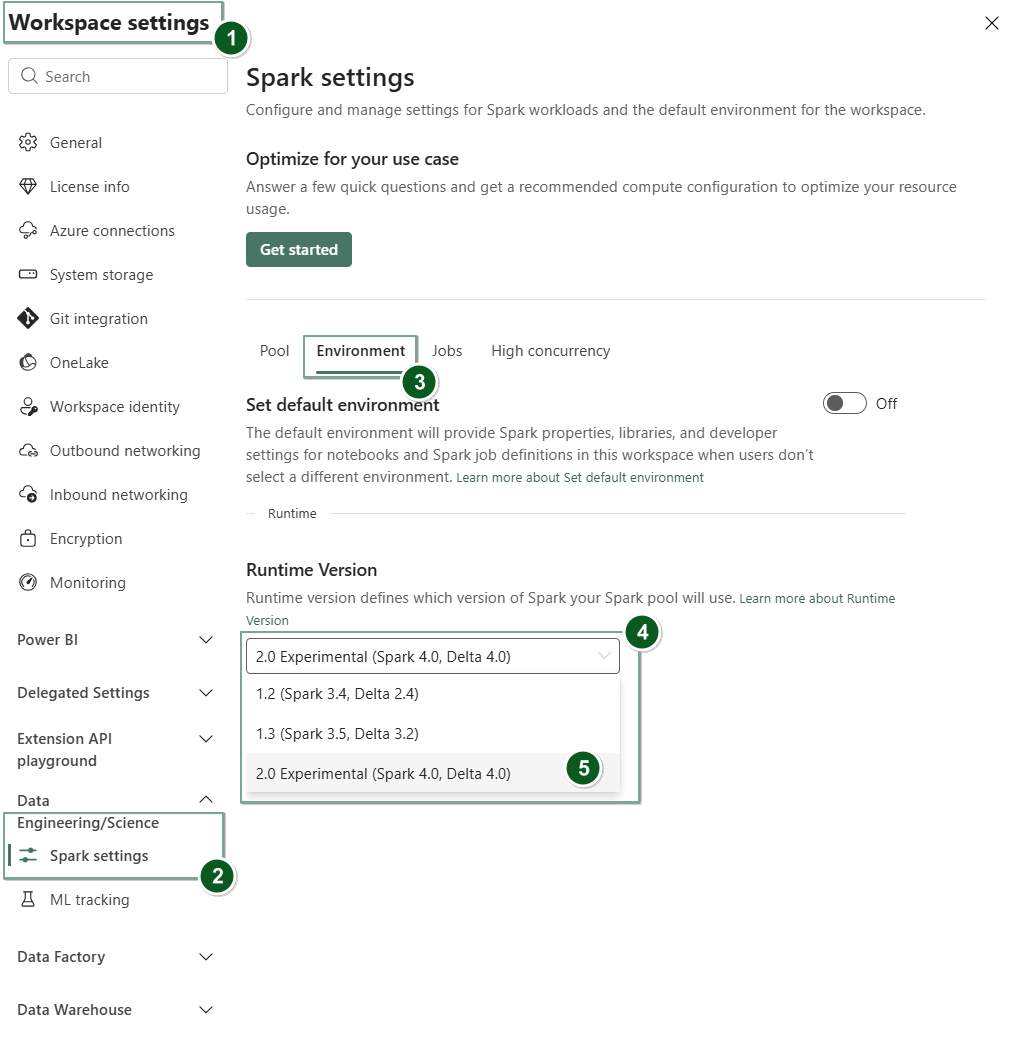

Aktiver Runtime 2.0 i Workspace-indstillingerne

For at sætte Runtime 2.0 som standard for hele dit arbejdsområde:

Gå til fanen Indstillinger for arbejdsområde i dit Fabric-arbejdsområde.

Gå til fanen Data Engineering/Science og vælg Spark-indstillinger.

Vælg fanen Miljø .

Under dropdown-menuen for runtime-versionen vælger du 2.0 Experimental (Spark 4.0, Delta 4.0) og gemmer dine ændringer. Denne handling sætter Runtime 2.0 som standardruntime for dit arbejdsområde.

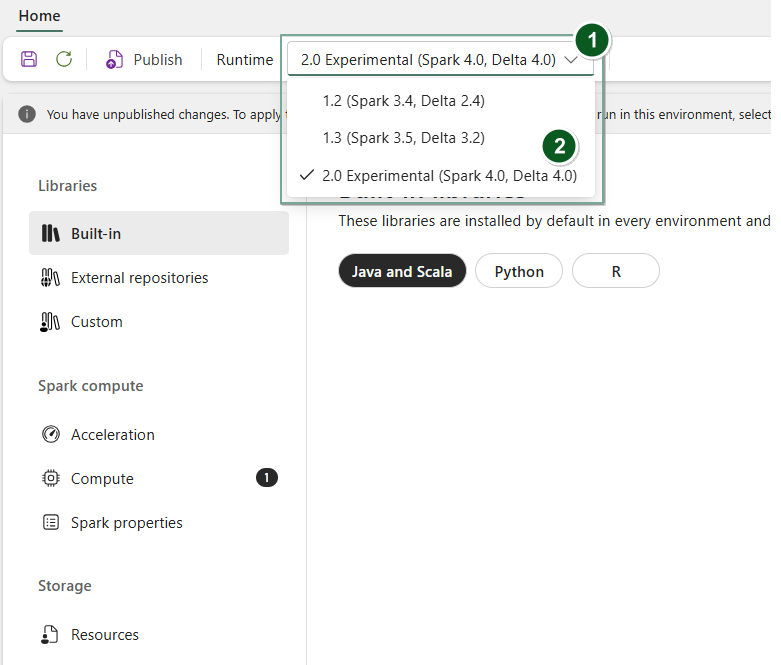

Aktivér Runtime 2.0 i et miljøelement

For at bruge Runtime 2.0 med specifikke notebooks eller Spark-jobdefinitioner:

Opret et nyt miljøobjekt eller åbn et eksisterende.

Under Runtime-dropdownmenuen vælger du 2.0 Experimental (Spark 4.0, Delta 4.0)

SaveogPublishdine ændringer.Vigtigt

Det kan tage omkring 2-5 minutter for Spark 2.0-sessioner at starte, da startpuljer ikke er en del af den tidlige eksperimentelle udgivelse.

Dernæst kan du bruge dette Miljø-element med din

NotebookellerSpark Job Definition.

Du kan nu begynde at eksperimentere med de nyeste forbedringer og funktioner, der er introduceret i Fabric Runtime 2.0 (Spark 4.0 og Delta Lake 4.0).

Eksperimentel offentlig forhåndsvisning

Fabric runtime 2.0 eksperimentelle preview-fasen giver dig tidlig adgang til nye funktioner og API'er fra både Spark 4.0 og Delta Lake 4.0. Forhåndsvisningen lader dig bruge de nyeste Spark-baserede forbedringer med det samme, hvilket sikrer en glidende parathed og overgang til fremtidige ændringer som de nyere Java-, Scala- og Python-versioner.

Tips

Hvis du vil have opdaterede oplysninger, en detaljeret liste over ændringer og specifikke produktbemærkninger til Fabric-kørsel, skal du kontrollere og abonnere på Spark Runtimes-udgivelser og -opdateringer.

Begrænsninger og noter

Fabric Runtime 2.0 er i øjeblikket i en eksperimentel offentlig preview-fase, designet til at brugere kan udforske og eksperimentere med de nyeste funktioner og API'er fra Spark og Delta Lake i udviklings- eller testmiljøerne. Selvom denne version giver adgang til kernefunktioner, er der visse begrænsninger:

Du kan bruge Spark 4.0-sessioner, skrive kode i notesbøger, planlægge Spark-jobdefinitioner og bruge med PySpark, Scala og Spark SQL. Dog understøttes R-sproget ikke i denne tidlige udgave.

Du kan installere biblioteker direkte i din kode med pip og conda. Du kan sætte Spark-indstillinger via de %%configure muligheder i notesbøger og Spark Job Definitions (SJD'er).

Du kan læse og skrive til Lakehouse med Delta Lake 4.0, men nogle avancerede funktioner som V-orden, native Parquet-skrivning, autokomprimering, optimering af skrivning, lav-shuffle sammenfletning, sammenfletning, skemaudvikling og tidsrejser er ikke inkluderet i denne tidlige udgivelse.

Spark Advisor er i øjeblikket utilgængelig. Dog understøttes overvågningsværktøjer som Spark UI og logs i denne tidlige udgave.

Funktioner som Data Science-integrationer inklusive Copilot og connectors som Kusto, SQL Analytics, Cosmos DB og MySQL Java Connector understøttes i øjeblikket ikke i denne tidlige version. Data Science-biblioteker understøttes ikke i PySpark-miljøer. PySpark fungerer kun med et grundlæggende Conda-setup, som inkluderer PySpark alene uden ekstra biblioteker.

Integrationer med miljøobjekt og Visual Studio Code understøttes ikke i denne tidlige udgivelse.

Den understøtter ikke læsning og skrivning af data til General Purpose v2 (GPv2) Azure Storage-konti med WASB- eller ABFS-protokoller.

Notat

Del din feedback på Fabric Runtime på Ideas-platformen. Sørg for at nævne den version og udgivelsesfase, du henviser til. Vi værdsætter feedback fra fællesskabet og prioriterer forbedringer baseret på stemmer, så vi sikrer, at vi opfylder brugernes behov.

Centrale punkter

Apache Spark 4.0

Apache Spark 4.0 markerer en vigtig milepæl som den første udgivelse i 4.x-serien og indkapsler den kollektive indsats fra det levende open source-fællesskab.

I denne version er Spark SQL betydeligt beriget med kraftfulde nye funktioner, der skal øge udtryksfuldhed og alsidighed for SQL-arbejdsbelastninger, såsom understøttelse af VARIANT-datatyper, brugerdefinerede SQL-funktioner, sessionsvariabler, pipesyntaks og streng-kollation. PySpark ser en kontinuerlig dedikation til både sin funktionelle bredde og den samlede udvikleroplevelse, idet det bringer en native plotting API, en ny Python Data Source API, understøttelse af Python UDTF'er og samlet profilering af PySpark UDF'er, sammen med adskillige andre forbedringer. Structured Streaming udvikler sig med nøgletilføjelser, der giver større kontrol og nem fejlfinding, især introduktionen af Arbitrary State API v2 for mere fleksibel tilstandsstyring og State Data Source for nemmere fejlfinding.

Du kan kontrollere den komplette liste og detaljerede ændringer her: https://spark.apache.org/releases/spark-release-4-0-0.html.

Notat

I Spark 4.0 er SparkR forældet og kan blive fjernet i en fremtidig version.

Delta Lake 4.0

Delta Lake 4.0 markerer et fælles engagement i at gøre Delta Lake interoperabel på tværs af formater, lettere at arbejde med og mere performant. Delta 4.0 er en milepælsudgivelse fyldt med kraftfulde nye funktioner, ydeevneoptimeringer og grundlæggende forbedringer for fremtiden for åbne data-lakehuse.

Du kan se den fulde liste og de detaljerede ændringer, der blev indført med Delta Lake 3.3 og 4.0 her: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Vigtigt

Delta Lake 4.0-specifikke funktioner er eksperimentelle og fungerer kun på Spark-oplevelser, såsom notebooks og Spark Job Definitions. Hvis du skal bruge de samme Delta Lake-tabeller på tværs af flere Microsoft Fabric-arbejdsbelastninger, skal du ikke aktivere de funktioner. For at lære mere om, hvilke protokolversioner og funktioner der er kompatible på tværs af alle Microsoft Fabric-oplevelser, læs Delta Lake table format interoperability.

Relateret indhold

- Apache Spark runtimes i Fabric - Oversigt, versionering og understøttelse af flere runtimes

- Spark Core-migreringsvejledning

- Vejledninger til migrering af SQL, Datasæt og DataFrame

- Vejledning til struktureret overførsel af streaming

- Overflytningsvejledning til MLlib (Machine Learning)

- Migreringsvejledning til PySpark (Python on Spark)

- SparkR-migreringsvejledning (R on Spark)