Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

I denne hurtige introduktion får du mere at vide om, hvordan dataflow og pipelines arbejder sammen for at oprette en effektiv Data Factory-løsning. Du skal rense data med dataflow og flytte dem med pipelines.

Forudsætninger

Før du starter, skal du bruge:

- En lejerkonto med et aktivt abonnement. Opret en gratis konto.

- Et Microsoft Fabric-aktiveret arbejdsområde: Konfigurer et arbejdsområde , der ikke er standardniveauet Mit arbejdsområde.

- En Azure SQL-database med tabeldata.

- En Blob Storage-konto.

Sammenlign dataflow og pipelines

Dataflow Gen2 giver en grænseflade med lav kode med 300+ data og AI-baserede transformationer. Du kan nemt rense, forberede og transformere data med fleksibilitet. Pipelines tilbyder omfattende dataorkestreringsfunktioner til at oprette fleksible dataarbejdsprocesser, der opfylder virksomhedens behov.

I en pipeline kan du oprette logiske grupperinger af aktiviteter, der udfører en opgave. Dette kan omfatte kald af et dataflow for at rense og forberede dine data. Selvom der er en vis overlapning af funktionaliteten mellem de to, afhænger dit valg af, om du har brug for de fulde funktioner i pipelines eller kan bruge de enklere funktioner i dataflow. Du kan finde flere oplysninger i Beslutningsvejledning til struktur.

Transformér data med dataflow

Følg disse trin for at konfigurere dit dataflow.

Oprette et dataflow

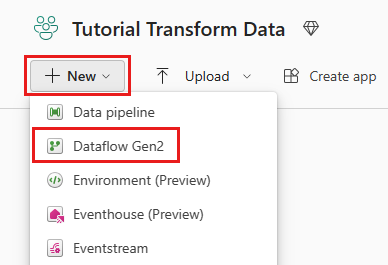

Vælg dit Fabric-aktiverede arbejdsområde, derefter Ny, og vælg Dataflow Gen2.

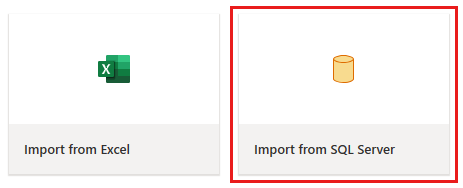

I datafloweditoren skal du vælge Importér fra SQL Server.

Hent data

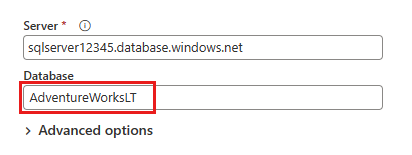

I dialogboksen Opret forbindelse til datakilde skal du angive dine Azure SQL-databaseoplysninger og vælge Næste. Brug AdventureWorksLT-eksempeldatabasen ud fra forudsætningerne.

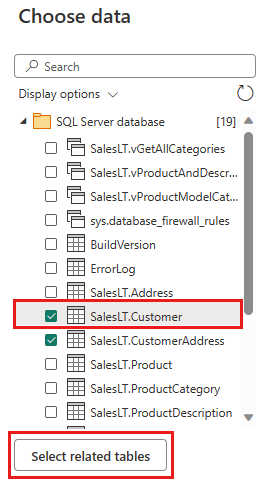

Vælg de data, der skal transformeres, f.eks. SalesLT.Customer, og brug Vælg relaterede tabeller til at medtage relaterede tabeller. Vælg derefter Opret.

Transformér dine data

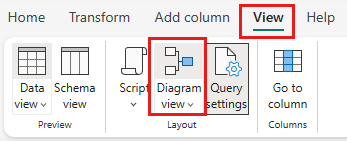

Vælg Diagramvisning på statuslinjen eller menuen Vis i Power Query-editoren.

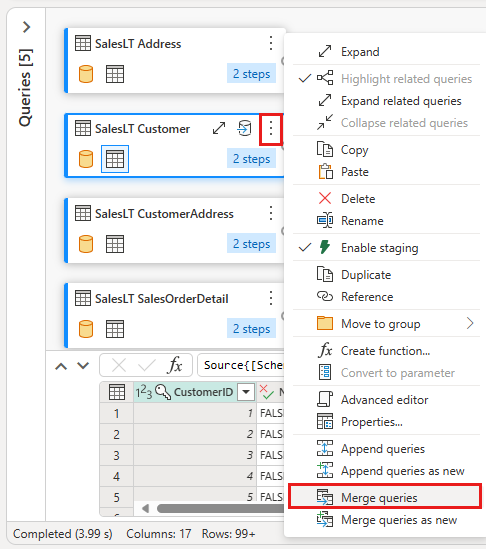

Højrevælg din SalesLT-kundeforespørgsel , eller vælg den lodrette ellipse til højre for forespørgslen, og vælg derefter Flet forespørgsler.

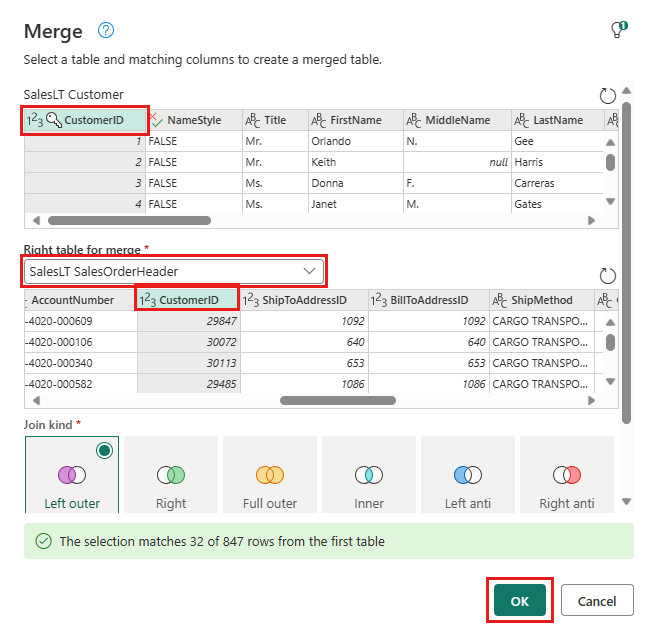

Konfigurer fletningen med SalesLTOrderHeader som højre tabel, CustomerID som joinkolonne og Venstre ydre som jointype. Vælg OK.

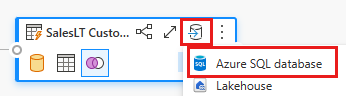

Tilføj en datadestination ved at vælge databasesymbolet med en pil. Vælg Azure SQL-database som destinationstype.

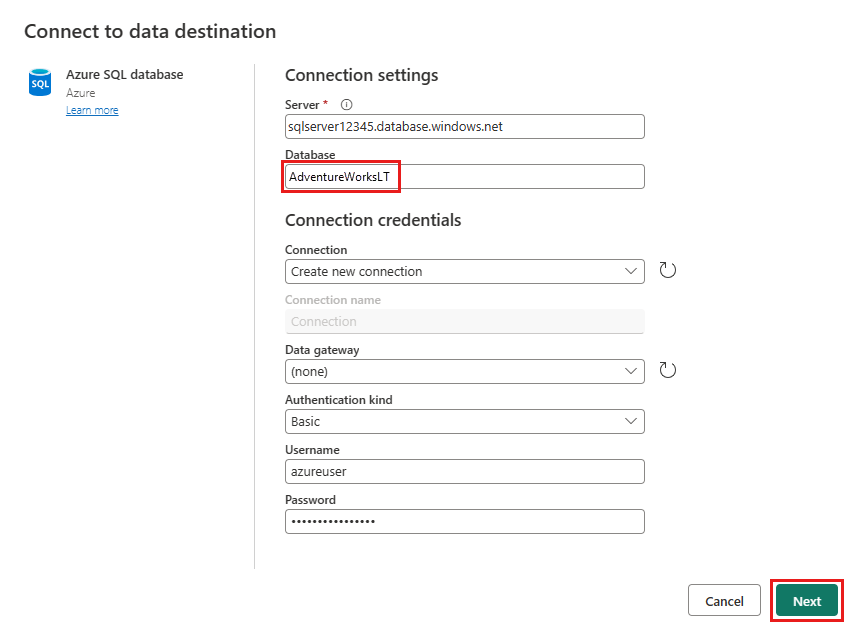

Angiv oplysninger om din Azure SQL-databaseforbindelse, hvor fletteforespørgslen skal publiceres. I dette eksempel bruger vi også den AdventureWorksLT-database , vi brugte, som datakilde for destinationen.

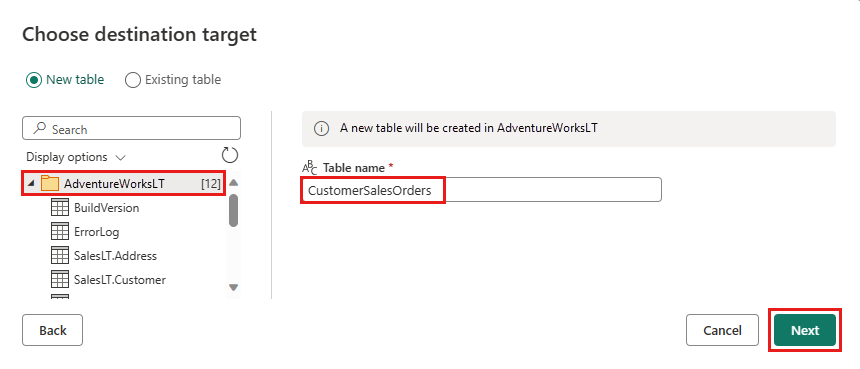

Vælg en database, hvor dataene skal gemmes, og angiv et tabelnavn, og vælg derefter Næste.

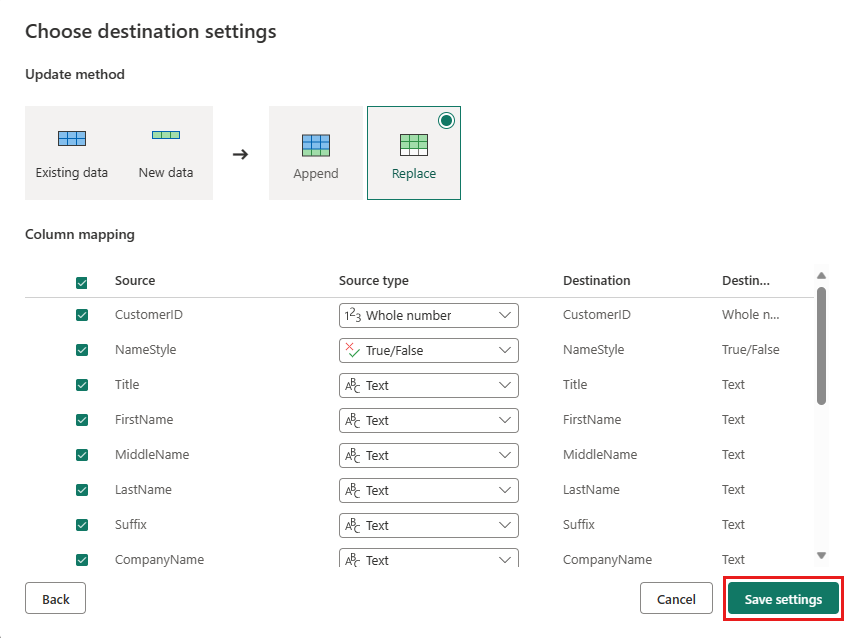

Accepter standardindstillingerne i dialogboksen Vælg destinationsindstillinger , og vælg Gem indstillinger.

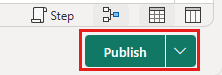

Vælg Publicer i datafloweditoren for at publicere dataflowet.

Flyt data med pipelines

Nu, hvor du har oprettet en Dataflow Gen2, kan du arbejde på den i en pipeline. I dette eksempel kopierer du de data, der er genereret fra dataflowet, til tekstformat på en Azure Blob Storage-konto.

Opret en ny pipeline

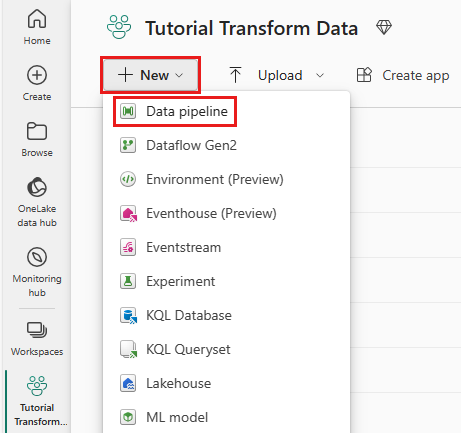

I dit arbejdsområde skal du vælge Ny og derefter Pipeline.

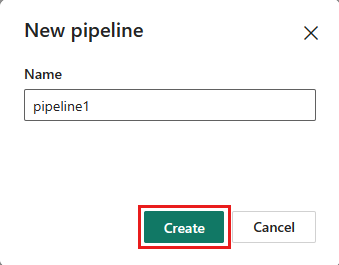

Navngiv din pipeline, og vælg Opret.

Konfigurer dit dataflow

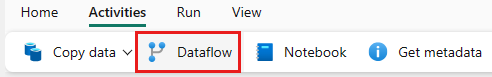

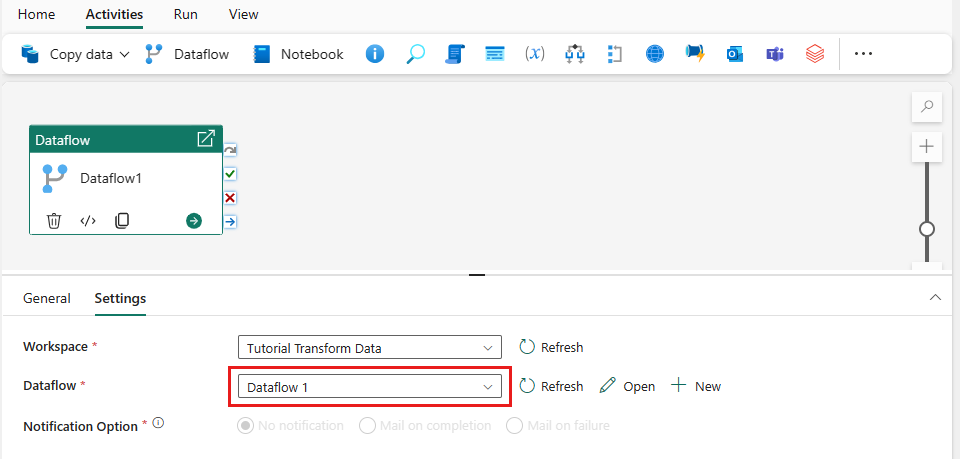

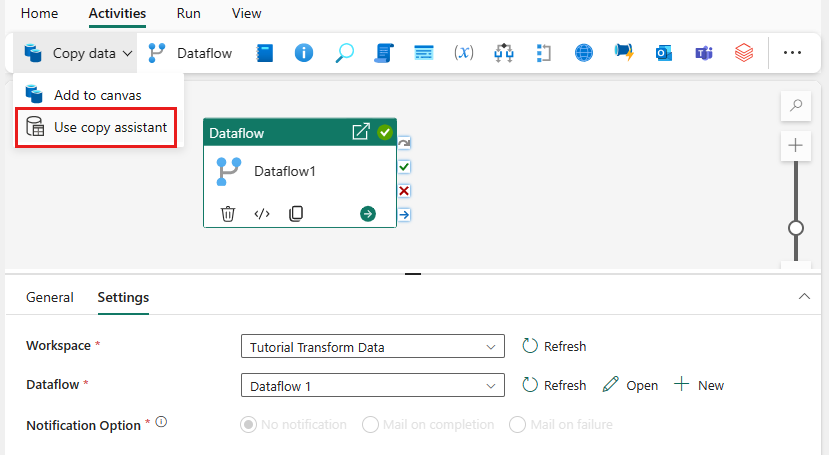

Føj en dataflowaktivitet til din pipeline ved at vælge Dataflow under fanen Aktiviteter .

Vælg dataflowet på pipelinelærredet, gå til fanen Indstillinger , og vælg det dataflow, du oprettede tidligere.

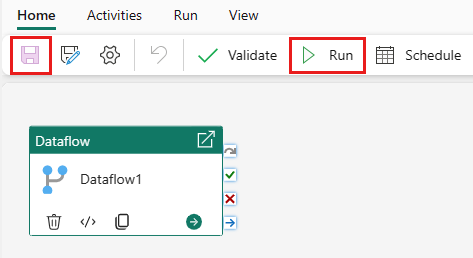

Vælg Gem og derefter Kør for at udfylde den flettede forespørgselstabel.

Tilføj en kopiaktivitet

Vælg Kopiér data på lærredet, eller brug Kopiassistent under fanen Aktiviteter .

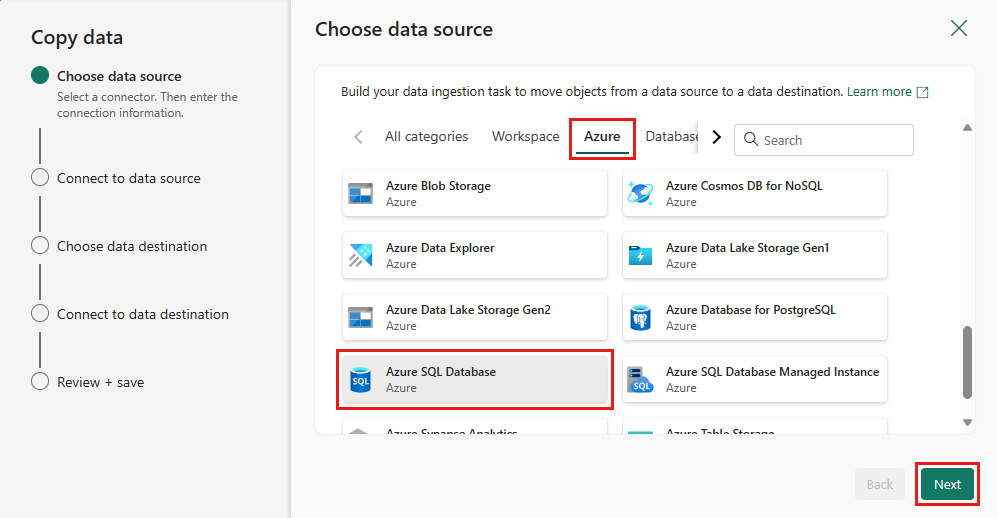

Vælg Azure SQL Database som datakilde, og vælg Næste.

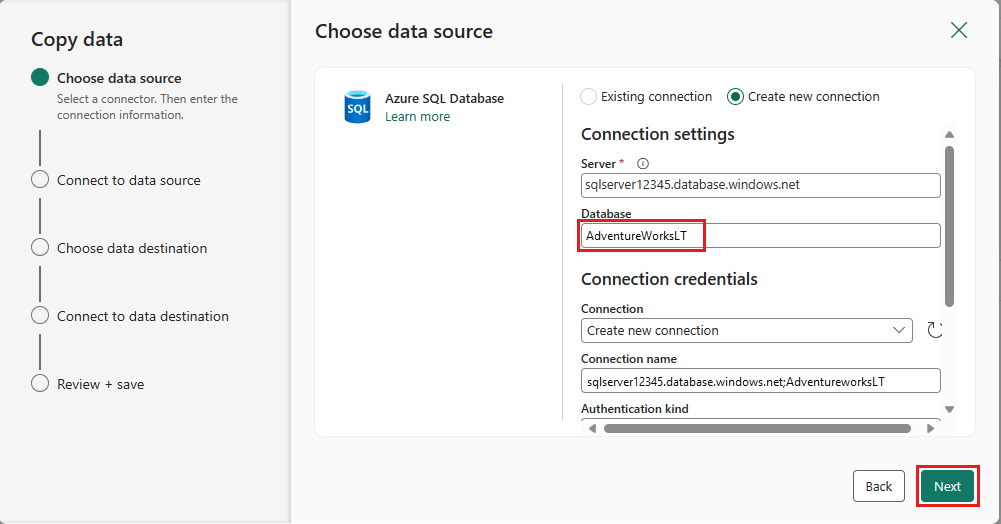

Opret en forbindelse til datakilden ved at vælge Opret ny forbindelse. Udfyld de påkrævede forbindelsesoplysninger i panelet, og angiv AdventureWorksLT for databasen, hvor vi oprettede fletteforespørgslen i dataflowet. Vælg derefter Næste.

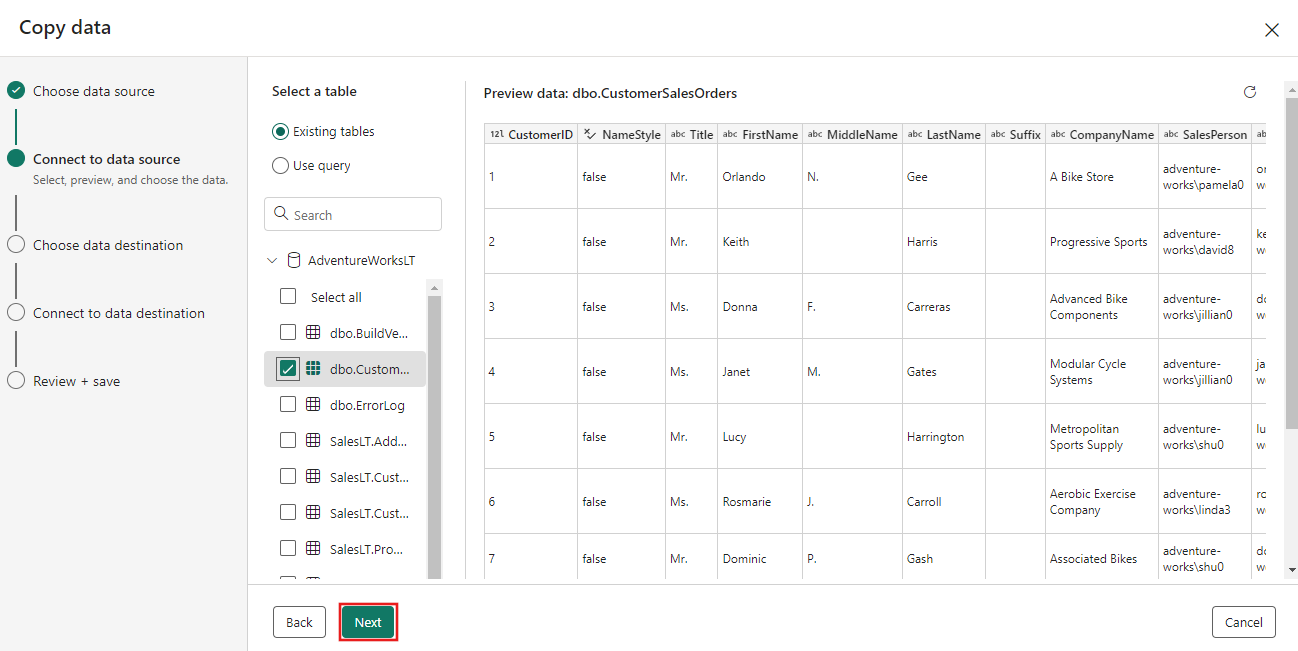

Vælg den tabel, du oprettede i dataflowtrinnet tidligere, og vælg derefter Næste.

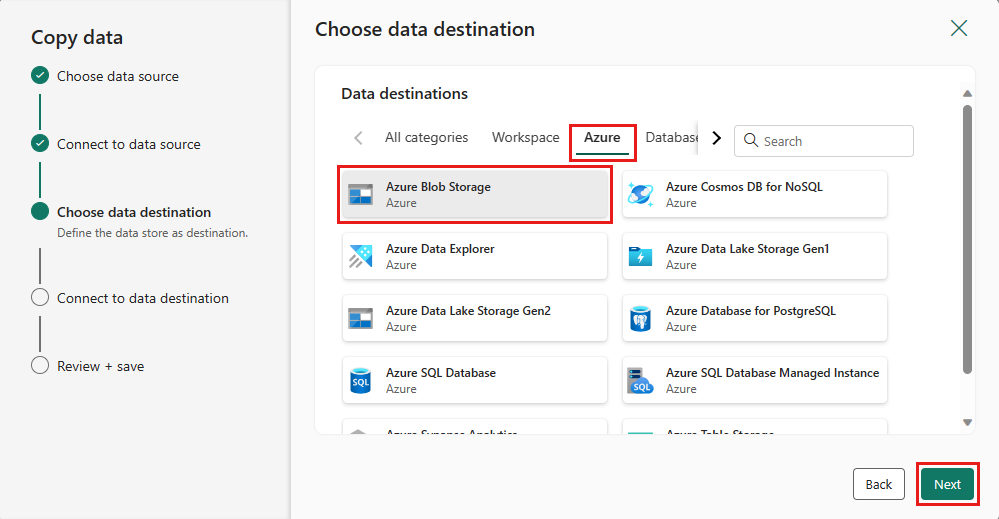

Vælg Azure Blob Storage- for destinationen, og vælg derefter Næste.

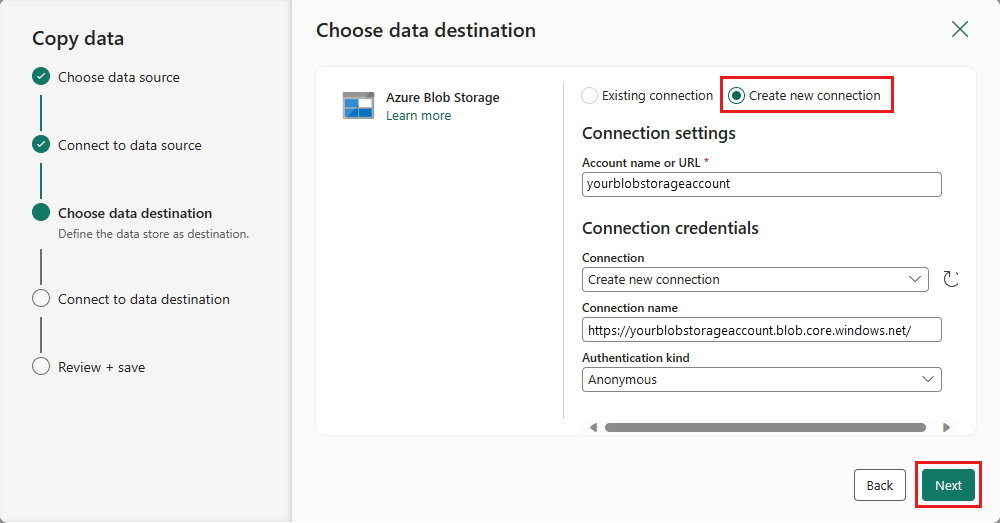

Opret en forbindelse til destinationen ved at vælge Opret ny forbindelse. Angiv detaljerne for forbindelsen, og vælg derefter Næste.

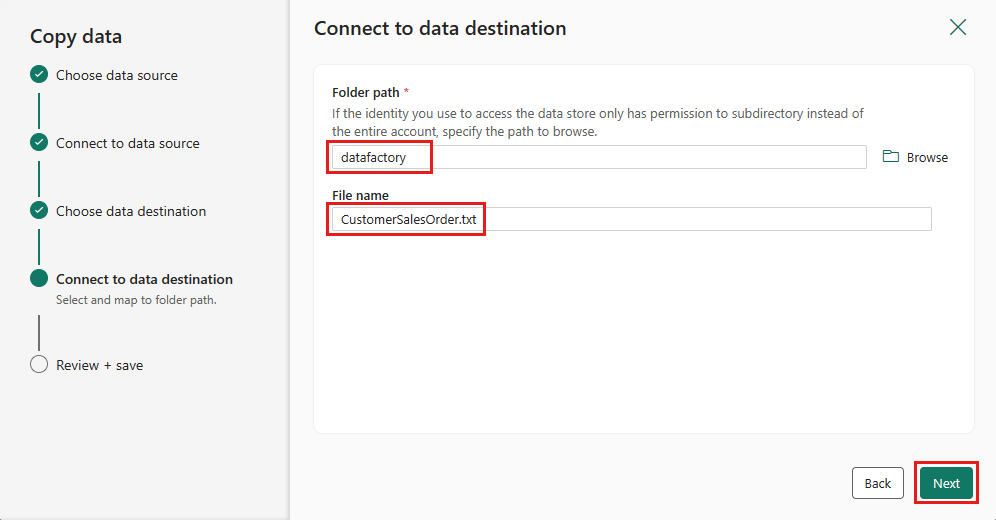

Vælg stien til den mappe, og angiv et Filnavn, og vælg derefter Næste.

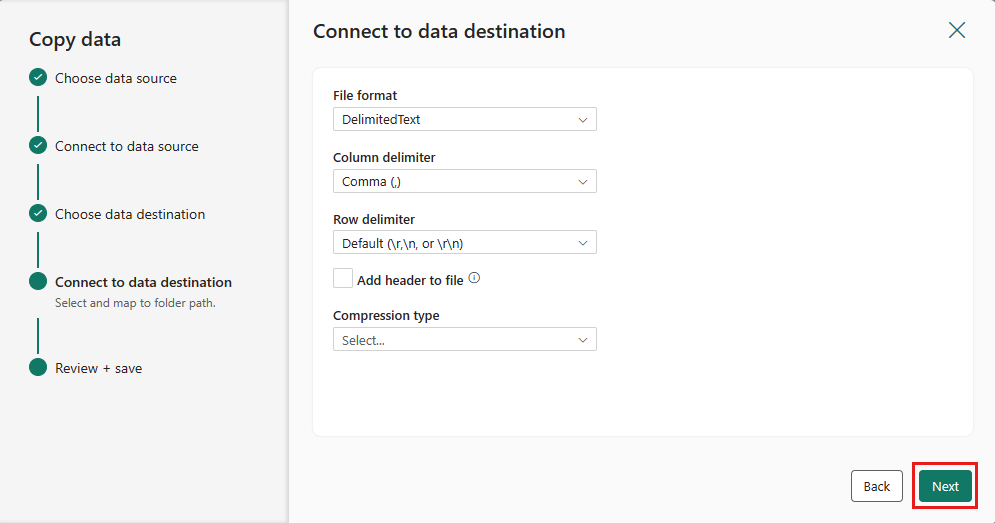

Vælg Næste igen for at acceptere standardfilformatet, kolonneafgrænseren, rækkeafgrænseren og komprimeringstypen, eventuelt med en overskrift.

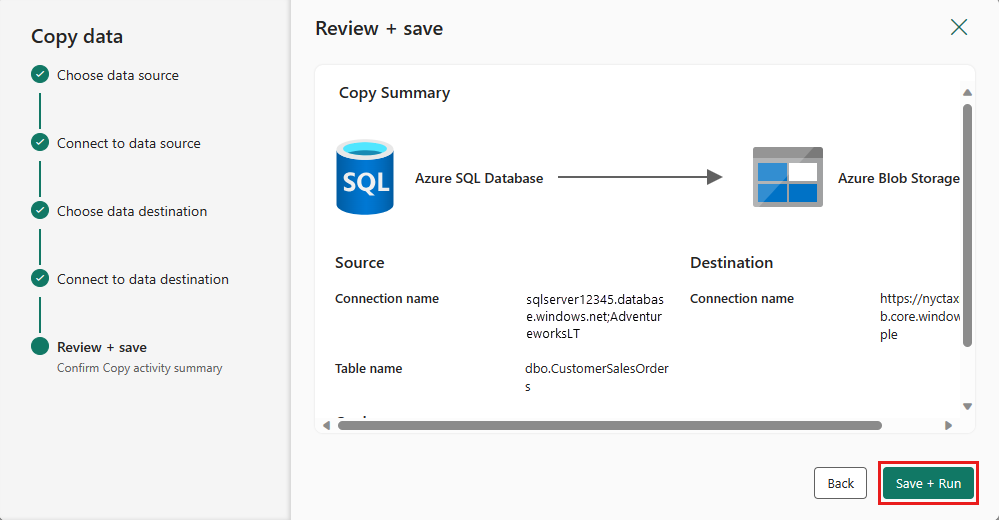

Afslut indstillingerne. Gennemse og vælg derefter Gem + Kør for at afslutte processen.

Design din pipeline, og gem for at køre og indlæse data

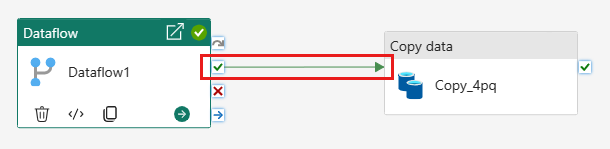

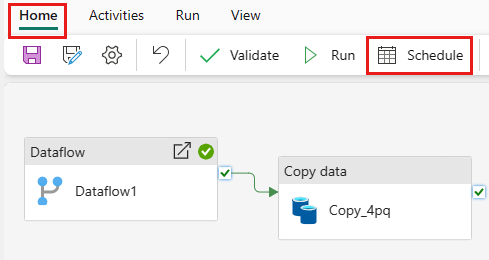

Hvis du vil køre Kopiér-aktivitet efter --aktivitet, skal du trække fra lykkedes på aktivitet for dataflowet til den Kopiér-aktivitet. Den Kopiér-aktivitet kører kun, når dataflowaktiviteten er fuldført.

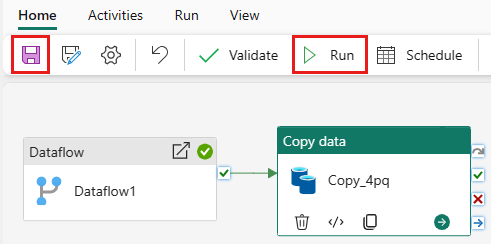

Vælg Gem for at gemme din pipeline. Vælg derefter Kør for at køre din pipeline og indlæse dine data.

Planlæg udførelse af pipeline

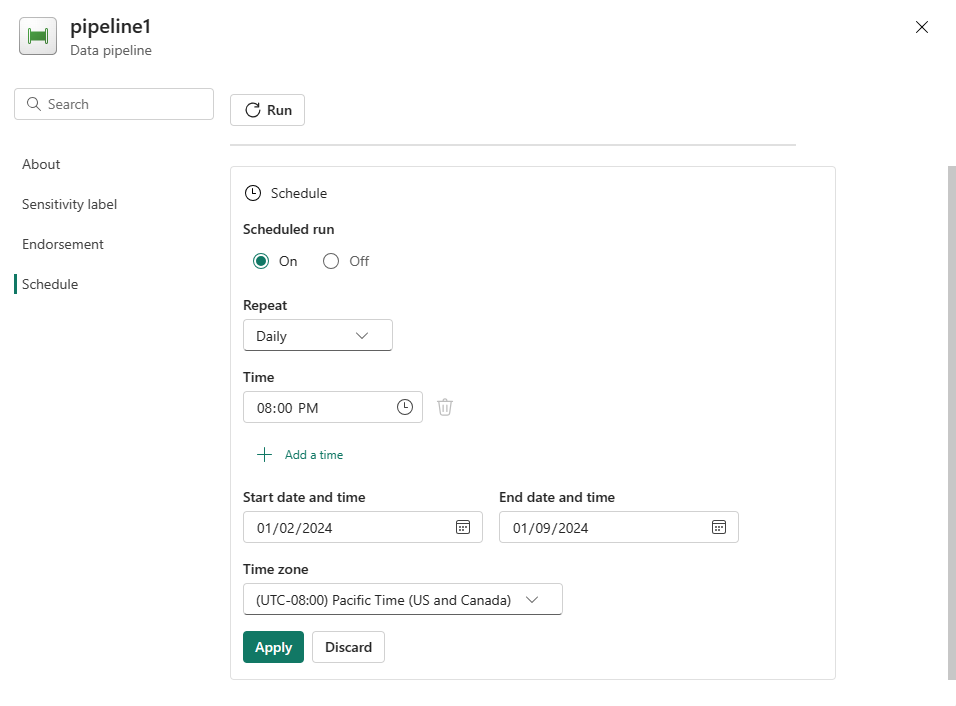

Når du er færdig med at udvikle og teste din pipeline, kan du planlægge, at den skal køre automatisk.

Vælg

Planlæg på fanenStartside i vinduet pipelineeditor.

Konfigurer tidsplanen efter behov. I eksemplet her planlægges pipelinen til at køre dagligt kl. 20:00 indtil slutningen af året.

Relateret indhold

I dette eksempel kan du se, hvordan du opretter og konfigurerer en Dataflow Gen2 for at oprette en fletteforespørgsel og gemme den i en Azure SQL-database og derefter kopiere data fra databasen til en tekstfil i Azure Blob Storage. Du har lært, hvordan du:

- Opret et dataflow.

- Transformér data med dataflowet.

- Opret en pipeline ved hjælp af dataflowet.

- Bestil udførelsen af trin i pipelinen.

- Kopiér data med Kopiér assistent.

- Kør og planlæg din pipeline.

Gå derefter videre for at få mere at vide om overvågning af dine pipelinekørsler.