Integrer OneLake med Azure Synapse Analytics

Azure Synapse er en ubegrænset analyseservice, der samler virksomhedsdataoplag og Big Data-analyser. I dette selvstudium kan du se, hvordan du opretter forbindelse til OneLake ved hjælp af Azure Synapse Analytics.

Skriv data fra Synapse ved hjælp af Apache Spark

Følg disse trin for at bruge Apache Spark til at skrive eksempeldata til OneLake fra Azure Synapse Analytics.

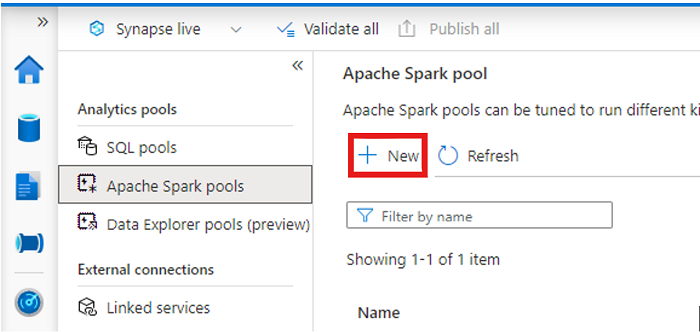

Åbn dit Synapse-arbejdsområde, og opret en Apache Spark-gruppe med dine foretrukne parametre.

Opret en ny Apache Spark-notesbog.

Åbn notesbogen, angiv sproget til PySpark (Python), og opret forbindelse til din nyoprettede Spark-gruppe.

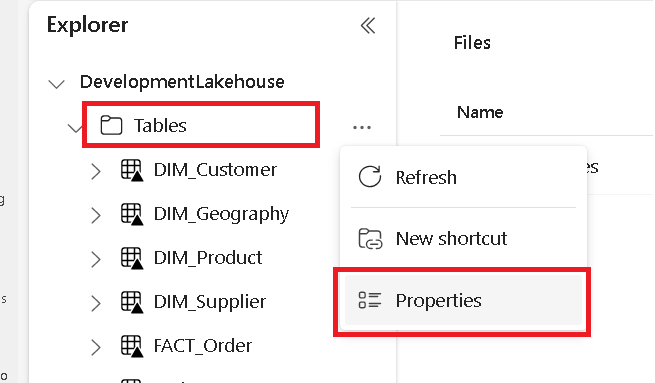

Gå til microsoft Fabric lakehouse under en separat fane, og find mappen Tabeller på øverste niveau.

Højreklik på mappen Tabeller, og vælg Egenskaber.

Kopiér ABFS-stien fra ruden Egenskaber.

Tilbage i Azure Synapse-notesbogen i den første nye kodecelle skal du angive stien til lakehouse. Dette lakehouse er stedet, hvor dine data skrives senere. Kør cellen.

# Replace the path below with the ABFS path to your lakehouse Tables folder. oneLakePath = 'abfss://WorkspaceName@onelake.dfs.fabric.microsoft.com/LakehouseName.lakehouse/Tables'I en ny kodecelle skal du indlæse data fra et åbent Azure-datasæt i en dataramme. Dette datasæt er det, du indlæser i dit lakehouse. Kør cellen.

yellowTaxiDf = spark.read.parquet('wasbs://nyctlc@azureopendatastorage.blob.core.windows.net/yellow/puYear=2018/puMonth=2/*.parquet') display(yellowTaxiDf.limit(10))I en ny kodecelle kan du filtrere, transformere eller forberede dine data. I dette scenarie kan du trimme dit datasæt for at få hurtigere indlæsning, deltage i andre datasæt eller filtrere ned til bestemte resultater. Kør cellen.

filteredTaxiDf = yellowTaxiDf.where(yellowTaxiDf.tripDistance>2).where(yellowTaxiDf.passengerCount==1) display(filteredTaxiDf.limit(10))I en ny kodecelle skal du ved hjælp af din OneLake-sti skrive din filtrerede dataramme til en ny Delta-Parquet-tabel i fabric lakehouse. Kør cellen.

filteredTaxiDf.write.format("delta").mode("overwrite").save(oneLakePath + '/Taxi/')Til sidst skal du i en ny kodecelle teste, at dine data blev skrevet ved at læse din nyligt indlæste fil fra OneLake. Kør cellen.

lakehouseRead = spark.read.format('delta').load(oneLakePath + '/Taxi/') display(lakehouseRead.limit(10))

Tillykke! Du kan nu læse og skrive data i OneLake ved hjælp af Apache Spark i Azure Synapse Analytics.

Læs data fra Synapse ved hjælp af SQL

Følg disse trin for at bruge SQL serveruafhængig til at læse data fra OneLake fra Azure Synapse Analytics.

Åbn et Fabric lakehouse, og identificer en tabel, som du vil forespørge fra Synapse.

Højreklik på tabellen, og vælg Egenskaber.

Kopiér ABFS-stien til tabellen.

Åbn dit Synapse-arbejdsområde i Synapse Studio.

Opret et nyt SQL-script.

I SQL-forespørgselseditoren skal du angive følgende forespørgsel og erstatte

ABFS_PATH_HEREmed den sti, du kopierede tidligere.SELECT TOP 10 * FROM OPENROWSET( BULK 'ABFS_PATH_HERE', FORMAT = 'delta') as rows;Kør forespørgslen for at få vist de øverste 10 rækker i tabellen.

Tillykke! Du kan nu læse data fra OneLake ved hjælp af SQL Serverless i Azure Synapse Analytics.