Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

I denne vejledning skal du:

Overfør data til OneLake med OneLake-stifinderen.

Brug en Fabric-notesbog til at læse data på OneLake og skrive tilbage som en Delta-tabel.

Analysér og transformér data med Spark ved hjælp af en Fabric-notesbog.

Forespørg én kopi af data på OneLake med SQL.

Forudsætninger

Før du begynder, skal du:

Download og installér OneLake-stifinder.

Opret et arbejdsområde med et Lakehouse-element.

Download WideWorldImportersDW-datasættet. Du kan bruge Azure Storage Explorer til at oprette forbindelse til

https://fabrictutorialdata.blob.core.windows.net/sampledata/WideWorldImportersDW/csv/full/dimension_cityog downloade sættet af csv-filer. Du kan også bruge dine egne csv-data og opdatere oplysningerne efter behov.

Overfør data

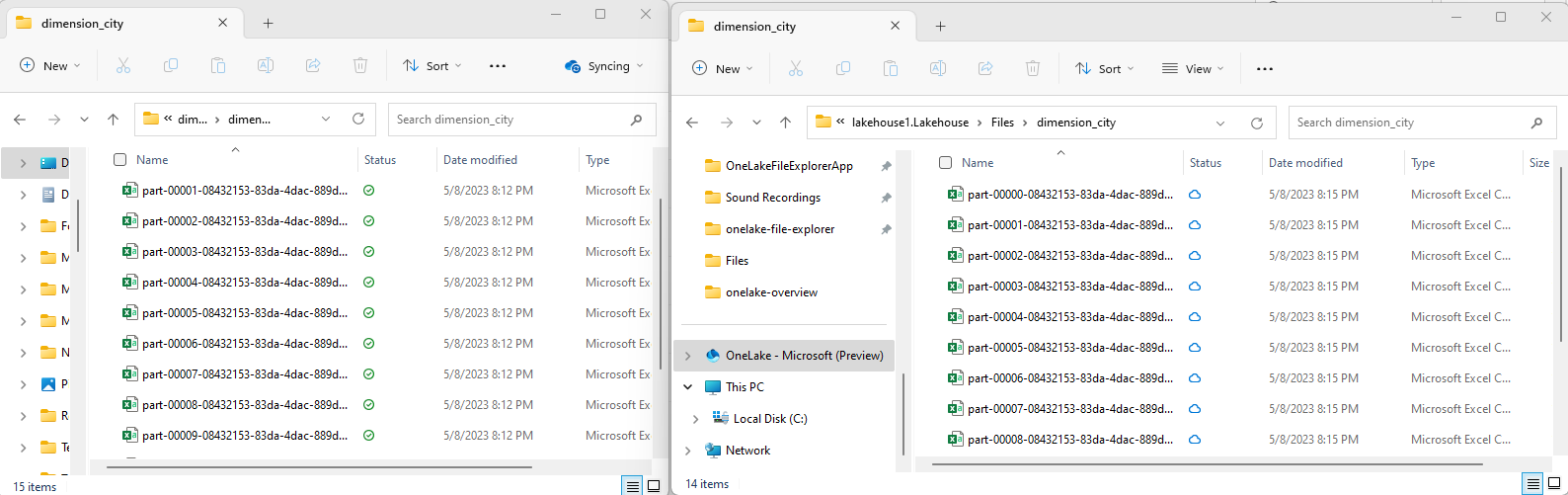

I dette afsnit uploader du testdata til dit lakehouse ved hjælp af OneLake-stifinder.

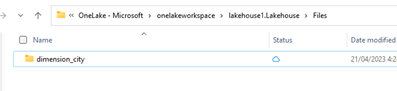

I OneLake-stifinder skal du navigere til dit lakehouse og oprette en undermappe med navnet

dimension_cityunder mappen/Files.

Kopiér dine csv-eksempelfiler til mappen

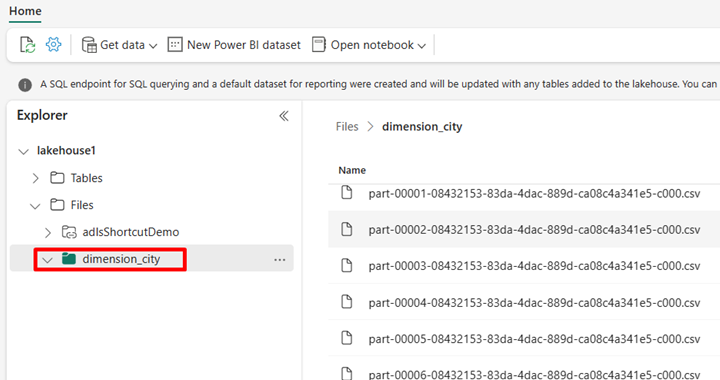

/Files/dimension_cityOneLake ved hjælp af OneLake-stifinder.Gå til dit lakehouse i Power BI- eller Fabric-tjenesten, og få vist dine filer.

Opret en Delta-tabel

I dette afsnit konverterer du de ikke-administrerede CSV-filer til en administreret tabel ved hjælp af Delta-format.

Bemærk

Opret, indlæs eller opret altid en genvej til Delta-Parquet-data direkte under afsnittet Tabeller i lakehouse. Indlejr ikke tabellerne i undermapper under afsnittet tabeller. Lakehouse genkender ikke undermapper som tabeller og angiver dem som Uidentificerede.

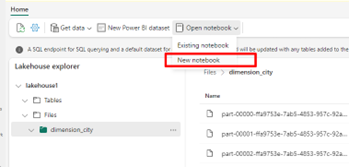

I dit lakehouse skal du vælge Åbn notesbogog derefter Ny notesbog for at oprette en notesbog.

Konvertér CSV-filerne til Delta-format ved hjælp af Fabric-notesbogen. Følgende kodestykke læser data fra den brugeroprettede mappe

/Files/dimension_cityog konverterer dem til en Delta-tabeldim_city.Kopiér kodestykket til notesbogens celleeditor. Erstat pladsholderne med dine egne arbejdsområdeoplysninger, og vælg derefter Kør celle eller Kør alle.

import os from pyspark.sql.types import * for filename in os.listdir("/lakehouse/default/Files/dimension_city"): df=spark.read.format('csv').options(header="true",inferSchema="true").load("abfss://<YOUR_WORKSPACE_NAME>@onelake.dfs.fabric.microsoft.com/<YOUR_LAKEHOUSE_NAME>.Lakehouse/Files/dimension_city/"+filename,on_bad_lines="skip") df.write.mode("overwrite").format("delta").save("Tables/dim_city")Drikkepenge

Du kan hente hele ABFS-stien til mappen ved at højreklikke på mappenavnet og vælge Kopiér ABFS-sti.

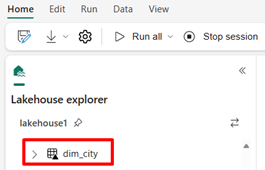

Hvis du vil se den nye tabel, skal du opdatere visningen af

/Tablesmappen. Vælg flere indstillinger (...) ud for mappen Tabeller, og vælg derefter Opdater.

Forespørg om og rediger data

I dette afsnit skal du bruge en Fabric-notesbog til at interagere med dataene i tabellen.

Forespørg din tabel med SparkSQL i den samme Fabric-notesbog.

%%sql SELECT * from <LAKEHOUSE_NAME>.dim_city LIMIT 10;Rediger tabellen Delta ved at tilføje en ny kolonne med navnet newColumn med heltal af datatypen. Angiv værdien 9 for alle posterne for denne nyligt tilføjede kolonne.

%%sql ALTER TABLE <LAKEHOUSE_NAME>.dim_city ADD COLUMN newColumn int; UPDATE <LAKEHOUSE_NAME>.dim_city SET newColumn = 9; SELECT City,newColumn FROM <LAKEHOUSE_NAME>.dim_city LIMIT 10;

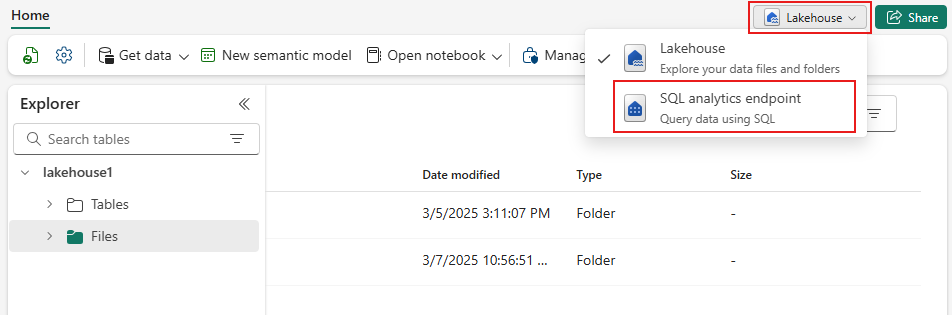

Du kan også få adgang til en hvilken som helst Delta-tabel på OneLake via et SQL Analytics-slutpunkt. Et SQL Analytics-slutpunkt refererer til den samme fysiske kopi af Delta-tabellen på OneLake og tilbyder T-SQL-oplevelsen.

Gå til dit lakehouse, og vælg derefter Lakehouse>SQL Analytics-slutpunkt i rullemenuen.

Vælg ny SQL-forespørgsel for at forespørge tabellen ved hjælp af T-SQL.

Kopiér og indsæt følgende kode i forespørgselseditoren, og vælg derefter Kør.

SELECT TOP (100) * FROM [<LAKEHOUSE_NAME>].[dbo].[dim_city];