Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

I denne vejledning skal du:

Opret en pipeline i et arbejdsområde, og indfødning af data i din OneLake i Delta-format.

Læs og rediger en Delta-tabel i OneLake med Azure Databricks.

Forudsætninger

Før du starter, skal du have:

Et arbejdsområde med et Lakehouse-element.

Et Premium Azure Databricks-arbejdsområde. Kun Premium Azure Databricks-arbejdsområder understøtter passthrough af Microsoft Entra-legitimationsoplysninger. Når du opretter din klynge, skal du aktivere passthrough af legitimationsoplysninger til Azure Data Lake Storage i Avancerede indstillinger.

Et eksempeldatasæt.

Indfødning af data, og rediger Delta-tabellen

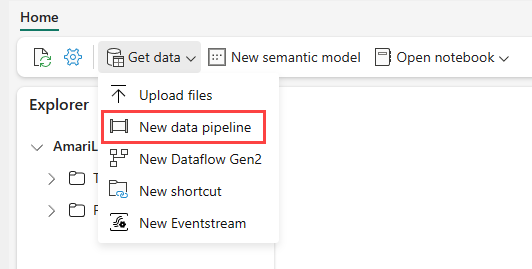

Gå til dit søhus i Power BI-tjeneste, vælg Hent data , og vælg derefter Ny pipeline.

I prompten Ny pipeline skal du angive et navn til den nye pipeline og derefter vælge Opret.

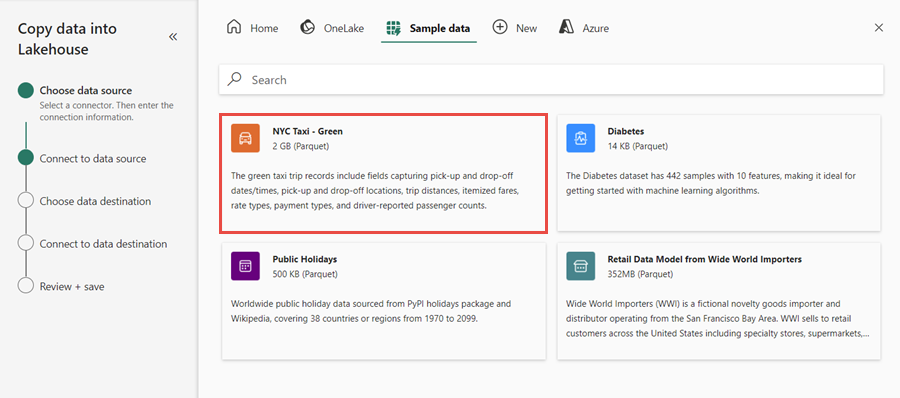

Til denne øvelse skal du vælge eksempeldataene NYC Taxi – Grøn som datakilde.

På eksempelskærmen skal du vælge Næste.

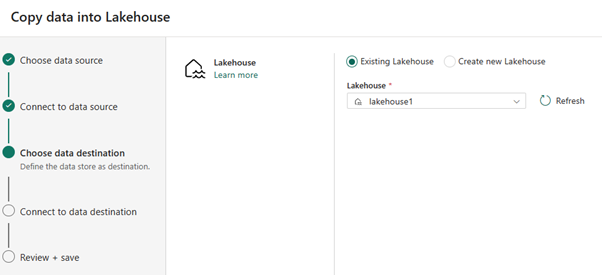

Som datadestination skal du vælge navnet på det lakehouse, du vil bruge til at gemme Data fra OneLake Delta-tabellen. Du kan vælge et eksisterende lakehouse eller oprette et nyt.

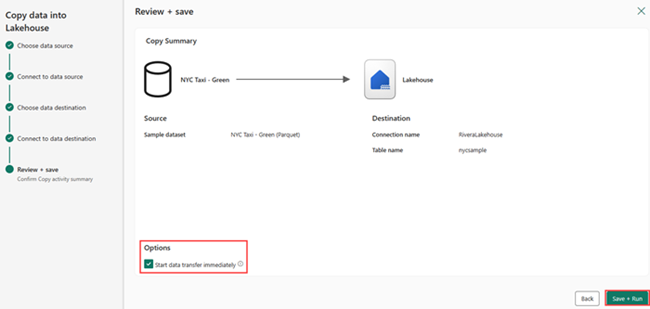

Vælg, hvor outputtet skal gemmes. Vælg Tabeller som rodmappe. Indtast "nycsample" som tabelnavn, og vælg Næste.

På skærmen Gennemse + Gem skal du vælge Start dataoverførsel med det samme og derefter vælge Gem + Kør.

Når jobbet er fuldført, skal du gå til lakehouse og få vist deltatabellen under mappen /Tables.

Højreklik på det oprettede tabelnavn, vælg Egenskaber, og kopiér stien til Azure Blob Filesystem (ABFS).

Åbn din Azure Databricks-notesbog. Læs deltatabellen på OneLake.

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)Opdater Delta-tabeldataene ved at ændre en feltværdi.

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;