Versionshinweise zu Azure Media Services v3

Warnung

Azure Media Services wird am 30. Juni 2024 eingestellt. Weitere Informationen finden Sie im Leitfaden zur Einstellung von AMS.

Damit Sie bezüglich der neuesten Entwicklungen auf dem neuesten Stand bleiben, bietet dieser Artikel Informationen zu Folgendem:

- Neueste Versionen

- Bekannte Probleme

- Behebung von Programmfehlern

- Veraltete Funktionen

Juni 2023

Azure Media Services wird zum 30. Juni 2023 eingestellt. Weitere Informationen finden Sie im Leitfaden zur Einstellung von Azure Media Services.

März 2023

Azure Media Indexer wird eingestellt. Er wird durch den Media Services v3 AudioAnalyzerPreset Basic-Modus ersetzt.

Februar 2023

Versionshinweise für Februar in Kürze verfügbar.

Januar 2023

Metadaten mit Zeitzeit

Zeitdaten sind benutzerdefinierte Daten, die in einen Livestream eingefügt werden. Sowohl die Daten als auch ihr Einfügezeitstempel bleiben im Mediendatenstrom selbst erhalten. Dies ist so, dass Clients, die den Videostream wiedergeben, dieselben benutzerdefinierten Metadaten zur exakt gleichen Zeit in Bezug auf den Videostream abrufen können. Mit zeitlimitierten Metadaten können Sie Folgendes ausführen:

- Fügen Sie dem Livestream Interaktivitätselemente hinzu, z. B. eine Umfrage.

- Fügen Sie Informationen zu den Videoinhalten hinzu, z. B. Sprecher, Produktlinks, Statistiken für Sportspieler usw.

- Fügen Sie Metadaten zum Video hinzu, z. B. GPS-Standort, Uhrzeit usw.

Weitere Informationen finden Sie unter Timed metadata with Azure Media Services and How to signald timed metadata with Azure Media Services.For more information, see Timed metadata with Azure Media Services. Sie können es mit Stackblitz ausprobieren.

Trennung der Bitrate

Die Entscheidung zur Trennung und Auflösung der ContentAwareEncoding-Bitrate wurde in diesem Monat verbessert.

ContentAwareEncoding kann zusammen mit PresetConfigurations verwendet werden, um Ihre spezifischen Anforderungen an eine optimale Streaming- und Codierungsleistung zu erfüllen.

Zur besseren Trennung der Bitrate wurde die geschätzte Komplexität aus der Testcodierung verwendet, um die Bitrate der obersten Ebene, die Bitrate der unteren Ebene und die Gesamtzahl der Ebenen zu schätzen. Sobald die Bitrate der obersten Ebene, die Bitrate der unteren Ebene und die Anzahl der Ebenen festgelegt sind, werden die Bitraten von Zwischenebenen basierend auf dem geraden Bitratenverhältnis zwischen benachbarten Ebenen berechnet. Es ist in diesem Fall fast gleichmäßig durch die Bitrate getrennt.

Wenn es um die Lösung geht, ist die untere Ebene das Standard Problem. Die Auflösung der unteren Ebene kann über PresetConfigurations konfiguriert werden. Die geänderte Logik bestimmt die Auflösung der unteren Ebene basierend auf der geschätzten Komplexität der Testcodierung, wenn Sie sie nicht konfigurieren. Außerdem wird die Bitrate der unteren Ebene bestimmt, wenn sie von Benutzern über PresetConfigurations festgelegt wird. Die Auflösungsentscheidung hat versucht, höhere Auflösungen als 180P für die untere Ebene zu verwenden, um eine bessere visuelle Qualität zu erzielen.

Dieses Release verbessert auch den Algorithmus für die Inhaltskomplexitätsschätzung. Der ursprüngliche Algorithmus ist konservativ und führt zu höheren Bitraten als erforderlich. Mit der geänderten Schätzung sind die Ausgabebitraten in der Regel niedriger als zuvor. Mit anderen Worten, Sie können jetzt mehr Geld in Bezug auf Netzwerkbandbreite und Speicherkosten sparen.

.NET SDK-Beispiele für das neueste Azure.ResourceManager.Media-Client-SDK

Das aktualisierte Azure.ResourceManager.Media-Client-SDK (auch als "track 2" .NET SDK bezeichnet) ist in Nuget Azure.ResourceManager.Media verfügbar. Alle Beispiele wurden im Standard Branch unseres Beispielrepositorys für .NET auf GitHub auf die neueste Version dieses Client-SDK aktualisiert. Azure-Samples/media-services-v3-dotnet. Die Projekte in diesem Repository veranschaulichen, wie unterschiedliche Azure Media Services-Szenarien mithilfe von V3 implementiert werden. (github.com).

Änderungen an der Assets-Schnittstelle im Azure-Portal

Auf dem Blatt Ressourcen im Azure-Portal wird eine verbesserte Benutzeroberfläche angezeigt. Sie können jetzt Spuren und Dateien im Asset anzeigen. Sie können auch Audio- und Textspuren in einem Asset hochladen, aktualisieren oder löschen.

Dezember 2022

Media Services unterstützt jetzt IPv6 zum Streamen von Medien zu Liveereignissen, zum Streamen von Inhalten von Streamingendpunkten und zum Übermitteln von Inhaltsschlüsseln. Um IPv6 für Streamingendpunkte und Liveereignisse zu aktivieren, muss die IP-Zulassungsliste für die Ressource mindestens eine IPv6-Adresse oder einen IPv6-Bereich enthalten. Wenn die CDN-Unterstützung für einen Streamingendpunkt aktiviert ist, hängt die IPv6-Unterstützung von der CDN-Konfiguration ab.

Weitere Informationen zur Verwendung von IPv6 mit Media Services finden Sie unter Media Services-Liveereignisse und Einschränken des Zugriffs auf die DRM-Lizenz und die AES-Schlüsselübermittlung mithilfe von IP-Zulassungslisten.

November 2022

Media Services entfernt jetzt standardmäßig die Audiowiedergabe aus der HLS Variant-Wiedergabeliste, um zu verhindern, dass der Client nur in einer schlechten Netzwerksituation auf Audio zurückfällt.

Um das Verhalten zu ändern, können Sie das URL-Tag [audio-only=true] verwenden, um eine Audiowiedergabe in HLS Variant Playlist zu schreiben.

Beispiel:

http://host/locator/asset.ism/manifest(format=m3u8-aapl,audio-only=true)

Dies war auf eine Änderung der HLS-Erstellungsrichtlinien zurückzuführen, die jetzt "Sie MÜSSEN keine audiogeschützten Varianten in der multivarianten Wiedergabeliste aufgeführt haben".

September 2022

API Release: Aktualisiert 2022-08-01 ARM REST API

Eine aktualisierte Version der ARM-REST-API für Azure Media Services wurde veröffentlicht. Version 2022-08-01 ist jetzt das neueste stabile Release in der Produktion. Die neuesten REST-API-Definitionen sind im REST-Spezifikationsordner für Media Services auf GitHub verfügbar.

Updates zur 2022-08-01-API gehören:

- Die LiveOutput-Entität führt eine neue Nullable-Eigenschaft rewindWindowLength ein, um suchfähige Fensterlänge während Live für die Codierung und das Durchlaufen von Live-Ereignissen zu steuern. Diese Eigenschaft wird nicht verwendet, sobald LiveOutput beendet wird. Die archivierte VOD verfügt über vollständigen Inhalt mit dem OriginalarchivWindowLength. Wenn die Eigenschaft auf NULL festgelegt ist, verwendet ein Liveereignis mit niedriger Latenz (LowLatencyV2) den Standardwert von 30 Minuten. Ein Standard-Liveereignis verwendet es nicht.

- Unterstützung für die Sicherheitsstufe PlayReady SL3000 in Inhaltsschlüsselrichtlinien hinzugefügt

- API für erweiterte Ressourcenspuren zur Unterstützung von Audiospuren (für beschreibende Audiodaten oder mehrere Sprachen)

- Unterstützung für MPEG Common Encryption Clear Key mit den Modi "cenc" und "cbcs" in Streamingrichtlinien hinzugefügt

Neue SDK-Clientversionen für Javascript, Python, Go verfügbar

Das neue Python-Client-SDK v10.1.0 ist auf PyPI verfügbar: azure-mgmt-media

Das neue JavaScript Client SDK v13 ist auf npm verfügbar: Azure Media client library for JavaScript - @azure/arm-mediaservices

Neues GO Client SDK v 3.1.0 ist verfügbar : armmediaservices-Paket

PlayReady Security Level 3000-Lizenzunterstützung (SL3000)

Die PlayReady DRM-Inhaltsschutz- und Lizenzbereitstellungsfeatures von Media Services unterstützen jetzt PlayReady SL3000. Die Sicherheitsstufe ist eine Eigenschaft eines PlayReady-Clients, und jede an einen Client übermittelte Lizenz verfügt über eine Eigenschaft, die die Mindestsicherheitsstufe angibt, die von einem Client erforderlich ist, um die Bindung an diese Lizenz zuzulassen. Sicherheitsstufe 3000 wird für gehärtete Geräte mit der höchsten Sicherheit bereitgestellt, die die höchste Qualität kommerzieller Inhalte verbrauchen. Mit diesem Update können Sie Inhaltsschlüsselrichtlinien für die Übermittlung von PlayReady SL3000-Lizenzen über die Media Services Key Delivery-Lizenzserver konfigurieren. Weitere Informationen zu PlayReady-Sicherheitsstufen finden Sie im Artikel Verwenden der Sicherheitsstufe in einer Lizenz.

- Wenn Sie einer Inhaltsschlüsselrichtlinie eine PlayReady ContentKeyPolicyOption hinzufügen, kann diese Richtlinie nur zusätzliche PlayReady SL3000- oder Widevine L1-Optionen enthalten.

- SL3000 erfordert, dass Sie einen anderen Schlüssel für Audio verwenden oder unverschlüsseltes Audio verwenden. Die Audiosicherheitsstufe sollte auf SL2000 oder niedriger beschränkt sein.

- Die SL3000-Wiedergabe funktioniert derzeit nicht im Azure Media Player (AMP). Testen Sie bitte einen Drittanbieter-Player (z. B. Shaka Player) oder ein Gerät, das die SL3000-Wiedergabe unterstützt.

Beispiel für eine Inhaltsschlüsselrichtlinie:

{

"properties": {

"options": [

{

"name": "PlayReadyOption",

"configuration": {

"@odata.type": "#Microsoft.Media.ContentKeyPolicyPlayReadyConfiguration",

"licenses": [

{

"playRight": {

"digitalVideoOnlyContentRestriction": false,

"imageConstraintForAnalogComponentVideoRestriction": false,

"imageConstraintForAnalogComputerMonitorRestriction": false,

"allowPassingVideoContentToUnknownOutput": "NotAllowed"

},

"licenseType": "NonPersistent",

"contentKeyLocation": {

"@odata.type": "#Microsoft.Media.ContentKeyPolicyPlayReadyContentEncryptionKeyFromHeader"

},

"contentType": "Unspecified",

"securityLevel": "SL3000"

}

]

},

"restriction": {

"@odata.type": "#Microsoft.Media.ContentKeyPolicyOpenRestriction"

}

}

]

}

}

**Beispiel-Streamingrichtlinie mit einer SL3000-Inhaltsschlüsselrichtlinie für Video und SL2000-Inhaltsschlüsselrichtlinie für Audiospuren: **

{

"properties": {

"defaultContentKeyPolicyName": "sl3000_content_key_policy",

"commonEncryptionCenc": {

"enabledProtocols": {

"download": false,

"dash": true,

"hls": false,

"smoothStreaming": true

},

"contentKeys": {

"defaultKey": {

"label": "cencDefaultKey"

},

"keyToTrackMappings": [

{

"label": "audiokey",

"policyName" : "sl2000_content_key_policy",

"tracks": [

{

"trackSelections": [

{

"property": "FourCC",

"operation": "Equal",

"value": "mp4a"

}

]

}

]

}

]

},

"drm": {

"playReady": {}

}

}

}

}

Weitere Informationen zur Verwendung von PlayReady-Lizenzvorlagen finden Sie im Artikel Media Services PlayReady-Lizenzvorlagen.

Hinzufügen von Audiospuren für beschreibende Audiodaten oder mehrere Sprachen mit der neuen Asset Tracks-API

Mit der neuen Asset Tracks-API können Sie eine beliebige Anzahl von Audiospuren spät an ein vorhandenes Asset binden und sie für die dynamische Verpackung an HLS und DASH verfügbar machen. Die API unterstützt das Festlegen von Metadaten, um die Sprach- oder Inhaltseigenschaften anzugeben, um "beschreibendes Audio" für eine verbesserte Barrierefreiheit von Inhalten anzugeben.

Eine vollständige Liste der Funktionen der Spuren-API finden Sie im Artikel Media Services-Spuren-API.

Unterstützung für MPEG Common Encryption Clear Key mit CENC- und CBCS-Verschlüsselung

Die Clear Key-Verschlüsselung ist ein Feature des MPEG Common Encryption -Standards (CENC) und wird von den HTML5 Encrypted Media Extensions (EME) unterstützt, die in vielen modernen Browsern verfügbar sind. Clear Key AES-128-Verschlüsselung mit den Verschlüsselungsmodi "cenc" oder "cbcs" kann in Ihren Streamingrichtlinien festgelegt werden, damit Sie die breiteste Palette von Geräten in Apple, Web und Android erreichen können.

Dieses Feature ermöglicht es Ihnen, den Common Encryption-Standard ohne die Verwendung eines DRM-Systems zu unterstützen und die größte Bandbreite von Spielern zu erreichen. Mit der Unterstützung der Clear Key-Verschlüsselung mit den Verschlüsselungsmodi "cenc" oder "cbcs" können Sie jetzt sichere Inhalte ohne DRM an Spieler verteilen, die beide im Standard zulässigen Verschlüsselungsmodi unterstützen. Auf diese Weise können Sie verschlüsselte Inhalte an Clientplayer wie Google Shaka Player (v4.0.0+), Dash.js (v4.5+), Bitmovin, Theo Player und Android ExoPlayer (v2.18.1+) mithilfe der "cenc"-Verschlüsselung bereitstellen.

Weitere Informationen zur Verwendung der Inhaltsschutzfeatures von Media Services finden Sie im Artikel Inhaltsschutz mit dynamischer Verschlüsselung und Schlüsselübermittlung.

Zurückspulen von Fenstern im Vergleich zum Archivfenster bei Liveausgaben

Der RewindWindowLength kann für Liveausgaben festgelegt werden, um das suchfähige Fenster auf dem Clientplayer während des Livestreamings zu steuern. Dadurch kann der Kunde steuern, wie viel Zeit im Player für die Suche nach dem Livestream sichtbar ist. Diese Einstellung trägt auch dazu bei, die Manifestgröße zu reduzieren, die während des Livestreamings über das Netzwerk an den Client übermittelt wird, was zu einer effizienteren Livestreamingerfahrung führen und die Arbeitsspeicherauslastung auf dem Client verringern kann.

Nachdem der Stream abgeschlossen ist, können Sie auf die archivierte Datei in dem Objekt zugreifen, das von der eigenschaft archiveWindowLength für die Liveausgabe definiert wird. Dadurch können Sie jetzt eine andere Archivdauer als die vorherige "DVR-Gleitfenster"-Dauer festlegen, die für den Player sichtbar ist. Dies ist sehr nützlich, wenn Sie mit einem sehr kleinen Zeitverschiebungsfenster im Player streamen möchten, aber das gesamte Liveereignis im Ausgabeobjekt archivieren möchten.

Sie können rewindWindowLength auf einen Mindestwert von 60 Sekunden festlegen. Der Standardwert beträgt 30 Minuten, wenn Sie ein Liveereignis mit der Option "LowLatencyV2" aktivieren, andernfalls gibt es keinen Standardwert. Wenn rewindWindowLength nicht festgelegt ist und das Liveereignis nicht auf die Option "LowLatencyV2" festgelegt ist, wird vom Server kein Standardwert festgelegt, und das suchbare Fenster während der Livewiedergabe wäre der gleiche Wert wie das archivWindowLength. Wenn in dieser Situation das ArchivWindowLength auf eine sehr große Dauer festgelegt ist, kann der Player aufgrund des größeren Manifest-Downloads zum Analysieren durch mehr Pufferungsprobleme während der Wiedergabe im Livemodus beeinträchtigt werden.

Weitere Informationen finden Sie im Artikel Verwenden von Zeitverschiebungen und Liveausgaben zum Erstellen von On-Demand-Videowiedergaben.

Neue Region: China North 3 ist jetzt allgemein verfügbar

Kunden in China können jetzt auf Azure Media Services in der Region China, Norden 3, zusätzlich zu den bestehenden 4 Regionen zugreifen, die bereits allgemein verfügbar sind (China, Osten, China, Osten 2, China Norden, China, Norden). Ausführliche Informationen finden Sie in der Tabelle "Regionsverfügbarkeit nach Feature" .

Einstellung von Azure Media Redactor, Video Analyzer und Gesichtserkennung am 14. September 2023

Gemäß seiner Standards zu verantwortungsvoller KI ist Microsoft hinsichtlich KI-Systemen zu Fairness, Datenschutz, Sicherheit und Transparenz verpflichtet. Um unsere Produkte besser an diesen neuen Standard und die Richtlinie für eingeschränkten Zugriff für andere Microsoft-Produkte auszurichten, wird Azure Media Services die folgenden Funktionen am 14. September 2023 eingestellt:

- Azure Media Redactor (RESTv2)

- Voreinstellung für die Gesichtserkennung

- Video Analyzer-Voreinstellung

Nach dem 14. September 2023 treten bei anwendungen, die Sie mithilfe des Azure Media Redactors, der Gesichtserkennungsvoreinstellung oder der Video Analyzer-Voreinstellung entwickelt haben, Fehler oder fehlerhafte Auftragsübermittlungen auf.

Aktion erforderlich

Der Azure Media Redactor (RESTv2) und die Gesichtserkennungsvoreinstellung werden eingestellt und werden zu diesem Zeitpunkt nicht ersetzt. Wenn Sie stattdessen Personen in einem Video erkennen möchten, empfehlen wir Ihnen, Ihre Anwendungen so zu aktualisieren, dass sie die Video Indexer-APIs verwenden, um beobachtete Personen zu erkennen und beobachtete Personen mit Gesichtern zu identifizieren und eine Anforderung zu übermitteln, um Zugriff auf das Programm mit eingeschränktem Zugriff für diese Features zu erhalten.

Wenn Sie derzeit die Video Analyzer-Voreinstellung verwenden, empfiehlt es sich, Ihre Anwendungen so zu aktualisieren, dass sie die Video Indexer-APIs für die Videoanalyse verwenden, die einen erweiterten Funktionsumfang bietet.

Weitere Informationen

Bei Fragen können Sie Antworten von Communityexperten auf Microsoft Q&A erhalten. Wenn Sie über einen Supportplan verfügen und technische Hilfe benötigen, erstellen Sie eine Supportanfrage im Azure-Portal.

August 2022

Neues Beispiel für die Titel-API in Node.js/Typescript zum Hinzufügen von Untertiteln und Beschriftungen zu Ihren Medienobjekten

Das Beispielprojekt für Node.js enthält ein neues Beispiel, das zeigt, wie eine Untertitel- oder Beschriftungsdatei im Format WebVTT bzw. TTML noch spät gebunden werden kann. Siehe Beispiel Hinzufügen eines Untertitels oder einer Beschriftung im Format WebVTT, IMSC1 oder TTML zu einem vorhandenen Medienobjekt

In diesem Beispiel wird gezeigt, wie Sie einem Medienobjekt eine beliebige Anzahl von Texttiteln hinzufügen und diese als TTML- oder IMSC1-Textprofil sowohl in DASH als auch in HLS verpacken können. Mit der API können Sie auch bestimmte Merkmale des HLS-Manifests festlegen, z. B. die Standardbeschriftungsspur, und Sie können die Eigenschaft „Erzwungen“ sowie den Wert „Merkmale“ der HLS-Textspur entsprechend der Apple HLS-Spezifikation festlegen.

Die API unterstützt derzeit das Hochladen von .vtt- und .ttml-Dateien in ein vorhandenes Medienobjekt. Mit der Titel-API neu registrierte Titel werden sofort im DASH- und HLS-Manifest als MP4-Textspuren mit IMSC1-Profil angezeigt.

Juni 2022

In benutzerdefinierten Voreinstellungen für die Livecodierung unterstützte benutzerdefinierte Audiobitraten

Sie können jetzt eine benutzerdefinierte Voreinstellung für die Livecodierung anfordern, die Ausgaben mit verschiedenen Audiobitraten unterstützt. In Voreinstellungen für die Livecodierung ist nun für Audio eine individuelle Anpassung mit folgenden AAC-Audiobitraten möglich: 96k, 112k, 128k, 160k, 192k, 224k, 256k, 320k, 384k, 448k, 512k. Geben Sie im Supportticket unbedingt an, dass Sie eine benutzerdefinierte Voreinstellung anfordern.

Benutzerdefinierte Voreinstellungen für die Livecodierung können jetzt mehrere diskrete Audiobitraten enthalten. Dies ist insbesondere in Märkten hilfreich, in denen für die Übertragung über mobile Netzwerke eine Audiospur mit niedrigerer Bitrate erforderlich ist. Beispiel: Eine benutzerdefinierte Voreinstellung für die Livecodierung, die AAC-Audiospuren sowohl mit 96 k als auch mit 128 k ausgeben kann. Der Player kann den entsprechenden Titel filtern oder auswählen, oder es kann ein dynamischer Filter angewendet werden, um während der Veröffentlichung durch einen Streaminglocator nur ein 96k-Manifest bzw. nur ein 128k-Manifest bereitzustellen (wobei dies über den Abfrageparameter „filter={filterName}“ in der URL des Streaminglocators auch während der Ausführung umgeschaltet werden kann).

Automatische Skalierung

Media Services bietet nun die Möglichkeit der automatischen Skalierung Ihrer Premium-Streamingendpunkte – basierend auf beliebigen für den Endpunkt oder zugehörige Entitäten verfügbaren Metriken. Die Regel für die automatische Skalierung kann auch eine Kombination verschiedener Metriken umfassen. Weitere Informationen finden Sie unter Automatische Skalierung von Premium-Streamingendpunkten in Media Services. Beachten Sie, dass auch die automatische Skalierung bei einem Anstieg des Bedarfs nicht sofort, sondern in der Regel zeitverzögert erfolgt. Achten Sie daher bereits im Design Ihrer Architektur darauf, dass Ihren Ressourcen ein ausreichender zeitlicher Puffer für die Skalierung und Bereitstellung verbleibt. Die Skalierung von Streamingendpunkten erfordert Zeit. Daher sollten Sie für Metriken wie die CPU-Auslastung oder die Ausgangsbandbreite des Netzwerks eher etwas niedrigere Werte für die Auslösung einer Skalierung wählen.

Mai 2022

Unterstützung von Untertiteln für 708 und 608 HLS-Manifestdekoration

Livestreams, die mit eingebetteten 608/708-Untertiteln im elementaren Stream erfasst werden, werden jetzt ordnungsgemäß im HLS-Manifest mithilfe des EXT-X-MEDIA-Tags mit einem TYPE=CLOSED-CAPTIONS zugeordnet. Dies entspricht RFC-8216, Abschnitt 4.3.4.1.

Beispielsweise wird ein Livestream mit 608 und 708 Untertiteln im HLS-Manifest angezeigt:

#EXT-X-MEDIA:TYPE=CLOSED-CAPTIONS,GROUP-ID="cc",NAME="CEA708_CC",DEFAULT=YES,INSTREAM-ID="SERVICE1"

#EXT-X-MEDIA:TYPE=CLOSED-CAPTIONS,GROUP-ID="cc",NAME="CEA608_CC",INSTREAM-ID="CC1"

April 2022

Livetranskriptionen

Die Livetranskription ist jetzt allgemein verfügbar und unterstützt alle verfügbaren Sprachen in der Spracherkennungs-API. Eine vollständige Liste der Sprachen finden Sie im Artikel Regionen und Sprachen für die Livetranskription.

Farbton/Leuchtkraft/Sättigung (HLS) mit geringer Wartezeit (LL-HLS)

HLS mit geringer Wartezeit (LL-HLS) ist jetzt in der API und im Azure-Portal verfügbar. Verwenden Sie zum Aktivieren von LL-HLS beim Erstellen eines Livestreams die Option „LowLatencyV2“. Informationen zur Konfiguration finden Sie im Node.js-Beispiel zum Erstellen eines HLS-Livecodierungsereignisses mit geringer Wartezeit. Wählen Sie im Azure-Portal beim Erstellen eines Liveereignisses die neue Option „Niedrige Latenz“ aus. Das neue LL-HLS-Feature kann bei der Verwendung eines Player Framework, das das LL-HLS-Protokoll unterstützt, eine um 4 bis 7 Sekunden geringere Wartezeit bieten. HLS mit geringer Wartezeit ist nur für Livetranscodierungskanäle verfügbar und steht noch nicht für Liveereignisse im Passthrough-Modus zur Verfügung.

März 2022

.NET SDK-Version 6.0.0

Die .NET SDK-Version 6.0.0 ist jetzt auf NuGet verfügbar. Microsoft.Azure.Management.Media

Dieses SDK unterstützt die neue stabile Version 2021-11-01 der AMS-REST-OpenAPI-Spezifikation.

So installieren Sie das SDK mithilfe des Paket-Managers:

Install-Package Microsoft.Azure.Management.Media -Version 6.0.0

So installieren Sie das SDK mithilfe der .NET-CLI:

dotnet add package Microsoft.Azure.Management.Media --version 6.0.0

Die SDK.-Version 6.0.0 enthält folgende Änderungen:

- Für Medienobjekte wurde die neue Titel-API zum Verwalten der im Medienobjekt verfügbaren Titel hinzugefügt.

- Das Main10-Codierungsprofil für die H265-Codierung wurde hinzugefügt.

- Der „RateControlMode“ für H264-Codierung wurde verfügbar gemacht und bietet zwei Modi für die Ratensteuerung: konstante Bitrate (Constant Bit Rate, CBR) und konstanter Ratenfaktor (Constant Rate Factor, CRF).

- Dem Streamingendpunkt wurde die Eigenschaft „skus“ hinzugefügt, um den Typ und die Skalierung des Streamingendpunkts anzugeben. Dies ermöglicht die Konfiguration der manuellen oder automatischen Skalierung von Streamingeinheiten in einem Streamingendpunkt.

- Für Liveereignisse wurde die Streamoption „LowLatencyV2“ zur Verwendung für das Livestreaming mit geringer Wartezeit im LL-HLS-Format (HLS mit geringer Wartezeit) von Apple hinzugefügt.

Neuer Dokumentationsinhalt: Streamen einer Microsoft Teams-Besprechung

Mit einem Media Services-Liveereignis können Sie Ihre Live-Besprechung in Microsoft Teams mühelos mittels Relay umleiten. Platzieren Sie Ihre Teams-Live-Besprechung ganz einfach auf einer öffentlichen Website, oder verwenden Sie die Verwaltung digitaler Rechte (Digital Rights Management, DRM), um Ihren Stream zu schützen. Für die Verwendung mit der Media Services-Codierungsplattform wird der Stream als VOD-Medienobjekt erfasst und aufgezeichnet. Weitere Informationen finden Sie unter Streamen einer Microsoft Teams-Besprechung.

Spätes Binden der Beschriftungen und Untertitel für Medienobjekte mit der neuen Titel-API

Eine neue Titel-API für Medienobjekte ermöglicht es Ihnen, verfügbare Titel innerhalb eines Medienobjekts aufzulisten. Auf diese Weise können Sie die verfügbaren Audio-, Video- und Texttitel ermitteln, die in einem Medienobjekt gespeichert sind. Mit der Titel-API können Sie Beschriftungs- und Untertiteldateien im IMSC1-Textprofil und WebVTT-Format spät an Ihre Streamingmedienobjekte binden. In der Vergangenheit mussten Kunden die ISM-Datei im BLOB-Speicherkonto ändern, um ihren Medienobjekten neue spät gebundene Titel hinzuzufügen. Jetzt entfällt dieser manuelle Schritt, und das Hinzufügen von spät gebundenen Untertitel- und Beschriftungsdateien ist über ein unterstütztes SDK möglich.

Technische Details zur neuen Titel-API finden Sie in der Version 2021-11-01 der AMS-REST-OpenAPI-Spezifikation.

Ein einfaches Beispiel zum Auflisten von Titeln in Javascript finden Sie hier. Weitere Beispiele und Dokumentationen für die einzelnen SDKs werden in Kürze bereitgestellt.

Dezember 2021

Version 10.0.0 des JavaScript SDK aktualisiert

Das JavaScript SDK wurde jetzt aktualisiert, um das neueste REST-API-Release 2021-06-01 zu unterstützen. Dieses neue isomorphe JavaScript SDK bietet eine bessere Unterstützung für Zusagen und die Möglichkeit, sich mithilfe der Bibliothek @azure/identity für die Verwendung mit Azure AD-Anwendungen, mithilfe einer verwalteten Identität usw. zu authentifizieren.

Informationen zum Herunterladen des aktuellen Pakets finden Sie im NPM-Paket „@azure/arm-media-services“.

Aktualisierte und erweiterte Node.js- und TypeScript-basierte Beispiele für das neue JavaScript-Paket sind auf GitHub verfügbar. https://github.com/Azure-Samples/media-services-v3-node-tutorials

In der Audio/Video Analyzer-Voreinstellung für Transkriptionen sind die Sprachen Hebräisch, Russisch und Portugiesisch (Portugal), verfügbar.

Hebräisch, Griechisch und Portugiesisch (Portugal; das aktuelle Modell ist für brasilianisches Portugiesisch) stehen jetzt zur Verwendung in der Audio und Video Analyzer-Voreinstellung zur Verfügung.

Die neuen unterstützten BCP-47-Sprachcodes sind he-IL, fa-IR und pt-PT.

Neue Region: Die Region "Schweden, Mitte" ist jetzt allgemein verfügbar.

Media Services ist jetzt in der Region „Schweden, Mitte“ allgemein verfügbar. Derzeit gelten einige Funktionseinschränkungen in der Region, während wir auf die Einführung einiger Abhängigkeitsdienste warten. Im Diagramm mit der regionalen Verfügbarkeit von Funktionen können Sie ermitteln, wann die Funktionen verfügbar sein werden.

Neues Ereignis für den Heartbeat des Liveereigniskanalarchivs

Ein neues Ereignis, das den Status und die Integrität des Liveereignisarchivs nachverfolgt, wurde hinzugefügt. Ausführlichere Informationen zu diesem neuen Ereignis finden Sie im Artikel Azure Event Grid-Schemas für Media Services-Ereignisse unter „LiveEventChannelArchiveHeartbeatEvent“.

September 2021

Neue Passthrough-Liveereignis-Basic-SKU

Mit der neuen Passthrough-Liveereignis-Basic-SKU können Kunden Liveereignisse zu einem niedrigeren Preispunkt erstellen. Dies ähnelt den standardmäßigen Passthrough-Liveereignissen, hat jedoch geringere Grenzwerte für die Eingabebandbreite, weniger zulässige Liveausgaben, andere Grenzwerte für die DVR-Fensterlänge und bietet keinen Zugriff auf Livetranskription. Weitere Informationen finden Sie im Artikel Vergleich von Liveereignistypen.

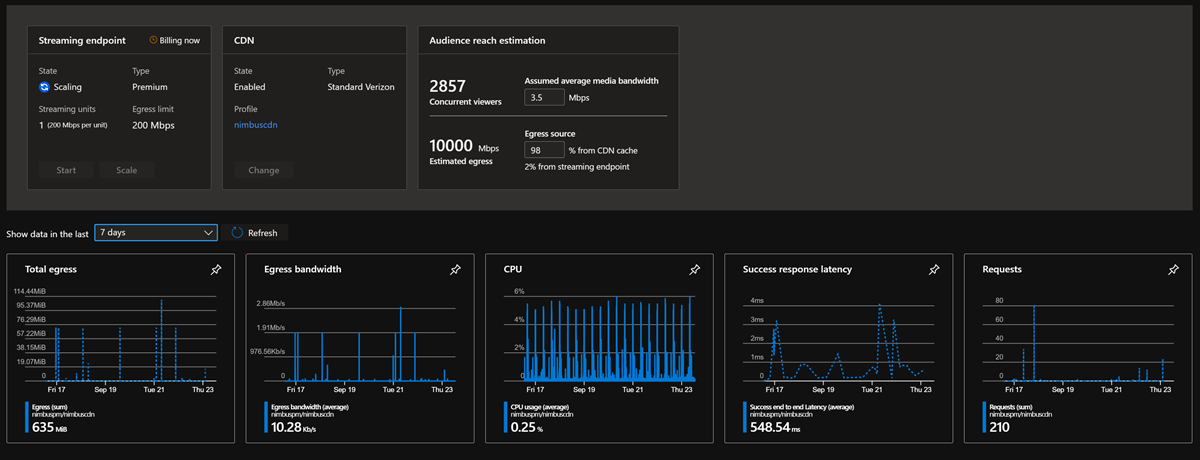

Verbesserte Skalierungsverwaltung und -überwachung für einen Streamingendpunkt im Portal

Die Portalseite des Streamingendpunkts bietet Ihnen jetzt eine einfache Möglichkeit, Ihre Ausgangskapazität zu verwalten und die Reichweite Ihrer Zielgruppe mit und ohne konfigurierte CDN einzuschätzen. Passen Sie die Übermittlungsbitrate und die erwartete CDN-Cachetrefferquote an, um schnelle Schätzungen Ihrer Zielgruppengröße zu erhalten und zu ermitteln, ob Sie auf mehr Premium-Streamingendpunkte hochskalieren müssen.

Die Portalseite des Streamingendpunkts zeigt jetzt CPU-, Ausgangs- und Latenzmetriken an.

Sie können nun die CPU-Last, die ausgehende Bandbreite und End-to-End-Latenzmetriken auf deren Streamingendpunkten im Azure-Portal visualisieren. Sie können jetzt Überwachungswarnungen basierend auf den CPU-, Ausgangs- oder Latenzmetriken direkt im Portal erstellen, indem Sie die Leistungsfähigkeit von Azure Monitor nutzen.

Unterstützung von benutzerseitig zugewiesene verwaltete Identitäten für Media Services Konten

Mit von benutzerseitig zugewiesenen, verwalteten Identitäten können Kunden jetzt die Sicherheit ihrer Speicherkonten und zugehörigen Schlüsseltresore optimieren. Der Zugriff auf das Kundenspeicherkonto und die Schlüsseltresore ist auf die benutzerseitig zugewiesene, verwaltete Identität beschränkt. Sie haben die volle Kontrolle über die Lebensdauer der benutzerseitig zugewiesenen, verwalteten Identitäten und können den Zugriff des Mediendienstkontos auf ein bestimmtes Speicherkonto bei Bedarf einfach widerrufen.

Die Seite „Media Services-Speicherkonten“ im Portal unterstützt jetzt sowohl UAMI als auch SAMI.

Sie können jetzt benutzerseitig zugewiesene verwaltete Identitäten (User-Assigned Managed Identities, UAMI) oder systemseitig verwaltete Identitäten (System-Assigned Managed Identities, SAMI) für Ihre Speicherkonten direkt im Azure-Portal für Media Services zuweisen und verwalten.

Die Seite „Bring Your Own Key“ unterstützt jetzt auch UAMI und SAMI.

Die Seite des Schlüsselverwaltungsportals für Media Services unterstützt jetzt die Konfiguration und Verwaltung von benutzerseitig zugewiesene verwaltete Identitäten (UAMI) oder von systemseitig zugewiesenen verwalteten Identitäten (SAMI).

Unterstützung für private Endpunkte in Media Services

Sie können nun den öffentlichen Zugriff auf Ihre Liveereignisse, Streamingendpunkte und Schlüsselübermittlungsdienste-Endpunkte für den Inhaltsschutz und DRM einschränken, indem Sie einen privaten Endpunkt für jeden der Dienste erstellen. Dadurch wird der öffentliche Zugriff auf jeden dieser Dienste eingeschränkt. Nur Datenverkehr, der aus Ihrem konfigurierten virtuellen Netzwerk (VNet) stammt, das im privaten Endpunkt konfiguriert ist, kann diese Endpunkte erreichen.

Liste zugelassener IP-Adressen für Schlüsseldienst

Sie können jetzt festlegen, dass bestimmte öffentliche IP-Adressen Zugriff auf den Schlüsselübermittlungsdienst für DRM und Inhaltsschutz haben sollen. Liveereignis- und Streamingendpunkte unterstützen bereits die Konfiguration der Liste zugelassener IP-Adressen auf ihren jeweiligen Seiten.

Sie verfügen jetzt auch über ein Featureflag auf Kontoebene, um den öffentlichen Internetzugriff auf Ihr Media Services-Konto zuzulassen bzw. zu blockieren.

Juli 2021

.NET SDK (Microsoft.Azure.Management.Media ) Release 5.0.0 in NuGet verfügbar

Das Microsoft.Azure.Management.Media .NET SDK Version 5.0.0 wird jetzt auf NuGet veröffentlicht. Diese Version wird generiert, um mit der stabilen Version 2021-06-01 der ARM-REST-API zu arbeiten.

Ausführliche Informationen zu Änderungen ab Version 4.0.0 finden Sie im Änderungsprotokoll.

Änderungen im 5.0.0 .NET SDK-Release

- Das Media Services-Konto unterstützt jetzt systemseitig und benutzerseitig zugewiesene verwaltete Identitäten.

- Die Option PublicNetworkAccess wurde Media Services-Konten hinzugefügt. Diese Option kann zusammen mit dem Private Link-Feature verwendet werden, um nur den Zugriff von privaten Netzwerken zuzulassen und den Zugriff auf öffentliche Netzwerke zu blockieren.

- Einfacher Passthrough: Ein neuer Liveereignistyp wird hinzugefügt. Liveereignisse mit einfachem Passthrough haben ähnliche Funktionen wie Liveereignisse mit Standard-Passthrough mit einigen Ein- und Ausgabeeinschränkungen und werden zu einem reduzierten Preis angeboten.

- PresetConfigurations: Ermöglicht Ihnen das Anpassen der Ausgabeeinstellungen sowie der minimalen und maximalen Bitraten, die für die Voreinstellungen der inhaltsbezogenen Codierung verwendet werden. Dies hilft Ihnen bei der besseren Schätzung und Planung für eine genauere Abrechnung, wenn Sie inhaltsbezogene Codierung mithilfe von begrenzten Ausgabenachverfolgungsnummern und Auflösungen verwenden.

Breaking Changes in Version 5.0.0 des .NET SDK

- ApiErrorException wurde durch ErrorResponseException ersetzt, um mit allen anderen Azure SDKs konsistent zu sein. Der Ausnahmetext hat sich nicht geändert.

- Alle Aufrufe, die „404 Nicht gefunden“ zurückgeben, geben jetzt eine ErrorResponseException aus, anstatt NULL zurückzugeben. Diese Änderung wurde vorgenommen, um mit anderen Azure SDKs konsistent zu sein.

- Der Media Service-Konstruktor verfügt über einen neuen optionalen PublicNetworkAccess-Parameter hinter dem KeyDelivery-Parameter.

- Die Type-Eigenschaft in MediaServiceIdentity wurde von Enumeration (enum) in Zeichenfolge (string) für „ManagedIdentityType“ geändert, um mehrere durch Komma getrennte Typen zu ermöglichen. Gültige Zeichenfolgen sind SystemAssigned oder UserAssigned.

Juni 2021

Zusätzliche Liveereignis-Erfassungstakteigenschaften für verbesserte Diagnosen

Der Event Grid-Nachricht wurden weitere Liveereignis-Erfassungstakteigenschaften hinzugefügt. Dazu gehören die folgenden neuen Felder, die bei der Diagnose von Problemen während der Liveerfassung helfen. Der ingestDriftValue ist in Szenarien hilfreich, in denen Sie die Netzwerklatenz vom Quellerfassungsencoder überwachen müssen, der in das Liveereignis pusht. Wenn dieser Wert zu stark abweicht, kann dies ein Hinweis darauf sein, dass die Netzwerklatenz für ein erfolgreiches Livestreamingereignis zu hoch ist.

Weitere Informationen finden Sie unter LiveEventIngestHeartbeat-Schema.

Unterstützung für Private Link ist jetzt allgemein verfügbar

Die Unterstützung für die Verwendung von Media Services mit privaten Verbindungen ist jetzt allgemein (GA) und in allen Azure-Regionen verfügbar, einschließlich Azure Government-Clouds.

Mit Azure Private Link können Sie über einen privaten Endpunkt in Ihrem virtuellen Netzwerk auf Azure-PaaS-Dienste sowie auf in Azure gehostete kundeneigene Dienste/Partnerdienste zugreifen.

Der Datenverkehr zwischen Ihrem virtuellen Netzwerk und dem Dienst wird über das Microsoft-Backbone-Netzwerk übertragen und dadurch vom öffentlichen Internet isoliert.

Informationen zur Verwendung von Media Services mit privaten Endpunkten finden Sie unter Erstellen eines Media Services- und Speicherkontos mit einem privaten Endpunkt.

Neue Region: Die Region "USA, Westen 3" ist allgemein verfügbar

Die Region „USA, Westen 3“ ist jetzt allgemein verfügbar und kann von Kunden verwendet werden, wenn sie neue Media Services-Konten erstellen.

Schlüsselübermittlung unterstützt Einschränkungen der Liste zugelassener IP-Adressen

Media Services-Konten können jetzt mit Einschränkungen der Liste zugelassener IP-Adressen für die Schlüsselübermittlung konfiguriert werden. Die neue Einstellung für die Positivliste ist in der Media Services-Kontoressource über das SDK sowie im Portal und über die CLI verfügbar. Dies ermöglicht es den Operatoren, die Bereitstellung von DRM-Lizenzen und symmetrischen AES-128-Schlüsseln auf bestimmte IPv4-Bereiche zu beschränken.

Dieses Feature kann auch verwendet werden, um alle öffentlichen Internetübermittlungen von DRM-Lizenzen oder AES-128-Schlüsseln zu deaktivieren und die Übermittlung auf einen privaten Endpunkt zu beschränken.

Weitere Informationen finden Sie im Artikel Einschränken des Zugriffs auf die DRM-Lizenz- und AES-Schlüsselübermittlung mithilfe von Listen zugelassener IP-Adressen.

Neue Beispiele für Python und Node.js (mit TypeScript)

Aktualisierte Beispiele für Node.js, die die neueste TypeScript-Unterstützung im Azure SDK verwenden.

| Beispiel | BESCHREIBUNG |

|---|---|

| Livestreaming | Einfaches Livestreaming-Beispiel. WARNUNG: Stellen Sie sicher, dass alle Ressourcen bereinigt sind und im Portal nicht mehr abgerechnet werden, wenn Sie Livestreaming verwenden. |

| Hochladen und Streamen von HLS und DASH | Einfaches Beispiel für das Hochladen einer lokalen Datei oder Codieren aus einer Quell-URL. Das Beispiel zeigt, wie Sie Storage SDK zum Herunterladen von Inhalten verwenden und wie Sie an einen Player streamen. |

| Hochladen und Streamen von HLS und DASH mit PlayReady und Widevine DRM | Zeigt, wie Sie mithilfe von Widevine und PlayReady DRM codieren und streamen. |

Neues Python-Beispiel, das zeigt, wie Azure Functions und Event Grid verwendet werden, um die Voreinstellung für die Gesichtsbearbeitung auszulösen.

Mai 2021

Verfügbarkeitszonen: Standardunterstützung in Media Services

Media Services unterstützt jetzt Verfügbarkeitszonen, die fehlerisolierte Standorte innerhalb einer Azure-Region bieten. Media Services-Konten sind jetzt standardmäßig zonenredundante Konten, und es sind keine zusätzlichen Konfigurationen oder Einstellungen erforderlich. Dies gilt nur für Regionen, in denen Verfügbarkeitszonen unterstützt werden.

März 2021

Hinzufügung der Unterstützung für neue Sprachen in der AudioAnalyzer-Voreinstellung

In der AudioAnalyzer-Voreinstellung (sowohl im Basic- als auch im Standard-Modus) sind jetzt für die Videotranskription und Untertitelung mehr Sprachen verfügbar.

- Englisch (Australien), „en-AU“

- Französisch (Kanada), „fr-CA“

- Arabisch (Bahrain), modernes Hocharabisch, „ar-BH“

- Arabisch (Ägypten), „ar-EG“

- Arabisch (Irak), „ar-IQ“

- Arabisch (Israel), „ar-IL“

- Arabisch (Jordanien), „ar-JO“

- Arabisch (Kuwait), „ar-KW“

- Arabisch (Libanon), „ar-LB“

- Arabisch (Oman), „ar-OM“

- Arabisch (Katar), „ar-QA“

- Arabisch (Saudi-Arabien), „ar-SA“

- Dänisch, „da-DK“

- Norwegisch, „nb-NO“

- Schwedisch, „sv-SE“

- Finnisch, „fi-FI“

- Thailändisch, „th-TH“

- Türkisch, „tr-TR“

Die neuesten verfügbaren Sprachen finden Sie im Konzeptartikel zur Analyse von Video- und Audiodateien.

Februar 2021

Unterstützung von HEVC-Codierung im Standard-Encoder

Der Standard-Encoder bietet jetzt Unterstützung für 8-Bit-HEVC-Codierung (H.265). HEVC-Inhalte können mithilfe des hev1-Formats über die dynamische Paketerstellung übermittelt und gepackt werden.

Ein neues Beispiel für eine benutzerdefinierte .NET-Codierung mit HEVC finden Sie im GitHub-Repository media-services-v3-dotnet. Neben der benutzerdefinierten Codierung sind nun die folgenden neuen integrierten HEVC-Codierungsvoreinstellungen verfügbar:

- H265ContentAwareEncoding

- H265AdaptiveStreaming

- H265SingleBitrate720P

- H265SingleBitrate1080p

- H265SingleBitrate4K

Kunden, die zuvor HEVC im Premium-Encoder in Version 2 der API verwendet haben, sollten zur neuen HEVC-Codierungsunterstützung im Standard-Encoder migrieren.

Ankündigung der Einstellung der API und SDKs für Azure Media Services v2

Aktualisieren Sie Ihre REST-API und SDKs für Azure Media Services bis 29. Februar 2024 auf Version 3

Da Version 3 der REST-API und Client-SDKs für Azure Media Services für .NET und Java mehr Funktionen bietet als Version 2, stellen wir Version 2 der REST-API und Client-SDKs für Azure Media Services für .NET und Java ein.

Wir empfehlen Ihnen, die Umstellung früher vorzunehmen, um schnellstmöglich von den Vorteilen von Version 3 der REST-API und Client-SDKs für Azure Media Services für .NET und Java zu profitieren. Version 3 bietet Folgendes:

- Liveereignisunterstützung rund um die Uhr

- ARM REST APIs, Client-SDKs für .NET Core, Node.js, Python, Java, Go und Ruby

- Kundenseitig verwaltete Schlüssel, Integration von vertrauenswürdigem Speicher, Unterstützung für private Verbindungen und vieles mehr

Im Rahmen des Updates der v3-API und SDKs werden Media Reserve Units (MRUs) nicht mehr für Media Services-Konten benötigt, da das System basierend auf der Last automatisch hoch- und herunterskaliert wird. Weitere Informationen finden Sie im Migrationsleitfaden für reservierte Einheiten für Medien.

Einstellung von AMS als eigenständiger Lizenzbereitstellungsserver (hybrid-lokaler Modus) in v2 und v3

Für die v3-API wurde die Unterstützung der Schlüsselübermittlungsdienste als eigenständige Funktion für den Inhaltsschutz für Anwendungsfälle eingestellt, in denen der Schlüsselübermittlungsdienst für die Bereitstellung von Lizenzen für Inhalte verwendet wird, die über Ursprungsserver von Drittanbietern gestreamt bzw. übertragen werden. Das bedeutet, dass AMS in der v3-API keine Szenarien mehr unterstützt, die nur die Schlüsselübermittlung beinhalten, sondern für die Bereitstellung mit v3 ein Streaming von AMS-Ursprungsservern mit dynamischer Paketerstellung und Verschlüsselung voraussetzt.

Vorhandene Inhalte, die mit der v2-API verschlüsselt und im Rahmen eines „Hybridmodells“ bereitgestellt wurden, funktionieren weiterhin, d. h., die Schlüssel können nach wie vor auf Datenebene abgerufen werden. Die Verwaltung dieser Schlüssel (Aktualisierungen und Bearbeitungen) sowohl in v2 als auch in v3 wird jedoch ab 29. Februar 2024 nicht mehr unterstützt.

Hinweis

Alle neuen Inhalte, die mit v3 bereitgestellt werden, unterstützen Inhaltsschutz und Streaming nur aus AMS. Der „Hybridmodus“ wird für diese Inhalte nicht unterstützt. Die Datenebene liefert weiterhin bestehende, in v2 erstellte Schlüssel und Lizenzen, jedoch wird die Verwaltung oder Aktualisierung über die v2- oder v3-API nicht mehr unterstützt.

Erforderliche Aktion

Um die Unterbrechung Ihrer Workloads zu minimieren, lesen Sie den Migrationsleitfaden. Hier erhalten Sie Informationen zur Übertragung Ihres Codes von der API und den SDKs der Version 2 zur API und den SDKs der Version 3 vor dem 29. Februar 2024. Nach dem 29. Februar 2024 akzeptiert Azure Media Services keinen Datenverkehr mehr über die REST-API der Version 2, über die ARM-Kontoverwaltungs-API der Version 2015-10-01 oder aus .NET-Client-SDKs der Version 2. Dies betrifft auch alle Open-Source-Client-SDKs von Drittanbietern, die möglicherweise Version 2 der API aufrufen.

Weitere Informationen finden Sie in der offiziellen Ankündigung zu Azure-Updates.

Standard-Encoder-Unterstützung für Features von Version 2 der API

Neben der neu hinzugefügten Unterstützung der HEVC-Codierung (H.265) sind in Version 2020-05-01 (oder höher) der Codierungs-API jetzt die folgenden Features verfügbar.

- Das Zusammenfügen mehrerer Eingabedateien wird jetzt unterstützt dank der neuen JobInputClip-Unterstützung.

- Es ist ein Beispiel für .NET verfügbar, in dem gezeigt wird, wie Sie zwei Objekte zusammenfügen.

- Die Audiotitelauswahl ermöglicht es Kunden, die eingehenden Audiotitel auszuwählen, zuzuordnen und an die Ausgabe für die Codierung weiterzuleiten.

- Details zu AudioTrackDescriptor und der Auswahl von Titeln finden Sie in der OpenAPI-Datei für die REST-API.

- Titelauswahl für Codierung: Dieses Feature ermöglicht Kunden das Auswählen von Titeln aus einer ABR-Quelldatei oder einem Livearchiv mit Titeln mit verschiedenen Bitraten. Dies ist äußerst hilfreich für das Generieren von MP4-Dateien aus den Archivdateien von Liveereignissen.

- Weitere Informationen finden Sie unter VideoTrackDescriptor.

- FaceDetector wurden Bearbeitungsfunktionen (Weichzeichner) hinzugefügt.

Neue Client-SDK-Releases für Version 2020-05-01 der Azure Media Services-API

Für alle unterstützten Sprachen sind jetzt neue Client-SDK-Versionen mit den oben aufgeführten Features verfügbar. Führen Sie mit Ihrem Paket-Manager für Ihre Codebasis ein Update auf die aktuellen Client-SDKs durch.

- .NET SDK-Paket 3.0.4

- Node.js TypeScript, Version 8.1.0

- Python azure-mgmt-media 3.1.0

- Java SDK 1.0.0-beta.2

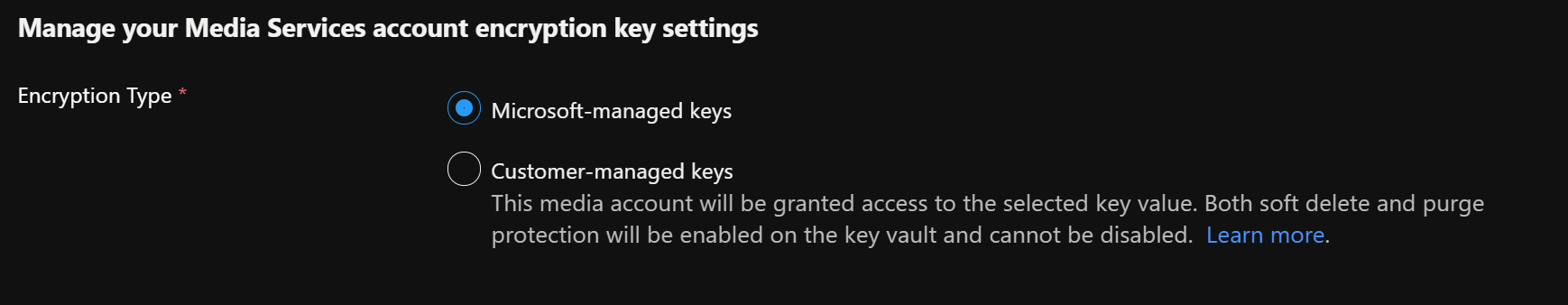

Neue verfügbare Sicherheitsfeatures in Version 2020-05-01 der Azure Media Services-API

Kundenseitig verwaltete Schlüssel: Inhaltsschlüssel und andere Daten, die in Konten gespeichert sind, die mit Version 2020-05-01 der API erstellt wurden, werden mit einem Kontoschlüssel verschlüsselt. Kunden können einen Schlüssel zur Verschlüsselung des Kontoschlüssels angeben.

Vertrauenswürdiger Speicher: Media Services kann so konfiguriert werden, dass über eine mit dem Media Services-Konto verknüpfte verwaltete Identität auf Azure Storage zugegriffen werden kann. Wenn über eine verwaltete Identität auf Speicherkonten zugegriffen wird, können Kunden restriktivere Netzwerk-ACLs für das Speicherkonto konfigurieren, ohne dass Media Services-Szenarios blockiert werden.

Verwaltete Identitäten: Kunden können eine systemseitig zugewiesene verwaltete Identität für ein Media Services-Konto aktivieren, um Zugriff auf Schlüsseltresore (für kundenseitig verwaltete Schlüssel) und Speicherkonten (für vertrauenswürdigen Speicher) zu gewähren.

Aktualisierte Beispiele für TypeScript Node.js mit isomorphem SDK für JavaScript

Die Node.js-Beispiele wurden so aktualisiert, dass das neueste isomorphe SDK verwendet wird. In ihnen wird jetzt die Verwendung von TypeScript demonstriert. Außerdem wurde ein neues Livestreamingbeispiel für Node.js bzw. TypeScript hinzugefügt.

Sehen Sie sich die neuesten Beispiele im GitHub-Repository media-services-v3-node-tutorials an.

Neuer Livestandbymodus zur Unterstützung eines schnelleren Starts aus dem warmen Zustand

Für Liveereignisse wird jetzt ein kostengünstigerer Abrechnungsmodus für den Standby unterstützt. Dadurch können Kunden für die Erstellung von heißen Pools Liveereignisse zu niedrigeren Kosten vorab zuordnen. Sie können dann die Liveereignisse im Standby schneller in den Ausführungszustand versetzen als beim Erstellen aus dem Kaltzustand. So wird die für das Starten des Kanals benötigte Zeit deutlich reduziert und eine schnelle Zuteilung von ausgeführten Computern zu heißen Pools in einem günstigeren Modus ermöglicht. Aktuelle ausführliche Informationen zu den Preisen finden Sie hier. Weitere Informationen zum Zustand „Standby“ und den anderen Zuständen von Liveereignissen finden Sie im Artikel Zustände von Liveereignissen und Abrechnung.

Dezember 2020

Regionale Verfügbarkeit

Azure Media Services ist jetzt in der Region „Norwegen, Osten“ im Azure-Portal verfügbar. RESTv2 ist in dieser Region nicht verfügbar.

Oktober 2020

Audioanalyse im Tarif „Basic“

Die Voreinstellung für die Audioanalyse enthält jetzt einen Basic-Tarif. Der neue Basic-Modus für die Audioanalyse bietet eine kostengünstige Option zum Extrahieren von Transkriptionen für gesprochenen Text sowie zum Formatieren von Beschriftungstext und Untertiteln. In diesem Modus werden Transkriptionen von gesprochenen Texten erstellt und VTT-Dateien mit Untertiteln und Beschriftungstexten generiert. Die Ausgabe in diesem Modus beinhaltet eine Insights JSON-Datei, die nur die Stichwörter, die Transkription und Zeitinformationen enthält. Eine automatische Spracherkennung und Sprecherdiarisierung sind nicht Bestandteil dieses Modus. Mehr dazu finden Sie in der Liste der unterstützten Sprachen.

Kunden, die Indexer v1 und Indexer v2 verwenden, sollten zur Voreinstellung für die Audioanalyse im Tarif „Basic“ migrieren.

Weitere Informationen zum Basic-Modus für die Audioanalyse finden Sie unter Analysieren von Video- und Audiodateien.

Liveereignisse

Aktualisierungen der meisten Eigenschaften sind jetzt zulässig, wenn Liveereignisse beendet werden. Darüber hinaus dürfen Benutzer ein Präfix für den statischen Hostnamen für die Eingabe- und Vorschau-URLs von Liveereignissen angeben. VanityUrl heißt jetzt useStaticHostName, um den Zweck der Eigenschaft besser widerzuspiegeln.

Liveereignisse verfügen jetzt über einen Standbyzustand. Weitere Informationen finden Sie unter Liveereignisse und Liveausgaben in Media Services.

Ein Liveereignis unterstützt den Empfang verschiedener Seitenverhältnisse bei Eingaben. Der Stretchingmodus ermöglicht es Kunden, das Stretchingverhalten für die Ausgabe anzugeben.

Live Encoding bietet jetzt die Möglichkeit, feste Keyframe-Intervallfragmente zwischen 0,5 und 20 Sekunden auszugeben.

Konten

Warnung

Wenn Sie ein Media Services-Konto mit der API-Version 2020-05-01 erstellen, funktioniert es nicht mit RESTv2.

August 2020

Dynamische Verschlüsselung

Unterstützung für die ältere PlayReady Protected Interoperable File Format-Verschlüsselung (PIFF 1.1) ist jetzt in Dynamic Packager verfügbar. Dies bietet Unterstützung für ältere Smart TV-Geräte von Samsung und LG, die die frühen Entwürfe der von Microsoft veröffentlichten Common Encryption-Standards (CENC) implementiert haben. Das PIFF 1.1-Format ist auch als das Verschlüsselungsformat bekannt, das zuvor von der Silverlight-Clientbibliothek unterstützt wurde. Heutzutage besteht das einzige Anwendungsszenario für dieses Verschlüsselungsformat in älteren Smart TV-Geräten, da es in einigen Regionen eine nicht unerheblich Anzahl von Smart TVs gibt, die nur Smooth Streaming mit PIFF 1.1-Verschlüsselung unterstützen.

Wenn Sie die neue PIFF 1.1-Verschlüsselungsunterstützung verwenden möchten, ändern Sie den Verschlüsselungswert im URL-Pfad des Streaminglocators in „piff“. Weitere Informationen finden Sie in der Übersicht über Content Protection. Beispiel: https://amsv3account-usw22.streaming.media.azure.net/00000000-0000-0000-0000-000000000000/ignite.ism/manifest(encryption=piff)|

Hinweis

PIFF 1.1-Unterstützung wird als abwärtskompatible Lösung für ein Smart TV-Gerät (Samsung, LG) bereitgestellt, das die frühe „Silverlight“-Version von Common Encryption implementiert hat. Sie sollten das PIFF-Format nur dann verwenden, wenn es zur Unterstützung älterer, von 2009 bis 2015 ausgelieferter Samsung- oder LG-Smart TV-Geräte verwendet wird, die die PIFF 1.1-Version der PlayReady-Verschlüsselung unterstützten.

Juli 2020

Livetranskriptionen

Livetranskriptionen unterstützen jetzt 19 Sprachen und 8 Regionen.

Hohe Verfügbarkeit

Wir haben eine Übersicht und ein Beispiel für Hochverfügbarkeit bei Media Services und Video on Demand (VoD) veröffentlicht.

Juni 2020

Live Video Analytics in IoT Edge (Vorschauversion)

Die Vorschauversion von Live Video Analytics in IoT Edge wurde veröffentlicht.

Live Video Analytics in IoT Edge ist eine Erweiterung der Media Services-Familie. Mit dieser Plattform können Sie Livevideos mit KI-Modellen Ihrer Wahl auf Ihren eigenen Edgegeräten analysieren und diese Videos optional aufzeichnen und speichern. Sie können nun Apps mit Echtzeit-Videoanalysen am Edge erstellen, ohne dass Sie sich Gedanken über die Komplexität des Erstellens und Ausführens einer Livevideo-Pipeline machen müssen.

Mai 2020

Neue Regionen: Germay North, Deutschland West, Mitte, Schweiz Nord und Schweiz West sind jetzt GA

Azure Media Services ist jetzt in den folgenden Regionen allgemein verfügbar: „Deutschland, Norden“, „Deutschland, Westen-Mitte“, „Schweiz, Norden“ und „Schweiz, Westen“. Kunden können Media Services mithilfe des Azure-Portals in diesen Regionen bereitstellen.

April 2020

Verbesserungen bei der Dokumentation

Die Azure Media Player-Dokumentation wurde zur Azure-Dokumentation migriert.

Januar 2020

Verbesserungen bei Medienprozessoren

- Verbesserte Unterstützung für verschachtelte Quellen in der Videoanalyse: Diese Inhalte werden jetzt ordnungsgemäß entschachtelt, bevor sie an Inferenzmodule gesendet werden.

- Beim Generieren von Miniaturansichten im „besten“ Modus sucht der Encoder jetzt über 30 Sekunden, um einen nicht monochromen Frame auszuwählen.

Updates für die Azure Government-Cloud

Media Services ist nun in den folgenden Azure Government-Regionen allgemein verfügbar: USGov Arizona und USGov Texas.

Dezember 2019

CDN-Unterstützung für Origin-Assist Prefetch-Header für Livestreaming und On-Demand-Videostreaming wurde hinzugefügt und ist für Kunden mit direktem Vertrag mit Akamai CDN verfügbar. Die Funktion „Origin-Assist CDN-Prefetch“ umfasst den folgenden HTTP-Header-Austausch zwischen Akamai CDN und dem Azure Media Services-Ursprung:

| HTTP-Header | Werte | Sender | Receiver | Zweck |

|---|---|---|---|---|

| CDN-Origin-Assist-Prefetch-Enabled | „1“ (Standardwert) oder „0“ | CDN | Origin | Angabe, dass CDN für den Vorabruf aktiviert ist |

| CDN-Origin-Assist-Prefetch-Path | Beispiel: Fragments(video=1400000000,format=mpd-time-cmaf) |

Origin | CDN | Angabe des Vorabrufpfads zu CDN |

| CDN-Origin-Assist-Prefetch-Request | „1“ (Vorabrufanforderung) oder „0“ (reguläre Anforderung) | CDN | Origin | Angabe, dass die Anforderung von CDN ein Vorabruf ist |

Um einen Teil des Headeraustausches in Aktion zu sehen, können Sie folgende Schritte ausführen:

- Verwenden Sie cURL, um eine Anforderung für ein Audio- oder Videosegment bzw. für ein Audio- oder Videofragment an den Media Services-Ursprung auszugeben. Fügen Sie den Header „CDN-Origin-Assist-Prefetch-Enabled: 1“ in der Anforderung hinzu.

- In der Antwort sollte der Header „CDN-Origin-Assist-Prefetch-Path“ mit einem relativen Pfad als Wert angezeigt werden.

November 2019

Livetranskription Preview

Die Livetranskription befindet sich jetzt in der öffentlichen Vorschau und ist in der Region „USA, Westen 2“ verfügbar.

Die Livetranskription ist so konzipiert, dass sie zusammen mit Liveereignissen als Add-On-Funktion funktioniert. Sie wird sowohl für Pass-Through-Liveereignisse als auch für Liveereignisse mit Standard- oder Premium-Codierung unterstützt. Wenn dieses Feature aktiviert wird, nutzt der Dienst das Spracherkennungsfeature von Cognitive Services, um den gesprochenen Text in der eingehenden Audiodatei in Text zu konvertieren. Dieser Text wird dann mitsamt Video- und Audiodaten in den MPEG-DASH- und HLS-Protokollen für die Übermittlung zur Verfügung gestellt. Die Abrechnung basiert auf einer neuen Add-On-Verbrauchseinheit, die sich als zusätzliche Kosten für das Liveereignis niederschlägt, wenn es sich im Zustand „Wird ausgeführt“ befindet. Details zur Livetranskription und Abrechnung finden Sie unter Livetranskription

Hinweis

Derzeit ist die Livetranskription nur als Vorschaufunktion in der Region „USA, Westen 2“ verfügbar. Sie unterstützt zu diesem Zeitpunkt nur die Transkription von gesprochener englischer Sprache (en-us).

Inhaltsschutz

Die Funktion Verhindern der Tokenwiedergabe (Token Replay Prevention), die in begrenzten Regionen im September veröffentlicht wurde, ist jetzt in allen Regionen verfügbar. Media Services-Kunden können jetzt einen Grenzwert festlegen, der bestimmt, wie oft ein Token zum Anfordern eines Schlüssels oder einer Lizenz verwendet werden kann. Weitere Informationen finden Sie unter Token Replay Prevention (Verhindern der Tokenwiedergabe).

Neue, empfohlene Liveencoder-Partner

Unterstützung für die folgenden neuen, empfohlenen Partner-Encoder für RTMP-Livestreaming wurde hinzugefügt:

Verbesserungen bei der Dateicodierung

- Eine neue Voreinstellung für Content Aware Encoding ist jetzt verfügbar. Sie erzeugt mithilfe der inhaltsbezogenen Codierung einen Satz von GOP-orientierten MP4s. Bei jeglichen eingegebenen Inhalten führt der Dienst eine erste einfache Analyse des eingegebenen Inhalts durch. Er verwendet diese Ergebnisse, um die optimale Anzahl der Ebenen, die geeignete Bitrate und die Auflösungseinstellungen für die Bereitstellung durch adaptives Streaming zu bestimmen. Diese Voreinstellung ist effektiv für Videos mit geringer und mittlerer Komplexität, bei denen die Ausgabedateien mit niedrigeren Bitraten, aber in einer Qualität vorliegen, die dem Betrachter dennoch ein gutes Erlebnis bietet. Die Ausgabe enthält MP4-Dateien mit überlappendem Video und Audio. Weitere Informationen finden Sie unter Öffnen der API-Spezifikationen.

- Verbesserte Leistung und Multithreading für das Größenänderungsmodul in Media Encoder Standard. Unter bestimmten Bedingungen sollte der Kunde eine Leistungssteigerung zwischen 5 und 40 % VOD-Codierung sehen. Inhalte von geringer Komplexität, die in mehrere Bitraten codiert werden, erfahren die höchsten Leistungssteigerungen.

- Die Standardcodierung behält nun bei Verwendung der zeitbasierten GOP-Einstellung einen regelmäßigen GOP-Rhythmus für Inhalte mit variablen Frameraten (VFR) bei der VOD-Codierung bei. Dies bedeutet, dass Kunden, die Inhalte mit gemischten Bildfrequenzen übermitteln, die beispielsweise zwischen 15 und 30 fps variieren, nun feststellen sollten, dass bei der Ausgabe in MP4-Dateien mit Adaptive Bitrate Streaming regelmäßige GOP-Abstände berechnet werden. Hierdurch wird die Möglichkeit verbessert, nahtlos zwischen den Spuren zu wechseln, wenn über HLS oder DASH geliefert wird.

- Verbesserte AV-Synchronisierung für Quellinhalte mit variabler Framerate (VFR)

Azure Video Indexer, Videoanalyse

- Keyframes, die mithilfe der VideoAnalyzer-Voreinstellung extrahiert wurden, sind jetzt in der ursprünglichen Auflösung des Videos, anstatt dass ihre Größe angepasst wird. Die hochauflösende Keyframe-Extraktion bietet Ihnen Bilder in Originalqualität und ermöglicht Ihnen die Verwendung bildbasierter KI-Modelle (künstliche Intelligenz), die von den Microsoft-Diensten Maschinelles Sehen und Custom Vision bereitgestellt werden, um noch mehr Erkenntnisse zu Ihrem Video zu erhalten.

September 2019

Media Services v3

Lineare Livecodierung von Liveereignissen

Media Services v3 gibt die Vorschauversion von 24 Stunden x 365 Tagen linearer Livecodierung von Liveereignisssen bekannt.

Media Services v2

Einstellung von Medienprozessoren

Wir kündigen die Einstellung von Azure Media Indexer und Azure Media Indexer 2 Preview an. Die Daten zur Einstellung finden Sie im Artikel Legacykomponenten. Azure Video Indexer ersetzt diese Legacy-Medienprozessoren.

Weitere Informationen finden Sie unter Migration von Azure Media Indexer v1 und Azure Media Indexer v2 zu Azure Media Services Video Indexer.

August 2019

Media Services v3

Südafrika-Regionspaar für Media Services verfügbar

Media Services ist jetzt in den Regionen „Südafrika, Norden“ und „Südafrika, Westen“ verfügbar.

Weiter Informationen finden Sie unter Clouds und Regionen, in denen Media Services v3 verfügbar ist.

Media Services v2

Einstellung von Medienprozessoren

Wir kündigen die Einstellung der Medienprozessoren Windows Azure Media Encoder (WAME) und Azure Media Encoder (AME) an, die eingestellt werden. Die Daten zur Einstellung finden Sie im Artikel Legacykomponenten.

Weitere Informationen finden Sie unter Migrieren von WAME zu Media Encoder Standard und Migrieren von AME zu Media Encoder Standard.

Juli 2019

Inhaltsschutz

Beim Streamen von Inhalten, die mittels Tokeneinschränkung geschützt sind, benötigen Endbenutzer ein Token, das im Rahmen der Schlüsselübermittlungsanforderung gesendet wird. Mit dem Feature zum Verhindern der Tokenwiedergabe können Media Services-Kunden einen Grenzwert festlegen, der bestimmt, wie oft ein Token zum Anfordern eines Schlüssels oder einer Lizenz verwendet werden kann. Weitere Informationen finden Sie unter Token Replay Prevention (Verhindern der Tokenwiedergabe).

Seit Juli war die Previewfunktion nur in „USA, Mitte“ und „USA, Westen-Mitte“ verfügbar.

Juni 2019

Video-Subclips

Sie können jetzt mithilfe eines Auftrags Videos beim Codieren zuschneiden oder Subclips für diese erstellen.

Dies funktioniert mit jeder Transformation, die entweder mit den BuiltInStandardEncoderPreset-Voreinstellungen oder mit den StandardEncoderPreset-Voreinstellungen erstellt wird.

Mai 2019

Azure Monitor-Unterstützung für Media Services-Diagnoseprotokolle und -Metriken

Sie können jetzt Azure Monitor verwenden, um die von Media Services ausgegebenen Telemetriedaten anzuzeigen.

- Nutzen Sie die Azure Monitor-Diagnoseprotokolle, um Anforderungen zu überwachen, die vom Endpunkt für die Media Services-Schlüsselbereitstellung gesendet werden.

- Überwachen Sie die Metriken, die von den Streamingendpunkten von Media Services ausgegeben werden.

Weitere Informationen finden Sie unter Überwachen von Media Services.

Unterstützung von mehreren Audiospuren bei der dynamischen Paketerstellung

Beim Streamen von Medienobjekten, die mehrere Audiospuren mit mehreren Codecs und Sprachen aufweisen, unterstützt die dynamische Paketerstellung jetzt mehrere Audiospuren für die HLS-Ausgabe (Version 4 oder höher).

Korea-Regionspaar für Media Services verfügbar

Microsoft Azure Media Services ist jetzt in den Regionen „Südkorea, Mitte“ und „Südkorea, Süden“ verfügbar.

Weiter Informationen finden Sie unter Clouds und Regionen, in denen Media Services v3 verfügbar ist.

Leistungsverbesserungen

Updates wurden hinzugefügt, die Verbesserungen an der Media Services-Leistung umfassen.

- Die maximal unterstützte Dateigröße für die Verarbeitung wurde aktualisiert. Weitere Informationen finden Sie unter Kontingente und Grenzwerte.

- Verbesserungen der Codierungsgeschwindigkeit.

April 2019

Neue Voreinstellungen

- FaceDetectorPreset wurde zu den Voreinstellungen des integrierten Analysetools hinzugefügt.

März 2019

Die dynamische Paketerstellung unterstützt jetzt Dolby Atmos. Weitere Informationen finden Sie unter Von der dynamischen Paketerstellung unterstützte Audiocodecs.

Sie können nun eine Liste von Medienobjekt- oder Kontenfiltern angeben, die für Ihren Streaminglocator gelten würden. Weitere Informationen finden Sie unter Zuordnen von Filtern mit Streaminglocator.

Februar 2019

Media Services v3 wird jetzt in nationalen Azure-Clouds unterstützt. Noch sind nicht alle Funktionen in allen Clouds verfügbar. Ausführliche Informationen finden Sie unter Clouds und Regionen, in denen Azure Media Services v3 verfügbar ist.

Das Ereignis Microsoft.Media.JobOutputProgress wurde den Azure Event Grid-Schemas für Media Services hinzugefügt.

Januar 2019

Media Encoder Standard und MPI-Dateien

Bei der Codierung mit Media Encoder Standard zum Erzeugen von MP4-Dateien wird eine neue MPI-Datei generiert und dem Ausgabeasset hinzugefügt. Diese MPI-Datei dient zum Verbessern der Leistung für die dynamische Paketerstellung und Streamingszenarios.

Sie sollten weder die MPI-Datei ändern oder entfernen noch beliebige Abhängigkeiten vom Vorhandensein (oder Nichtvorhandensein) einer solchen Datei in Ihren Dienst integrieren.

Dezember 2018

Zu den Updates in der GA-Version der V3-API gehören:

- Die PresentationTimeRange-Eigenschaften sind nicht mehr für Medienobjektfilter und Kontofilter erforderlich.

- Die Abfrageoptionen „$top“ und „$skip“ für Aufträge und Transformationen wurden entfernt, und „$orderby“ wurde hinzugefügt. Beim Hinzufügen der neuen Sortierungsfunktionalität wurde festgestellt, dass die Optionen „$top“ und „$skip“ versehentlich zuvor verfügbar gemacht wurden, obwohl sie nicht implementiert sind.

- Enumerationserweiterbarkeit wurde erneut aktiviert. Dieses Feature wurde in den Vorschauversionen des SDK aktiviert und wurde in der GA-Version versehentlich deaktiviert.

- Zwei vordefinierte Streamingrichtlinien wurden umbenannt. SecureStreaming ist jetzt MultiDrmCencStreaming. SecureStreamingWithFairPlay ist jetzt Predefined_MultiDrmStreaming.

November 2018

Das CLI 2.0-Modul ist ab sofort für Azure Media Services v3 (allgemein verfügbar) v2.0.50 verfügbar.

Neue Befehle

- az ams account

- az ams account-filter

- az ams asset

- az ams asset-filter

- az ams content-key-policy

- az ams job

- az ams live-event

- az ams live-output

- az ams streaming-endpoint

- az ams streaming-locator

- az ams account mru: Hiermit können Sie reservierte Einheiten für Medien verwalten.

Neue Features und Breaking Changes

Assetbefehle

- Die Argumente

--storage-accountund--containerwurden hinzugefügt. - Standardwerte für Ablaufzeit (aktueller Zeitpunkt + 23 Std.) und Berechtigungen (Lesen) im Befehl

az ams asset get-sas-urlwurden hinzugefügt.

Auftragsbefehle

- Die Argumente

--correlation-dataund--labelwurden hinzugefügt. --output-asset-nameswurde in--output-assetsumbenannt. Ab sofort wird eine durch Leerzeichen getrennte Ressourcenliste im Format „assetName=Bezeichnung“ akzeptiert. Assets ohne Bezeichnung können wie folgt gesendet werden: „assetName=“.

streaming locator-Befehle

- Der Basisbefehl

az ams streaming locatorwurde durchaz ams streaming-locatorersetzt. - Die Argumente

--streaming-locator-idund--alternative-media-id supportwurden hinzugefügt. - Das Argument

--content-keys argumentwurde aktualisiert. --content-policy-namewurde in--content-key-policy-nameumbenannt.

streaming policy-Richtlinien

- Der Basisbefehl

az ams streaming policywurde durchaz ams streaming-policyersetzt. - Unterstützung für Verschlüsselungsparameter für

az ams streaming-policy createwurde hinzugefügt.

transform-Befehle

- Das Argument

--preset-nameswurde durch--presetersetzt. Ab sofort kann nur noch eine einzelne Ausgabe/Voreinstellung festgelegt werden. (Wenn Sie weitere hinzufügen möchten, müssen Sieaz ams transform output addausführen.) Darüber hinaus können Sie eine benutzerdefinierte Voreinstellung für den Standard-Encoder (StandardEncoderPreset) festlegen, indem Sie den Pfad an Ihr benutzerdefiniertes JSON-Objekt übergeben. - Für

az ams transform output removekann der zu entfernende Ausgabeindex übergeben werden. - Die Argumente

--relative-priority, --on-error, --audio-language and --insights-to-extractwurden inaz ams transform createund den Befehlenaz ams transform output addhinzugefügt.

Oktober 2018 – Allgemeine Verfügbarkeit (GA)

In diesem Abschnitt werden die Oktober-Updates für Azure Media Services (AMS) beschrieben.

REST v3-GA-Release

Das REST v3-GA-Release umfasst mehr APIs für den Livebetrieb, Manifestfilter für die Konto-/Ressourcenebene und DRM-Support.

Azure-Ressourcenverwaltung

Die Unterstützung der Azure-Ressourcenverwaltung ermöglicht eine einheitliche Verwaltung und Vorgangs-API (jetzt alles an einem Ort).

Ab dieser Version können Sie Resource Manager-Vorlagen verwenden, um Liveereignisse zu erstellen.

Verbesserung von Medienobjektvorgängen

Die folgenden Verbesserungen wurden eingeführt:

- Erfassen von HTTP(S)-URLs oder Azure Blob Storage-SAS-URLs

- Angeben von eigenen Containernamen für Medienobjekte

- Einfachere Unterstützung der Ausgabe zur Erstellung von benutzerdefinierten Workflows mit Azure Functions

Neues Transform-Objekt

Mit dem neuen Transform-Objekt wird das Codierungsmodell vereinfacht. Es ist mit dem neuen Objekt einfach, Resource Manager-Vorlagen und -Voreinstellungen für die Codierung zu erstellen und gemeinsam zu nutzen.

Azure Active Directory-Authentifizierung und Azure-RBAC

Die Azure AD-Authentifizierung und die rollenbasierte Zugriffssteuerung in Azure (Azure-RBAC) ermöglichen sichere Transformationen, Liveereignisse, Richtlinien für Inhaltsschlüssel oder den Zugriff auf Medienobjekte nach Rolle oder Benutzer in Azure AD.

Client-SDKs

In Media Services (v3) unterstützte Sprachen: .NET Core, Java, Node.js, Ruby, TypeScript, Python, Go.

Updates der Livecodierung

Die folgenden Updates für die Livecodierung wurden eingeführt:

Neuer Modus mit geringer Latenz für den Livebetrieb (10 Sekunden für den End-to-End-Vorgang).

Verbesserte RTMP-Unterstützung (höhere Stabilität und bessere Unterstützung für Quellcodierer).

Sichere RTMPS-Erfassung.

Bei der Erstellung eines Liveereignisses erhalten Sie jetzt vier Erfassungs-URLs. Die vier Erfassungs-URLs sind nahezu identisch und verfügen über das gleiche Streamingtoken (AppId). Nur der Portnummernteil unterscheidet sich. Zwei der URLs dienen als primäre URL und Backup-URL für RTMPS.

Unterstützung der 24-Stunden-Transcodierung.

Verbesserte Unterstützung für Werbeeinblendungen in RTMP über SCTE35.

Verbesserte Event Grid-Unterstützung

Folgende Verbesserungen der Event Grid-Unterstützung wurden eingeführt:

- Azure Event Grid-Integration, um die Entwicklung mit Logic Apps und Azure Functions zu vereinfachen.

- Abonnieren von Ereignissen für Codierung, Livekanäle und mehr.

CMAF-Unterstützung

CMAF- und „cbcs“-Verschlüsselungsunterstützung für Apple HLS- (iOS 11 und höher) und MPEG-DASH-Player, die CMAF unterstützen.

Video Indexer

Das Video Indexer-GA-Release wurde im August angekündigt. Neue Informationen zu derzeit unterstützten Funktionen finden Sie unter Was ist Video Indexer?.

Pläne für Änderungen

Azure CLI 2.0

Das Azure CLI 2.0-Modul mit Vorgängen für alle Features (z.B. Livebetrieb, Richtlinien für Inhaltsschlüssel, Konto-/Ressourcenfilter, Streamingrichtlinien) ist in Kürze verfügbar.

Bekannte Probleme

Nur Kunden, die die Vorschauversion der API für Ressourcen- oder Kontofilter verwendet haben, sind vom folgenden Problem betroffen.

Wenn Sie zwischen dem 28.09. und dem 12.10. mit der Media Services v3 CLI oder den zugehörigen APIs Ressourcen- oder Kontofilter erstellt haben, müssen Sie aufgrund eines Versionskonflikts alle Ressourcen- und Kontofilter entfernen und neu erstellen.

Mai 2018 – Vorschau

.NET SDK

Das .NET SDK enthält die folgenden Funktionen:

- Streaminglocators zum Veröffentlichen und Streamen von Inhalten auf Endbenutzergeräten

- Streamingrichtlinien und Inhaltsschlüssel-Richtlinien zum Konfigurieren der Schlüsselübermittlung und des Inhaltsschutzes (DRM) bei der Inhaltsbereitstellung

- Liveereignisse und Liveausgaben zum Konfigurieren der Erfassung und Archivierung von Livestreaminginhalten

- Medienobjekte zum Speichern und Veröffentlichen von Medieninhalten in Azure Storage

- Streamingendpunkte zum Konfigurieren und Skalieren der dynamischen Paketerstellung, der Verschlüsselung und des Streamings von Live- und On-Demand-Medieninhalten

Bekannte Probleme

- Wenn Sie einen Auftrag übermitteln, können Sie angeben, dass Ihr Quellvideo mithilfe von HTTPS, URLs, SAS-URLs oder Pfaden zu Dateien in Azure Blob Storage erfasst wird. Media Services v3 unterstützt derzeit keine segmentierte Transfercodierung über HTTPS-URLs.

Fragen stellen, Feedback geben, Updates abrufen

Im Artikel Azure Media Services-Community finden Sie verschiedene Möglichkeiten, Fragen zu stellen, Feedback zu geben und Updates zu Media Services zu bekommen.