Anmerkung

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen, dich anzumelden oder die Verzeichnisse zu wechseln.

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen , die Verzeichnisse zu wechseln.

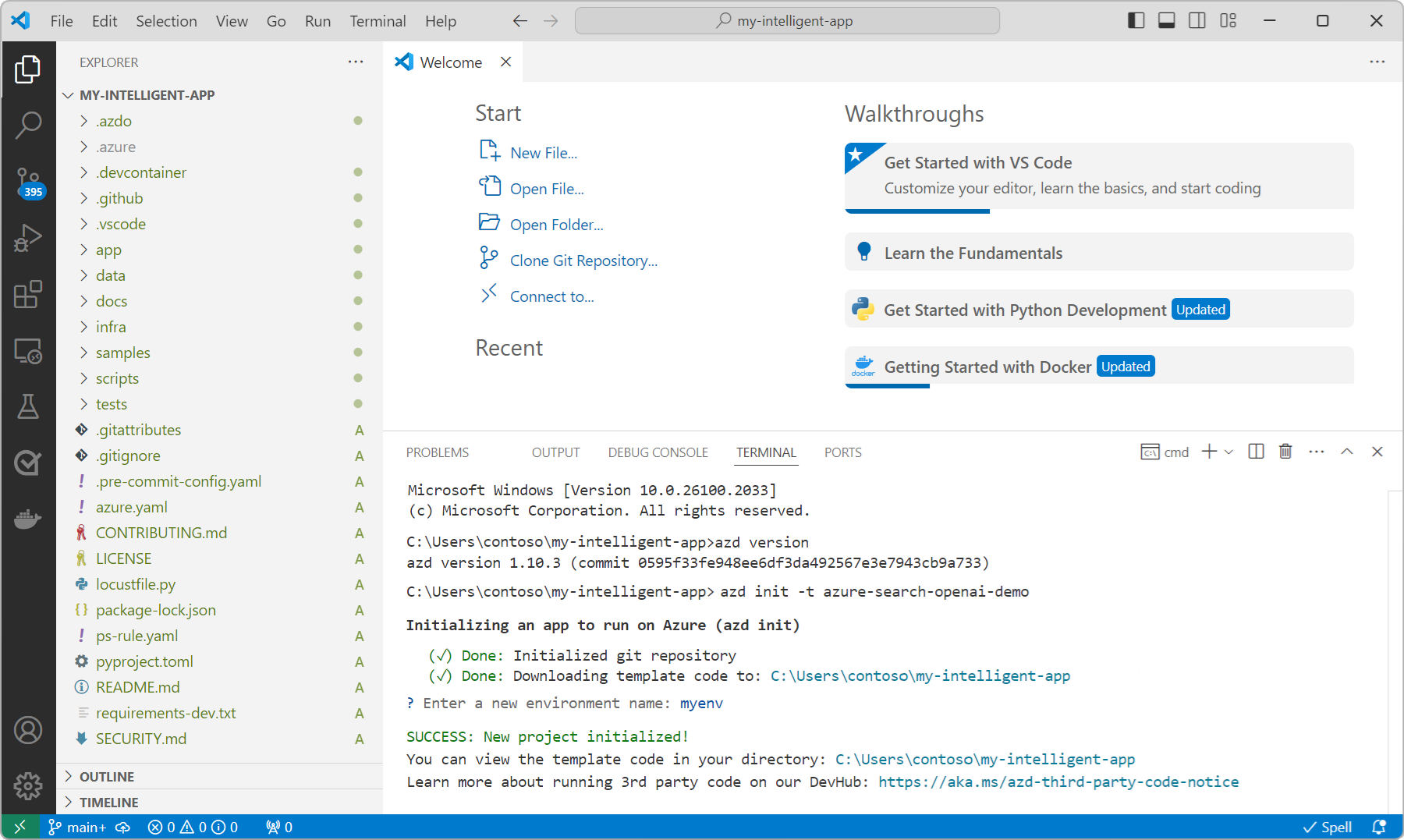

In diesem Artikel wird gezeigt, wie Sie den Chat mit Ihrem eigenen Datenbeispielmithilfe von Beispielcode für Python bereitstellen und ausführen. Diese Beispielchatanwendung wird mit Python, Azure OpenAI Service und Retrieval Augmented Generation (RAG) über Azure AI Search erstellt.

Die App bietet Antworten auf Fragen von Benutzern zu Mitarbeitervorteilen in einem fiktiven Unternehmen. Es verwendet Retrieval-Augmented Generation (RAG), um auf Inhalte aus bereitgestellten PDF-Dateien zu verweisen, die folgendes umfassen können:

- Ein Mitarbeiterhandbuch

- Leistungsübersichtsdokument

- Eine Liste der Unternehmensrollen und Erwartungen

Durch die Analyse dieser Dokumente kann die App auf Abfragen natürlicher Sprachen mit genauen, kontextbezogenen Antworten reagieren. Dieser Ansatz veranschaulicht, wie Sie Ihre eigenen Daten verwenden können, um intelligente, domänenspezifische Chaterfahrungen mit Azure OpenAI und Azure AI Search zu ermöglichen.

Außerdem erfahren Sie, wie Sie die Einstellungen der App konfigurieren, um das Antwortverhalten zu ändern.

Nachdem Sie die Schritte in diesem Artikel abgeschlossen haben, können Sie mit dem Anpassen des Projekts mit Ihrem eigenen Code beginnen. Dieser Artikel ist Teil einer Reihe, die Sie durch das Erstellen einer Chat-App mit Azure OpenAI Service und Azure AI Search führt. Weitere Artikel in dieser Reihe:

Hinweis

Dieser Artikel basiert auf einer oder mehreren AI-App-Vorlagen, die als gut verwaltete Referenzimplementierungen dienen. Diese Vorlagen sind so konzipiert, dass sie einfach bereitzustellen sind und einen zuverlässigen, qualitativ hochwertigen Ausgangspunkt für die Erstellung Eigener KI-Anwendungen bieten.

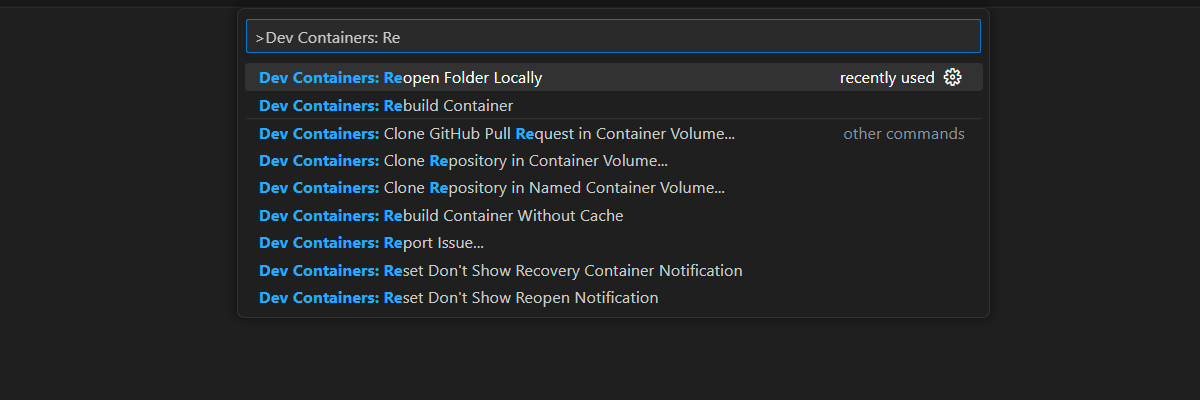

Beispiel-App-Architektur

Das folgende Diagramm zeigt eine einfache Architektur der Chat-App.

Zu den wichtigsten Komponenten der Architektur gehören:

- Eine Webanwendung, die die interaktive Chatschnittstelle (in der Regel mit Python Flask oder JavaScript/React erstellt) hosten und Benutzerfragen zur Verarbeitung an das Back-End sendet.

- Eine Azure AI Search-Ressource, die intelligente Suche über indizierte Dokumente (PDFs, Word-Dateien usw.) durchführt und relevante Dokumentauszüge (Blöcke) für die Verwendung in Antworten zurückgibt.

- Eine Azure OpenAI-Dienstinstanz, die:

- Konvertiert Dokumente und Benutzerfragen in Vektordarstellungen für die semantische Ähnlichkeitssuche.

- Extrahiert wichtige Schlüsselwörter, um Azure AI Search-Abfragen zu verfeinern.

- Synthetisiert endgültige Antworten mithilfe der abgerufenen Daten und Der Benutzerabfrage.

Der typische Fluss der Chat-App lautet wie folgt:

- Der Benutzer sendet eine Frage: Ein Benutzer gibt eine Frage in natürlicher Sprache über die Web-App-Benutzeroberfläche ein.

-

Azure OpenAI verarbeitet die Frage: Das Back-End verwendet Azure OpenAI für:

- Generieren Sie eine Einbettung der Frage mithilfe des Modells "text-embedding-ada-002".

- Extrahieren Sie optional Schlüsselwörter, um die Suchrelevanz zu verfeinern

- Azure AI Search ruft relevante Daten ab: Die Einbettung oder Schlüsselwörter werden verwendet, um eine semantische Suche über indizierte Inhalte (z. B. PDFs) in Azure AI Search durchzuführen.

- Kombinieren Sie Ergebnisse mit der Frage: Die relevantesten Dokumentauszüge (Blöcke) werden mit der ursprünglichen Frage des Benutzers kombiniert.

- Azure OpenAI generiert eine Antwort: Die kombinierte Eingabe wird an ein GPT-Modell (z. B. gpt-35-turbo oder gpt-4) übergeben, das eine kontextabhängige Antwort generiert.

- Die Antwort wird an den Benutzer zurückgegeben: Die generierte Antwort wird in der Chatoberfläche angezeigt.

Voraussetzungen

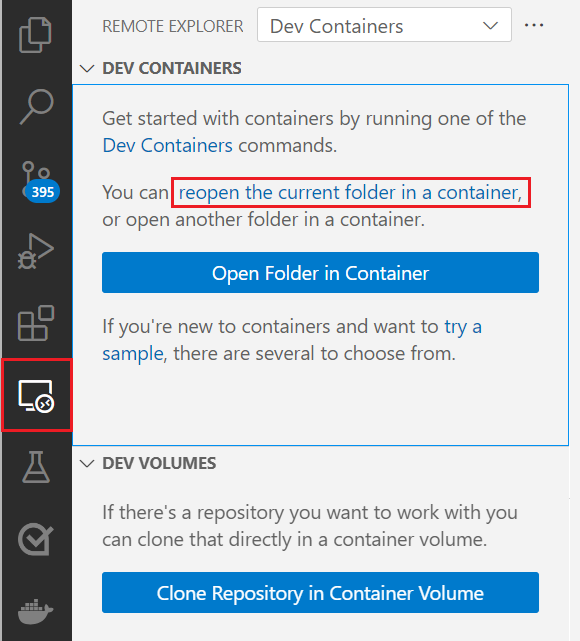

Eine Entwicklungscontainerumgebung steht mit allen Abhängigkeiten zur Verfügung, die zum Abschluss dieses Artikels erforderlich sind. Sie können den Entwicklungscontainer in GitHub Codespaces (in einem Browser) oder lokal mit Visual Studio Code ausführen.

Um diesen Artikel zu verwenden, benötigen Sie die folgenden Voraussetzungen:

Ein Azure-Abonnement. Erstellen Sie ein kostenloses Konto, bevor Sie beginnen.

Azure-Kontoberechtigungen. Ihr Azure-Konto muss über Microsoft.Authorization/roleAssignments/Schreibberechtigungen verfügen. Rollen wie Benutzerzugriffsadministrator oder Besitzer erfüllen diese Anforderung.

Zugriff auf Azure OpenAI wurde in Ihrem Azure-Abonnement gewährt. In den meisten Fällen können Sie benutzerdefinierte Inhaltsfilter erstellen und Schweregrade mit allgemeinem Zugriff auf Azure OpenAI-Modelle verwalten. Die Registrierung für den genehmigungsbasierten Zugriff ist für den allgemeinen Zugriff nicht erforderlich. Weitere Informationen finden Sie unter Eingeschränkter Zugriff für Azure AI-Dienste.

Inhaltsfilter oder Änderungen zur Missbrauchsvermeidung (optional). Zum Erstellen von benutzerdefinierten Inhaltsfiltern, Ändern des Schweregrads oder Zur Unterstützung der Missbrauchsüberwachung benötigen Sie eine formale Zugriffsgenehmigung. Sie können den Zugriff beantragen, indem Sie die erforderlichen Registrierungsformulare ausfüllen. Weitere Informationen finden Sie unter Registrierung für geänderte Inhaltsfilter und/oder Missbrauchsüberwachung.

Zugriff auf den Support und die Fehlerbehebung. Öffnen Sie für den Zugriff auf die Problembehandlung ein Supportproblem im GitHub-Repository.

Ein GitHub-Konto. Erforderlich, um das Repository zu forken und GitHub Codespaces zu verwenden oder es lokal zu klonen.

Nutzungskosten für Beispielressourcen

Die meisten ressourcen, die in dieser Architektur verwendet werden, fallen unter einfache oder verbrauchsbasierte Preisniveaus. Dies bedeutet, dass Sie nur für ihre Nutzung bezahlen, und Die Gebühren sind in der Regel während der Entwicklung oder beim Testen minimal.

Um dieses Beispiel abzuschließen, können geringe Kosten für die Verwendung von Diensten wie Azure OpenAI, AI Search und dem Speicher anfallen. Nachdem Sie die Auswertung oder Bereitstellung der App abgeschlossen haben, können Sie alle bereitgestellten Ressourcen löschen, um laufende Gebühren zu vermeiden.

Eine detaillierte Aufschlüsselung der erwarteten Kosten finden Sie in der Kostenschätzung im GitHub-Repository für das Beispiel.

Offene Entwicklungsumgebung

Beginnen Sie mit dem Einrichten einer Entwicklungsumgebung, die alle Abhängigkeiten installiert hat, um diesen Artikel abzuschließen.

- Ein Azure-Abonnement. Eines kostenlos erstellen.

- Azure-Kontoberechtigungen. Ihr Azure-Konto muss über Microsoft.Authorization/roleAssignments/Schreibberechtigungen verfügen. Rollen wie Benutzerzugriffsadministrator oder Besitzer erfüllen diese Anforderung.

- Ein GitHub-Konto. Erforderlich, um das Repository zu forken und GitHub Codespaces zu verwenden oder es lokal zu klonen.

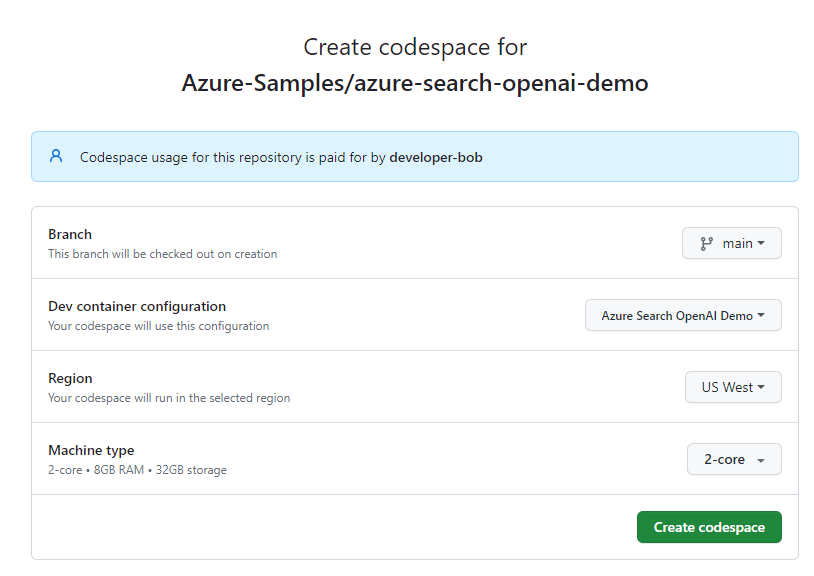

Öffnen einer Entwicklungsumgebung

Verwenden Sie die folgenden Anweisungen, um eine vorkonfigurierte Entwicklungsumgebung bereitzustellen, die alle erforderlichen Abhängigkeiten enthält, um diesen Artikel abzuschließen.

Verwenden Sie GitHub Codespaces, um das einfachste und optimierte Setup zu ermöglichen. GitHub Codespaces führt einen von GitHub verwalteten Entwicklungscontainer aus und stellt Visual Studio Code für das Web als Benutzeroberfläche bereit. Diese Umgebung enthält alle erforderlichen Tools, SDKs, Erweiterungen und vorinstallierten Abhängigkeiten, sodass Sie sofort ohne manuelle Konfiguration mit der Entwicklung beginnen können.

Die Verwendung von Codespaces stellt Folgendes sicher:

- Die richtigen Entwicklertools und -versionen sind bereits installiert.

- Es ist nicht erforderlich, Docker, VS Code oder Erweiterungen lokal zu installieren.

- Schnelles Onboarding und reproduzierbare Einrichtung der Umgebung.

Wichtig

Alle GitHub-Konten können GitHub Codespaces für bis zu 60 Stunden kostenlos jeden Monat mit 2 Kerninstanzen verwenden. Wenn Sie das kostenlose Kontingent überschreiten oder größere Computeoptionen verwenden, gelten standardmäßige GitHub Codespaces-Abrechnungssätze. Weitere Informationen finden Sie unter GitHub Codespaces – Monatlich enthaltene Speicher- und Kernstunden.

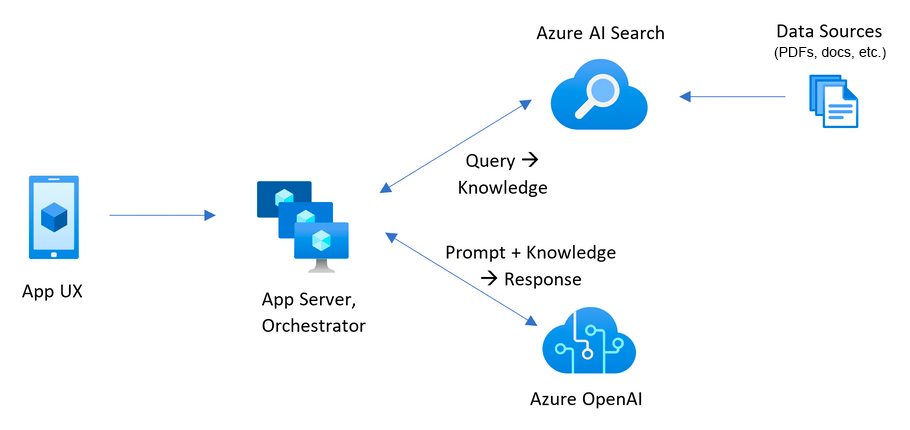

Um mit der Arbeit mit dem Beispielprojekt zu beginnen, erstellen Sie einen neuen GitHub-Codespace auf der

mainVerzweigung desAzure-Samples/azure-search-openai-demoGitHub-Repositorys.Klicken Sie mit der rechten Maustaste auf die GitHub Codespaces - Option "Öffnen " oben auf der Repositoryseite, und wählen Sie "Link öffnen" im neuen Fenster aus. Dadurch wird sichergestellt, dass der Entwicklungscontainer in einer vollbildigen, dedizierten Browserregisterkarte gestartet wird, sodass Sie sowohl auf den Quellcode als auch auf die integrierte Dokumentation zugreifen können.

Überprüfen Sie auf der Seite " Neue Codespace erstellen" die Codespace-Konfigurationseinstellungen, und wählen Sie dann " Codespace erstellen" aus:

Warten Sie, bis der GitHub-Codespace gestartet wird. Der Startvorgang kann einige Minuten dauern.

Nachdem der GitHub-Codespace geöffnet wurde, melden Sie sich mit der Azure Developer CLI bei Azure an, indem Sie den folgenden Befehl im Terminalbereich des Codespace eingeben:

azd auth loginGitHub zeigt einen Sicherheitscode im Terminalbereich an.

Kopieren Sie den Sicherheitscode im Terminalbereich, und drücken Sie die EINGABETASTE. Ein Browser-Fenster öffnet sich.

Fügen Sie an der Eingabeaufforderung den Sicherheitscode in das Browserfeld ein.

Befolgen Sie die Anweisungen zum Authentifizieren mit Ihrem Azure-Konto.

Sie führen die verbleibenden GitHub Codespaces-Aufgaben in diesem Artikel im Kontext dieses Entwicklungscontainers aus.

Bereitstellen einer Chat-App in Azure

Das Beispiel-Repository enthält alles, was Sie zum Bereitstellen eines Chats mit Ihrer eigenen Datenanwendung in Azure benötigen, einschließlich:

- Anwendungsquellcode (Python)

- Infrastructure-as-Code Dateien (Bicep)

- Konfiguration für GitHub-Integration und CI/CD (optional)

Führen Sie die folgenden Schritte aus, um die App mit der Azure Developer CLI (azd) bereitzustellen.

Wichtig

Azure-Ressourcen, die in diesem Abschnitt erstellt wurden, insbesondere Azure AI Search, können mit der Fälligkeit von Gebühren sofort bei der Bereitstellung beginnen, auch wenn die Bereitstellung vor Abschluss unterbrochen wird. Um unerwartete Gebühren zu vermeiden, überwachen Sie Ihre Azure-Nutzung, und löschen Sie nicht verwendete Ressourcen umgehend nach dem Testen.

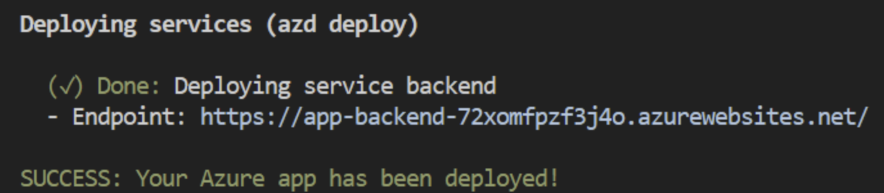

Erstellen Sie im Bereich Visual Studio Code Terminal die Azure-Ressourcen, und stellen Sie den Quellcode bereit, indem Sie den folgenden

azdBefehl ausführen:azd upDer Prozess fordert Sie auf der Grundlage Ihrer Konfiguration auf, eine oder mehrere der folgenden Einstellungen anzugeben:

Umgebungsname: Dieser Wert wird als Teil des Ressourcengruppennamens verwendet. Geben Sie einen kurzen Namen mit Kleinbuchstaben und Bindestrichen (), z. B.

-, ein. Großbuchstaben, Zahlen und Sonderzeichen werden nicht unterstützt.Abonnement: Wählen Sie ein Abonnement aus, um die Ressourcen zu erstellen. Wenn Ihr gewünschtes Abonnement nicht angezeigt wird, verwenden Sie die Pfeiltasten, um die vollständige Liste der verfügbaren Abonnements zu scrollen.

Standort: Dieser Standort wird für die meisten Ressourcen, einschließlich des Hostings, verwendet. Wählen Sie einen Speicherort in Ihrer geografischen Nähe.

Speicherort für OpenAI-Modell oder Dokumentintelligenzressource: Wählen Sie den standortnächsten Standort aus. Wenn die Region, die Sie für Ihren Standort ausgewählt haben, für diese Einstellung verfügbar ist, wählen Sie dieselbe Region aus.

Es kann einige Zeit dauern, bis die App bereitgestellt wird. Warten Sie auf den Abschluss der Bereitstellung, bevor Sie fortfahren.

Nachdem die App erfolgreich bereitgestellt wurde, zeigt der Terminalbereich eine Endpunkt-URL an:

Wählen Sie die Endpunkt-URL aus, um die Chatanwendung in einem Browser zu öffnen:

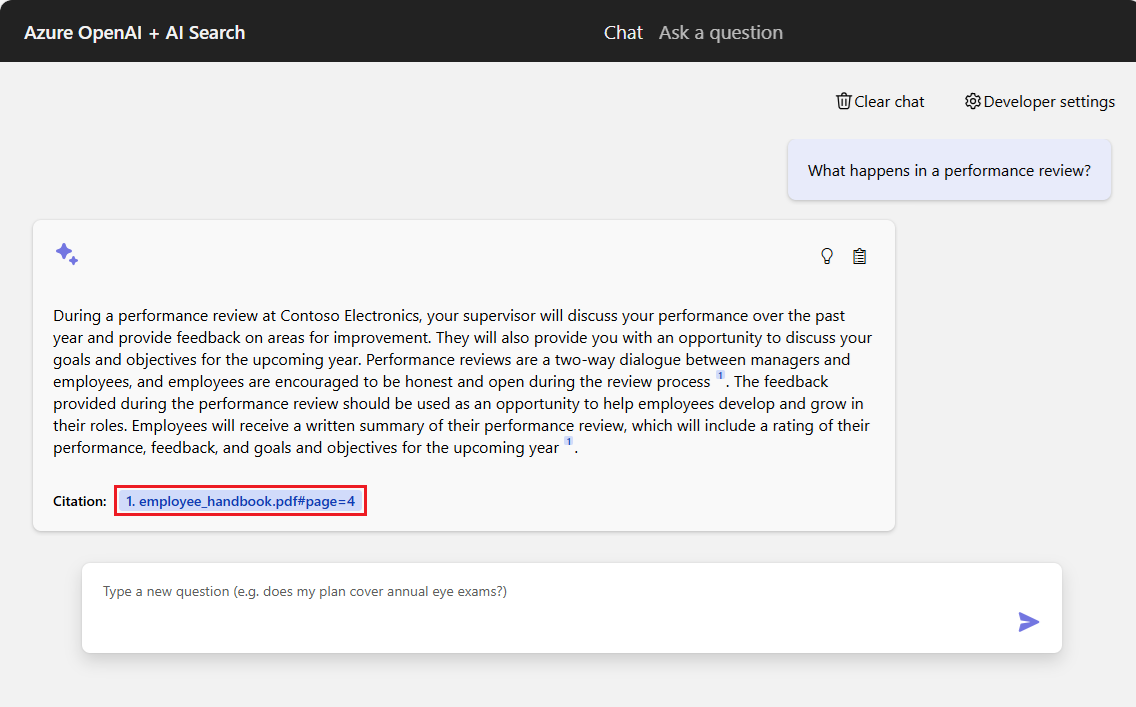

Verwenden der Chat-App zum Abrufen von Antworten aus PDF-Dateien

Die Chat-App wird vorab mit Informationen zu den Leistungen für Mitarbeiter aus PDF-Dateien befüllt. Sie können die Chat-App verwenden, um Fragen zu den Vorteilen zu stellen. Die folgenden Schritte führen Sie durch den Prozess der Verwendung der Chat-App. Ihre Antworten können variieren, wenn die zugrunde liegenden Modelle aktualisiert werden.

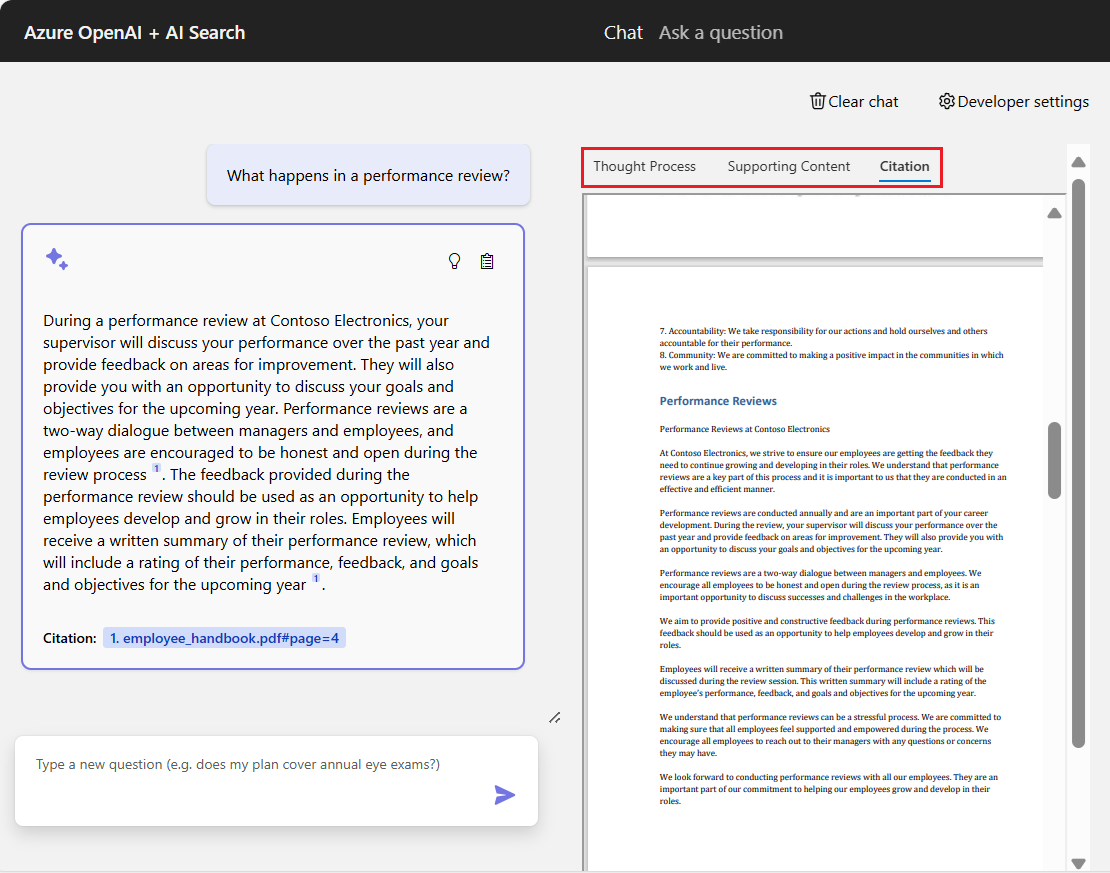

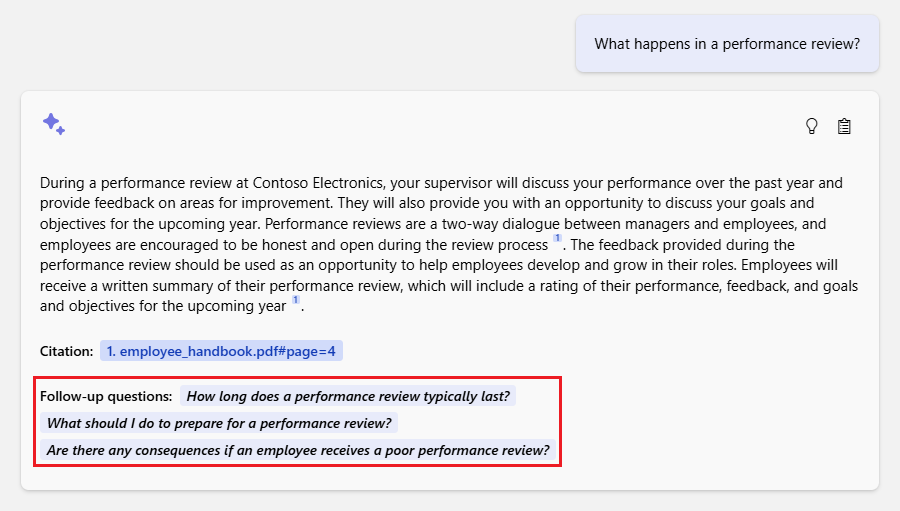

Wählen Sie in der Chat-App die Option "Was geschieht in einer Leistungsüberprüfung?" aus, oder geben Sie denselben Text in das Chattextfeld ein. Die App gibt die erste Antwort zurück:

Wählen Sie im Antwortfeld ein Zitat aus:

GitHub Codespaces öffnet den rechten Bereich " Zitat " mit drei Registerkartenbereichen, und der Fokus befindet sich auf der Registerkarte "Zitat ":

GitHub Codespaces bietet drei Registerkarten mit Informationen, die Ihnen helfen, zu verstehen, wie die Chat-App die Antwort generiert hat:

Registerkarte BESCHREIBUNG Gedankenprozess Zeigt ein Skript der Frage-/Antwortinteraktionen im Chat an. Sie können die von der Chat-App systembereitgestellten Inhalte anzeigen, fragen, die von demuserSystem eingegeben wurden, und Klarstellungen des Systemsassistant.Unterstützende Inhalte Listet die Informationen auf, die verwendet werden, um Ihre Frage und das Quellmaterial zu beantworten. Die Anzahl der Quellmaterialzitate wird durch die Entwicklereinstellungen angegeben. Die Standardanzahl von Zitaten ist 3. Quellenangaben Zeigt die ursprüngliche Quelle für das ausgewählte Zitat an. Wenn Sie fertig sind, wählen Sie im rechten Bereich die aktuell ausgewählte Registerkarte aus. Das rechte Fenster wird abgeschlossen.

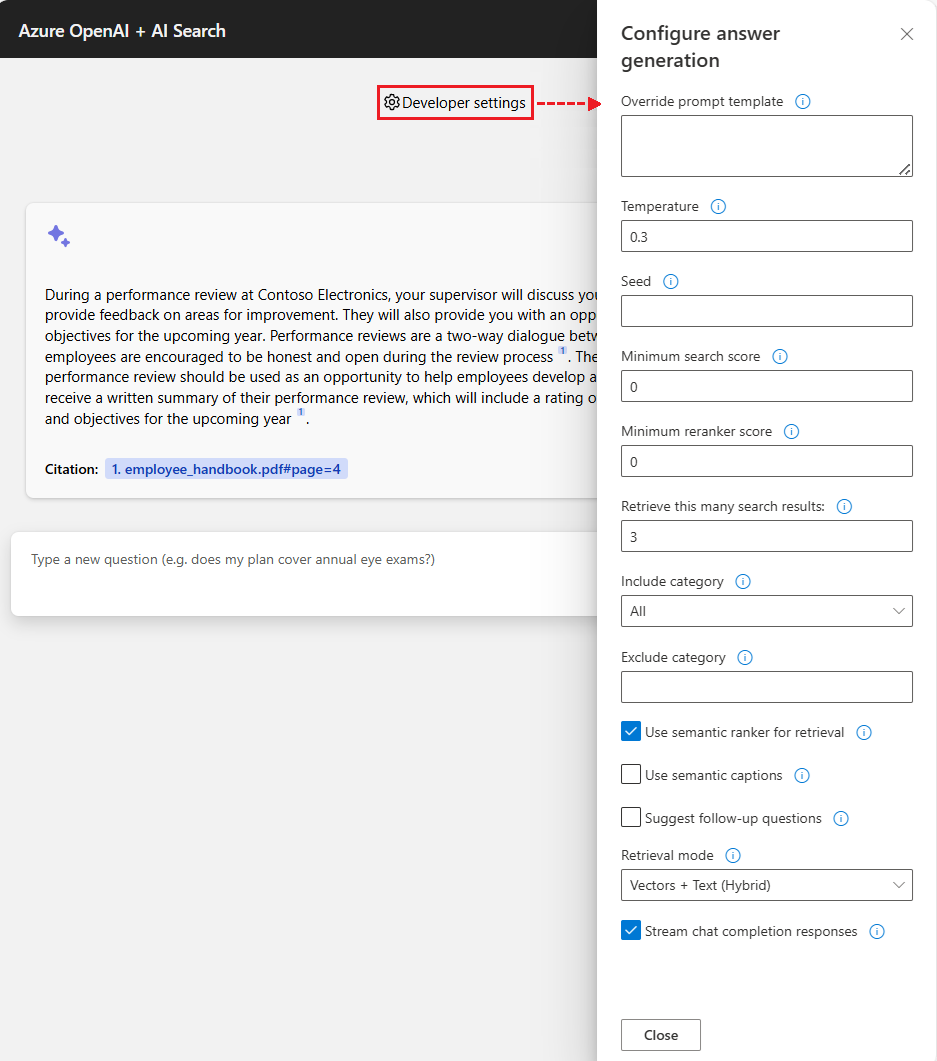

Verwenden von Einstellungen zum Ändern des Antwortverhaltens

Das spezifische OpenAI-Modell bestimmt die Intelligenz des Chats und die Einstellungen, die für die Interaktion mit dem Modell verwendet werden. Die Option "Entwicklereinstellungen " öffnet den Bereich " Antwortgenerierung konfigurieren ", in dem Sie Einstellungen für die Chat-App ändern können:

| Konfiguration | BESCHREIBUNG |

|---|---|

| Vorlage zum Außerkraftsetzen der Eingabeaufforderung | Überschreibt die Eingabeaufforderung, die verwendet wird, um die Antwort basierend auf der Frage und den Suchergebnissen zu generieren. |

| Temperatur | Legt die Temperatur der Anforderung auf das große Sprachmodell (LLM) fest, das die Antwort generiert. Höhere Temperaturen führen zu kreativeren Reaktionen, aber sie sind möglicherweise weniger geerdet. |

| Seed | Legt einen Startwert fest, um die Reproduzierbarkeit der Antworten des Modells zu verbessern. Der Startwert kann eine beliebige Ganzzahl sein. |

| Minimale Bewertung für die Suche | Legt eine Mindestbewertung für Suchergebnisse fest, die von Azure AI Search zurückgegeben werden. Der Bewertungsbereich hängt davon ab, ob Sie Hybrid (Standard), Vektoren oder Nur Text für die Einstellung "Abrufmodus " verwenden. |

| Mindestwiederholungsbewertung | Legt eine Mindestbewertung für Suchergebnisse fest, die vom semantischen Reranker zurückgegeben werden. Die Bewertung liegt immer zwischen 0 und 4. Je höher die Bewertung ist, desto semantischer relevanter ist das Ergebnis für die Frage. |

| Abrufen dieser vielen Suchergebnisse | Legt die Anzahl der Suchergebnisse fest, die aus Azure AI Search abgerufen werden sollen. Weitere Ergebnisse können die Wahrscheinlichkeit erhöhen, die richtige Antwort zu finden, aber kann dazu führen, dass das Modell "in der Mitte verloren geht". Die zurückgegebenen Quellen werden auf den Registerkarten " Gedankenprozess " und " Unterstützende Inhalte " im Bereich "Zitat " angezeigt. |

| Kategorie einschließen | Gibt die Kategorien an, die beim Generieren der Suchergebnisse eingeschlossen werden sollen. Verwenden Sie die Dropdownliste, um Ihre Auswahl zu treffen. Die Standardaktion besteht darin, alle Kategorien einzuschließen. |

| Kategorie ausschließen | Gibt alle Kategorien an, die aus den Suchergebnissen ausgeschlossen werden sollen. Im Standarddatensatz werden keine Kategorien verwendet. |

| Semantischen Ranker zum Abruf verwenden | Aktiviert den semantischen Rangfolger von Azure AI Search, ein Modell, das Suchergebnisse basierend auf der semantischen Ähnlichkeit mit der Abfrage des Benutzers rerankt. |

| Verwenden von semantischen Beschriftungen | Sendet semantische Beschriftungen statt des vollständigen Suchergebnisses an das LLM. Eine semantische Beschreibung wird während des Prozesses der semantischen Einstufung aus einem Suchergebnis extrahiert. |

| Vorschlagen von Nachverfolgungsfragen | Fordert die LLM auf, Nachverfolgungsfragen basierend auf der Abfrage des Benutzers vorzuschlagen. |

| Abrufmodus | Legt den Abrufmodus für die Azure AI Search-Abfrage fest. Die Standardaktion ist Vectors + Text (Hybrid), die eine Kombination aus Vektorsuche und Volltextsuche verwendet. Die Option "Vektoren" verwendet nur die Vektorsuche. Die Option "Text " verwendet nur die Volltextsuche. Der Hybridansatz ist optimal. |

| Chat-Abschlussantworten streamen | Streamt die Antwort kontinuierlich auf die Chat-Oberfläche, während der Inhalt erstellt wird. |

Die folgenden Schritte führen Sie durch den Prozess der Änderung der Einstellungen.

Wählen Sie im Browser die Option "Entwicklereinstellungen" aus.

Aktivieren Sie das Kontrollkästchen " Nachverfolgungsfragen vorschlagen ", um die Option zu aktivieren, und wählen Sie "Schließen " aus, um die Einstellungsänderung anzuwenden.

Formulieren Sie in der Chat-App die Frage erneut, indem Sie den Text in das Fragefeld eingeben.

What happens in a performance review?Die Chat-App-Antwort enthält jetzt vorgeschlagene Nachverfolgungsfragen:

Wählen Sie die Option Entwicklereinstellungen erneut aus und deaktivieren Sie die Option Semantikranger für das Abrufen verwenden. Schließen Sie die Einstellungen ab.

Stellen Sie die gleiche Frage erneut, und beachten Sie den Unterschied in der Antwort von der Chat-App.

Mit dem semantischen Rangierer: "Während einer Leistungsüberprüfung bei Contoso Electronics wird Ihr Vorgesetzter Ihre Leistung im vergangenen Jahr besprechen und Feedback zu Verbesserungsbereichen geben. Sie haben auch die Möglichkeit, Ihre Ziele und Ziele für das kommende Jahr zu besprechen. Die Überprüfung ist ein bidirektionaler Dialog zwischen Führungskräften und Mitarbeitern, und es wird ermutigt, dass die Mitarbeiter während des Prozesses ehrlich und offen sind (1). Das Feedback, das während der Überprüfung bereitgestellt wird, sollte positiv und konstruktiv sein, um mitarbeitern zu helfen, sich in ihren Rollen zu entwickeln und zu wachsen. Mitarbeiter erhalten eine schriftliche Zusammenfassung ihrer Leistungsüberprüfung, die eine Bewertung ihrer Leistung, ihres Feedbacks und ihrer Ziele für das kommende Jahr (1) enthält."

Ohne den semantischen Rangierer: "Während einer Leistungsüberprüfung bei Contoso Electronics wird Ihr Vorgesetzter Ihre Leistung im vergangenen Jahr besprechen und Feedback zu Verbesserungsbereichen geben. Es ist ein bidirektionaler Dialog, in dem Sie ermutigt werden, ehrlich und offen zu sein (1). Das feedback, das während der Überprüfung bereitgestellt wird, sollte positiv und konstruktiv sein, um Ihnen dabei zu helfen, sich in Ihrer Rolle zu entwickeln und zu wachsen. Sie erhalten eine schriftliche Zusammenfassung der Rezension, einschließlich einer Bewertung Ihrer Leistung, Ihres Feedbacks und der Ziele für das kommende Jahr (1)."

Bereinigen von Ressourcen

Nachdem Sie die Übung abgeschlossen haben, empfiehlt es sich, alle Ressourcen zu entfernen, die nicht mehr benötigt werden.

Bereinigen von Azure-Ressourcen

Die in diesem Artikel erstellten Azure-Ressourcen werden Ihrem Azure-Abonnement in Rechnung gestellt. Wenn Sie nicht erwarten, dass diese Ressourcen in Zukunft benötigt werden, löschen Sie sie, um weitere Gebühren zu vermeiden.

Löschen Sie die Azure-Ressourcen, und entfernen Sie den Quellcode, indem Sie den folgenden azd Befehl ausführen:

azd down --purge --force

Zu den Befehlsschaltern gehören:

-

purge: Gelöschte Ressourcen werden sofort gelöscht. Mit dieser Option können Sie die Azure OpenAI-Token pro Minute (TPM)-Metrik wiederverwenden. -

force: Der Löschvorgang erfolgt im Hintergrund, ohne dass die Einwilligung durch den Benutzer erforderlich ist.

Aufräumen von GitHub-Codespaces

Durch das Löschen der GitHub Codespaces-Umgebung wird sichergestellt, dass Sie die anzahl der kostenlosen Berechtigungen pro Kernstunden maximieren können, die Sie für Ihr Konto erhalten.

Wichtig

Weitere Informationen zu den Berechtigungen Ihres GitHub-Kontos finden Sie unter GitHub Codespaces – Monatlich enthaltene Speicher- und Kernstunden.

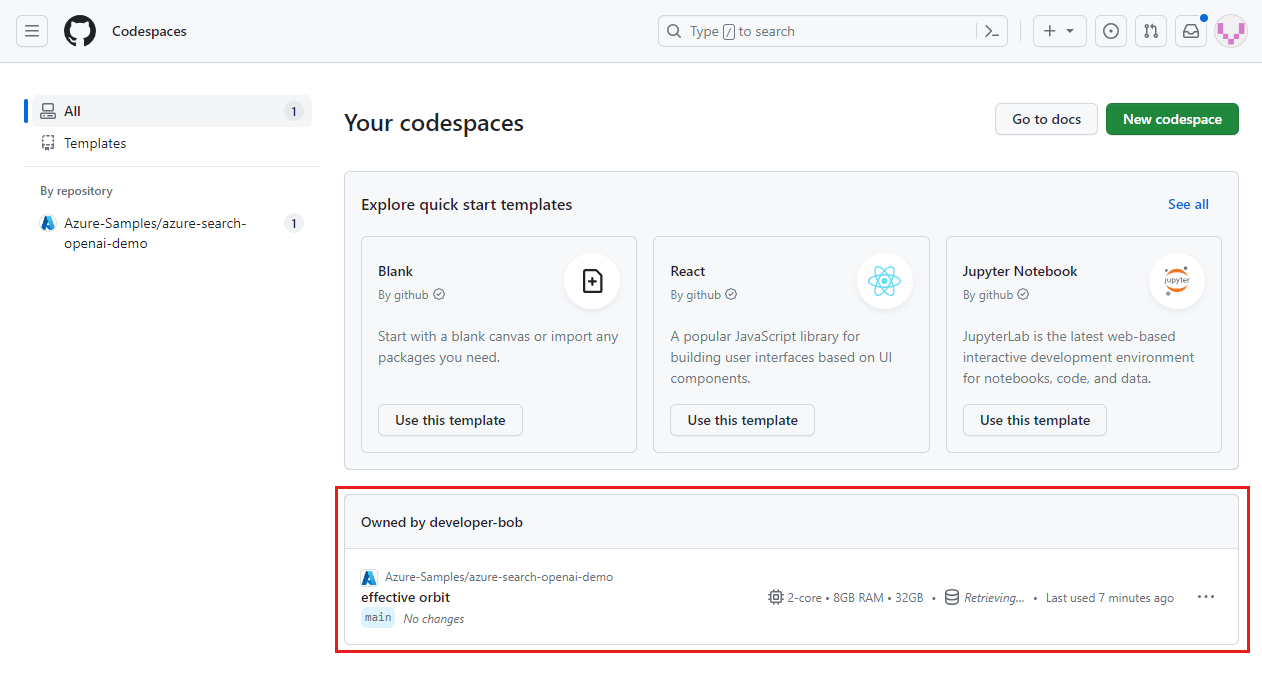

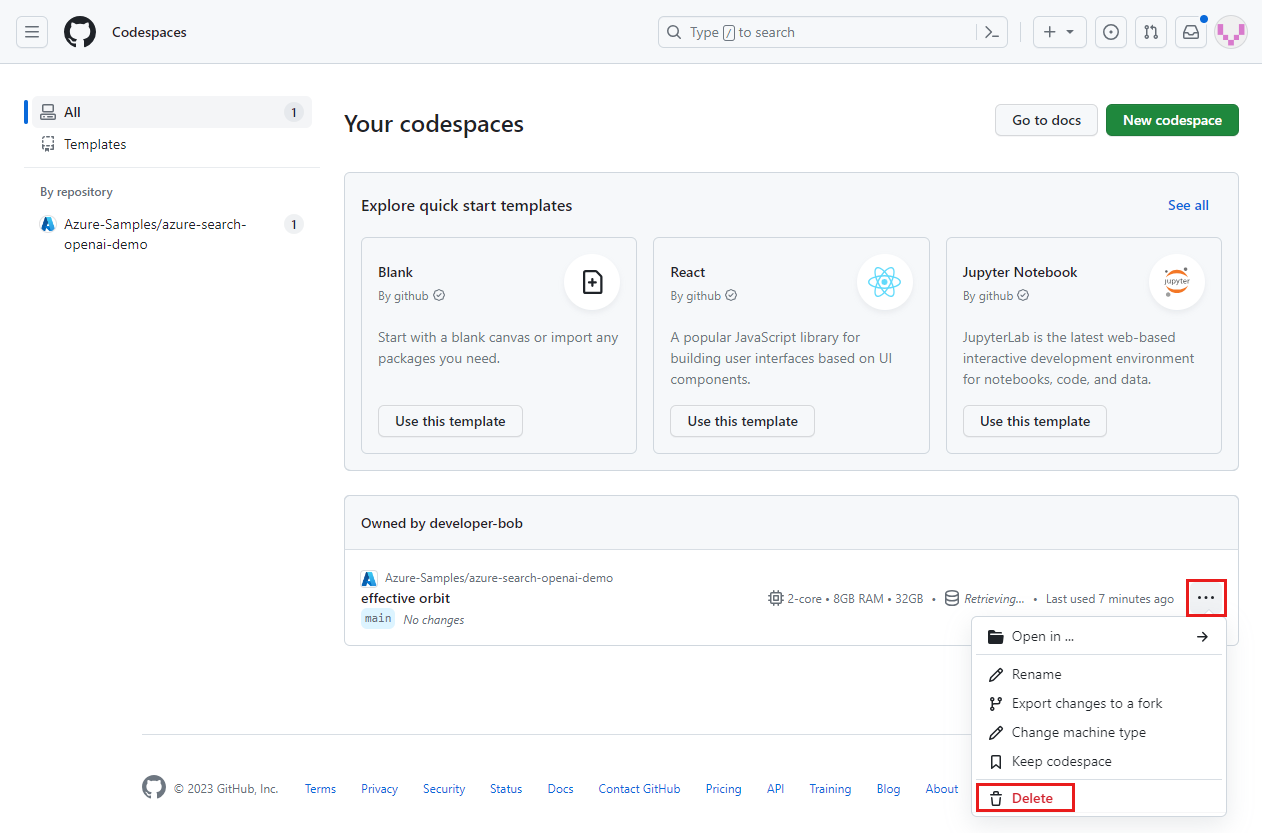

Melden Sie sich beim GitHub Codespaces-Dashboardan.

Suchen Sie auf dem Dashboard Ihre aktuell ausgeführten Codespaces, die aus dem

Azure-Samples/azure-search-openai-demoGitHub-Repository stammen:Öffnen Sie das Kontextmenü für den Codespace, und wählen Sie "Löschen" aus:

Hier erhalten Sie Hilfe

Dieses Beispiel-Repository bietet Informationen zur Problembehandlung.

Wenn Ihr Problem nicht behoben ist, fügen Sie Ihr Problem zur Webseite " Probleme " des Repositorys hinzu.

Verwandte Inhalte

- Holen Sie sich den Quellcode für das in diesem Artikel verwendete Beispiel

- Erstellen einer Chat-App mit Azure OpenAI Best Practice-Lösungsarchitektur

- Zugriffssteuerung in generativen KI-Apps mit Azure AI Search

- Erstellen einer unternehmensbereiten OpenAI-Lösung mit Azure API Management

- Leistungsstarke Vektorsuche mit hybriden Abruf- und Ranking-Fähigkeiten