Anmerkung

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen, dich anzumelden oder die Verzeichnisse zu wechseln.

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen , die Verzeichnisse zu wechseln.

Gilt für:✅ SQL-Analyseendpunkt und Warehouse in Microsoft Fabric

Dieses Lernprogramm ist eine schrittweise exemplarische Vorgehensweise eines End-to-End Data Warehouse-Szenarios von der Datenerfassung bis hin zum Datenverbrauch. Führen Sie dieses Lernprogramm aus, um ein grundlegendes Verständnis der Microsoft Fabric-Benutzeroberfläche, der verschiedenen Erfahrungen und ihrer Integrationspunkte sowie der Professionellen und Bürger-Entwicklererfahrungen von Microsoft Fabric zu erstellen.

Viele Konzepte in Microsoft Fabric sind Daten- und Analyseexpert*innen zwar bekannt, es kann jedoch schwierig sein, diese Konzepte in einer neuen Umgebung anzuwenden. Die Tutorials sind nicht als Referenzarchitektur, vollständige Liste von Features und Funktionen oder als Empfehlung bestimmter bewährter Methoden vorgesehen.

Umfassendes Data Warehouse-Szenario

Bevor Sie dieses Lernprogramm starten, führen Sie die folgenden Schritte aus:

- Melden Sie sich bei Ihrem Power BI-Onlinekonto an, oder wenn Sie kein Konto besitzen, registrieren Sie sich für eine kostenlose Testversion.

- Aktivieren Sie Microsoft Fabric in Ihrem Mandanten.

In diesem Lernprogramm übernehmen Sie die Rolle eines Warehouse-Entwicklers im fiktiven Unternehmen Wide World Importers . Sie implementieren eine End-to-End-Data Warehouse-Lösung:

- Einen Arbeitsbereich erstellen.

- Erstellen eines Warehouse

- Aufnehmen von Daten aus der Quelle in das dimensionale Data Warehouse-Modell mit einer Pipeline.

- Tabellen mit T-SQL in Ihrem Warehouse erstellen.

- Laden Sie Daten mit T-SQL mit dem SQL-Abfrage-Editor im Fabric-Portal.

- Klonen einer Tabelle mit T-SQL mit dem SQL-Abfrage-Editor.

- Transformieren von Daten mit einer gespeicherten Prozedur zum Erstellen aggregierter Datensätze.

- Zeitreise mit T-SQL, um Daten anzuzeigen, wie sie zu einem bestimmten Zeitpunkt erschienen.

- Erstellen einer Abfrage mit dem visuellen Abfrage-Editor zum Abrufen von Ergebnissen aus dem Data Warehouse

- Daten in einem Notizbuch analysieren.

- Erstellen und Ausführen einer warehouseübergreifenden Abfrage mit dem SQL-Abfrage-Editor

- Erstellen Sie ein DirectLake-Semantikmodell und einen Power BI-Bericht, um die Daten vor Ort zu analysieren.

- Generieren eines Berichts über den OneLake-Katalog

- Bereinigen von Tutorial-Ressourcen durch Löschen des Arbeitsbereichs und anderer Elemente

Umfassende Data Warehouse-Architektur

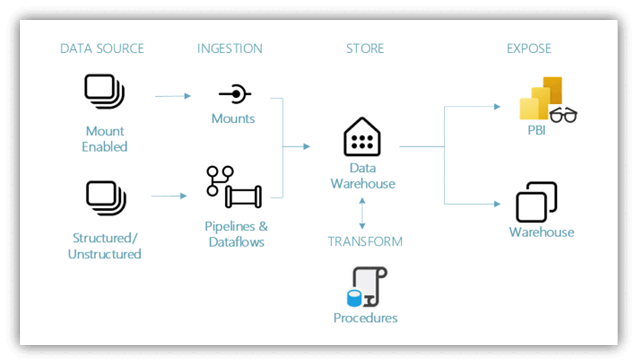

Datenquellen – Microsoft Fabric erleichtert und schnell eine Verbindung mit Azure Data Services, anderen Cloudplattformen und lokalen Datenquellen.

Erfassung: Mit mehr als 200 nativen Connectors als Teil der Microsoft Fabric-Pipeline und der Datentransformation per Drag-and-Drop-Vorgängen mit Dataflow können Sie schnell Erkenntnisse für Ihre Organisation erhalten. Mit dem neuen Verknüpfungsfeature in Microsoft Fabric können Sie eine Verbindung mit vorhandenen Daten herstellen, ohne dabei Daten kopieren oder verschieben zu müssen. Weitere Informationen zum Verknüpfungsfeature finden Sie weiter unten in diesem Tutorial.

Transformieren und Speichern: Microsoft Fabric standardisiert das Delta Lake-Format. Dies bedeutet, dass alle Engines von Microsoft Fabric dieselben in OneLake gespeicherten Daten lesen und bearbeiten können, sodass Daten nicht dupliziert werden müssen. Mit diesem Speicher können Sie ein Data Warehouse oder ein Data Mesh basierend auf den Anforderungen Ihrer Organisation erstellen. Für die Transformation können Sie entweder einen Low-Code- oder No-Code-Ansatz mit Pipelines bzw. Dataflows oder T-SQL für einen Code-First-Ansatz verwenden.

Nutzen Sie Power BI, das branchenführende Business Intelligence-Tool, um Daten aus dem Lager zu melden und zu visualisieren. Jedes Lager verfügt über einen integrierten TDS-Endpunkt zum Herstellen einer Verbindung mit und Abfragen von Daten aus anderen Berichterstellungstools bei Bedarf. In diesem Lernprogramm erstellen Sie ein semantisches Modell in Ihrem Beispiellager, um daten in einem Sternschema in nur wenigen Schritten zu visualisieren.

Beispieldaten

Für Beispieldaten wird die WWI-Beispieldatenbank (Wide World Importers) genutzt. Für das umfassende Data Warehouse-Szenario wurden genügend Daten generiert, um einen Einblick in die Skalierungs- und Leistungsfunktionen der Microsoft Fabric-Plattform zu erhalten.

Wide World Importers (WWI) ist ein Großhandelsimporteur von Neuheitsgütern mit Sitz im San Francisco Bay-Gebiet. WWI-Kunden sind hauptsächlich Unternehmen, die an Einzelpersonen weiterverkaufen. WWI verkauft auch Einzelhandelskunden in den VEREINIGTEN Staaten, wie Spezialgeschäfte, Supermärkte, Computergeschäfte, Touristenattraktionsgeschäfte und einige Einzelpersonen. WWI verkauft an andere Großhändler über ein Netzwerk von Agenten, die die Produkte für WWI bewerben. Weitere Informationen zu Unternehmensprofilen und -vorgängen finden Sie in den Beispieldatenbanken für Wide World Importers für Microsoft SQL.

In der Regel würden Sie Daten aus Transaktionssystemen (oder Branchenanwendungen) in einen Data Lake- oder Data Warehouse-Stagingbereich übertragen. In diesem Tutorial wird das von WWI bereitgestellte Dimensionsmodell als erste Datenquelle verwendet. Es wird als Quelle zum Erfassen der Daten in einem Data Warehouse und Transformieren der Daten über T-SQL verwendet.

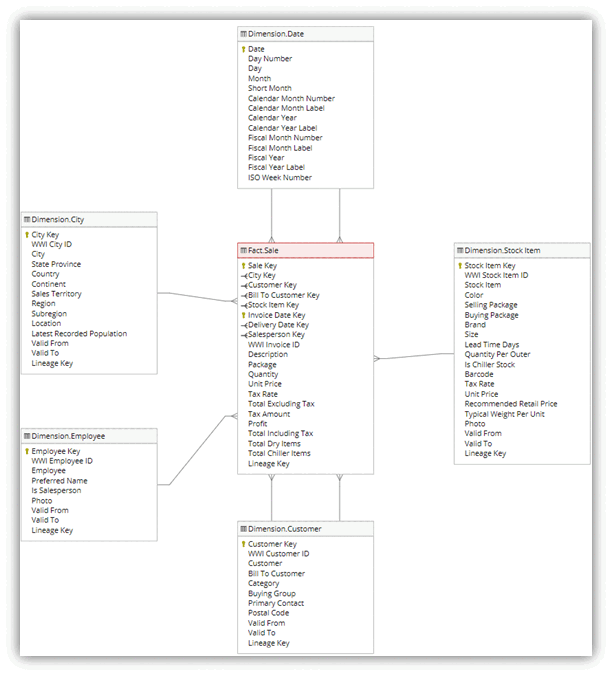

Datenmodell

Das WWI-dimensionale Modell verfügt über mehrere Faktentabellen in einem Sternschema. In diesem Lernprogramm konzentrieren Sie sich auf die fact_sale Tabelle und die zugehörigen Dimensionen , um ein End-to-End-Data Warehouse-Szenario zu veranschaulichen: