Einführung in instinktive Interaktionen

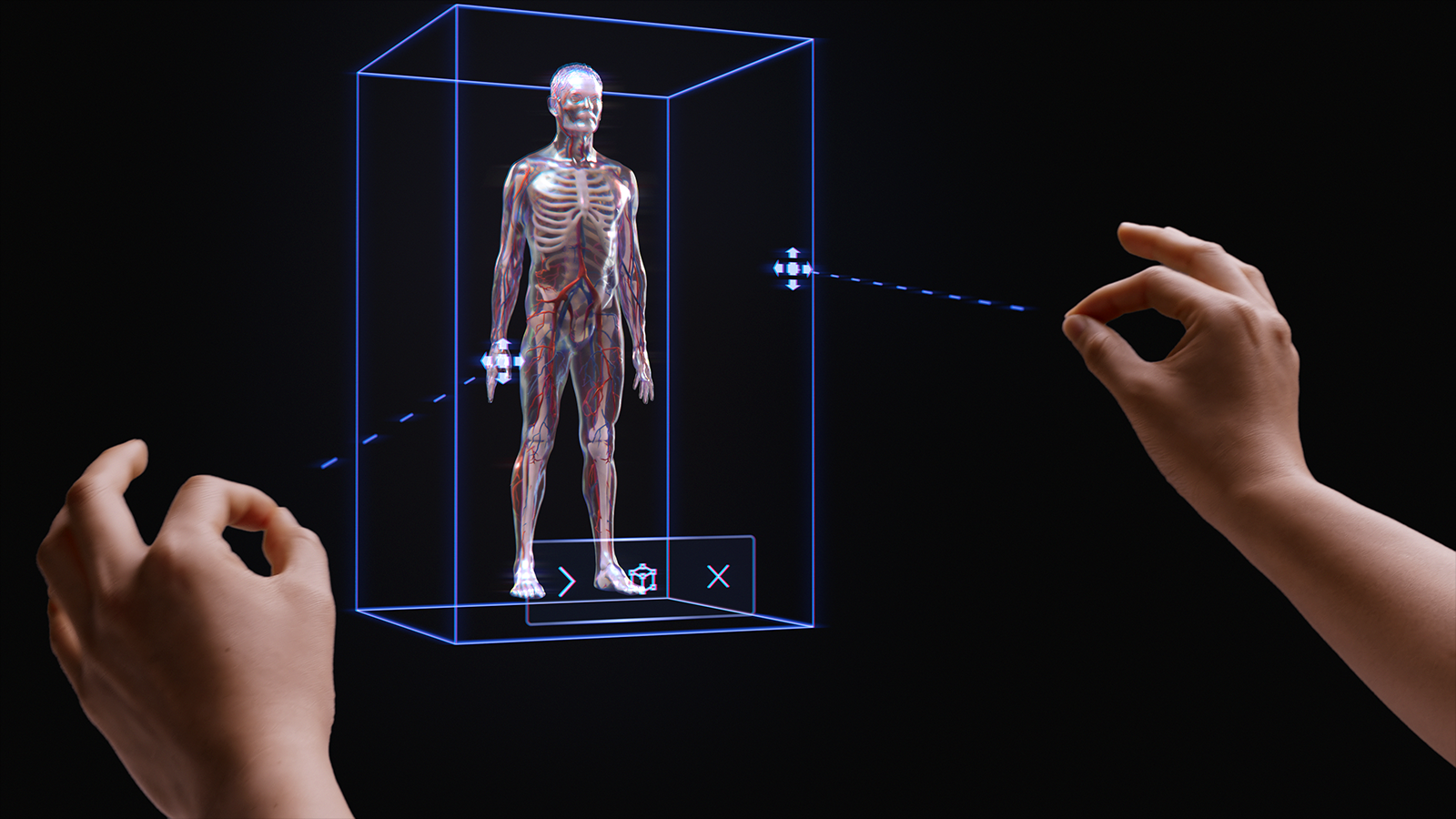

Die Philosophie der einfachen, instinktiven Interaktionen ist in der gesamten Mixed Reality-Plattform (MR) verwurzelt. Wir haben drei Schritte unternommen, um sicherzustellen, dass Anwendungsdesigner und -entwickler ihren Kunden einfache und intuitive Interaktionen bereitstellen können.

Zunächst haben wir dafür gesorgt, dass unsere Sensoren und Eingabetechnologien zu multimodalen Interaktionsmodellen kombiniert werden. Diese Interaktionsmodelle umfassen das Hand- und Eyetracking sowie Eingaben in natürlicher Sprache. Basierend auf unseren Studien ist das kombinierte Entwerfen und Entwickeln in einem multimodalen Framework – und nicht die Fokussierung auf einzelne Eingaben – der Schlüssel zur Realisierung instinktiver Erfahrungen.

Zweitens haben wir erkannt, dass viele Entwickler auf mehrere HoloLens-Geräte ausgerichtet sind, z. B. HoloLens 2 und HoloLens (1. Generation) oder HoloLens und VR. Deshalb haben wir unsere Interaktionsmodelle so konzipiert, dass sie geräteübergreifend funktionieren, auch wenn die Eingabetechnologie von Gerät zu Gerät variiert. So verwenden z. B. die ferne Interaktion bei einem Windows Immersive Headset mit einem 6DoF-Controller und HoloLens 2 jeweils dieselben Angebote und Muster. Dies erleichtert die geräteübergreifende Entwicklung und bietet Benutzerinteraktionen, die sich natürlich anfühlen.

Wir haben zwar erkannt, dass Mixed Reality (MR) Tausende von effektiven, ansprechenden und einzigartigen Interaktionen bietet, aber wir haben festgestellt, dass der bewusste Einsatz eines einzelnen umfassenden Interaktionsmodells in einer Anwendung der beste Weg ist, um sicherzustellen, dass Benutzer erfolgreich sind und ein großartiges Erlebnis haben. Zu diesem Zweck haben wir drei Punkte in diese Interaktionsanleitung einbezogen:

- Diese Anleitung um die drei primären Interaktionsmodelle und die für jedes einzelne Modell erforderlichen Komponenten und Muster.

- Zusätzliche Anleitungen zu weiteren Vorteilen, die unsere Plattform bietet.

- Allgemeine Anleitungen zur Auswahl des geeigneten Interaktionsmodells für Ihr Entwicklungsszenario.

Demo zu grundlegendem Handtracking und instinktiven Interaktionen

Sehen Sie sich unten unsere Videodemo Entwerfen von Hologrammen: Kopf- und Eyetracking an, und fahren Sie dann mit spezifischeren Themen fort:

Dieses Video stammt aus der HoloLens 2-App "Entwerfen von Hologrammen". Sie können das vollständige Erlebnis hier herunterladen und genießen.

Kombinierte Interaktionsmodelle

Ausgehend von unseren Studien und dem Feedback von Kunden haben wir festgestellt, dass drei primäre Interaktionsmodelle für die meisten Mixed Reality-Umgebungen geeignet sind. In vielerlei Hinsicht ist das Interaktionsmodell das mentale Modell des Benutzers zur Durchführung eines Workflows. Jedes dieser Interaktionsmodelle ist für eine Reihe von Kundenanforderungen optimiert und ist bei richtiger Anwendung benutzerfreundlich, leistungsstark und praktikabel.

Das folgende Diagramm stellt eine vereinfachte Übersicht dar. Ausführliche Informationen zur Verwendung der einzelnen Interaktionsmodelle sind auf den folgenden Seiten mit Bildern und Codebeispielen verknüpft.

| Modell | Beispielszenarien | Eignung | Hardware |

| Hände und Motion-Controller | 3D-Raumerlebnisse, z. B. räumliches Layout und räumlicher Entwurf, Inhaltsmanipulation oder Simulation. | Ideal für neue Benutzer, kombiniert mit Stimme, Eyetracking oder Anvisieren mit dem Kopf. Niedrige Lernkurve. Konsistente Benutzererfahrung für Handtracking und Controller mit 6 Freiheitsgraden. | HoloLens 2 Immersive Headsets |

| Freihändig | Kontextbezogene Erfahrungen, bei denen die Hände eines Benutzers beschäftigt sind, z. B. praxisnahes Lernen und Wartung. | Gewisser Lernaufwand erforderlich. Das Gerät ist gut für Stimme und natürliche Sprache geeignet, wenn die Hände nicht verfügbar sind. | HoloLens 2 HoloLens (1. Generation) Immersive Headsets |

| Anvisieren und Ausführen | Durchklickumgebungen, beispielsweise 3D-Präsentationen und Demos. | Erfordert Training für HMDs, aber nicht für mobile Geräte. Ideal für verfügbare Controller. Ideal für HoloLens (1. Generation). | HoloLens 2 HoloLens (1. Generation) Immersive Headsets Mobile AR |

Zum Vermeiden von Lücken in der erlebten Benutzerinteraktion besteht das beste Vorgehen darin, die Anleitung für ein bestimmtes Modell von Anfang bis Ende zu befolgen.

Die folgenden Abschnitte führen durch die Schritte zur Auswahl und Implementierung eines dieser Interaktionsmodelle.

Am Ende dieser Seite werden Sie unsere Anleitung zu Folgendem verstehen:

- Auswählen eines Interaktionsmodells für Ihren Kunden

- Implementieren des Interaktionsmodells

- Wechseln zwischen Interaktionsmodellen

- Entwerfen der nächsten Schritte

Auswählen eines Interaktionsmodells für Ihren Kunden

In der Regel haben Entwickler und Ersteller die Arten von Interaktionen, die Ihre Kunden ausführen können, bereits durchdacht. Um einen kundenorientierten Ansatz für den Entwurf zu fördern, empfehlen wir Ihnen die folgende Anleitung zur Auswahl des für Ihren Kunden optimierten Interaktionsmodells.

Gründe zum Befolgen dieser Anleitung

- Wir testen unsere Interaktionsmodelle nach objektiven und subjektiven Kriterien, wie physischer und kognitiver Leistung, Intuitivität und Erlernbarkeit.

- Da die Interaktion unterschiedlich verläuft, können sich auch die visuellen/akustischen Angebote sowie das Objektverhalten zwischen Interaktionsmodellen unterscheiden.

- Die Kombination von Komponenten verschiedener Interaktionsmodelle birgt das Risiko konkurrierender Angebote, z. B. simultane Handstrahlen und ein Cursor zum Anvisieren mit dem Kopf. Dies kann Benutzer überfordern und verwirren.

Hier folgen einige Beispiele dazu, wie Angebote und Verhaltensweisen für die einzelnen Interaktionsmodelle optimiert werden. Neue Benutzer haben häufig ähnliche Fragen, z. B. „Woher weiß ich, dass das System funktioniert?“ , „Woher weiß ich, über welche Möglichkeiten ich verfüge?“ und „Woher weiß ich, ob es verstanden hat, was ich gerade getan habe?“ .

| Modell | Woher weiß ich, dass es funktioniert? | Woher weiß ich, über welche Möglichkeiten ich verfüge? | Woher weiß ich, was ich gerade getan habe? |

| Hände und Motion-Controller | Ich sehe ein Handgittermodell, ein Fingerspitzenangebot oder Hand-/Controllerstrahlen. | Es werden greifbare Ziehpunkte oder ein Begrenzungsrahmen angezeigt, wenn die Hand sich in der Nähe des Objekts befindet. | Ich höre Töne und sehe Animationen beim Greifen und Loslassen. |

| Anvisieren mit dem Kopf und Ausführen | Ich sehe einen Cursor in der Mitte meines Sichtfelds. | Der Cursor wechselt den Zustand, wenn er sich über bestimmten Objekten befindet. | Ich sehe/höre beim Agieren visuelle und akustische Bestätigungen. |

| Freihändig (Anvisieren mit dem Kopf und Verweilen) | Ich sehe einen Cursor in der Mitte meines Sichtfelds. | Ich sehe eine Statusanzeige, wenn ich über einem interaktionsfähigen Objekt verweile. | Ich sehe/höre beim Agieren visuelle und akustische Bestätigungen. |

| Freihändig (Sprachbefehle) | Ich sehe eine Anzeige zur Spracherkennung und Untertitel, die zeigen, was das System gehört hat. | Ich erhalte Sprachansagen und Hinweise. Wenn ich Folgendes sage: Was kann ich sagen? Ich sehe ein Feedback. | Ich sehe/höre visuelle und akustische Bestätigungen, wenn ich einen Befehl erteile, oder erhalte bei Bedarf die Benutzerumgebung zur Mehrdeutigkeitsvermeidung. |

Nachfolgend sind Fragen aufgeführt, die Teams (gemäß unserer Erfahrung) bei der Auswahl eines Interaktionsmodells geholfen haben:

Q: Möchten meine Benutzer Hologramme berühren und präzise holografische Eingriffe durchführen?

A: In diesem Fall sollten Sie das Interaktionsmodell für Hände und Motion-Controller für die Präzisionszielbestimmung und für Eingriffe ausprobieren.Q: Müssen meine Benutzer für reale Aufgaben die Hände frei haben?

A: In diesem Fall sollten Sie sich das Interaktionsmodell „Freihändig“ ansehen, das durch blick- und sprachbasierte Interaktionen eine großartige freihändige Umgebung bietet.Q: Haben meine Benutzer Zeit, Interaktionen für meine MR-Anwendung zu erlernen, oder sind Interaktionen mit einer möglichst geringen Lernkurve erforderlich?

A: Wir empfehlen das Modell für Hände und Motion-Controller für die flachste Lernkurve und intuitivste Interaktion, sofern die Benutzer ihre Hände zur Interaktion nutzen können.Q: Verwenden meine Benutzer Motion-Controller zum Zeigen und Bearbeiten?

A: Das Modell für Hände und Motion-Controller enthält alle Anleitungen für ein großartiges Erlebnis mit den Motion-Controllern.Q: Verwenden meine Benutzer einen Controller für Barrierefreiheit oder einen herkömmlichen Bluetooth-Controller, z. B. ein Klick-Gerät?

A: Wir empfehlen das Modell „Anvisieren mit dem Kopf und Ausführen“ für alle nicht nachverfolgten Controller. Es wurde für Benutzer entwickelt, um ein ganzheitliches Erlebnis mit einem einfachen Mechanismus für „Anvisieren und Ausführen“ zu durchlaufen.Q: Können meine Benutzer in einer Umgebung nur durch „Durchklicken“ voranschreiten (z. B. wie bei einer 3D-Diashow), anstatt durch kompakte Layouts von Steuerelementen der Benutzeroberfläche zu navigieren?

A: Wenn Benutzer nicht viele Komponenten einer Benutzeroberfläche steuern müssen, bietet „Anvisieren mit dem Kopf und Ausführen“ eine erlernbare Option, bei der sich Benutzer nicht um die Zielbestimmung kümmern müssen.Q: Verwenden meine Benutzer sowohl HoloLens (1. Generation) als auch HoloLens 2/Immersive Windows Mixed Reality-Headsets (VR)?

A: Da „Anvisieren mit dem Kopf und Ausführen“ das Interaktionsmodell für HoloLens (1. Generation) ist, empfehlen wir Entwicklern, die HoloLens (1. Generation) unterstützen, „Anvisieren mit dem Kopf und Ausführen“ nur alle Features oder Modi zu verwenden, die Benutzer auf einem HoloLens-Headset (1. Generation) erleben können. Weitere Informationen zur Erstellung einer großartigen Umgebung für mehrere HoloLens-Generationen finden Sie unter Wechseln zwischen Interaktionsmodellen.Q: Wie sieht es mit mobilen Benutzern, die einen großen Raum abdecken oder sich zwischen verschiedenen Räumen bewegen, im Vergleich mit Benutzern aus, die dazu neigen, in einem einzelnen Raum zu arbeiten?

A: Für diese Benutzer ist jedes der Interaktionsmodelle geeignet.

Hinweis

Weitere Anleitungen zum App-Design sind bald verfügbar.

Wechseln zwischen Interaktionsmodellen

Es kann auch vorkommen, dass Ihre Anwendungsfälle die Verwendung mehrerer Interaktionsmodelle erfordern. Beim „Erstellungsablauf“ Ihrer Anwendung wird z. B. das Interaktionsmodell „Hände und Motion-Controller“ verwendet, aber Sie möchten einen Freihandmodus für Außendiensttechniker verwenden. Wenn Ihre Umgebung mehrere Interaktionsmodelle erfordert, haben die Benutzer möglicherweise Schwierigkeiten beim Übergang von einem Modell zum anderen, insbesondere, wenn sie noch nicht mit Mixed Reality vertraut sind.

Hinweis

Wir arbeiten ständig an weiteren Anleitungen, die Entwicklern und Designern zur Verfügung stehen werden und sie über das Wie, Wann und Warum für den Einsatz mehrerer MR-Interaktionsmodelle informieren sollen.