Modellkatalog und Sammlungen in Azure KI Studio

Wichtig

Einige der in diesem Artikel beschriebenen Features sind möglicherweise nur in der Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Der Modellkatalog in Azure KI Studio ist der Hub, um eine Vielzahl von Modellen zu entdecken und zu verwenden, mit denen Sie generative KI-Anwendungen erstellen können. Der Modellkatalog enthält Hunderte von Modellen von Modellanbietern wie Azure OpenAI Service, Mistral, Meta, Cohere, Nvidia und Hugging Face, darunter auch Modelle, die von Microsoft trainiert wurden. Modelle von anderen Anbietern als Microsoft sind Nicht-Microsoft-Produkte, wie in den Produktbedingungen von Microsoft definiert und unterliegen den mit dem Modell gelieferten Geschäftsbedingungen.

Modellsammlungen

Der Modellkatalog organisiert Modelle in Sammlungen. Im Modellkatalog gibt es drei Arten von Sammlungen:

- Von Azure KI kuratierte Modelle: Die beliebtesten Modelle mit offener Gewichtung und die proprietären Modelle von Drittanbietern, gepackt und optimiert für den nahtlosen Einsatz auf der Azure KI-Plattform. Die Verwendung dieser Modelle unterliegt den Lizenzbedingungen des Modellanbieters, die mit dem Modell geliefert werden. Bei der Bereitstellung in Azure KI Studio unterliegt die Verfügbarkeit des Modells der entsprechenden Azure-SLA, und Microsoft bietet Support für Bereitstellungsprobleme. Modelle von Partnern wie Meta, NVIDIA oder Mistral AI sind Beispiele für Modelle, die in der Sammlung „Kuratiert von Azure KI“ im Katalog zur Verfügung stehen. Diese Modelle können durch ein grünes Häkchen auf den Modellkacheln im Katalog identifiziert werden, oder Sie können nach der Sammlung „Kuratiert von Azure KI“ filtern.

- Azure OpenAI-Modelle, exklusiv verfügbar auf Azure: Azure OpenAI-Vorzeigemodelle über die Sammlung „Azure OpenAI“ durch eine Integration mit dem Azure OpenAI Service. Microsoft unterstützt diese Modelle und deren Verwendung gemäß den Produktbedingungen und dem SLA für Azure OpenAI Service.

- Offene Modelle aus dem Hugging Face-Hub: Hunderte von Modellen aus dem Hugging Face-Hub sind über die Sammlung „Hugging Face“ für Echtzeitrückschluss mit verwalteten Computeressourcen zugänglich. Hugging Face erstellt und unterhält Modelle, die in der Hugging Face-Sammlung aufgelistet sind. Verwenden Sie das HuggingFace-Forum oder den HuggingFace-Support, um Hilfe zu erhalten. Erfahren Sie mehr unter Bereitstellen offener Modelle .

Vorschlagen von Ergänzungen zum Modellkatalog: Sie können mithilfe dieses Formulars eine Anforderung senden, um dem Modellkatalog ein Modell hinzuzufügen.

Übersicht über die Funktionalitäten des Modellkatalogs

Informationen zu Azure OpenAI-Modellen finden Sie unter Azure OpenAI Service.

Einige Modelle in den Sammlungen Von Azure AI kuratiert und offene Modelle aus dem Hugging Face-Hub können mit einer verwalteten Computeoption bereitgestellt werden, und einige Modelle können mit serverlosen APIs mit nutzungsbasierter Abrechnung bereitgestellt werden. Diese Modelle können entdeckt, verglichen, ausgewertet, verfeinert (wenn unterstützt) und im großen Stil bereitgestellt und in Ihre generativen KI-Anwendungen mit Sicherheits- und Datengovernance auf Unternehmensniveau integriert werden.

- Entdecken: Überprüfen Sie Modellkarten, testen Sie Stichprobenrückschlüsse und durchsuchen Sie Codebeispiele, um das Modell auszuwerten, zu verfeinern oder bereitzustellen.

- Vergleichen: Vergleichen Sie Benchmarks zwischen den in der Branche verfügbaren Modellen und Datasets, um zu beurteilen, welches Modell Ihrem Geschäftsszenario entspricht.

- Auswerten: Werten Sie aus, ob das Modell für Ihre bestimmte Workload geeignet ist, indem Sie Ihre eigenen Testdaten bereitstellen. Auswertungsmetriken gestalten die Visualisierung einfach, wie gut das ausgewählte Modell in Ihrem Szenario funktioniert hat.

- Verfeinern: Passen Sie optimierbare Modelle mit Ihren eigenen Trainingsdaten an, und wählen Sie das beste Modell aus, indem Sie Metriken aus all Ihren Feinabstimmungsaufträgen vergleichen. Integrierte Optimierungen beschleunigen die Feinabstimmung und reduzieren den für die Feinabstimmung benötigten Arbeitsspeicher und die Compute-Ressourcen.

- Bereitstellen: Nahtloses Bereitstellen von vortrainierten oder verfeinerten Modellen für den Rückschluss. Modelle, die mit verwalteten Computeressourcen bereitgestellt werden können, können auch heruntergeladen werden.

Modellbereitstellung: Verwaltete Computeressourcen und serverlose API (nutzungsbasierte Bezahlung)

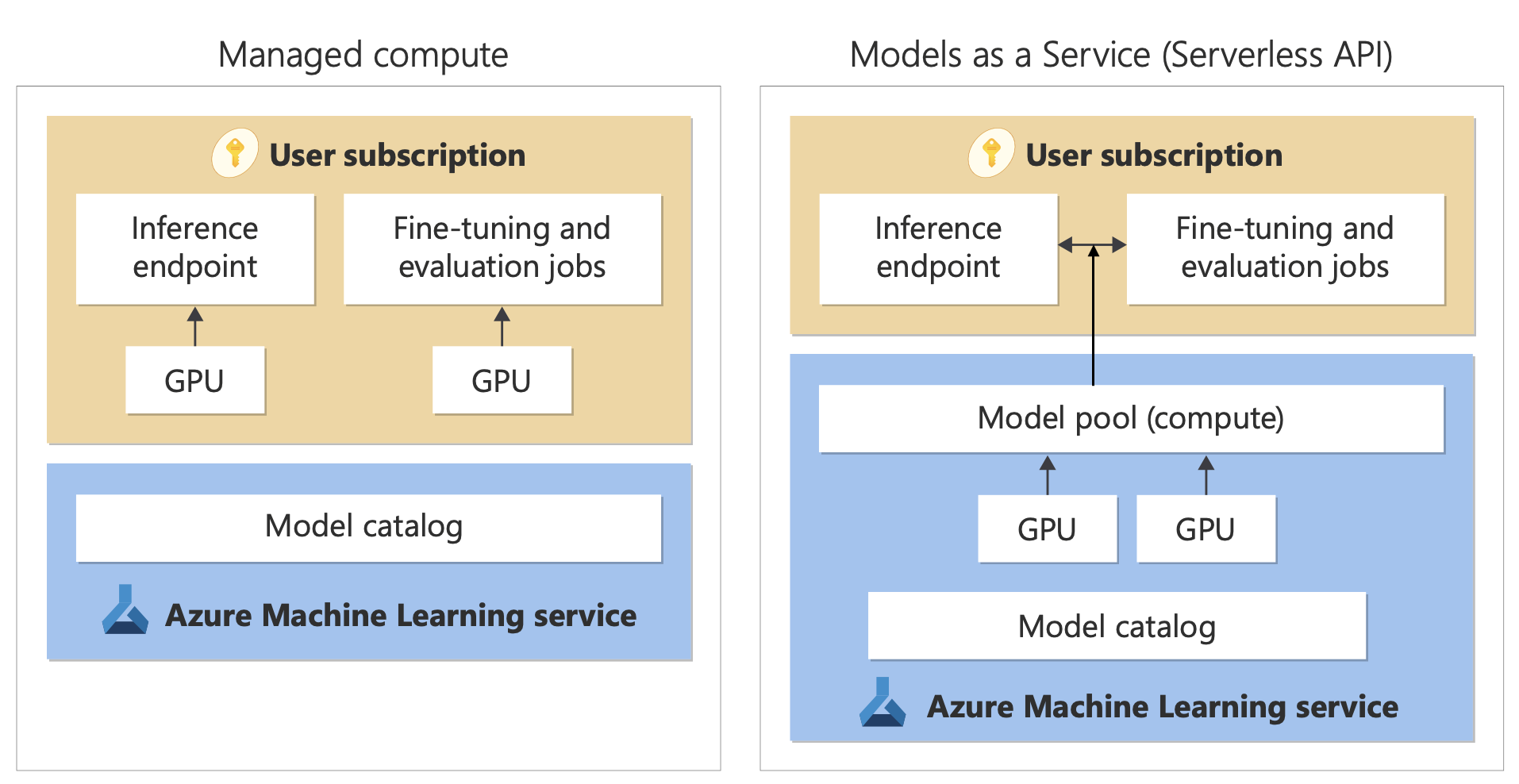

Der Modellkatalog bietet zwei unterschiedliche Möglichkeiten zum Bereitstellen von Modellen aus dem Katalog für Ihre Verwendung: verwaltete Computeressourcen und serverlose APIs. Die für jedes Modell verfügbaren Bereitstellungsoptionen variieren. Erfahren Sie in den folgenden Tabellen mehr über die Features der Bereitstellungsoptionen und die Optionen, die für bestimmte Modelle verfügbar sind. Erfahren Sie mehr über die Datenverarbeitung mit den Bereitstellungsoptionen.

| Features | Verwaltete Computeressourcen | Serverlose API (nutzungsbasierte Bezahlung) |

|---|---|---|

| Bereitstellungserfahrung und Abrechnung | Modellgewichtungen werden für dedizierte VMs mit verwalteten Onlineendpunkten bereitgestellt. Der verwaltete Onlineendpunkt, der über eine oder mehrere Bereitstellungen verfügen kann, stellt eine REST-API für den Rückschluss zur Verfügung. Ihnen werden die VM-Kernstunden in Rechnung gestellt, die von den Bereitstellungen verbraucht werden. | Der Zugriff auf Modelle erfolgt über eine Bereitstellung, die eine API für den Zugriff auf das Modell bereitstellt. Die API bietet Zugriff auf das von Microsoft gehostete und verwaltete Modell für den Rückschluss. Sie werden für Eingaben und Ausgaben an die APIs in Rechnung gestellt, in der Regel in Token. Preisinformationen werden vor der Bereitstellung bereitgestellt. |

| API-Authentifizierung | Schlüssel und Microsoft Entra ID-Authentifizierung. | Nur Schlüssel. |

| Inhaltssicherheit | Verwenden Sie APIs des Azure-Inhaltssicherheitsdiensts. | Azure KI Inhaltssicherheit-Filter sind integriert mit Rückschluss-APIs verfügbar. Azure KI Inhaltssicherheit-Filter können separat abgerechnet werden. |

| Netzwerkisolation | Konfigurieren von verwalteten Netzwerken für Azure KI Studio-Hubs. | Endpunkte folgen der Einstellung für den öffentlichen Netzwerkzugriff (Public Network Access, PNA) Ihres Hubs. Weitere Informationen finden Sie im Abschnitt Netzwerkisolation für Modelle, die über serverlose APIs bereitgestellt werden. |

| Modell | Verwaltete Computeressourcen | Serverlose API (nutzungsbasierte Bezahlung) |

|---|---|---|

| Modelle der Llama-Familie | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Modelle der Mistral-Familie | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large Mistral-small |

| Modelle der Cohere-Familie | Nicht verfügbar | Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

| JAIS | Nicht verfügbar | jais-30b-chat |

| Modelle der Phi3-Familien | Phi-3-small-128k-Instruct Phi-3-small-8k-Instruct Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi3-medium-128k-instruct Phi3-medium-4k-instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi3-medium-128k-instruct Phi3-medium-4k-instruct |

| Nixtla | Nicht verfügbar | TimeGEN-1 |

| Andere Modelle | Verfügbar | Nicht verfügbar |

Verwaltete Computeressourcen

Die Funktionalität, Modelle als verwaltete Computeressourcen bereitzustellen, baut auf Plattformfunktionen von Azure Machine Learning auf, um eine nahtlose Integration der umfangreichen Sammlung von Modellen im Modellkatalog über den gesamten LLMOps-Lebenszyklus hinweg zu ermöglichen.

Wie werden Modelle für die Bereitstellung als verwaltete Computeressource zur Verfügung gestellt?

Die Modelle werden über Azure Machine Learning-Registrierungen verfügbar gemacht, die den „ML zuerst“-Ansatz zum Hosten und Verteilen von Machine Learning-Ressourcen wie Modellgewichtungen, Containerlaufzeiten für die Ausführung der Modelle, Pipelines zum Auswerten und Verfeinern der Modelle und Datasets für Benchmarks und Stichproben ermöglichen. Diese ML-Registrierungen bauen auf einer hoch skalierbaren und unternehmensfähigen Infrastruktur auf, die Folgendes bietet:

Liefert Modellartefakte für den Zugriff mit geringer Wartezeit für alle Azure-Regionen mit integrierter Georeplikation.

Unterstützt Unternehmenssicherheitsanforderungen wie Zugriff auf Modelle mit Azure Policy einschränken und sichere Bereitstellung mit verwalteten virtuellen Netzwerken.

Bereitstellen von Modellen für Rückschlüsse mit verwalteten Computeressourcen

Modelle, die für die Bereitstellung für eine verwaltete Computeressource verfügbar sind, können für Azure Machine Learning Online-Endpunkte für den Echtzeitrückschluss bereitgestellt werden. Die Bereitstellung auf verwaltete Computeressourcen erfordert, dass Sie in Ihrem Azure-Abonnement über eine Quote für virtuelle Maschinen für die spezifischen SKUs verfügen, die für die optimale Ausführung des Modells erforderlich sind. Einige Modelle ermöglichen Ihnen die Bereitstellung im vorübergehend freigegebenen Kontingent zum Testen des Modells. Weitere Informationen zum Bereitstellen von Modellen:

- Bereitstellen von Meta-Llama-Modellen

- Bereitstellen von offenen Modellen, die von Azure KI erstellt wurden

Erstellen von generativen KI-Apps mit verwalteten Computeressourcen

Der Prompt Flow bietet eine großartige Erfahrung für die Prototyperstellung. Sie können Modelle verwenden, die mit verwalteten Computeressourcen in Prompt Flow mit dem Open Model LLM Tool bereitgestellt werden. Sie können auch die REST-API verwenden, die von den verwalteten Computeressourcen in beliebten LLM-Tools wie LangChain mit der Azure Machine Learning-Erweiterung verfügbar gemacht wird.

Inhaltssicherheit für Modelle, die als verwaltete Computeressourcen bereitgestellt werden

Der Dienst Azure KI Inhaltssicherheit steht für die Verwendung mit verwalteten Computeressourcen zur Verfügung, um auf verschiedene Kategorien schädlicher Inhalte wie sexuelle Inhalte, Gewalt, Hass und Selbstverletzung sowie fortgeschrittene Bedrohungen wie Erkennung von Jailbreak-Risiken und die Erkennung von Text mit geschütztem Material zu überprüfen. Sie können für die Referenzintegration mit AACS für Llama 2 auf dieses Notebook verweisen, oder das Tool für die Inhaltssicherheit (Text) in Prompt Flow verwenden, um Antworten vom Modell an AACS zur Überprüfung zu übergeben. Diese Nutzung wird Ihnen gemäß den AACS-Preisen separat in Rechnung gestellt.

Serverlose APIs mit nutzungsbasierter Abrechnung

Bestimmte Modelle im Modellkatalog können als serverlose APIs mit nutzungsbasierter Abrechnung bereitgestellt werden und bieten eine Möglichkeit, sie als API zu nutzen, ohne sie in Ihrem Abonnement zu hosten. Modelle werden in von Microsoft verwalteter Infrastruktur gehostet, wodurch API-basierter Zugriff auf das Modell des Modellanbieters ermöglicht wird. Der API-basierte Zugriff kann die Kosten für den Zugriff auf ein Modell dramatisch reduzieren und die Bereitstellungserfahrung erheblich vereinfachen.

Modelle, die für die Bereitstellung als serverlose APIs mit nutzungsbasierter Abrechnung verfügbar sind, werden vom Modellanbieter angeboten, aber in der von Microsoft verwalteten Azure-Infrastruktur gehostet und über eine API zugänglich gemacht. Modellanbieter definieren die Lizenzbedingungen und legen den Preis für die Verwendung ihrer Modelle fest, während Azure Machine Learning Service die Hostinginfrastruktur verwaltet, die Rückschluss-APIs verfügbar macht und als Datenverarbeiter für übermittelte Prompts und Inhaltsausgaben von über MaaS bereitgestellten Modellen fungiert. Weitere Informationen zur Datenverarbeitung für MaaS finden Sie im Artikel Datenschutz.

Abrechnung

Die Erfahrung für Ermittlung, Abonnement und Verbrauch für Modelle, die über MaaS bereitgestellt werden, befindet sich im Azure KI Studio und im Azure Machine Learning Studio. Benutzer akzeptieren Lizenzbedingungen für die Verwendung der Modelle, und Preisinformationen für den Verbrauch werden während der Bereitstellung bereitgestellt. Modelle von Drittanbietern werden über Azure Marketplace gemäß den Nutzungsbedingungen des Commercial Marketplace in Rechnung gestellt. Modelle von Microsoft werden mit Azure-Verbrauchseinheiten als Erstanbieter-Verbrauchsdienste in Rechnung gestellt. Wie in den Produktbedingungen beschrieben, werden Erstanbieter-Verbrauchsdienste mit Azure-Verbrauchseinheiten erworben, unterliegen jedoch nicht den Azure-Dienstbedingungen. Die Verwendung dieser Modelle unterliegt den bereitgestellten Lizenzbedingungen.

Feinabstimmung von Modellen

Bestimmte Modelle unterstützen auch die serverlose Feinabstimmung, wo Benutzer die Hosting-Feinabstimmung mit Abrechnung über nutzungsbasierte Bezahlung nutzen können, um die Modelle mithilfe von Daten anzupassen, die sie bereitstellen. Weitere Informationen finden Sie in der Feinabstimmungsübersicht.

RAG mit Modellen, die als serverlose APIs bereitgestellt werden

Azure KI Studio ermöglicht Benutzern die Verwendung von Vektorindizes und Retrieval Augmented Generation. Modelle, die über serverlose APIs bereitgestellt werden können, können verwendet werden, um Einbettungen und Rückschluss basierend auf benutzerdefinierten Daten zu generieren, um spezifische Antworten für ihren Anwendungsfall zu generieren. Weitere Informationen finden Sie unter Erstellen eines Vektorindexes.

Regionale Verfügbarkeit von Angeboten und Modellen

Die nutzungsbasierte Abrechnung ist nur für Benutzer verfügbar, deren Azure-Abonnement zu einem Abrechnungskonto in einem Land gehört, in dem der Modellanbieter das Angebot verfügbar gemacht hat (siehe „Verfügbarkeitsregion des Angebots“ in der Tabelle im nächsten Abschnitt). Wenn das Angebot in der relevanten Region verfügbar ist, muss der Benutzer über einen Hub/ein Projekt in der Azure-Region verfügen, in der das Modell je nach Bedarf für die Bereitstellung oder Feinabstimmung verfügbar ist (siehe Spalten „Hub-/Projektregion“ in der nachstehenden Tabelle).

| Modell | Verfügbarkeitsregion für Angebot | Hub-/Projektregion für die Bereitstellung | Hub./Projektregion für Feinabstimmung |

|---|---|---|---|

| Llama-3-70B-Instruct Llama-3-8B-Instruct |

Von Microsoft verwaltete Länder | USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; Schweden, Mitte; USA, Westen; USA, Westen 3 | Nicht verfügbar |

| Llama-2-7b Llama-2-13b Llama-2-70b |

Von Microsoft verwaltete Länder | USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; USA, Westen; USA, Westen 3 | USA, Westen 3 |

| Llama-2-7b-chat Llama-2-13b-chat Llama-2-70b-chat |

Von Microsoft verwaltete Länder | USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; USA, Westen; USA, Westen 3, | Nicht verfügbar |

| Mistral Small | Von Microsoft verwaltete Länder | USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; Schweden, Mitte; USA, Westen; USA, Westen 3 | Nicht verfügbar |

| Mistral-Large | Von Microsoft verwaltete Länder Brasilien Hongkong Israel |

USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; Schweden, Mitte; USA, Westen; USA, Westen 3 | Nicht verfügbar |

| Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

Von Microsoft verwaltete Länder Japan |

USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; Schweden, Mitte; USA, Westen; USA, Westen 3 | Nicht verfügbar |

| TimeGEN-1 | Von Microsoft verwaltete Länder Mexiko Israel |

USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; Schweden, Mitte; USA, Westen; USA, Westen 3 | Nicht verfügbar |

| jais-30b-chat | Von Microsoft verwaltete Länder | USA, Osten; USA, Osten 2; USA, Norden-Mitte; USA, Süden-Mitte; Schweden, Mitte; USA, Westen; USA, Westen 3 | Nicht verfügbar |

| Phi-3-mini-4k-instruct | Von Microsoft verwaltete Länder | USA, Osten 2; Kanada, Mitte; Schweden, Mitte; USA, Westen 3 | Nicht verfügbar |

| Phi-3-mini-128k-instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct |

Von Microsoft verwaltete Länder | „USA, Osten 2“, „Schweden, Mitte“ | Nicht verfügbar |

Inhaltssicherheit für Modelle, die über die serverlose APIs bereitgestellt werden

Wichtig

Einige der in diesem Artikel beschriebenen Features sind möglicherweise nur in der Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Für Sprachmodelle, die über serverlose APIs bereitgestellt werden, implementiert Azure KI eine Standardkonfiguration für Textmoderationsfilter von Azure KI Inhaltssicherheit, welche schädliche Inhalte wie Hass, Selbstverletzung, sexuelle und gewalttätige Inhalte entdecken. Weitere Informationen zur Inhaltsfilterung (Vorschau) finden Sie unter Schadenkategorien in Azure KI Inhaltssicherheit.

Tipp

Die Inhaltsfilterung (Vorschau) ist für bestimmte Modelltypen, die über serverlose APIs bereitgestellt werden, nicht verfügbar. Zu diesen Modelltypen gehören Einbettungsmodelle und Zeitreihenmodelle.

Die Inhaltsfilterung (Vorschau) erfolgt synchron, während der Dienst die Prompts zum Generieren von Inhalten verarbeitet, und Sie werden möglicherweise separat gemäß den AACS-Preisen für diese Nutzung in Rechnung gestellt. Sie können die Inhaltsfilterung (Vorschau) für einzelne serverlose Endpunkte entweder zum Zeitpunkt der ersten Bereitstellung eines Sprachmodells oder später deaktivieren, oder auf der Seite mit den Bereitstellungsdetails, indem Sie die Umschaltfläche für die Inhaltsfilterung auswählen.

Angenommen, Sie entscheiden sich für die Verwendung einer anderen API als der Azure KI Model Inference-API, um mit einem Modell zu arbeiten, das über eine serverlose API bereitgestellt wird. In einer solchen Situation ist die Inhaltsfilterung (Vorschau) nicht aktiviert, es sei denn, Sie implementieren sie separat mithilfe von Azure KI Inhaltssicherheit. Weitere Informationen zu den ersten Schritten mit Azure KI Inhaltssicherheit finden Sie in der Schnellstartanleitung: Analysieren von Textinhalten. Wenn Sie beim Arbeiten mit Modellen, die über serverlose APIs bereitgestellt werden, keine Inhaltsfilterung (Vorschau) verwenden, besteht ein höheres Risiko, dass Benutzer schädlichen Inhalten ausgesetzt werden.

Netzwerkisolation für Modelle, die über serverlose APIs bereitgestellt werden

Endpunkte für Modelle, die als serverlose APIs bereitgestellt werden, folgen der PNA-Kennzeichnungseinstellung (Public Network Access) des KI Studio Hub mit dem Projekt, in dem die Bereitstellung vorhanden ist. Um Ihren MaaS-Endpunkt zu sichern, deaktivieren Sie das PNA-Flag auf Ihrem KI Studio Hub. Sie können eingehende Kommunikation von einem Client zu Ihrem Endpunkt sichern, indem Sie einen privaten Endpunkt für den Hub verwenden.

So legen Sie das PNA-Flag für den Azure KI-Hub fest:

- Navigieren Sie zum Azure-Portal.

- Suchen Sie nach der Ressourcengruppe, zu welcher der Hub gehört, und wählen Sie Ihren Azure KI-Hub aus den Ressourcen aus, die für diese Ressourcengruppe aufgeführt sind.

- Verwenden Sie auf der Seite „Hubübersicht“ den linken Navigationsbereich, um zu Einstellungen>Netzwerk zu wechseln.

- Auf der Registerkarte Öffentlicher Zugriff können Sie Einstellungen für das Flag für den Zugriff auf das öffentliche Netzwerk konfigurieren.

- Speichern Sie die Änderungen. Es kann bis zu fünf Minuten dauern, bis Ihre Änderungen verteilt sind.

Begrenzungen

- Wenn Sie einen KI Studio-Hub mit einem privaten Endpunkt haben, der vor dem 11. Juli 2024 erstellt wurde, folgen neue MaaS-Endpunkte, die zu Projekten in diesem Hub hinzugefügt wurden, nicht der Netzwerkkonfiguration des Hubs. Stattdessen müssen Sie einen neuen privaten Endpunkt für den Hub erstellen und neue serverlose API-Bereitstellungen im Projekt erstellen, damit die neuen Bereitstellungen der Netzwerkkonfiguration des Hubs folgen können.

- Wenn Sie einen KI Studio-Hub mit MaaS-Bereitstellungen haben, die vor dem 11. Juli 2024 erstellt wurden und Sie einen privaten Endpunkt auf diesem Hub aktivieren, folgen die vorhandenen MaaS-Bereitstellungen nicht der Netzwerkkonfiguration des Hubs. Damit serverlose API-Bereitstellungen im Hub der Netzwerkkonfiguration des Hubs folgen können, müssen Sie die Bereitstellungen erneut erstellen.

- Derzeit ist Unterstützung für Ihre Daten für MaaS-Bereitstellungen in privaten Hubs nicht verfügbar, da private Hubs das PNA-Flag deaktiviert haben.

- Jede Netzwerkkonfigurationsänderung (z. B. das Aktivieren oder Deaktivieren des PNA-Flags) kann bis zu fünf Minuten dauern, bis sie verteilt sind.

Nächster Schritt

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Tickets als Feedbackmechanismus für Inhalte auslaufen lassen und es durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter: https://aka.ms/ContentUserFeedback.

Einreichen und Feedback anzeigen für