Dieser Artikel bietet eine Übersicht über die im Azure Architecture Center beschriebenen Azure-Datenbanklösungen.

Apache®, Apache Cassandra® und das Hadoop-Logo sind entweder eingetragene Marken oder Marken der Apache Software Foundation in den Vereinigten Staaten und/oder anderen Ländern. Die Verwendung dieser Markierungen impliziert kein Endorsement durch die Apache Software Foundation.

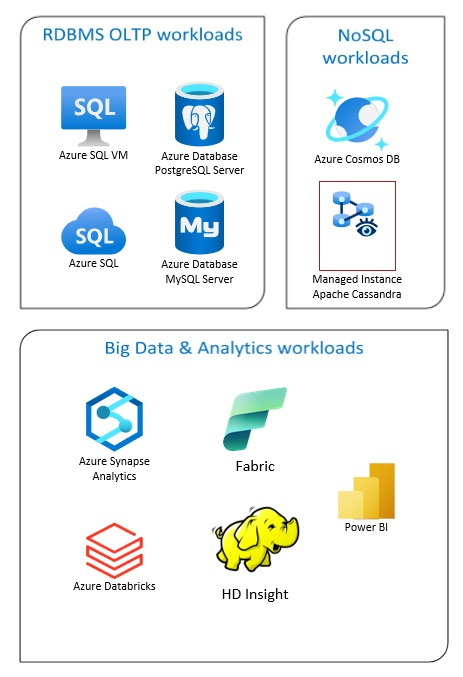

Azure-Datenbanklösungen umfassen herkömmliche Lösungen für Managementsystem für relationale Datenbanken (RDBMS und OLTP), Big Data- und Analytics-Workloads (einschließlich OLAP) und NoSQL-Workloads.

Zu RDBMS-Workloads zählen OLTP (Online Transaction Processing, Onlinetransaktionsverarbeitung) und OLAP (Online Analytical Processing, analytische Onlineverarbeitung). Daten aus mehreren Quellen in der Organisation können in einem Data Warehouse konsolidiert werden. Sie können einen Extraktions-, Transformations- und Ladeprozess (ETL) oder einen Extraktions-, Lade- und Transformationsprozess (ELT) verwenden, um die Quelldaten zu verschieben und zu transformieren. Weitere Informationen zu RDBMS-Datenbanken finden Sie unter Erkunden relationaler Datenbanken in Azure".

Eine Big Data-Architektur ist für die Erfassung, Verarbeitung und Analyse umfangreicher oder komplexer Daten konzipiert. Zu Big Data-Lösungen gehören in der Regel große Mengen nicht relationaler Daten, für deren Speicherung herkömmliche RDBMS-Systeme nicht gut geeignet sind. Hierzu gehören in der Regel Lösungen wie Data Lakes, Delta Lakes und Lakehouses. Weitere Informationen finden Sie unter Entwurf der Analysearchitektur.

NoSQL-Datenbanken werden austauschbar als nonrelational, NoSQL Dbs oder non-SQL bezeichnet, um hervorzuheben, dass sie große Mengen sich schnell ändernder, unstrukturierter Daten verarbeiten können. Sie speichern die Daten nicht in Tabellen, Zeilen und Spalten wie (SQL-)Datenbanken. Weitere Informationen über No-SQL-DBs-Datenbanken finden Sie unter NoSQL-Daten und Was sind NoSQL-Datenbanken?.

Dieser Artikel bietet Ressourcen, um mehr über Azure-Datenbanken zu erfahren. Es werden Wege zur Implementierung von Architekturen aufgezeigt, die Ihren Anforderungen entsprechen, sowie bewährte Verfahren, die Sie bei der Entwicklung Ihrer Lösungen berücksichtigen sollten.

Es gibt viele Architekturen, aus denen Sie wählen können, um Ihre Datenbankanforderungen zu erfüllen. Außerdem stellen wir Lösungsvorschläge vor, auf denen Sie aufbauen können, einschließlich Links zu allen Komponenten, die Sie benötigen.

Informationen zu Datenbanken in Azure

Wenn Sie damit beginnen, sich Überlegungen zu möglichen Architekturen für Ihre Lösung zu machen, ist es wichtig, dass Sie den richtigen Datenspeicher auswählen. Wenn Datenbanken in Azure für Sie neu ist, ist Microsoft Learn der beste Ausgangspunkt. Auf dieser kostenlosen Onlineplattform finden Sie Videos und Tutorials zum praxisbezogenen Lernen. Microsoft Learn bietet Lernpfade, die auf Ihrer Position basieren, z. B. für Entwickler oder Datenanalysten.

Sie können mit einer allgemeinen Beschreibung der verschiedenen Datenbanken in Azure und deren Verwendung beginnen. Sie können auch Azure-Datenmodule und durchsuchen. Wählen Sie einen Datenspeicheransatz in Azure. Diese Artikel helfen Ihnen dabei, Ihre Auswahl an Azure-Datenlösungen zu verstehen und erfahren, warum einige Lösungen in bestimmten Szenarien empfohlen werden.

Im Folgenden finden Sie einige Learn-Module, die ggf. nützlich für Sie sind:

- Entwerfen der Migration zu Azure

- Bereitstellen von Azure SQL-Datenbank

- Einführung in Azure-Datenbank- und Analysedienste

- Schützen von Azure SQL-Datenbank

- Azure Cosmos DB

- Azure-Datenbank für PostgreSQL

- Azure Database for MySQL

- SQL Server auf Azure VMs

Pfad zur Produktion

Wenn Sie Optionen für den Umgang mit relationalen Daten suchen, sollten Sie sich diese Ressourcen ansehen:

- Informationen über Ressourcen zum Erfassen von Daten aus mehreren Quellen und zum Anwenden von Datentransformationen innerhalb der Datenpipelines finden Sie unter Analysen in Azure.

- Informationen über OLAP, das große Unternehmensdatenbanken organisiert und komplexe Analysen unterstützt, finden Sie unter Online Analytical Processing.

- Informationen über OLTP-Systeme, die geschäftliche Interaktionen aufzeichnen, finden Sie unter Online Transaction Processing.

Eine nicht-relationale Datenbank verwendet nicht das tabellarische Schema von Zeilen und Spalten. Weitere Informationen finden Sie unter Nichtrelationale Daten und NoSQL.

Informationen zu Data Lakes, die eine große Datenmenge im nativen Rohformat enthalten, finden Sie unter Data Lakes.

Eine Big Data-Architektur kann Daten erfassen, verarbeiten und analysieren, die für herkömmliche Datenbanksysteme zu umfangreich oder zu komplex sind. Weitere Informationen finden Sie unter Big Data-Architekturen und Analytics.

Eine Hybrid Cloud ist eine IT-Umgebung, in der öffentliche Clouds und lokale Rechenzentren kombiniert werden. Weitere Informationen finden Sie unter Erweitern lokaler Datenlösungen auf die Cloud oder ziehen Sie Azure Arc in Verbindung mit Azure-Datenbanken in Erwägung.

Azure Cosmos DB ist ein vollständig verwalteter NoSQL-Datenbankdienst für die moderne App-Entwicklung. Weitere Informationen finden Sie unter Ressourcenmodell für Azure Cosmos DB.

Informationen zu den Optionen zum Übertragen von Daten in und aus Azure finden Sie unter Übertragen von Daten in und aus Azure.

Bewährte Methoden

Prüfen Sie diese bewährten Methoden beim Entwerfen Ihrer Lösungen.

| Bewährte Methoden | Beschreibung |

|---|---|

| Datenverwaltungsmuster | Die Datenverwaltung ist das Schlüsselelement von Cloudanwendungen, das die meisten Qualitätsattribute beeinflusst. |

| Transaktionsausgangsmuster mit Azure Cosmos DB | Erfahren Sie, wie Sie das Transactional Outbox-Muster für zuverlässiges Messaging und garantierte Übermittlung von Ereignissen verwenden. |

| Globales Verteilen Ihrer Daten mit Azure Cosmos DB | Um geringe Latenz und Hochverfügbarkeit zu erreichen, müssen einige Anwendungen in Rechenzentren bereitgestellt werden, die sich in der Nähe ihrer Benutzer befinden. |

| Sicherheit bei Azure Cosmos DB | Bewährte Sicherheitsmethoden helfen dabei, Sicherheitsverletzungen bei Datenbanken zu verhindern, zu erkennen und darauf zu reagieren. |

| Fortlaufende Sicherung mit der Zeitpunktwiederherstellung von Azure Cosmos DB | Erfahren Sie mehr über das Feature der Zeitpunktwiederherstellung von Azure Cosmos DB. |

| Realisieren von Hochverfügbarkeit mit Azure Cosmos DB | Azure Cosmos DB bietet mehrere Features und Konfigurationsoptionen, um Hochverfügbarkeit zu erzielen. |

| Hochverfügbarkeit für Azure SQL-Datenbank und SQL Managed Instance | Die Datenbank darf kein Single Point of Failure in Ihrer Architektur sein. |

Auswahl der Technologie

Es gibt viele Optionen für Technologien, die Sie mit Azure-Datenbanken verwenden können. Diese Artikel helfen Ihnen bei der Wahl der besten Technologien für Ihre Anforderungen.

- Auswählen eines Datenspeichers

- Auswählen eines Analysedatenspeichers in Azure

- Auswählen einer Technologie für die Datenanalyse in Azure

- Auswählen einer Batchverarbeitungstechnologie in Azure

- Auswählen einer Big Data-Speichertechnologie in Azure

- Auswählen einer Technologie für die Datenpipelineorchestrierung in Azure

- Auswählen eines Suchdatenspeichers in Azure

- Auswählen einer Technologie für die Datenstromverarbeitung in Azure

Bei Datenbanken auf dem Laufenden bleiben

Unter Azure-Updates erfahren Sie, wie Sie über die Azure-Datenbanktechnologie auf dem Laufenden bleiben.

Zugehörige Ressourcen

- Adatum Corporation-Szenario für Datenverwaltung und -analysen in Azure

- Lamna Healthcare-Szenario für Datenverwaltung und -analysen in Azure

- Optimieren der Verwaltung von SQL Server-Instanzen

- Relecloud-Szenario für Datenverwaltung und -analysen in Azure

Beispiellösungen

Diese Lösungsvorschläge sind einige beispielhafte Ansätze, die Sie an Ihre Anforderungen anpassen können.

Ähnliche Datenbankprodukte

Wenn Sie mit Amazon Web Services (AWS) oder Google Cloud vertraut sind, sehen Sie sich die folgenden Vergleiche an: