Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Artikel wird erläutert, wie Sie serverlose Compute für Notebooks verwenden. Informationen zur Verwendung der serverlosen Berechnung für Aufträge finden Sie unter Ausführen von Lakeflow-Aufträgen mit serverloser Berechnung für Workflows.

Preisinformationen zur Verwendung von serverlosen Compute in Notizbüchern finden Sie unter Databricks-Preise.

Anforderungen

- Ihr Arbeitsbereich muss für Unity Catalog aktiviert sein.

- Ihr Arbeitsbereich muss sich in einer unterstützten Region befinden, damit serverlose Berechnungen ausgeführt werden können. Weitere Informationen finden Sie unter Azure Databricks-Regionen.

Anfügen eines Notebooks an serverloses Computing

Wenn Ihr Arbeitsbereich für die serverlose interaktive Berechnung aktiviert ist, haben alle Benutzer im Arbeitsbereich Zugriff auf serverlose Berechnung für Notebooks. Es sind keine zusätzlichen Berechtigungen erforderlich.

Zum Anfügen an die serverlose Berechnung klicken Sie im Notebook auf das Dropdownmenü "Verbinden", und wählen Sie "Serverless" aus. Bei neuen Notebooks wird der angefügte Compute bei der Codeausführung automatisch serverlos ausgeführt, wenn keine andere Ressource ausgewählt wurde.

Abfrageeinblicke anzeigen

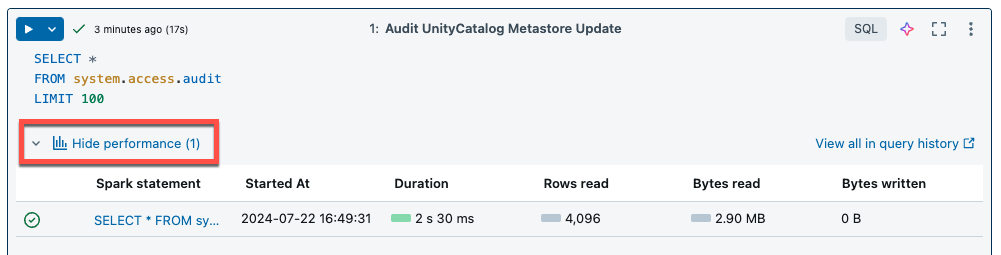

Serverloses Computing für Notebooks und Aufträge verwendet Abfrageerkenntnisse zur Bewertung der Spark-Ausführungsleistung. Nachdem Sie eine Zelle in einem Notebook ausgeführt haben, können Sie Einblicke im Zusammenhang mit SQL- und Python-Abfragen anzeigen, indem Sie auf den Link "Leistung anzeigen" klicken.

Sie können auf eine der Spark-Anweisungen klicken, um die Abfragemetriken anzuzeigen. Dort können Sie auf "Abfrageprofil anzeigen" klicken, um eine Visualisierung der Abfrageausführung anzuzeigen. Weitere Informationen zu Abfrageprofilen finden Sie unter "Abfrageprofil".

Hinweis

Leistungserkenntnissen für Ihre Auftragsausführung erhalten Sie unter Anzeigen von Abfrageerkenntnissen für Auftragsausführungen.

Abfrageverlauf

Alle Abfragen, die auf serverloser Berechnung ausgeführt werden, werden auch auf der Abfrageverlaufsseite Ihres Arbeitsbereichs aufgezeichnet. Informationen zum Abfrageverlauf finden Sie unter "Abfrageverlauf".

Einschränkungen für Einblickabfragen

- Das Abfrageprofil ist erst verfügbar, nachdem die Abfrageausführung beendet wurde.

- Metriken werden live aktualisiert, obwohl das Abfrageprofil während der Ausführung nicht angezeigt wird.

- Es werden nur die folgenden Abfragestatus behandelt: RUNNING, CANCELED, FAILED, FINISHED.

- Die Ausführung von Abfragen kann nicht von der Abfrageverlaufsseite abgebrochen werden. Sie können in Notebooks oder Aufträgen abgebrochen werden.

- Ausführliche Metriken sind nicht verfügbar.

- Der Abfrageprofildownload ist nicht verfügbar.

- Der Zugriff auf die Spark-Benutzeroberfläche ist nicht verfügbar.

- Der Anweisungstext enthält nur die letzte Zeile, die ausgeführt wurde. Es kann jedoch mehrere Zeilen vor dieser Zeile geben, die als Teil derselben Anweisung ausgeführt wurden.

Serverloser Überlastungsschutz

Um lange ausgeführte Abfragen zu steuern, verfügen serverlose Notizbücher über ein Standardmäßiges Ausführungstimeout von 2,5 Stunden. Sie können die Timeoutlänge manuell festlegen, indem Sie spark.databricks.execution.timeout im Notizbuch konfigurieren. Siehe Konfigurieren von Spark-Eigenschaften für serverlose Notizbücher und Aufträge.