Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Dataflow Gen2 ist die neue Generation von Dataflows. Die neue Generation von Dataflows wird neben Power BI Dataflow (Gen1) eingesetzt und bietet neue Features und Benutzeroberflächen. Der folgende Abschnitt enthält einen Vergleich zwischen Dataflow Gen1 und Dataflow Gen2.

Funktionsübersicht

| Feature | Dataflow Gen2 | Dataflow Gen1 |

|---|---|---|

| Erstellen von Dataflows mit Power Query | ✓ | ✓ |

| Kürzerer Erstellungsablauf | ✓ | |

| Automatisches Speichern und Hintergrundveröffentlichung | ✓ | |

| Datenziele | ✓ | |

| Verbesserter Überwachungs- und Aktualisierungsverlauf | ✓ | |

| Integration mit Datenpipelines | ✓ | |

| Hochskalierung von Computeressourcen | ✓ | |

| Abrufen von Daten über den Dataflows-Connector | ✓ | ✓ |

| Direkte Abfrage über den Dataflows-Connector | ✓ | |

| Inkrementelle Aktualisierung | ✓ | |

| KI Insights-Unterstützung | ✓ |

Kürzere Erstellung

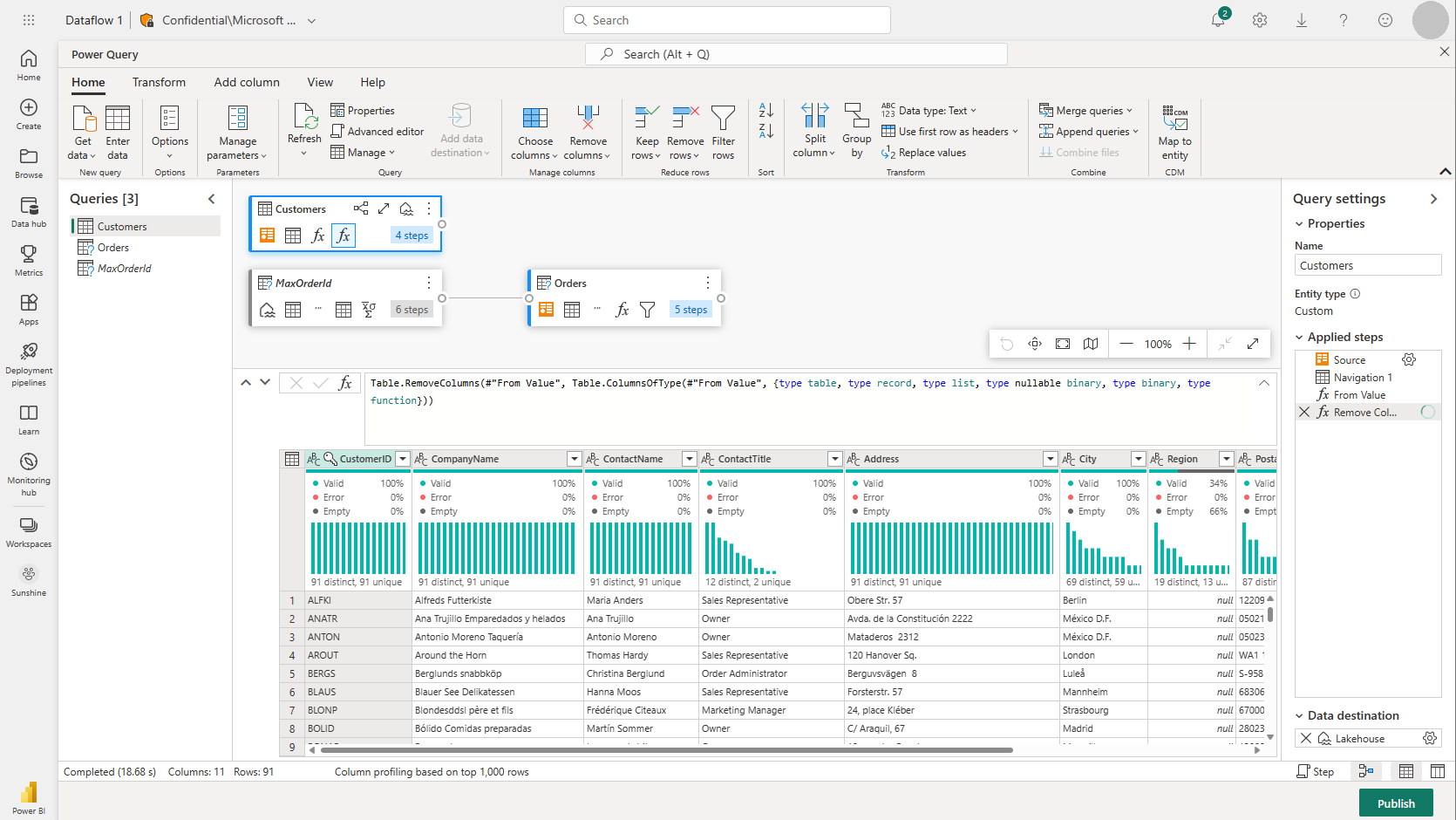

Die Arbeit mit Dataflow Gen2 ist äußerst intuitiv. Wir haben die gesamte Power Query-Benutzeroberfläche beibehalten, die Sie von Power BI-Dataflows kennen. Wenn Sie die Benutzeroberfläche öffnen, werden Sie Schritt für Schritt angeleitet, wie Sie die Daten in Ihren Dataflow übertragen. Außerdem haben wir die Erstellung von Dataflows verkürzt, um die Anzahl der erforderlichen Schritte zu verringern, und einige neue Funktionen hinzugefügt, um Ihre Arbeit noch weiter zu vereinfachen.

Neue Dataflow-Speicherumgebung

Mit Dataflow Gen2 haben wir die Funktionsweise des Speicherns eines Dataflows geändert. Alle an einem Dataflow vorgenommenen Änderungen werden automatisch in der Cloud gespeichert. So können Sie die Erstellung jederzeit beenden und zu einem späteren Zeitpunkt dort weitermachen, wo Sie aufgehört haben. Sobald Sie mit dem Erstellen Ihres Dataflows fertig sind, veröffentlichen Sie Ihre Änderungen. Diese Änderungen werden bei der Aktualisierung des Dataflows verwendet. Darüber hinaus werden bei der Veröffentlichung des Datenflusses Ihre Änderungen gespeichert und Überprüfungen durchgeführt, die im Hintergrund ablaufen müssen. Mit diesem Feature können Sie Ihren Dataflow speichern, ohne warten zu müssen, bis die Überprüfung abgeschlossen ist.

Weitere Informationen zur neuen Speicherumgebung finden Sie unter Speichern eines Entwurfs Ihres Dataflows.

Datenziele

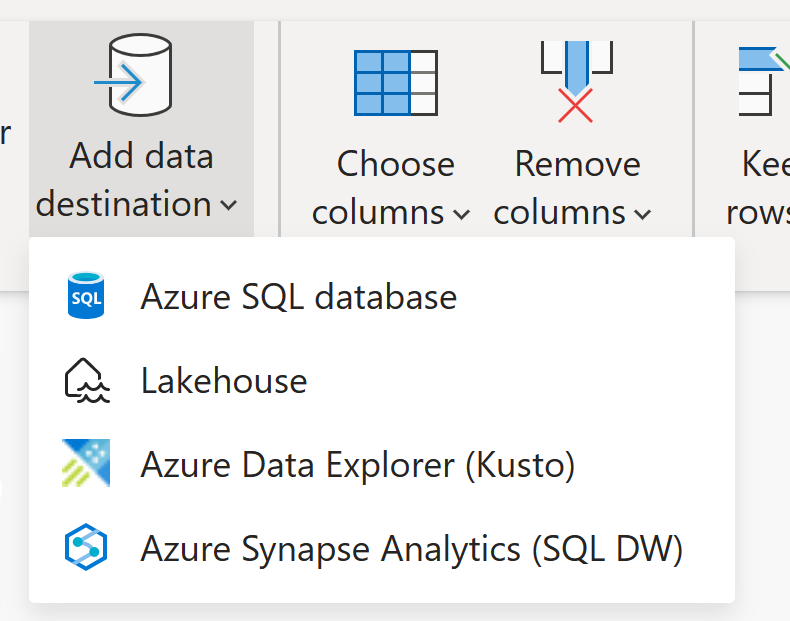

Ähnlich wie Dataflow Gen1 ermöglicht Dataflow Gen2 das Transformieren Ihrer Daten in den internen Speicher bzw. Stagingspeicher des Dataflows, auf den mithilfe des Dataflow-Connectors zugegriffen werden kann. Mit Dataflow Gen2 können Sie auch ein Datenziel für Ihre Daten angeben. Mit diesem Feature können Sie jetzt Ihre ETL-Logik und den Zielspeicher trennen. Von diesem Feature profitieren Sie in vielerlei Hinsicht. Beispielsweise können Sie jetzt einen Dataflow verwenden, um Daten in ein Lakehouse zu laden, und dann ein Notebook verwenden, um die Daten zu analysieren. Alternativ können Sie einen Dataflow verwenden, um Daten in eine Azure SQL-Datenbank zu laden und dann eine Datenpipeline zum Laden der Daten in ein Data Warehouse zu verwenden.

In Dataflow Gen2 haben wir Unterstützung für die folgenden Ziele hinzugefügt, und viele weitere Ziele werden in Kürze verfügbar sein:

- Fabric-Lakehouse

- Azure Data Explorer (Kusto)

- Azure Synapse Analytics (SQL DW)

- Azure SQL-Datenbank

Hinweis

Um Ihre Daten in das Fabric-Warehouse zu laden, können Sie den Azure Synapse Analytics-Connector (SQL DW) verwenden, indem Sie die SQL-Verbindungszeichenfolge abrufen. Weitere Informationen finden Sie unter Konnektivität mit Data Warehousing in Microsoft Fabric.

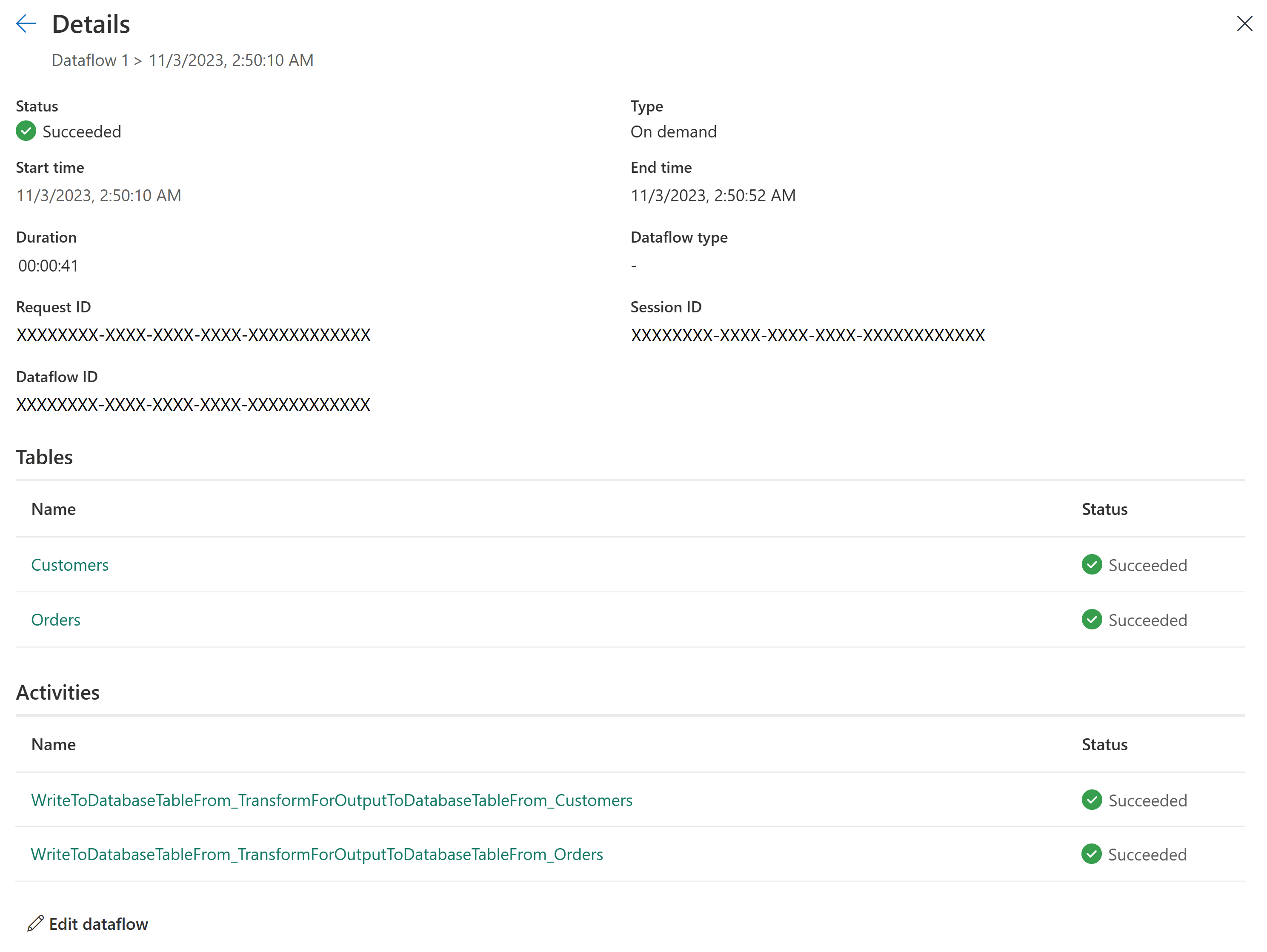

Neuer Aktualisierungsverlauf und Überwachung

Mit Dataflow Gen2 führen wir eine neue Möglichkeit für Sie ein, Ihre Dataflow-Aktualisierungen zu überwachen. Wir integrieren Unterstützung für den Überwachungshub und führen ein umfangreiches Upgrade für unseren Aktualisierungsverlauf aus.

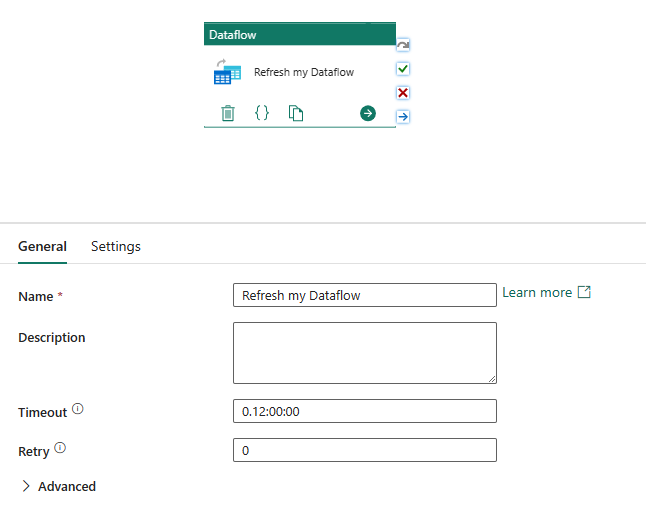

Integration mit Datenpipelines

Mit Datenpipelines können Sie Aktivitäten gruppieren, die zusammen eine Aufgabe ausführen. Eine Aktivität ist eine Arbeitseinheit, die ausgeführt werden kann. Beispielsweise kann eine Aktivität Daten von einem Speicherort an einen anderen kopieren sowie eine SQL-Abfrage, eine gespeicherte Prozedur oder ein Python-Notebook ausführen.

Eine Pipeline kann eine oder mehrere Aktivitäten enthalten, die durch Abhängigkeiten verbunden sind. Sie können beispielsweise eine Pipeline verwenden, um Daten aus einem Azure-Blob zu erfassen und zu bereinigen, und dann einen Dataflow Gen2 starten, um die Protokolldaten zu analysieren. Sie können auch eine Pipeline verwenden, um Daten aus einem Azure-Blob in eine Azure SQL Datenbank zu kopieren und dann eine gespeicherte Prozedur für die Datenbank auszuführen.

Speichern als Entwurf

Mit Dataflow Gen2 führen wir eine unkomplizierte Benutzeroberfläche ein, indem wir die Notwendigkeit der Veröffentlichung zum Speichern Ihrer Änderungen beseitigen. Mit der Funktion „Als Entwurf speichern“ speichern wir bei jeder Änderung eine Entwurfsversion Ihres Dataflows. Ist Ihre Internetverbindung unterbrochen? Haben Sie Ihren Browser versehentlich geschlossen? Keine Sorge, wir halten Ihnen den Rücken frei. Sobald Sie zu Ihrem Dataflow zurückkehren, sind Ihre letzten Änderungen noch vorhanden, und Sie können dort fortfahren, wo Sie aufgehört haben. Dies ist eine nahtlose Benutzeroberfläche und erfordert keine Eingaben von Ihnen. So können Sie an Ihrem Datenfluss arbeiten, ohne sich Sorgen machen zu müssen, dass Ihre Änderungen verloren gehen oder Sie alle Abfragefehler beheben müssen, bevor Sie Ihre Änderungen speichern können. Weitere Informationen zu diesem Feature finden Sie unter Speichern eines Dataflowentwurfs.

Hochskalierung von Computeressourcen

Ähnlich wie Dataflow Gen1 verfügt auch Dataflow Gen2 über eine verbesserte Compute-Engine, um die Leistung sowohl bei der Transformation verwiesener Abfragen als auch bei Datenabrufszenarios zu verbessern. Um dies zu erreichen, erstellt Dataflow Gen2 sowohl Lakehouse- als auch Warehouse-Elemente in Ihrem Arbeitsbereich und verwendet sie zum Speichern und Zugreifen auf Daten, um die Leistung für alle Ihre Dataflows zu verbessern.

Lizenzierung von Dataflow Gen1 im Vergleich zu Gen2

Dataflow Gen2 ist die neue Generation von Dataflows, die neben dem Power BI-Dataflow (Gen1) eingesetzt wird und neue Features und Benutzeroberflächen bietet. Es erfordert eine Fabric-Kapazität oder eine Fabric-Testkapazität. Um besser zu verstehen, wie die Lizenzierung für Datenflüsse funktioniert, lesen Sie den folgenden Artikel: Microsoft Fabric-Konzepte und -Lizenzen

Testen von Dataflow Gen2 durch Wiederverwenden der Abfragen aus Dataflow Gen1

Sie haben wahrscheinlich viele Dataflow Gen1-Abfragen und fragen sich, wie Sie sie in Dataflow Gen2 ausprobieren können. Es gibt einige Optionen, um Ihre Gen1-Dataflows als Dataflow Gen2 neu zu erstellen.

Exportieren Sie Ihre Dataflow Gen1-Abfragen, und importieren Sie sie in Dataflow Gen2.

Sie können Abfragen jetzt sowohl in der Dataflow Gen1- als auch in der Gen2-Erstellungsumgebung exportieren und in einer PQT-Datei speichern, die Sie dann in Dataflow Gen2 importieren können. Weitere Informationen finden Sie unter Verwenden des Exportvorlagenfeatures.

Kopieren und Einfügen in Power Query

Wenn Sie in Power BI oder Power Apps über einen Dataflow verfügen, können Sie Ihre Abfragen kopieren und in den Editor Ihrer Dataflow Gen2-Instanz einfügen. Mit dieser Funktion können Sie Ihren Dataflow zu Gen2 migrieren, ohne Ihre Abfragen neu schreiben zu müssen. Weitere Informationen finden Sie unter Kopieren und Einfügen vorhandener Dataflow Gen1-Abfragen.