Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

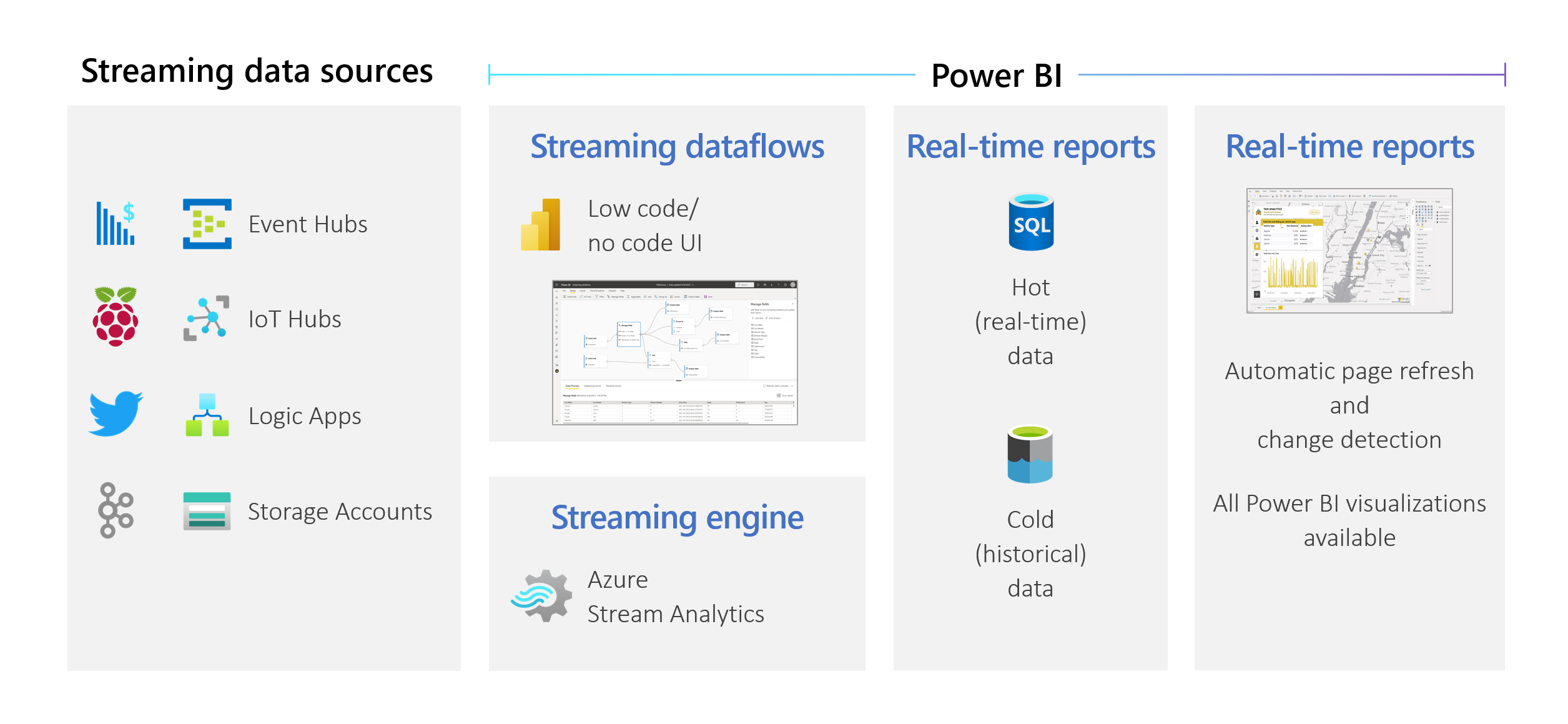

Organisationen möchten Daten verarbeiten, wenn sie eingehen, nicht Tage oder Wochen später. Die Vision hinter Power BI ist einfach: Die Unterscheidung zwischen Batch-, Echtzeit- und Streamingdaten sollte wegfallen. Benutzer sollten mit allen Daten arbeiten können, sobald sie verfügbar sind. Analysten benötigen in der Regel technische Hilfe bei streamingbasierten Datenquellen, der Datenvorbereitung, komplexen zeitbasierten Vorgängen und der Datenvisualisierung in Echtzeit. IT-Abteilungen sind häufig auf benutzerdefinierte Systeme und eine Kombination von Technologien verschiedener Anbieter angewiesen, um zeitnah Datenanalysen ausführen zu können. Ohne diese Voraussetzung können sie Entscheidungsträgern Informationen nicht nahezu in Echtzeit bereitstellen.

Streaming-Dataflows ermöglichen es Autoren, auf der Grundlage von nahezu in Echtzeit eingehenden Streamingdaten direkt im Power BI-Dienst Verbindungen mit Berichten herzustellen, diese zu erfassen, zu verbinden, Mashups durchzuführen, Berichte zu modellieren und zu erstellen. Der Dienst ermöglicht dies ohne Programmierung auf einer Drag-&-Drop-Oberfläche. Sie können Streamingdaten mit Batchdaten kombinieren und abgleichen, wenn Sie dies über eine Benutzeroberfläche (UI) benötigen, die eine Diagrammansicht für ein einfaches Datenmischup enthält. Das letztendlich erstellte Element ist ein Dataflow, der in Echtzeit genutzt werden kann, um eine hochgradig interaktive Berichterstellung nahezu in Echtzeit zu ermöglichen. Alle Datenvisualisierungsfunktionen in Power BI funktionieren mit Streamingdaten, genau wie bei Batchdaten.

Wichtig

Streaming-Dataflows wurden eingestellt und sind nicht mehr verfügbar.

Azure Stream Analytics hat die Funktionalität von Streaming-Dataflows zusammengeführt. Weitere Informationen zur Einstellung von Streaming-Dataflows finden Sie in der Ankündigung zur Einstellung.

Benutzer können Datenvorbereitungsvorgänge wie Verknüpfungen und Filter ausführen. Sie können auch Zeitfensteraggregationen (z. B. „Rollierende Fenster“, „Springende Fenster“ und „Sitzungsfenster“) für „Gruppieren nach“-Vorgänge ausführen.

Streaming-Dataflows in Power BI geben Organisationen diese Möglichkeiten:

Benutzer können Datenvorbereitungsvorgänge wie Verknüpfungen und Filter ausführen. Sie können auch Zeitfensteraggregationen (z. B. „Rollierende Fenster“, „Springende Fenster“ und „Sitzungsfenster“) für „Gruppieren nach“-Vorgänge ausführen.

Streaming-Dataflows in Power BI geben Organisationen diese Möglichkeiten:

- Treffen sicherer Entscheidungen nahezu in Echtzeit. Organisationen können agiler handeln und auf Grundlage der aktuellsten Erkenntnisse sinnvolle Aktionen durchführen.

- Demokratisieren von Streamingdaten. Organisationen können mit einer programmierfreien Lösung einen verbesserten Datenzugang sowie eine einfachere Interpretation von Daten bei weniger IT-Ressourcen ermöglichen.

- Verkürzen Sie die Zeit bis zur Erkenntnis, indem Sie eine End-to-End-Streaminganalyselösung mit integriertem Datenspeicher und Business Intelligence verwenden.

Streaming-Dataflows unterstützen DirectQuery und automatische Seitenaktualisierung/Änderungserkennung. Durch diesen Support können Benutzer Berichte erstellen, die nahezu in Echtzeit (bis hinab zur Sekundenebene) aktualisiert werden, indem sie alle in Power BI verfügbaren Visuals verwenden.

Anforderungen

Bevor Sie Ihren ersten Streaming-Dataflow erstellen, stellen Sie sicher, dass Sie alle nachfolgend aufgeführten Anforderungen erfüllen:

Um einen Streaming-Dataflow zu erstellen und auszuführen, benötigen Sie einen Arbeitsbereich, der Teil einer Premium-Kapazität oder Premium-Einzelbenutzerlizenz ist.

Wichtig

Wenn Sie eine Premium-Einzelbenutzerlizenz verwenden und möchten, dass andere Benutzer Berichte nutzen, die mit Streaming-Dataflows erstellt wurden, die in Echtzeit aktualisiert werden, benötigen diese Benutzer ebenfalls eine Premium-Einzelbenutzerlizenz. Diese Benutzer können die Berichte dann mit der gleichen Aktualisierungshäufigkeit nutzen, die Sie eingerichtet haben, wenn diese Aktualisierung häufiger als alle 30 Minuten stattfindet.

Aktivieren Sie Dataflows für Ihren Mandanten. Weitere Informationen finden Sie unter Aktivieren von Dataflows in Power BI Premium.

Damit sichergestellt ist, dass Streaming-Dataflows in Ihrer Premium-Kapazität funktionieren, muss die erweiterte Compute-Engine aktiviert sein. Die Engine ist standardmäßig aktiviert und kann von Power BI Kapazitätsadministratoren deaktiviert werden. Wenn dies der Fall ist, bitten Sie Ihren Administrator, sie zu aktivieren.

Die erweiterte Compute-Engine ist nur in Premium P- oder Embedded A3- und größeren Premium-Kapazitäten verfügbar. Um Streaming-Dataflows verwenden zu können, benötigen Sie entweder eine Einzelbenutzerlizenz, eine Premium P-Kapazität beliebiger Größe oder eine Embedded A3- oder eine größere Kapazität. Weitere Informationen zu Premium-SKUs und deren Spezifikationen finden Sie unter Kapazität und SKUs in Power BI Embedded Analytics.

Zum Erstellen von Berichten, die in Echtzeit aktualisiert werden, müssen Sie sicherstellen, dass Ihr Administrator (Kapazitäts- und/oder Power BI für Premium-Einzelbenutzerlizenz) die automatische Seitenaktualisierung aktiviert hat. Stellen Sie außerdem sicher, dass der Administrator ein minimales Aktualisierungsintervall zugelassen hat, das Ihren Anforderungen entspricht. Weitere Informationen finden Sie unter Automatische Seitenaktualisierung in Power BI.

Erstellen eines Streaming-Dataflows

Ein Streaming-Dataflow ist wie sein Dataflow-Verwandter eine Sammlung von Entitäten (Tabellen), die in Arbeitsbereichen im Power BI-Dienst erstellt und verwaltet werden. Eine Tabelle ist eine Gruppe von Feldern, die ähnlich wie eine Tabelle in einer Datenbank zum Speichern von Daten verwendet wird.

Sie können Ihrem Streaming-Dataflow direkt aus dem Arbeitsbereich, in dem Ihr Dataflow erstellt wurde, Tabellen hinzufügen und diese bearbeiten. Der Hauptunterschied zu regulären Dataflows besteht darin, dass Sie sich keine Gedanken über Aktualisierungen oder die Häufigkeit machen müssen. Aufgrund der Art der Streamingdaten wird ein kontinuierlicher Stream genutzt. Die Aktualisierung erfolgt durchgehend und ist unbegrenzt, es sei denn, Sie beenden diese.

Hinweis

Pro Arbeitsbereich kann nur ein Dataflowtyp verwendet werden. Wenn Sie in Ihrem Premium-Arbeitsbereich bereits über einen regulären Dataflow verfügen, können Sie keinen Streaming-Dataflow erstellen (und umgekehrt).

Zum Erstellen eines Streaming-Dataflows:

Öffnen Sie den Power BI-Dienst in einem Browser und wählen Sie dann einen Premium-aktivierten Arbeitsbereich aus. (Streaming-Dataflows sind, wie reguläre Dataflows, nicht unter Mein Arbeitsbereich verfügbar.)

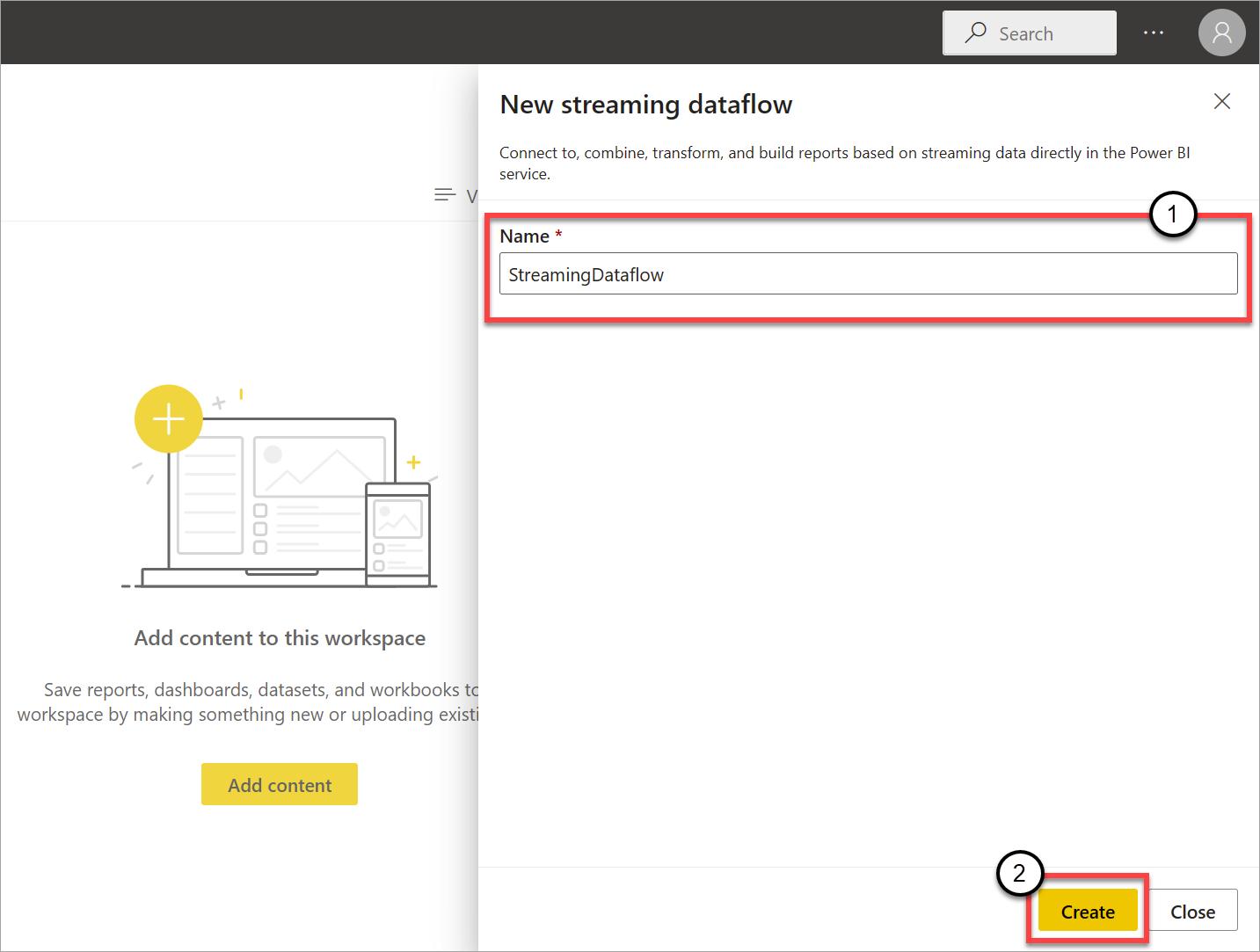

Wählen Sie das Dropdownmenü Neu und dann Streaming-Dataflow aus.

Im sich seitlich öffnenden Bereich müssen Sie Ihrem Streaming-Dataflow einen Namen zuweisen. Geben Sie einen Namen in das Feld Name (1) ein und wählen Sie dann Erstellen (2) aus.

Es wird die leere Diagrammansicht für Streaming-Dataflows angezeigt.

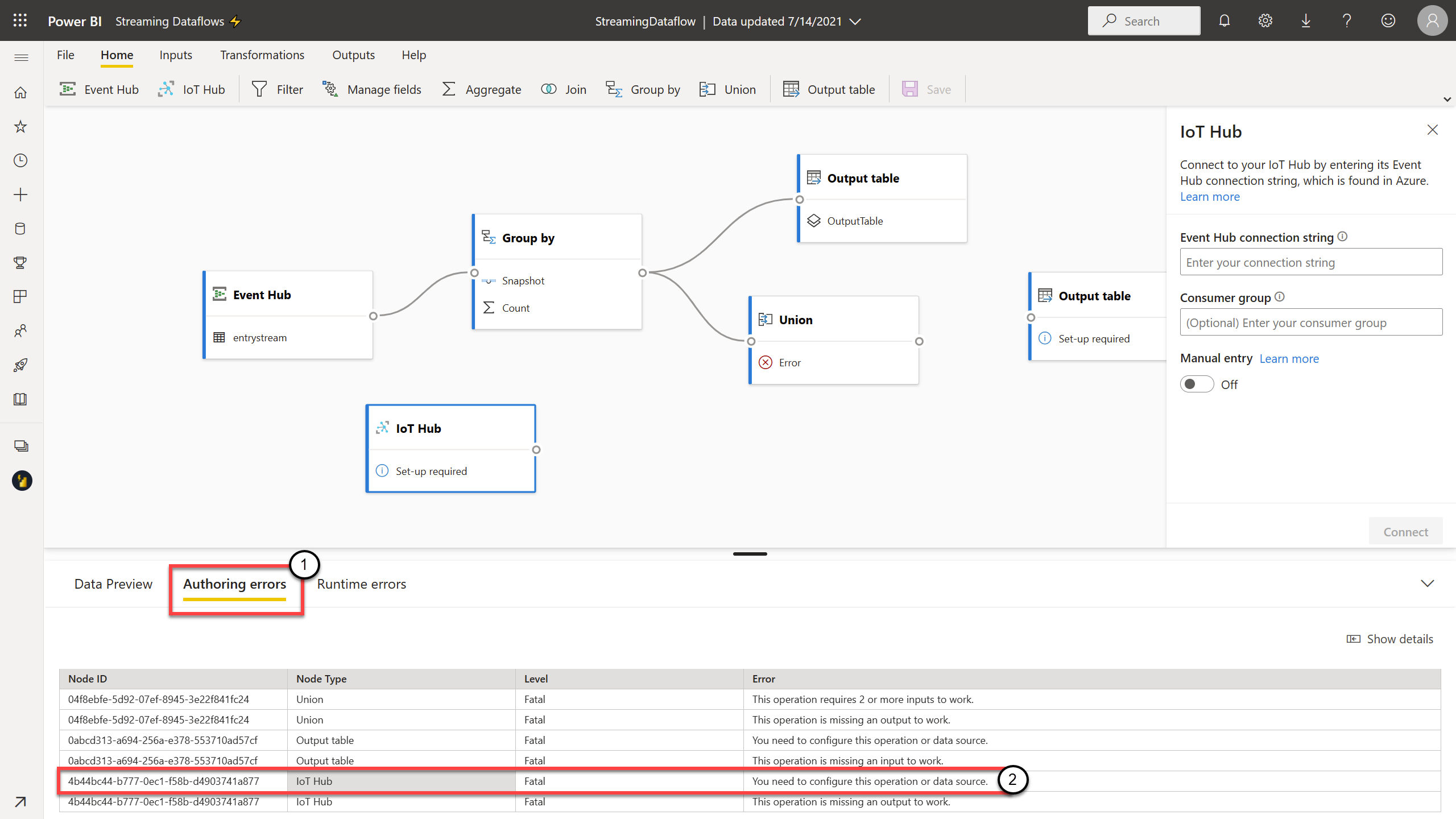

Der folgende Screenshot zeigt einen fertig erstellen Dataflow. Es sind alle Abschnitte hervorgehoben, die Ihnen zur Dokumenterstellung auf der Streaming-Dataflow-Benutzeroberfläche zur Verfügung stehen.

Menüband: Im Menüband folgen die Abschnitte der Reihenfolge eines „klassischen“ Analyseprozesses: Eingaben (auch als Datenquellen bezeichnet), Transformationen (Streaming-ETL-Vorgänge), Ausgaben und eine Schaltfläche zum Speichern des Fortschritts.

Diagrammansicht: Diese Ansicht ist eine grafische Darstellung Ihres Dataflows von Eingaben über Vorgänge bis hin zu Ausgaben.

Seitenbereich: Je nachdem, welche Komponente Sie in der Diagrammansicht ausgewählt haben, werden Ihnen Einstellungen zum Ändern der einzelnen Eingaben, Transformationen oder Ausgaben angezeigt.

Tabs zur Datenvorschau, Erstellungsfehler und Laufzeitfehler: Für jede angezeigte Karte zeigt die Datenvorschau die Ergebnisse für diesen Schritt an (live für Eingaben und auf Anforderung für Transformationen und Ausgaben).

In diesem Abschnitt werden außerdem alle Erstellungsfehler oder -warnungen zusammengefasst, die möglicherweise in Ihren Dataflows aufgetreten sind. Durch Auswahl der einzelnen Fehler oder Warnungen wird die entsprechende Transformation ausgewählt. Zusätzlich haben Sie Zugriff auf Laufzeitfehler (z. B. auf verworfene Nachrichten), nachdem der Dataflow ausgeführt wird.

Sie können diesen Abschnitt von Streaming-Dataflows jederzeit minimieren, indem Sie den Pfeil in der oberen rechten Ecke auswählen.

Ein Streaming-Dataflow basiert auf drei Hauptkomponenten: Streamingeingaben, Transformationen und Ausgaben. Sie können beliebig viele Komponenten verwenden, einschließlich mehrerer Eingaben, paralleler Verzweigungen mit mehreren Transformationen und mehrere Ausgaben.

Hinzufügen einer Streamingeingabe:

Wählen Sie zum Hinzufügen einer Streamingeingabe das Symbol im Menüband aus und geben Sie im Seitenbereich die Informationen an, die für die Einrichtung erforderlich sind. Ab Juli 2021 unterstützt die Vorschauversion der Streaming-Dataflows Azure Event Hubs und Azure IoT Hub als Eingaben.

Azure Event Hubs und Azure IoT Hub sind Dienste, die auf einer gemeinsamen Architektur basieren und dem Zweck dienen, die schnelle und skalierbare Erfassung und Nutzung von Ereignissen zu ermöglichen. Insbesondere IoT Hub ist als zentraler Nachrichten-Hub für die Kommunikation in beiden Richtungen zwischen einer IoT-Anwendung und den mit ihr verbundenen Geräten maßgeschneidert.

Azure Event Hubs

Bei Azure Event Hubs handelt es sich um eine Big Data-Streamingplattform und einen Ereigniserfassungsdienst. Mit diesem Dienst können Millionen von Ereignissen pro Sekunde empfangen und verarbeitet werden. An einen Event Hub gesendete Daten können transformiert und mit einem beliebigen Echtzeitanalyseanbieter oder Batchverarbeitungs- und Speicheradapter gespeichert werden.

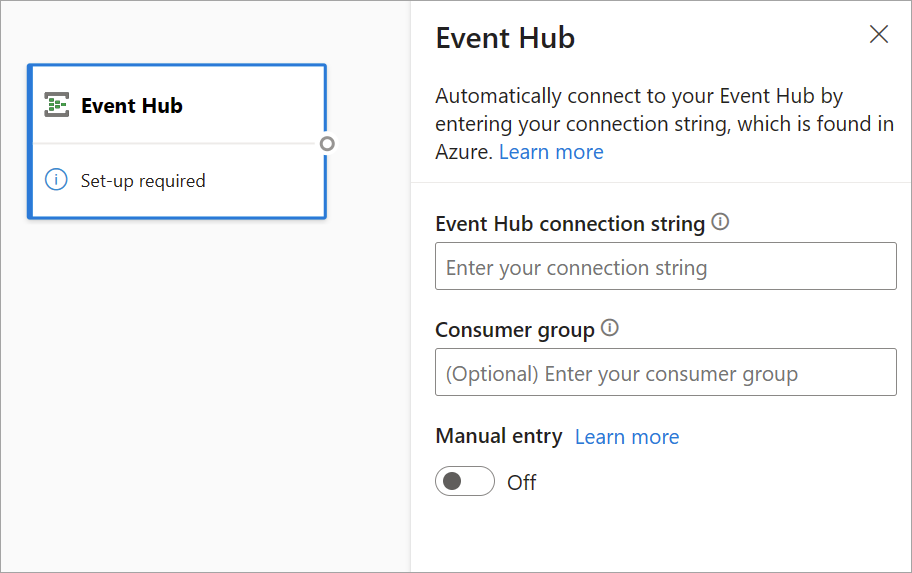

Um einen Event Hub als Eingabe für Streaming-Dataflows zu konfigurieren, wählen Sie das Event Hub-Symbol aus. Eine Karte wird in der Diagrammansicht angezeigt, einschließlich eines Seitenbereichs für die Konfiguration.

Sie haben die Möglichkeit, die Event Hubs-Verbindungszeichenfolge einzufügen. Streaming-Dataflows füllen alle erforderlichen Informationen aus, einschließlich der optionalen Consumergruppe (standardmäßig $Default). Wenn Sie alle Felder manuell eingeben möchten, können Sie den Umschalter für den manuellen Eintrag anschalten, um sie verfügbar zu machen. Weitere Informationen finden Sie unter Abrufen einer Event Hubs-Verbindungszeichenfolge.

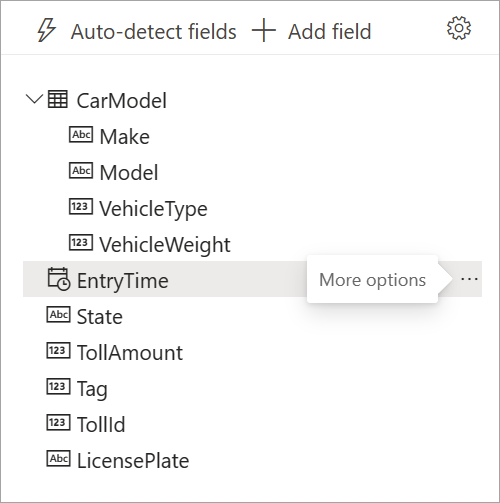

Nachdem Sie Ihre Event Hubs-Anmeldeinformationen eingerichtet und Verbinden ausgewählt haben, können Sie über + Feld hinzufügen Felder manuell hinzufügen. Voraussetzung ist, dass Sie die Feldnamen kennen. Um stattdessen Felder und Datentypen automatisch basierend auf einem Beispiel der eingehenden Nachrichten zu erkennen, wählen Sie Felder automatisch erkennen aus. Durch Auswahl des Zahnradsymbols können Sie die Anmeldeinformationen bei Bedarf bearbeiten.

Wenn Streaming-Dataflows die Felder erkennt, werden sie in der Liste angezeigt. Darüber hinaus wird in der Datenvorschautabelle unter der Diagrammansicht eine Livevorschau der eingehenden Nachrichten angezeigt.

Sie können die Feldnamen jederzeit bearbeiten und den Datentyp entfernen oder ändern, indem Sie „Weitere Optionen“ (...) neben den einzelnen Feldern auswählen. Sie können auch geschachtelte Felder aus den eingehenden Nachrichten erweitern, auswählen und bearbeiten, wie in der folgenden Abbildung dargestellt.

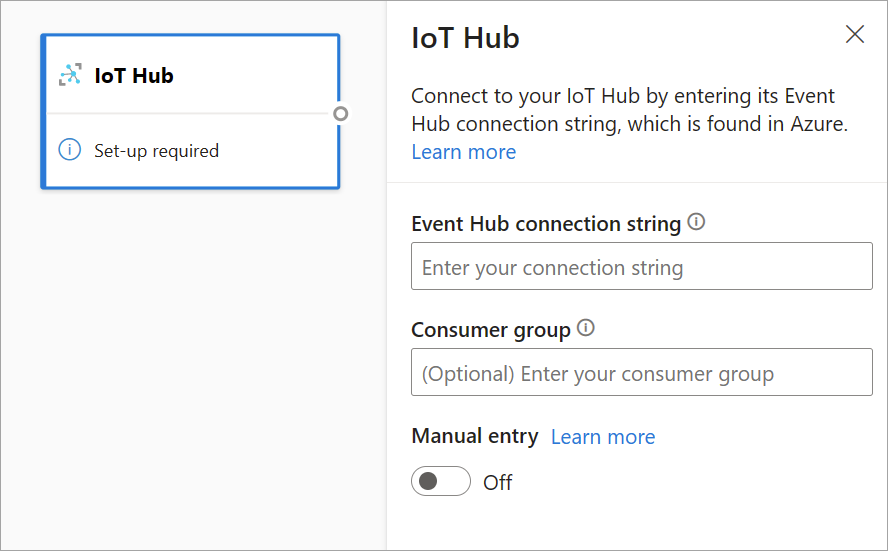

Azure IoT Hub

IoT Hub ist ein verwalteter Dienst, der in der Cloud gehostet wird. Er fungiert als zentraler Nachrichtenhub für die Kommunikation in beide Richtungen zwischen einer IoT-Anwendung und den angeschlossenen Geräten. Sie können Millionen von Geräten und deren Back-End-Lösungen zuverlässig und sicher verbinden. Fast jedes Gerät kann mit einem IoT Hub verbunden werden.

Aufgrund ihrer allgemeinen Architektur ähnelt die IoT Hub-Konfiguration der Event Hubs-Konfiguration. Es gibt jedoch einige Unterschiede, z. B. wo die Event Hubs-kompatible Verbindungszeichenfolge für den integrierten Endpunkt zu finden ist. Weitere Informationen finden Sie unter Lesen von Geräte-zu-Cloud-Nachrichten vom integrierten Endpunkt.

Nachdem Sie die Verbindungszeichenfolge für den integrierten Endpunkt eingefügt haben, sind alle Funktionen zum Auswählen, Hinzufügen, automatischen Ermitteln und Bearbeiten von Feldern, die von IoT Hub eingehen, mit Event Hubs identisch. Sie können die Anmeldeinformationen auch bearbeiten, indem Sie auf das Zahnradsymbol klicken.

Tipp

Wenn Sie Zugriff auf Event Hub oder IoT Hub im Azure-Portal Ihrer Organisation haben und ihn als Eingabe für Ihren Streaming-Dataflow verwenden möchten, finden Sie die Verbindungszeichenfolgen an den folgenden Speicherorten:

Für Event Hubs:

- Wählen Sie im Abschnitt Analyse die Option Alle Dienste>Event Hubs aus.

- Wählen Sie zunächst Event Hubs Namespace>Entitäten/Event Hubs und dann den Event Hub-Namen aus.

- Wählen Sie in der Liste SAS-Richtlinie eine Richtlinie aus.

- Wählen Sie neben dem Feld Verbindungszeichenfolge – Primärschlüssel „In Zwischenablage kopieren“ aus.

Für IoT Hub:

- Wählen Sie im Abschnitt Internet der Dinge die Option Alle Dienste>IoT Hubs aus.

- Wählen Sie den IoT Hub aus, mit dem Sie eine Verbindung herstellen möchten. Wählen Sie dann Integrierte Endpunkte aus.

- Wählen Sie „In Zwischenablage kopieren“ neben dem Event Hubs-kompatiblen Endpunkt aus.

Wenn Ihre Streamingdaten aus Event Hubs oder IoT Hub stammen, haben Sie in Ihrem Streaming-Dataflow Zugriff auf folgende Metadaten-Uhrzeitfelder:

- EventProcessedUtcTime: Datum und Uhrzeit der Verarbeitung des Ereignisses.

- EventEnqueuedUtcTime: Datum und die Uhrzeit des Empfangs des Ereignisses.

Keines dieser Felder wird in der Eingabevorschau angezeigt. Sie müssen diese manuell hinzufügen.

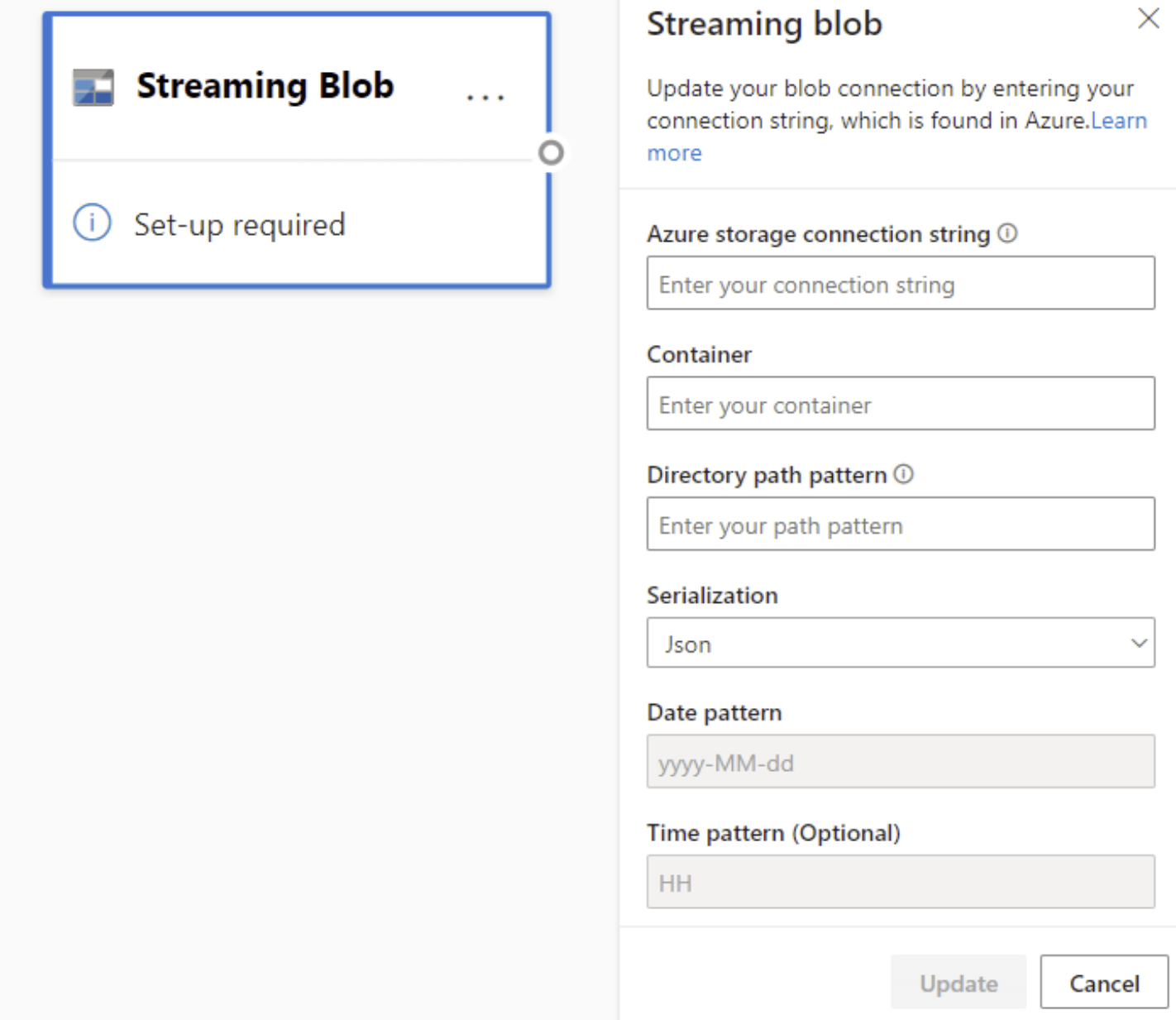

Blob Storage

Azure Blob Storage ist die Objektspeicherlösung von Microsoft für die Cloud. Blob Storage ist für die Speicherung großer Mengen unstrukturierter Daten optimiert. Unstrukturierte Daten sind Daten, die keinem bestimmten Datenmodell und keiner bestimmten Definition entsprechen (also beispielsweise Text- oder Binärdaten).

Sie können Azure-Blobs als Streaming-/Verweiseingabe verwenden. Streamingblobs werden jede Sekunde auf Updates überprüft. Im Gegensatz zu einem Streamingblob wird ein Verweisblob nur zu Beginn der Aktualisierung geladen. Es handelt sich um statische Daten, die sich voraussichtlich nicht ändern, und für die das empfohlene Limit bei 50 MB oder weniger liegt.

Power BI erwartet, dass Verweisblobs zusammen mit Streamingquellen verwendet werden, z. B. über JOIN. Deshalb muss ein Streaming-Dataflow mit einem Verweisblob auch eine Streamingquelle aufweisen.

Die Konfiguration für Azure-Blobs unterscheidet sich leicht von der eines Azure Event Hubs-Knotens. Wie Sie Ihre Azure Blob-Verbindungszeichenfolge finden erfahren Sie unter Anzeigen von Kontozugriffsschlüsseln.

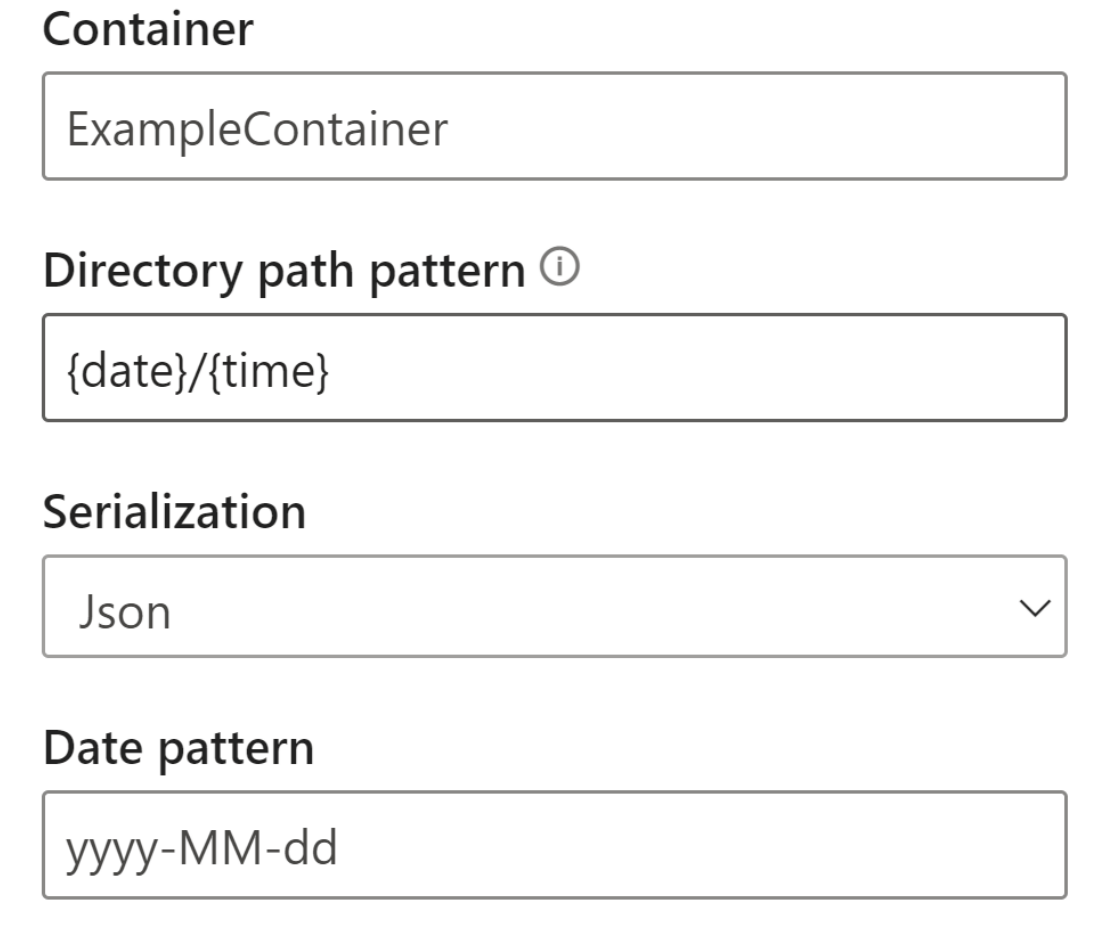

Nachdem Sie die Blob-Verbindungszeichenfolge eingegeben haben, müssen Sie den Namen Ihres Containers angeben. Sie müssen auch das Pfadmuster innerhalb Ihres Verzeichnisses eingeben, um auf die Dateien zuzugreifen, die Sie als Quelle für Ihren Dataflow festlegen möchten.

Für Streamingblobs wird erwartet, dass das Verzeichnispfadmuster ein dynamischer Wert ist. Das Datum muss Teil des Dateipfads für das Blob sein, referenziert als {date}. Außerdem werden Sternchen (*) im Pfadmuster, z. B. „{date}/{time}/*.json“ nicht unterstützt.

Angenommen, Sie verfügen über ein Blob mit dem Namen „ExampleContainer“, in dem Sie geschachtelte JSON-Dateien speichern, wobei die erste Ebene das Erstellungsdatum und die zweite Ebene die Stunde der Erstellung angibt (jjjj-mm-tt/hh). In diesem Fall würde Ihre Containereingabe „ExampleContainer“ lauten. Das Verzeichnispfadmuster würde „date}/{time}“ lauten, wobei Sie das Datums- und Zeitmuster ändern könnten.

Nachdem Ihr Blob mit dem Endpunkt verbunden wurde, sind alle Funktionen zum Auswählen, Hinzufügen, automatischen Erkennen und Bearbeiten von Feldern, die von Azure Blob eingehen, dieselben wie in Event Hubs. Sie können die Anmeldeinformationen auch bearbeiten, indem Sie auf das Zahnradsymbol klicken.

Bei der Arbeit mit Echtzeitdaten werden die Daten oft komprimiert, und zur Darstellung des Objekts werden Bezeichner verwendet. Ein möglicher Anwendungsfall für Blobs wäre außerdem die Verwendung als Verweisdaten für Ihre Streamingquellen. Verweisdaten ermöglichen es Ihnen, statische Daten mit Streamingdaten zu verbinden, um Ihre Streams für die Analyse anzureichern. Ein einfaches Beispiel dafür, wann diese Funktion hilfreich wäre, wäre die Installation von Sensoren in verschiedenen Kaufhäusern, um zu messen, wie viele Personen das Geschäft zu einem bestimmten Zeitpunkt betreten. Üblicherweise muss die Sensor-ID mit einer statischen Tabelle verknüpft werden, um anzugeben, in welchem Kaufhaus und an welchem Standort sich der Sensor befindet. Mithilfe von Verweisdaten ist es möglich, diese Daten während der Erfassung zu verknüpfen, sodass leicht erkennbar ist, welches Kaufhaus die höchste Kundenzahl aufweist.

Hinweis

Ein Auftrag für einen Streaming-Dataflow ruft jede Sekunde Daten aus Azure Blob Storage oder ADLS Gen2-Eingaben ab, wenn die Blobdatei verfügbar ist. Falls die Blobdatei nicht verfügbar ist, kommt es zu einem exponentiellen Backoff mit einer maximalen Zeitverzögerung von 90 Sekunden.

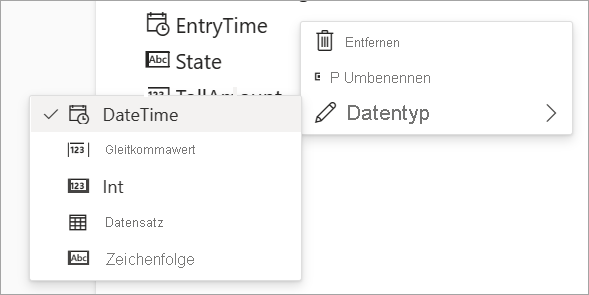

Datentypen

Unter anderem sind folgende Datentypen für Streaming-Dataflow-Felder verfügbar:

- DateTime: Datums- und Uhrzeitfeld im ISO-Format

- Gleitkomma: Dezimalzahl

- Int: Ganzzahl

- Datensatz: Geschachteltes Objekt mit mehreren Datensätzen

- Zeichenfolge: Text

Wichtig

Die für eine Streamingeingabe ausgewählten Datentypen haben im weiteren Verlauf wichtige Auswirkungen auf Ihren Streaming-Dataflow. Wählen Sie den Datentyp so früh wie möglich in Ihrem Dataflow aus, um ein Beenden zu einem späteren Zeitpunkt zu Bearbeitungszwecken zu vermeiden.

Hinzufügen einer Streamingdatentransformation

Streamingdatentransformationen unterscheiden sich grundsätzlich von Batchdatentransformationen. Nahezu alle Streamingdaten haben eine Zeitkomponente, die Einfluss auf alle beteiligten Datenaufbereitungsaufgaben hat.

Um Ihrem Dataflow eine Streamingdatentransformation hinzuzufügen, wählen Sie im Menüband das Transformationssymbol für die entsprechende Transformation aus. Die entsprechende Karte wird dann in der Diagrammansicht angezeigt. Nach Auswahl des Symbols wird der Seitenbereich für die betreffende Transformation angezeigt, sodass Sie sie konfigurieren können.

Ab Juli 2021 unterstützen Streaming-Dataflows die folgenden Streamingtransformationen.

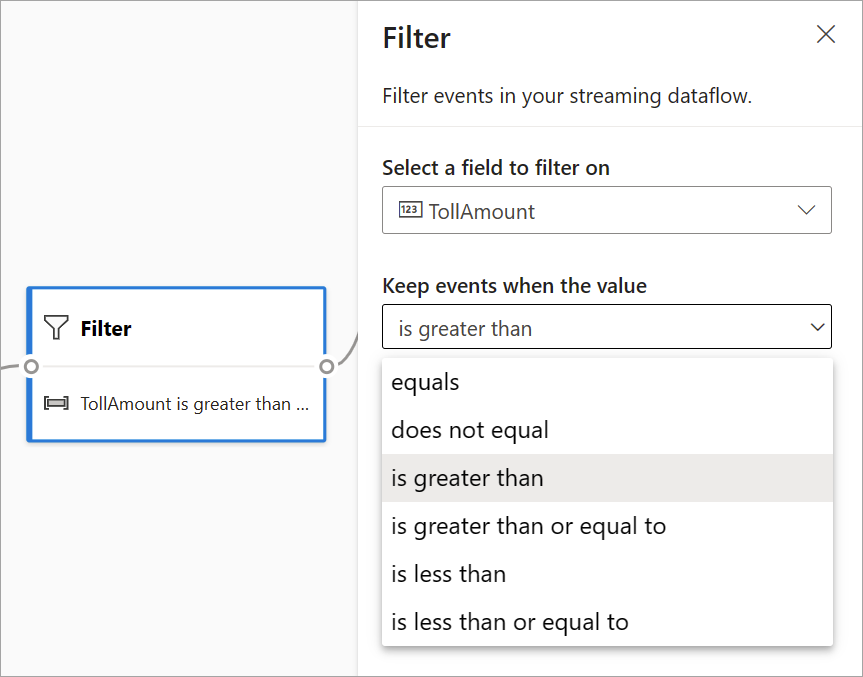

Filtern

Verwenden Sie die Filter-Transformation, um Ereignisse basierend auf dem Wert eines Felds in der Eingabe zu filtern. Abhängig vom Datentyp (Zahl oder Text) werden bei der Transformation die Werte beibehalten, die der ausgewählten Bedingung entsprechen.

Hinweis

Auf jeder Karte finden Sie Informationen darüber, was sonst noch erforderlich ist, um die Transformation fertig zu stellen. Wenn Sie z. B. eine neue Karte hinzufügen, wird die Meldung „Set-up required“ (Einrichtung erforderlich) angezeigt. Wenn Ihnen ein Knotenconnector fehlt, wird entweder eine Meldung „Fehler“ oder „Warnung“ angezeigt.

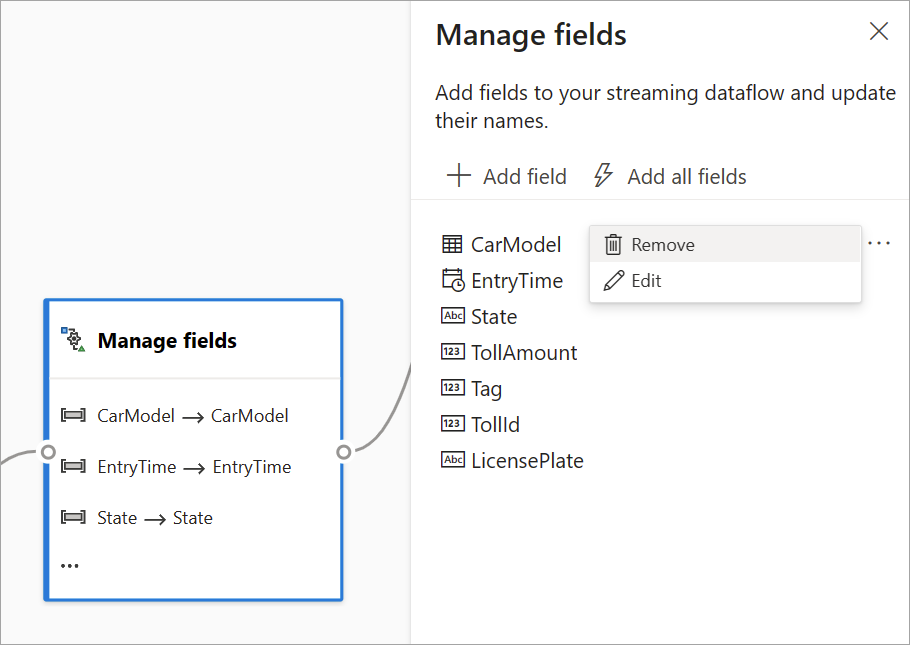

Verwalten von Feldern

Mit der Transformation Verwalten von Feldern können Sie Felder, die aus einer Eingabe oder einer anderen Transformation stammen, hinzufügen, entfernen oder umbenennen. In den Einstellungen im Seitenbereich haben Sie die Möglichkeit, durch Auswahl von Feld hinzufügen ein neues Feld oder alle Felder zugleich hinzuzufügen.

Tipp

Nachdem Sie eine Karte konfiguriert haben, erhalten Sie in der Diagrammansicht einen Einblick in die Einstellungen auf der Karte selbst. Beispielsweise können Sie im Bereich Felder verwalten der vorherigen Abbildung sehen, wie die ersten drei Felder verwaltet werden und welche neuen Namen ihnen zugewiesen wurden. Jede Karte besitzt Informationen, die für diese relevant sind.

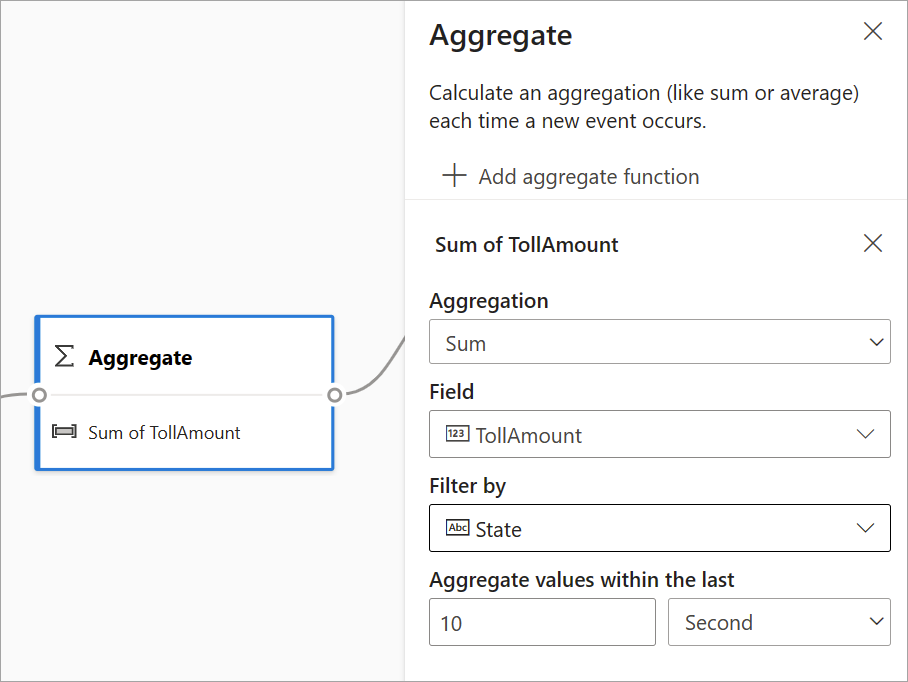

Aggregat

Mithilfe der Aggregattransformation können Sie jedes Mal, wenn in einem Zeitraum ein neues Ereignis eintritt, eine Aggregation (Summe, Minimum, Maximum oder Durchschnitt) berechnen. Mit diesem Vorgang können Sie die Aggregation außerdem basierend auf anderen Dimensionen in Ihren Daten filtern oder segmentieren. Sie können in derselben Transformation eine oder mehrere Aggregationen verwenden.

Wählen Sie das Transformationssymbol aus, um eine Aggregation hinzuzufügen. Verbinden Sie dann eine Eingabe, wählen Sie die Aggregation aus, fügen Sie eventuelle Filter- oder Slicedimensionen hinzu, und wählen Sie den Zeitraum aus, über den Sie die Aggregation berechnen möchten. In diesem Beispiel wird die Summe des Mautwerts über die letzten 10 Sekunden nach dem Bundesstaat berechnet, in dem sich Fahrzeug befindet.

Um der gleichen Transformation eine weitere Aggregation hinzuzufügen, wählen Sie Aggregatfunktion hinzufügen aus. Beachten Sie, dass der Filter oder das Slice auf alle Aggregationen in der Transformation angewendet wird.

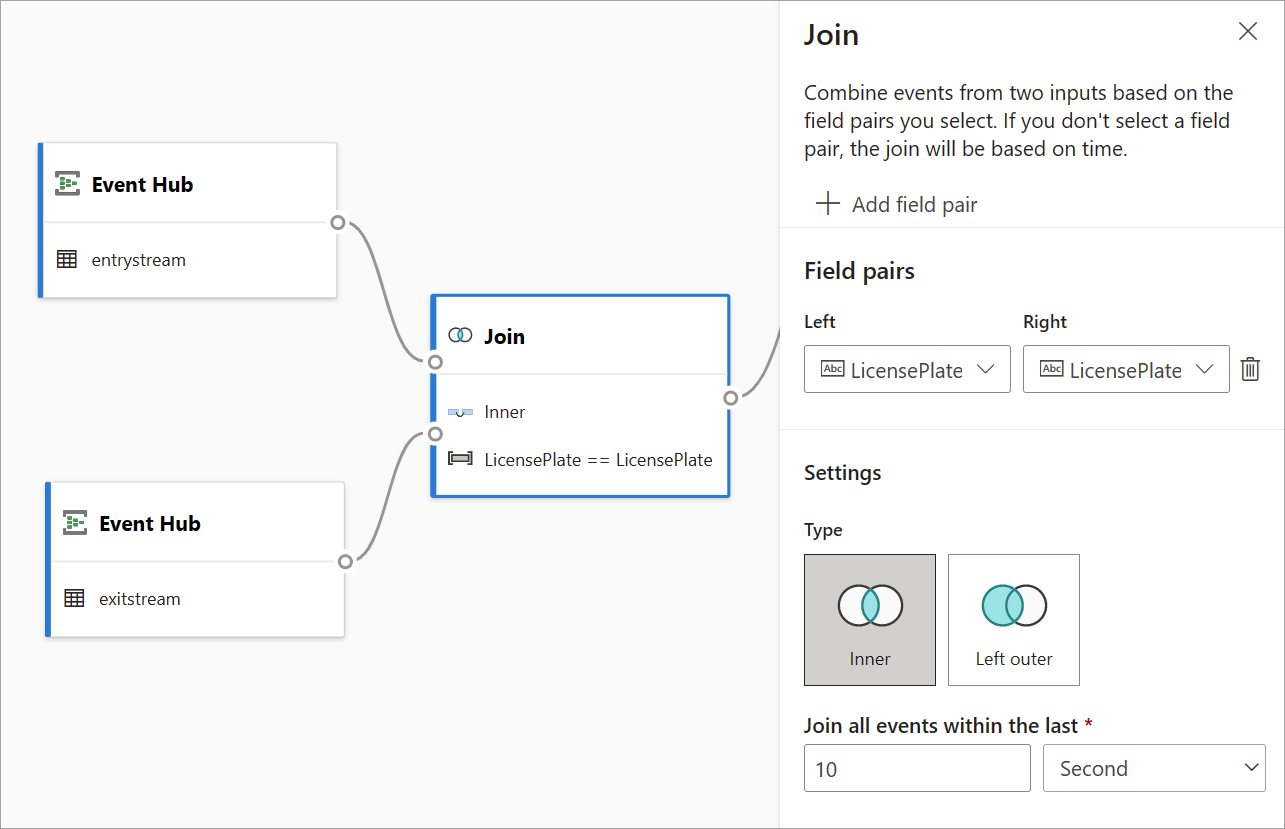

Join

Verwenden Sie die Join-Transformation, um Ereignisse aus zwei Eingaben basierend auf den von Ihnen ausgewählten Feldpaaren zu kombinieren. Wenn Sie kein Feldpaar auswählen, basiert der Join standardmäßig auf der Zeit. Standardmäßig unterscheidet sich diese Transformation von einer Batch-Transformation.

Wie bei regulären Joins haben Sie unterschiedliche Optionen für Ihre Verknüpfungslogik:

- Innerer Join: Enthält nur Datensätze aus beiden Tabellen, in denen das Paar übereinstimmt. In diesem Beispiel also die Fälle, in denen das Nummernschild mit beiden Eingaben übereinstimmt.

- Linker äußerer Join: Eingeschlossen sind alle Datensätze aus der linken (ersten) Tabelle und nur die Datensätze aus der zweiten, die dem Feldpaar entsprechen. Wenn keine Übereinstimmung besteht, sind die Felder aus der zweiten Eingabe leer.

Wählen Sie zum Aufrufen des Verknüpfungstyps im Seitenbereich das Symbol für den gewünschten Typ aus.

Wählen Sie abschließend aus, für welchen Zeitraum die Verknüpfung berechnet werden soll. In diesem Beispiel berücksichtigt der Join die letzten 10 Sekunden. Je länger der Zeitraum ist, desto seltener erfolgt die Ausgabe und desto mehr Verarbeitungsressourcen werden für die Transformation aufgewendet.

Standardmäßig sind alle Felder aus beiden Tabellen enthalten. Die Präfixe links (erster Knoten) und rechts (zweiter Knoten) in der Ausgabe helfen ihnen, die Quelle unterscheiden zu können.

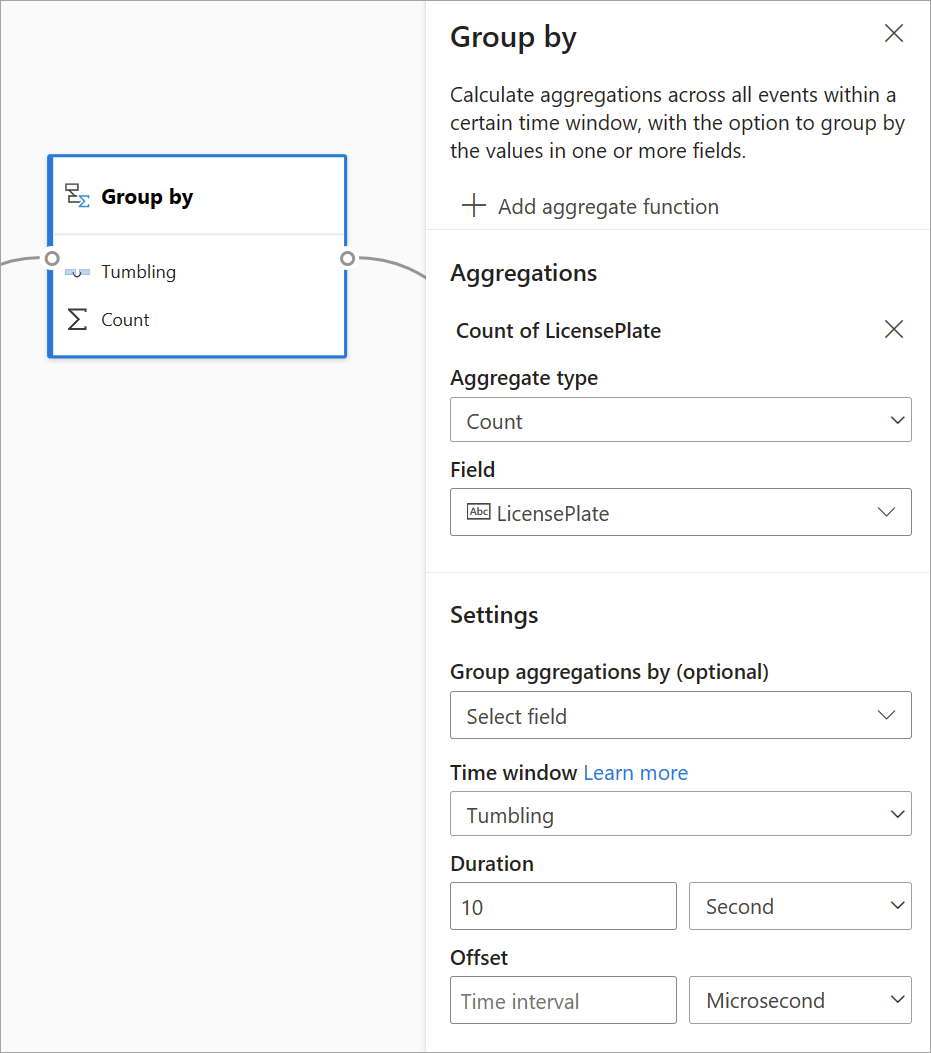

Gruppieren nach

Verwenden Sie die Gruppieren nach-Transformation, um Aggregationen für alle Ereignisse innerhalb eines bestimmten Zeitfensters zu berechnen. Sie können die Ansicht nach den Werten in einem oder mehreren Feldern gruppieren. Dies ähnelt der Aggregattransformation, bietet jedoch weitere Optionen für Aggregationen. Es stehen auch komplexere Zeitfensteroptionen zur Verfügung. Ebenfalls ähnlich wie bei der Aggregation können Sie pro Transformation mehrere Aggregationen hinzufügen.

Die in dieser Transformation verfügbaren Aggregationen sind: Durchschnitt, Anzahl, Maximum, Minimum, Quantil (kontinuierlich und diskret), Standardabweichung, Summe und Varianz.

Um diese Transformation zu konfigurieren:

- Wählen Sie Ihre bevorzugte Aggregation aus.

- Wählen Sie das Feld aus, für das Sie die Aggregation durchführen möchten.

- Wählen Sie ein optionales „Gruppieren nach“-Feld aus, wenn Sie die Aggregatberechnung über eine andere Dimension oder Kategorie (z. B. State) erhalten möchten.

- Wählen Sie Ihre Funktion für die Zeitfenster aus.

Um der gleichen Transformation eine weitere Aggregation hinzuzufügen, wählen Sie Aggregatfunktion hinzufügen aus. Beachten Sie, dass sich das Feld Gruppieren nach und die Zeitfensterfunktion auf alle in der Transformation enthaltenen Aggregationen beziehen.

Ein Zeitstempel für das Ende des Zeitfensters wird zur Referenz als Teil der Transformationsausgabe bereitgestellt.

In einem Abschnitt weiter unten in diesem Artikel werden die einzelnen Zeitfenstertypen erläutert, die für diese Transformation verfügbar sind.

Union

Mithilfe von Union-Transformation können Sie zwei oder mehr Eingaben verbinden, um Ereignisse mit gemeinsamen Feldern (mit dem gleichen Namen und Datentyp) in eine Tabelle einzufügen. Felder, die nicht übereinstimmen, werden verworfen und sind nicht in der Ausgabe enthalten.

Einrichten von Zeitfensterfunktionen

Zeitfenster sind eines der komplexesten Konzepte beim Streamen von Daten. Dieses Konzept steht im Mittelpunkt der Streaminganalyse.

Mit Streaming-Dataflows können Sie Zeitfenster einrichten, wenn Sie Daten als Option für die Gruppieren nach-Transformation aggregieren.

Hinweis

Beachten Sie, dass alle Ausgabeergebnisse für Fenstervorgänge am Ende des Zeitfensters berechnet werden. Die Ausgabe des Fensters ist ein einzelnes Ereignis, das auf der Aggregatfunktion basiert. Dieses Ereignis weist den Zeitstempel auf, der dem Ende des Fensters entspricht, und alle Fensterfunktionen werden mit einer festen Länge definiert.

Es stehen fünf Arten von Zeitfenstern zur Auswahl: „Rollierend“, „Springend“, „Gleitend“, „Sitzung“ und „Momentaufnahme“.

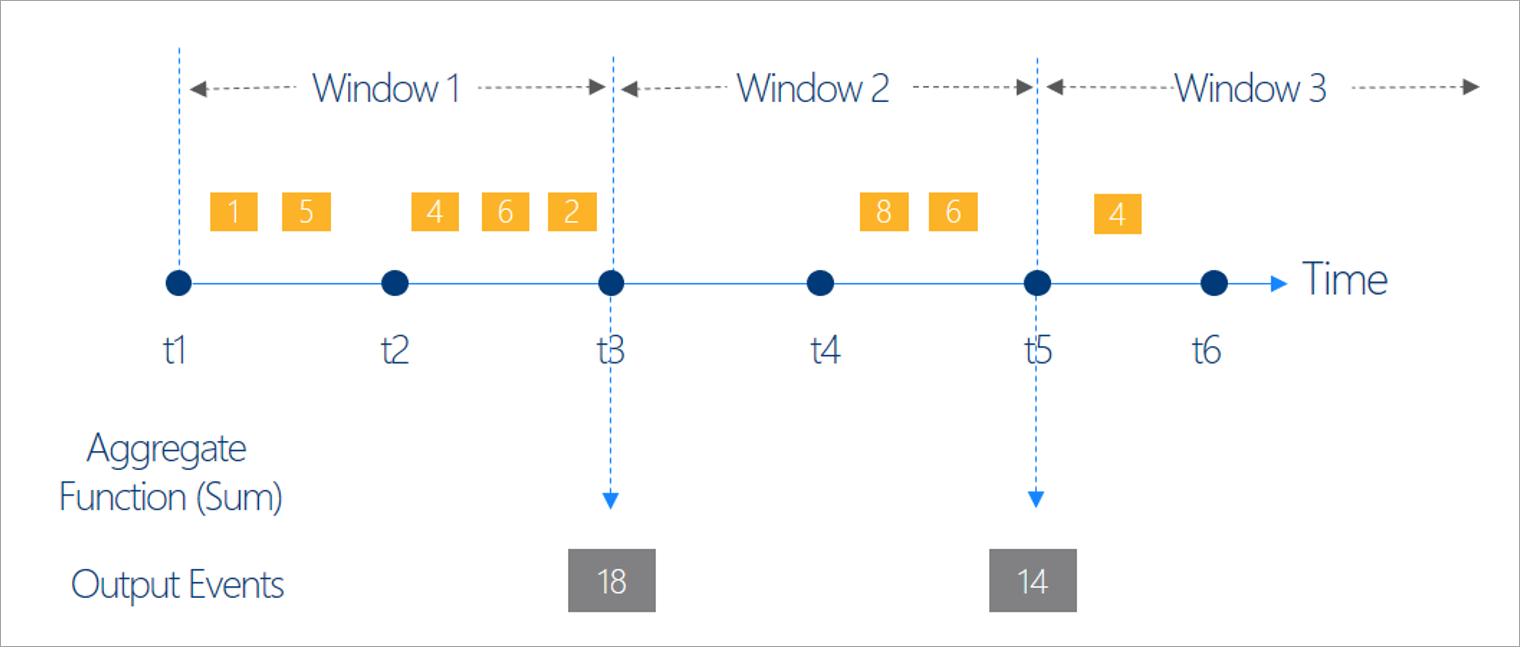

Rollierendes Fenster

„Rollierend“ ist der gebräuchlichste Zeitfenstertyp. Rollierende Fenster sind im wesentlichen dadurch gekennzeichnet, dass sie sich wiederholen, dieselbe Zeitlänge haben und sich nicht überlappen. Ein Ereignis darf nicht zu mehr als einem rollierendem Fenster gehören.

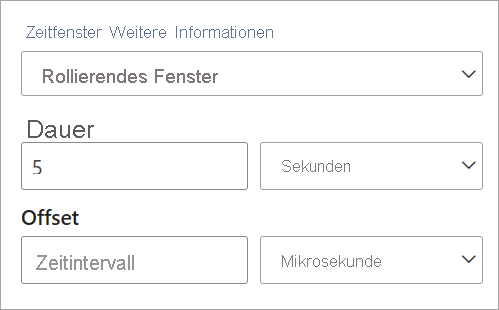

Beim Einrichten eines rollierenden Fensters in Streaming-Dataflows müssen Sie die Dauer des Fensters angeben (in diesem Fall für alle Fenster gleich). Sie können auch einen optionalen Offset angeben. In der Standardeinstellung schließen die rollierenden Fenster das Fensterende ein und den Anfang aus. Sie können diesen Parameter verwenden, um dieses Verhalten zu ändern, die Ereignisse am Anfang des Fensters einzuschließen und die Ereignisse am Ende auszuschließen.

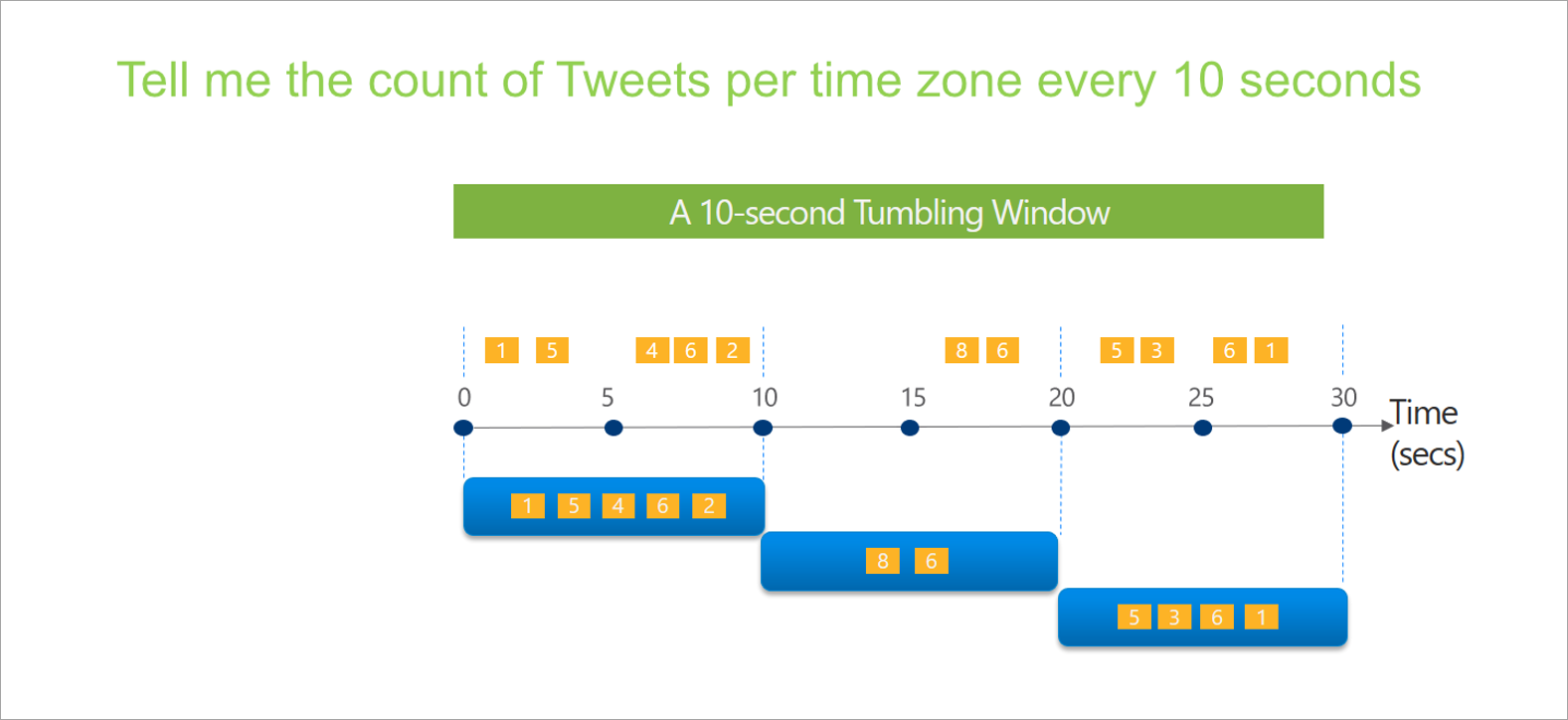

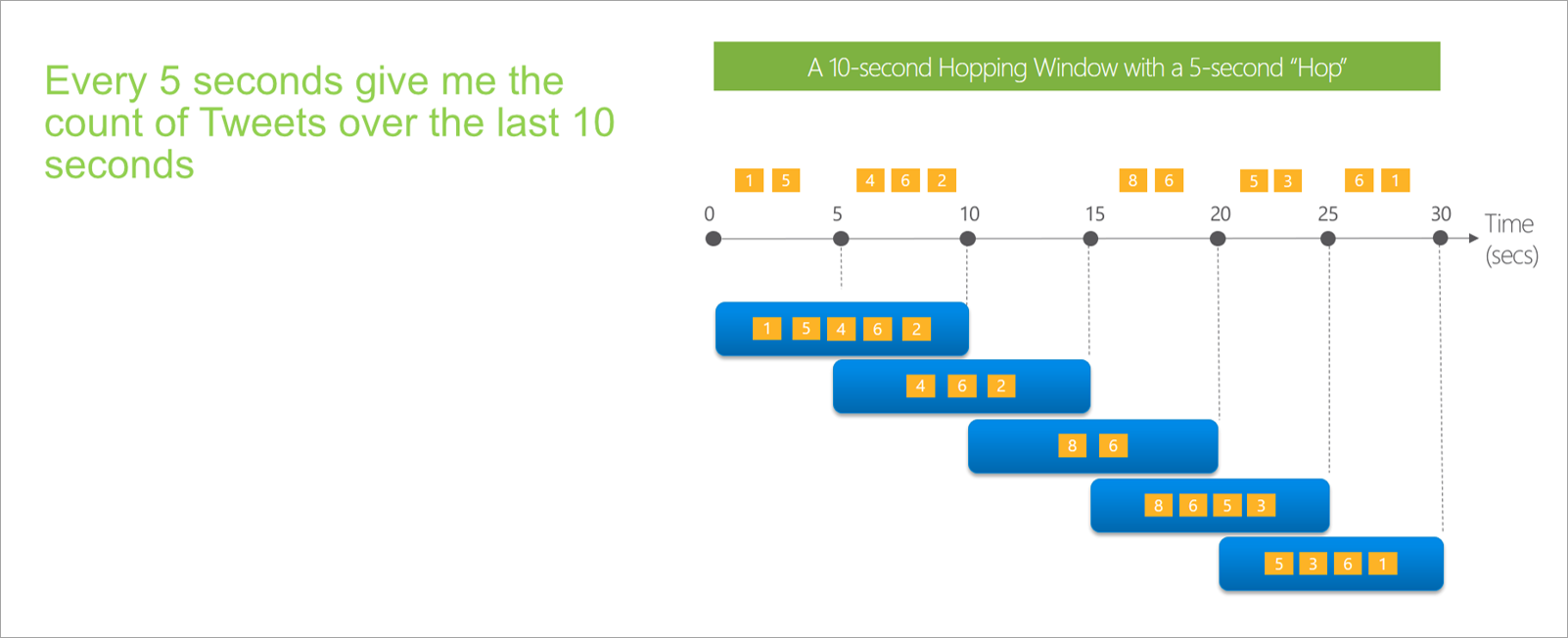

Springendes Fenster

Springende Fenster „springen“ im Zeitverlauf um einen festen Zeitraum vorwärts. Sie können sich dies wie rollierende Fenster vorstellen, die sich überlappen können und häufiger als die Fenstergröße ausgegeben werden. Ereignisse können zu mehr als einem Ergebnisset für ein springendes Fenster gehören. Wenn Sie ein springendes Fenster an ein rollierendes Fenster angleichen möchten, geben Sie die Sprunggröße als gleich der Fenstergröße an.

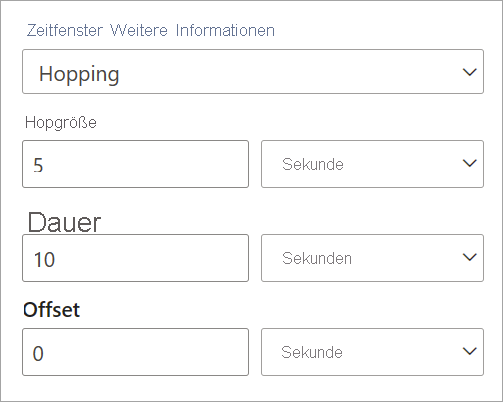

Beim Einrichten eines springenden Fensters in Streaming-Dataflows müssen Sie die Dauer des Fensters angeben (ebenso wie für rollierende Fenster). Darüber hinaus müssen Sie die Sprunggröße angeben, die Streaming-Dataflows mitteilt, wie oft die Aggregation für die definierte Dauer berechnet werden soll.

Der Offset-Parameter ist aus demselben Grund wie bei den rollierenden Fenstern auch bei den Sprungfenstern verfügbar. Er definiert die Logik für die Aufnahme und den Ausschluss von Ereignissen für den Beginn und das Ende des springenden Fensters.

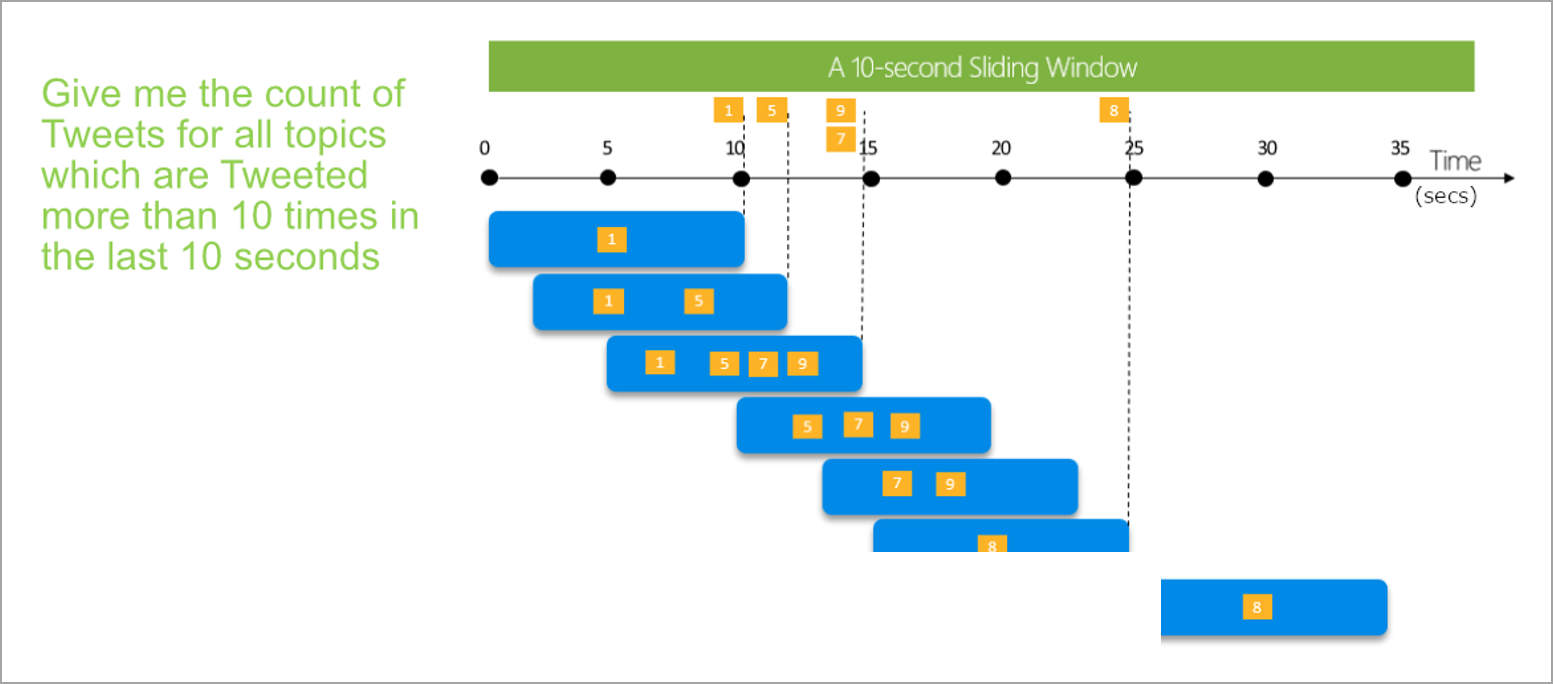

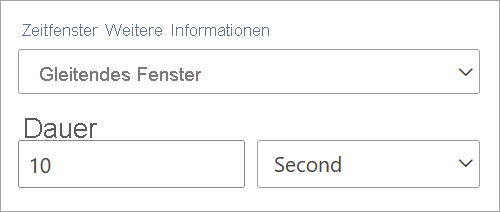

Gleitendes Fenster

Gleitende Fenster berechnen im Gegensatz zu rollierenden oder springenden Fenstern die Aggregation nur für Zeitpunkte, an denen sich der Inhalt des Fensters tatsächlich ändert. Wenn ein Ereignis in das Fenster ein- oder aus ihm austritt, wird die Aggregation berechnet. Jedes Fenster verfügt also über mindestens ein Ereignis. Ähnlich wie bei springenden Fenstern können Ereignisse zu mehr als einem gleitenden Fenster gehören.

Der einzige Parameter, den Sie für ein gleitendes Fenster benötigen, ist die Dauer, da Ereignisse selbst definieren, wann das Fenster gestartet wird. Es ist keine Offsetlogik erforderlich.

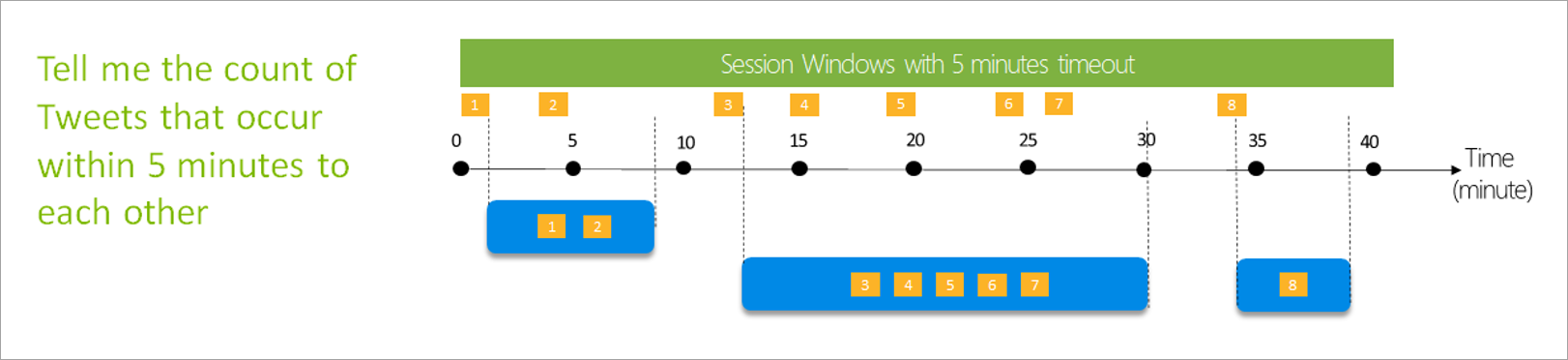

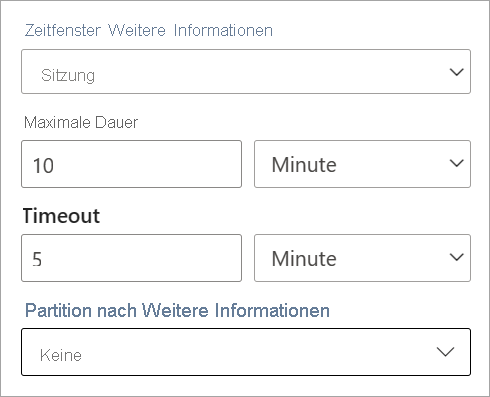

Sitzungsfenster

Sitzungsfenster sind der komplexeste Typ. Mit ihrer Hilfe werden Ereignisse gruppiert, die zu ähnlichen Zeiten eingehen. Zeiträume, in denen keine Daten anfallen, werden herausgefiltert. Für dieses Fenster sind die folgenden Informationen bereitzustellen:

- Timeout: d. h. wie lange gewartet werden soll, wenn keine neuen Daten vorhanden sind.

- Maximale Dauer: die längste Zeit, für die die Aggregation berechnet wird, wenn ständig neue Daten ankommen.

Bei Bedarf können Sie auch eine Partition definieren.

Sie richten ein Sitzungsfenster direkt im Seitenbereich für die Transformation ein. Wenn Sie eine Partition angeben, gruppiert die Aggregation nur Ereignisse für den gleichen Schlüssel zusammen.

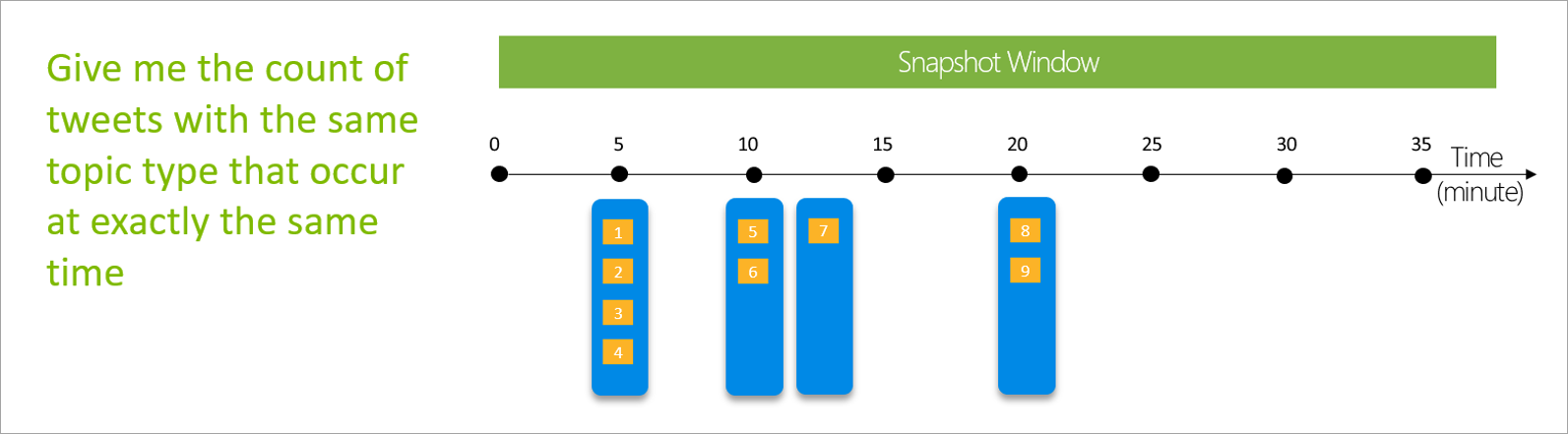

Momentaufnahmefenster

Momentaufnahmefenster gruppieren Ereignisse, die denselben Zeitstempel haben. Im Gegensatz zu anderen Fenstern erfordert eine Momentaufnahme keine Parameter, da sie die Zeit aus dem System verwendet.

Definieren der Ausgaben

Nachdem Sie die Eingaben und Transformationen festgelegt haben, ist es an der Zeit, eine oder mehrere Ausgaben zu definieren. Ab Juli 2021 unterstützen Streaming-Dataflows nur einen Ausgabetyp: Power BI-Tabellen.

Bei dieser Ausgabe handelt es sich um eine Dataflowtabelle (d. h. eine Entität), mit der Sie Berichte in Power BI Desktop erstellen können. Sie müssen die Knoten des vorherigen Schritts mit der erstellten Ausgabe verknüpfen, damit sie funktioniert. Danach sollten Sie die Tabelle benennen.

Nachdem Sie eine Verbindung mit Ihrem Dataflow hergestellt haben, steht Ihnen diese Tabelle zum Erstellen von Visuals für Ihre Berichte zur Verfügung, die in Echtzeit aktualisiert werden.

Datenvorschau und Fehler

Streaming-Dataflows bieten Tools, mit denen Sie Ihre Analysepipeline für Streamingdaten erstellen, sowie Problembehandlung und Leistungsbewertung für sie ausführen können.

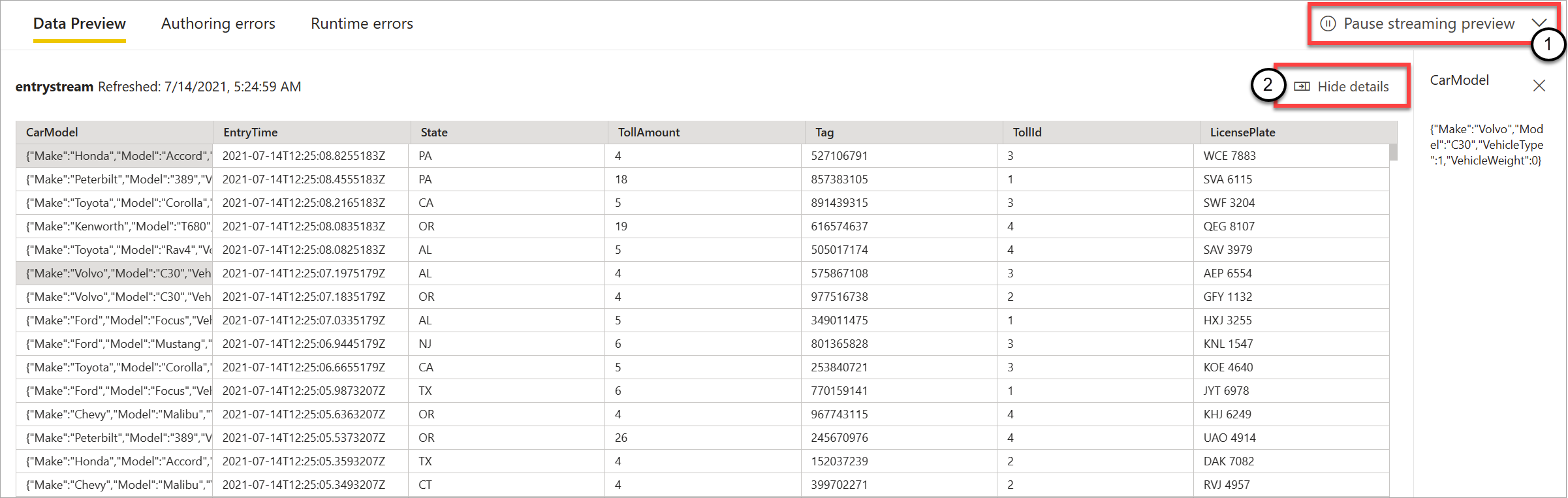

Livedatenvorschau für Eingaben

Wenn Sie eine Verbindung mit einem Event Hub oder IoT Hub herstellen und dessen Karte in der Diagrammansicht (Registerkarte Datenvorschau) auswählen, erhalten Sie eine Livevorschau der eintreffenden Daten, wenn alle folgenden Punkte zutreffen:

- Daten werden per Push übertragen.

- Die Eingabe ist ordnungsgemäß konfiguriert.

- Felder wurden hinzugefügt.

Wie im folgenden Screenshot zu sehen, können Sie die Vorschau (1) anhalten, wenn Sie etwas Bestimmtes anzeigen oder einen Drilldown ausführen möchten. Oder Sie können sie erneut starten, wenn Sie fertig sind.

Sie können auch die Details eines bestimmten Datensatzes (eine „Zelle“ in der Tabelle) anzeigen, indem Sie ihn auswählen und dann Details anzeigen oder Details ausblenden (2) auswählen. Der Screenshot zeigt die detaillierte Ansicht eines geschachtelten Objekts in einem Datensatz.

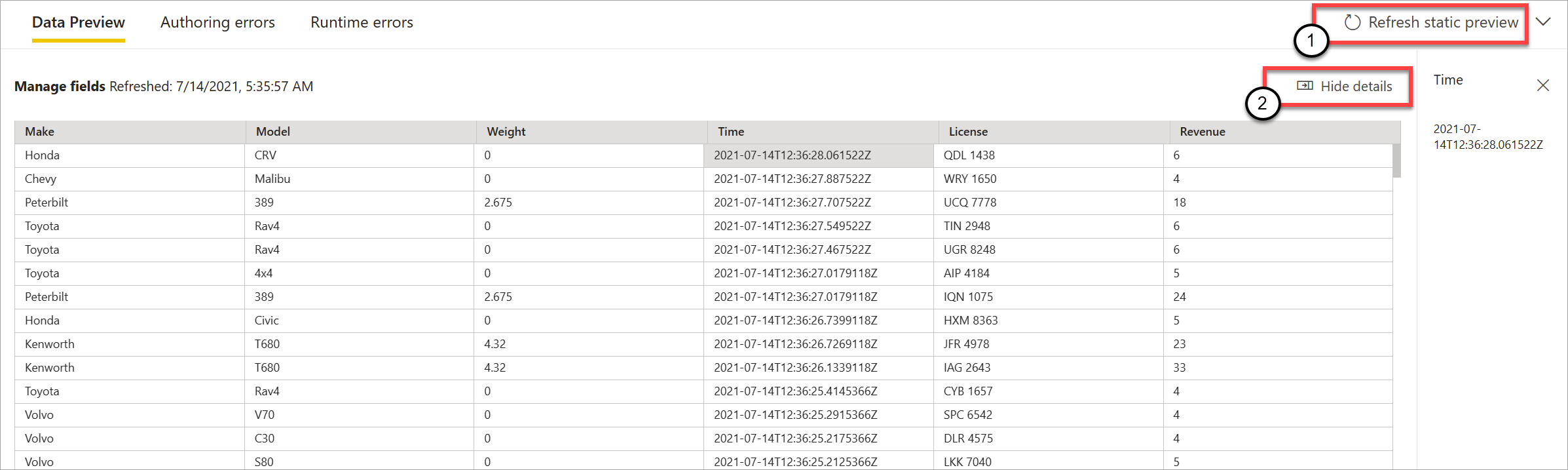

Statische Vorschau für Transformationen und Ausgaben

Nachdem Sie alle benötigten Schritte in der Diagrammansicht hinzugefügt und eingerichtet haben, können Sie das Verhalten testen, indem Sie die Schaltfläche „Statische Daten“ auswählen.

Anschließend werten Streaming-Dataflows alle Transformationen und Ausgaben aus, die ordnungsgemäß konfiguriert sind. Streaming-Dataflows zeigen dann die Ergebnisse in der statischen Datenvorschau an (siehe folgende Abbildung).

Sie können die Vorschau aktualisieren, indem Sie Statische Vorschau aktualisieren (1) auswählen. Wenn Sie dies tun, nehmen Streamingdatenflüsse neue Daten aus der Eingabe und bewerten alle Transformationen und Ausgaben erneut mit allen Aktualisierungen, die Sie ausführen können. Die Option Details ein- bzw. ausblenden ist ebenfalls verfügbar (2).

Erstellungsfehler

Wenn Sie Erstellungsfehler oder Warnungen haben, werden diese auf der Registerkarte Erstellungsfehler (1) aufgeführt, wie im folgenden Screenshot gezeigt. Die Liste enthält Details zum Fehler oder zur Warnung, zum Kartentyp (Eingabe, Transformation oder Ausgabe), zur Fehlerstufe und eine Beschreibung des Fehlers oder der Warnung (2). Wenn Sie einen Fehler oder eine Warnung auswählen, wird die entsprechende Karte ausgewählt, und der Konfigurations-Seitenbereich wird geöffnet, damit Sie die erforderlichen Änderungen vornehmen können.

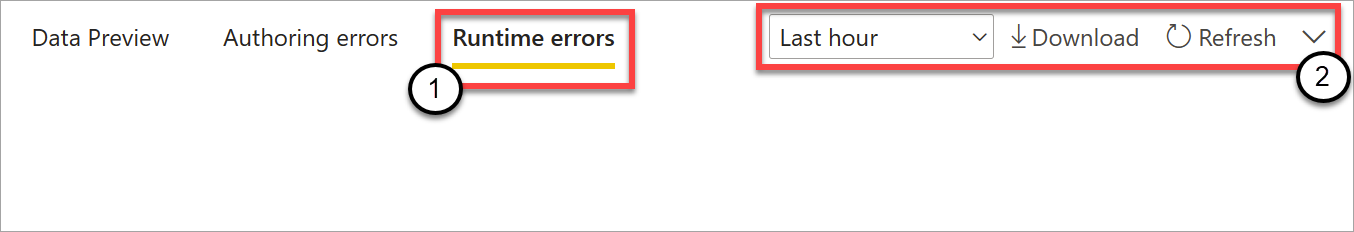

Laufzeitfehler

Die letzte verfügbare Registerkarte in der Vorschau ist Laufzeitfehler (1), wie im folgenden Screenshot gezeigt. Auf dieser Registerkarte werden alle Fehler beim Erfassen und Analysieren des Streaming-Dataflows aufgeführt, nachdem Sie den Prozess gestartet haben. So erhalten Sie möglicherweise einen Laufzeitfehler, wenn eine Nachricht beschädigt ist und der Dataflow sie nicht erfassen und die definierten Transformationen ausführen konnte.

Da Dataflows über einen längeren Zeitraum ausgeführt werden können, bietet diese Tabelle die Möglichkeit, nach Zeitspanne zu filtern sowie die Liste der Fehler herunterzuladen und sie ggf. zu aktualisieren (2).

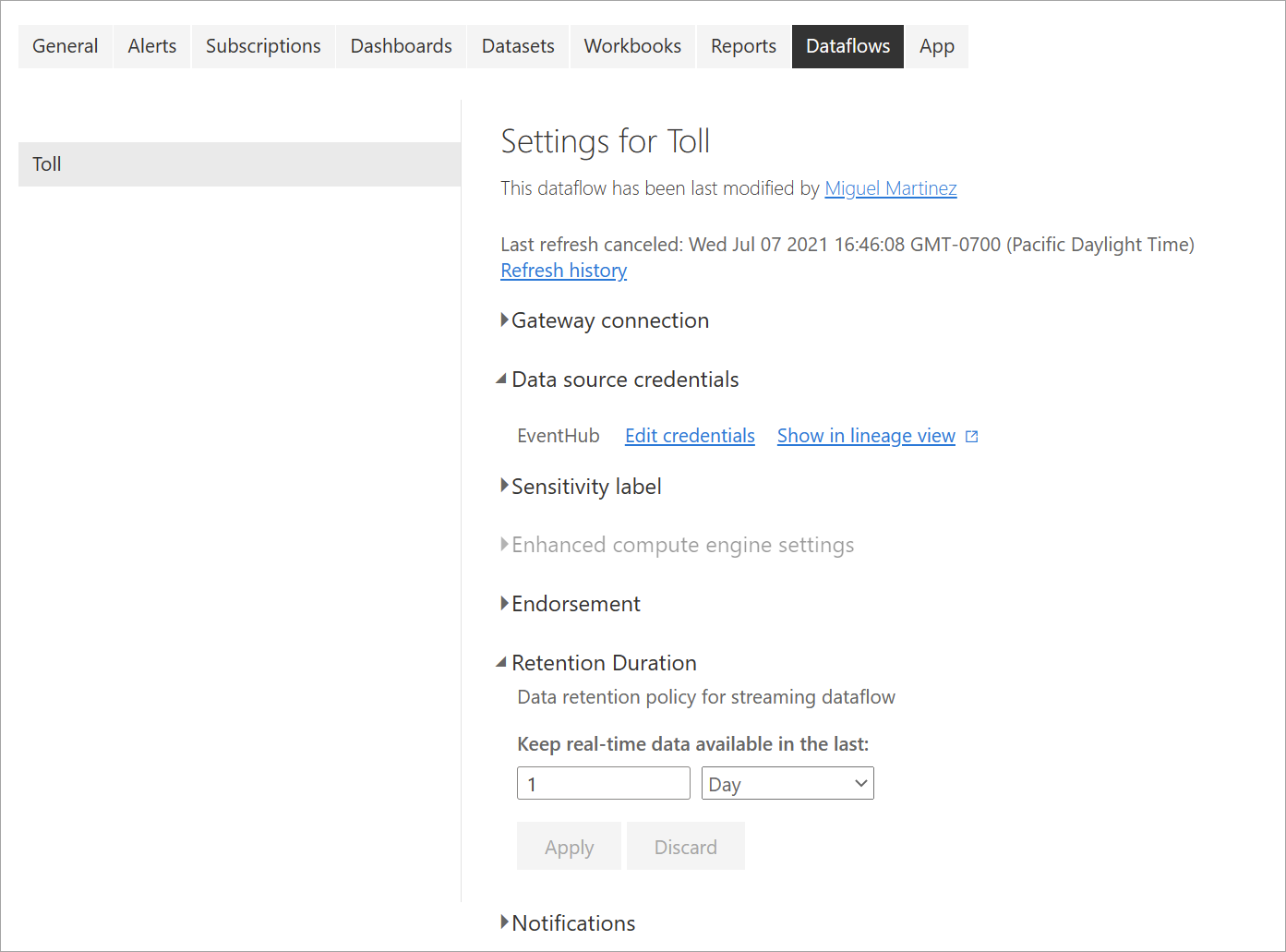

Ändern von Einstellungen für Streaming-Dataflows

Wie für reguläre Dataflows können auch die Einstellungen für Streaming-Dataflows nach den Anforderungen von Besitzern und Autoren geändert werden. Die folgenden Einstellungen gelten nur für Streaming-Dataflows. Im Hinblick auf die verbleibenden Einstellungen können Sie aufgrund der gemeinsamen Infrastruktur der beiden Arten von Dataflows davon ausgehen, dass die Verwendung identisch ist.

Aktualisierungsverlauf: Da Streaming-Dataflows kontinuierlich ausgeführt werden, zeigt der Aktualisierungsverlauf nur Informationen dazu an, wann der Dataflow gestartet wurde, wann er abgebrochen wurde oder wann ein Fehler aufgetreten ist (mit Details und Fehlercodes, falls zutreffend). Diese Informationen ähneln den Informationen, die für reguläre Dataflows angezeigt werden. Sie können diese Informationen verwenden, um Probleme zu beheben oder Power BI Support mit angeforderten Details bereitzustellen.

Anmeldeinformationen für die Datenquelle: Diese Einstellungen zeigen die Eingaben an, die für den spezifischen Streaming-Dataflow konfiguriert wurden.

Erweiterte Compute-Engine-Einstellungen: Streaming-Dataflows benötigen die erweiterte Compute-Engine, um Echtzeitvisuals bereitzustellen, daher ist diese Einstellung standardmäßig aktiviert und kann nicht geändert werden.

Aufbewahrungsdauer: Diese Einstellung ist spezifisch für Streaming-Dataflows. Hier können Sie definieren, wie lange die Echtzeitdaten für die Visualisierung in Berichten aufbewahrt werden sollen. Verlaufsdaten werden standardmäßig in Azure Blob Storage gespeichert. Diese Einstellung ist spezifisch für die Echtzeitseite Ihrer Daten (heißer Speicher). Der Mindestwert beträgt 1 Tag oder 24 Stunden.

Wichtig

Die Menge der heißen Daten, die bei dieser Aufbewahrungsdauer gespeichert werden, wirkt sich direkt auf die Leistung Ihrer Echtzeitvisuals aus, wenn Sie Berichte auf der Grundlage dieser Daten erstellen. Eine längere Aufbewahrungsdauer kann eine stärkere Beeinträchtigung Ihrer Echtzeit-Visuals in Berichten nach sich ziehen. Wenn Sie eine Verlaufsanalyse durchführen müssen, sollten Sie dafür den kalten Speicher verwenden, der für Streaming-Datafows zur Verfügung steht.

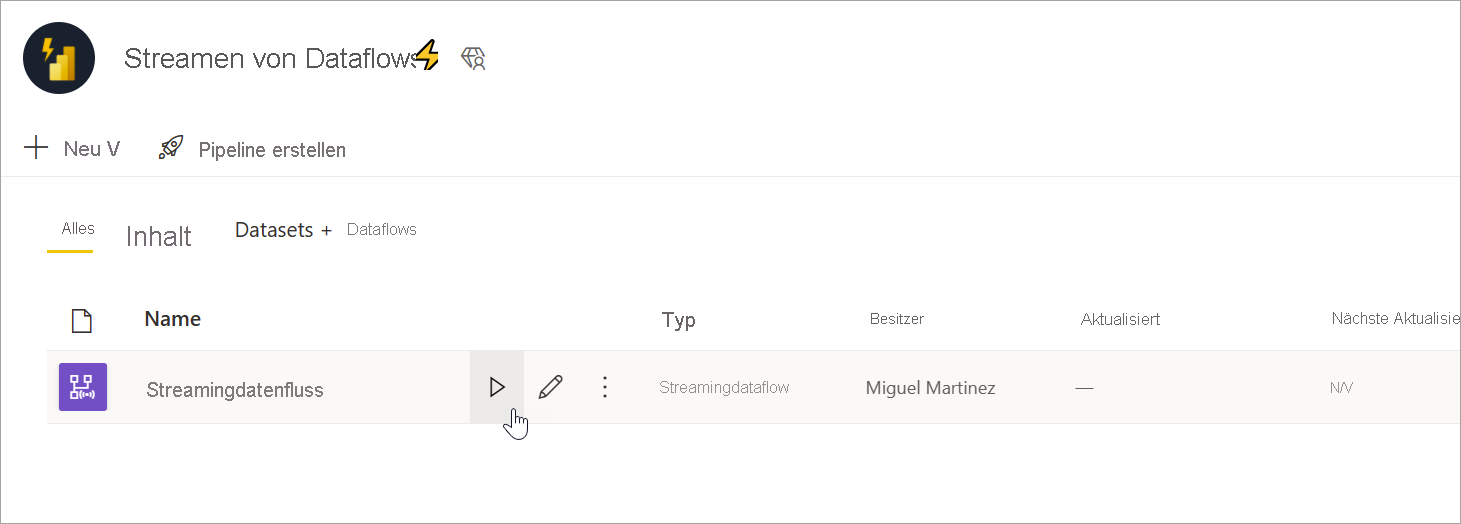

Ausführen und Bearbeiten eines Streaming-Dataflows

Nachdem Sie Ihren Streaming-Dataflow gespeichert und konfiguriert haben, können Sie ihn ausführen. Anschließend können Sie mit der Streaminganalyselogik, die Sie definiert haben, mit der Erfassung von Daten in Power BI beginnen.

Ausführen Ihres Streaming-Dataflows

Um ihren Streaming-Dataflow zu starten, speichern Sie zuerst Ihren Dataflow und wechseln zu dem Arbeitsbereich, in dem Sie ihn erstellt haben. Fahren Sie mit der Maus über den Streaming-Dataflow und wählen Sie die angezeigte Schaltfläche für Wiedergabe aus. Es wird eine Popup-Meldung mit dem Hinweis angezeigt, dass der Streaming-Dataflow gestartet wird.

Hinweis

Es kann bis zu fünf Minuten dauern, bis Daten erfasst werden und Sie eingehende Daten zum Erstellen von Berichten und Dashboards in Power BI Desktop sehen.

Bearbeiten Ihres Streaming-Dataflows

Während ein Streaming-Dataflow ausgeführt wird, kann er nicht bearbeitet werden. Sie können jedoch in einen Streaming-Dataflow wechseln, der sich in einem ausgeführten Zustand befindet, und sich die Analyselogik anzeigen lassen, auf der der Dataflow basiert.

Wenn Sie zu einem ausgeführten Streaming-Dataflow wechseln, werden alle Bearbeitungsoptionen deaktiviert und es wird eine Meldung angezeigt: „Der Dataflow kann nicht bearbeitet werden, während er ausgeführt wird. Beenden Sie den Dataflow, wenn Sie fortfahren möchten.“ Die Datenvorschau wird ebenfalls deaktiviert.

Um Ihren Streaming-Dataflow zu bearbeiten, müssen Sie ihn beenden. Ein beendeter Dataflow führt zu fehlenden Daten.

Die einzige verfügbare Benutzeroberfläche während der Ausführung eines Streaming-Dataflows sind Laufzeitfehler, bei denen Sie das Verhalten ihres Dataflows auf gelöschte Nachrichten und ähnliche Situationen hin überwachen können.

Denken Sie beim Bearbeiten Ihres Dataflows an die Datenspeicherung.

Wenn Sie einen Dataflow bearbeiten, müssen Sie einige andere Überlegungen berücksichtigen. Ähnlich wie bei Änderungen am Schema von regulären Dataflows führen Änderungen an einer Ausgabetabelle zum Verlust von Daten, die bereits per Push an Power BI übertragen und dort gespeichert wurden. Die Schnittstelle bietet klare Informationen zu den Folgen dieser Änderungen in Ihrem Streaming-Dataflow sowie Auswahlmöglichkeiten für Änderungen, die Sie vor dem Speichern vornehmen.

Dies lässt sich besser an einem Beispiel zeigen. Der folgende Screenshot zeigt die Meldung, die Sie nach dem Hinzufügen einer Spalte zu einer Tabelle, dem Ändern eines Namens für eine zweite Tabelle und Belassen einer dritten Tabelle ohne Änderungen erhalten würden.

In diesem Beispiel werden die in beiden Tabellen mit Schema- und Namensänderungen bereits gespeicherten Daten gelöscht, wenn Sie die Änderungen speichern. Für die Tabelle, die unverändert geblieben ist, erhalten Sie die Möglichkeit, alle alten Daten zu löschen und von Grund auf neu zu beginnen oder sie für die spätere Analyse zusammen mit neuen eingehenden Daten zu speichern.

Beachten Sie diese Feinheiten beim Bearbeiten Ihres Streaming-Dataflows, insbesondere wenn Sie später zur weiteren Analyse Verlaufsdaten benötigen.

Nutzen eines Streaming-Dataflows

Sobald Ihr Streaming-Dataflow ausgeführt wird, können Sie mit dem Erstellen von Inhalten beginnen, die auf Ihren Streamingdaten basieren. Es gibt keine strukturellen Änderungen im Vergleich zu dem, was Sie zur Erstellung von Berichten tun müssen, die in Echtzeit aktualisiert werden. Es müssen einige Nuancen und Updates berücksichtigt werden, sodass Sie diese neue Art der Datenaufbereitung für Streamingdaten nutzen können.

Einrichten des Datenspeichers

Wie bereits erwähnt, speichern Streaming-Dataflows Daten an den zwei folgenden Speicherorten. Die Verwendung dieser Quellen hängt davon ab, welche Art von Analyse Sie durchführen möchten.

- Hot Storage (Echtzeitanalyse): Wenn Daten aus Streaming-Dataflows bei Power BI eingehen, werden die Daten an einem heißen Speicherort gespeichert, auf den Sie mit Echtzeitvisuals zugreifen können. Wie viele Daten in diesem Speicher gespeichert werden, hängt von dem Wert ab, den Sie für die Aufbewahrungsdauer in den Streaming-Dataflow-Einstellungen definiert haben. Der Standardwert (und Mindestwert) beträgt 24 Stunden.

- Cold Storage (Verlaufsanalyse) : Jeder Zeitraum, der nicht in den von Ihnen für die Aufbewahrungsdauer definierten Zeitraum fällt, wird in Power BI in Cold Storage (Blobs) gespeichert, damit Sie ihn bei Bedarf nutzen können.

Hinweis

Es gibt Überschneidungen zwischen diesen beiden Datenspeicherorten. Wenn Sie beide Standorte zusammen verwenden müssen (z. B. Änderung des Prozentsatzes im Vortagesvergleich), müssen Sie Ihre Datensätze möglicherweise deduplizieren. Dies hängt von den von Ihnen durchgeführten Zeitintelligenzberechnungen und der Aufbewahrungsrichtlinie ab.

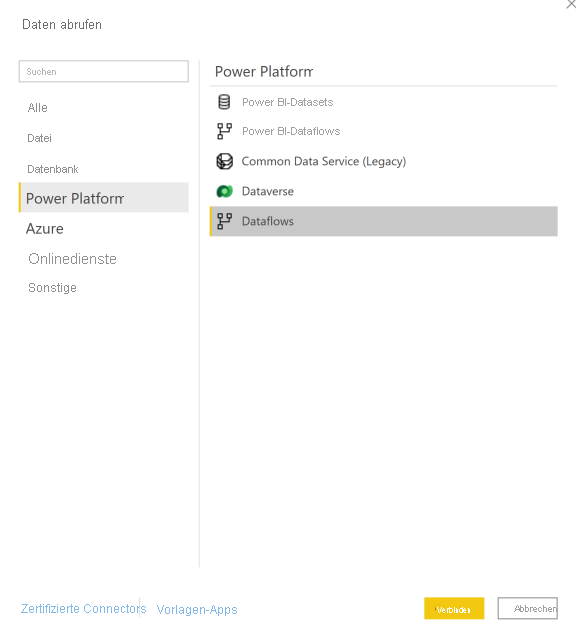

Herstellen einer Verbindung mit Streaming-Dataflows über Power BI Desktop

Power BI Desktop bietet einen Konnektor namens Dataflows, den Sie verwenden können. Als Teil dieses Connectors werden für den Streaming-Dataflows zwei Tabellen angezeigt, die den zuvor beschriebenen Datenspeicherorten entsprechen.

So stellen Sie eine Verbindung mit den Daten Ihres Streaming-Dataflows her:

Wechseln Sie zu Daten abrufen, wählen Sie Power Platform und dann den Connector Dataflows aus.

Melden Sie sich mit Ihren Power BI-Anmeldeinformationen an.

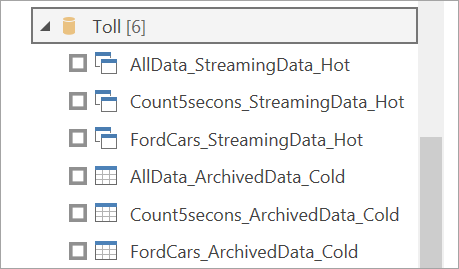

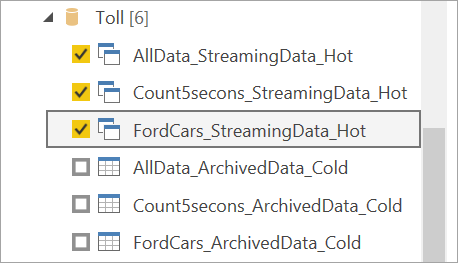

Wählen Sie Arbeitsbereiche aus. Suchen Sie nach dem Arbeitsbereich, der Ihren Streaming-Dataflow enthält, und wählen Sie diesen Dataflow aus. (In diesem Beispiel heißt der Streaming-Dataflow Toll.)

Beachten Sie, dass alle Ausgabetabellen zweimal angezeigt werden: einmal für Streamingdaten (heiß) und einmal für archivierte Daten (kalt). Sie können sie anhand der Bezeichnungen, die hinter den Tabellennamen angefügt wurden, und den Symbolen unterscheiden.

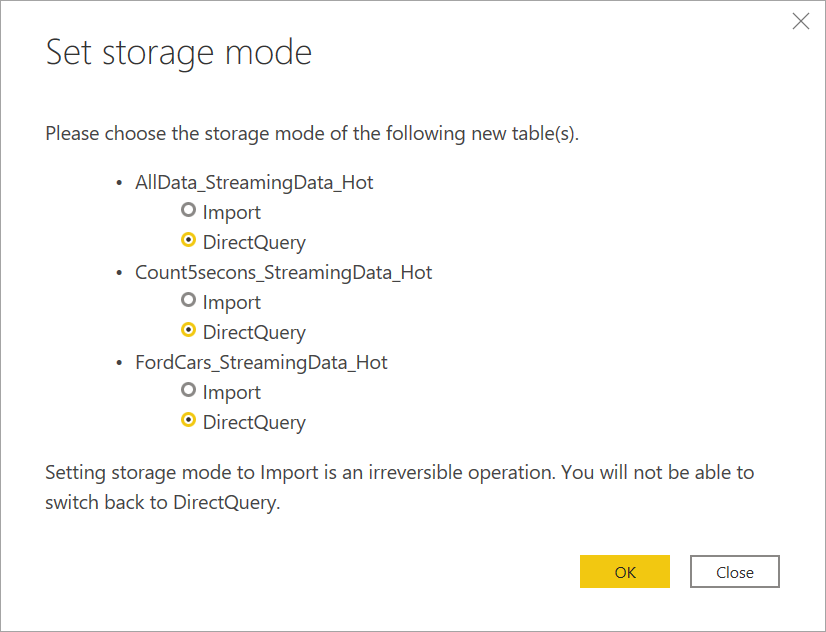

Stellen Sie eine Verbindung zu den Streamingdaten her. Der Vorgang ist für archivierte Daten der gleiche, mit dem Unterschied, dass sie nur im Importmodus verfügbar sind. Wählen Sie die Tabellen aus, die die Bezeichnungen Streaming und Heiß enthalten, und wählen Sie dann Laden aus.

Wenn Sie aufgefordert werden, einen Speichermodus auszuwählen, wählen Sie DirectQuery aus, wenn Sie Echtzeitvisuals erstellen möchten.

Mithilfe der in Power BI Desktop verfügbaren Funktionen können Sie nun Visuals, Measures und weitere Elemente erstellen.

Hinweis

Der reguläre Power BI-Dataflow-Connector ist weiterhin verfügbar und funktioniert mit Streaming-Dataflows, jedoch mit zwei Einschränkungen:

- Er ermöglicht Ihnen nur Verbindungen mit der heißen Speicherebene.

- Die Datenvorschau im Connector funktioniert für Streaming-Dataflows nicht.

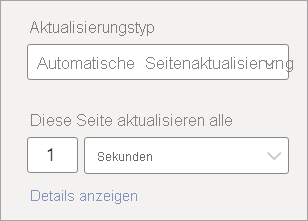

Aktivieren der automatischen Seitenaktualisierung für Echtzeit-Visuals

Sobald Ihr Bericht bereit ist und Sie alle Inhalte hinzugefügt haben, die Sie freigeben möchten, müssen Sie nur noch sicherstellen, dass Ihre Visuals in Echtzeit aktualisiert werden. Sie können ein Feature mit dem Namen automatische Seitenaktualisierung verwenden. Dieses Feature ermöglicht es Ihnen, Visuals aus einer DirectQuery-Quelle im Abstand von einer Sekunde zu aktualisieren.

Weitere Informationen zu diesem Feature finden Sie unter Automatische Seitenaktualisierung in Power BI. Dieser Artikel enthält Informationen zur Verwendung und Einrichtung des Features sowie zur Kontaktaufnahme mit Ihrem Administrator im Falle von Problemen. Im Folgenden finden Sie die Grundlagen zur Einrichtung:

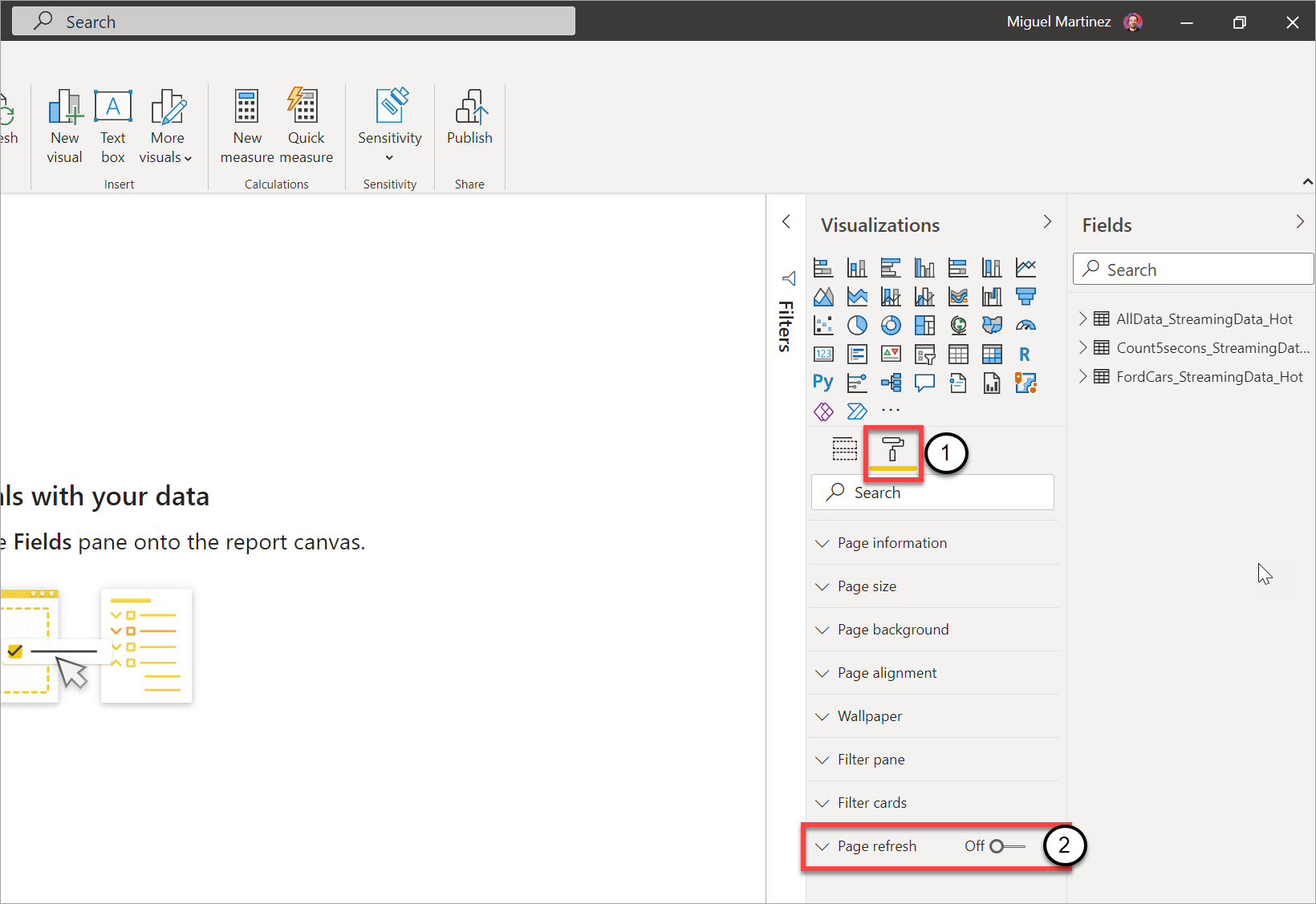

Wechseln Sie zur Berichtsseite, auf der die Visuals in Echtzeit aktualisiert werden sollen.

Löschen Sie alle Visualisierungen auf der Seite. Wählen Sie nach Möglichkeit den Hintergrund der Seite aus.

Wechseln Sie in den Formatbereich (1) und aktivieren Sie Seite aktualisieren (2).

Richten Sie die gewünschte Häufigkeit ein (bis zu einmal pro Sekunde, wenn Ihr Administrator dies zugelassen hat).

Um einen Echtzeitbericht freizugeben, veröffentlichen Sie diesen zuerst wieder im Power BI-Dienst. Anschließend können Sie Ihre Dataflow-Anmeldeinformationen für das Semantikmodell einrichten und freigeben.

Tipp

Wenn sich Ihr Bericht nicht in Echtzeit bzw. wie gewünscht aktualisiert, lesen Sie bitte die Dokumentation zur automatischen Seitenaktualisierung durch. Befolgen Sie die Anweisungen in den FAQs bzw. zur Problembehandlung, um herauszufinden, warum dieses Problem möglicherweise auftritt.

Überlegungen und Einschränkungen

Allgemeine Einschränkungen

- Ein Power BI Premium-Abonnement (Kapazität oder Premium-Einzelbenutzer) ist zum Erstellen und Ausführen von Streaming-Dataflows erforderlich.

- Pro Arbeitsbereich ist nur ein Dataflowtyp zulässig.

- Das Verknüpfen von regulären und Streaming-Dataflows ist nicht möglich.

- Kapazitäten, die kleiner als A3 sind, lassen die Verwendung von Streaming-Dataflows nicht zu.

- Wenn in einem Mandanten Dataflows oder die erweiterte Berechnungs-Engine nicht aktiviert sind, können Sie keine Streaming-Dataflows erstellen oder ausführen.

- Arbeitsbereiche, die mit einem Speicherkonto verbunden sind, werden nicht unterstützt.

- Jeder Streaming-Dataflow kann einen Durchsatz von bis zu 1 MB pro Sekunde bereitstellen.

Verfügbarkeit

Die Vorschau für Streaming-Dataflows ist in den folgenden Regionen nicht verfügbar:

- Indien, Mitte

- Deutschland, Norden

- Norwegen, Osten

- Norwegen, Westen

- VAE, Mitte

- Südafrika, Norden

- Südafrika, Westen

- Schweiz, Norden

- Schweiz, Westen

- Brasilien, Südosten

Lizenzierung

Die Anzahl der pro Mandant zulässigen Streaming-Dataflows hängt von der verwendeten Lizenz ab:

Für reguläre Kapazitäten: Verwenden Sie die folgende Formel zur Berechnung der maximalen Anzahl von Streaming-Dataflows, die in einer Kapazität zulässig sind:

Maximale Anzahl Streaming-Dataflows pro Kapazität = virtuelle Kerne in der Kapazität, multipliziert mit 5

Zum Beispiel verfügt P1 über 8 virtuelle Kerne: 8 * 5 = 40 Streaming-Dataflows.

Für Premium-Einzelbenutzer ist pro Benutzer ein Streaming-Dataflow zulässig. Wenn ein weiterer Benutzer einen Streaming-Dataflow in einem Premium-Einzelbenutzer-Arbeitsbereich nutzen möchte, benötigt er ebenfalls eine Premium-Einzelbenutzerlizenz.

Dataflowerstellung

Berücksichtigen Sie bei der Erstellung von Streaming-Dataflows folgende Überlegungen:

- Der Besitzer eines Streaming-Dataflows kann nur Änderungen vornehmen, und er kann die Änderungen nur dann vornehmen, wenn der Dataflow nicht ausgeführt wird.

- Streaming-Dataflows sind nicht unter Mein Arbeitsbereich verfügbar.

Herstellen einer Verbindung von Power BI Desktop aus

Sie können auf Cold Storage nur mithilfe des Connectors Dataflows zugreifen, der ab dem Power BI Desktop-Update vom Juli 2021 verfügbar ist. Die vrühere Version des Power BI Dataflow-Connectors lässt nur Verbindungen mit dem Streamingdatenspeicher (hot) zu. Die Datenvorschau des Connectors funktioniert nicht.

Zugehöriger Inhalt

In diesem Artikel haben Sie erfahren, wie Sie Self-Service-Streamingdaten mithilfe von Streaming-Dataflows aufbereiten. Die folgenden Artikel enthalten Informationen zum Testen dieser Funktion und zur Verwendung weiterer Streamingdatenfeatures in Power BI: