Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Die Verwendung von Datenflüssen mit Microsoft Power Platform erleichtert die Datenvorbereitung und ermöglicht es Ihnen, Ihre Datenvorbereitung in nachfolgenden Berichten, Apps und Modellen wiederzuverwenden.

In der Welt der ständig wachsenden Daten kann die Datenvorbereitung schwierig und teuer sein. Es kann bis zu 60 bis 80 Prozent der Zeit und Kosten für ein typisches Analyseprojekt verbrauchen. Solche Projekte können das Bewältigen von fragmentierten und unvollständigen Daten, die Integration komplexer Systeme, Daten mit Strukturinkonsistenz und einen hohen Qualifikationsbedarf erfordern.

Um die Datenvorbereitung zu vereinfachen und Ihnen dabei zu helfen, Mehr Wert aus Ihren Daten zu ziehen, wurden Power Query- und Power Platform-Datenflüsse erstellt.

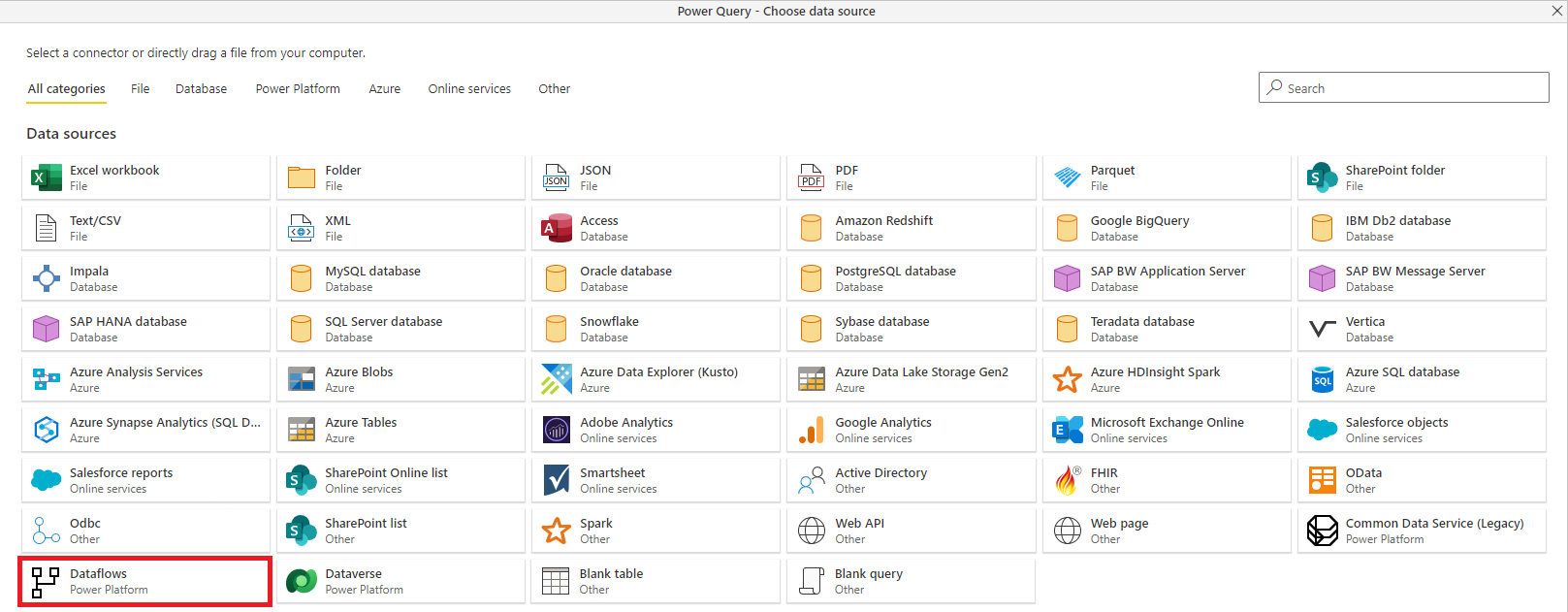

Mit Datenflüssen bringt Microsoft die Self-Service-Datenvorbereitungsfunktionen von Power Query in die Power BI- und Power Apps-Onlinedienste ein und erweitert vorhandene Funktionen auf folgende Weise:

Self-Service-Datenvorbereitung für Big Data mit Dataflows: Dataflows können verwendet werden, um Daten aus einer großen und ständig wachsenden Anzahl von Transaktions- und Beobachtungsquellen auf einfache Weise zu erfassen, zu bereinigen, umzuwandeln, zu integrieren, anzureichern und zu schematisieren, wobei die gesamte Datenaufbereitungslogik berücksichtigt wird. Zuvor konnte die ETL-Logik (Extrahieren, Transformieren, Laden) nur in semantischen Modellen in Power BI enthalten sein, zwischen semantischen Modellen kopiert und an die Verwaltungseinstellungen semantischer Modelle gebunden werden.

Mit Dataflows wird die ETL-Logik zu einem erstklassigen Artefakt innerhalb der Microsoft Power Platform-Dienste erhoben und umfasst dedizierte Erstellungs- und Verwaltungserfahrungen. Business Analysts, BI-Experten und Data Scientists können Datenflüsse verwenden, um die komplexesten Herausforderungen bei der Datenvorbereitung zu bewältigen und auf die Arbeit der anderen aufzubauen, dank eines revolutionären modellgesteuerten Berechnungsmoduls. Diese Engine übernimmt die Transformations- und Abhängigkeitslogik und reduziert den Zeit-, Kosten- und Fachkenntnisaufwand auf einen Bruchteil dessen, was traditionell für diese Aufgaben erforderlich war. Sie können Dataflows erstellen, indem Sie die bekannte Self-Service-Datenvorbereitung von Power Query nutzen. Dataflows werden in App-Arbeitsbereichen oder -Umgebungen in Power BI bzw. Power Apps erstellt und einfach verwaltet, wobei alle Funktionen dieser Dienste genutzt werden können, z. B. die Verwaltung von Berechtigungen und geplante Aktualisierungen.

Laden von Daten in Dataverse oder Azure Data Lake Storage: Je nach Anwendungsfall können Sie die von Power Platform-Dataflows aufbereiteten Daten in Dataverse oder im Azure Data Lake Storage-Konto Ihrer Organisation speichern:

mit Dataverse- können Sie Daten, die von Geschäftsanwendungen verwendet werden, sicher speichern und verwalten. Daten in Dataverse werden in einer Reihe von Tabellen gespeichert. Eine Tabelle ist eine Reihe von Zeilen (früher als Datensätze bezeichnet) und Spalten (früher als Felder/Attribute bezeichnet). Jede Spalte in der Tabelle dient zum Speichern eines bestimmten Datentyps, z. B. Name, Alter, Gehalt usw. Dataverse enthält einen Basissatz von Standardtabellen, die typische Szenarien abdecken, aber Sie können auch benutzerdefinierte Tabellen erstellen, die für Ihre Organisation spezifisch sind, und diese mithilfe von Datenflüssen auffüllen. App-Hersteller können dann Power Apps und Power Automate verwenden, um umfangreiche Anwendungen zu erstellen, die diese Daten verwenden.

Azure Data Lake Storage ermöglicht die Zusammenarbeit mit Personen in Ihrer Organisation mithilfe von Power BI, Azure Data und KI-Diensten oder mithilfe von benutzerdefinierten Branchenanwendungen, die Daten aus dem Data Lake lesen. Datenflüsse, die Daten in ein Azure Data Lake Storage-Konto laden, speichern Daten in Gemeinsamen Datenmodellordnern. Allgemeine Datenmodellordner enthalten schematisierte Daten und Metadaten in einem standardisierten Format, um den Datenaustausch zu erleichtern und die vollständige Interoperabilität zwischen Diensten zu ermöglichen, die Daten produzieren oder nutzen, die im Azure Data Lake Storage-Konto einer Organisation als freigegebene Speicherebene gespeichert sind.

Advanced Analytics und KI mit Azure: Power Platform Dataflows speichern Daten in Dataverse oder Azure Data Lake Storage – was bedeutet, dass Daten, die über Dataflows aufgenommen werden, jetzt für Datentechniker und Datenwissenschaftler verfügbar sind, um das volle Potenzial von Azure Data Services wie Azure Machine Learning, Azure Databricks und Azure Synapse Analytics für fortschrittliche Analysen und KI anzuwenden. Mit dieser Verfügbarkeit können Geschäftsanalysten, Dateningenieure und Data Scientists an den gleichen Daten innerhalb ihrer Organisation zusammenarbeiten.

Unterstützung für allgemeine Datenmodell-: Das allgemeine Datenmodell ist eine Reihe standardisierter Datenschemas und eines Metadatensystems, um die Konsistenz von Daten und deren Bedeutung für Anwendungen und Geschäftsprozesse zu ermöglichen. Dataflows unterstützen das Common Data Model, indem sie eine einfache Zuordnung von Daten in beliebiger Form in die standardmäßigen Common Data Model-Tabellen wie "Konto" und "Kontakt" ermöglichen. Dataflows speichern auch die Daten, sowohl Standard- als auch benutzerdefinierte Tabellen, in schematisierter Common Data Model-Form. Business Analysts können das Standardschema und die semantische Konsistenz nutzen oder ihre Tabellen basierend auf ihren individuellen Anforderungen anpassen. Common Data Model entwickelt sich im Rahmen der Open Data Initiativeweiter.

Dataflow-Funktionen in Microsoft Power Platform-Diensten

Die meisten Datenflussfunktionen sind sowohl in Power Apps als auch in Power BI verfügbar. Dataflows sind im Rahmen der Pläne dieser Dienste verfügbar. Einige Dataflow-Features sind entweder produktspezifisch oder in verschiedenen Produktplänen verfügbar. In der folgenden Tabelle werden Datenflussfunktionen und deren Verfügbarkeit beschrieben.

| Dataflowfunktion | Power Apps | Power BI |

|---|---|---|

| Geplante Aktualisierung | Bis zu 48 pro Tag | Bis zu 48 pro Tag |

| Maximale Aktualisierungszeit pro Tabelle | Bis zu 2 Stunden | Bis zu 2 Stunden |

| Dataflowerstellung mit Power Query Online | Ja | Ja |

| Datenflussverwaltung | Im Power Apps-Verwaltungsportal | Im Power BI-Verwaltungsportal |

| Neue Connectors | Ja | Ja |

| Standardisiertes Schema/integrierte Common Data Model-Unterstützung | Ja | Ja |

| Dataflows-Datenconnector in Power BI Desktop | Für Dataflows mit Azure Data Lake Storage als Ziel | Ja |

| Integration mit dem Azure Data Lake Storage der Organisation | Ja | Ja |

| Integration mit Dataverse | Ja | Nein |

| Mit Dataflow verknüpfte Tabellen | Für Dataflows mit Azure Data Lake Storage als Ziel | Ja |

| Berechnete Tabellen (speicherinterne Transformationen mit M) | Für Dataflows mit Azure Data Lake Storage als Ziel | Nur Power BI Premium |

| Inkrementelle Dataflowaktualisierung | Für Dataflows mit Azure Data Lake Storage als Ziel, erfordert PowerApps Plan2 | Nur Power BI Premium |

| Betrieb auf Power BI Premium-Kapazität / parallele Ausführung von Transformationen | Nein | Ja |

Bekannte Einschränkungen

- Das Kopieren von Datenflüssen als Teil eines Vorgangs " Sicherungs- und Wiederherstellungsumgebungen " wird nicht unterstützt.

- Das Kopieren von Datenflüssen als Teil eines Kopiervorgangs für Power Platform-Umgebungen behält ihre E-Mail-Benachrichtigungseinstellung nicht bei.

- Der Besitzer für einen Dataflow mit einer Verbindung und ein Abfrageparameter würde auch den Parameterwert in einen vorherigen Wert ändern (wenn dieser Wert festgelegt wurde).

Nächste Schritte

Weitere Informationen zu Datenflüssen in Power Apps:

- Self-Service-Datenaufbereitung in Power Apps

- Erstellen und Verwenden von Datenflüssen in Power Apps

- Herstellen einer Verbindung mit Azure Data Lake Storage Gen2 für die Dataflowspeicherung

- Hinzufügen von Daten zu einer Tabelle in Dataverse mithilfe von Power Query-

- Besuchen Sie die Dataflow-Community von Power Apps, und tauschen Sie sich über Ihre Arbeit aus, stellen Sie Fragen oder reichen Sie neue Ideen ein.

- Besuchen Sie das Communityforum von Power Apps, und tauschen Sie sich über Ihre Arbeit aus, stellen Sie Fragen oder reichen Sie neue Ideen ein.

Weitere Informationen zu Datenflüssen in Power BI:

- Self-Service-Datenaufbereitung in Power BI

- Erstellen und Verwenden von Datenflüssen in Power BI

- Whitepaper über Dataflows

- Ausführliches Video zu einer exemplarischen Vorgehensweise für Dataflows

- Besuchen Sie die Dataflows-Community von Power BI, und tauschen Sie sich über Ihre Arbeit aus, stellen Sie Fragen oder reichen Sie neue Ideen ein.

In den folgenden Artikeln finden Sie ausführlichere Informationen zu allgemeinen Nutzungsszenarien für Datenflüsse.

- Verwenden der inkrementellen Aktualisierung mit Dataflows

- Erstellen berechneter Tabellen in Datenflüssen

- Verbindung zu Datenquellen für Dataflows

- Verknüpfen von Tabellen zwischen Datenflüssen

Weitere Informationen zu Common Data Model und dem Standard des Common Data Model-Ordners finden Sie in den folgenden Artikeln: