Σημείωση

Η πρόσβαση σε αυτή τη σελίδα απαιτεί εξουσιοδότηση. Μπορείτε να δοκιμάσετε να συνδεθείτε ή να αλλάξετε καταλόγους.

Η πρόσβαση σε αυτή τη σελίδα απαιτεί εξουσιοδότηση. Μπορείτε να δοκιμάσετε να αλλάξετε καταλόγους.

Το Microsoft Fabric Runtime είναι μια ενσωματωμένη πλατφόρμα Azure που βασίζεται στο Apache Spark, η οποία επιτρέπει την εκτέλεση και διαχείριση των εμπειριών διαχείρισης δεδομένων και επιστήμης δεδομένων. Συνδυάζει βασικά στοιχεία τόσο από εσωτερικές προελεύσεις όσο και από προελεύσεις ανοιχτού κώδικα, παρέχοντας στους πελάτες μια ολοκληρωμένη λύση. Για λόγους ευκολίας, αναφερόμαστε στον χρόνο εκτέλεσης Microsoft Fabric που υποστηρίζεται από το Apache Spark ως Χρόνος εκτέλεσης Fabric.

Κύρια στοιχεία του χρόνου εκτέλεσης Fabric:

Apache Spark - μια ισχυρή κατανεμημένη υπολογιστική βιβλιοθήκη ανοιχτού κώδικα που επιτρέπει εργασίες επεξεργασίας και ανάλυσης δεδομένων μεγάλης κλίμακας. Το Apache Spark παρέχει μια ευέλικτη και υψηλής απόδοσης πλατφόρμα για τη διαχείριση δεδομένων και τις εμπειρίες επιστήμης δεδομένων.

Delta Lake - ένα επίπεδο αποθήκευσης ανοιχτού κώδικα που φέρνει συναλλαγές ACID και άλλα χαρακτηριστικά αξιοπιστίας δεδομένων στο Apache Spark. Ενοποιημένο στον χρόνο εκτέλεσης Fabric, το Delta Lake βελτιώνει τις δυνατότητες επεξεργασίας δεδομένων και εξασφαλίζει συνέπεια δεδομένων σε πολλές ταυτόχρονες λειτουργίες.

Ο εγγενής μηχανισμός εκτέλεσης είναι μια μετασχηματιστική βελτίωση για τους φόρτους εργασίας Apache Spark, προσφέροντας σημαντικά κέρδη απόδοσης εκτελώντας απευθείας ερωτήματα Spark σε υποδομή lakehouse. Ενοποιημένη απρόσκοπτα, δεν απαιτεί αλλαγές κώδικα και αποφεύγει το κλείδωμα προμηθευτών, υποστηρίζοντας τόσο τις μορφές Parquet όσο και delta σε όλα τα API Apache Spark στο Runtime 1.3 (Spark 3.5). Αυτός ο μηχανισμός αυξάνει τις ταχύτητες των ερωτημάτων έως και τέσσερις φορές ταχύτερα από το παραδοσιακό OSS Spark, όπως φαίνεται από το στοιχείο αναφοράς TPC-DS 1TB, μειώνοντας το λειτουργικό κόστος και βελτιώνοντας την αποδοτικότητα σε διάφορες εργασίες δεδομένων, συμπεριλαμβανομένης της πρόσληψης δεδομένων, του ETL, της ανάλυσης και των αλληλεπιδραστικών ερωτημάτων. Ο εγγενής μηχανισμός εκτέλεσης βασίζεται σε δύο βασικά στοιχεία του OSS: το Velox, μια βιβλιοθήκη επιτάχυνσης βάσης δεδομένων C++ που παρουσιάστηκε από τη Meta και το Apache Meta (incubating), ένα μεσαίο επίπεδο που ευθύνεται για τη μείωση της φόρτωσης της εκτέλεσης κινητήρων SQL που βασίζονται σε JVM σε εγγενείς κινητήρες που εισήγαγε η Intel.

Πακέτα προεπιλεγμένου επιπέδου για Java/Scala, Python και R - πακέτα που υποστηρίζουν διαφορετικές γλώσσες προγραμματισμού και περιβάλλοντα. Αυτά τα πακέτα εγκαθίστανται και ρυθμίζονται αυτόματα, επιτρέποντας στους προγραμματιστές να εφαρμόσουν τις προτιμώμενες γλώσσες προγραμματισμού για εργασίες επεξεργασίας δεδομένων.

Ο χρόνος εκτέλεσης Microsoft Fabric βασίζεται σε ένα ισχυρό λειτουργικό σύστημα ανοιχτού κώδικα, το οποίο εξασφαλίζει συμβατότητα με διάφορες ρυθμίσεις παραμέτρων υλικού και απαιτήσεις συστήματος.

Παρακάτω μπορείτε να βρείτε μια ολοκληρωμένη σύγκριση βασικών στοιχείων, συμπεριλαμβανομένων των εκδόσεων Apache Spark, υποστηριζόμενων λειτουργικών συστημάτων, Java, Scala, Python, Delta Lake και R, για χρόνους εκτέλεσης που βασίζονται στο Apache Spark στην πλατφόρμα Microsoft Fabric.

Φιλοδώρημα

Χρησιμοποιείτε πάντα την πιο πρόσφατη, γενικά διαθέσιμη έκδοση χρόνου εκτέλεσης (GA) για τον φόρτο εργασίας παραγωγής σας, η οποία αυτή τη στιγμή είναι ο χρόνος εκτέλεσης 1.3.

| Συνθετικός | Χρόνος εκτέλεσης: 1.2 | Χρόνος εκτέλεσης: 1.3 | Χρόνος εκτέλεσης 2.0 |

|---|---|---|---|

| σταδίου κυκλοφορίας |

EOSA | Γενική διαθεσιμότητα | Πειραματικό (Προεπισκόπηση) |

| Έκδοση Apache Spark | 3.4.1 | 3.5.5 | 4.0.0 |

| Λειτουργικό σύστημα | Μάρινερ 2.0 | Μάρινερ 2.0 | Μάρινερ 3.0 |

| Έκδοση Java | 11 | 11 | 21 |

| Έκδοση Scala | 2.12.17 | 2.12.17 | 2.13.16 |

| Έκδοση Python | 3,10 | 3.11 | 3.12.11 |

| Έκδοση Delta Lake | 2.4.0 | 3,2 | 4.0.0 |

Επισκεφτείτε το Runtime 1.2, το Runtime 1.3 ή το Runtime 2.0 για να εξερευνήσετε λεπτομέρειες, νέες δυνατότητες, βελτιώσεις και σενάρια μετεγκατάστασης για τη συγκεκριμένη έκδοση χρόνου εκτέλεσης.

Βελτιστοποιήσεις fabric

Στο Microsoft Fabric, τόσο ο μηχανισμός Spark όσο και οι υλοποιήσεις του Delta Lake ενσωματώνουν βελτιστοποιήσεις και δυνατότητες ειδικά για την πλατφόρμα. Αυτές οι δυνατότητες έχουν σχεδιαστεί για χρήση εγγενών ενοποιήσεων εντός της πλατφόρμας. Είναι σημαντικό να έχετε υπόψη ότι όλες αυτές οι δυνατότητες μπορούν να απενεργοποιηθούν για την επίτευξη τυπικής λειτουργικότητας του Spark και του Delta Lake. Οι χρόνοι εκτέλεσης Fabric για το Apache Spark περιλαμβάνουν:

- Η πλήρης έκδοση ανοιχτού κώδικα του Apache Spark.

- Μια συλλογή σχεδόν 100 ενσωματωμένων, διακριτών βελτιώσεων απόδοσης ερωτημάτων. Αυτές οι βελτιώσεις περιλαμβάνουν δυνατότητες όπως η προσωρινή αποθήκευση διαμερίσματος (η ενεργοποίηση του cache διαμερίσματος FileSystem για τη μείωση των κλήσεων μεταστάσεων) και η διασταυρούμενη σύνδεση στην προβολή ανυσματικών δευτερευουσών ερωτημάτων.

- Ενσωματωμένο έξυπνο cache.

Εντός του χρόνου εκτέλεσης Fabric για το Apache Spark και το Delta Lake, υπάρχουν εγγενείς δυνατότητες συγγραφέων που εξυπηρετούν δύο βασικούς σκοπούς:

- Προσφέρουν διαφοροποιημένες επιδόσεις για τη σύνταξη φόρτων εργασίας, βελτιστοποιώντας τη διαδικασία εγγραφής.

- Έχουν ως προεπιλογή τη βελτιστοποίηση V-Order των αρχείων Delta Parquet. Η βελτιστοποίηση της V-Order του Delta Lake είναι σημαντική για την παροχή ανώτερης απόδοσης ανάγνωσης σε όλους τους κινητήρες Fabric. Για να κατανοήσετε βαθύτερα τον τρόπο λειτουργίας της και τον τρόπο διαχείρισής της, ανατρέξτε στο αποκλειστικό άρθρο σχετικά με τη βελτιστοποίηση πινάκων Delta Lake και τη σειρά V.

Υποστήριξη πολλών εκτελέσεων/εκτελέσεων

Το Fabric υποστηρίζει πολλούς χρόνους εκτέλεσης, παρέχοντας στους χρήστες την ευελιξία να κάνουν απρόσκοπτη εναλλαγή μεταξύ τους, ελαχιστοποιώντας τον κίνδυνο ασυμβατότητας ή διακοπών.

Από προεπιλογή, όλοι οι νέοι χώροι εργασίας χρησιμοποιούν την πιο πρόσφατη έκδοση χρόνου εκτέλεσης GA, η οποία είναι επί του παρόντος Runtime 1.3.

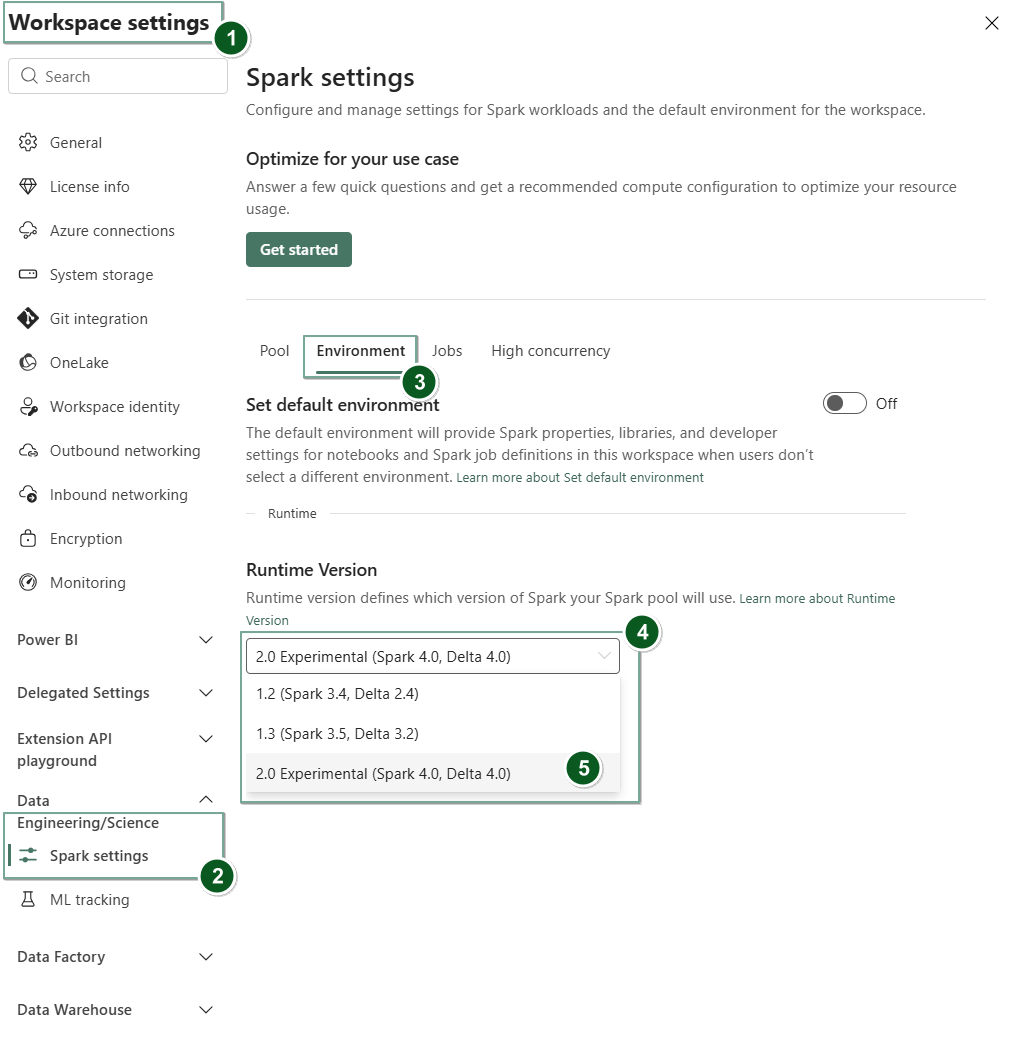

Για να αλλάξετε την έκδοση του χρόνου εκτέλεσης σε επίπεδο χώρου εργασίας, μεταβείτε στις ρυθμίσεις του Workspace>Data Engineering/Science>Spark ρυθμίσεις. Από την καρτέλα περιβάλλοντος

Μόλις κάνετε αυτή την αλλαγή, όλα τα στοιχεία που δημιουργούνται από το σύστημα εντός του χώρου εργασίας, συμπεριλαμβανομένων των Lakehouses, SJDs και Notebooks, θα λειτουργούν χρησιμοποιώντας τη νέα επιλεγμένη έκδοση χρόνου εκτέλεσης σε επίπεδο χώρου εργασίας, ξεκινώντας από την επόμενη περίοδο λειτουργίας Spark. Εάν χρησιμοποιείτε ένα σημειωματάριο με μια υπάρχουσα περίοδο λειτουργίας για μια εργασία ή οποιαδήποτε δραστηριότητα που σχετίζεται με lakehouse, αυτή η περίοδος λειτουργίας Spark συνεχίζεται ως έχει. Ωστόσο, ξεκινώντας από την επόμενη περίοδο λειτουργίας ή εργασία, θα εφαρμοστεί η επιλεγμένη έκδοση χρόνου εκτέλεσης.

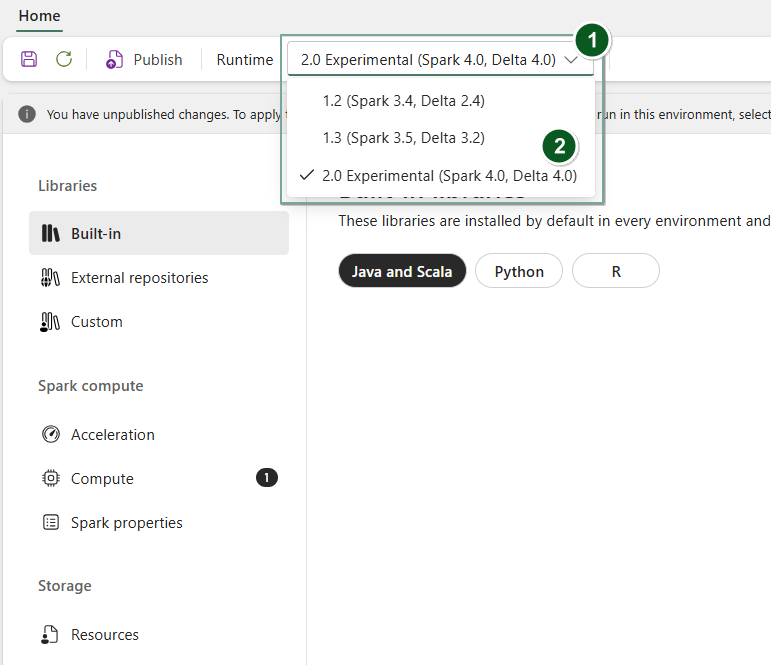

Επιπλέον, για να αλλάξετε το Environment χρόνο εκτέλεσης σε επίπεδο στοιχείου, δημιουργήστε ένα νέο στοιχείο Περιβάλλον ή ανοίξτε και υπάρχον, στην αναπτυσσόμενη λίστα Χρόνος εκτέλεσης , επιλέξτε την επιθυμητή έκδοση χρόνου εκτέλεσης από τις διαθέσιμες επιλογές, επιλέξτε Save και, στη συνέχεια Publish , τις αλλαγές σας. Στη συνέχεια, μπορείτε να χρησιμοποιήσετε αυτό το στοιχείο με το Environment δικό σας Notebook ή Spark Job Definition.

Συνέπειες των αλλαγών χρόνου εκτέλεσης στις ρυθμίσεις Spark

Σε γενικές γραμμές, στόχος μας είναι η μετεγκατάσταση όλων των ρυθμίσεων Spark. Ωστόσο, εάν προσδιορίσουμε ότι η ρύθμιση Spark δεν είναι συμβατή με το Runtime B, εκδώνουμε ένα προειδοποιητικό μήνυμα και αποφεύγουμε την υλοποίηση της ρύθμισης.

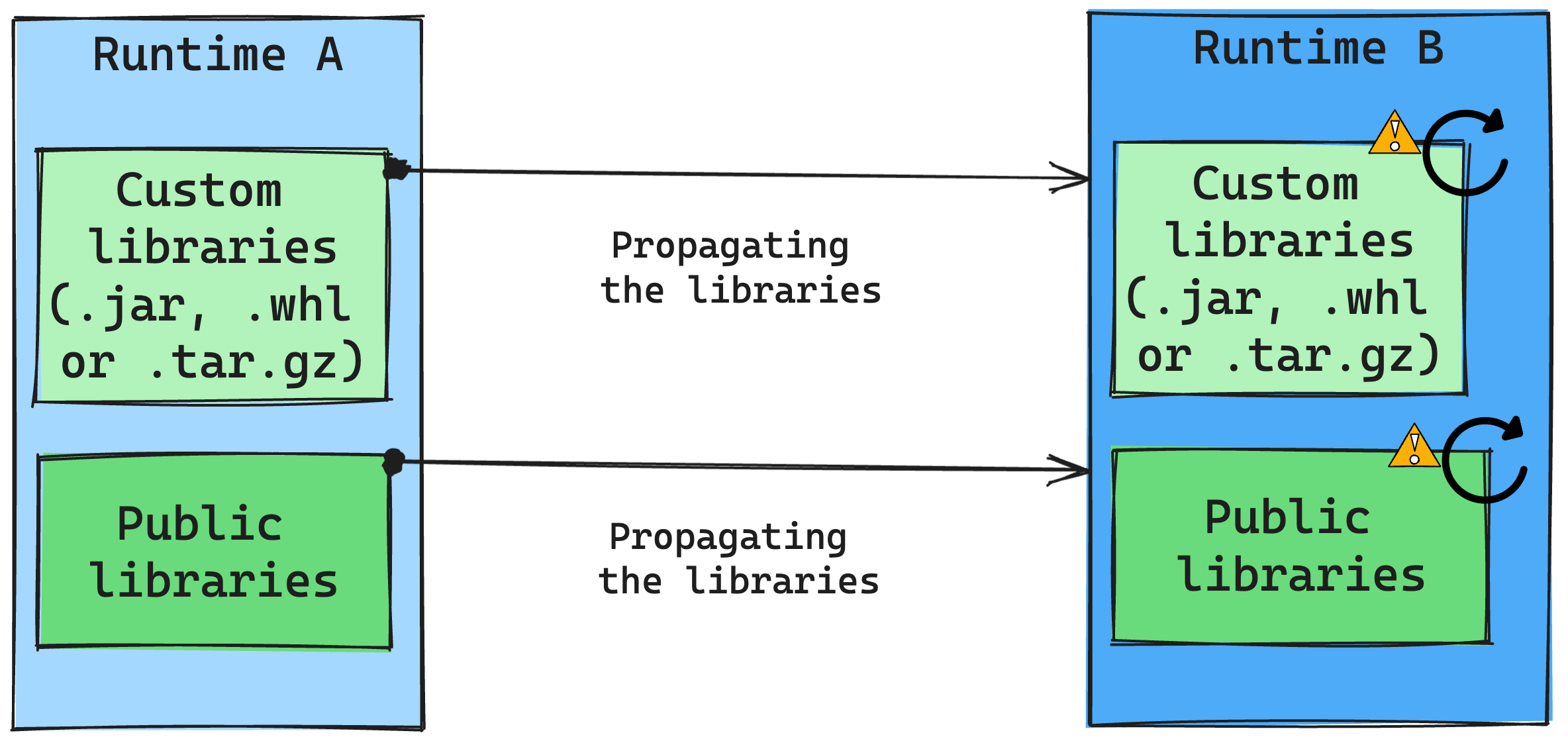

Συνέπειες των αλλαγών στον χρόνο εκτέλεσης στη διαχείριση βιβλιοθήκης

Σε γενικές γραμμές, η προσέγγισή μας είναι να μετεγκαταστήσουμε όλες τις βιβλιοθήκες από τον Χρόνο εκτέλεσης Α στον Χρόνο εκτέλεσης Β, συμπεριλαμβανομένων των δημόσιων και των προσαρμοσμένων χρόνου εκτέλεσης. Εάν οι εκδόσεις Python και R παραμείνουν αμετάβλητες, οι βιβλιοθήκες θα πρέπει να λειτουργούν σωστά. Ωστόσο, για τα Jars, υπάρχει σημαντική πιθανότητα να μην λειτουργούν λόγω αλλαγών στις εξαρτήσεις και άλλων παραγόντων, όπως αλλαγές στη Scala, την Java, το Spark και το λειτουργικό σύστημα.

Ο χρήστης είναι υπεύθυνος για την ενημέρωση ή την αντικατάσταση τυχόν βιβλιοθηκών που δεν λειτουργούν με το Runtime B. Εάν υπάρχει διένεξη, που σημαίνει ότι το Runtime B περιλαμβάνει μια βιβλιοθήκη που ορίστηκε αρχικά στο Runtime A, το σύστημα διαχείρισης της βιβλιοθήκης μας προσπαθεί να δημιουργήσει την απαραίτητη εξάρτηση για το Runtime B με βάση τις ρυθμίσεις του χρήστη. Ωστόσο, η διαδικασία κατασκευής αποτυγχάνει εάν προκύψει σύγκρουση. Στο αρχείο καταγραφής σφαλμάτων, οι χρήστες μπορούν να δουν ποιες βιβλιοθήκες προκαλούν διενέξεις και να κάνουν προσαρμογές στις εκδόσεις ή τις προδιαγραφές τους.

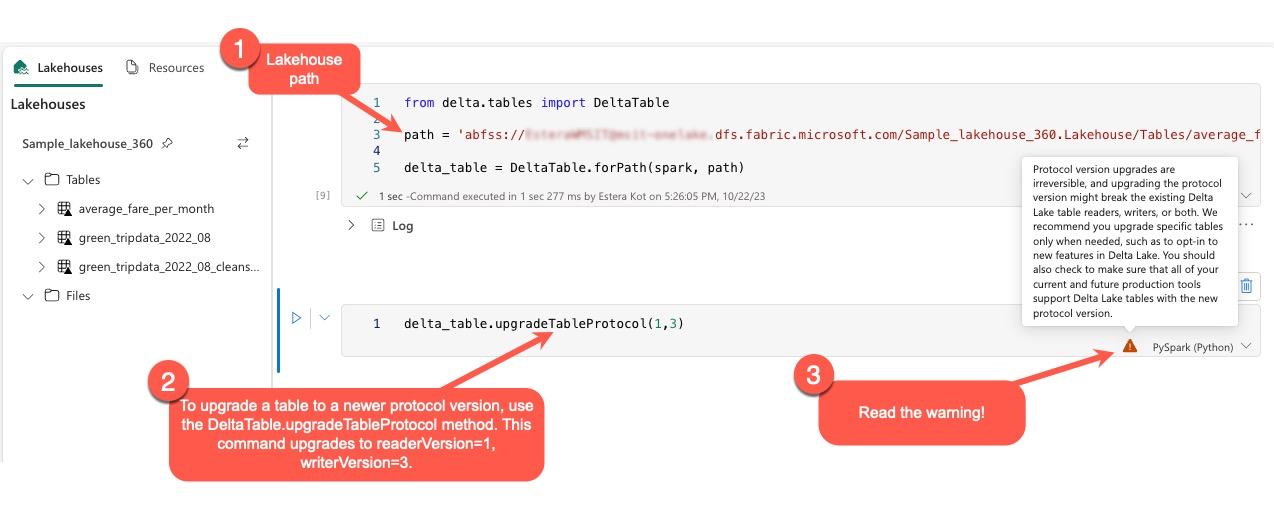

Αναβάθμιση του πρωτοκόλλου Delta Lake

Οι δυνατότητες του Delta Lake είναι πάντα συμβατές με προηγούμενες εκδόσεις, εξασφαλίζοντας ότι οι πίνακες που δημιουργούνται σε χαμηλότερη έκδοση του Delta Lake μπορούν να αλληλεπιδρούν απρόσκοπτα με υψηλότερες εκδόσεις. Ωστόσο, όταν είναι ενεργοποιημένες ορισμένες δυνατότητες (για παράδειγμα, με τη χρήση delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) της μεθόδου, ενδέχεται να διακυβευτεί η συμβατότητα προς τα εμπρός με χαμηλότερες εκδόσεις Delta Lake. Σε αυτές τις περιπτώσεις, είναι σημαντικό να τροποποιήσετε τους φόρτους εργασίας που αναφέρονται στους αναβαθμισμένους πίνακες ώστε να ευθυγραμμίζονται με μια έκδοση του Delta Lake που διατηρεί συμβατότητα.

Κάθε πίνακας Delta σχετίζεται με μια προδιαγραφή πρωτοκόλλου, ορίζοντας τις δυνατότητες που υποστηρίζει. Οι εφαρμογές που αλληλεπιδρούν με τον πίνακα, είτε για ανάγνωση είτε για εγγραφή, βασίζονται σε αυτήν την προδιαγραφή πρωτοκόλλου για να προσδιορίσουν εάν είναι συμβατές με το σύνολο δυνατοτήτων του πίνακα. Εάν μια εφαρμογή δεν έχει τη δυνατότητα να χειριστεί μια δυνατότητα που αναφέρεται ως υποστηριζόμενη στο πρωτόκολλο του πίνακα, δεν μπορεί να διαβάσει ή να γράψει σε αυτόν τον πίνακα.

Η προδιαγραφή πρωτοκόλλου χωρίζεται σε δύο διακριτά στοιχεία: το πρωτόκολλο "ανάγνωσης" και το πρωτόκολλο "εγγραφής". Για περισσότερες πληροφορίες, επισκεφθείτε τη σελίδα "Πώς διαχειρίζεται η Delta Lake τη συμβατότητα χαρακτηριστικών;".

Οι χρήστες μπορούν να εκτελέσουν την εντολή delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) εντός του περιβάλλοντος PySpark, καθώς και στα Spark SQL και Scala. Αυτή η εντολή τους επιτρέπει να ξεκινήσουν μια ενημέρωση στον πίνακα Delta.

Είναι σημαντικό να έχετε υπόψη ότι κατά την εκτέλεση αυτής της αναβάθμισης, οι χρήστες λαμβάνουν μια προειδοποίηση που υποδεικνύει ότι η αναβάθμιση της έκδοσης του πρωτοκόλλου Delta είναι μια μη εφάμιλλη διαδικασία. Αυτό σημαίνει ότι μόλις εκτελεστεί η ενημέρωση, δεν μπορεί να αναιρεθεί.

Οι αναβαθμίσεις έκδοσης πρωτοκόλλου ενδέχεται να επηρεάσουν τη συμβατότητα των υπαρχόντων προγραμμάτων ανάγνωσης πινάκων Delta Lake, των προγραμμάτων εγγραφής ή και των δύο. Επομένως, συνιστάται να συνεχίσετε προσεκτικά και να αναβαθμίσετε την έκδοση του πρωτοκόλλου μόνο όταν είναι απαραίτητο, όπως κατά την υιοθέτηση νέων δυνατοτήτων στο Delta Lake.

Σημαντικό

Για να μάθετε περισσότερα σχετικά με τις εκδόσεις πρωτοκόλλου και τις δυνατότητες που είναι συμβατές με όλες τις εμπειρίες Microsoft Fabric, διαβάστε το θέμα Διαλειτουργικότητα μορφής πίνακα Delta Lake.

Επιπλέον, οι χρήστες θα πρέπει να επαληθεύουν ότι όλοι οι τρέχοντες και μελλοντικοί φόρτοι εργασίας και διαδικασίες παραγωγής είναι συμβατοί με πίνακες delta lake χρησιμοποιώντας τη νέα έκδοση πρωτοκόλλου για να διασφαλίσουν μια απρόσκοπτη μετάβαση και να αποτρέψουν τυχόν πιθανές διακοπές.