Evaluación de aplicaciones de IA generativas con Azure AI Studio

Importante

Algunas de las características descritas en este artículo solo pueden estar disponibles en versión preliminar. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

Para evaluar exhaustivamente el rendimiento de su aplicación de IA generativa cuando se aplica a un conjunto de datos sustancial, puede iniciar un proceso de evaluación. Durante esta evaluación, la aplicación se prueba con el conjunto de datos determinado y su rendimiento se mide cuantitativamente con métricas basadas en matemáticas y métricas asistidas por IA. Esta ejecución de evaluación proporciona información completa sobre las funcionalidades y limitaciones de la aplicación.

Para llevar a cabo esta evaluación, puede utilizar la funcionalidad de evaluación en inteligencia artificial de Azure Studio, una plataforma completa que ofrece herramientas y características para evaluar el rendimiento y la seguridad del modelo de IA generativa. Con inteligencia artificial de Azure Studio, puede registrar, ver y analizar métricas de evaluación detalladas.

En este artículo, aprenderá a crear una ejecución de evaluación a partir de un conjunto de datos de prueba o un flujo con métricas de evaluación integradas de la interfaz de usuario de inteligencia artificial de Azure Studio. Para mayor flexibilidad, puede establecer un flujo de evaluación personalizado y emplear la característica de evaluación personalizada. Alternativamente, si el objetivo es realizar únicamente una ejecución por lotes sin ninguna evaluación, también puede usar la característica de evaluación personalizada.

Requisitos previos

Para ejecutar una evaluación con métricas asistidas por IA, debe tener lo siguiente listo:

- Un conjunto de datos de prueba en uno de estos formatos:

csvojsonl. - Una conexión de Azure OpenAI.

- Una implementación de uno de estos modelos: modelos GPT 3.5, modelos GPT 4 o modelos Davinci.

Creación de una evaluación con métricas de evaluación integradas

Una ejecución de evaluación permite generar salidas de métricas para cada fila de datos del conjunto de datos de prueba. Puede elegir una o varias métricas de evaluación para evaluar la salida desde diferentes aspectos. Puede crear una ejecución de evaluación a partir de las páginas de flujo de avisos y evaluación en IA Studio. A continuación, aparecerá el asistente para la creación de evaluaciones para guiarlo por el proceso de configuración de una ejecución de evaluación.

Desde la página de evaluación

En el menú izquierdo contraíble, seleccione Evaluación>+ Nueva evaluación.

Desde la página de flujo

En el menú izquierdo contraíble, seleccione Flujo de avisos>Evaluar>Evaluación integrada.

Información básica

Al iniciar una evaluación desde la página de evaluación, primero debe decidir cuál es el destino de evaluación. Al especificar el destino de evaluación adecuado, podemos adaptar la evaluación a la naturaleza específica de la aplicación, lo que garantiza métricas precisas y pertinentes. Actualmente se admiten dos tipos de destino de evaluación:

Conjunto de datos: ya tiene los resultados generados por el modelo en un conjunto de datos de prueba. Flujo de avisos: ha creado un flujo y desea evaluar la salida del flujo.

Cuando ingresa al Asistente para la creación de evaluaciones, puede proporcionar un nombre opcional para la ejecución de evaluación y seleccionar el escenario que mejor se adapte a los objetivos de la aplicación. Actualmente ofrecemos compatibilidad con los escenarios siguientes:

- Preguntas y respuestas con contexto: Este escenario está diseñado para aplicaciones que implican responder consultas de los usuarios y proporcionar respuestas con información de contexto.

- Preguntas y respuestas sin contexto: Este escenario está diseñado para aplicaciones que implican responder consultas de los usuarios y proporcionar respuestas sin contexto.

Puede usar el panel de ayuda para comprobar las preguntas más frecuentes y guiarse a través del asistente.

Si va a evaluar un flujo de avisos, puede seleccionar el flujo que se va a evaluar. Si inicia la evaluación desde la página Flujo, seleccionaremos automáticamente el flujo para evaluarlo. Si piensa evaluar otro flujo, puede seleccionar uno diferente. Es importante tener en cuenta que, dentro de un flujo, es posible que tenga varios nodos, cada uno de los cuales podría tener su propio conjunto de variantes. En tales casos, debe especificar el nodo y las variantes que desea evaluar durante el proceso de evaluación.

Configurar los datos de prueba

Puede seleccionar entre conjuntos de datos preexistentes o cargar un nuevo conjunto de datos específicamente para su evaluación. El conjunto de datos de prueba debe tener las salidas generadas por el modelo que se van a usar para la evaluación si no hay ningún flujo seleccionado en el paso anterior.

Elija el conjunto de datos existente: puede elegir el conjunto de datos de prueba de la colección de conjuntos de datos establecida.

Agregar nuevo conjunto de datos: puede cargar archivos desde el almacenamiento local. Solo se admiten formatos de archivo

.csvy.jsonl.Asignación de datos para el flujo: si selecciona un flujo que se va a evaluar, asegúrese de que las columnas de datos están configuradas para alinearse con las entradas necesarias para que el flujo ejecute una ejecución por lotes, generando la salida para la evaluación. A continuación, la evaluación se llevará a cabo mediante la salida del flujo. Posteriormente, configure la asignación de datos para las entradas de evaluación en el paso siguiente.

Seleccionar métricas

Se admiten dos tipos de métricas mantenidas por Microsoft para facilitar una evaluación completa de la aplicación:

- Métricas de rendimiento y calidad: Estas métricas evalúan la calidad general y la coherencia del contenido generado.

- Métricas de riesgo y seguridad: Estas métricas se centran en identificar posibles riesgos de contenido y garantizar la seguridad del contenido generado.

Puede consultar la tabla para obtener la lista completa de métricas para las que ofrecemos compatibilidad en cada escenario. Para obtener información más detallada sobre cada definición de métrica y cómo se calcula, consulte Métricas de evaluación y supervisión.

| Escenario | Métricas de rendimiento y calidad | Métricas de riesgo y seguridad |

|---|---|---|

| Pregunta y respuesta con contexto | Fundamentación, Relevancia, Coherencia, Fluidez, Similitud GPT, Puntuación F1 | Contenido relacionado con autolesiones, Contenido de odio e injusto, Contenido violento, Contenido sexual, Material protegido, Ataque indirecto |

| Pregunta y respuesta sin contexto | Coherencia, Fluidez, Similitud de GPT, Puntuación F1 | Contenido relacionado con autolesiones, Contenido de odio e injusto, Contenido violento, Contenido sexual, Material protegido, Ataque indirecto |

Al usar métricas asistidas por IA para la evaluación de rendimiento y calidad, debe especificar un modelo GPT para el proceso de cálculo. Elija una conexión de Azure OpenAI y una implementación con GPT-3.5, GPT-4 o el modelo Davinci para nuestros cálculos.

En el caso de las métricas de riesgo y seguridad, no es necesario proporcionar una conexión e implementación. La evaluación de seguridad de inteligencia artificial de Azure Studio aprovisiona un modelo GPT-4 que puede generar puntuaciones de gravedad de riesgo de contenido y razonamiento para permitirle evaluar la aplicación por daños en el contenido.

Puede establecer el umbral para calcular la tasa de defectos de las métricas de daño de contenido (contenido relacionado con autolesiones, contenido de odio e injusto, contenido violento, contenido sexual). La tasa de defectos se calcula tomando un porcentaje de instancias con niveles de gravedad (Muy bajo, Bajo, Medio, Alto) por encima de un umbral. De forma predeterminada, establecemos el umbral como "Medio".

Para el material protegido y el ataque indirecto, la tasa de defectos se calcula tomando un porcentaje de instancias donde la salida es "true" (Tasa de defectos = (#trues / #instances) × 100).

Nota:

Las métricas de seguridad y riesgo asistidos por IA se hospedan en el servicio back-end de evaluaciones de seguridad de inteligencia artificial de Azure Studio y solo están disponibles en las siguientes regiones: Este de EE. UU. 2, Centro de Francia, Sur de Reino Unido, Centro de Suecia

Asignación de datos para la evaluación: debe especificar qué columnas de datos del conjunto de datos corresponden a las entradas necesarias en la evaluación. Las diferentes métricas de evaluación exigen distintos tipos de entradas de datos para cálculos precisos.

Nota:

Si va a realizar la evaluación a partir de datos, la "respuesta" debe asignarse a la columna de respuesta del conjunto de datos ${data$answer}. Si va a realizar la evaluación a partir del flujo, la "respuesta" debe proceder de la salida del flujo ${run.outputs.answer}.

Para obtener instrucciones sobre los requisitos de asignación de datos específicos para cada métrica, consulte la información proporcionada en la tabla:

Requisitos de métricas de respuesta a preguntas

| Métrica | Pregunta | Respuesta | Context | Cierto |

|---|---|---|---|---|

| Base | Obligatorio: Str | Obligatorio: Str | Obligatorio: Str | N/D |

| Coherencia | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Fluidez | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Relevancia | Obligatorio: Str | Obligatorio: Str | Obligatorio: Str | N/D |

| Similitud de GPT | Obligatorio: Str | Obligatorio: Str | N/D | Obligatorio: Str |

| Puntuación F1 | Obligatorio: Str | Obligatorio: Str | N/D | Obligatorio: Str |

| Contenido relacionado con autolesiones | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Contenido injusto y de odio | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Contenido violento | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Contenido sexual | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Material protegido | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

| Ataque indirecto | Obligatorio: Str | Obligatorio: Str | N/D | N/D |

- Pregunta: la pregunta planteada por el usuario en el par Preguntas y respuestas

- Respuesta: respuesta a la pregunta generada por el modelo como respuesta

- Contexto: el origen con respecto al cual se genera la respuesta (es decir, los documentos base)

- Verdad básica: la respuesta a la pregunta generada por el usuario o el ser humano como la respuesta verdadera

Revisar y finalizar

Después de completar todas las configuraciones necesarias, puede revisarlas y continuar seleccionando "Enviar" para enviar la ejecución de evaluación.

Creación de una evaluación con un flujo de evaluación personalizado

Puede desarrollar sus propios métodos de evaluación:

En la página de flujos, en el menú izquierdo contraíble, seleccione Flujo de avisos>Evaluar>Evaluación personalizada.

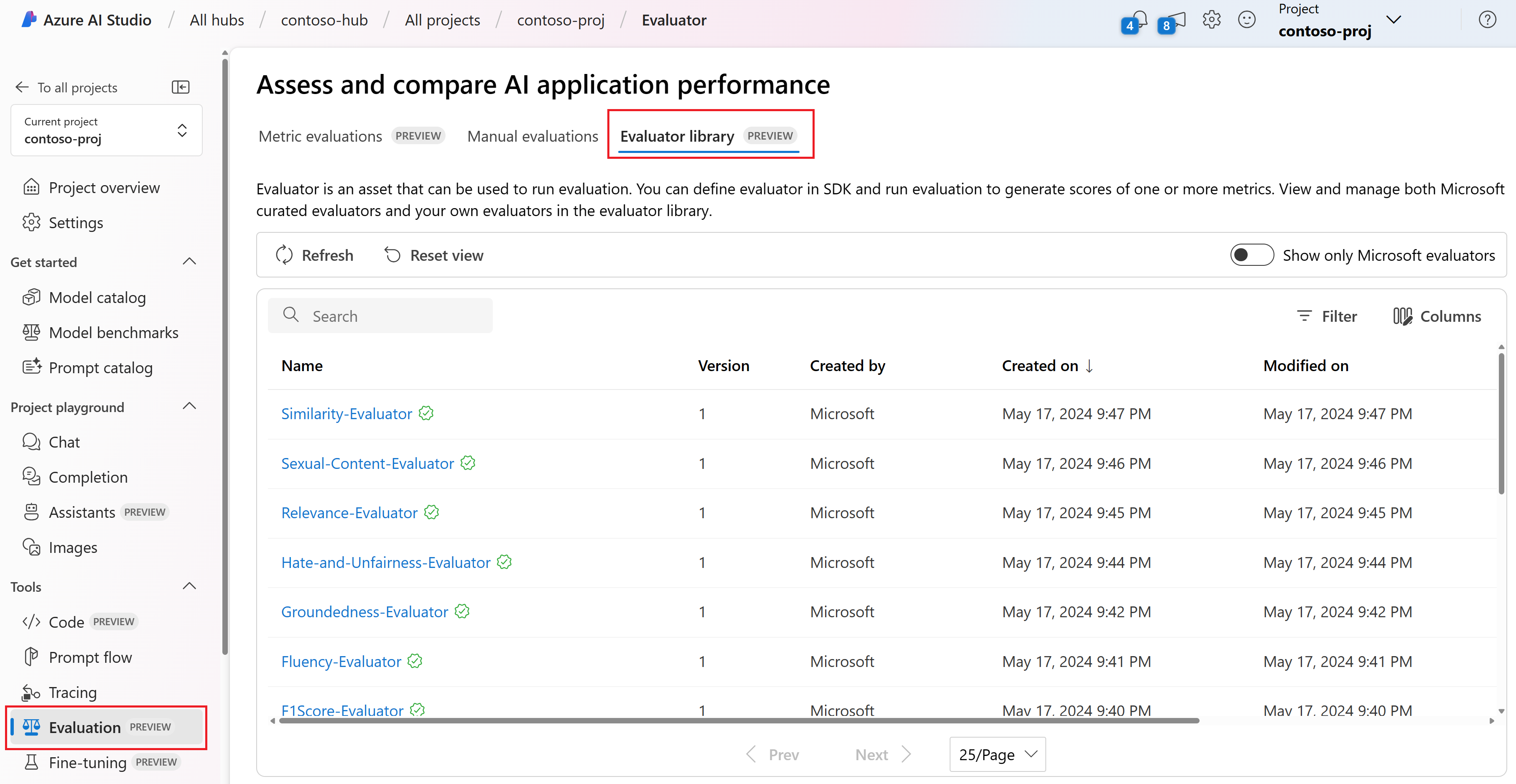

Visualización y administración de los evaluadores en la biblioteca de evaluadores

La biblioteca de evaluadores es un lugar centralizado que le permite ver los detalles y el estado de los evaluadores. Puede ver y administrar evaluadores mantenidos por Microsoft.

Sugerencia

Puede usar evaluadores personalizados a través del SDK del flujo de avisos. Para obtener más información, consulteEvaluar con el SDK de flujo de mensajes.

La biblioteca de evaluadores también habilita la administración de versiones. Puede comparar diferentes versiones del trabajo, restaurar versiones anteriores si es necesario y colaborar con otros usuarios con mayor facilidad.

Para usar la biblioteca de evaluadores en Inteligencia artificial de Studio, vaya a la página Evaluación del proyecto y seleccione la pestaña Biblioteca de evaluadores.

Puede seleccionar el nombre del evaluador para ver más detalles. Puede ver el nombre, la descripción y los parámetros, así como comprobar los archivos asociados al evaluador. Estos son algunos ejemplos de evaluadores mantenidos por Microsoft:

- En el caso de los evaluadores de rendimiento y calidad mantenidos por Microsoft, puede ver la solicitud de anotación en la página de detalles. Puede adaptar estas indicaciones a su propio caso de uso cambiando los parámetros o criterios según sus datos y objetivos con el SDK del flujo de avisos. Por ejemplo, puede seleccionar Groundedness-Evaluator y consultar el archivo Prompty que muestra cómo calculamos la métrica.

- Para los evaluadores de riesgos y seguridad mantenidos por Microsoft, puede ver la definición de las métricas. Por ejemplo, puede seleccionar Self-Harm-Related-Content-Evaluator y conocer lo que significa y cómo Microsoft determina los distintos niveles de gravedad para esta métrica de seguridad.

Pasos siguientes

Obtenga más información sobre cómo evaluar las aplicaciones de IA generativa: