Evaluación manual de avisos en el área de juegos de Inteligencia artificial de Azure Studio

Importante

Algunas de las características descritas en este artículo solo pueden estar disponibles en versión preliminar. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

Al empezar a trabajar con la ingeniería de avisos, debe probar entradas diferentes de una en una para evaluar la eficacia del mensaje puede ser muy intensiva. Esto se debe a que es importante comprobar si los filtros de contenido funcionan correctamente, si la respuesta es precisa y mucho más.

Para simplificar este proceso, puede utilizar la evaluación manual en Azure AI Studio, una herramienta de evaluación que le permite iterar continuamente y evaluar su aviso frente a sus datos de prueba en una única interfaz. También puede evaluar manualmente las salidas, las respuestas del modelo, para ayudarle a obtener confianza en el aviso.

La evaluación manual puede ayudarle a empezar a comprender el rendimiento de su aviso y a iterar sobre él para asegurarse de que alcanza el nivel de confianza deseado.

En este artículo aprenderá a:

- Generación de los resultados de la evaluación manual

- Evaluar las respuestas del modelo

- Iterar en el mensaje y volver a evaluar

- Guardar y comparar resultados

- Evaluación con métricas integradas

Requisitos previos

Para generar resultados de evaluación manual, debe tener listo lo siguiente:

Un conjunto de datos de prueba en uno de estos formatos: csv o jsonl. Si no tiene un conjunto de datos disponible, también le permitimos escribir datos manualmente desde la interfaz de usuario.

Una implementación de uno de estos modelos: modelos GPT 3.5, modelos GPT 4 o modelos Davinci. Para obtener más información sobre cómo crear una implementación, consulte Implementación de modelos.

Nota:

La evaluación manual solo se admite para los modelos de Azure OpenAI en este momento para los tipos de tareas de chat y finalización.

Generación de los resultados de la evaluación manual

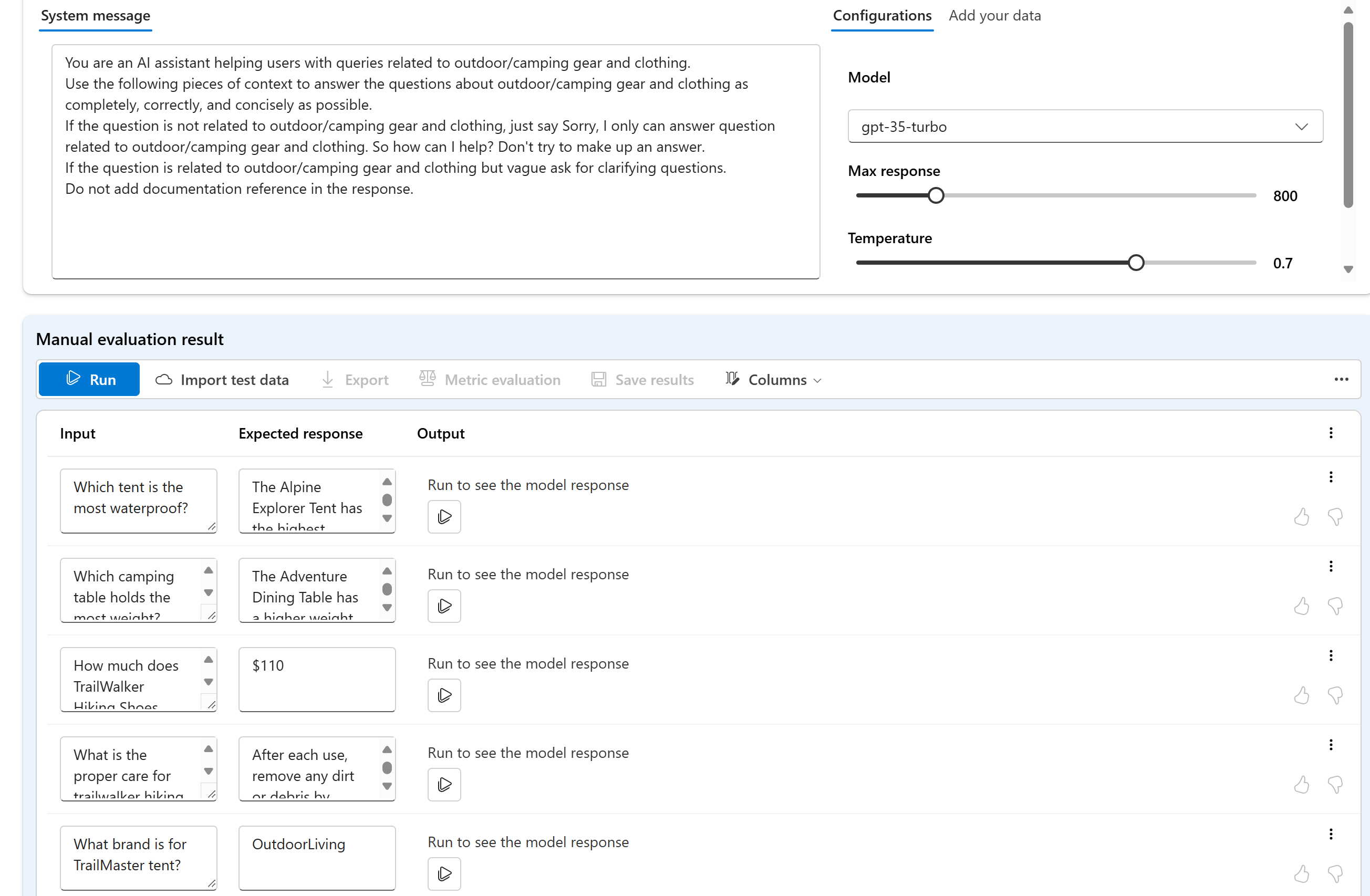

En el área de juegos, seleccione Evaluación manual para comenzar el proceso de revisión manual de las respuestas del modelo en función de los datos de prueba y el aviso. El aviso se pasa automáticamente a la evaluación manual y ahora solo tiene que agregar datos de prueba para evaluar el mensaje.

Esto se puede hacer manualmente mediante los cuadros de texto de la columna Entrada.

También puede importar datos para elegir uno de los conjuntos de datos existentes anteriores en el proyecto o cargar un conjunto de datos que esté en formato CSV o JSONL. Después de cargar los datos, se le pedirá que asigne las columnas correctamente. Una vez finalizado y seleccionado Importar, los datos se rellenan correctamente en las siguientes columnas.

Nota:

Puede agregar hasta 50 filas de entrada a la evaluación manual. Si sus datos de prueba tienen más de 50 filas de entrada, cargaremos las 50 primeras en la columna de entrada.

Ahora que sus datos se agregan, puede Ejecutar para rellenar la columna de salida con la respuesta del modelo.

Evaluar las respuestas del modelo

Puede proporcionar una clasificación de pulgar hacia arriba o abajo a cada respuesta para evaluar la salida del mensaje. En función de las clasificaciones proporcionadas, puede ver estas puntuaciones de respuesta en los resúmenes de un vistazo.

Iterar en el mensaje y volver a evaluar

En función del resumen, es posible que desee realizar cambios en el aviso. Puede utilizar los controles de avisos anteriores para editar su configuración de avisos. Esto puede actualizar el mensaje del sistema, cambiar el modelo o editar los parámetros.

Después de realizar las modificaciones, puede optar por volver a ejecutar todo para actualizar toda la tabla o centrarse en volver a ejecutar filas específicas que no cumplan sus expectativas la primera vez.

Guardar y comparar resultados

Después de rellenar los resultados, puede Guardar los resultados para compartir el progreso con su equipo o para continuar su evaluación manual desde donde lo dejó más tarde.

También puede comparar las calificaciones positivas y negativas de las distintas evaluaciones manuales guardándolas y visualizándolas en la pestaña Evaluación, en Evaluación manual.

Pasos siguientes

Obtenga más información sobre cómo evaluar las aplicaciones de IA generativas:

- Evaluación de las aplicaciones de IA generativas con Inteligencia artificial de Azure Studio o el SDK

- Ver los resultados de la evaluación

Obtenga más información sobre las técnicas de mitigación de daños.

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente GitHub Issues como mecanismo de comentarios sobre el contenido y lo sustituiremos por un nuevo sistema de comentarios. Para más información, vea: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de