Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

SE APLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. ¡Obtenga más información sobre cómo iniciar una nueva evaluación gratuita!

En este artículo se describe el uso de la actividad de copia en una canalización de Azure Data Factory o Synapse Analytics para copiar datos desde un almacén de datos de IBM Informix. El documento se basa en el artículo de introducción a la actividad de copia que describe información general de la actividad de copia.

Funcionalidades admitidas

Este conector de Informix es compatible con las funciones siguientes:

| Funcionalidades admitidas | IR |

|---|---|

| Actividad de copia (origen/receptor) | ② |

| Actividad de búsqueda | ② |

① Azure Integration Runtime ② Entorno de ejecución de integración autohospedado

Consulte la tabla de almacenes de datos compatibles para ver una lista de almacenes de datos que la actividad de copia admite como orígenes o receptores.

Requisitos previos

Para usar este conector de Informix, necesitará lo siguiente:

- Configurar un entorno Integration Runtime autohospedado. Consulte el artículo sobre Integration Runtime autohospedado para más información.

- Descargue el SDK de cliente de 64 bits para Informix para crear una conexión ODBC para el almacén de datos en la máquina del entorno de ejecución de integración. Para la descarga y configuración del SDK, consulte los detalles en este artículo o póngase en contacto con el equipo de soporte técnico de IBM para obtener instrucciones sobre la instalación de controladores.

Introducción

Para realizar la actividad de copia con una canalización, puede usar una de los siguientes herramientas o SDK:

- La herramienta Copiar datos

- Azure Portal

- El SDK de .NET

- El SDK de Python

- Azure PowerShell

- API REST

- La plantilla de Azure Resource Manager

Creación de un servicio vinculado en Informix mediante la interfaz de usuario

Siga estos pasos para crear un servicio vinculado en Informix en la interfaz de usuario de Azure Portal.

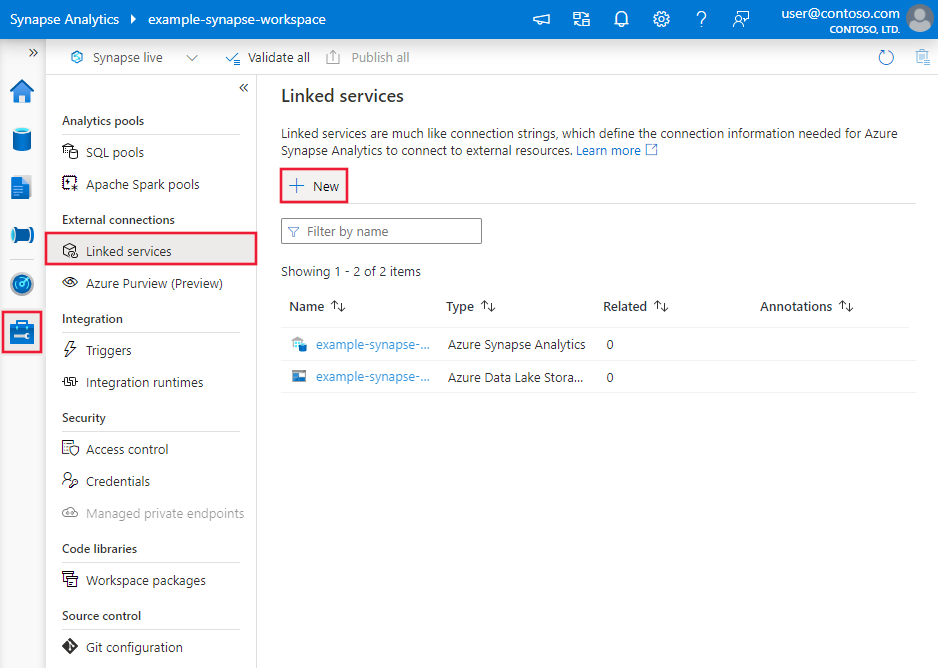

Vaya a la pestaña Administrar del área de trabajo de Azure Data Factory o Synapse y seleccione Servicios vinculados; luego haga clic en Nuevo:

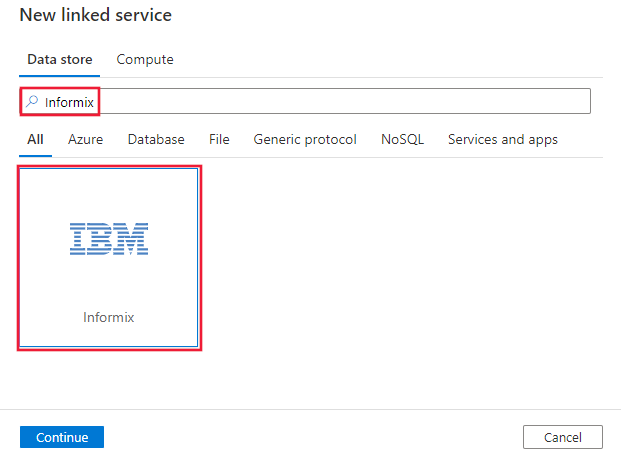

Busque Informix y seleccione el conector de Informix.

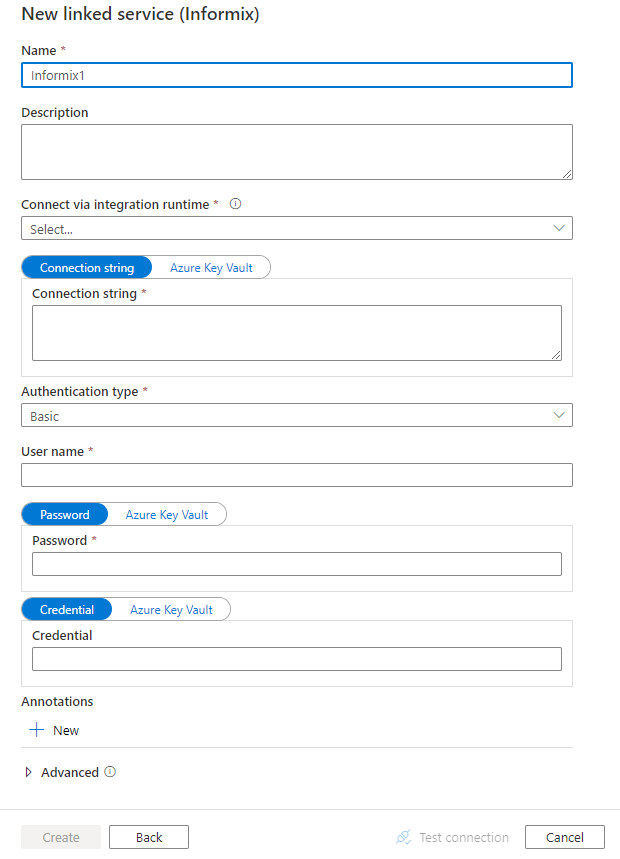

Configure los detalles del servicio, pruebe la conexión y cree el nuevo servicio vinculado.

Detalles de configuración del conector

En las secciones siguientes se proporcionan detalles sobre las propiedades que se usan para definir entidades de Data Factory específicas del conector de Informix.

Propiedades del servicio vinculado

Las siguientes propiedades son compatibles con el servicio vinculado de Informix:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type debe establecerse en: Informix | Sí |

| connectionString | La cadena de conexión ODBC que excluye la parte de la credencial. Puede especificar la cadena de conexión o utilizar el DSN (nombre de origen de datos) de sistema que se ha configurado en la máquina de Integration Runtime (se necesita especificar la parte de la credencial en el servicio vinculado según corresponda). También puede establecer una contraseña en Azure Key Vault y extraer la configuración de password de la cadena de conexión. Consulte el artículo Almacenamiento de credenciales en Azure Key Vault para obtener información detallada. |

Sí |

| authenticationType | Tipo de autenticación que se usa para conectarse al almacén de datos de Informix. Los valores permitidos son: Basic (básica) y Anonymous (anónima). |

Sí |

| userName | Especifique el nombre de usuario si usa la autenticación básica. | No |

| password | Especifique la contraseña de la cuenta de usuario que se especificó para el nombre de usuario. Marque este campo como SecureString para almacenarlo de forma segura, o bien haga referencia a un secreto almacenado en Azure Key Vault. | No |

| credencial | La parte de la credencial de acceso de la cadena de conexión especificada en formato de valor de propiedad específico del controlador. Marque este campo como SecureString. | No |

| connectVia | El entorno Integration Runtime que se usará para conectarse al almacén de datos. Tal y como se mencionó en los requisitos previos, se requiere un entorno Integration Runtime autohospedado. | Sí |

Ejemplo:

{

"name": "InformixLinkedService",

"properties": {

"type": "Informix",

"typeProperties": {

"connectionString": "<Informix connection string or DSN>",

"authenticationType": "Basic",

"userName": "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Propiedades del conjunto de datos

Si desea ver una lista completa de las secciones y propiedades disponibles para definir conjuntos de datos, consulte el artículo sobre conjuntos de datos. En esta sección se proporciona una lista de las propiedades compatibles con el conjunto de datos de Informix.

Para copiar datos de Informix, se admiten las siguientes propiedades:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del conjunto de datos debe establecerse en: InformixTable | Sí |

| tableName | Nombre de la tabla de Informix. | No (si se especifica "query" en el origen de la actividad) Sí para el receptor |

Ejemplo

{

"name": "InformixDataset",

"properties": {

"type": "InformixTable",

"linkedServiceName": {

"referenceName": "<Informix linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"tableName": "<table name>"

}

}

}

Propiedades de la actividad de copia

Si desea ver una lista completa de las secciones y propiedades disponibles para definir actividades, consulte el artículo sobre canalizaciones. En esta sección se proporciona una lista de las propiedades compatibles con el origen de Informix.

Informix como origen

Para copiar datos de Informix, en la sección source (origen) de la actividad de copia se admiten las siguientes propiedades:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del origen de la actividad de copia debe establecerse en: InformixSource | Sí |

| Query | Utilice la consulta personalizada para leer los datos. Por ejemplo: "SELECT * FROM MyTable". |

No (si se especifica "tableName" en el conjunto de datos) |

Ejemplo:

"activities":[

{

"name": "CopyFromInformix",

"type": "Copy",

"inputs": [

{

"referenceName": "<Informix input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "InformixSource",

"query": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Informix como receptor

Para copiar datos a Informix, se admiten las siguientes propiedades en la sección sink de la actividad de copia:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del receptor de la actividad de copia debe establecerse en: InformixSink | Sí |

| writeBatchTimeout | Tiempo de espera para que la operación de inserción por lotes se complete antes de que se agote el tiempo de espera. Los valores permitidos son: intervalos de tiempo. Ejemplo: "00:30:00" (30 minutos). |

No |

| writeBatchSize | Inserta datos en la tabla SQL cuando el tamaño del búfer alcanza el valor writeBatchSize. Los valores permitidos son: enteros (número de filas). |

No (el valor predeterminado es 0, detectado automáticamente) |

| preCopyScript | Especifique una consulta SQL para que la actividad de copia se ejecute antes de escribir datos en el almacén de datos en cada ejecución. Puede usar esta propiedad para limpiar los datos cargados previamente. | No |

| maxConcurrentConnections | Número máximo de conexiones simultáneas establecidas en el almacén de datos durante la ejecución de la actividad. Especifique un valor solo cuando quiera limitar las conexiones simultáneas. | No |

Ejemplo:

"activities":[

{

"name": "CopyToInformix",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Informix output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "InformixSink"

}

}

}

]

Propiedades de la actividad de búsqueda

Para obtener información detallada sobre las propiedades, consulte Actividad de búsqueda.

Contenido relacionado

Para obtener una lista de almacenes de datos que la actividad de copia admite como orígenes y receptores, vea Almacenes de datos que se admiten.