Carga de datos en Azure Data Lake Storage Gen1 mediante Azure Data Factory

SE APLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

Azure Data Lake Storage Gen1 (anteriormente conocido como Azure Data Lake Store) es un repositorio de gran escala en toda la empresa para cargas de trabajo de análisis de macrodatos. Azure Data Lake Storage Gen1 permite capturar datos de cualquier tamaño, tipo y velocidad de ingesta. Los datos se capturan en un único lugar para análisis operativos y exploratorios.

Azure Data Factory es un servicio de integración de datos en la nube totalmente administrado. Puede utilizar el servicio para rellenar la instancia de Data Lake Store con datos del sistema actual y ahorrar tiempo al compilar las soluciones de análisis.

Azure Data Factory ofrece las siguientes ventajas para cargar datos en Data Lake Storage Gen1:

- Fácil de configurar: con un asistente intuitivo en cinco pasos sin necesidad de scripting.

- Amplia compatibilidad para el almacenamiento de datos: compatibilidad integrada para un amplio conjunto de almacenes de datos tanto locales como en la nube. Para una lista detallada, consulte la tabla de almacenes de datos admitidos.

- Seguro y compatible: los datos se transfieren a través de HTTPS o ExpressRoute. La presencia del servicio global garantiza que los datos nunca abandonan el límite geográfico.

- Alto rendimiento: hasta 1 GB/s de velocidad de carga de datos en Data Lake Storage Gen1. Para más información, consulte el rendimiento de la actividad de copia.

En este artículo se muestra cómo utilizar la herramienta Copy Data de Data Factory para cargar datos de Amazon S3 en Data Lake Storage Gen1. Puede seguir los mismos pasos para copiar datos de otros tipos de almacenes de datos.

Nota

Para más información, vea Copia de datos con Data Lake Storage Gen1 como origen o destino mediante Azure Data Factory.

Requisitos previos

- Suscripción de Azure: Si no tiene una suscripción a Azure, cree una cuenta gratuita antes de empezar.

- Cuenta de Data Lake Storage Gen1: si no tiene una cuenta de Data Lake Storage Gen1, consulte las instrucciones de Creación de una cuenta de Data Lake Storage Gen1.

- Amazon S3: En este artículo se muestra cómo copiar datos de Amazon S3. Puede usar otros almacenes de datos siguiendo los mismos pasos.

Crear una factoría de datos

Si aún no ha creado la factoría de datos, siga los pasos descritos en Inicio rápido: Creación de una factoría de datos mediante Azure Portal y Azure Data Factory Studio para crear una. Después de crearla, vaya a la factoría de datos en Azure Portal.

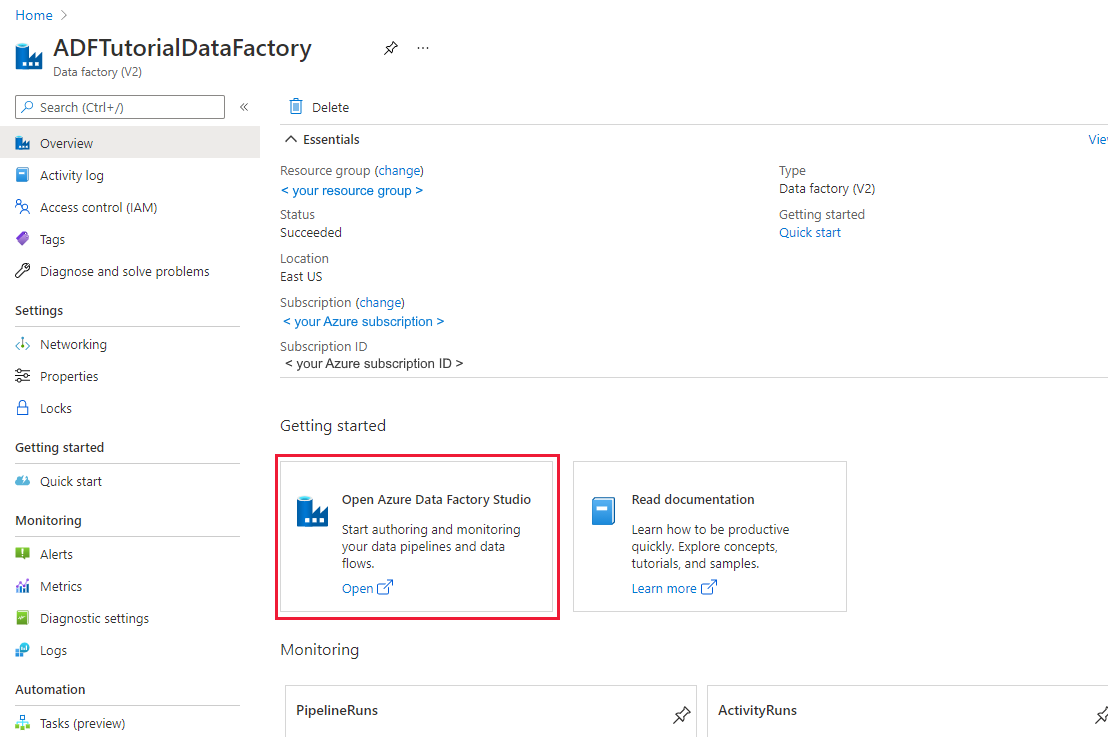

Seleccione Open (Abrir) en el icono Open Azure Data Factory Studio (Abrir Azure Data Factory Studio) para iniciar la aplicación de integración de datos en una pestaña independiente.

Carga de datos en Data Lake Storage Gen1

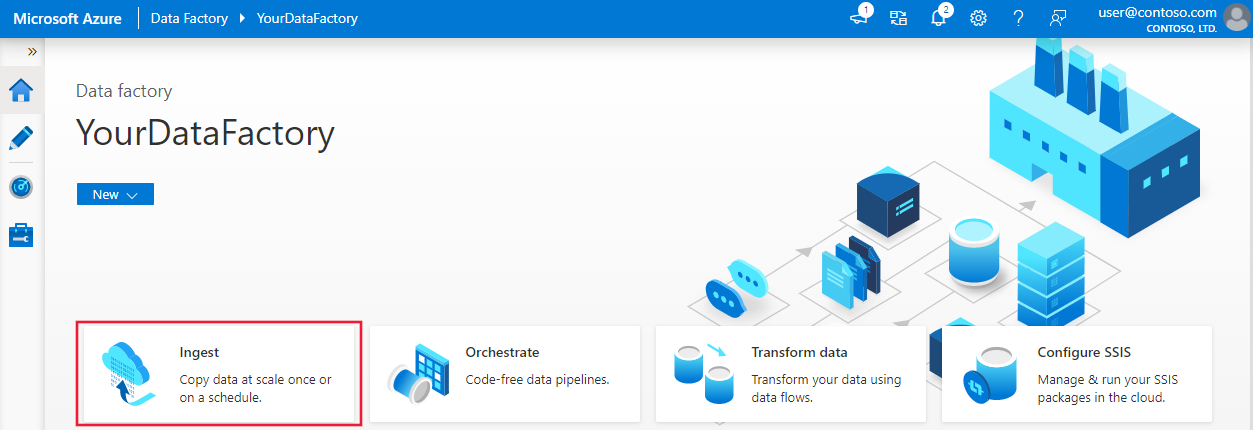

En la página principal, seleccione el icono Ingerir para iniciar la herramienta Copia de datos:

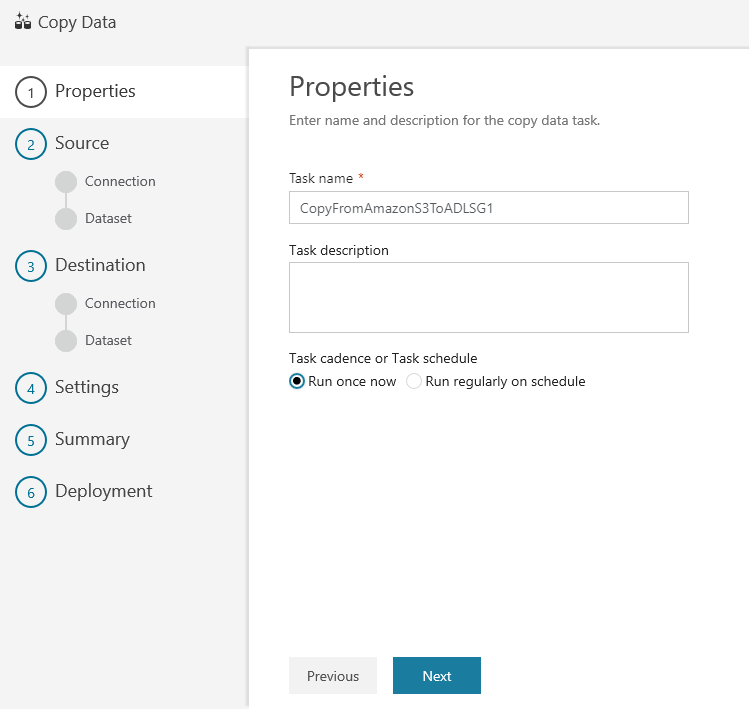

En la página Properties (Propiedades), especifique CopyFromAmazonS3ToADLS en el campo Task name (Nombre de la tarea) y seleccione Next (Siguiente):

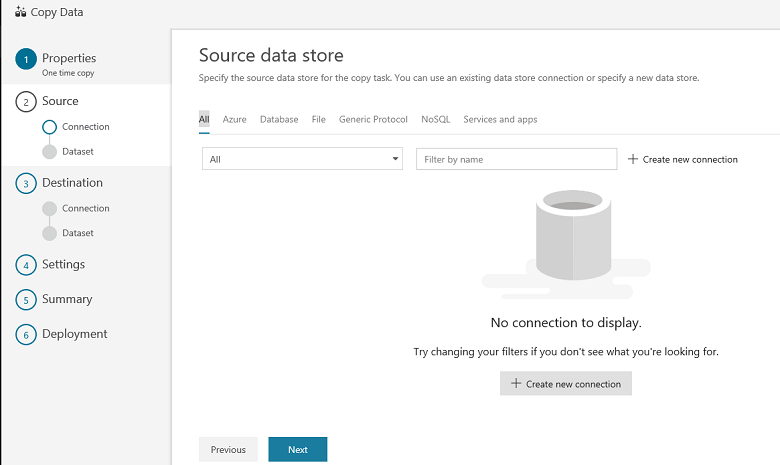

En la página Almacén de datos de origen, haga clic en + Crear una conexión nueva:

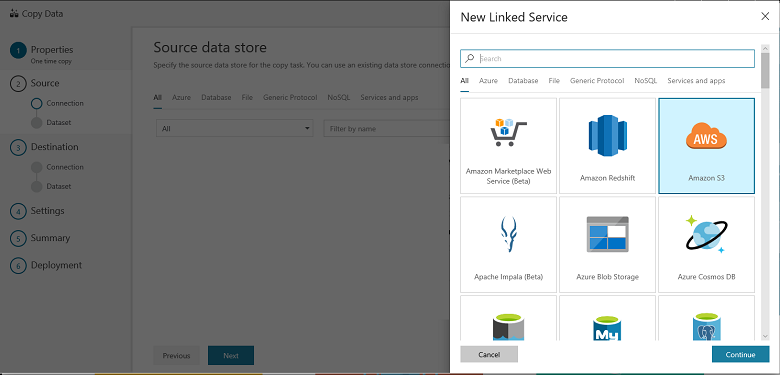

Seleccione Amazon S3 y, luego, seleccione Continuar.

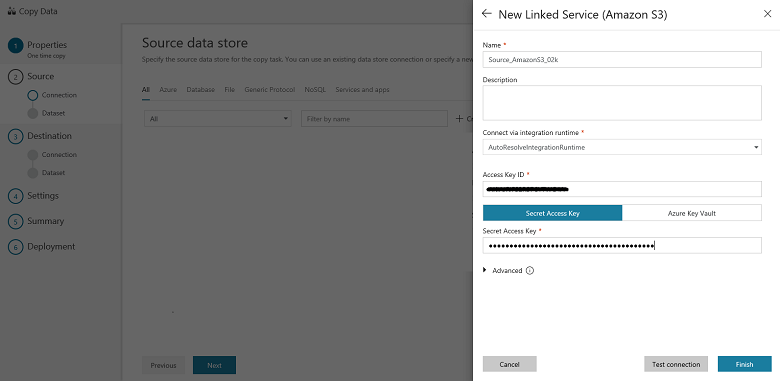

En la página Specify Amazon S3 connection (Especificar conexión de Amazon S3), siga estos pasos:

Especifique el valor de Access Key ID (Identificador de clave de acceso).

Especifique el valor de Secret Access Key (Clave de acceso secreta).

Seleccione Finalizar.

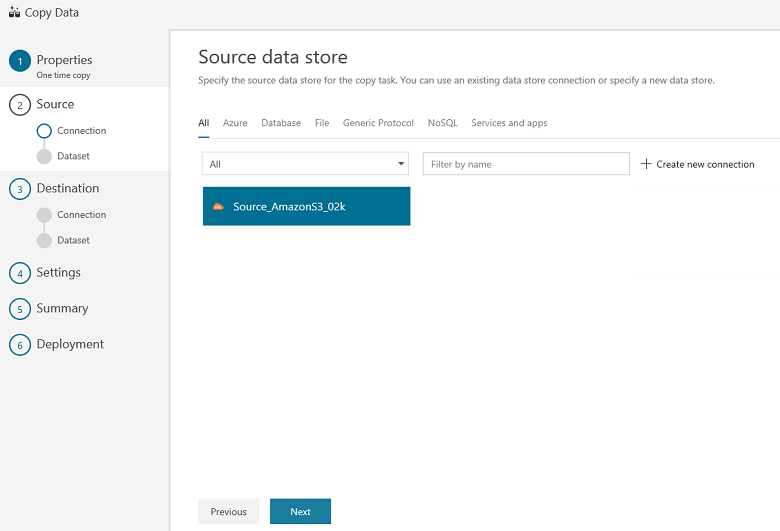

Podrá ver una nueva conexión. Seleccione Siguiente.

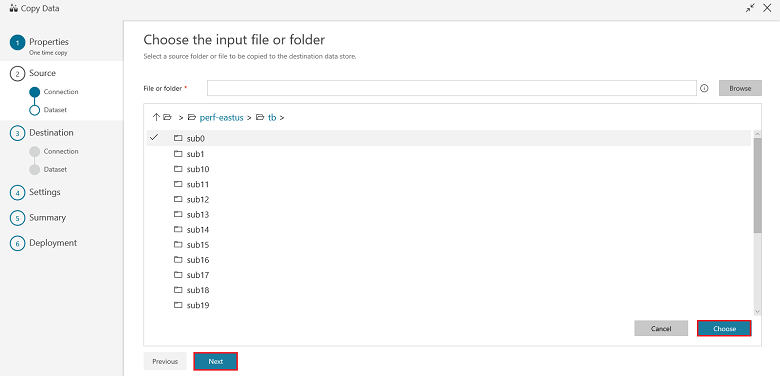

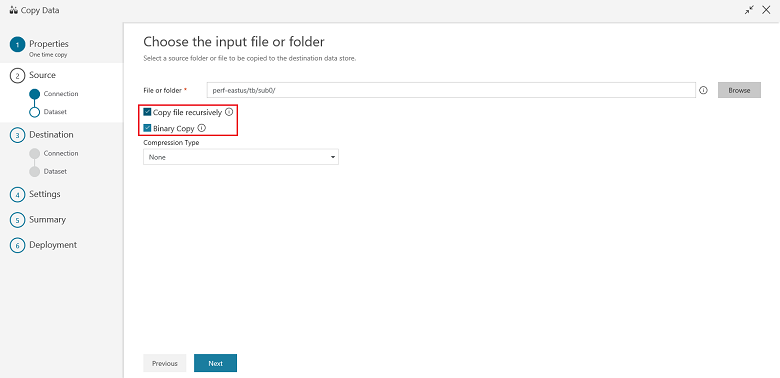

En la página Choose the input file or folder (Elegir archivo o carpeta de entrada), vaya a la carpeta y el archivo que desea copiar. Seleccione la carpeta o el archivo, Choose (Elegir) y Next (Siguiente):

Elija el comportamiento de copia seleccionando las opciones Copy files recursively (Copiar archivos de forma recursiva) y Binary copy (Copia binaria). Haga clic en Siguiente:

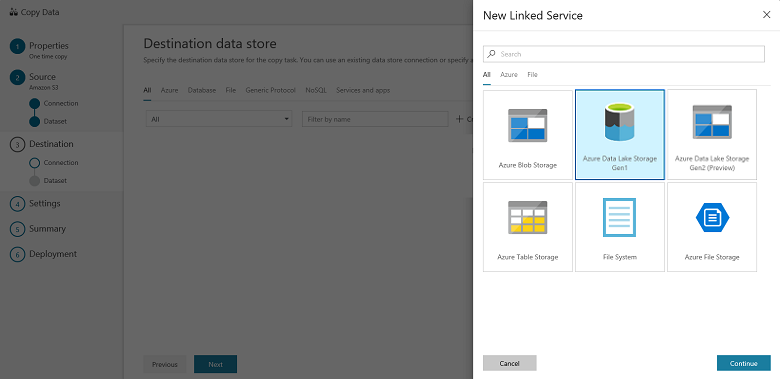

En la página Almacén de datos de destino, seleccione + Crear nueva conexión, después Azure Data Lake Storage Gen1 y Continuar:

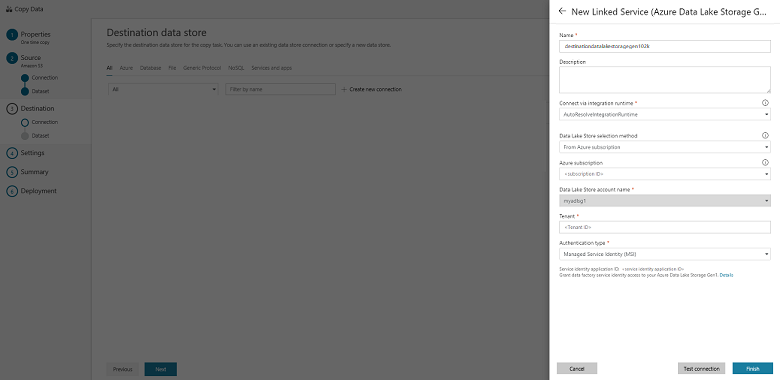

En la página New Linked Service (Azure Data Lake Storage Gen1) [Nuevo servicio vinculado (Azure Data Lake Storage Gen1)], siga estos pasos:

- Seleccione la cuenta de Data Lake Storage Gen1 para el nombre de la cuenta de Data Lake Store.

- Especifique el inquilino y seleccione Finalizar.

- Seleccione Next (Siguiente).

Importante

En este tutorial, utilizará una identidad administrada para recursos de Azure para autenticar la cuenta de Data Lake Storage Gen1. Asegúrese de conceder a MSI los permisos adecuados en Data Lake Storage Gen1 con estas instrucciones.

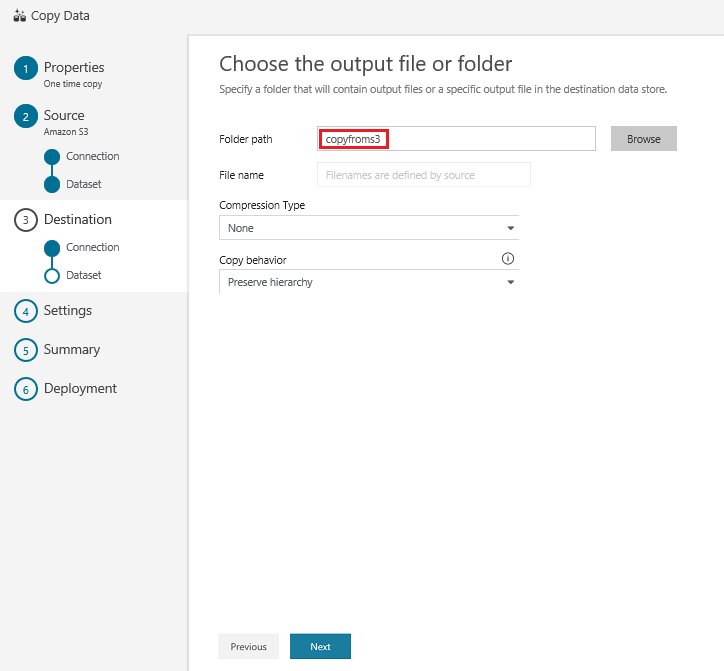

En la página Choose the output file or folder (Elegir archivo o carpeta de salida) escriba copyfroms3 como nombre de la carpeta de salida y seleccione Next (Siguiente):

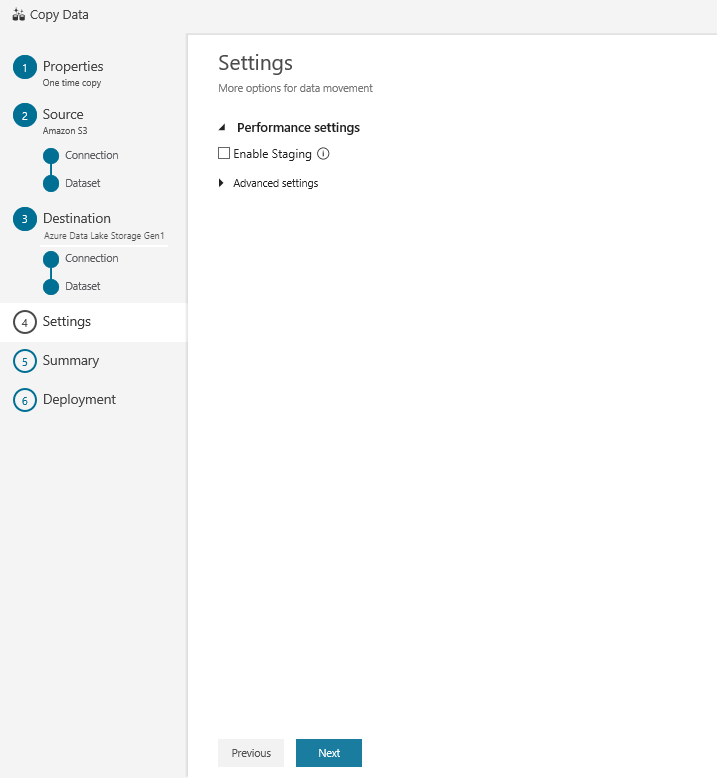

En la página Settings (Configuración), seleccione Next (Siguiente):

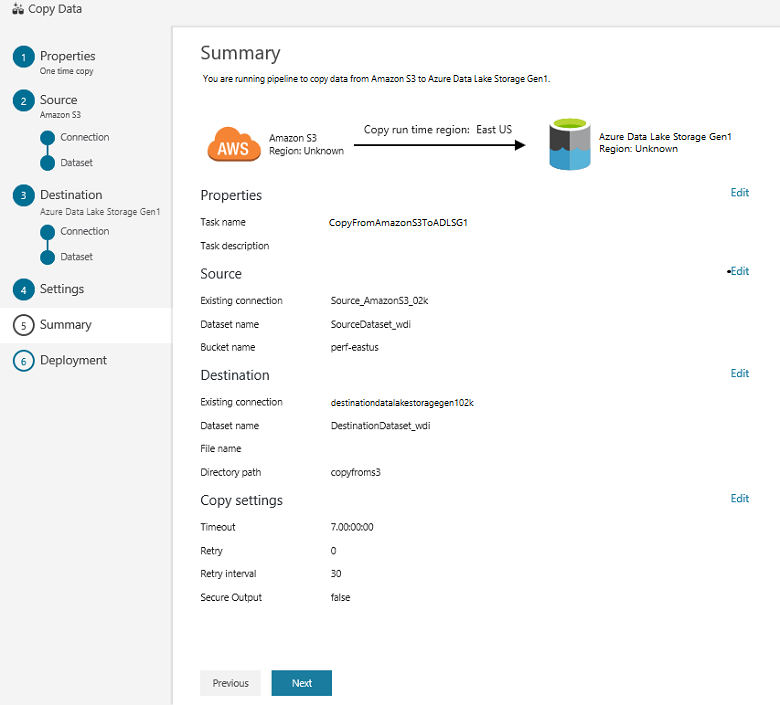

En la página Summary (Resumen), revise la configuración y seleccione Next (Siguiente):

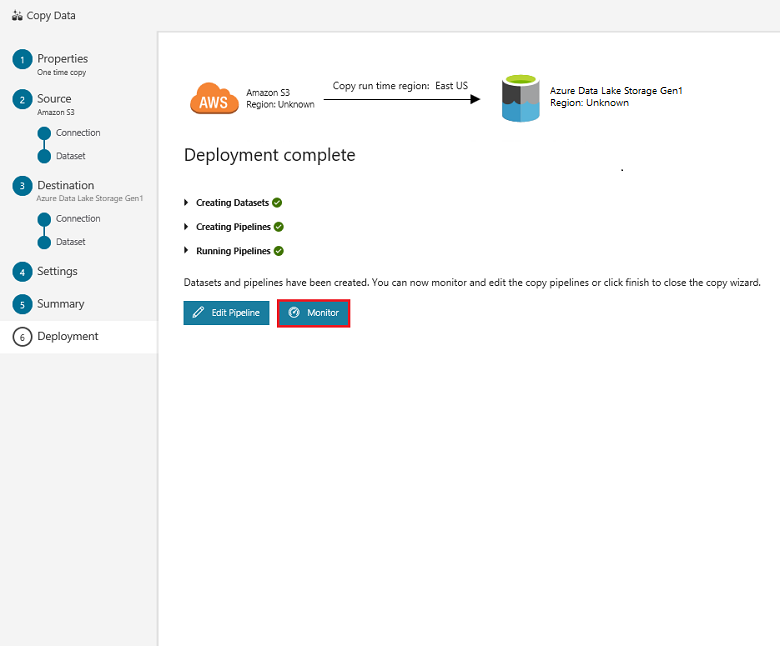

En la página Deployment (Implementación), seleccione Monitor (Supervisión) para supervisar la canalización (tarea):

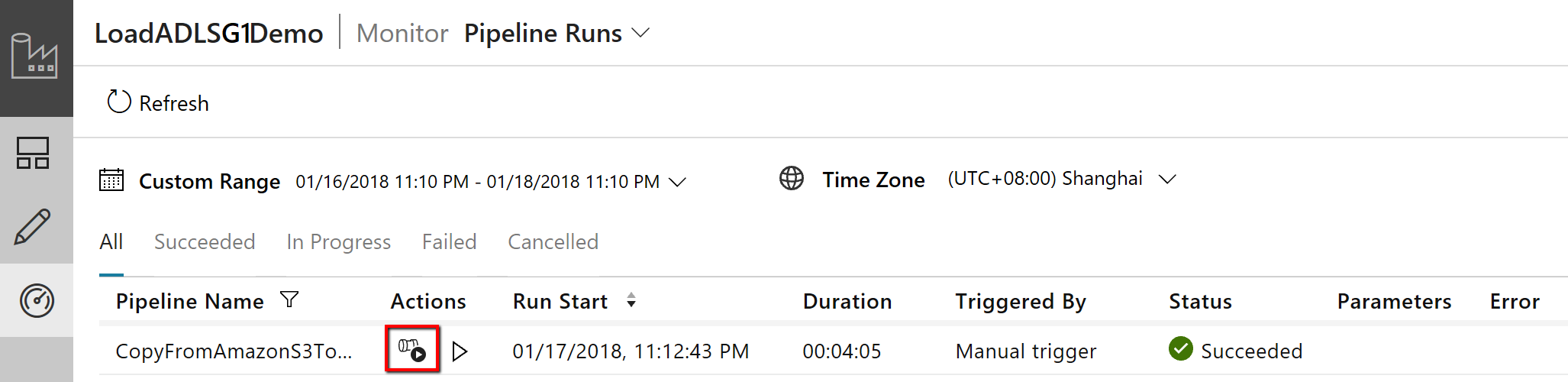

Observe que la pestaña Monitor (Supervisión) de la izquierda se selecciona automáticamente. La columna Actions (Acciones) incluye los vínculos para ver los detalles de la ejecución de actividad y volver a ejecutar la canalización:

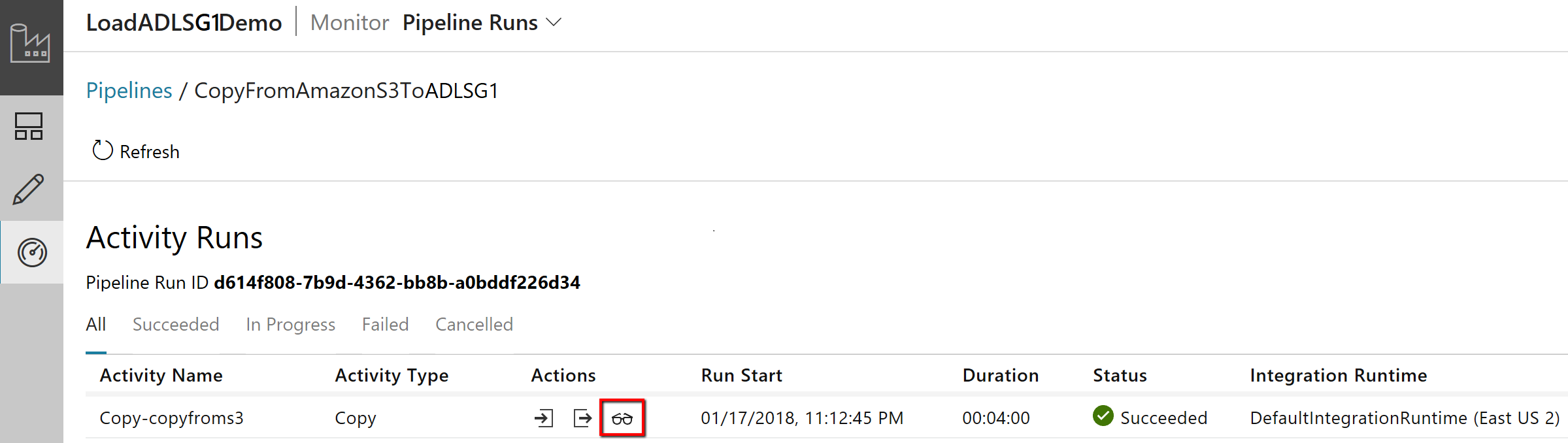

Para ver las ejecuciones de actividad asociadas con la ejecución de canalización, seleccione el vínculo View Activity Runs (Ver ejecuciones de actividad) en la columna Actions (Acciones). Como solo hay una actividad (actividad de copia) en la canalización, solo verá una entrada. Para volver a la vista de ejecuciones de canalización, seleccione el vínculo Pipelines (Canalizaciones) de la parte superior. Seleccione Refresh (Actualizar) para actualizar la lista.

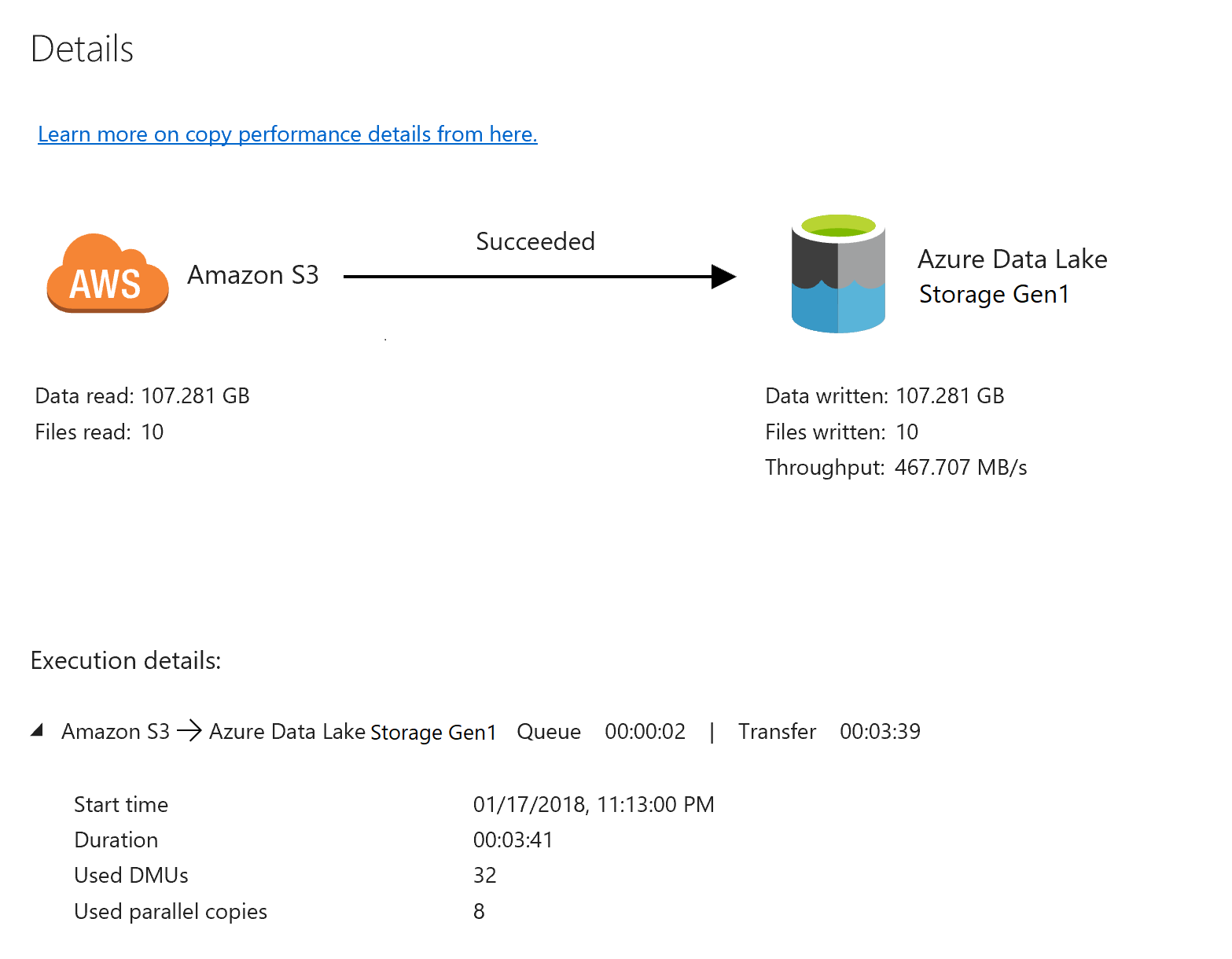

Para supervisar los detalles de la ejecución de cada actividad de copia, seleccione el vínculo Details (Detalles) en Actions (Acciones) en la vista de supervisión de la actividad. Puede supervisar detalles como el volumen de datos copiados desde el origen al receptor, el rendimiento de los datos, los pasos de ejecución con su duración correspondiente y las configuraciones que se utilizan:

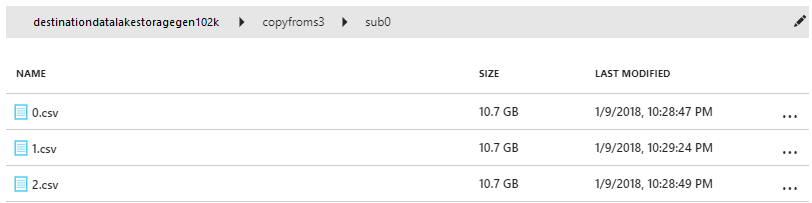

Verifique que los datos se copian en la cuenta de Data Lake Storage Gen1:

Contenido relacionado

Prosiga en el siguiente artículo para obtener información sobre la compatibilidad de Data Lake Storage Gen1: