Inicio rápido: Introducción al uso de GPT-35-Turbo y GPT-4 con el servicio Azure OpenAI en IntelliJ

En este artículo se muestra cómo empezar a trabajar con el servicio Azure OpenAI en IntelliJ IDEA. Muestra cómo usar modelos de chat como GPT-3.5-Turbo y GPT-4 para probar y experimentar con diferentes parámetros y orígenes de datos.

Requisitos previos

Un kit de desarrollo de Java (JDK) admitido Para más información sobre los JDK disponibles para desarrollar en Azure, consulte Compatibilidad con Java en Azure y Azure Stack.

IntelliJ IDEA, Ultimate o Community Edition.

El kit de herramientas de Azure para IntelliJ. Para más información, consulte Instalación del kit de herramientas de Azure para IntelliJ. También debe iniciar sesión en su cuenta de Azure para el kit de herramientas de Azure para IntelliJ. Para más información, consulte Instrucciones de inicio de sesión para El kit de herramientas de Azure para IntelliJ.

Una suscripción a Azure (cree una cuenta gratuita).

Acceso concedido a Azure OpenAl en la suscripción de Azure que quiera.

Actualmente, solo la aplicación concede acceso a este servicio. Puede solicitar acceso a Azure OpenAI completando el formulario en Solicitud de acceso al servicio Azure OpenAI.

Un recurso de Azure OpenAI Service con los modelos

gpt-35-turboogpt-4implementados. Para más información sobre la implementación de modelo, consulte Creación e implementación de un recurso de Azure OpenAI Service.

Instalación e inicio de sesión

Los pasos siguientes le guiarán por el proceso de inicio de sesión de Azure en el entorno de desarrollo de IntelliJ:

Si no tiene instalado el complemento, consulte Kit de herramientas de Azure para IntelliJ.

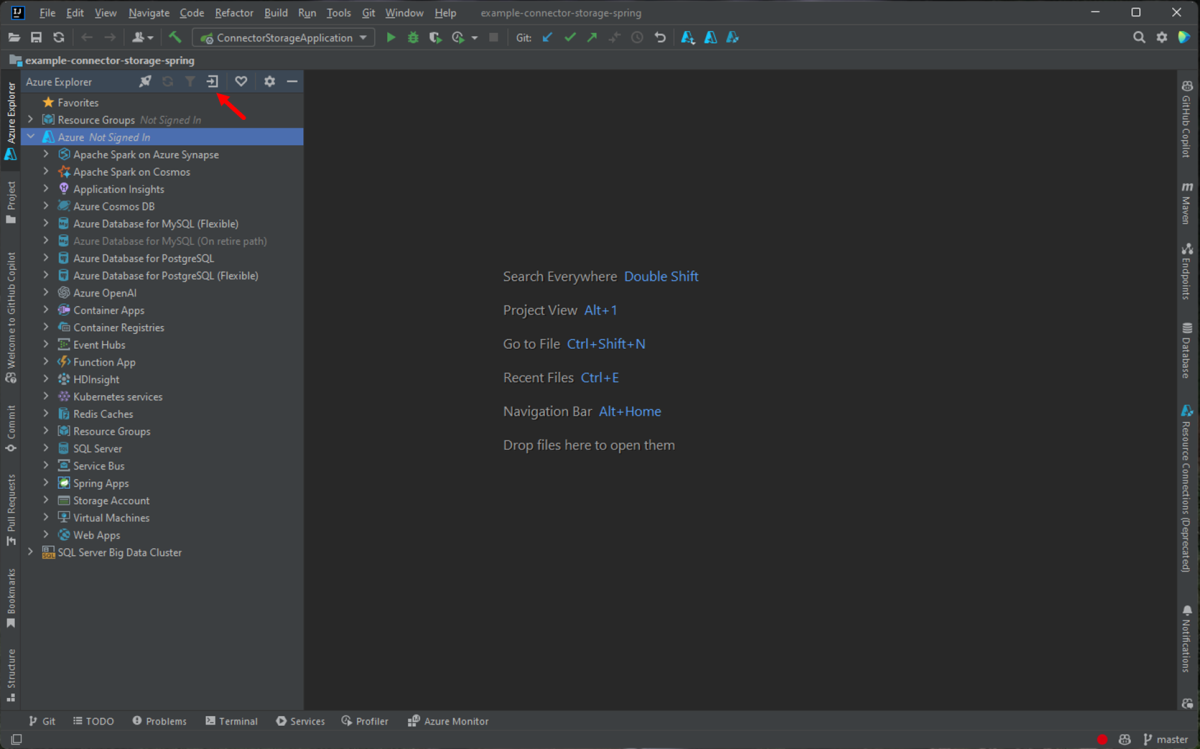

Para iniciar sesión en su cuenta de Azure, vaya a la barra lateral izquierda de Azure Explorer y seleccione el icono De inicio de sesión de Azure. Como alternativa, puede ir a Herramientas, expandir Azure y, a continuación, seleccionar Inicio de sesión de Azure.

En la ventana Inicio de sesión de Azure, seleccione OAuth 2.0 y, a continuación, seleccione Iniciar sesión. Para ver otras opciones de inicio de sesión, consulte el artículo en el que se proporcionan las Instrucciones de inicio de sesión del kit de herramientas de Azure para IntelliJ.

En el explorador, inicie sesión con su cuenta que tenga acceso al recurso de OpenAI y vuelva a IntelliJ. En el cuadro de diálogo Seleccionar suscripciones , seleccione la suscripción que desea usar y, a continuación, seleccione Seleccionar.

Creación e implementación de un recurso de Azure OpenAI Service

Después del flujo de trabajo de inicio de sesión, haga clic con el botón derecho en el elemento Azure OpenAI en Azure Explorer y seleccione Crear servicio Azure OpenAI.

En el cuadro de diálogo Crear servicio OpenAI de Azure, especifique la siguiente información y, a continuación, seleccione Aceptar:

- Nombre: un nombre descriptivo para el recurso del servicio Azure OpenAI, como MyOpenAIResource. Este nombre también es el nombre de dominio personalizado en el punto de conexión. El nombre del recurso solo puede incluir caracteres alfanuméricos y guiones, y no puede empezar ni terminar con un guión.

- Región: la ubicación de la instancia. Algunos modelos solo están disponibles en regiones específicas. Para obtener más información, consulte Modelos de servicio de OpenAI de Azure.

- Sku: los recursos estándar de Azure OpenAI se facturan en función del uso del token. Para más información, consulte Precios del servicio Azure OpenAI.

Para poder usar finalizaciones de chat, debe implementar un modelo. Haga clic con el botón derecho en la instancia de Azure OpenAI y seleccione Crear nueva implementación. En el cuadro de diálogo Crear implementación de Azure OpenAI emergente, especifique la siguiente información y, a continuación, seleccione Aceptar:

- Nombre de implementación: elija un nombre cuidadosamente. El nombre de implementación se usa en el código para llamar al modelo a través de las bibliotecas de cliente y las API de REST.

- Modelo: seleccione un modelo. La disponibilidad de los modelos varía según la región. Para obtener una lista de los modelos disponibles por región, consulte la sección Tabla de resumen de modelos y disponibilidad de regiones de los modelos de azure OpenAI Service.

El kit de herramientas muestra un mensaje de estado cuando la implementación está completa y lista para su uso.

Interacción con Azure OpenAI mediante avisos y configuraciones

Haga clic con el botón derecho en el recurso de Azure OpenAI y seleccione Abrir en ai Playground.

Puede empezar a explorar las funcionalidades de OpenAI a través del área de juegos de Chat de Azure OpenAI Studio en IntelliJ IDEA.

Para desencadenar la finalización, puede escribir texto como mensaje. El modelo genera la finalización e intenta que coincida con el contexto o el patrón.

Para iniciar una sesión de chat, siga estos pasos:

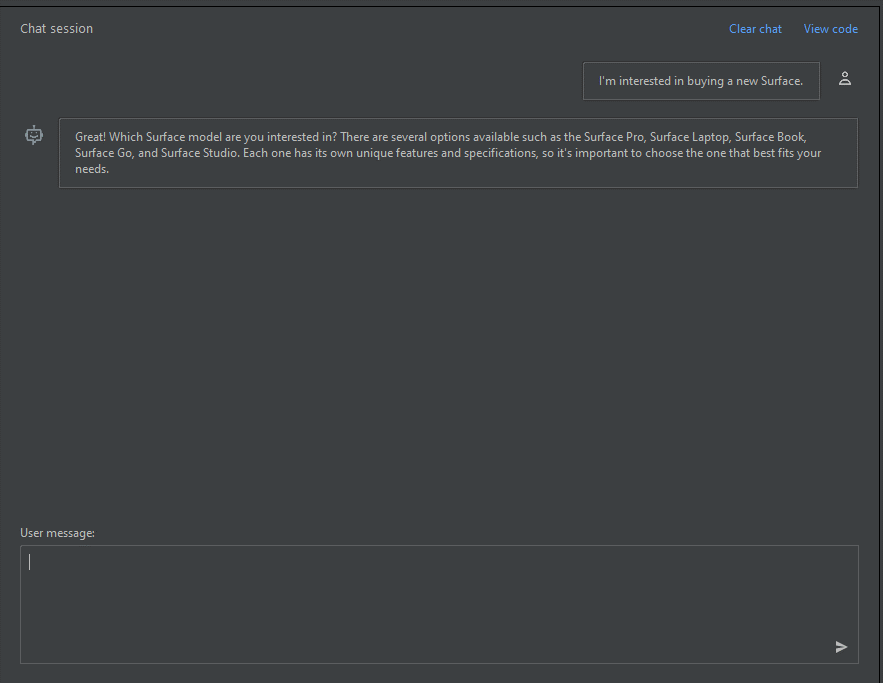

En el panel de sesión de chat, puedes empezar con un mensaje sencillo como este: "Estoy interesado en comprar una nueva Surface". Después de escribir el mensaje, seleccione Enviar. Recibirá una respuesta similar al ejemplo siguiente:

Great! Which Surface model are you interested in? There are several options available such as the Surface Pro, Surface Laptop, Surface Book, Surface Go, and Surface Studio. Each one has its own unique features and specifications, so it's important to choose the one that best fits your needs.Escriba una pregunta de seguimiento como: "¿Qué modelos admiten GPU?" y seleccione Enviar. Recibirá una respuesta similar al ejemplo siguiente:

Most Surface models come with an integrated GPU (Graphics Processing Unit), which is sufficient for basic graphics tasks such as video playback and casual gaming. However, if you're looking for more powerful graphics performance, the Surface Book 3 and the Surface Studio 2 come with dedicated GPUs. The Surface Book 3 has an NVIDIA GeForce GTX GPU, while the Surface Studio 2 has an NVIDIA GeForce GTX 1060 or 1070 GPU, depending on the configuration.Ahora que tiene una conversación básica, seleccione Ver código en el panel y tenga una reproducción del código detrás de toda la conversación hasta ahora. Puede ver los ejemplos de código basados en el SDK de Java, curl y JSON que corresponden a la configuración y la sesión de chat, como se muestra en la captura de pantalla siguiente:

A continuación, puede seleccionar Copiar para tomar este código y escribir una aplicación para completar la misma tarea que está realizando actualmente con el área de juegos.

Configuración

Puede seleccionar la pestaña Configuración para establecer los parámetros siguientes:

| Nombre | Descripción |

|---|---|

| Respuesta máxima | Establece un límite en el número de tokens por respuesta del modelo. La API admite un máximo de 4096 tokens compartidos entre la solicitud (incluidos el mensaje del sistema, los ejemplos, el historial de mensajes y la consulta del usuario) y la respuesta del modelo. Un token equivale aproximadamente a cuatro caracteres de un texto típico en inglés. |

| Temperatura | Controla la aleatoriedad. Reducir la temperatura significa que el modelo genera respuestas más repetitivas y deterministas. Aumentar la temperatura da como resultado respuestas más inesperadas o creativas. Intente ajustar la temperatura o las probabilidades principales, pero no ambas. |

| Probabilidades principales | De forma similar a la temperatura, controla la aleatoriedad, pero usa un método diferente. Al reducir el valor De probabilidad superior, se reduce la selección del token del modelo a tokens con valores similares. Aumentar el valor permite que el modelo elija entre tokens con probabilidad alta y baja. Intente ajustar la temperatura o las probabilidades principales, pero no ambas. |

| Secuencias de detención | Hace que el modelo finalice su respuesta en un punto deseado. La respuesta del modelo finaliza antes de la secuencia especificada, por lo que no contiene el texto de la secuencia de detención. Para GPT-35-Turbo, el uso de <|im_end|> garantiza que la respuesta del modelo no genere una consulta de usuario de seguimiento. Puede incluir hasta cuatro secuencias de detención. |

| Penalización de frecuencia | Reduce la posibilidad de repetir un token proporcionalmente en función de la frecuencia con la que aparece en el texto hasta ahora. Esta acción reduce la probabilidad de repetir exactamente el mismo texto en una respuesta. |

| Penalización de presencia | Reduce la posibilidad de repetir cualquier token que aparezca en el texto en absoluto hasta ahora. Así aumenta la probabilidad de introducir nuevos temas en una respuesta. |

Limpieza de recursos

Una vez que haya terminado de probar el área de juegos de chat, si desea limpiar y quitar un recurso de OpenAI, puede eliminar el recurso o el grupo de recursos. Al eliminar el grupo de recursos, también se elimina cualquier otro recurso que esté asociado a él. Siga estos pasos para limpiar los recursos:

Para eliminar los recursos de Azure OpenAI, vaya a la barra lateral izquierda de Azure Explorer y busque el elemento Azure OpenAI .

Haga clic con el botón derecho en el servicio Azure OpenAI que desea eliminar y, a continuación, seleccione Eliminar.

Para eliminar el grupo de recursos, visite Azure Portal y elimine manualmente los recursos de la suscripción.

Pasos siguientes

Para obtener más información, consulte Aprenda a trabajar con los modelos GPT-35-Turbo y GPT-4.

Para obtener más ejemplos, consulte el repositorio de GitHub de ejemplos de Azure OpenAI.