Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

El editor sin código permite desarrollar un trabajo de Stream Analytics sin esfuerzo para procesar los datos de streaming en tiempo real, mediante la funcionalidad de arrastrar y colocar, sin necesidad de escribir una sola línea de código. La experiencia proporciona un lienzo que permite conectarse a orígenes de entrada para ver rápidamente los datos de streaming. Después, puede transformarlo antes de escribir a los destinos.

Con el editor sin código, puede hacer lo siguiente fácilmente:

- Modificar los esquemas de entrada.

- Realizar operaciones de preparación de datos, como combinaciones y filtros.

- Abordar escenarios avanzados, como agregaciones de ventana de tiempo (ventanas de saltos de tamaño constante, de saltos y de sesiones) en operaciones de agrupación.

Después de crear y ejecutar los trabajos de Stream Analytics, puede operacionalizar fácilmente las cargas de trabajo de producción. Use el conjunto adecuado de métricas integradas con fines de supervisión y de solución de problemas. Los trabajos de Stream Analytics se facturan según el modelo de precios cuando se ejecutan.

Requisitos previos

Antes de desarrollar trabajos de Stream Analytics con el editor sin código, debe cumplir estos requisitos:

- Los orígenes de entrada de streaming y los recursos de destino del trabajo de Stream Analytics deben ser accesibles públicamente y no pueden estar en una red virtual de Azure.

- Debe tener los permisos necesarios para acceder a los recursos de entrada y salida de streaming.

- Debe mantener los permisos para crear y modificar recursos de Azure Stream Analytics.

Nota

El editor sin código no está disponible actualmente en la región de China.

Trabajo de Azure Stream Analytics

Un trabajo de Stream Analytics se basa en tres componentes principales: entradas de streaming, transformaciones y salidas. Puede tener tantos componentes como quiera, incluidas varias entradas, ramas paralelas con varias transformaciones y varias salidas. Para obtener más información, vea Documentación de Azure Stream Analytics.

Nota

Las siguientes funcionalidades y tipos de salida no están disponibles cuando se usa el editor sin código:

- Funciones definidas por el usuario.

- Edición de consultas en la hoja de consulta de Azure Stream Analytics. Sin embargo, puede ver la consulta generada por el editor sin código en la hoja de consulta.

- Adición de entrada y salida en hojas de entrada y salida de Azure Stream Analytics. Sin embargo, puede ver la entrada/salida generada por el editor sin código en la hoja de entrada y salida.

- Los siguientes tipos de salida no están disponibles: Azure Functions, ADLS Gen1, PostgreSQL DB, cola o tema de Service Bus, Table Storage.

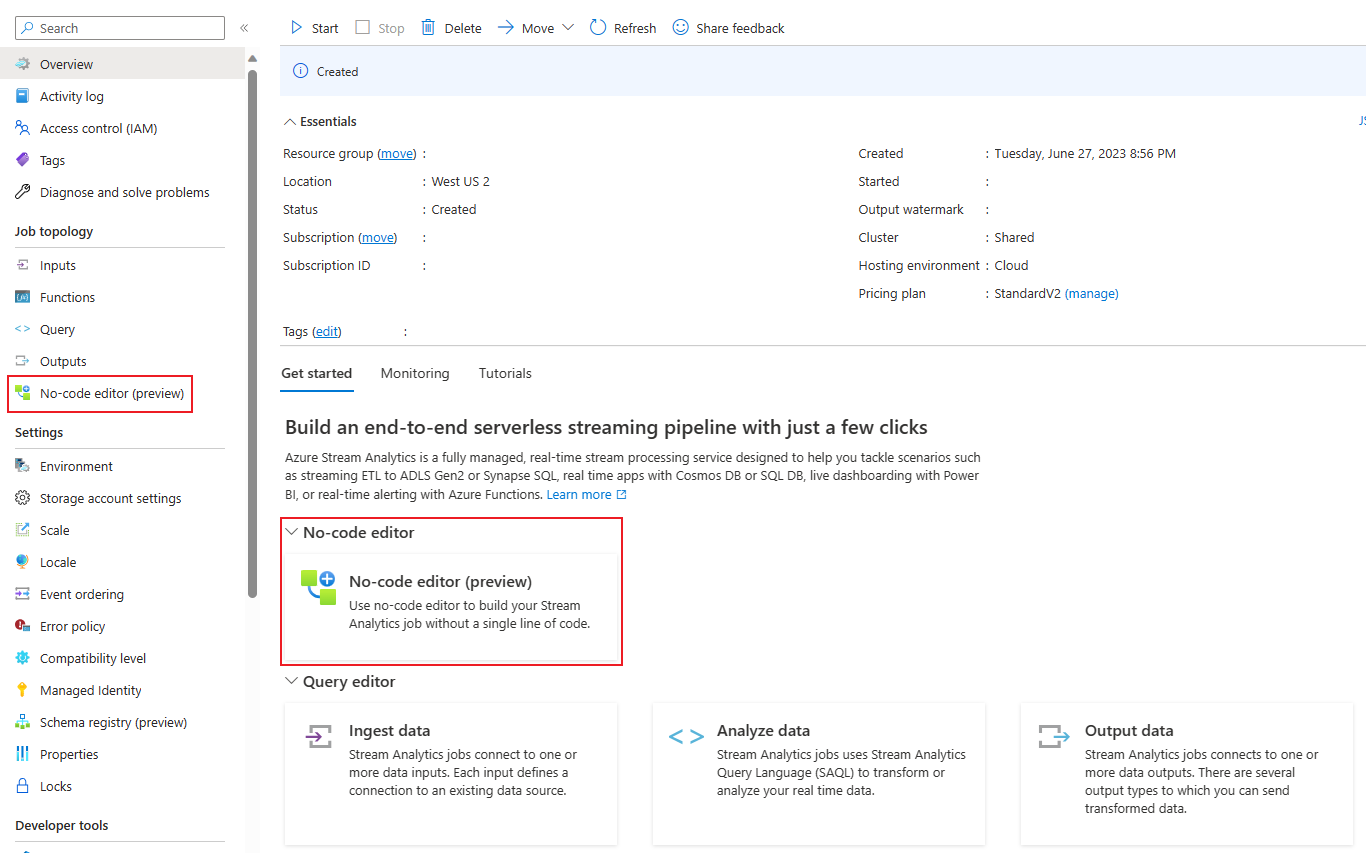

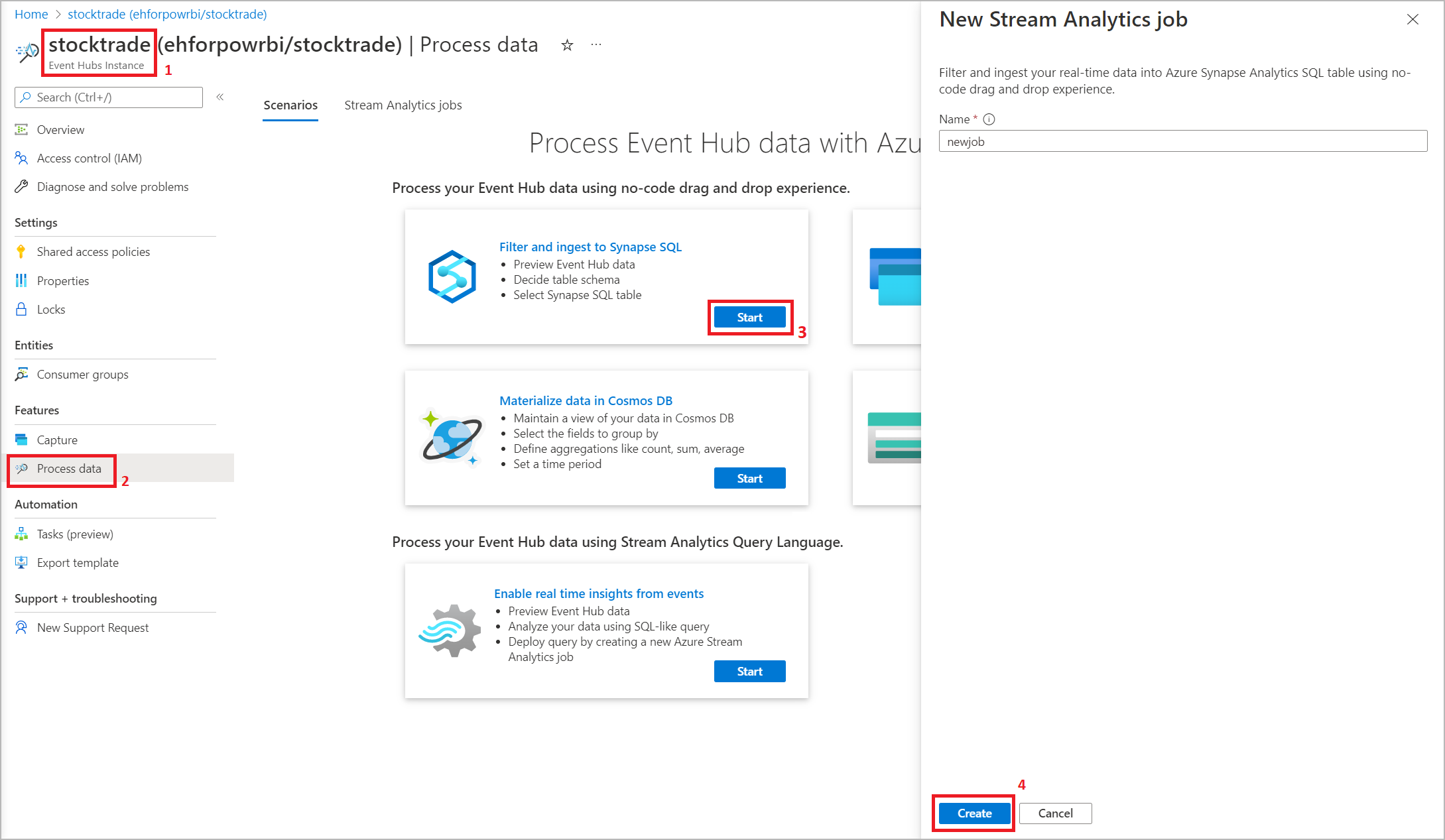

Para acceder al editor sin código para compilar el trabajo de Stream Analytics, hay dos enfoques:

Mediante el portal de Azure Stream Analytics (versión preliminar): cree un trabajo de Stream Analytics y luego seleccione el editor sin código en la pestaña Comenzar en la hoja Información general, o seleccione Editor sin código en el panel izquierdo.

Mediante el portal de Azure Event Hubs: Abra una instancia de Event Hubs. Seleccione Procesar datos y, después, seleccione cualquier plantilla predefinida.

Las plantillas predefinidas pueden ayudarle a desarrollar y ejecutar un trabajo para abordar diversos escenarios, entre los que se incluyen:

- Creación de un panel en tiempo real con un conjunto de datos de Power BI

- Captura de datos de Event Hubs en formato de Delta Lake (versión preliminar)

- Filtrado e ingesta en Azure Synapse SQL

- Captura de datos de Event Hubs en formato Parquet en Azure Data Lake Storage Gen2

- Materialización de datos en Azure Cosmos DB

- Filtrado e ingesta en Azure Data Lake Storage Gen2

- Enriquecimiento de datos e ingesta en el centro de eventos

- Transformación y almacenamiento de datos en la base de datos de Azure SQL

- Filtrado e ingesta en Azure Data Explorer

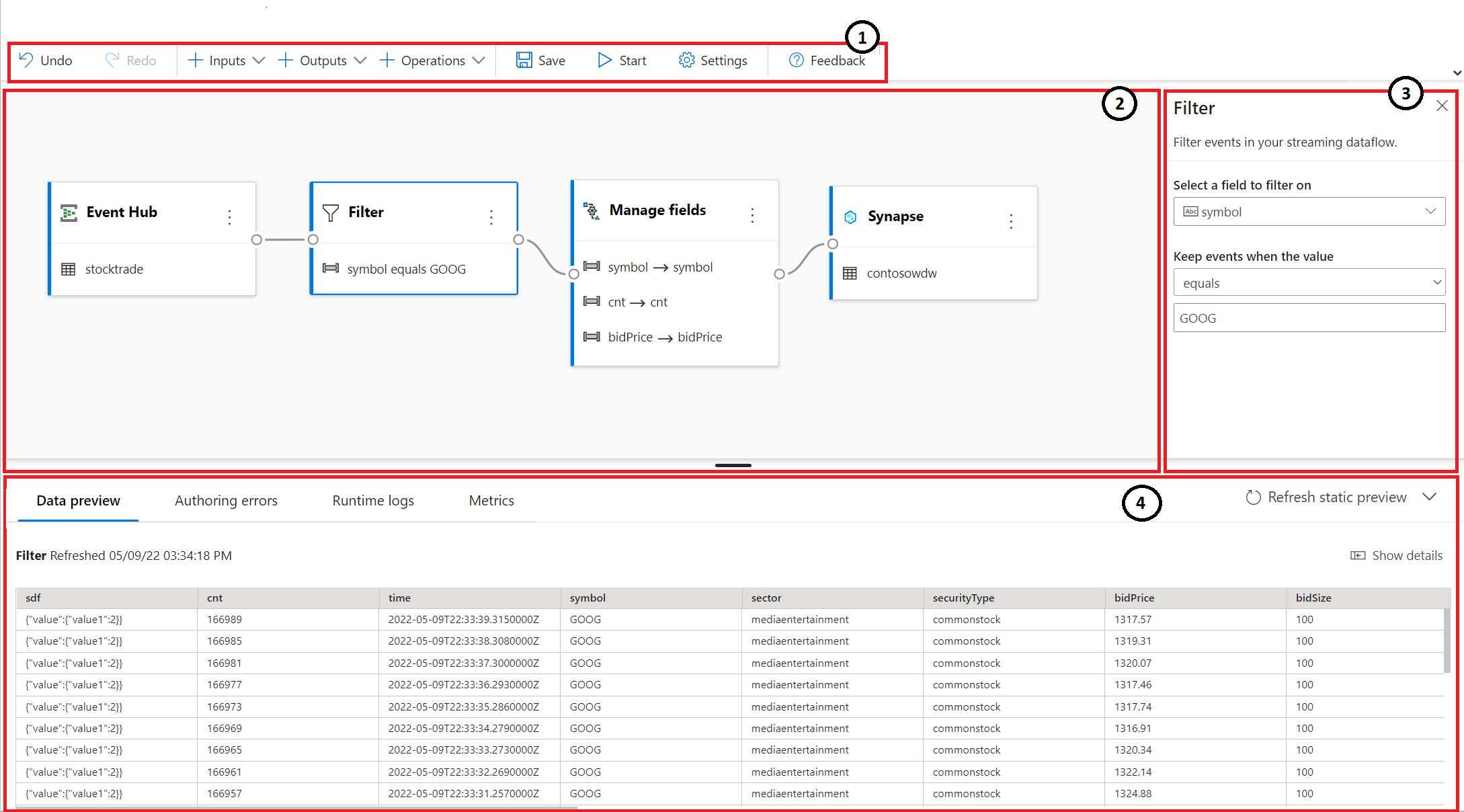

La siguiente captura de pantalla muestra un trabajo de Stream Analytics completado. Se resaltan todas las secciones disponibles mientras la creamos.

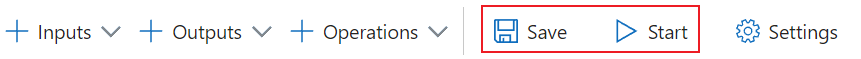

- Cinta de opciones: en la cinta de opciones, las secciones siguen el orden de un proceso de análisis clásico: un centro de eventos como entrada (también conocido como origen de datos), transformaciones (operaciones de streaming de extracción, transformación y carga), salidas, un botón para guardar el progreso y un botón para iniciar el trabajo.

- Vista de diagrama: es una representación gráfica del trabajo de Stream Analytics, desde la entrada a las operaciones, hasta las salidas.

- Panel lateral: en función del componente que haya seleccionado en la vista de diagrama, se mostrarán opciones para modificar la entrada, la transformación o la salida.

- Pestañas de vista previa de datos, errores de creación, registros en tiempo de ejecución y métricas: la vista previa de datos muestra para cada icono los resultados de ese paso (en directo en el caso de las entradas y a petición en el caso de las transformaciones y las salidas). En esta sección también se resumen los errores o advertencias de creación que pueden aparecer en el trabajo a medida que va desarrollándolo. Al seleccionar cada error o advertencia, se selecciona esa transformación. También proporciona las métricas del trabajo para supervisar el estado del trabajo en ejecución.

Entrada de datos de streaming

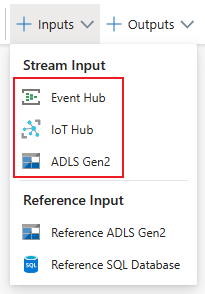

El editor sin código admite la entrada de datos de streaming de tres tipos de recursos:

- Azure Event Hubs

- Azure IoT Hub

- Azure Data Lake Storage Gen2

Para obtener más información sobre las entradas de streaming, consulte Transmisión de datos como entrada en Stream Analytics.

Nota

El editor sin código del portal de Azure Event Hubs solo tiene un Centro de eventos como opción de entrada.

Azure Event Hubs como entrada de streaming

Azure Event Hubs es una plataforma de streaming de macrodatos y un servicio de ingesta de eventos. Puede recibir y procesar millones de eventos por segundo. Los datos enviados a un centro de eventos se pueden transformar y almacenar mediante cualquier proveedor de análisis en tiempo real o adaptadores de procesamiento por lotes y almacenamiento.

Para configurar un centro de eventos como entrada del trabajo, seleccione el icono Centro de eventos. Aparece un mosaico en la vista de diagrama, así como un panel lateral para su configuración y conexión.

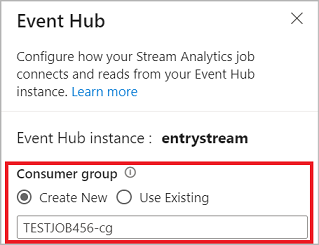

Al conectarse al centro de eventos en el editor sin código, se recomienda crear un nuevo grupo de consumidores (que es la opción predeterminada). Este enfoque ayuda a evitar que el centro de eventos alcance el límite de lectores simultáneos. Para obtener más información sobre los grupos de consumidores y si debe seleccionar un grupo de consumidores existente o crear uno nuevo, consulte Grupos de consumidores.

Si el centro de eventos está en el nivel Básico, solo puede usar el grupo de consumidores $Default existente. Si el centro de eventos está en el nivel Estándar o Premium, puede crear un nuevo grupo de consumidores.

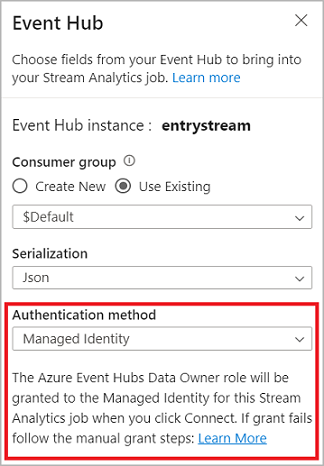

Al conectarse al centro de eventos, si selecciona Identidad administrada como modo de autenticación, se concederá a la identidad administrada el rol Propietario de datos de Azure Event Hubs para el trabajo de Stream Analytics. Para más información sobre las identidades administradas de un centro de eventos, consulte Uso de identidades administradas para acceder a Event Hubs desde un trabajo de Azure Stream Analytics.

Las identidades administradas eliminan las limitaciones de los métodos de autenticación basados en el usuario. Estas limitaciones incluyen la necesidad de volver a autenticarse debido a cambios de contraseña o a las expiraciones de los token de usuario que se producen cada 90 días.

Después de configurar los detalles del centro de eventos y seleccionar Conectar, puede agregar campos manualmente mediante + Agregar campo si conoce los nombres de estos. Para detectar campos y tipos de datos automáticamente en función de un ejemplo de los mensajes entrantes, seleccione Detección automática de campos. Al seleccionar el símbolo de engranaje, puede editar las credenciales si es necesario.

Cuando el trabajo de Stream Analytics detecte los campos, estos aparecerán en la lista. También verá una vista previa activa de los mensajes entrantes en la tabla Vista previa de datos en la vista de diagrama.

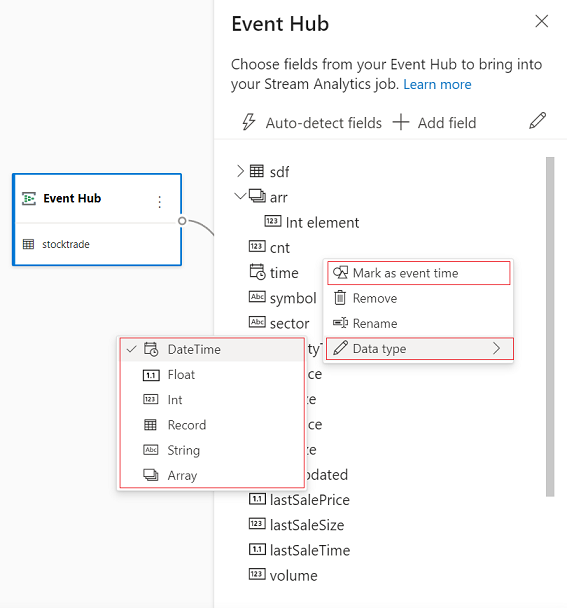

Modificación de los datos de entrada

Puede editar los nombres de los campos, eliminar campos, cambiar el tipo de datos o cambiar la hora del evento (Marcar como hora del evento: cláusula TIMESTAMP BY si es un campo de tipo datetime), seleccionando el símbolo de tres puntos junto a cada campo. También puede expandir, seleccionar y editar los campos anidados de los mensajes entrantes, como se muestra en la imagen siguiente.

Sugerencia

Esto también se aplica a los datos de entrada de Azure IoT Hub y Azure Data Lake Storage Gen2.

Estos son los tipos de datos disponibles:

- DateTime: campo de fecha y hora en formato ISO.

- Float: número decimal.

- Int: número entero.

- Record: objeto anidado con varios registros.

- String: texto.

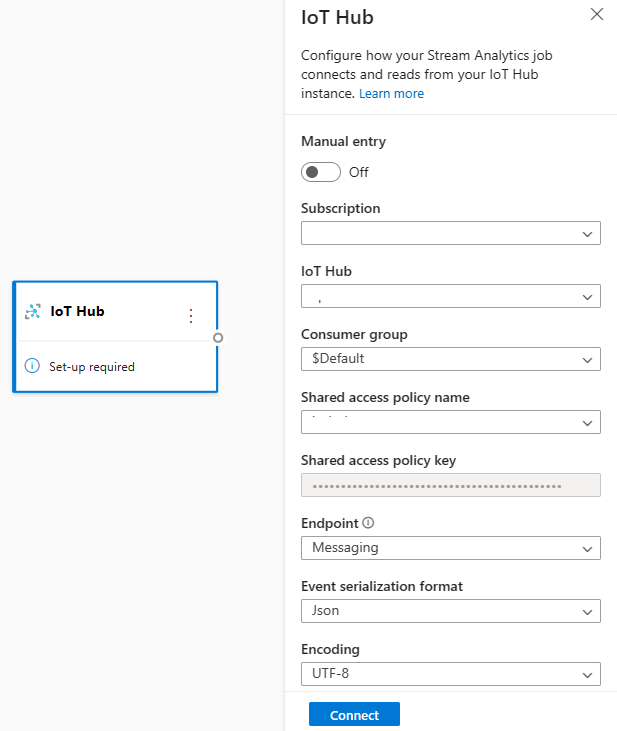

Azure IoT Hub como entrada de streaming

Azure IoT Hub es un servicio administrado, hospedado en la nube, que actúa como centro de mensajes para la comunicación entre una aplicación de IoT y los dispositivos conectados. Los datos del dispositivo IoT enviados a IoT Hub se pueden usar como entrada para un trabajo de Stream Analytics.

Nota

Azure IoT Hub entrada está disponible en el editor sin código en el portal de Azure Stream Analytics.

Para agregar un centro de IoT como entrada de streaming para el trabajo, seleccione el IoT Hub en Entradas de la cinta. A continuación, rellene la información necesaria en el panel derecho para conectar IoT Hub al trabajo. Para obtener más información sobre los detalles de cada campo, consulteTransmisión de datos de IoT Hub al trabajo de Stream Analytics.

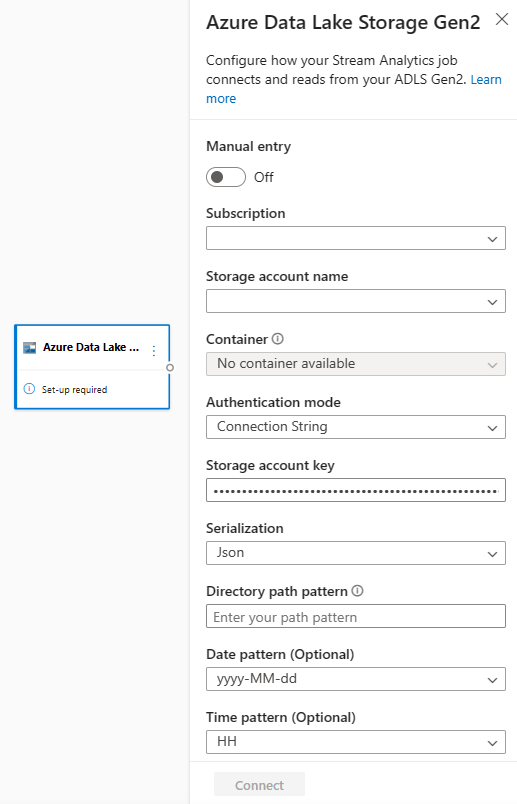

Azure Data Lake Storage Gen2 como entrada de streaming

Azure Data Lake Storage Gen2 (ADLS Gen2) es una solución de lago de datos empresarial basada en la nube. Está diseñado para almacenar grandes cantidades de datos en cualquier formato y para facilitar las cargas de trabajo analíticas de macrodatos. Stream Analytics puede procesar los datos almacenados en ADLS Gen2 como un flujo de datos. Para obtener más información sobre este tipo de entrada, consulte Transmisión de datos de ADLS Gen2 al trabajo de Stream Analytics

Nota

La entrada de Azure Data Lake Storage Gen2 está disponible en el editor sin código en el portal de Azure Stream Analytics.

Para agregar un ADLS Gen2 como entrada de streaming para su trabajo, seleccione el ADLS Gen2 en Entradas de la cinta. A continuación, rellene la información necesaria en el panel derecho para conectar ADLS Gen2 al trabajo. Para obtener más información sobre los detalles de cada campo, consulte Transmisión de datos de ADLS Gen2 al trabajo de Stream Analytics

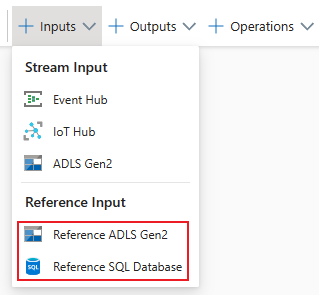

Entradas de datos de referencia

Los datos de referencia son estáticos o cambian lentamente con el tiempo. Normalmente se usan para enriquecer las secuencias entrantes y realizar búsquedas en el trabajo. Por ejemplo, puede combinar los datos de entrada del flujo de datos con los datos de referencia, de la misma forma que realizaría una combinación de SQL para buscar valores estáticos. Para obtener más información sobre las entradas de datos de referencia, consulte Uso de datos de referencia para las búsquedas en Stream Analytics.

El editor sin código ahora admite dos orígenes de datos de referencia:

- Azure Data Lake Storage Gen2

- Azure SQL Database

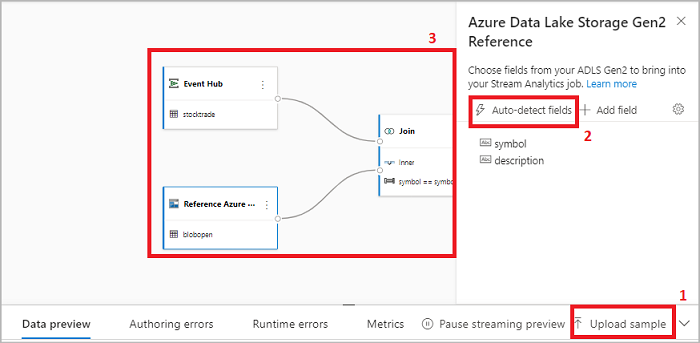

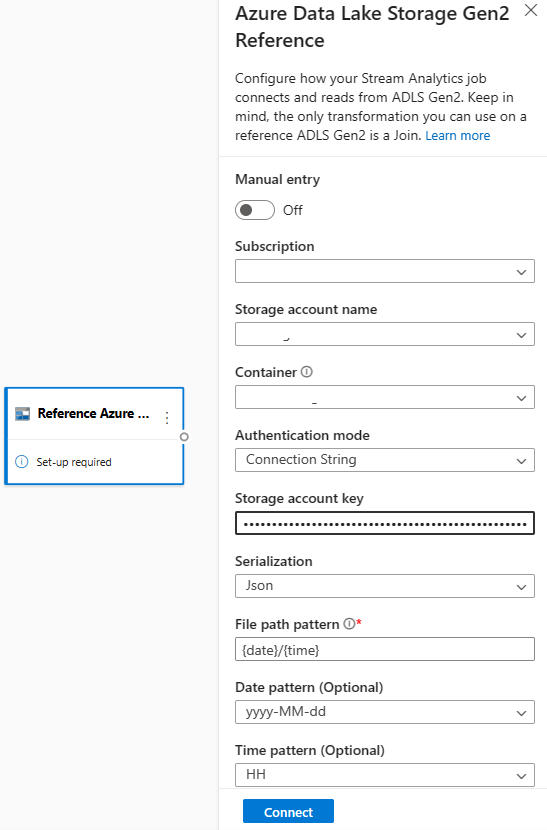

Azure Data Lake Storage Gen2 como datos de referencia

Los datos de referencia se modelan como una secuencia de blobs en orden ascendente de la combinación de fecha y hora especificada en el nombre del blob. Solo se pueden agregar blobs al final de la secuencia con una fecha y hora mayor que la especificada por el último blob de la secuencia. Los blobs se definen en la configuración de entrada.

En primer lugar, en la sección Entradas de la cinta de opciones, seleccione Referencia a ADLS Gen2. Para ver detalles sobre cada campo, consulte la sección sobre Azure Blob Storage en Uso de datos de referencia para las búsquedas en Stream Analytics.

A continuación, cargue un archivo de matriz JSON. Se detectarán los campos del archivo. Use estos datos de referencia para realizar la transformación con los datos de entrada de streaming de Event Hubs.

Azure SQL Database como datos de referencia

Puede usar Azure SQL Database como datos de referencia para el trabajo de Stream Analytics en el editor sin código. Para más información, consulte la sección sobre SQL Database en Uso de datos de referencia para las búsquedas en Stream Analytics.

Para configurar SQL Database como entrada de datos de referencia, seleccione Referencia a SQL Database en la sección Entradas de la cinta de opciones. A continuación, rellene la información para conectar la base de datos de referencia y seleccione la tabla con las columnas necesarias. También puede capturar los datos de referencia de la tabla editando manualmente la consulta SQL.

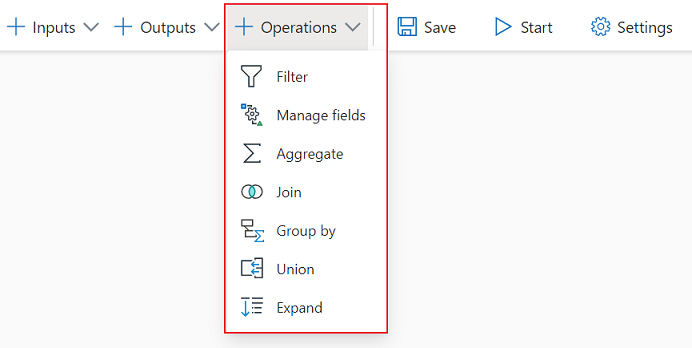

Transformaciones

Las transformaciones de datos de streaming son inherentemente diferentes de las transformaciones de datos por lotes. Casi todos los datos de streaming tienen un componente de tiempo que afecta a las tareas de preparación de datos implicadas.

Para agregar una transformación de datos de streaming al trabajo, seleccione el símbolo de transformación de la sección Operaciones en la cinta de esa transformación. El mosaico correspondiente se incluirá en la vista de diagrama. Una vez que la seleccione, aparecerá el panel lateral de esa transformación para configurarla.

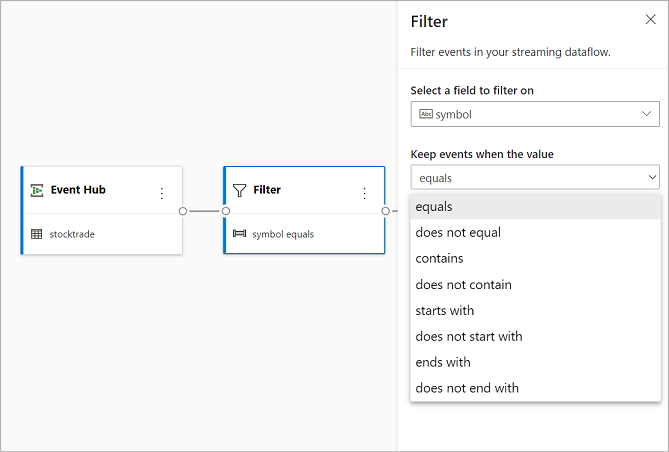

Filter

Use la transformación Filtro para filtrar eventos en función del valor de un campo de la entrada. En función del tipo de datos (número o texto), la transformación mantendrá los valores que coincidan con la condición seleccionada.

Nota

Dentro de cada icono aparecerá información sobre qué más se necesita para que la transformación esté lista. Por ejemplo, cuando agregue un nuevo icono, verá el mensaje Configuración necesaria. Si falta un conector de nodo, verá un mensaje de Error o un mensaje de Advertencia.

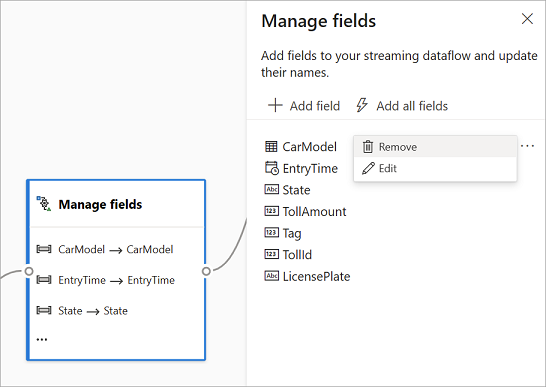

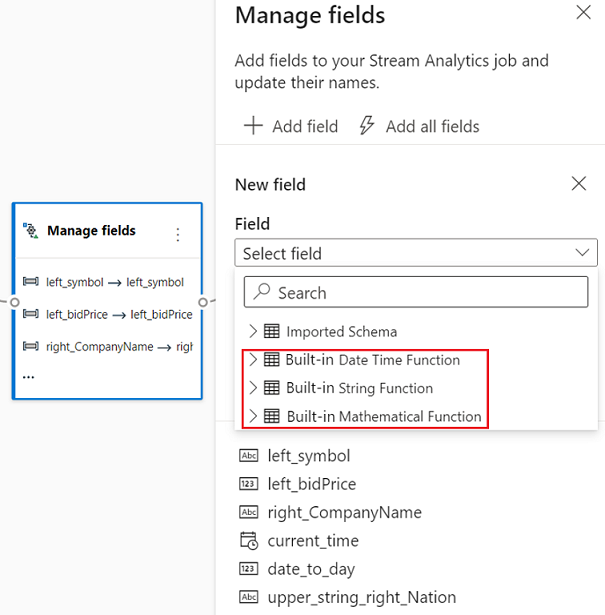

Administrar campos

La transformación Administrar campos permite agregar, quitar o cambiar el nombre de los campos procedentes de una entrada u otra transformación. Los valores del panel lateral le ofrecen la opción de agregar uno nuevo si selecciona Agregar campo, o bien de agregar todos los campos a la vez.

También puede agregar un nuevo campo con las Funciones integradas para agregar los datos del flujo ascendente. Actualmente, las funciones integradas que se admiten son algunas funciones en Funciones de cadena, Funciones de fecha y hora, Funciones matemáticas. Para más información sobre las definiciones de estas funciones, consulte Funciones integradas (Azure Stream Analytics).

Sugerencia

Después de configurar un icono, la vista de diagrama ofrece un vistazo de la configuración que hay en el icono. Por ejemplo, en el área Administrar campos de la imagen anterior, puede ver que se están administrando los tres primeros campos y se les están asignando nombres nuevos. Cada icono tiene información pertinente sobre él.

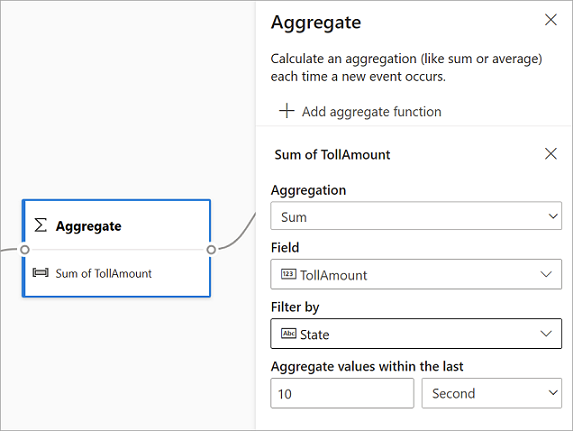

Agregado

Puede usar la transformación Agregado para calcular una agregación (Suma, Mínimo, Máximo o Promedio) cada vez que se produzca un nuevo evento durante un período de tiempo. Esta operación también permite filtrar o segmentar la agregación en función de otras dimensiones de los datos. Puede tener una o varias agregaciones en la misma transformación.

Para agregar una agregación, seleccione el símbolo Transformación. Después, conecte una entrada, seleccione la agregación, agregue cualquier dimensión de filtro o segmentación y seleccione el período de tiempo de cálculo de la agregación. En este ejemplo, se calcula la suma del valor del peaje según el estado del que procede el vehículo durante los últimos 10 segundos.

Para agregar otra agregación a la misma transformación, seleccione Agregar función de agregado. Tenga en cuenta que el filtro o segmentación se aplicará a todas las agregaciones de la transformación.

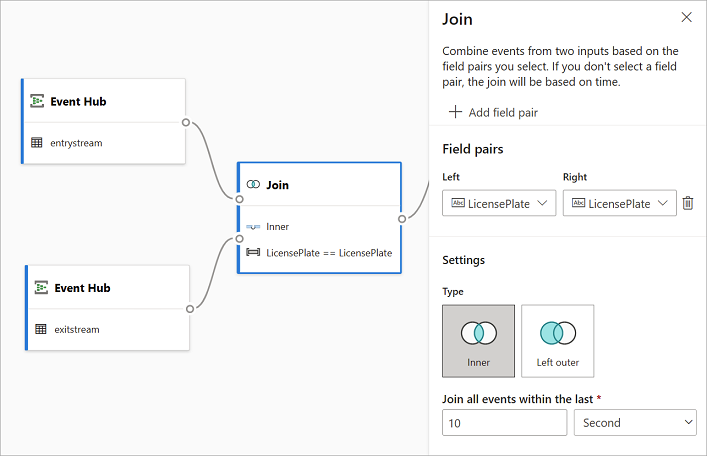

Join

Use la transformación Combinación para combinar eventos de dos entradas en función de los pares de campo que seleccione. Si no selecciona un par de campos, la combinación se basará en el tiempo de forma predeterminada. El valor predeterminado hace que esta transformación sea diferente de una por lotes.

Al igual que con las combinaciones normales, tiene opciones para la lógica de combinación:

- Combinación interna: incluye solo los registros de ambas tablas donde coincide el par. En este ejemplo, se refiere a cuando la matrícula coincide con ambas entradas.

- Combinación externa izquierda: se incluyen todos los registros de la tabla izquierda (la primera) y solo los registros de la segunda que coincidan con el par de campos. Si no hay coincidencias, los campos de la segunda entrada estarán en blanco.

Para seleccionar el tipo de combinación, seleccione el símbolo del tipo preferido en el panel lateral.

Por último, seleccione durante qué período quiere que se calcule la combinación. En este ejemplo, la combinación examina los últimos 10 segundos. Tenga en cuenta que cuanto mayor sea el período, menos frecuente será la salida y más recursos de procesamiento usará para la transformación.

De manera predeterminada, se incluyen todos los campos de ambas tablas. Los prefijos a la izquierda (primer nodo) y a la derecha (segundo nodo) en la salida le ayudan a diferenciar el origen.

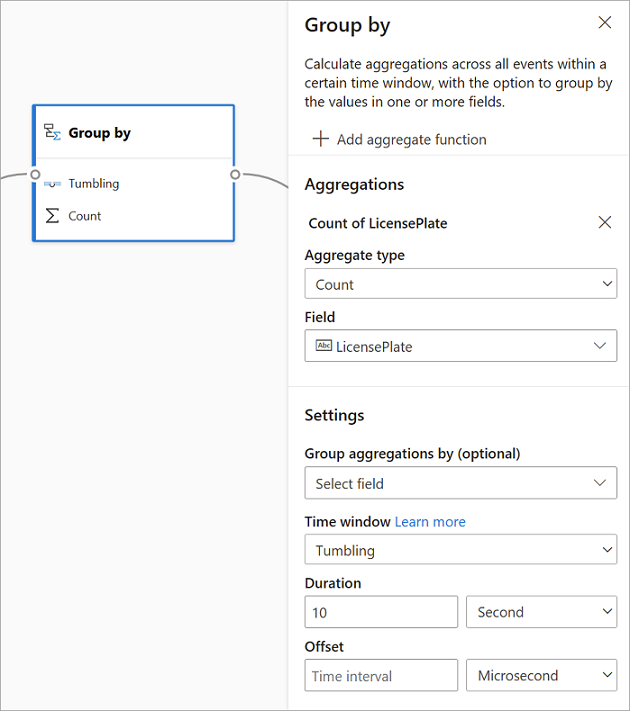

Agrupar por

Use la transformación Agrupar por para calcular agregaciones en todos los eventos dentro de un período de tiempo determinado. Puede agrupar por los valores en uno o varios campos. Es como la transformación Agregado, pero proporciona más opciones para las agregaciones. También incluye opciones más complejas para las ventanas de tiempo. Al igual que Agregado, puede incluir más de una agregación por transformación.

Estas son las agregaciones disponibles en la transformación:

- Average

- Recuento

- Máximo

- Mínimo

- Percentil (continuo y discreto)

- Desviación estándar

- Sum

- Variance

Para configurar la transformación:

- Seleccione su agregación preferida.

- Seleccione el campo en el que desea realizar la agregación.

- Seleccione un campo Agrupar por opcional si quiere obtener el cálculo agregado en relación con otra dimensión o categoría Por ejemplo: Estado.

- Seleccione la función para los períodos de tiempo.

Para agregar otra agregación a la misma transformación, seleccione Agregar función de agregado. Tenga en cuenta que el campo Agrupar por y la función de período de tiempo se aplicarán a todas las agregaciones de la transformación.

Aparece una marca de tiempo para el final de la ventana de tiempo en la salida de la transformación como referencia. Para obtener más información sobre las ventanas de tiempo compatibles con los trabajos de Stream Analytics, consulte Funciones de ventana (Azure Stream Analytics).

Union

Use la transformación Unión para conectar dos o más entradas a fin de agregar eventos que tengan campos compartidos (con el mismo nombre y tipo de datos) en una tabla. Los campos que no coincidan se descartarán y no se incluirán en la salida.

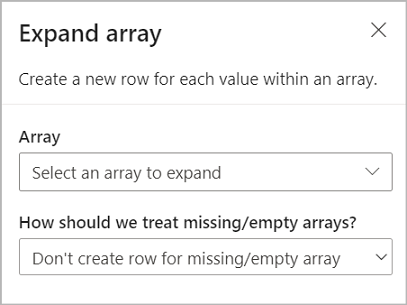

Expandir matriz

Utilice la transformación Expandir matriz para crear una nueva fila por cada valor dentro de una matriz.

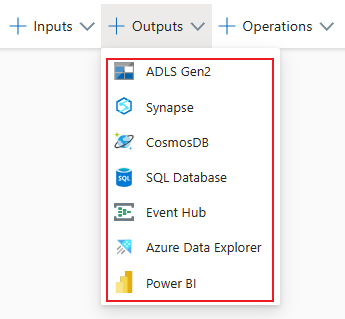

Salidas de streaming

La experiencia de arrastrar y colocar sin código admite actualmente varios receptores de salida para almacenar los datos procesados en tiempo real.

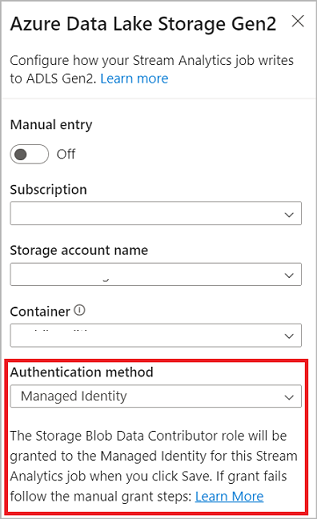

Azure Data Lake Storage Gen2

Data Lake Storage Gen2 convierte a Azure Storage en los cimientos para crear lagos de datos empresariales en Azure. Está diseñado para proporcionar varios petabytes de información, al mismo tiempo que mantiene un rendimiento de cientos de gigabits. Permite administrar fácilmente grandes cantidades de datos. Azure Blob Storage ofrece una solución rentable y escalable para almacenar grandes cantidades de datos no estructurados en la nube.

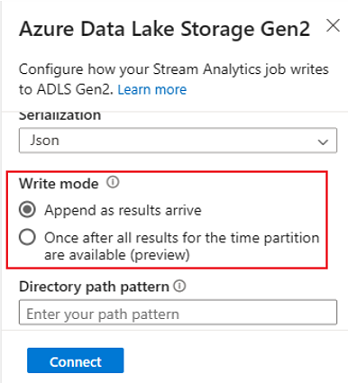

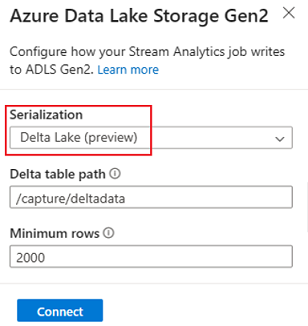

En la sección Salidas de la cinta de opciones, seleccione ADLS Gen2 como salida del trabajo de Stream Analytics. A continuación, seleccione el contenedor al que quiere enviar la salida del trabajo. Para obtener más información sobre la salida de Azure Data Lake Gen2 de un trabajo de Stream Analytics, consulte Salida de Blob Storage y Azure Data Lake Gen2 de Azure Stream Analytics.

Al conectarse a Azure Data Lake Storage Gen2, si selecciona Identidad administrada como modo de autenticación, se concederá el rol Colaborador de datos de Storage Blob a la identidad administrada para el trabajo de Stream Analytics. Para más información sobre las identidades administradas para Azure Data Lake Storage Gen2, consulte Uso de identidad administrada para autenticar su trabajo de Azure Stream Analytics en Azure Blob Storage.

Las identidades administradas eliminan las limitaciones de los métodos de autenticación basados en el usuario. Estas limitaciones incluyen la necesidad de volver a autenticarse debido a cambios de contraseña o a las expiraciones de los token de usuario que se producen cada 90 días.

La entrega exactamente una vez (versión preliminar) se admite en ADLS Gen2 como salida del editor de código. Puede habilitarla en la sección Modo de escritura de la configuración de ADLS Gen2. Para más información sobre esta característica, vea Entrega exactamente una vez (versión preliminar) en Azure Data Lake Gen2

La escritura en la tabla de Delta Lake (versión preliminar) se admite en ADLS Gen2 como salida del editor sin código. Se puede acceder a esta opción en la sección Serialización de la configuración de ADLS Gen2. Para más información sobre esta característica, consulte Escritura en la tabla de Delta Lake.

Azure Synapse Analytics

Los trabajos de Azure Stream Analytics pueden enviar la salida a una tabla del grupo de SQL dedicado en Azure Synapse Analytics y pueden procesar velocidades de rendimiento de hasta 200 MB por segundo. Stream Analytics admite las necesidades de procesamiento de datos de ruta de acceso activa y análisis en tiempo real más exigentes para cargas de trabajo como informes y paneles.

Importante

La tabla del grupo de SQL dedicado debe existir antes de poder agregarla como salida al trabajo de Stream Analytics. El esquema de tabla debe coincidir con los campos y los tipos en la salida del trabajo.

En la sección Salidas de la cinta de opciones, seleccione Synapse como salida del trabajo de Stream Analytics. A continuación, seleccione la tabla del grupo de SQL a la que quiere enviar la salida del trabajo. Para obtener más información sobre la salida de Azure Synapse de un trabajo de Stream Analytics, consulte Salida de Azure Synapse Analytics desde Azure Stream Analytics.

Azure Cosmos DB

Azure Cosmos DB es un servicio de base de datos distribuido globalmente que ofrece un escalado elástico ilimitado en todo el mundo. También ofrece consultas enriquecidas e indexación automática sobre modelos de datos independientes del esquema.

En la sección Salidas de la cinta de opciones, seleccione CosmosDB como salida del trabajo de Stream Analytics. Para obtener más información sobre la salida de Azure Cosmos DB de un trabajo de Stream Analytics, consulte Salida de Azure Cosmos DB desde Azure Stream Analytics.

Al conectarse a Azure Cosmos DB, si selecciona Identidad administrada como modo de autenticación, se concederá el rol Colaborador a la identidad administrada para el trabajo de Stream Analytics. Para más información sobre las identidades administradas para Azure Cosmos DB, consulte Uso de identidades administradas para acceder a Cosmos DB desde un trabajo de Azure Stream Analytics (versión preliminar).

El método de autenticación de identidades administradas también se admite en la salida de Azure Cosmos DB en el editor sin código, que tiene las mismas ventajas que en la salida de ADLS Gen2 anterior.

Azure SQL Database

Azure SQL Database es un motor de base de datos de plataforma como servicio (PaaS) totalmente administrado que puede ayudarle a crear una capa de almacenamiento de datos de alto rendimiento y de alta disponibilidad para las aplicaciones y soluciones de Azure. Mediante el editor sin código, puede configurar los trabajos de Azure Stream Analytics para escribir los datos procesados en una tabla existente en SQL Database.

Para configurar Azure SQL Database como salida, seleccione SQL Database en la sección Salidas de la cinta de opciones. A continuación, rellene la información necesaria para conectar la base de datos SQL y seleccione la tabla en la que desea escribir datos.

Importante

La tabla de Azure SQL Database debe existir antes de poder agregarla como salida al trabajo de Stream Analytics. El esquema de tabla debe coincidir con los campos y los tipos en la salida del trabajo.

Para obtener más información sobre la salida de Azure SQL Database de un trabajo de Stream Analytics, consulte Salida de Azure SQL Database desde Azure Stream Analytics.

Event Hubs

Con los datos en tiempo real que llegan mediante el centro de eventos a ASA, el editor sin código puede transformarlos, enriquecerlos y enviarlos a otro centro de eventos. Puede elegir la salida Event Hubs al configurar el trabajo de Azure Stream Analytics.

Para configurar Event Hubs como salida, seleccione Centro de eventos en la sección Salidas de la cinta de opciones. A continuación, rellene la información necesaria para conectarse al centro de eventos en el que desea escribir datos.

Para más información sobre la salida de Event Hubs de un trabajo de Stream Analytics, consulte Salida de Event Hubs desde Azure Stream Analytics.

Explorador de datos de Azure

Azure Data Explorer es una plataforma de análisis de macrodatos totalmente administrada y de alto rendimiento que facilita el análisis de grandes volúmenes de datos. También puede usar Azure Data Explorer como salida para el trabajo de Azure Stream Analytics mediante el editor sin código.

Para configurar Azure Data Explorer como salida, seleccione Azure Data Explorer en la sección Salidas de la cinta de opciones. A continuación, rellene la información necesaria para conectar la base de datos de Azure Data Explorer y especifique la tabla en la que desea escribir datos.

Importante

La tabla debe existir en la base de datos seleccionada y el esquema de la tabla debe coincidir exactamente con los campos y sus tipos en la salida del trabajo.

Para más información sobre la salida de Azure Data Explorer para un trabajo de Stream Analytics, consulte Salida de Azure Data Explorer desde Azure Stream Analytics (versión preliminar).

Power BI

Power BI brinda una experiencia de visualización integral para el resultado del análisis de datos. Con la salida de Power BI en Stream Analytics, los datos de streaming procesados se escriben en el conjunto de datos de streaming de Power BI y, a continuación, se pueden usar para crear el panel de Power BI casi en tiempo real. Para obtener más información sobre cómo crear el panel casi en tiempo real, consulte Creación de un panel en tiempo real con el conjunto de datos de Power BI generado desde el editor sin código de Stream Analytics.

Para configurar Power BI como salida, seleccione Power BI en la sección Salidas de la cinta. A continuación, rellene la información necesaria para conectar el área de trabajo de Power BI y proporcione los nombres para el conjunto de datos de streaming y la tabla en los que desea escribir los datos. Para obtener más información sobre los detalles de cada campo, consulte Salida de Power BI de Azure Stream Analytics.

Vista previa de datos, errores de creación, registros en tiempo de ejecución y métricas

La experiencia de arrastrar y colocar sin código proporciona herramientas para ayudarle a crear, solucionar problemas y evaluar el rendimiento de la canalización de análisis para los datos de streaming.

Vista previa de datos dinámica para entradas

Cuando se conecta a un origen de entrada, por ejemplo: centro de eventos, y selecciona el mosaico en la vista de diagrama (la pestaña Vista previa de datos), obtendrá una vista previa en vivo de los datos que ingresan si todo lo siguiente es cierto:

- Los datos se están insertando.

- La entrada se configuró correctamente.

- Se han agregado campos.

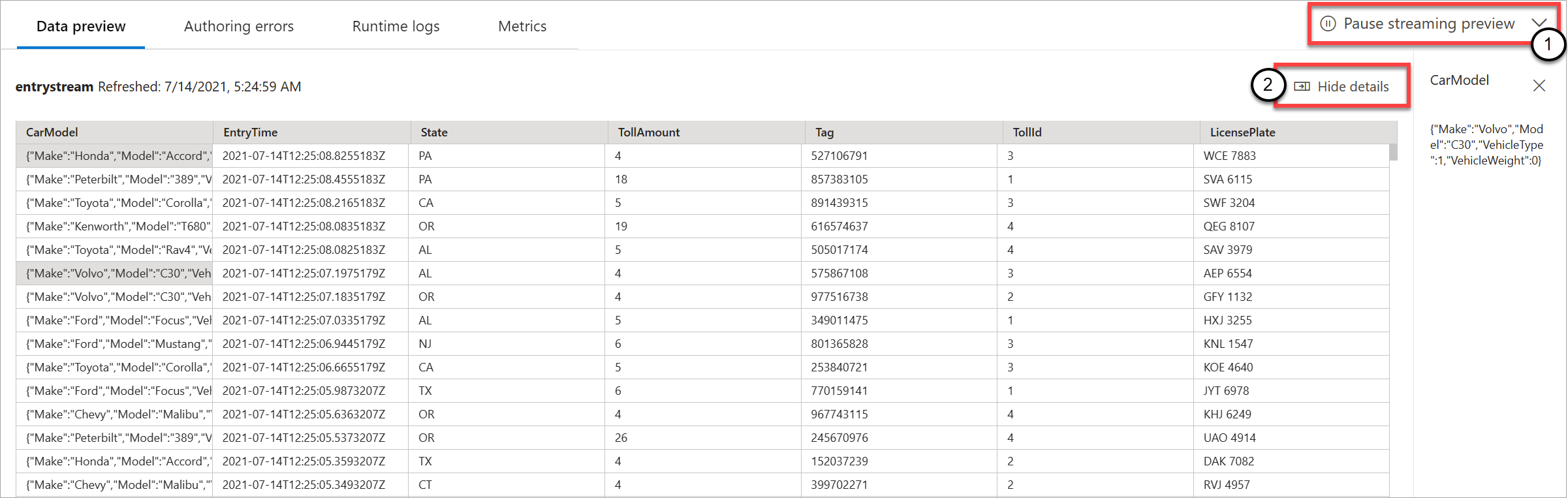

Como se muestra en la captura de pantalla siguiente, si quiere ver o explorar en profundidad algo específico, puede pausar la vista previa (1). O bien, puede iniciarla de nuevo si ha terminado.

También puede ver los detalles de un registro específico (una celda de la tabla); para ello, selecciónelo y, a continuación, seleccione Mostrar u ocultar detalles (2). La captura de pantalla muestra la vista detallada de un objeto anidado en un registro.

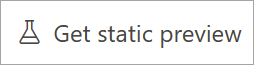

Vista previa estática para transformaciones y salidas

Después de agregar y configurar los pasos en la vista de diagrama, puede probar su comportamiento seleccionando el botón Get static preview (Obtener vista previa estática).

Después de hacerlo, el trabajo de Stream Analytics evalúa todas las transformaciones y salidas para asegurarse de que están correctamente configuradas. A continuación, Stream Analytics muestra los resultados en la vista previa de datos estática, tal como se muestra en la siguiente imagen.

Para actualizar la versión preliminar, seleccione Actualizar vista previa estática (1). Al actualizar la versión preliminar, el trabajo de Stream Analytics toma datos nuevos de la entrada y evalúa todas las transformaciones. A continuación, se vuelve a generar la salida con las actualizaciones que pueda haber realizado. La opción Mostrar u ocultar detalles también está disponible (2).

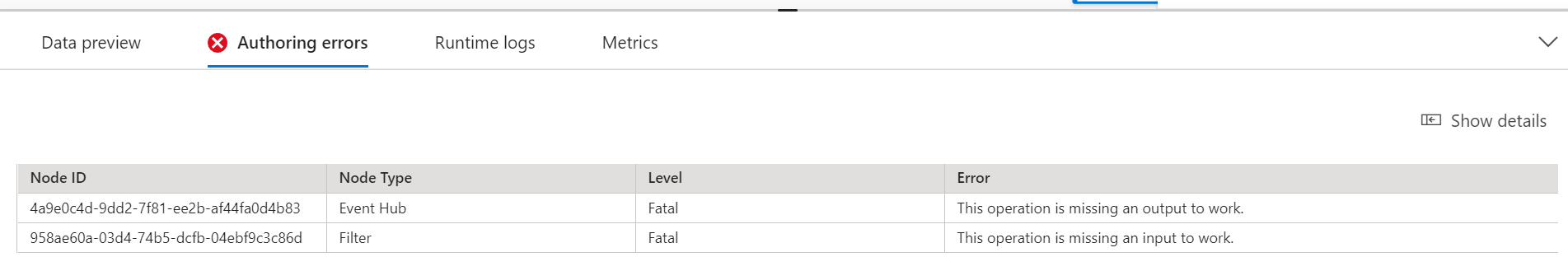

Errores de creación

Si tiene errores o advertencias de creación, la pestaña Errores de creación los mostrará en una lista, como se muestra en la captura de pantalla siguiente. La lista incluye detalles sobre el error o la advertencia, el tipo de tarjeta (entrada, transformación o salida), el nivel de error y una descripción del error o advertencia.

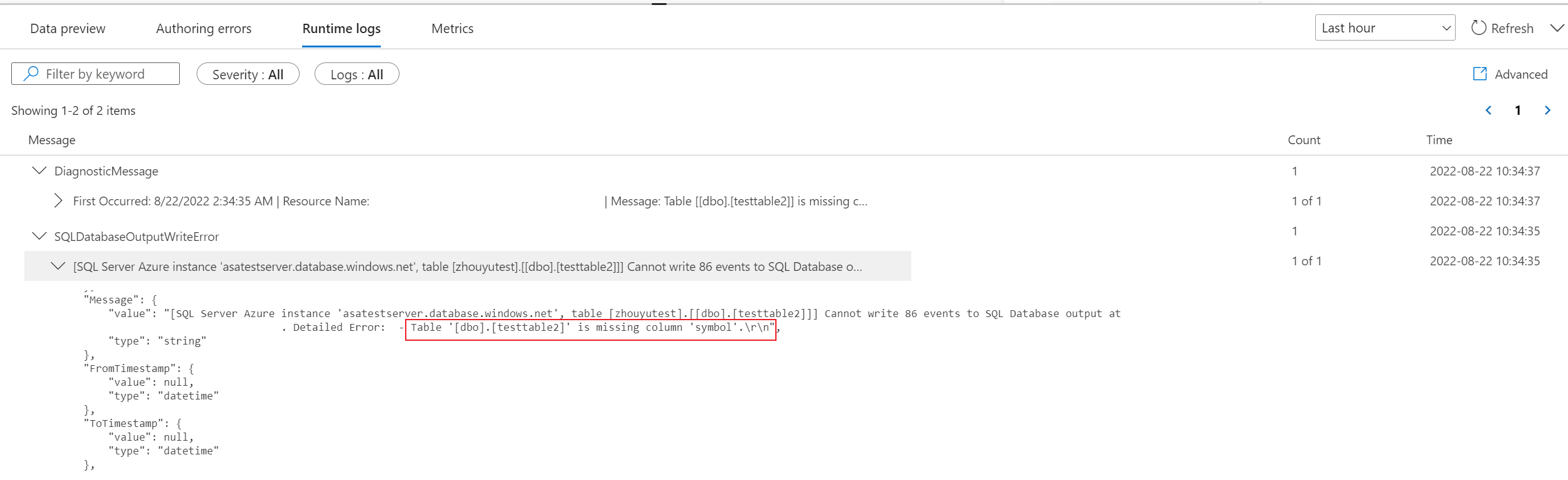

Registros en tiempo de ejecución

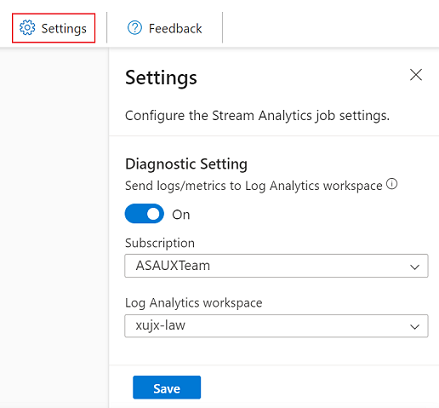

Los registros en tiempo de ejecución aparecen en el nivel de advertencia, error o información cuando se ejecuta un trabajo. Estos registros son útiles si queremos editar la topología o la configuración del trabajo de Stream Analytics para solucionar problemas. Se recomienda activar los registros de diagnóstico y enviarlos al área de trabajo de Log Analytics en Configuración para obtener más información sobre los trabajos en ejecución para la depuración.

En el ejemplo de captura de pantalla siguiente, el usuario ha configurado la salida de SQL Database con un esquema de tabla que no coincide con los campos de la salida del trabajo.

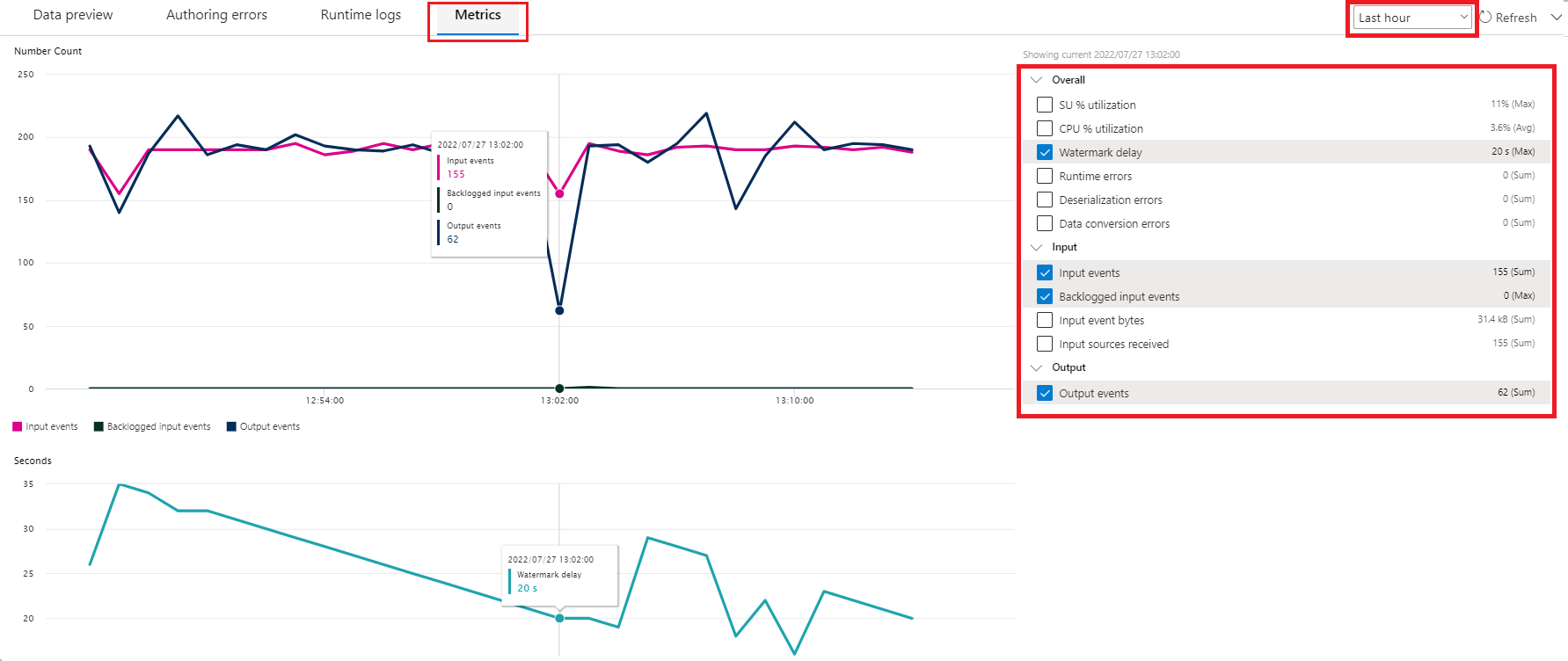

Métricas

Si el trabajo se está ejecutando, puede supervisar el estado del trabajo en la pestaña Métricas. Las cuatro métricas que se muestran de manera predeterminada son Retraso de marca de agua, Eventos de entrada, Eventos de entrada pendientes y Eventos de salida. Puede usar estas métricas para comprender si los eventos fluyen hacia y desde el trabajo sin ningún trabajo pendiente de entrada.

Puede seleccionar más métricas en la lista. Para comprender todas las métricas con detalle, consulte Métricas del trabajo de Azure Stream Analytics.

Inicio de un trabajo de Stream Analytics

Puede guardar el trabajo en cualquier momento mientras lo crea. Después de configurar las entradas de streaming, las transformaciones y las salidas de streaming para el trabajo, puede iniciar el trabajo.

Nota:

Aunque el editor sin código en el portal de Azure Stream Analytics está en versión preliminar, el servicio de Azure Stream Analytics está disponible con carácter general.

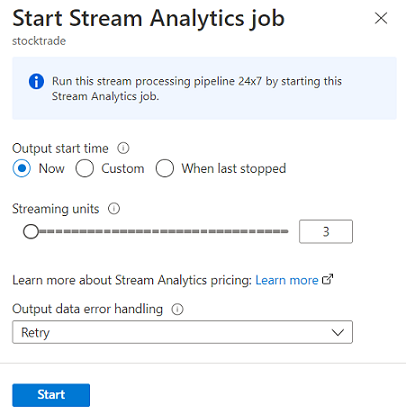

Puede configurar estas opciones:

-

Hora de inicio de la salida: cuando inicie un trabajo, debe seleccionar una hora para que el trabajo comience a crear la salida.

- Ahora: esta opción hace que el punto de inicio de la secuencia de eventos de salida coincida con el del inicio del trabajo.

- Personalizado: puede elegir el punto de partida de la salida.

- Última detención: esta opción está disponible cuando el trabajo se inició previamente, pero se detuvo manualmente o no se realizó correctamente. Si elige esta opción, se usará la última hora de salida para reiniciar el trabajo, de modo que no se pierdan datos.

- Unidades de streaming: las unidades de streaming (SU) representan la cantidad de proceso y memoria asignada al trabajo mientras se ejecuta. Si no está seguro de cuántas SU elegir, le recomendamos empezar por tres y ajustar según sea necesario.

- Control de errores de los datos de salida: las directivas de control de errores de los datos de salida se aplican solo cuando el evento de salida que produce un trabajo de Stream Analytics no cumple con el esquema del receptor de destino. Puede configurar la directiva seleccionando Reintentar o Anular. Para obtener más información, vea Directivas de errores de salida en Azure Stream Analytics.

- Iniciar: este botón inicia el trabajo de Stream Analytics.

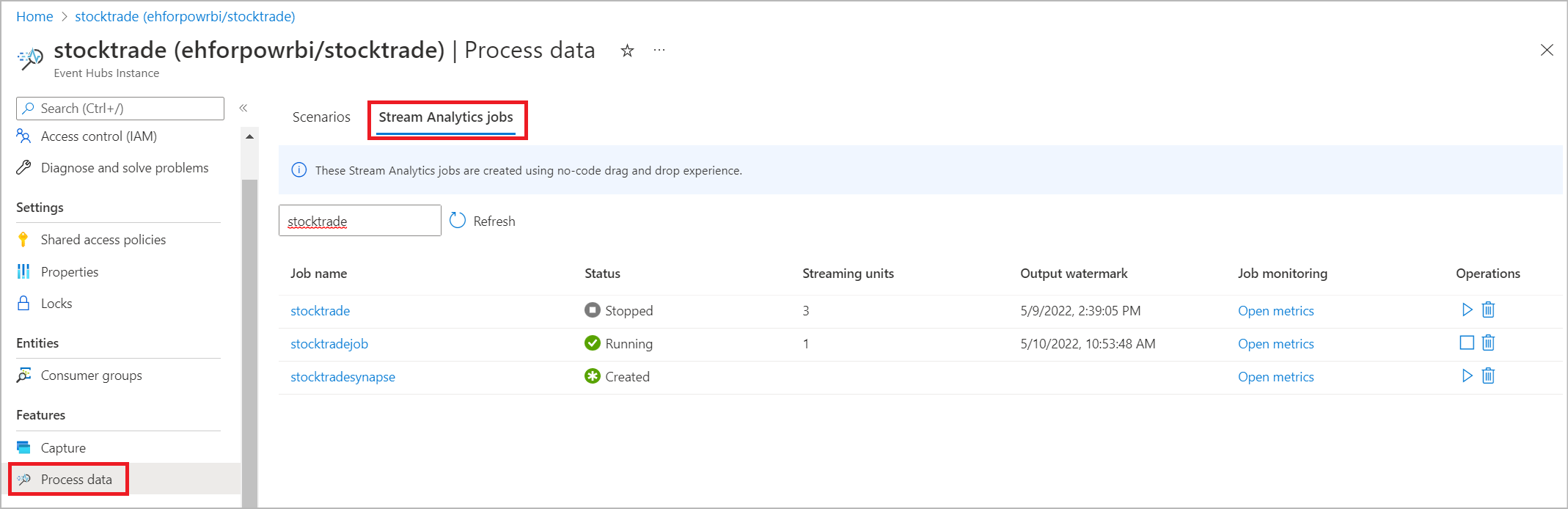

Lista de trabajos de Stream Analytics en el portal de Azure Event Hubs

Para ver una lista de todos los trabajos de Stream Analytics que creó mediante la experiencia de arrastrar y soltar sin código en el portal de Azure Event Hubs, seleccione Procesar datos>de los trabajos de Stream Analytics.

Estos son los elementos de la pestaña Trabajos de Stream Analytics:

- Filtrar: puede filtrar la lista por nombre de trabajo.

- Actualizar: actualmente, la lista no se actualiza automáticamente. Use el botón Actualizar para actualizar la lista y ver el estado más reciente.

- Nombre del trabajo: el nombre de esta área es el que proporcionó en el primer paso de creación del trabajo. No se puede editar. Seleccione el nombre del trabajo para abrir el trabajo en la experiencia de arrastrar y colocar sin código, donde puede detenerlo, editarlo y volver a iniciarlo.

- Estado: esta área muestra el estado del trabajo. Seleccione Actualizar en la parte superior de la lista para ver el estado más reciente.

- Unidades de streaming: esta área muestra el número de unidades de streaming seleccionadas al iniciar el trabajo.

- Marca de agua de salida: esta área proporciona un indicador de la actualidad de los datos que ha generado el trabajo. Todos los eventos anteriores a la marca de tiempo ya se han procesado.

- Supervisión del trabajo: seleccione Open metrics (Abrir métricas) para ver las métricas relacionadas con este trabajo de Stream Analytics. Para obtener más información sobre las métricas que se pueden usar para supervisar el trabajo de Stream Analytics, consulte Métricas del trabajo de Stream Analytics.

- Operaciones: iniciar, detener o eliminar el trabajo.

Pasos siguientes

Obtenga información sobre cómo usar el editor sin código para abordar escenarios comunes mediante plantillas predefinidas: