Muistiinpano

Tämän sivun käyttö edellyttää valtuutusta. Voit yrittää kirjautua sisään tai vaihtaa hakemistoa.

Tämän sivun käyttö edellyttää valtuutusta. Voit yrittää vaihtaa hakemistoa.

Note

Fabric Runtime 2.0 on tällä hetkellä kokeellisessa esikatseluvaiheessa. Lisätietoja saat rajoituksista ja muistiinpanoista.

Fabric Runtime tarjoaa saumattoman integraation Microsoft Fabricin ekosysteemissä, tarjoten vahvan ympäristön data-insinööri- ja data-analytiikkaprojekteille, joita tukee Apache Spark.

Tässä artikkelissa esitellään Fabric Runtime 2.0 Experimental (Preview), joka on uusin Microsoft Fabricin big data -laskentaan suunniteltu ajonaikainen. Se korostaa keskeisiä ominaisuuksia ja komponentteja, jotka tekevät tästä julkaisusta merkittävän askeleen eteenpäin skaalautuvan analytiikan ja edistyneiden työkuormien saralla.

Fabric Runtime 2.0 sisältää seuraavat komponentit ja päivitykset, jotka on suunniteltu parantamaan datankäsittelykykyäsi:

- Apache Spark 4.0

- Käyttöjärjestelmä: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta-järvi: 4,0

Ota käyttöön Runtime 2.0

Voit ottaa Runtime 2.0:n käyttöön joko työtilan tasolla tai ympäristön kohdetasolla. Käytä työtilan asetusta soveltaaksesi Runtime 2.0:aa oletusarvona kaikille Spark-työkuormille työtilassasi. Vaihtoehtoisesti voit luoda Environment-alkion Runtime 2.0:lla käytettäväksi tiettyjen muistikirjojen tai Spark-työtehtävien määrittelyjen kanssa, mikä ohittaa työtilan oletusarvon.

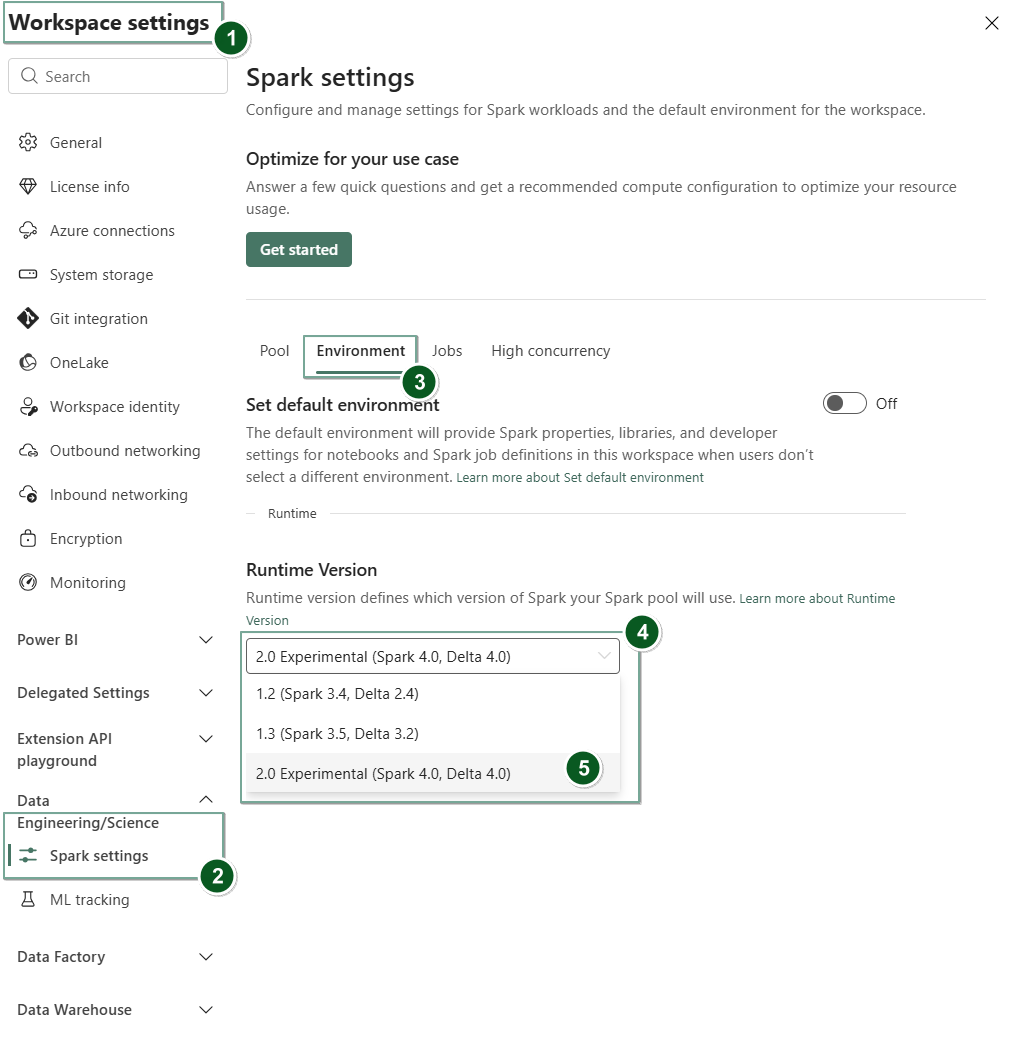

Ota Runtime 2.0 käyttöön Workspace-asetuksissa

Asetetaan Runtime 2.0 oletuseksi koko työtilallesi:

Siirry Fabric-työtilan Työtilan asetukset -välilehteen.

Mene Data Engineering/Science -välilehdelle ja valitse Spark settings.

Valitse Ympäristö-välilehti .

Runtime-version pudotusvalikosta valitse 2.0 Experimental (Spark 4.0, Delta 4.0) ja tallenna muutoksesi. Tämä toiminto asettaa Runtime 2.0:n oletusajonaikaksi työtilallesi.

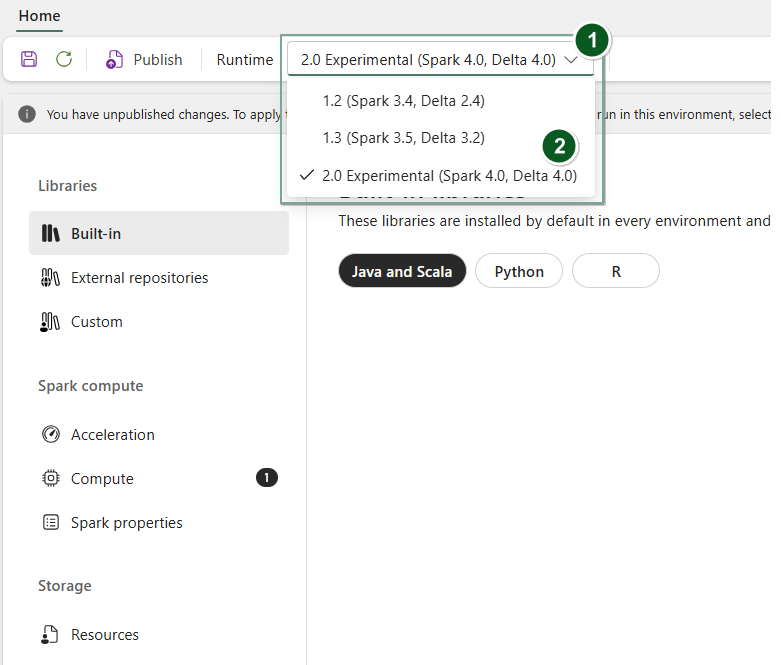

Ota käyttöön Runtime 2.0 Ympäristö-kohteessa

Käyttääksesi Runtime 2.0:aa tiettyjen muistikirjojen tai Spark-tehtävämääritelmien kanssa:

Luo uusi ympäristökohde tai avoin ja olemassa oleva.

Runtime-pudotusvalikosta valitse 2.0 Experimental (Spark 4.0, Delta 4.0) ja

Savemuutoksesi.PublishTärkeää

Spark 2.0 -sessioiden alkaminen voi kestää noin 2–5 minuuttia, sillä aloituspoolit eivät kuulu varhaiseen kokeelliseen julkaisuun.

Seuraavaksi voit käyttää tätä Ympäristö-esinettä sinun

NotebooktaiSpark Job Definition-merkin kanssa.

Voit nyt alkaa kokeilla Fabric Runtime 2.0:n uusimpia parannuksia ja toimintoja (Spark 4.0 ja Delta Lake 4.0).

Kokeellinen julkinen esikatselu

Fabric runtime 2.0 -kokeellinen esikatseluvaihe antaa sinulle varhaisen pääsyn uusiin ominaisuuksiin ja API:iin sekä Spark 4.0:sta että Delta Lake 4.0:sta. Esikatselu antaa sinun käyttää viimeisimpiä Spark-pohjaisia parannuksia heti, varmistaen sujuvan valmiuden ja siirtymän tulevia muutoksia, kuten uudempia Java-, Scala- ja Python-versioita, varten.

Vinkki

Saat ajan tasalla olevat tiedot, yksityiskohtaisen luettelon muutoksista ja Fabric-suorituspalvelun erityisistä julkaisutiedoista tarkistamalla Spark Runtimes -julkaisut ja -päivitykset ja tilaamalla ne.

Rajoitukset ja huomautukset

Fabric Runtime 2.0 on tällä hetkellä kokeellisessa julkisessa esikatseluvaiheessa, ja se on suunniteltu käyttäjille tutkimaan ja kokeilemaan Sparkin ja Delta Laken uusimpia ominaisuuksia ja rajapintoja kehitys- tai testausympäristöissä. Vaikka tämä versio tarjoaa pääsyn ydintoimintoihin, siihen liittyy tiettyjä rajoituksia:

Voit käyttää Spark 4.0 -istuntoja, kirjoittaa koodia muistikirjoihin, ajoittaa Spark-työn määrittelyjä ja käyttää PySparkia, Scalaa ja Spark SQL:ää. Kuitenkin R-kieltä ei tueta tässä varhaisessa julkaisussa.

Voit asentaa kirjastoja suoraan koodiisi pip:llä ja condalla. Voit asettaa Spark-asetukset %%configure-asetuksilla muistikirjoissa ja Spark Job Definitions (SJD) -asetuksissa.

Voit lukea ja kirjoittaa Lakehouseen Delta Lake 4.0:lla, mutta jotkut edistyneemmät ominaisuudet kuten V-järjestys, natiivi Parquet-kirjoitus, automaattitiivisointi, optimoitu kirjoitus, low-shuffle merge, merge, skeeman evoluutio ja aikamatkailu eivät sisälly tähän varhaiseen julkaisuun.

Spark Advisor ei ole tällä hetkellä saatavilla. Kuitenkin valvontatyökalut, kuten Spark UI ja lokit, ovat tuettuja tässä varhaisessa julkaisussa.

Ominaisuuksia, kuten Data Science -integraatioita, kuten Copilotia, sekä liittimiä kuten Kusto, SQL Analytics, Cosmos DB ja MySQL Java Connector, ei tällä hetkellä tueta tässä varhaisessa julkaisussa. Data Science -kirjastoja ei tueta PySpark-ympäristöissä. PySpark toimii vain perus Conda-kokoonpanolla, joka sisältää pelkän PySparkin ilman ylimääräisiä kirjastoja.

Integraatioita ympäristöelementin ja Visual Studio Coden kanssa ei tueta tässä varhaisessa julkaisussa.

Se ei tue datan lukemista ja kirjoittamista General Purpose v2 (GPv2) Azure Storage -tileille, joissa on WASB- tai ABFS-protokollat.

Note

Jaa palautteesi Fabric Runtimesta Ideas-alustalla. Muista mainita versio ja julkaisuvaihe, johon viittaat. Arvostamme yhteisön palautetta ja priorisoimme parannuksia äänestyksen perusteella, varmistaen että vastaamme käyttäjien tarpeisiin.

Tärkeimmät tiedot

Apache Spark 4.0

Apache Spark 4.0 merkitsee merkittävää virstanpylvästä 4.x-sarjan ensimmäisenä julkaisuna, ilmentäen vilkkaan avoimen lähdekoodin yhteisön yhteistä ponnistusta.

Tässä versiossa Spark SQL on merkittävästi rikastettu tehokkailla uusilla ominaisuuksilla, jotka on suunniteltu lisäämään SQL-työkuormien ilmaisukykyä ja monipuolisuutta, kuten VARIANT-tietotyyppien tuki, SQL-käyttäjän määrittelemät funktiot, istuntomuuttujat, putkisyntaksi ja merkkijonojen kokoaminen. PySpark sitoutuu jatkuvasti sekä toiminnalliseen laajuuteen että kehittäjäkokemukseen, tuoden mukanaan natiivin piirto-API:n, uuden Python Data Source API:n, tuen Python UDTF:ille ja yhtenäisen profiloinnin PySpark UDF:ille sekä lukuisia muita parannuksia. Strukturoitu suoratoisto kehittyy tärkeiden lisäysten myötä, jotka tarjoavat paremman hallinnan ja helpomman virheenkorjauksen, erityisesti Arbitrary State API v2:n käyttöönoton myötä joustavampaan tilanhallintaan sekä State Data Sourcen myötä helpompaan virheenkorjaukseen.

Voit tarkistaa täydellisen luettelon ja yksityiskohtaiset muutokset täältä: https://spark.apache.org/releases/spark-release-4-0-0.html.

Note

Spark 4.0:ssa SparkR on vanhentunut ja se voidaan poistaa tulevassa versiossa.

Delta Lake 4.0

Delta Lake 4.0 merkitsee yhteistä sitoutumista tehdä Delta Lakesta yhteensopiva eri formaateissa, helpompi työskennellä ja suorituskykyisempi. Delta 4.0 on merkkipaalujulkaisu, joka on täynnä tehokkaita uusia ominaisuuksia, suorituskyvyn optimointeja ja perustavanlaatuisia parannuksia avoimen datan järvenrakennusten tulevaisuudelle.

Voit tarkistaa koko listan ja yksityiskohtaiset muutokset, jotka on tehty Delta Lake 3.3:n ja 4.0:n myötä, täältä: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Tärkeää

Delta Lake 4.0:n erityisominaisuudet ovat kokeellisia ja toimivat vain Spark-kokemuksissa, kuten muistikirjoissa ja Spark-työmääritteluissa. Jos sinun täytyy käyttää samoja Delta Lake -taulukoita useissa Microsoft Fabricin työkuormissa, älä ota näitä ominaisuuksia käyttöön. Jos haluat tietää lisää siitä, mitkä protokollaversiot ja -ominaisuudet ovat yhteensopivia kaikissa Microsoft Fabric -käyttökokemuksissa, lue Delta Lake -taulukkomuotojen yhteentoimivuus.