Cet article décrit l’automatisation de la planification et de la distribution de la fabrication pour les charges de travail de fabrication de semi-conducteurs sur Azure. La solution utilise un environnement de calcul haute performance (HPC) pour effectuer l’apprentissage par renforcement (RL) à grande échelle. L’architecture est basée sur minds.ai Maestro, une suite de produits de fabrication de semi-conducteurs.

Architecture

Téléchargez un fichier PowerPoint de cette architecture.

Workflow

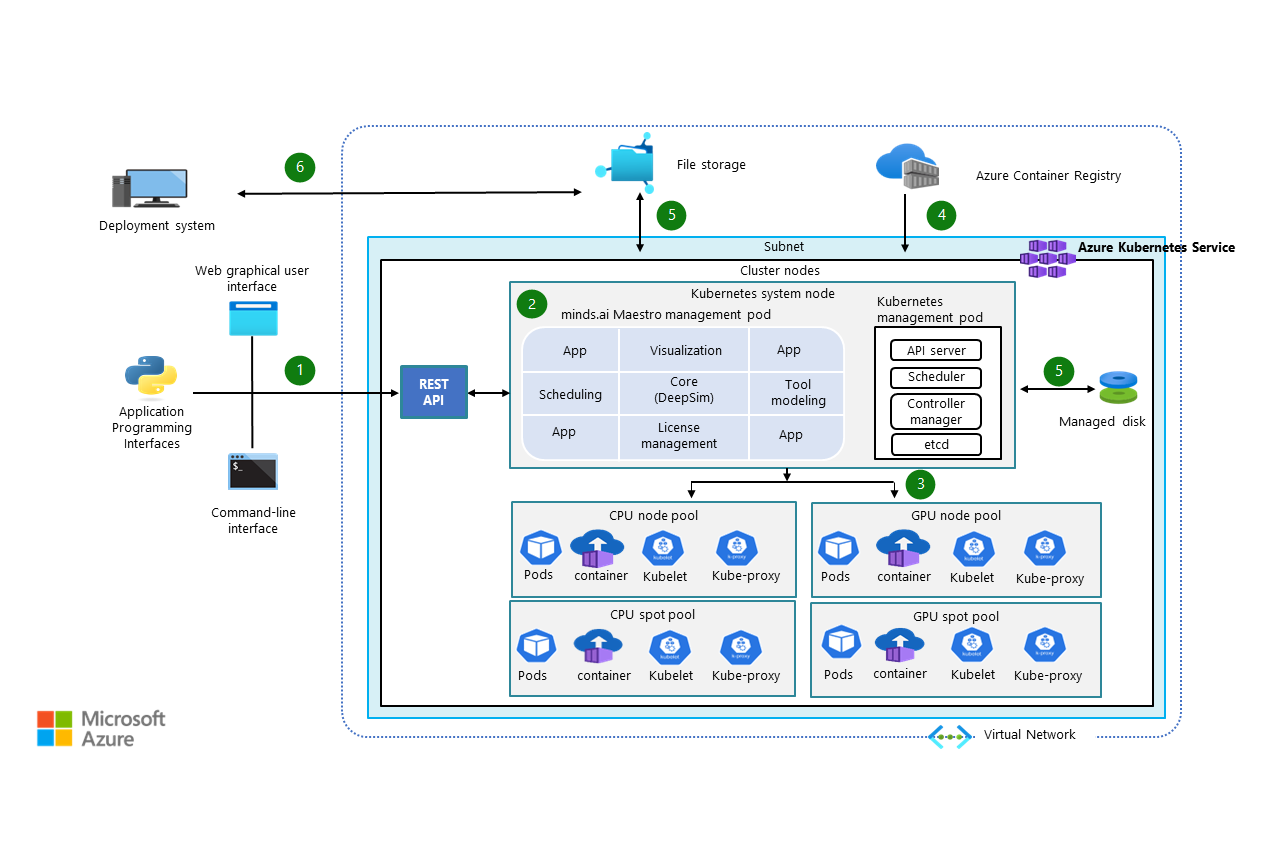

Ce flux de travail fournit une vue d’ensemble générale de l’architecture utilisée pour l’apprentissage par renforcement.

Les utilisateurs finaux interagissent avec le système de gestion Maestro via une API REST qui s’exécute sur Azure Kubernetes Service (AKS). Ils peuvent interagir avec le système de différentes manières :

- API Python

- Interface utilisateur web

- Client de ligne de commande

Maestro planifie les travaux d’apprentissage sur un cluster Kubernetes.

Maestro appelle Kubernetes pour affecter des pods aux pools de nœuds appropriés. AKS met à l’échelle les pools de nœuds en fonction des besoins. Maestro affecte les pods à des pools de nœuds spécifiques en fonction d’une configuration spécifiée par l’utilisateur. L’utilisateur peut sélectionner :

- Des nœuds réguliers ou spot.

- Des nœuds processeur ou GPU.

Kubernetes extrait l’image conteneur de Azure Container Registry, en fonction de la configuration définie par Maestro, et initialise les pods.

Pendant l’apprentissage, les résultats sont stockés dans Azure Files et le système de suivi des indicateurs de performance qui fait partie des pods de gestion Maestro (et soutenus par un dispositif de stockage supplémentaire). L’utilisateur surveille la progression du travail à l’aide du tableau de bord Maestro.

Une fois l’entraînement terminé, l’agent d’apprentissage par renforcement est envoyé (push) au système de déploiement, où il peut être interrogé pour les actions. Si vous le souhaitez, le serveur de déploiement peut signaler des statistiques de surveillance à la plateforme Maestro pour optimiser davantage l’agent via Azure Files.

Composants

- AKS est un service d’orchestration de conteneurs managé basé sur le système Kubernetes open source. Vous pouvez utiliser AKS pour gérer des fonctionnalités critiques telles que le déploiement, la mise à l’échelle et la gestion des conteneurs Docker et des applications basées sur des conteneurs.

- Le moteur Maestro (nom de code DeepSim) augmente les workflows de fabrication existants et améliore les indicateurs de performance clés de fabrication de semi-conducteurs avec des suggestions de distribution et de planification améliorées par IA.

- Azure Spot Virtual Machines provisionne la capacité de calcul Azure inutilisée avec une réduction significative. Les machines virtuelles Spot offrent les mêmes types de machines, les mêmes options et les mêmes performances que les instances de calcul standard.

- Les comptes de stockage Azure sont utilisés dans cette architecture pour stocker les résultats d’apprentissage, les données d’entrée et de configuration.

- Les disques managés Azure sont un stockage de blocs durable hautes performances conçu pour les machines virtuelles Azure et Azure VMware Solution.

- Azure Virtual Network permet à des ressources Azure, comme des machines virtuelles (VM) de communiquer les unes avec les autres, avec Internet et avec des réseaux locaux, avec des connexions bénéficiant d’une sécurité renforcée.

- Azure Files permet des partages de fichiers complètement managés dans le cloud, accessibles via les protocoles SMB et NFS standard du secteur.

- Azure Container Registry permet de générer, stocker, analyser, répliquer et gérer des images conteneurs et des artefacts avec une instance de distribution OCI géo-répliquée et complètement managée.

Détails du scénario

Une modélisation efficace des outils et des méthodes de planification et de distribution efficaces sont essentielles pour les fabricants.

Pour tirer parti des solutions d’IA et de Machine Learning de pointe, les entreprises ont besoin d’une infrastructure HPC évolutive et économique. L’exécution de charges de travail très complexes peut prendre plusieurs jours avec des infrastructures locales. Les systèmes locaux sont également généralement moins économes en énergie que les solutions Azure.

Le partenaire Microsoft minds.ai créé la solution de planification et de distribution Maestro pour aider les entreprises de fabrication de semi-conducteurs à optimiser les indicateurs de performance clés de fabrication des puces.

Cette solution utilise AKS pour déployer, gérer et mettre à l’échelle des applications basées sur des conteneurs dans un environnement de cluster. Une API REST est utilisée pour fournir une interface conviviale à AKS. Vous pouvez utiliser Container Registry pour créer, stocker et gérer des images conteneur comme DeepSim. Les conteneurs ont une portabilité élevée et augmentent l’agilité des flux de travail à la demande.

L’architecture de solution décrite dans cet article s’applique aux scénarios suivants.

L’apprentissage par renforcement pour la planification de fabrication

Cette solution peut aider les ingénieurs de contrôle de ligne à améliorer la durée, le débit et l’utilisation du cycle de produit, et à libérer de la bande passante des ressources via l’automatisation et l’augmentation des flux de travail actuels. La solution peut augmenter un flux de travail avec des agents IA qui sont formés via RL pour fournir aux ingénieurs en fabrication plus d’insights et d’options pour améliorer les indicateurs de performance clés.

La solution utilise l’apprentissage par renforcement pour effectuer l’apprentissage des modèles. Les solutions déployées sont entraînées, dans des simulations, pour répondre rapidement aux états de fabrication dynamiques. Le flux de travail génère automatiquement des suggestions de planification.

Dans un scénario réel, les planifications résultantes ont permis à une entreprise d’économiser des dizaines de millions de dollars par an en :

- Augmentant le débit de 1 à 2 %.

- Réduisant des violations du temps de file d’attente critique de 1 à 2 %.

- Réduisant la durée de cycle des nouveaux produits de 2 à 7 %.

- Améliorant l’utilisation des groupes d’outils goulots d’étranglement.

- Réduisant le coût par puce.

Apprentissage supervisé pour la modélisation des outils de fabrication

L’obtention d’informations précises sur les outils et l’équipement est un autre aspect essentiel de la planification et de l’exploitation d’une fabrication. Les exigences métier incluent souvent des modèles de mesure de la fiabilité et de la prévisibilité des outils, notamment l’indice d’intégrité de l’équipement (EHI) et la durée de vie restante (RUL).

Maestro inclut des applications pour l’apprentissage des modèles EHI et RUL. Les données historiques qui font partie du système de journalisation de la fabrication sont utilisées pour entraîner les modèles. Le matériel GPU Azure accélère ce processus. Les modèles résultants sont utilisés pour la planification sensible aux risques afin d’optimiser la productivité, le rendement et la maintenance préventive et d’améliorer considérablement l’EHI.

Cas d’usage potentiels

Cette architecture s’applique également aux secteurs d’activité suivants, dans lesquels des solutions avancées de contrôle et de planification sont généralement utilisées :

- Industry 4.0

- Voyage et transport (développement d’applications)

- Pharmaceutique et santé

- Contrôle des énergies renouvelables et conception de site multivarié

Considérations

Ces considérations implémentent les piliers d’Azure Well-Architected Framework, un ensemble de principes directeurs que vous pouvez utiliser pour améliorer la qualité d’une charge de travail. Pour plus d'informations, consultez Microsoft Azure Well-Architected Framework.

Fiabilité

La fiabilité permet de s’assurer que votre application tient vos engagements auprès de vos clients. Pour plus d’informations, consultez la page Vue d’ensemble du pilier de fiabilité.

Les solutions minds.ai sont déployées dans certains des processus les plus complexes et critiques au monde pour la production de puce et d’énergie, de sorte que la fiabilité est essentielle. Sur la plateforme Azure, vous pouvez maintenir la stabilité de vos environnements en cours d’exécution à l’aide de zones de disponibilité, de groupes à haute disponibilité, de stockage géoredondant et d’Azure Site Recovery. Si des problèmes sont détectés, le système redémarre automatiquement une partie de l’environnement de calcul et redémarre le processus d’entraînement. Cette fonctionnalité permet de garantir que vous obtenez un agent ou un modèle de réseau neural entraîné dans la période attendue.

Ce système augmente vos solutions existantes, de sorte que vous pouvez toujours revenir à ces solutions.

Sécurité

La sécurité fournit des garanties contre les attaques délibérées, et contre l’utilisation abusive de vos données et systèmes importants. Pour plus d’informations, consultez Vue d’ensemble du pilier Sécurité.

Cette solution est déployée en tant que solution monolocataire. Le contrôle exclusif des logiciels, des données et des simulations in-process vous incombe.

AKS offre un contrôle d’accès en fonction du rôle (RBAC), qui permet de s’assurer que les ingénieurs accèdent uniquement aux informations dont ils ont besoin pour effectuer leur travail.

Pour plus d’informations sur les options de sécurité de réseau, consultez Sécuriser le trafic entre les pods avec des stratégies réseau dans AKS.

Optimisation des coûts

L’optimisation des coûts consiste à réduire les dépenses inutiles et à améliorer l’efficacité opérationnelle. Pour plus d’informations, consultez Vue d’ensemble du pilier d’optimisation des coûts.

Les exécutions d’entraînement Maestro peuvent fonctionner de manière interruptible, ce qui permet deux options :

- Les machines virtuelles spot réduisent les coûts, mais augmentent le risque que les travaux prennent plus de temps à se terminer en raison d’interruptions.

- Les instances réservées augmentent les coûts, mais utilisent des ressources de calcul dédiées qui entraînent des runtimes prévisibles.

Les machines virtuelles spot vous permettent de disposer de notre capacité Azure inutilisée en réalisant des économies significatives. Si Azure a besoin de la capacité, il supprime les machines virtuelles spot, et le logiciel minds.ai démarre automatiquement les nouvelles instances et reprend le processus d’entraînement.

Aucun coût n'est associé à AKS au niveau du déploiement, de la gestion et des opérations du cluster Kubernetes. Vous payez uniquement pour les instances de machines virtuelles, le stockage et les ressources réseau consommées par votre cluster Kubernetes. Azure Files est utilisé pour le stockage de données à long terme. Étant donné que toutes les données restent dans le cloud, les frais de bande passante de transfert de données sont réduits.

Voici quelques détails sur les cas d’utilisation du processeur et du GPU.

Cas d’utilisation de l’UC : 10 agents d’apprentissage par renforcement s’exécutant pendant un mois sur 20 nœuds, avec 120 cœurs d’UC par nœud, sont utilisés avec un temps de calcul de 360 heures (2 400 cœurs d’UC).

Pour économiser jusqu’à 83 % du coût, utilisez Azure Spot Virtual Machines.

Catégorie de service Type de service Description Compute Machines virtuelles Une machine virtuelle Standard_HB120rs_v3 (120 cœurs, 448 Gio de RAM) Compute Machines virtuelles Une machine virtuelle Standard_B8ms (8 cœurs, 32 Gio de RAM) Stockage Comptes de stockage Stockage de fichiers, niveau de performances Premium Stockage Comptes de stockage Disques managés, SSD Premium, type de disque P4, un disque Conteneurs Container Registry Un registre Compute Machines virtuelles 20 machines virtuelles Standard_HB120rs_v3 (120 cœurs, 448 Gio de RAM) Cas d’usage de GPU : l’apprentissage supervisé de 10 travaux d’entraînement de réseau neural exécutés pendant un mois sur 16 nœuds, avec un GPU par nœud, est utilisé avec un temps de calcul de 360 heures (16 GPU).

Pour économiser jusqu’à 52 % du coût, utilisez Azure Spot Virtual Machines.

Catégorie de service Type de service Description Compute Machines virtuelles Une machine virtuelle Standard_HB120_rs v3 (120 cœurs, 448 Gio de RAM) Compute Machines virtuelles Une machine virtuelle Standard_B8ms (8 cœurs, 32 Gio de RAM) Stockage Comptes de stockage Stockage de fichiers, niveau de performances Premium Stockage Comptes de stockage Disques managés, SSD Premium, type de disque P4, un disque Conteneurs Container Registry Un registre Compute Machines virtuelles 16 machines virtuelles Standard_NC6s_v3 (6 processeurs virtuels, 112 Gio de RAM)

Utilisez la Calculatrice de prix Azure afin d’estimer les coûts pour votre organisation.

Efficacité des performances

L’efficacité des performances est la capacité de votre charge de travail à s’adapter à la demande de façon efficace. Pour plus d’informations, consultez Vue d’ensemble du pilier d’efficacité des performances.

Cette architecture utilise des machines virtuelles de la série HBv3 avec des processeurs AMD pour l’apprentissage par renforcement et des machines virtuelles de la série NCv3 avec des GPU NVIDIA pour l’apprentissage supervisé.

Les machines virtuelles de la série HBv3 disposent de processeurs gourmands en calcul et d’une mémoire à bande passante élevée qui conviennent parfaitement à l’apprentissage par renforcement. Vous pouvez les utiliser dans des configurations de cluster à plusieurs nœuds pour obtenir des performances évolutives.

Les machines virtuelles de la série NCv3 ont des processeurs à accélération GPU gourmands en ressources de calcul qui conviennent parfaitement aux exigences de l’apprentissage supervisé. Ils peuvent utiliser des fonctionnalités multi-GPU pour obtenir des performances évolutives.

Pour plus d’informations, consultez Options de mise à l’échelle pour les applications dans AKS.

Contributeurs

Cet article est géré par Microsoft. Il a été écrit à l’origine par les contributeurs suivants.

Auteurs principaux :

- Kalaiselvan Balaraman | Architecte de solution cloud

- Mahaboob Basha R | Architecte de solution cloud

- Jeroen Bédorf | Architecte Principal

- Thomas Soule | Responsable du développement commercial

Autres contributeurs :

- Mick Alberts | Rédacteur technique

- Hari Bagudu | Directeur senior

- Gauhar Junnarkar | Responsable de programme principal

- Sachin Rastogi | Responsable du programme

Pour afficher les profils LinkedIn non publics, connectez-vous à LinkedIn.

Étapes suivantes

- Présentation d’AKS

- Machines virtuelles dans Azure

- Utiliser des machines virtuelles Azure Spot

- Introduction à Azure Storage

- Qu’est-ce que le réseau virtuel Azure ?

- Instances de machines virtuelles compatibles RDMA

- Options de configuration de cluster HPC

- Description du produit DeepSim

- Solutions de semi-conducteurs minds.ai

- Plateforme d’entraînement DeepSim

- Vestas suralimente ses modèles de contrôle de parc éolien pour l’énergie durable avec Azure HPC