Note

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Cet article explique comment utiliser le calcul serverless pour les notebooks. Pour plus d’informations sur l’utilisation du calcul serverless pour les travaux, consultez Exécuter vos travaux Lakeflow avec un calcul serverless pour les flux de travail.

Pour obtenir des informations sur la tarification de l'utilisation du calcul sans serveur dans les notebooks, consultez la tarification de Databricks.

Spécifications

- Vous devez activer votre espace de travail pour Unity Catalog.

- Votre espace de travail doit se trouver dans une région prise en charge pour le calcul serverless. Voir les régions Azure Databricks.

Attacher un notebook à un calcul serverless

Si votre espace de travail est configuré pour prendre en charge le calcul serverless interactif, toutes les personnes qui l’utilisent ont accès au calcul serverless pour les notebooks. Aucune autorisation supplémentaire n’est nécessaire.

Pour effectuer un attachement au calcul serverless, cliquez sur le menu déroulant Se connecter dans le notebook, puis sélectionnez Serverless. Pour les nouveaux notebooks, le calcul attaché passe automatiquement par défaut au mode serverless au moment de l’exécution du code, si aucune autre ressource n’a été sélectionnée.

Voir les insights de requête

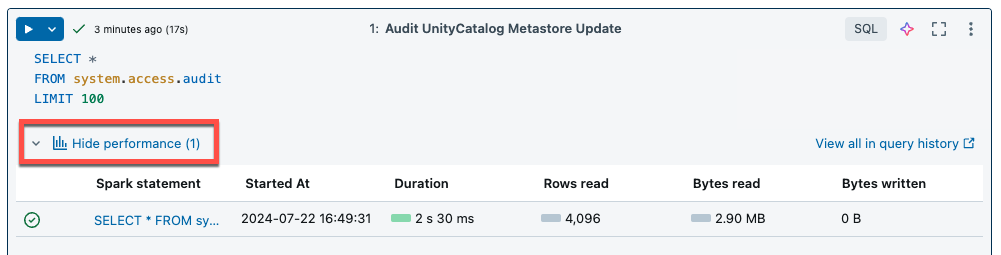

Le calcul serverless pour les notebooks et les travaux utilise des insights de requête pour évaluer les performances d’exécution de Spark. Après avoir exécuté une cellule dans un notebook, vous pouvez voir les insights liés aux requêtes SQL et Python en cliquant sur le lien Voir les performances.

Vous pouvez cliquer sur l’une des instructions Spark pour voir les métriques de requête. Vous pouvez ensuite cliquer sur Voir le profil de requête pour visualiser l’exécution de la requête. Pour plus d’informations sur les profils de requête, consultez Profil de requête.

Remarque

Pour afficher les insights sur les performances de vos exécutions de travail, consultez Afficher les insights de requête d’exécution de travail.

Historique des requêtes

Toutes les requêtes exécutées sur le calcul serverless sont également enregistrées sur la page d’historique des requêtes de votre espace de travail. Pour plus d’informations sur l’historique des requêtes, consultez Historique des requêtes.

Limitations des insights de requête

- Le profil de requête est disponible uniquement à la fin de l’exécution de la requête.

- Les métriques sont mises à jour en temps réel, même si le profil de requête ne s’affiche pas durant l’exécution.

- Seuls les états de requête suivants sont couverts : RUNNING, CANCELED, FAILED, FINISHED.

- Les requêtes en cours d’exécution ne peuvent pas être annulées à partir de la page d’historique des requêtes. Elles peuvent être annulées dans les notebooks ou les travaux.

- Les métriques détaillées ne sont pas disponibles.

- Le téléchargement du profil de requête n’est pas disponible.

- L’accès à l’IU de Spark n’est pas disponible.

- Le texte de l’instruction contient uniquement la dernière ligne exécutée. Toutefois, plusieurs lignes précédant cette ligne ont peut-être été exécutées dans le cadre de la même instruction.

Protection par dépassement de charge serverless

Pour contrôler les requêtes longues, les notebooks serverless ont un délai d’exécution par défaut de 2,5 heures. Vous pouvez définir manuellement la durée du délai d’attente en configurant spark.databricks.execution.timeout dans le notebook. Consultez Configurer les propriétés Spark pour les blocs-notes serverless et les travaux.