Note

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de changer d’annuaire.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de changer d’annuaire.

Important

Cette fonctionnalité est disponible en préversion publique.

Cet article explique comment utiliser un notebook dans les pipelines déclaratifs de Spark Lakeflow pour développer et déboguer des pipelines ETL.

Note

Cette page décrit l’expérience de modification de bloc-notes héritée. L’expérience par défaut recommandée est l’éditeur de pipelines Lakeflow. Vous pouvez utiliser l’Éditeur de pipelines Lakeflow pour modifier des notebooks, ou des fichiers de code Python ou SQL pour un pipeline. Pour plus d’informations, consultez Développer et déboguer des pipelines ETL avec l’éditeur de pipelines Lakeflow.

Pour configurer l’expérience de notebook décrite sur cette page, vous devez désactiver l’éditeur de pipelines Lakeflow. Consultez L’activation de l’éditeur de pipelines Lakeflow et la surveillance mise à jour.

Vue d’ensemble des blocs-notes dans les pipelines déclaratifs Spark Lakeflow

Lorsque vous travaillez sur un notebook Python ou SQL configuré en tant que code source pour un pipeline existant, vous pouvez connecter le notebook directement au pipeline. Lorsque le notebook est connecté au pipeline, les fonctionnalités suivantes sont disponibles :

- Démarrez et validez le pipeline à partir du notebook.

- Affichez le graphique de flux de données et le journal des événements du pipeline pour connaître la dernière mise à jour dans le notebook.

- Afficher les diagnostics de pipeline dans l’éditeur de notebook.

- Consultez l'état du cluster du pipeline dans le cahier de notes.

- Accédez à l’interface utilisateur des pipelines déclaratifs Spark Lakeflow à partir du bloc-notes.

Prerequisites

- Vous devez disposer d’un pipeline existant avec un notebook Python ou SQL configuré comme code source.

- Vous devez être le propriétaire du pipeline ou avoir le

CAN_MANAGEprivilège.

Limites

- Les fonctionnalités décrites dans cet article ne sont disponibles que dans les notebooks Azure Databricks. Les fichiers d’espace de travail ne sont pas pris en charge.

- Le terminal web n’est pas disponible lorsqu’il est attaché à un pipeline. Par conséquent, il n’est pas visible sous forme d’onglet dans le volet inférieur.

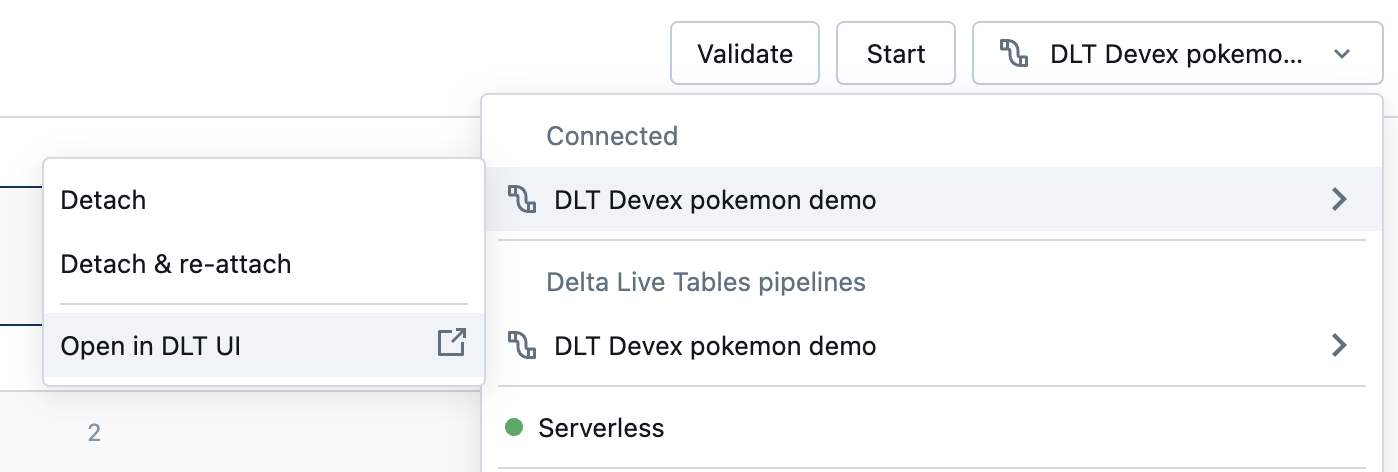

Connecter un notebook à un pipeline

Dans le bloc-notes, cliquez sur le menu déroulant utilisé pour sélectionner le calcul. Le menu déroulant affiche tous vos pipelines déclaratifs Spark Lakeflow avec ce bloc-notes comme code source. Pour connecter le bloc-notes à un pipeline, sélectionnez-le dans la liste.

Afficher l’état du cluster du pipeline

Pour comprendre facilement l’état du cluster de votre pipeline, son état s’affiche dans le menu déroulant de calcul avec une couleur verte pour indiquer que le cluster est en cours d’exécution.

Valider le code du pipeline

Vous pouvez valider le pipeline pour vérifier les erreurs de syntaxe dans votre code source sans traiter de données.

Pour valider un pipeline, effectuez l’une des opérations suivantes :

- Dans le coin supérieur droit du bloc-notes, cliquez sur Valider.

- Appuyez

Shift+Entersur n’importe quelle cellule de bloc-notes. - Dans le menu déroulant d’une cellule, cliquez sur Valider le pipeline.

Note

Si vous tentez de valider votre pipeline pendant qu’une mise à jour existante est déjà en cours d’exécution, une boîte de dialogue s’affiche pour vous demander si vous souhaitez arrêter la mise à jour existante. Si vous cliquez sur Oui, la mise à jour existante s’arrête et une mise à jour de validation démarre automatiquement.

Démarrer une mise à jour de pipeline

Pour démarrer une mise à jour de votre pipeline, cliquez sur le bouton Démarrer dans le coin supérieur droit du bloc-notes. Consultez Exécuter une mise à jour de pipeline.

Afficher l’état d’une mise à jour

Le panneau supérieur du notebook indique si une mise à jour de pipeline est :

- Démarrage

- En cours de validation

- Arrêt

Afficher les erreurs et les diagnostics

Une fois que vous avez démarré une mise à jour ou une validation de pipeline, toutes les erreurs s’affichent en ligne avec un soulignement rouge. Pointez sur une erreur pour afficher plus d’informations.

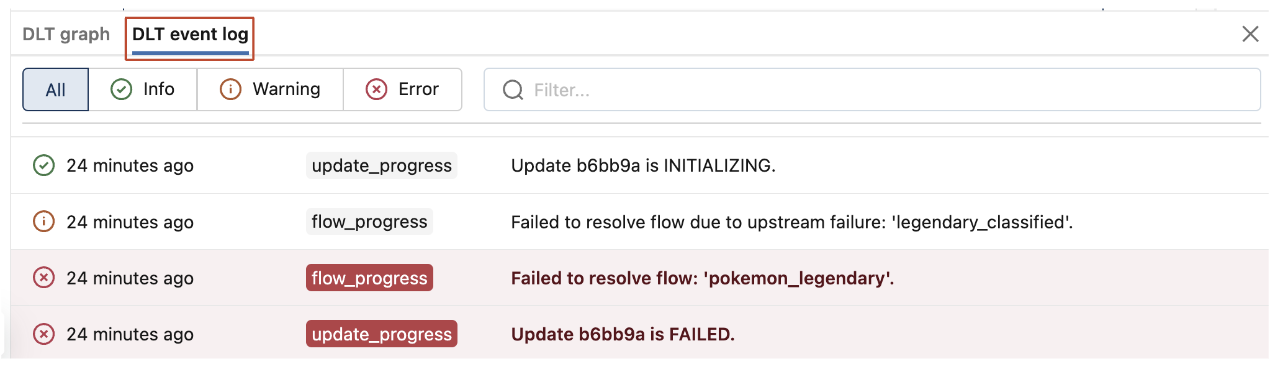

Afficher les événements de pipeline

Lorsqu'il est attaché à un pipeline, un onglet des événements des pipelines déclaratifs Lakeflow Spark se trouve en bas du bloc-notes.

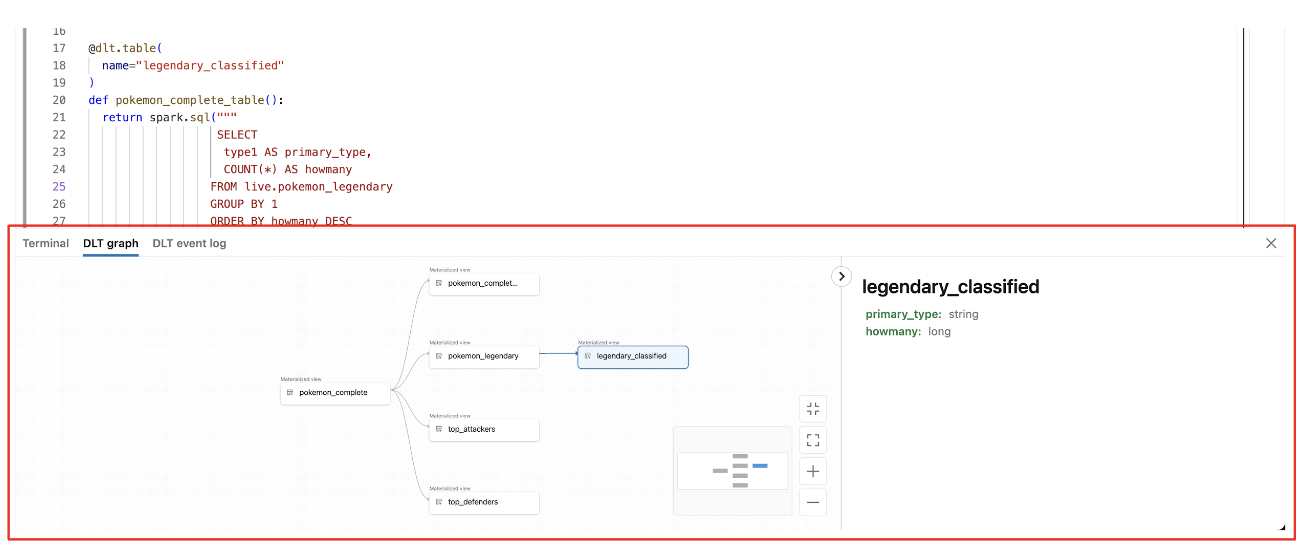

Afficher le graphe de flux de données du pipeline

Pour afficher le graphique de flux de données d’un pipeline, utilisez l’onglet Graphique de Lakeflow Spark pour les Pipelines déclaratifs situé en bas du bloc-notes. La sélection d’un nœud dans le graphique affiche son schéma dans le volet droit.

Comment accéder à l’interface utilisateur des pipelines déclaratifs Spark Lakeflow à partir du notebook

Pour accéder facilement à l’interface utilisateur des pipelines déclaratifs Spark Lakeflow, utilisez le menu en haut à droite du bloc-notes.

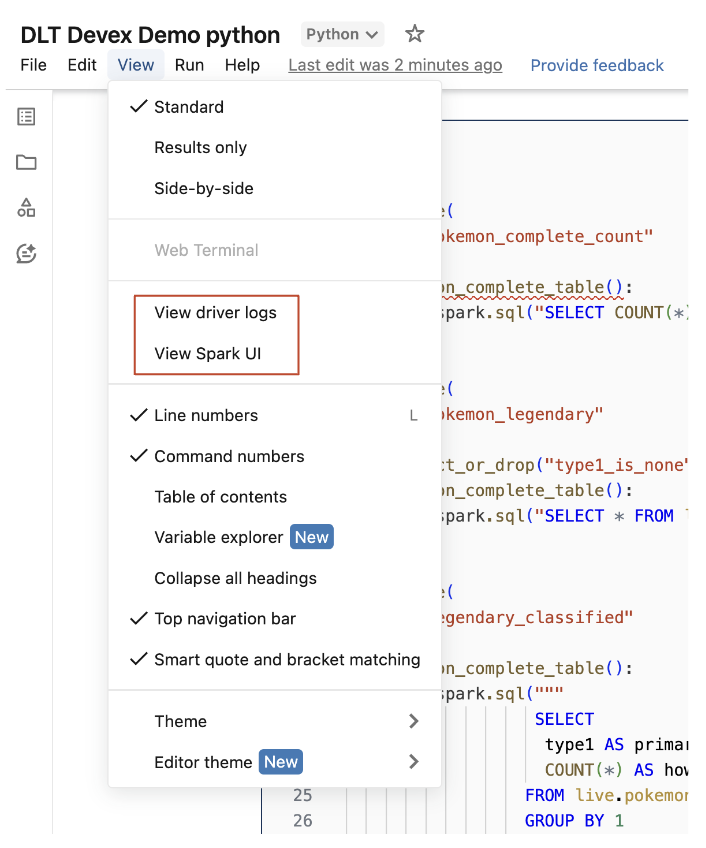

Accéder aux journaux des pilotes et à l’interface utilisateur Spark à partir du notebook

Les journaux du pilote et l’interface utilisateur Spark associés au pipeline en cours de développement sont facilement accessibles à partir du menu Affichage du bloc-notes.