Ce guide compare le système tarifaire et la gestion des coûts dans Azure Kubernetes Service (AKS) par rapport à Amazon Elastic Kubernetes Service (Amazon EKS). L’article explique comment optimiser les coûts et implémenter des solutions de gouvernance des coûts pour votre cluster AKS.

Remarque

Cet article fait partie d'une série d'articles qui aide les professionnels qui connaissent Amazon EKS à comprendre Azure Kubernetes Service (AKS).

Concepts de base sur les coûts d’Amazon EKS

Dans Amazon EKS, vous payez un prix horaire fixe pour chaque cluster Amazon EKS. Vous payez également pour les réseaux, les outils d’exploitation et le stockage utilisés par le cluster.

Les nœuds Worker Amazon EKS étant des instances Amazon EC2 standard, ils sont facturés aux prix standard d’Amazon EC2. Vous payez aussi le provisionnement des autres ressources Amazon Web Services (AWS) dont vous avez besoin pour exécuter vos nœuds Worker Kubernetes.

Vous pouvez utiliser les groupes de nœuds managés Amazon EKS sans coût supplémentaire. Vous payez uniquement pour les ressources AWS que vous provisionnez, notamment les instances Amazon EC2, les volumes Amazon EBS, les heures de fonctionnement du cluster Amazon EKS et toute autre infrastructure AWS.

Lorsque vous créez un groupe de nœuds managés, vous pouvez choisir d’utiliser le type de capacité Instances à la demande ou Instances Spot pour gérer le coût des nœuds d’agent. Amazon EKS déploie un groupe de nœuds managés avec un groupe de mise à l’échelle automatique Amazon EC2 qui contient toutes les instances à la demande ou toutes les instances Spot.

Avec les instances à la demande, vous payez la capacité de calcul par seconde, sans engagement à long terme. Les instances Spot Amazon EC2 sont une capacité Amazon EC2 réservée qui est disponible avec des réductions par rapport aux prix des instances à la demande.

Les instances Spot Amazon EC2 peuvent être interrompues avec un avis d’interruption de deux minutes quand EC2 a besoin de récupérer la capacité.

Amazon fournit Spot Fleet, une méthode permettant d’automatiser les groupes d’instances à la demande et Spot, et Spot Instance Advisor pour vous aider à prédire la région ou la zone de disponibilité avec une interruption minimale.

Les prix des instances Spot AWS varient. AWS définit le prix en fonction des tendances de l’offre et de la demande à long terme pour la capacité Instances Spot. Vous payez le prix qui est en vigueur pendant la période de fonctionnement de l’instance.

Analyse des coûts Azure Kubernetes Service

Un cluster Azure Kubernetes Service (AKS) repose sur diverses ressources Azure telles que des machines virtuelles, des disques virtuels, des équilibreurs de charge et des adresses IP publiques. Ces ressources peuvent être utilisées par plusieurs applications, qui peuvent être gérées par différentes équipes au sein d’une organisation. Les modes de consommation de ces ressources peuvent varier, ce qui se traduit par une contribution variable au coût total des ressources du cluster. De plus, certaines applications peuvent avoir des empreintes sur plusieurs clusters, ce qui rend l’attribution et la gestion des coûts difficiles.

Pour les scénarios où un cluster contient une seule charge de travail, Microsoft Cost Management peut être utilisé pour mesurer la consommation des ressources du cluster sous le groupe de ressources du cluster. Cependant, certains scénarios ne sont pas nativement couverts par cette solution seule, par exemple :

- Répartition granulaire de l’utilisation des ressources, comme le calcul, le réseau et le stockage.

- Distinction entre les coûts des applications individuelles et les coûts partagés.

- Analyse des coûts sur plusieurs clusters dans le cadre du même abonnement.

Pour augmenter l’observabilité des coûts, AKS s’est intégré à Microsoft Cost Management pour fournir des décompositions détaillées des coûts au niveau des constructions Kubernetes comme le cluster et l’espace de noms. Cette intégration permet une analyse des coûts dans les catégories de calcul, de réseau et de stockage Azure.

L’addon d’analyse des coûts AKS est basé sur OpenCost, un projet open-source pour la collecte de données d’utilisation. Il fournit une visibilité des coûts en conciliant les données avec votre facture Azure. Les données post-traitées sont directement visibles dans le portail d’analyse des coûts de Cost Management. Pour plus d’informations, consultez Analyse des coûts Azure Kubernetes Service.

Définitions des coûts

Dans les vues des espaces de noms Kubernetes et des actifs, vous verrez les charges, telles que :

- Frais inactifs : représente le coût de la capacité des ressources disponible qui n’a pas été utilisée par les charges de travail.

- Frais de service : Représente les frais associés à des services tels que l'accord de niveau de service (SLA) Uptime et Microsoft Defender for Containers.

- Charges système: Représente le coût de la capacité réservée par AKS sur chaque nœud pour exécuter les processus système requis par le cluster.

- Frais non alloués : représente le coût des ressources qui n’ont pas pu être allouées aux espaces de noms.

Concepts de base sur les coûts AKS

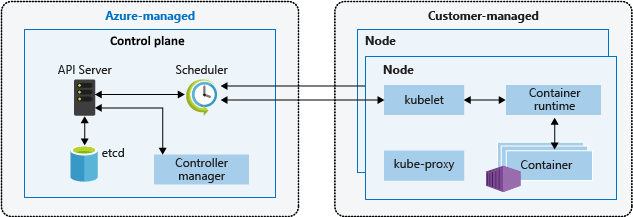

L’architecture Kubernetes repose sur deux couches : le plan de contrôle, et un ou plusieurs nœuds ou pools de nœuds. Le modèle tarifaire d’AKS est basé sur les deux couches de l’architecture Kubernetes.

Le plan de contrôle fournit les services Kubernetes de base, tels que le serveur d’API et

etcd, ainsi que l’orchestration des charges de travail d’application. La plateforme Azure gère le plan de contrôle de l'AKS, et pour le niveau AKS Free, le plan de contrôle n'a pas de coût.Les nœuds, également appelés nœuds d’agent ou nœuds Worker, hébergent les charges de travail et les applications Kubernetes. Dans AKS, les clients gèrent et paient entièrement tous les coûts liés aux nœuds d’agent.

Le diagramme suivant montre la relation entre le plan de contrôle et les nœuds dans une architecture AKS Kubernetes.

Plan de contrôle

Azure provisionne et configure automatiquement la couche du plan de contrôle lorsque vous créez un cluster AKS. Pour le niveau Gratuit d’AKS, le plan de contrôle est gratuit.

Pour un contrat de niveau de service (SLA) supérieur pour le plan de contrôle, vous pouvez créer un cluster AKS dans le niveau Standard. Le contrat SLA concernant la durée de bon fonctionnement est inclus par défaut dans le niveau Standard et est activé par cluster. Le prix est de 0,10 $ par cluster et par heure. Pour plus d’informations, consultez Détails des prix d’AKS.

Les clusters du niveau Standard ont plus de ressources de plan de contrôle, comme le nombre d’instances de serveur d’API, les limites de ressources etcd, la scalabilité jusqu’à 5 000 nœuds et la prise en charge du contrat SLA de durée de bon fonctionnement existante avec pénalités financières. AKS utilise des réplicas du nœud principal entre les domaines de mise à jour et d’erreur pour satisfaire aux exigences de disponibilité.

Il est préférable d’utiliser le contrat SLA Standard dans les charges de travail de production afin d’offrir une plus haute disponibilité des composants du plan de contrôle. Les clusters de niveau Gratuit ont moins de réplicas et des ressources de plan de contrôle limitées, et ils ne sont pas recommandés pour les charges de travail de production.

Nœuds

Dans AKS, vous créez des nœuds Worker ou d’agent dans un ou plusieurs pools de nœuds, qui peuvent utiliser de nombreuses fonctionnalités Azure de base dans l’environnement Kubernetes. AKS facture uniquement les nœuds attachés au cluster AKS.

Les nœuds AKS utilisent plusieurs ressources de l’infrastructure Azure, notamment les groupes de machines virtuelles identiques, les réseaux virtuels et les disques managés. Par exemple, vous pouvez utiliser la plupart des types de machines virtuelles (VM) Azure directement dans AKS. Vous pouvez utiliser les réservations Azure et le plan d’économies Azure pour le calcul pour obtenir des remises significatives sur ces ressources.

Les tarifs du cluster AKS dépendent de la classe, du nombre et de la taille des machines virtuelles dans les pools de nœuds. Le coût d'une machine virtuelle dépend de sa taille, du type de processeur, du nombre de processeurs virtuels, de la mémoire, de la famille et du type de stockage disponible, par exemple un lecteur à état solide (SSD) haute performance ou un lecteur de disque dur standard. Pour plus d’informations, consultez Série de machines virtuelles. Planifiez la taille des nœuds en fonction des exigences des applications, du nombre de nœuds et des besoins de scalabilité du cluster.

Pour plus d’informations sur les nœuds d’agent et les pools de nœuds, consultez l’article Pools de nœuds dans cette série, et Créer et gérer plusieurs pools de nœuds pour un cluster dans Azure Kubernetes Service (AKS).

Déploiement d’un cluster AKS

Chaque déploiement AKS s’étend sur deux groupes de ressources Azure.

Vous créez le premier groupe de ressources, qui contient uniquement la ressource de service Kubernetes et ne donne lieu à aucun coût.

Le fournisseur de ressources AKS crée automatiquement le second groupe de ressources ou groupe de ressources de nœud durant le déploiement. Le nom par défaut de ce groupe de ressources est

MC_<resourcegroupname>_<clustername>_<location>, mais vous pouvez changer ce nom. Pour plus d’informations, consultez Spécifier un nom de mon choix pour le groupe de ressources de nœud AKS.Le groupe de ressources de nœud contient toutes les ressources d’infrastructure du cluster et affiche les frais associés à votre abonnement. Les ressources incluent les machines virtuelles de nœud Kubernetes, les réseaux virtuels, le stockage et d’autres services. AKS supprime automatiquement le groupe de ressources de nœud quand le cluster est supprimé. Vous devez donc l’utiliser uniquement pour les ressources qui partagent le cycle de vie du cluster.

Coûts de calcul

Vous payez pour les machines virtuelles Azure en fonction de leur taille et de leur utilisation. Pour avoir une comparaison du calcul Azure par rapport à AWS, consultez Services de calcul sur Azure et AWS.

En règle générale, plus la taille de machine virtuelle que vous sélectionnez pour un pool de nœuds est élevée, plus le coût horaire est élevé pour les nœuds d’agent. Plus la série de machines virtuelles que vous utilisez pour le pool de nœuds est spécialisée, par exemple avec GPU ou à mémoire optimisée, plus le pool est coûteux.

Lorsque vous examinez les tarifs des machines virtuelles Azure, tenez compte des points suivants :

Les tarifs diffèrent selon la région, et les services et tailles de machines virtuelles ne sont pas tous disponibles dans chaque région.

Il existe de multiples familles de machines virtuelles, qui sont optimisées pour différents types de charges de travail.

Les disques managés utilisés comme lecteurs de système d’exploitation sont facturés séparément, et vous devez ajouter leur coût à vos estimations. La taille du disque géré dépend de la classe, comme les disques durs standard, les disques SSD standard, les disques SSD Premium ou les disques Ultra. Les opérations d’entrée et de sortie par seconde (IOPS) et le débit en Mo/s dépendent de la taille et de la classe. Les disques de système d’exploitation éphémères sont gratuits et sont inclus dans le prix des machines virtuelles.

Les disques de données, y compris ceux créés avec des revendications de volume persistant, sont optionnels et sont facturés individuellement en fonction de leur catégorie, comme les disques durs standard, les disques SSD standard, les disques SSD Premium et le stockage sur disque ultra. Vous devez ajouter explicitement les disques de données aux estimations de coûts. Le nombre de disques de données, de disques SSD de stockage temporaire, d’IOPS et de données transférées en Mo/s autorisés dépendent de la taille et de la classe des machines virtuelles.

Plus la durée de bon fonctionnement des nœuds d’agent est longue, plus le coût total du cluster est élevé. Les environnements de développement n’ont généralement pas besoin d’être exécutés en continu.

Les interfaces réseau (cartes réseau) sont gratuites.

Coûts de stockage

CSI (Container Storage Interface) est une norme pour exposer des systèmes de stockage de blocs et de fichiers à des charges de travail conteneurisées sur Kubernetes. En adoptant et en utilisant la norme CSI, AKS peut écrire, déployer et itérer les plug-ins qui exposent des systèmes de stockage Kubernetes, sans avoir à modifier le code Kubernetes de base ni à attendre ses cycles de mise en production.

Si vous exécutez des charges de travail qui utilisent des volumes persistants CSI sur votre cluster AKS, prenez en compte le coût du stockage que vos applications provisionnent et utilisent. Les pilotes de stockage CSI sur AKS offrent une prise en charge native des options de stockage suivantes :

Azure Disks crée des ressources de disque de données Kubernetes. Les disques peuvent utiliser un Stockage Premium Azure, assorti de disques SSD haute performance, ou un Stockage Standard Azure, assorti de disques HDD ordinaires ou de disques SSD standard. La plupart des charges de travail de développement et de production utilisent le Stockage Premium. Les disques Azure sont montés en

ReadWriteOnce, ce qui les rend disponibles pour un seul nœud AKS. Pour les volumes de stockage auxquels plusieurs pods peuvent accéder simultanément, utilisez Azure Files. Pour obtenir des informations de coût, consultez Tarifs des disques managés.Azure Files monte des partages de fichiers SMB (Server Messaging Block) 3.0/3.1 associés à un compte Stockage Azure sur des pods AKS. Vous pouvez partager des données entre plusieurs nœuds et pods. Azure Files peut utiliser un stockage Standard avec des disques HDD Standard, ou un stockage Premium avec des disques SSD haute performance. Azure Files utilise un compte Stockage Azure et génère des frais en fonction des facteurs suivants :

- Service : Blob, Fichier, File d’attente, Table ou disques non managés

- Type de compte de stockage : GPv1, GPv2, Blob ou Premium Blob

- Résilience : stockage localement redondant (LRS), stockage redondant interzone (ZRS), stockage géoredondant (GRS) ou stockage géoredondant avec accès en lecture (RA-GRS)

- Niveau d’accès : chaud, froid ou archive

- Opérations et transferts de données

- Capacité utilisée en Go

Azure NetApp Files est disponible dans plusieurs niveaux SKU et nécessite une capacité provisionnée minimale de 4 Tio, par incréments de 1 Tio. Les frais Azure NetApp Files dépendent des facteurs suivants :

- SKU

- Résilience : LRS, ZRS ou GRS

- Taille ou capacité provisionnée, et non capacité utilisée

- Opérations et transfert de données

- Sauvegardes et restaurations

Coûts réseau

Plusieurs services réseau Azure peuvent fournir l’accès à vos applications qui s’exécutent dans AKS :

Équilibreur de charge Azure. Par défaut, Load Balancer utilise la référence SKU Standard. Les frais Load Balancer dépendent des facteurs suivants :

- Règles : nombre de règles de trafic sortant et d’équilibrage de la charge configurées. Les règles de traduction d’adresses réseau (NAT) de trafic entrant ne sont pas comptabilisées dans le nombre total de règles.

- Données traitées : volume entrant et sortant de données traitées, indépendamment des règles. Il n'y a pas de frais horaires pour un équilibreur de charge standard sans règles configurées.

Azure Application Gateway : AKS utilise souvent Application Gateway via le contrôleur d’entrée Application Gateway, ou en utilisant un autre contrôleur d’entrée front-end avec une Application Gateway gérée manuellement. Application Gateway prend en charge le routage des passerelles, l’arrêt TLS (Transport Layer Security) et les fonctionnalités Web Application Firewall. Les frais Application Gateway dépendent des facteurs suivants :

- Prix fixe défini par heure ou heure partielle.

- Prix de l’unité de capacité, qui est un coût supplémentaire basé sur la consommation. Chaque unité de capacité a au plus une unité Compute, 2 500 connexions persistantes et un débit de 2,22 Mbits/s.

Les adresses IP publiques ont un coût associé qui dépend des facteurs suivants :

- Association réservée ou dynamique.

- Niveau De base ou niveau Standard redondant interzone et sécurisé.

Coûts de scale-out

Il existe plusieurs options de mise à l’échelle d’un cluster AKS afin d’ajouter une capacité supplémentaire aux pools de nœuds :

À la demande, vous pouvez mettre à jour manuellement le nombre de machines virtuelles qui font partie d’un pool de nœuds ou bien ajouter d’autres pools de nœuds.

L’autoscaler de cluster AKS identifie les pods qui ne peuvent pas être planifiés sur les nœuds en raison de contraintes de ressources et augmente automatiquement le nombre de nœuds.

AKS prend en charge l’exécution de conteneurs sur Azure Container Instances avec l’implémentation d’un kubelet virtuel. Un nœud virtuel AKS provisionne des pods Container Instances qui démarrent en quelques secondes, ce qui permet à AKS de s’exécuter avec la juste capacité nécessaire à une charge de travail moyenne. Quand le cluster AKS manque de capacité, vous pouvez effectuer un scale-out pour ajouter d’autres pods Container Instances sans avoir à gérer de serveurs supplémentaires. Vous pouvez combiner cette approche avec l’autoscaler de cluster et la mise à l’échelle manuelle.

Si vous utilisez la mise à l’échelle à la demande ou l’autoscaler de cluster, prenez en compte les machines virtuelles ajoutées. Les frais Container Instances dépendent des facteurs suivants :

- Facturation des métriques basées sur l’utilisation par groupe de conteneurs

- Utilisation des ressources processeur virtuel et mémoire

- Utilisation d’un seul conteneur ou partage de plusieurs conteneurs

- Utilisation de conteneurs coplanifiés qui partagent le cycle de vie du réseau et des nœuds

- Durée d’utilisation calculée depuis le démarrage ou redémarrage du tirage (pull) d’image jusqu’à l’arrêt

- Frais supplémentaires associés aux groupes de conteneurs Windows

Coûts de mise à niveau

Une partie du cycle de vie du cluster AKS implique des mises à niveau périodiques vers la dernière version de Kubernetes. Il est important d’appliquer les versions de sécurité les plus récentes et d’obtenir les dernières fonctionnalités. Vous pouvez mettre à niveau les clusters AKS et les pools à nœud unique manuellement ou automatiquement. Pour plus d’informations, consultez Mettre à niveau un cluster Azure Kubernetes Service (AKS).

Par défaut, AKS configure les mises à niveau avec un nœud supplémentaire. La valeur par défaut 1 pour le paramètre max-surge minimise l’interruption de la charge de travail en créant un nœud supplémentaire qui remplace les nœuds d’une version antérieure avant d’isoler ou de drainer les applications existantes. Vous pouvez personnaliser la valeur max-surge par pool de nœuds pour parvenir à un compromis entre la vitesse de mise à niveau et l’interruption due à la mise à niveau. L’augmentation de la valeur max-surge accélère le processus de mise à niveau, mais une valeur max-surge élevée peut entraîner des interruptions pendant la mise à niveau et générer des frais supplémentaires associés aux machines virtuelles ajoutées.

Autres coûts

Selon l’utilisation et les exigences, les clusters AKS peuvent entraîner les coûts supplémentaires suivants :

Coûts Azure Container Registry variables en fonction de la référence SKU De base, Standard ou Premium, des builds d’images et du stockage utilisés. Déployez Container Registry sur la même région que le cluster pour éviter des frais de transfert de données supplémentaires. Utilisez la réplication si nécessaire, et réduisez les tailles d’images autant que possible pour diminuer les coûts de stockage et les temps de déploiement.

Transferts de données sortants à partir d’Azure, et trafic interrégion.

Autres services de stockage ou PaaS (platform as a service), tels que des bases de données.

Services réseau globaux comme Azure Traffic Manager ou Azure Front Door qui routent le trafic vers les points de terminaison publics des charges de travail AKS.

Services de protection et de pare-feu tels que le Pare-feu Azure qui inspectent et autorisent ou bloquent le trafic vers et depuis des clusters AKS.

Services de monitoring et de journalisation comme Azure Monitor Container Insights, Azure Monitor Application Insights et Microsoft Defender pour le cloud. Pour plus d’informations, consultez Comprendre les coûts de monitoring pour Container Insights.

Coûts associés à des outils DevOps comme Azure DevOps Services ou GitHub.

Optimisation des coûts

Les recommandations suivantes vous aideront à optimiser les coûts de votre cluster AKS :

Lisez la section Optimisation des coûts du framework Azure Well-Architected Framework pour AKS.

Pour les solutions multilocataires, l’isolation physique est plus coûteuse et ajoute une surcharge de gestion. L’isolation logique demande davantage d’expérience avec Kubernetes et augmente la surface d’exposition pour les modifications et les menaces de sécurité, mais elle partage les coûts.

Les réservations Azure peuvent vous aider à économiser de l’argent en vous engageant sur des plans d’un ou de trois ans pour plusieurs produits, tels que les machines virtuelles dans votre cluster AKS. Vous obtenez des remises en réservant la capacité. Utilisez les réservations Azure pour le stockage et le calcul afin de réduire le coût des nœuds d'agent.

Les réservations peuvent diminuer les coûts de vos ressources jusqu’à 72 % par rapport aux prix de paiement à l’utilisation, sans impacter l’état d’exécution des ressources. Quand vous achetez une réservation, la remise s’applique automatiquement aux ressources correspondantes. Vous pouvez acheter des réservations à partir du portail Azure, ou en utilisant les API REST Azure, PowerShell ou la CLI Azure Si vous utilisez des outils opérationnels qui fonctionnent avec les espaces de travail Log Analytics, prévoyez également des réservations pour ce stockage.

Ajoutez un ou plusieurs pools de nœuds spot à votre cluster AKS. Un pool de nœuds spot est un pool de nœuds qui est associé à des groupes de machines virtuelles identiques Azure Spot. L’utilisation de machines virtuelles spot pour les nœuds du cluster AKS vous permet de tirer parti de la capacité Azure inutilisée et de réaliser des économies importantes. La quantité de capacité inutilisée disponible varie en fonction de plusieurs facteurs, comme la taille des nœuds, la région et l’heure de la journée. Azure alloue les nœuds spot si une capacité est disponible, mais il n’y a pas de contrat SLA pour les nœuds spot. Un groupe identique spot, sur lequel s’appuie le pool de nœuds spot, est déployé dans un domaine d’erreur unique. Il n’offre aucune garantie de haute disponibilité. Quand Azure a besoin de récupérer la capacité, l’infrastructure Azure supprime les nœuds spot.

Lorsque vous créez un pool de nœuds spot, vous pouvez définir le prix maximal à payer par heure et activer l’autoscaler de cluster, qui est recommandé pour les pools de nœuds spot. L’autoscaler de cluster effectue un scale-out et un scale-in du nombre de nœuds dans le pool de nœuds en fonction des charges de travail en cours d’exécution. Pour les pools de nœuds spot, l’autoscaler de cluster effectue un scale-out du nombre de nœuds après une éviction si les nœuds sont toujours nécessaires. Pour plus d’informations, consultez Ajouter un pool de nœuds spot à un cluster Azure Kubernetes Service (AKS).

Choisissez la taille de machine virtuelle appropriée pour vos pools de nœuds de cluster AKS en fonction des besoins en processeur et en mémoire de vos charges de travail. Azure propose de nombreux types d’instances de machine virtuelle différents qui conviennent à un large éventail de cas d’usage, avec plusieurs combinaisons de capacité pour le processeur, la mémoire, le stockage et les réseaux. Chaque type est disponible dans une ou plusieurs tailles, ce qui vous permet de mettre facilement à l’échelle vos ressources.

Vous pouvez maintenant déployer et gérer des applications conteneurisées avec AKS s’exécutant sur des processeurs ARM Ampere Altra. Pour plus d’informations, consultez Machines virtuelles Azure avec des processeurs ARM Ampere Altra.

Créez plusieurs pools de nœuds avec des tailles de machines virtuelles différentes pour des utilisations et charges de travail spécifiques. Utilisez des aversions et tolérances ainsi que des étiquettes de nœud Kubernetes pour placer les applications gourmandes en ressources sur des pools de nœuds spécifiques et éviter ainsi des problèmes de voisins bruyants. Conservez ces ressources de nœuds disponibles pour les charges de travail qui en ont besoin et ne planifiez pas d’autres charges de travail sur ces nœuds. L’utilisation de plusieurs tailles de machine virtuelle pour les différents pools de nœuds contribue également à l’optimisation des coûts. Pour plus d’informations, consultez Utiliser plusieurs pools de nœuds dans Azure Kubernetes Service (AKS).

Les pools de nœuds en mode système doivent contenir au moins un nœud, alors que les pools de nœuds en mode utilisateur peuvent contenir zéro, un ou plusieurs nœuds. Dans la mesure du possible, configurez un pool de nœuds en mode utilisateur pour effectuer une mise à l’échelle automatique et passer de

0àNnœuds. Vous pouvez configurer vos charges de travail de manière à ce qu'elles soient mises à l'échelle en dehors et en dedans à l'aide d'un Pod Autoscaler horizontal. Choisissez une mise à l’échelle automatique basée sur le processeur et la mémoire, ou utilisez la solution Kubernetes Event-driven Autoscaling (KEDA) pour baser la mise à l’échelle automatique sur les métriques d’un système externe comme Apache Kafka, RabbitMQ ou Azure Service Bus.Veillez à définir correctement les requêtes et limites de vos pods pour améliorer la densité d’application, et éviter d’affecter trop de ressources processeur et mémoire aux charges de travail. Observez la consommation moyenne et maximale des ressources processeur et mémoire en utilisant Prometheus ou Container Insights. Configurez de manière appropriée les limites et quotas de vos pods dans les manifestes YAML, les graphiques Helm et les manifestes Kustomize pour vos déploiements.

Avec des objets ResourceQuota, définissez les quotas de quantité totale de ressources mémoire et processeur pour tous les pods s’exécutant dans un espace de noms donné. L’utilisation systématique de quotas de ressources évite les problèmes de voisins bruyants, améliore la densité d’application, et diminue le nombre de nœuds d’agent et les coûts totaux. Utilisez également des objets LimitRange pour configurer les requêtes de ressources processeur et mémoire par défaut pour les pods d’un espace de noms.

Utilisez Container Instances pour le bursting.

Vos charges de travail AKS n’ont pas toujours besoin d’être exécutées en continu ; c’est le cas de certaines charges de travail dans des pools de nœuds d’un cluster de développement. Pour optimiser les coûts, vous pouvez arrêter complètement un cluster AKS, ou arrêter un ou plusieurs pools de nœuds dans le cluster AKS. Pour plus d’informations, consultez Arrêter et démarrer un cluster Azure Kubernetes Service (AKS) et Démarrer et arrêter un pool de nœuds sur Azure Kubernetes Service (AKS).

Azure Policy s’intègre à AKS par le biais de stratégies intégrées pour appliquer des mesures d’exécution et de protection centralisées, cohérentes et à grande échelle. Activez le module complémentaire Azure Policy sur votre cluster, et appliquez les requêtes et limites de ressources processeur par défaut ainsi que les limites de ressources mémoire, ce qui garantit que les limites de ressources processeur et mémoire sont définies sur les conteneurs de cluster.

Utilisez Azure Advisor pour superviser et libérer des ressources inutilisées.

Utilisez les budgets et analyses Microsoft Cost Management pour suivre les dépenses.

Gouvernance des coûts

Le cloud peut considérablement améliorer les performances techniques des charges de travail d’entreprise. Les technologies cloud peuvent également réduire le coût et la surcharge de gestion des ressources organisationnelles. Toutefois, cette opportunité engendre un risque pour l’entreprise en ce sens que les déploiements cloud peuvent potentiellement augmenter les gaspillages et les manques d’efficacité.

La gouvernance des coûts est le processus d’implémentation continue de stratégies ou de contrôles visant à limiter les dépenses et les coûts. Les outils Kubernetes natifs et les outils Azure prennent en charge la gouvernance des coûts avec une supervision proactive et une optimisation des coûts de l’infrastructure sous-jacente.

Microsoft Cost Management est une suite d’outils Microsoft qui vous aide à analyser, gérer et optimiser les coûts de vos charges de travail Azure. Utilisez la suite pour aider votre organisation à tirer pleinement parti des avantages du cloud.

Passez en revue les bonnes pratiques de gouvernance du Cloud Adoption Framework pour la discipline Gestion des coûts afin de mieux comprendre comment gérer et contrôler les coûts associés au cloud.

Explorez des outils open source comme KubeCost qui permettent de superviser et contrôler les coûts du cluster AKS. Vous pouvez étendre l’allocation des coûts à un déploiement, un service, une étiquette, un pod et un espace de noms, ce qui facilite l’affichage et la facturation des utilisateurs du cluster.

Documents de référence

Voici quelques documents de référence qui peuvent vous aider à mieux comprendre et utiliser l’analyse des coûts AKS :

- Analyse des coûts Azure Kubernetes Service

- Webinaire : Outils et astuces pour une transparence des coûts inégalée sur AKS

- Projet OpenCost sur GitHub

Contributeurs

Cet article est géré par Microsoft. Il a été écrit à l’origine par les contributeurs suivants.

Auteurs principaux :

- Paolo Salvatori | Ingénieur système principal

- Laura Nicolas | Architecte de solutions cloud

Autres contributeurs :

- Chad Kittel | Ingénieur logiciel principal

- Ed Price | Responsable de programme senior

- Theano Petersen | Rédacteur technique

Pour afficher les profils LinkedIn non publics, connectez-vous à LinkedIn.

Étapes suivantes

- AKS pour les professionnels Amazon EKS

- Gestion de l’identité et de l’accès Kubernetes

- Monitoring et journalisation Kubernetes

- Sécuriser l’accès réseau à Kubernetes

- Options de stockage pour un cluster Kubernetes

- Gestion des nœuds et des pools de nœuds Kubernetes

- Gouvernance des clusters