Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

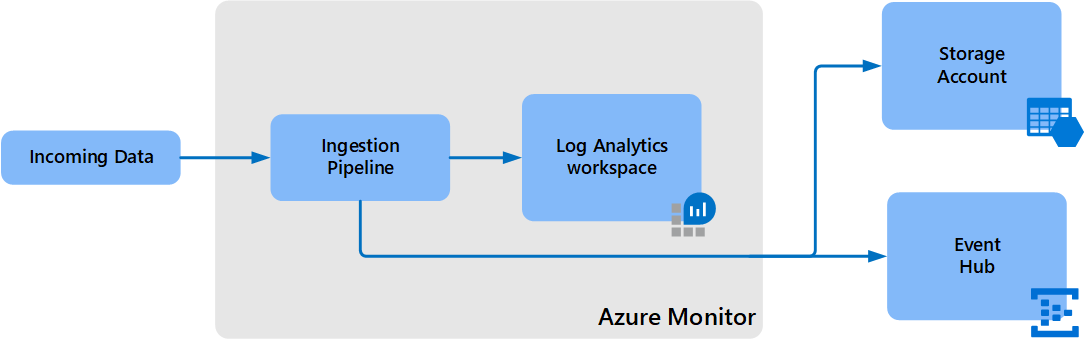

L’exportation de données vers un espace de travail Log Analytics vous permet d’exporter en continu les données de tables sélectionnées dans votre espace de travail. Vous pouvez exporter les données vers un compte Stockage Azure ou Azure Event Hubs à mesure qu’elles arrivent dans un pipeline Azure Monitor. Cet article fournit des informations détaillées sur cette fonctionnalité et les étapes à suivre pour configurer l’exportation de données dans vos espaces de travail.

Vue d’ensemble

Les données de Log Analytics sont disponibles pendant la période de conservation définie dans votre espace de travail. Elles sont utilisées dans différentes expériences fournies dans Azure Monitor et les services Azure. Dans certains cas, vous devez utiliser d’autres outils :

- Conformité du magasin protégé contre la falsification : les données ne peuvent pas être altérées dans Log Analytics après leur ingestion, mais elles peuvent être vidées. Exportez-les vers un compte de stockage défini avec des stratégies d’immuabilité pour les protéger contre la falsification de données.

- Intégration aux services Azure et à d’autres outils : exportez les données vers des hubs d’événements à mesure qu’elles arrivent et sont traitées dans Azure Monitor.

- Conservation à long terme des données d’audit et de sécurité : exportez les données vers un compte de stockage dans la région de l’espace de travail. Vous pouvez également répliquer les données vers d’autres régions en utilisant l’une des options de redondance du stockage Azure, notamment le stockage géoredondant (GRS) et le stockage géoredondant interzone (GZRS).

Une fois que vous avez configuré les règles d’exportation de données dans un espace de travail Log Analytics, les nouvelles données pour les tables dans les règles sont exportées du pipeline Azure Monitor vers votre compte de stockage ou vos hubs d’événements à mesure qu’elles arrivent. Le trafic d’exportation de données est dans le réseau principal Azure et ne quitte pas le réseau Azure.

Les données sont exportées sans filtre. Par exemple, quand vous configurez une règle d’exportation de données pour une table SecurityEvent, toutes les données envoyées à la table SecurityEvent sont exportées à compter de l’heure de configuration. Vous pouvez également filtrer ou modifier les données exportées en configurant des transformations dans votre espace de travail, qui sont appliquées aux données entrantes, avant que les données ne soient envoyées vers vos espaces de travail Log Analytics et aux destinations de l’exportation.

Autres options d’exportation

L’exportation des données d’espace de travail Log Analytics exporte en continu des données qui sont envoyées à votre espace de travail Log Analytics. Voici d’autres options d’exportation de données pour des scénarios particuliers :

- Si une ressource Azure envoie des journaux à votre espace de travail Log Analytics via ses paramètres de journal de diagnostic déjà, envisagez de mettre à jour les paramètres de diagnostic sur la ressource Azure directement pour ajouter la nouvelle destination au lieu d’utiliser régulièrement une exportation de données. Cette approche a une latence inférieure par rapport à une exportation de données, mais n’envoie pas de données historiques.

- Planifiez une exportation de données basée sur une requête de journal que vous définissez avec l’API de requête Log Analytics. Utilisez Azure Data Factory, Azure Functions ou Azure Logic Apps pour orchestrer les requêtes dans votre espace de travail et exporter les données vers une destination. Cette méthode est similaire à la fonctionnalité d’exportation de données, mais vous pouvez vous en servir pour exporter des données historiques à partir de votre espace de travail en utilisant des filtres et l’agrégation. Cette méthode est soumise aux limites de requêtes de journal et n’est pas destinée à la mise à l’échelle. Pour plus d’informations, consultez Exporter des données d’un espace de travail Log Analytics vers un compte de stockage en utilisant Logic Apps.

- Utilisez une exportation unique vers un ordinateur local à l’aide d’un script PowerShell. Pour plus d’informations, consultez Invoke-AzOperationalInsightsQueryExport.

Autorisations requises

| Action | Autorisations requises |

|---|---|

| Créer ou mettre à jour une règle d’exportation de données | Autorisations Microsoft.OperationalInsights/workspaces/dataexports/write d’accès aux espaces de travail Log Analytics, telles que fournies par le rôle intégré Contributeur Log Analytics, par exemple |

| Supprimer une règle d’exportation de données | Autorisations Microsoft.OperationalInsights/workspaces/dataexports/delete d’accès aux espaces de travail Log Analytics, telles que fournies par le rôle intégré Contributeur Log Analytics, par exemple |

| Exporter vers un compte de stockage | Autorisations Microsoft.Storage/storageAccounts/blobServices/containers/write pour le compte de stockage, telles qu’elles sont fournies par le rôle intégré Contributeur de comptes de stockage, par exemple |

| Exporter vers Event Hub | Autorisations Microsoft.EventHub/namespaces/eventhubs/write, Microsoft.EventHub/namespaces/eventhubs/messages/write, Microsoft.EventHub/namespaces/authorizationRules/listkeys/action pour l’Event Hub, telles qu’elles sont fournies par les rôles intégrés Propriétaire des données Azure Event Hubs, par exemple |

| Interroger les journaux d’activité dans une table | Autorisations Microsoft.OperationalInsights/workspaces/query/<table>/read d’accès aux espaces de travail Log Analytics, telles que fournies par le rôle intégré Lecteur Log Analytics, par exemple |

| Journaux d’activité de requête dans une table (action de table) | Autorisations Microsoft.OperationalInsights/workspaces/tables/query/read d’accès aux espaces de travail Log Analytics, telles que fournies par le rôle intégré Lecteur Log Analytics, par exemple |

Limites

- Les journaux personnalisés créés à l’aide de l’API Collecteur de données HTTP ne peuvent pas être exportés, y compris des journaux textuels consommés par l’agent Log Analytics. Vous pouvez exporter des journaux personnalisés créés à l’aide de règles de collecte de données, notamment des journaux textuels.

- L’exportation de données prend progressivement en charge davantage de tables. Consultez la section Tables non prises en charge .

- Le nombre maximal de règles actives par espace de travail est de 10, chacun peut inclure plusieurs tables.

- Le compte de stockage doit être unique dans les règles de l’espace de travail.

- Les plans de table pris en charge sont Analytique et Essentiel. Le plan Auxiliaire n’est pas pris en charge.

- Les destinations doivent se trouver dans la même région que l’espace de travail Log Analytics.

- L’exportation vers un compte Stockage Premium n’est pas prise en charge.

Exhaustivité des données

L’exportation de données est optimisée pour déplacer de grands volumes de données vers vos destinations. En cas de destination avec une échelle ou une disponibilité insuffisante, un processus de réessai continue pendant jusqu'à 12 heures et peut entraîner la duplication d'une fraction des enregistrements exportés. Suivez les recommandations relatives au compte de stockage et aux destinations Event Hubs pour améliorer la fiabilité. Si les destinations sont encore indisponibles après la période de nouvelle tentative, les données sont abandonnées.

Pour plus d’informations sur les limites de destination et les alertes recommandées, consultez Créer ou mettre à jour une règle d’exportation de données.

Modèle de tarification

Les frais d’exportation de données dépendent du nombre d’octets exportés vers les destinations sous forme de données JSON et sont mesurés en Go (10^9 octets). Les calculs de taille d’exportation de données ne peuvent pas être effectués avec une requête d’espace de travail, car le calcul de taille n’inclut pas la surcharge de mise en forme JSON. Utilisez la méthode de cet échantillon de script PowerShell pour calculer la taille de facturation totale d’un conteneur blob. Il n’y a actuellement aucuns frais pour l’exportation vers des clouds souverains. Une notification sera envoyée avant l’activation.

Pour plus d’informations, notamment la chronologie de facturation de l’exportation de données, consultez la tarification d’Azure Monitor. La facturation de l’exportation de données a été activée au début du mois d’octobre 2023.

Destinations d’exportation

La destination d’exportation des données doit être disponible avant la création de règles d’exportation dans votre espace de travail. Les destinations peuvent se trouver dans différents abonnements. Avec Azure Lighthouse, il est également possible d’envoyer des données à des destinations dans un autre client Microsoft Entra.

Compte de stockage

Empêchez les échecs d’entrée de stockage en raison d’une latence ou d’un dépassement des limites de débit à l’aide d’un compte de stockage existant qui n’a pas d’autres données de non-surveillance. Cela vous permet de mieux contrôler l’accès aux données et d’améliorer la fiabilité de l’exportation des données.

Pour envoyer des données à un compte de stockage immuable, définissez la stratégie d’immuabilité du compte de stockage comme décrit dans Définir et gérer des stratégies d’immuabilité pour le Stockage Blob Azure. Vous devez suivre toutes les étapes décrites dans cet article, y compris l’activation des écritures protégées pour l’ajout de blobs.

Le compte de stockage ne peut pas être Premium, doit être StorageV1 ou ultérieur et se trouver dans la même région que votre espace de travail. Si vous devez répliquer vos données vers d’autres comptes de stockage dans d’autres régions, utilisez l’une des options de redondance stockage Azure, notamment GRS et GZRS.

Les données sont envoyées aux comptes de stockage dès qu’elles atteignent Azure Monitor et exportées vers des destinations situées dans une région de l’espace de travail. Un conteneur est créé pour chaque table du compte de stockage portant le nom am- suivi du nom de la table. Par exemple, la table SecurityEvent est envoyée à un conteneur nommé am-SecurityEvent.

Les blobs sont stockés dans des dossiers de cinq minutes selon la structure de chemin d’accès suivante : WorkspaceResourceId=/subscriptions/subscription-id/resourcegroups/<resource-group>/providers/microsoft.operationalinsights/workspaces/<workspace>/y=<four-digit numeric year>/m=<two-digit numeric month>/d=<two-digit numeric day>/h=<two-digit 24-hour clock hour>/m=<two-digit 60-minute clock minute>/PT05M.json. Les ajouts aux blobs sont limités à 50 000 écritures. D’autres blobs seront ajoutés dans le dossier sous la forme PT05M_#.json*, où « # » est le numéro de blob incrémentiel.

Notes

Les ajouts aux objets blob sont écrits en fonction du champ « TimeGenerated » et se déclenchent lors de la réception des données sources. Les données arrivant dans Azure Monitor avec un délai ou à partir d’une nouvelle tentative après la limitation des destinations sont écrites dans les objets blob en fonction de leur TimeGenerated.

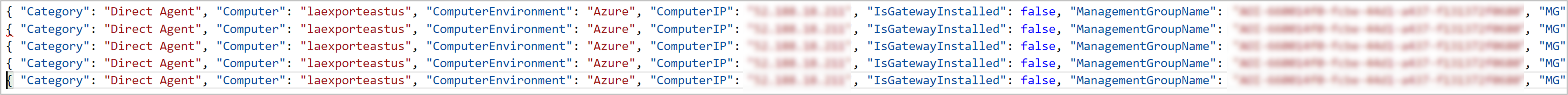

Le format des blobs du compte de stockage est en lignes JSON, où chaque enregistrement est délimité par un caractère de nouvelle ligne, sans tableau d’enregistrements extérieur ni virgule entre les enregistrements JSON.

Event Hubs

Évitez d’utiliser un Hub d’événements qui possède des données existantes et non de surveillance. Cette bonne pratique permet d’éviter les défaillances d’entrée en raison d’une latence ou d’un dépassement des limites de débit.

Les données sont envoyées à votre hub d’événements quand elles arrivent à Azure Monitor et sont exportées vers des destinations situées dans une région de l’espace de travail. Créez plusieurs règles d’exportation vers le même espace de noms Event Hub en fournissant un Event Hub name différent dans la règle. Quand aucun Event Hub name n’est fourni, un hub d’événements par défaut est créé pour les tables que vous exportez, avec le nom am- suivi du nom de la table. Par exemple, la table SecurityEvent est envoyée à un hub d’événements nommé am-SecurityEvent.

Le nombre de hubs d’événements pris en charge dans les niveaux d’espace de noms « De base » et « Standard » est de 10. Quand vous exportez plus de 10 tables vers ces niveaux, répartissez les tables entre plusieurs règles d’exportation vers différents espaces de noms du hub d’événements ou indiquez un nom de hub d’événements pour y exporter toutes les tables.

Notes

- Le niveau d’espace de noms Event Hubs « De base » est limité. Il prend en charge des événements de taille inférieure et ne dispose pas de l’option Majoration automatique pour effectuer un scale-up et augmenter le nombre d’unités de débit automatiquement. Étant donné que le volume de données de votre espace de travail augmente au fil du temps et qu’une mise à l’échelle conséquente du hub d’événements est nécessaire, utilisez les niveaux pour le hub d’événements « Standard », « Premium » ou « Dedicated » avec la fonctionnalité Majoration automatique activée. Pour plus d’informations, consultez Effectuer automatiquement un scale-up des unités de débit Azure Event Hubs.

- L’exportation de données ne peut pas atteindre les ressources Event Hubs quand des réseaux virtuels sont activés. Vous devez cocher la case Autoriser les services Azure figurant dans la liste des services approuvés à accéder à ce compte de stockage pour contourner ce paramètre de pare-feu dans un hub d’événements afin d’accorder l’accès à vos hubs d’événements.

Interroger les données exportées

L’exportation de données depuis les espaces de travail vers des comptes de stockage permet de répondre aux différents scénarios mentionnés dans la vue d’ensemble et peut être consommée par des outils capables de lire les objets blob depuis les comptes de stockage. Les méthodes suivantes vous permettent d’interroger des données au moyen du langage de requête Log Analytics qui est le même pour Azure Data Explorer.

- Utiliser Azure Data Explorer pour interroger des données dans Azure Data Lake.

- Utiliser Azure Data Explorer pour ingérer des données depuis un Compte de stockage.

- Utiliser l’espace de travail Log Analytics pour interroger les données ingérées avec l’API d’ingestion des journaux. Les données ingérées sont envoyées à une table de journal personnalisée et non à la table d’origine.

Activer l’exportation de données

Les étapes suivantes doivent être effectuées pour permettre l’exportation de données Log Analytics.

- Inscrire le fournisseur de ressources

- Autoriser les services Microsoft approuvés

- Surveiller les destinations (Recommandé)

- Créer ou mettre à jour une règle d’exportation de données

Inscrire le fournisseur de ressources

Le fournisseur de ressources Azure Microsoft.Insights doit être inscrit dans votre abonnement pour permettre l’exportation de données Log Analytics.

Ce fournisseur de ressources est probablement déjà inscrit pour la plupart des utilisateurs d’Azure Monitor. Pour vérifier, accédez à Abonnements dans le Portail Azure. Sélectionnez votre abonnement, puis Fournisseurs de ressources sous la section Paramètres du menu. Recherchez Microsoft.Insights. Si son état est Inscrit, il est déjà inscrit. Si ce n’est pas le cas, sélectionnez Inscrire pour l’inscrire.

Vous pouvez également utiliser une des méthodes disponibles pour inscrire un fournisseur de ressources, comme décrit dans Fournisseurs et types de ressources Azure. L’exemple de commande suivant utilise Azure CLI :

az provider register --namespace 'Microsoft.insights'

L’exemple de commande suivant utilise PowerShell :

Register-AzResourceProvider -ProviderNamespace Microsoft.insights

Autoriser les services Microsoft approuvés

Si vous avez configuré votre compte de stockage pour autoriser l’accès à partir de réseaux sélectionnés, vous devez ajouter une exception afin d’autoriser Azure Monitor à écrire dans le compte. Dans Pare-feux et réseaux virtuels pour votre compte de stockage, sélectionnez Autoriser les services Azure figurant dans la liste des services approuvés à accéder à ce compte de stockage.

Monitorer les destinations

Important

Les destinations d’exportation ont des limites et doivent être surveillées pour réduire la limitation de bande passante, les défaillances et la latence. Pour plus d’informations, consultez Scalabilité du compte de stockage et Quotas d’espace de noms de hub d’événements.

Les métriques suivantes sont disponibles pour les opérations d'exportation de données et les alertes

| Nom de métrique | Descriptif |

|---|---|

| Octets exportés | Nombre total d'octets exportés vers la destination à partir de l'espace de travail Log Analytics au cours de la plage de temps sélectionnée. La taille des données exportées est le nombre d’octets dans les données au format JSON exportées. 1 Go = 10^9 octets. |

| Échecs d’exportation | Nombre total des demandes d’exportation ayant échoué à atteindre la destination depuis l’espace de travail Log Analytics au cours de l’intervalle de temps sélectionné. Ce nombre comprend les échecs de tentative d’exportation en raison de la limitation des ressources de destination, d’une erreur d’accès interdit ou d’une erreur de serveur quelle qu’elle soit. Un processus de nouvelle tentative gère les tentatives ayant échoué et le nombre n’indique pas les données manquantes. |

| Enregistrements exportés | Nombre total d'enregistrements exportés depuis l'espace de travail Log Analytics au cours de la plage de temps sélectionnée. Ce nombre compte les enregistrements des opérations qui se sont terminées avec succès. |

Surveiller un compte de stockage

Utilisez un compte de stockage distinct pour l’exportation.

Configurez une alerte sur la métrique :

Étendue Espace de noms de la métrique Métrique Agrégation Seuil nom-de-stockage Compte Entrée Somme 80 % de l’entrée maximale par période d’évaluation des alertes. Par exemple, la limite est de 60 Gbit/s pour v2 universel dans la région USA Ouest. Le seuil d’alerte est de 1 676 Gio par période d’évaluation de 5 minutes. Actions de correction des alertes :

- Utilisez un compte de stockage distinct pour l’exportation, qui n’est pas partagé avec des données non liées au monitoring.

- Les comptes standard Stockage Azure prennent en charge une limite d’entrée supérieure par demande. Pour demander une augmentation, contactez le Support Azure.

- Répartissez les tables sur plusieurs comptes de stockage.

Monitorer les hubs d’événements

Configurez des alertes sur les métriques :

Étendue Espace de noms de la métrique Métrique Agrégation Seuil namespaces-name Métriques standard d’Event Hubs Octets entrants Somme 80 % de l’entrée maximale par période d’évaluation des alertes. Par exemple, la limite est de 1 Mo/s par unité (TU ou PU) et de 5 unités utilisées. Le seuil est de 228 Mio par période d’évaluation de 5 minutes. namespaces-name Métriques standard d’Event Hubs Requêtes entrantes Nombre 80 % du nombre maximal d’événements par période d’évaluation des alertes. Par exemple, la limite est de 1 000/s par unité (TU ou PU) et de cinq unités utilisées. Le seuil est de 1 200 000 par période d’évaluation de 5 minutes. namespaces-name Métriques standard d’Event Hubs Erreurs de dépassement de quota Nombre 1% de la demande. Par exemple, les demandes par 5 minutes sont au nombre de 600 000. Le seuil est de 6 000 par période d’évaluation de 5 minutes. Actions de correction des alertes :

- Utiliser un espace de noms Event Hubs distinct pour l’exportation qui n’est pas partagé avec des données non liées au monitoring.

- Configurer la fonctionnalité Majoration automatique pour effectuer un scale-up et augmenter le nombre d’unités de débit automatiquement afin de répondre aux besoins d’utilisation.

- Vérifier l’augmentation des unités de débit pour répondre au volume de données.

- Répartir les tables entre davantage d’espaces de noms.

- Utiliser des niveaux « Premium » ou « Dédié » pour un débit plus élevé.

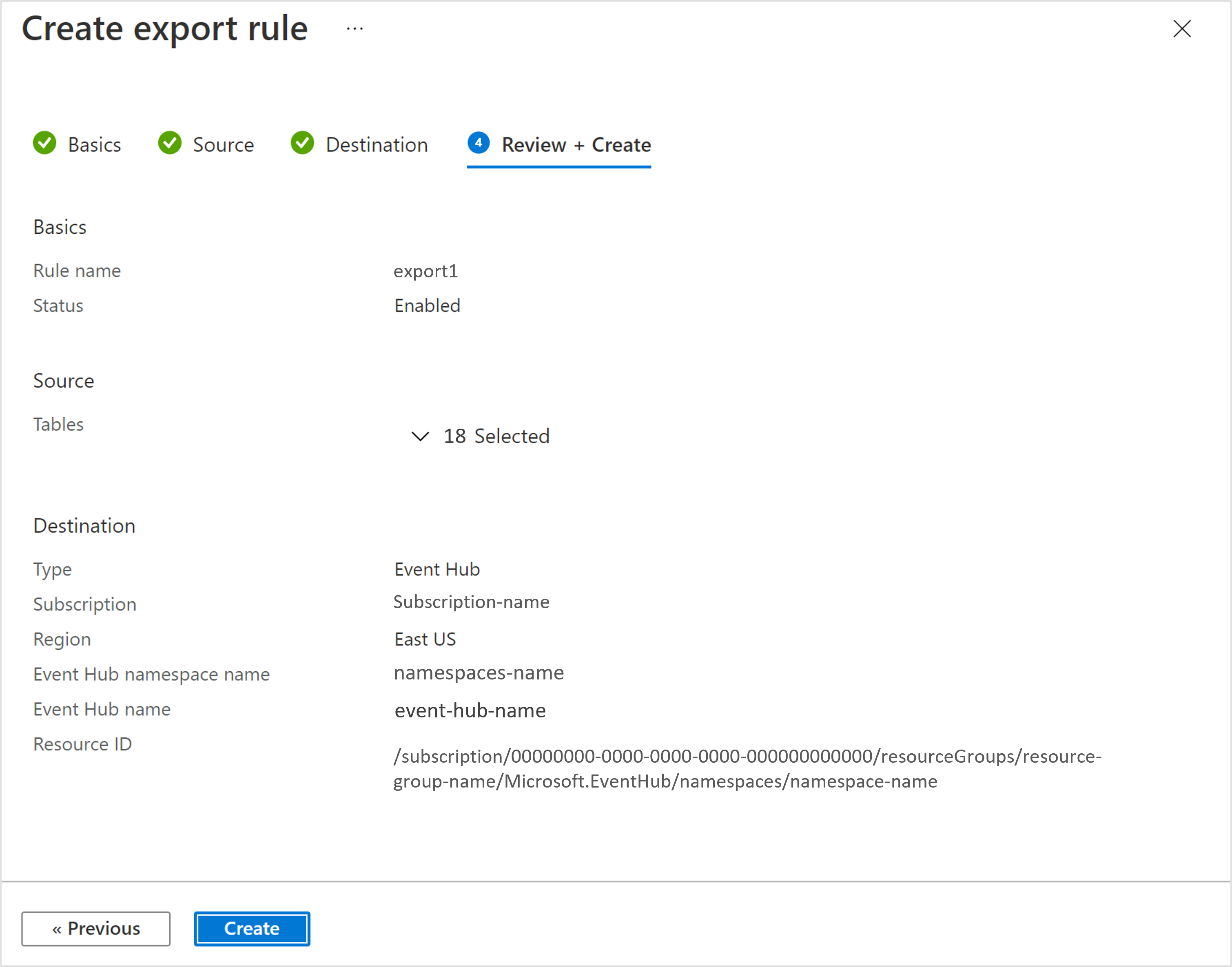

Créer ou mettre à jour une règle d’exportation de données

Une règle d’exportation de données définit la destination et les tables pour lesquelles les données sont exportées. L’approvisionnement de règles prend environ 30 minutes, puis l’opération d’exportation est lancée. Considérations relatives aux règles d’exportation de données :

- Le compte de stockage doit être unique dans les règles de l’espace de travail.

- Plusieurs règles peuvent utiliser le même espace de noms de hub d’événements quand vous envoyez des données vers des hubs d’événements distincts.

- Exporter vers un compte de stockage : un conteneur distinct est créé dans le compte de stockage pour chaque table.

- Exporter vers des hubs d’événements : si aucun nom de hub d’événements n’est fourni, un hub d’événements distinct est créé pour chaque table. Le nombre de hubs d’événements pris en charge dans les niveaux d’espace de noms « De base » et « Standard » est de 10. Quand vous exportez plus de 10 tables vers ces niveaux, répartissez les tables entre plusieurs règles d’exportation vers différents espaces de noms de hub d’événements ou indiquez un nom de hub d’événements dans la règle pour y exporter toutes les tables.

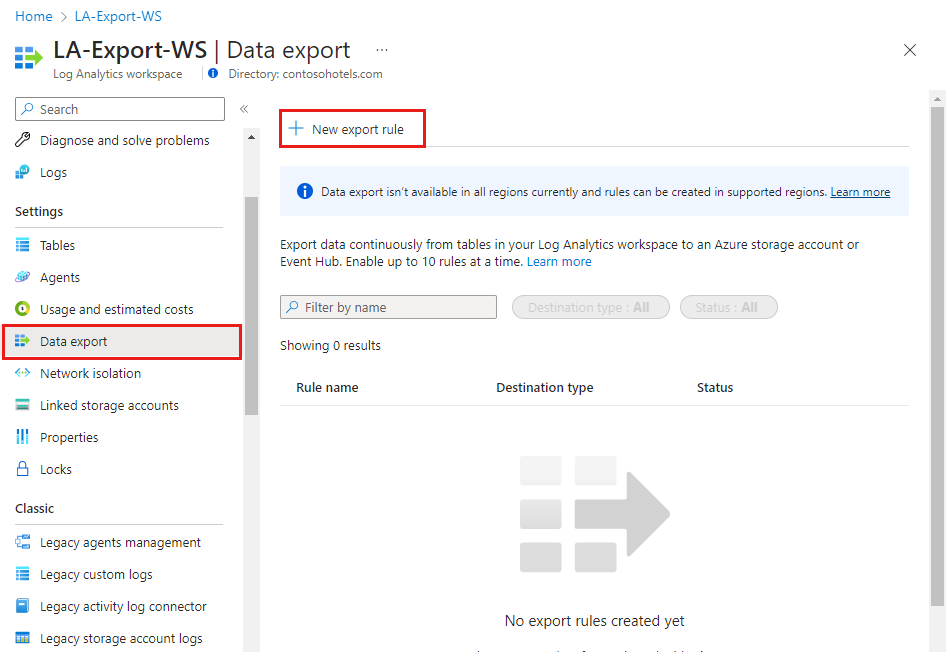

Dans le menu Espace de travail Log Analytics du portail Azure, sélectionnez Exportation de données sous la section Paramètres. Sélectionnez Nouvelle règle d’exportation en haut du volet.

Suivez les étapes, puis sélectionnez Créer. Seules les tables contenant des données sont affichées sous l’onglet « Source ».

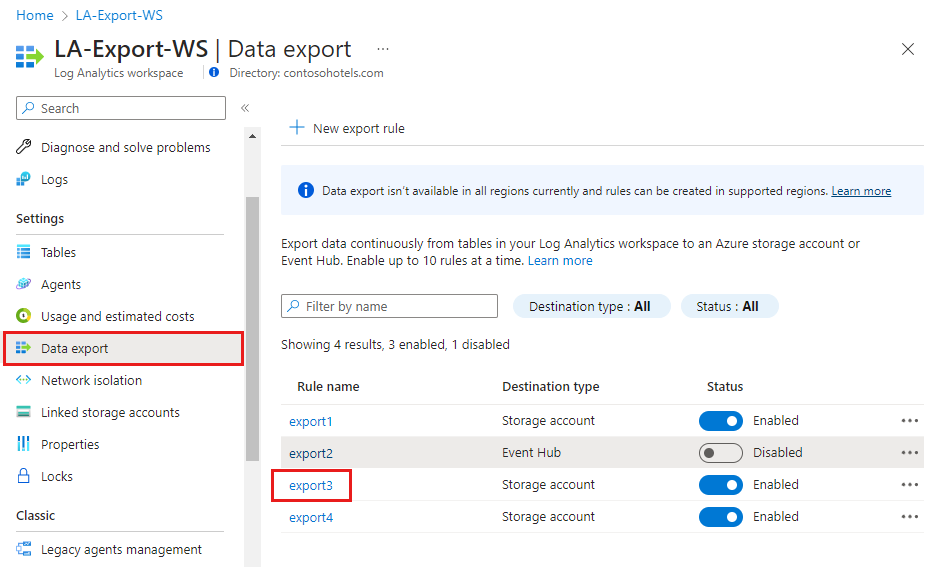

Afficher la configuration de règle d’exportation de données

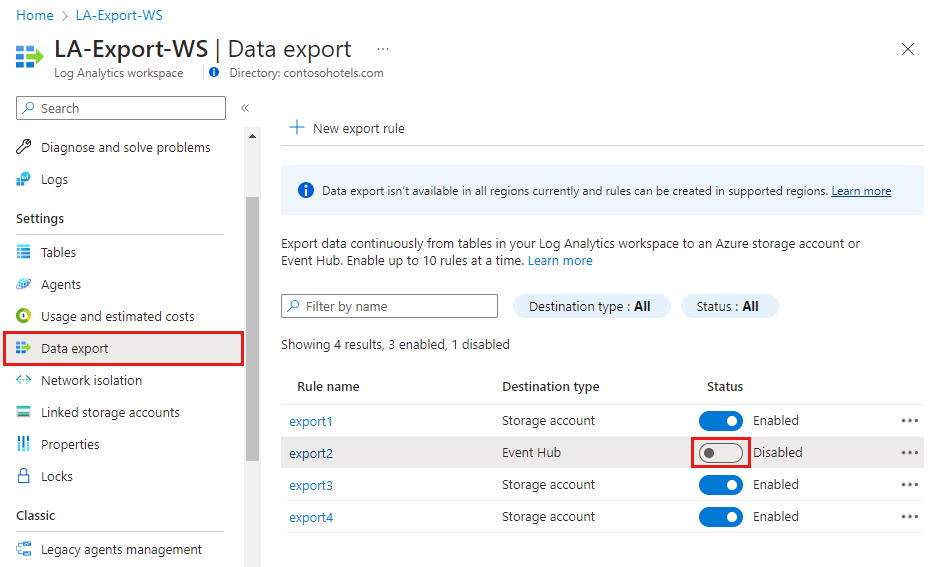

Désactiver ou mettre à jour une règle d’exportation

Vous pouvez désactiver les règles d’exportation pour arrêter l’exportation pendant une certaine période, par exemple lors de tests. Dans le menu Espace de travail Log Analytics du portail Azure, sélectionnez Exportation de données sous la section Paramètres. Sélectionnez le bouton bascule État pour désactiver ou activer la règle d’exportation.

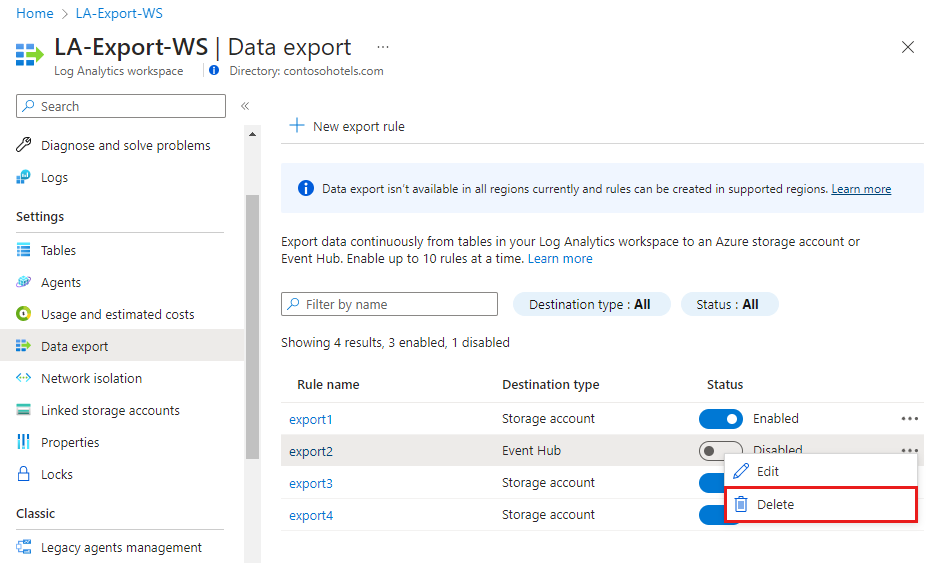

Supprimer une règle d’exportation

Dans le menu Espace de travail Log Analytics du portail Azure, sélectionnez Exportation de données sous la section Paramètres. Sélectionnez les points de suspension à droite de la règle, puis sélectionnez Supprimer.

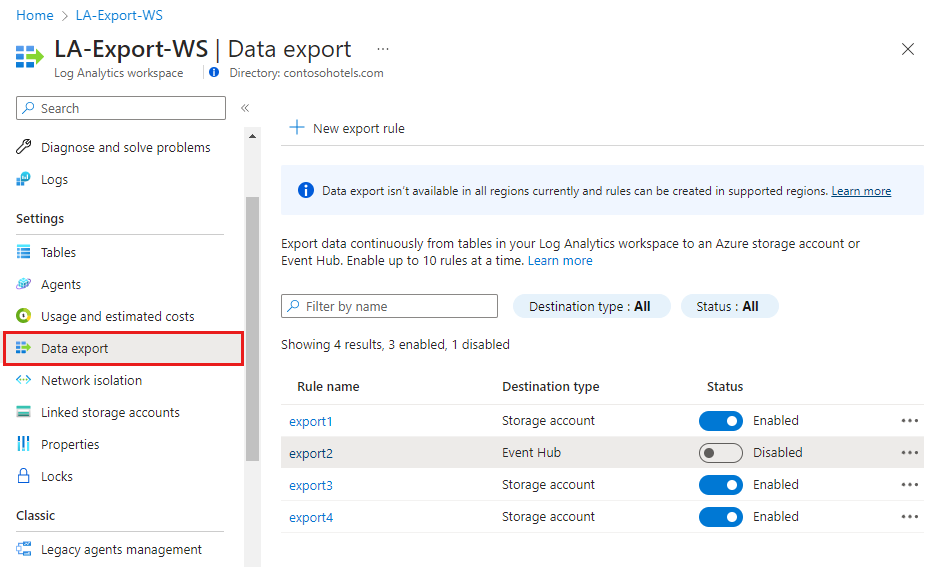

Afficher toutes les règles d’exportation de données dans un espace de travail

Dans le menu Espace de travail Log Analytics du portail Azure, sélectionnez Exportation de données sous la section Paramètres pour afficher toutes les règles d’exportation dans l’espace de travail.

Tables non prises en charge

Notes

Si la règle d’exportation de données comprend une table non prise en charge, la configuration échoue, mais aucune donnée n’est exportée pour cette table. Lorsque la table est prise en charge, l’exportation de données démarre alors. Nous sommes en train d’ajouter la prise en charge d’autres tables. N’hésitez pas à consulter cet article régulièrement.

| Tableau | Limites |

|---|---|

| ADXDataOperation | |

| Alerte | Prise en charge partielle. L’ingestion des données pour les alertes Zabbix n’est pas prise en charge. |

| Historique des Alertes | |

| AzureActivity | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| AzureDiagnostics | |

| AzureMetrics | |

| Changement de configuration | |

| Données de configuration | Prise en charge partielle. Certaines données sont ingérées par le biais de services internes qui ne sont pas pris en charge dans l’exportation. Cette partie est actuellement manquante dans l’exportation. |

| DatabricksDatabricksSQL | |

| DatabricksSQL | |

| DeviceAppLaunch | |

| Calendrier de l'appareil | |

| DeviceConnectSession | |

| DeviceEtw | |

| DeviceHealth | |

| DeviceHeartbeat | |

| ETWEvent | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| Événement | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| InsightsMetrics | Prise en charge partielle. Certaines données sont ingérées par le biais de services internes qui ne sont pas pris en charge dans l’exportation. Cette partie est actuellement manquante dans l’exportation. |

| Sessions de Réseau | |

| Opération | Prise en charge partielle. Certaines données sont ingérées par le biais de services internes qui ne sont pas pris en charge dans l’exportation. Cette partie est actuellement manquante dans l’exportation. |

| ProtectionStatus | |

| Événement Opérationnel ServiceFabric | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| ServiceFabricReliableActorEvent | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| ServiceFabricReliableServiceEvent | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| Mise à jour | Prise en charge partielle. Certaines données sont ingérées par le biais de services internes qui ne sont pas pris en charge dans l’exportation. Cette partie est actuellement manquante dans l’exportation. |

| VMBoundPort | |

| VMComputer | |

| VMConnection | |

| VMProcess | |

| W3CIISLog | Prise en charge partielle. Les données provenant de l’agent Log Analytics ou de l’agent Azure Monitor sont entièrement prises en charge dans l’exportation. Les données arrivant via l’agent d’extension Diagnostics sont collectées par le biais du stockage. Ce chemin n’est pas pris en charge dans l’exportation. |

| WireData | Prise en charge partielle. Certaines données sont ingérées par le biais de services internes qui ne sont pas pris en charge dans l’exportation. Cette partie est actuellement manquante dans l’exportation. |

Étapes suivantes

Interroger les données exportées à partir d’Azure Data Explorer