Adoptez des principes d’IA responsable et de confiance

Les six principes clés de l’IA responsable chez Microsoft incluent l’équité, la fiabilité et la sécurité, la confidentialité et la sécurité, l’inclusivité, la transparence et la responsabilité. Utilisez ces principes pour créer une IA responsable et digne de confiance à mesure que vous l’intégrez dans les produits et services grand public tout au long de votre parcours d’adoption de l’IA.

Principes de l’IA responsable

Microsoft s’engage à promouvoir les pratiques d’IA responsable.

Six principes clés définissent l’IA responsable :

Équité : Les systèmes d’IA doivent traiter tout le monde de manière égale et fournir les mêmes recommandations à tous les individus. L’équité dans les systèmes d’IA empêche la discrimination basée sur des caractéristiques personnelles.

Fiabilité et sécurité : Les systèmes d’IA doivent fonctionner de manière fiable, en toute sécurité et de manière cohérente dans diverses conditions pour aider à instaurer la confiance.

Confidentialité et sécurité : Les systèmes d’IA doivent respecter la confidentialité et maintenir la sécurité en protégeant les informations privées et confidentielles. Ils doivent également résister aux attaques et aux tentatives de corruption ou de compromission du système.

Inclusivité : Les systèmes d’IA doivent responsabiliser et impliquer tout le monde. Les pratiques de conception inclusive peuvent aider les développeurs de systèmes d’IA à comprendre et à résoudre les obstacles potentiels à l’exclusion dans un produit ou un service. L’inclusivité favorise l’innovation et aide à concevoir des expériences qui bénéficient à tous.

Transparence : Les systèmes d’IA doivent être transparents et compréhensibles. Les systèmes d’IA peuvent éclairer des décisions qui peuvent profondément affecter la vie des gens, il est donc crucial que les individus comprennent comment le système prend ces décisions.

Responsabilité : Les systèmes d’IA et leurs développeurs doivent être responsables et redevables.

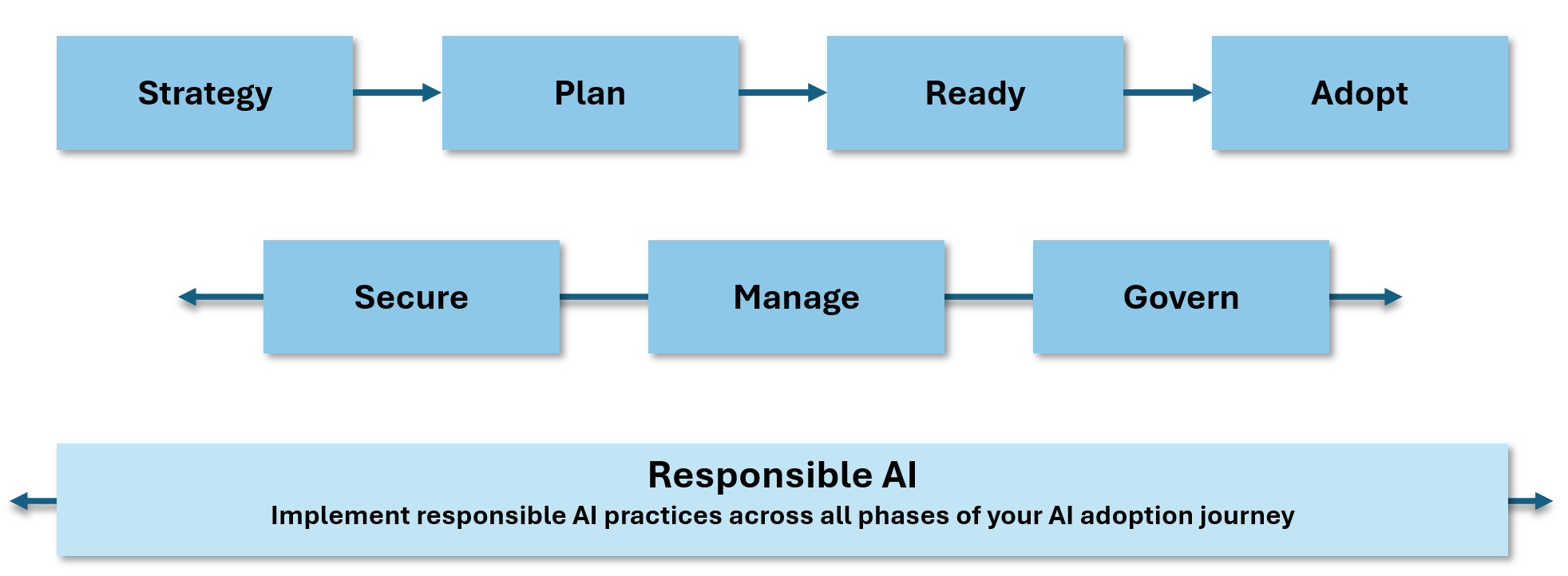

Incorporez les principes de l’IA responsable tout au long de votre parcours d’adoption de l’IA, de la stratégie et de la planification à la mise en œuvre. Assurez-vous d’appliquer ces principes lorsque vous sécurisez, gérez et gouvernez vos initiatives d’IA.

Ces conseils d’adoption de l’IA incluent des exemples de la manière dont vous pouvez utiliser le Cloud Adoption Framework pour Azure afin de mettre en œuvre des pratiques d’IA responsable. Les principes de l’IA responsable sont intégrés dans les directives et recommandations tout au long de ce parcours d’adoption de l’IA.

L’importance de l’IA responsable

L’IA responsable aide à atténuer les risques suivants :

Conséquences involontaires : Planifiez et supervisez votre mise en œuvre de l’IA responsable pour réduire le risque d’effets imprévus ayant des implications éthiques.

Menaces évolutives : De nouvelles menaces apparaissent régulièrement à mesure que la technologie de l’IA évolue. Pour aider à atténuer et à anticiper ces menaces, respectez les principes de l’IA responsable.

Biais : L’atténuation des biais dans l’IA peut être un défi mais est nécessaire pour garantir que les systèmes d’IA sont justes et impartiaux. Utilisez les principes de l’IA responsable pour vous guider.

Technologies sensibles : Des technologies comme la reconnaissance faciale peuvent être considérées comme des technologies sensibles en raison des risques qu’elles présentent pour les libertés fondamentales et les droits humains. Tenez compte des implications de ces technologies pour vous assurer que vous les utilisez de manière responsable.

Facilitation via Azure

Microsoft Azure propose une gamme d’outils, de services et de ressources pour vous aider à créer des systèmes d’IA responsable.

Utilisez Microsoft Azure AI Content Safety pour créer des systèmes sûrs

Utilisez Microsoft Azure AI Content Safety pour détecter les contenus générés par les utilisateurs et les IA potentiellement nuisibles dans les applications et services. Content Safety vous aide à analyser le contenu généré dans vos applications d’IA, y compris les textes et les images, pour garantir qu’il est sûr et approprié pour vos utilisateurs. Content Safety fournit les fonctionnalités suivantes :

Prompt shields scanne les textes et documents pour évaluer le risque d’une attaque d’entrée utilisateur, ou d’une évasion, sur un grand modèle de langage (LLM).

Détection d’ancrage détecte si les réponses textuelles d’un LLM sont ancrées dans les documents sources fournis par les utilisateurs.

Détection de matériel protégé identifie si les réponses textuelles d’un LLM contiennent du matériel protégé, comme des textes sous copyright, des paroles de chansons, des articles et des contenus web.

L’API Custom Categories (rapid) définit des modèles émergents de contenu nuisible et scanne les textes et images à la recherche de correspondances.

L’API Analyze Text analyse le contenu textuel potentiellement nuisible. Elle identifie généralement des catégories telles que la haine, l’auto-mutilation, et le contenu sexuel ou violent.

L’API Analyze Image analyse le contenu d’image potentiellement nuisible. Elle identifie généralement des catégories telles que la haine, l’auto-mutilation, et le contenu sexuel ou violent.

Utilisez l’IA de manière responsable dans les services Azure AI

Microsoft propose une liste de notes de transparence pour les services Azure pertinents en matière d’IA. La liste inclut des services au sein de la suite des services Azure AI. Pour plus d’informations, veuillez consulter la section Utilisation responsable de l’IA avec les services Azure AI.

Utilisez le tableau de bord d’IA responsable pour Azure Machine Learning

Si vous créez des systèmes avec Azure Machine Learning, vous pouvez utiliser le tableau de bord d’IA responsable pour évaluer vos systèmes d’IA. Le tableau de bord d’IA responsable fournit une interface unique pour vous aider à mettre en œuvre les principes de l’IA responsable. Certaines des fonctionnalités de l’IA responsable incluent :

Analyse des données : Comprenez et explorez les distributions de vos ensembles de données et leurs statistiques.

Vue d’ensemble du modèle et évaluation de l’équité : Évaluez les performances de votre modèle et les problèmes d’équité de groupe de votre modèle.

Analyse des erreurs : Visualisez et comprenez comment les erreurs sont réparties dans votre ensemble de données.

Interprétabilité du modèle : Comprenez les prédictions de votre modèle et comment il génère des prédictions individuelles et globales.

Analyse contrefactuelle d’hypothèses : Observez comment les modifications des caractéristiques peuvent affecter les prédictions de votre modèle.

Analyse causale : Utilisez des données historiques pour visualiser les effets causaux des caractéristiques de traitement sur les résultats réels.

Développez l’IA de manière responsable

| Ressource | Description |

|---|---|

| Outils pratiques pour construire des expériences humain-IA efficaces (HAXs) | Utilisez le HAX Toolkit dès le début de votre processus de conception pour vous aider à conceptualiser ce que fait le système d’IA et comment il se comporte. Utilisez le HAX Toolkit pour les produits d’IA destinés aux utilisateurs finaux. |

| Instructions pour l’IA conversationnelle | Concevez des bots de manière à gagner la confiance des autres pour aider les personnes et la société à réaliser leur plein potentiel. Utilisez ces lignes directrices pour créer un bot qui inspire confiance dans l’entreprise et le service qu’il représente. |

| Directives de conception d’IA inclusive | Utilisez ces directives pour vous aider à concevoir une IA qui soit inclusive et accessible à tous. |

| Liste de contrôle d’équité de l’IA | Utilisez la checklist d’équité de l’IA pour déterminer si votre système d’IA est juste et impartial. |

| IA responsable dans le Machine Learning | Consultez ces ressources sur l’IA responsable si vous utilisez le Machine Learning pour construire des systèmes d’IA. |