Démarrage rapide : Créer une fabrique de données Azure à l’aide d’un modèle ARM

S’APPLIQUE À :  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Ce démarrage rapide décrit comment utiliser un modèle Azure Resource Manager (modèle ARM) pour créer une fabrique de données Azure. Le pipeline que vous créez dans cette fabrique de données copie les données d’un dossier vers un autre dossier dans un stockage Blob Azure. Pour suivre un tutoriel sur la transformation des données à l’aide d’Azure Data Factory, consultez Tutoriel : Transformer des données à l’aide de Spark.

Un modèle Azure Resource Manager est un fichier JSON (JavaScript Object Notation) qui définit l’infrastructure et la configuration de votre projet. Le modèle utilise la syntaxe déclarative. Vous décrivez votre déploiement prévu sans écrire la séquence de commandes de programmation pour créer le déploiement.

Remarque

Cet article ne fournit pas de présentation détaillée du service Data Factory. Pour une présentation du service Azure Data Factory, consultez Présentation d’Azure Data Factory.

Si votre environnement remplit les prérequis et que vous êtes déjà familiarisé avec l’utilisation des modèles ARM, sélectionnez le bouton Déployer sur Azure. Le modèle s’ouvre dans le portail Azure.

Prérequis

Abonnement Azure

Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer.

Créer un fichier

Ouvrez un éditeur de texte tel que Bloc-notes, puis créez un fichier nommé emp.txt avec le contenu suivant :

John, Doe

Jane, Doe

Enregistrez-le dans le dossier C:\ADFv2QuickStartPSH (si le dossier n’existe pas, créez-le).

Vérifier le modèle

Le modèle utilisé dans ce démarrage rapide est tiré des modèles de démarrage rapide Azure.

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"metadata": {

"_generator": {

"name": "bicep",

"version": "0.26.54.24096",

"templateHash": "17339534711754973978"

}

},

"parameters": {

"dataFactoryName": {

"type": "string",

"defaultValue": "[format('datafactory{0}', uniqueString(resourceGroup().id))]",

"metadata": {

"description": "Data Factory Name"

}

},

"location": {

"type": "string",

"defaultValue": "[resourceGroup().location]",

"metadata": {

"description": "Location of the data factory."

}

},

"storageAccountName": {

"type": "string",

"defaultValue": "[format('storage{0}', uniqueString(resourceGroup().id))]",

"metadata": {

"description": "Name of the Azure storage account that contains the input/output data."

}

},

"blobContainerName": {

"type": "string",

"defaultValue": "[format('blob{0}', uniqueString(resourceGroup().id))]",

"metadata": {

"description": "Name of the blob container in the Azure Storage account."

}

}

},

"variables": {

"dataFactoryLinkedServiceName": "ArmtemplateStorageLinkedService",

"dataFactoryDataSetInName": "ArmtemplateTestDatasetIn",

"dataFactoryDataSetOutName": "ArmtemplateTestDatasetOut",

"pipelineName": "ArmtemplateSampleCopyPipeline"

},

"resources": [

{

"type": "Microsoft.Storage/storageAccounts/blobServices",

"apiVersion": "2023-01-01",

"name": "[format('{0}/{1}', parameters('storageAccountName'), 'default')]",

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts', parameters('storageAccountName'))]"

]

},

{

"type": "Microsoft.Storage/storageAccounts",

"apiVersion": "2023-01-01",

"name": "[parameters('storageAccountName')]",

"location": "[parameters('location')]",

"sku": {

"name": "Standard_LRS"

},

"kind": "StorageV2",

"properties": {

"minimumTlsVersion": "TLS1_2",

"supportsHttpsTrafficOnly": true,

"allowBlobPublicAccess": false

}

},

{

"type": "Microsoft.Storage/storageAccounts/blobServices/containers",

"apiVersion": "2023-01-01",

"name": "[format('{0}/{1}/{2}', parameters('storageAccountName'), 'default', parameters('blobContainerName'))]",

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts/blobServices', parameters('storageAccountName'), 'default')]"

]

},

{

"type": "Microsoft.DataFactory/factories",

"apiVersion": "2018-06-01",

"name": "[parameters('dataFactoryName')]",

"location": "[parameters('location')]",

"identity": {

"type": "SystemAssigned"

}

},

{

"type": "Microsoft.DataFactory/factories/linkedservices",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('dataFactoryLinkedServiceName'))]",

"properties": {

"type": "AzureBlobStorage",

"typeProperties": {

"connectionString": "[format('DefaultEndpointsProtocol=https;AccountName={0};AccountKey={1}', parameters('storageAccountName'), listKeys(resourceId('Microsoft.Storage/storageAccounts', parameters('storageAccountName')), '2023-01-01').keys[0].value)]"

}

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.Storage/storageAccounts', parameters('storageAccountName'))]"

]

},

{

"type": "Microsoft.DataFactory/factories/datasets",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('dataFactoryDataSetInName'))]",

"properties": {

"linkedServiceName": {

"referenceName": "[variables('dataFactoryLinkedServiceName')]",

"type": "LinkedServiceReference"

},

"type": "Binary",

"typeProperties": {

"location": {

"type": "AzureBlobStorageLocation",

"container": "[parameters('blobContainerName')]",

"folderPath": "input",

"fileName": "emp.txt"

}

}

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.DataFactory/factories/linkedservices', parameters('dataFactoryName'), variables('dataFactoryLinkedServiceName'))]"

]

},

{

"type": "Microsoft.DataFactory/factories/datasets",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('dataFactoryDataSetOutName'))]",

"properties": {

"linkedServiceName": {

"referenceName": "[variables('dataFactoryLinkedServiceName')]",

"type": "LinkedServiceReference"

},

"type": "Binary",

"typeProperties": {

"location": {

"type": "AzureBlobStorageLocation",

"container": "[parameters('blobContainerName')]",

"folderPath": "output"

}

}

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.DataFactory/factories/linkedservices', parameters('dataFactoryName'), variables('dataFactoryLinkedServiceName'))]"

]

},

{

"type": "Microsoft.DataFactory/factories/pipelines",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('pipelineName'))]",

"properties": {

"activities": [

{

"name": "MyCopyActivity",

"type": "Copy",

"typeProperties": {

"source": {

"type": "BinarySource",

"storeSettings": {

"type": "AzureBlobStorageReadSettings",

"recursive": true

}

},

"sink": {

"type": "BinarySink",

"storeSettings": {

"type": "AzureBlobStorageWriteSettings"

}

},

"enableStaging": false

},

"inputs": [

{

"referenceName": "[variables('dataFactoryDataSetInName')]",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "[variables('dataFactoryDataSetOutName')]",

"type": "DatasetReference"

}

]

}

]

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.DataFactory/factories/datasets', parameters('dataFactoryName'), variables('dataFactoryDataSetInName'))]",

"[resourceId('Microsoft.DataFactory/factories/datasets', parameters('dataFactoryName'), variables('dataFactoryDataSetOutName'))]"

]

}

],

"outputs": {

"name": {

"type": "string",

"value": "[variables('pipelineName')]"

},

"resourceId": {

"type": "string",

"value": "[resourceId('Microsoft.DataFactory/factories/pipelines', parameters('dataFactoryName'), variables('pipelineName'))]"

},

"resourceGroupName": {

"type": "string",

"value": "[resourceGroup().name]"

},

"location": {

"type": "string",

"value": "[parameters('location')]"

}

}

}

Des ressources sont définies dans le modèle :

- Microsoft.Storage/storageAccounts : définit un compte de stockage.

- Microsoft.DataFactory/factories : crée une fabrique de données Azure.

- Microsoft.DataFactory/factories/linkedServices : crée un service lié Azure Data Factory.

- Microsoft.DataFactory/factories/datasets : crée un jeu de données Azure Data Factory.

- Microsoft.DataFactory/factories/pipelines : crée un pipeline Azure Data Factory.

Vous trouverez d’autres exemples de modèles Azure Data Factory dans la galerie de modèles de démarrage rapide.

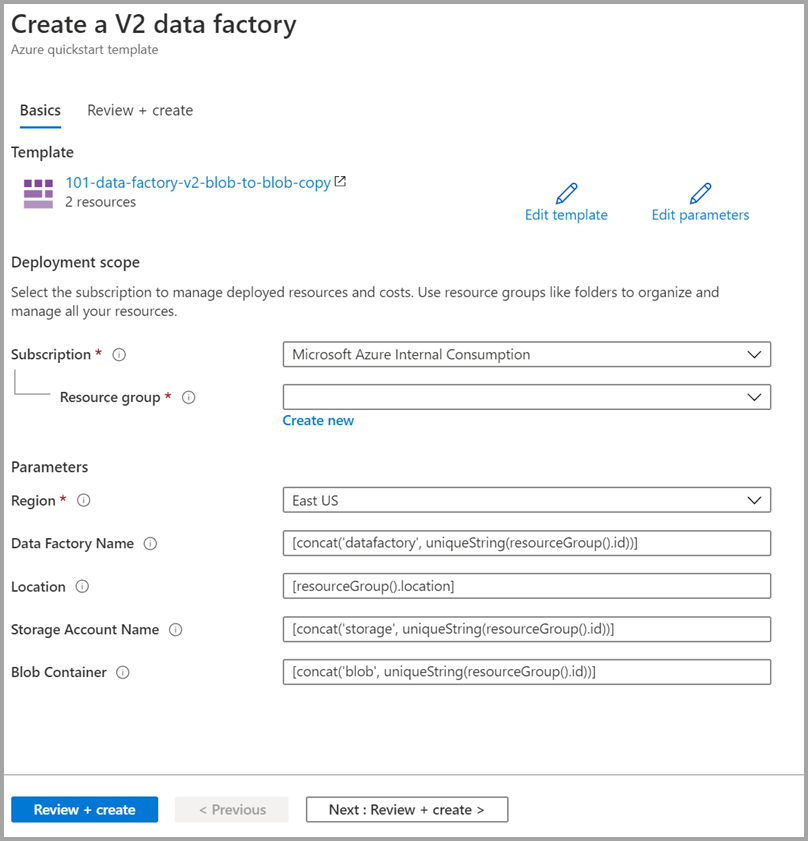

Déployer le modèle

Cliquez sur l’image ci-après pour vous connecter à Azure et ouvrir un modèle. Le modèle crée un compte Azure Data Factory, un compte de stockage et un conteneur d’objets blob.

Sélectionnez ou entrez les valeurs suivantes.

Sauf aucune valeur n’est spécifiée, utilisez les valeurs par défaut pour créer les ressources Azure Data Factory :

- Abonnement: Sélectionnez un abonnement Azure.

- Groupe de ressources : Sélectionnez Créer, entrez un nom unique pour le groupe de ressources, puis sélectionnez OK.

- Région : Sélectionnez un emplacement. Par exemple, USA Est.

- Nom de la fabrique de données : Utilisez la valeur par défaut.

- Emplacement : Utilisez la valeur par défaut.

- Nom du compte de stockage : Utilisez la valeur par défaut.

- Conteneur d’objets blob : Utilisez la valeur par défaut.

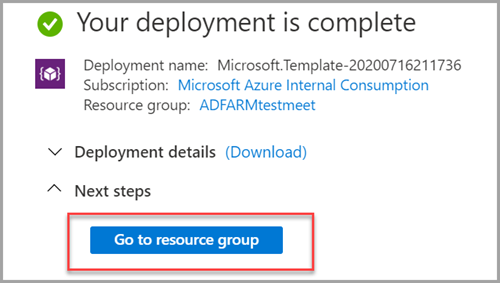

Vérifier les ressources déployées

Sélectionnez Accéder au groupe de ressources.

Vérifiez que votre Azure Data Factory est créé.

- Le nom de votre Azure Data Factory est au format datafactory<uniqueid>.

Vérifiez que votre compte de stockage est créé.

- Le nom du compte de stockage est au format storage<uniqueid>.

Sélectionnez le compte de stockage créé, puis Conteneurs.

- Sur la page Conteneurs, sélectionnez le conteneur d’objets blob que vous avez créé.

- Le nom du conteneur d’objets blob est au format blob<uniqueid>.

- Sur la page Conteneurs, sélectionnez le conteneur d’objets blob que vous avez créé.

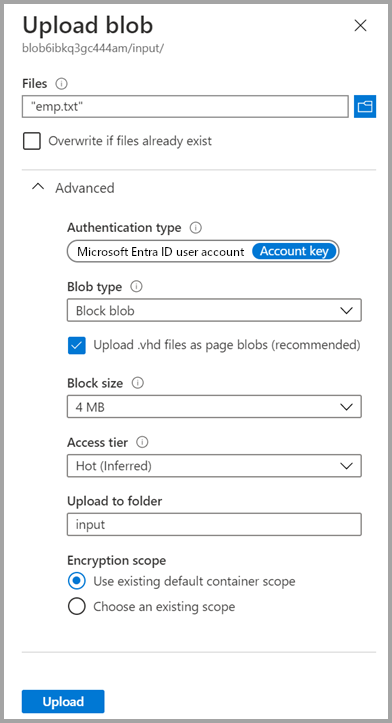

Charger un fichier

Sur la page Conteneurs, sélectionnez Charger.

Dans le volet de droite, activez la zone Fichiers, puis recherchez et sélectionnez le fichier emp.txt que vous avez créé précédemment.

Développez le titre Avancé.

Dans la zone Charger dans le dossier, entrez input.

Cliquez sur le bouton Charger. Vous devriez voir le fichier emp.txt et l’état du chargement dans la liste.

Sélectionnez l’icône Fermer (X) pour fermer la page Charger l’objet blob.

Laissez la page du conteneur ouverte, car elle vous permettra de vérifier la sortie à l’issue de ce démarrage rapide.

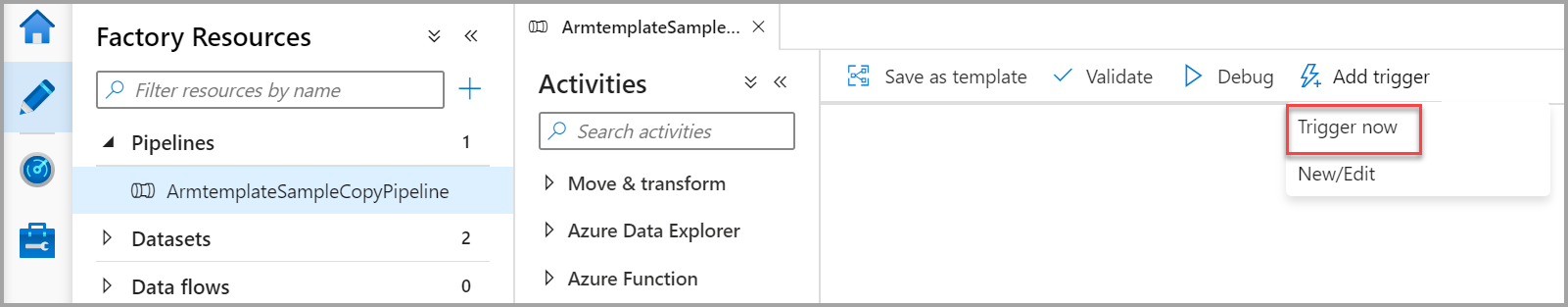

Démarrer le déclencheur

Accédez à la page fabriques de données, puis sélectionnez la fabrique de données que vous avez créée.

Sélectionnez Ouvrir dans la vignette Ouvrir Azure Data Factory Studio.

Sélectionnez l’onglet Auteur

.

.Sélectionnez le pipeline créé ArmtemplateSampleCopyPipeline.

Sélectionnez Ajouter un déclencheur>Déclencher maintenant.

Dans le volet droit, sous Exécuter le pipeline, sélectionnez OK.

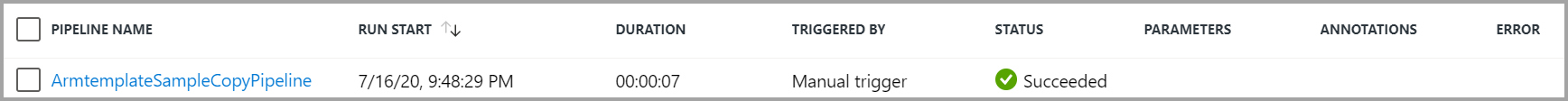

Surveiller le pipeline

Sélectionnez l’onglet Moniteur

.

.Vous voyez les exécutions d’activités associées avec l’exécution du pipeline. Dans ce guide de démarrage rapide, le pipeline n’a qu’une seule activité de type : Copier. Par conséquent, vous voyez une exécution pour cette activité.

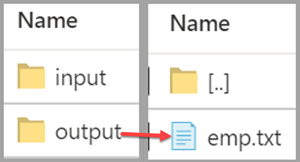

Vérifier le fichier de sortie

Le pipeline crée automatiquement un dossier de sortie dans le conteneur d’objets blob. Ensuite, il copie le fichier emp.txt à partir du dossier d’entrée dans le dossier de sortie.

Dans le portail Azure, dans la page Conteneurs, sélectionnez Actualiser pour voir le dossier de sortie.

Dans la liste des dossiers, sélectionnez output.

Vérifiez que le fichier emp.txt a été copié dans le dossier de sortie.

Nettoyer les ressources

Vous disposez de deux moyens de supprimer les ressources que vous avez créées dans le guide de démarrage rapide. Vous pouvez supprimer le groupe de ressources Azure qui inclut toutes les ressources du groupe de ressources. Si vous souhaitez conserver les autres ressources, supprimez uniquement la fabrique de données créée dans ce tutoriel.

Si vous supprimez un groupe de ressources, toutes les ressources qu’il contient, y compris les fabriques de données, seront supprimées. Exécutez la commande suivante pour supprimer l’intégralité du groupe de ressources :

Remove-AzResourceGroup -ResourceGroupName $resourcegroupname

Si vous souhaitez supprimer uniquement la fabrique de données, et non pas le groupe de ressources entier, exécutez la commande suivante :

Remove-AzDataFactoryV2 -Name $dataFactoryName -ResourceGroupName $resourceGroupName

Contenu connexe

Dans ce démarrage rapide, vous avez créé une fabrique de données Azure à l’aide d’un modèle ARM, et avez validé le déploiement. Pour en savoir plus sur Azure Data Factory et Azure Resource Manager, passez aux articles ci-dessous.

- Documentation Azure Data Factory

- En savoir plus sur Azure Resource Manager

- Obtenez d’autres modèles ARM Azure Data Factory