Copier plusieurs tables en bloc en utilisant Azure Data Factory avec PowerShell

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Ce tutoriel montre comment copier des tables d’Azure SQL Database dans Azure Synapse Analytics. Vous pouvez appliquer le même modèle à d’autres scénarios de copie. Par exemple : copie de tables à partir de SQL Server/Oracle dans Azure SQL Database/Data Warehouse/Azure Blob, copie de différents chemins à partir de Blob dans des tables Azure SQL Database.

Globalement, ce tutoriel implique les étapes suivantes :

- Créer une fabrique de données.

- Créez des services liés Azure SQL Database, Azure Synapse Analytics et Stockage Azure.

- Créer des jeux de données Azure SQL Database et Azure Synapse Analytics

- Créer un pipeline pour rechercher les tables à copier et un autre pipeline pour effectuer l’opération de copie.

- Démarrer une exécution de pipeline.

- Surveiller les exécutions de pipeline et d’activité.

Ce tutoriel utilise Azure PowerShell. Pour en savoir plus sur l’utilisation d’autres outils/SDK pour créer une fabrique de données, consultez Démarrages rapides.

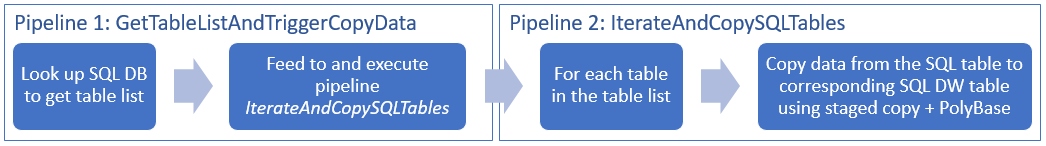

Workflow de bout en bout

Dans ce scénario, nous disposons d’un certain nombre de tables dans Azure SQL Database que nous souhaitons copier dans Azure Synapse Analytics. Voici l’ordre logique des étapes du workflow qui se produit dans les pipelines :

- Le premier pipeline recherche la liste des tables à copier dans les banques de données du récepteur. Vous pouvez également conserver une table de métadonnées qui répertorie toutes les tables à copier dans la banque de données du récepteur. Le pipeline déclenche ensuite un autre pipeline qui itère chaque table dans la base de données et effectue l’opération de copie de données.

- Le second pipeline effectue la copie. Il prend la liste des tables comme paramètre. Pour obtenir de meilleurs résultats, copiez chaque table de la liste entre Azure SQL Database et la table correspondante dans Azure Synapse Analytics à l’aide d’une copie intermédiaire effectuée via le Stockage Blob et PolyBase. Dans cet exemple, le premier pipeline passe la liste des tables comme valeur pour le paramètre.

Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer.

Prérequis

Notes

Nous vous recommandons d’utiliser le module Azure Az PowerShell pour interagir avec Azure. Pour commencer, consultez Installer Azure PowerShell. Pour savoir comment migrer vers le module Az PowerShell, consultez Migrer Azure PowerShell depuis AzureRM vers Az.

- Azure PowerShell. Suivez les instructions de la page Installation et configuration d’Azure PowerShell.

- Compte Stockage Azure. Le compte Stockage Azure est utilisé comme stockage d’objets blob intermédiaire dans l’opération de copie en bloc.

- Azure SQL Database. Cette base de données contient les données sources.

- Azure Synapse Analytics. Cet entrepôt de données conserve les données copiées à partir de SQL Database.

Préparer SQL Database et Azure Synapse Analytics

Préparer la base de données Azure SQL source :

Créez une base de données avec l’exemple de données Adventure Works LT dans SQL Database en suivant les instructions données dans l’article Créer une base de données dans Azure SQL Database. Ce tutoriel copie toutes les tables de cet exemple de base de données dans un magasin de données Azure Synapse Analytics.

Préparer le récepteur Azure Synapse Analytics :

Si vous n’avez pas d’espace de travail Azure Synapse Analytics, consultez l’article Bien démarrer avec Azure Synapse Analytics pour savoir comment en créer un.

Créez les schémas de table correspondants dans Azure Synapse Analytics. Plus tard, vous utiliserez Azure Data Factory pour migrer/copier les données.

Services Azure pour accéder au serveur SQL

Pour SQL Database et Azure Synapse Analytics, autorisez les services Azure à accéder au serveur SQL. Vérifiez que le paramètre Autoriser l’accès aux services Azure est activé sur votre serveur. Ce paramètre permet au service Data Factory de lire les données d’Azure SQL Database et de les écrire dans le magasin de données Azure Synapse Analytics. Pour vérifier et activer ce paramètre, procédez comme suit :

- Cliquez sur Tous les services sur la gauche, puis sur Serveurs SQL.

- Sélectionnez votre serveur, puis cliquez sur Pare-feu sous PARAMÈTRES.

- Dans la page Paramètres de pare-feu, cliquez sur ACTIVER pour Autoriser l’accès aux services Azure.

Créer une fabrique de données

Lancez PowerShell. Conservez Azure PowerShell ouvert jusqu’à la fin de ce tutoriel. Si vous fermez puis rouvrez Azure PowerShell, vous devez réexécuter ces commandes.

Exécutez la commande suivante, puis saisissez le nom d’utilisateur et le mot de passe que vous avez utilisés pour la connexion au portail Azure :

Connect-AzAccountExécutez la commande suivante pour afficher tous les abonnements de ce compte :

Get-AzSubscriptionExécutez la commande suivante pour sélectionner l’abonnement que vous souhaitez utiliser. Remplacez SubscriptionId par l’ID de votre abonnement Azure :

Select-AzSubscription -SubscriptionId "<SubscriptionId>"Exécutez la cmdlet Set-AzDataFactoryV2 pour créer une fabrique de données. Avant d’exécuter la commande, remplacez les espaces réservés par vos propres valeurs.

$resourceGroupName = "<your resource group to create the factory>" $dataFactoryName = "<specify the name of data factory to create. It must be globally unique.>" Set-AzDataFactoryV2 -ResourceGroupName $resourceGroupName -Location "East US" -Name $dataFactoryNameNotez les points suivants :

Le nom de la fabrique de données Azure doit être un nom global unique. Si vous recevez l’erreur suivante, changez le nom, puis réessayez.

The specified Data Factory name 'ADFv2QuickStartDataFactory' is already in use. Data Factory names must be globally unique.Pour créer des instances de fabrique de données, vous devez être un administrateur/collaborateur de l’abonnement Azure.

Pour obtenir la liste des régions Azure dans lesquelles Data Factory est actuellement disponible, sélectionnez les régions qui vous intéressent dans la page suivante, puis développez Analytique pour localiser Data Factory : Disponibilité des produits par région. Les magasins de données (Stockage Azure, Azure SQL Database, etc.) et les services de calcul (HDInsight, etc.) utilisés par la fabrique de données peuvent être proposés dans d’autres régions.

Créez des services liés

Dans ce tutoriel, vous allez créer trois services liés (un pour la source, un pour le récepteur et un pour l’objet blob intermédiaire), avec des connexions à vos magasins de données :

Créer le service lié Azure SQL Database pour la source

Créez un fichier JSON nommé AzureSqlDatabaseLinkedService.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant : (Créez le dossier ADFv2TutorialBulkCopy s’il n’existe pas déjà.)

Important

Remplacez <servername>, <databasename>, <username>@<servername> et <password> par les valeurs de votre base de données Azure SQL Database avant d’enregistrer le fichier.

{ "name": "AzureSqlDatabaseLinkedService", "properties": { "type": "AzureSqlDatabase", "typeProperties": { "connectionString": "Server=tcp:<servername>.database.windows.net,1433;Database=<databasename>;User ID=<username>@<servername>;Password=<password>;Trusted_Connection=False;Encrypt=True;Connection Timeout=30" } } }Dans Azure PowerShell, passez au dossier ADFv2TutorialBulkCopy.

Exécutez la cmdlet Set-AzDataFactoryV2LinkedService pour créer le service lié : AzureSqlDatabaseLinkedService.

Set-AzDataFactoryV2LinkedService -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureSqlDatabaseLinkedService" -File ".\AzureSqlDatabaseLinkedService.json"Voici l'exemple de sortie :

LinkedServiceName : AzureSqlDatabaseLinkedService ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> Properties : Microsoft.Azure.Management.DataFactory.Models.AzureSqlDatabaseLinkedService

Créer un service lié du récepteur Azure Synapse Analytics

Créez un fichier JSON nommé AzureSqlDWLinkedService.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant :

Important

Remplacez <servername>, <databasename>, <username>@<servername> et <password> par les valeurs de votre base de données Azure SQL Database avant d’enregistrer le fichier.

{ "name": "AzureSqlDWLinkedService", "properties": { "type": "AzureSqlDW", "typeProperties": { "connectionString": "Server=tcp:<servername>.database.windows.net,1433;Database=<databasename>;User ID=<username>@<servername>;Password=<password>;Trusted_Connection=False;Encrypt=True;Connection Timeout=30" } } }Pour créer le service lié : AzureSqlDWLinkedService, exécutez la cmdlet Set-AzDataFactoryV2LinkedService.

Set-AzDataFactoryV2LinkedService -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureSqlDWLinkedService" -File ".\AzureSqlDWLinkedService.json"Voici l'exemple de sortie :

LinkedServiceName : AzureSqlDWLinkedService ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> Properties : Microsoft.Azure.Management.DataFactory.Models.AzureSqlDWLinkedService

Créer le service lié Stockage Azure intermédiaire

Dans ce tutoriel, vous allez utiliser Stockage Blob Azure comme zone intermédiaire pour améliorer les performances de copie de PolyBase.

Créez un fichier JSON nommé AzureSqlDWLinkedService.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant :

Important

Remplacez <accountName> et <accountKey> par le nom et la clé de votre compte de stockage Azure avant d’enregistrer le fichier.

{ "name": "AzureStorageLinkedService", "properties": { "type": "AzureStorage", "typeProperties": { "connectionString": "DefaultEndpointsProtocol=https;AccountName=<accountName>;AccountKey=<accountKey>" } } }Pour créer le service lié : AzureStorageLinkedService, exécutez la cmdlet Set-AzDataFactoryV2LinkedService.

Set-AzDataFactoryV2LinkedService -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureStorageLinkedService" -File ".\AzureStorageLinkedService.json"Voici l'exemple de sortie :

LinkedServiceName : AzureStorageLinkedService ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> Properties : Microsoft.Azure.Management.DataFactory.Models.AzureStorageLinkedService

Créez les jeux de données

Dans ce tutoriel, vous créez des jeux de données (source et récepteur) qui spécifient l’emplacement de stockage des données :

Créer un jeu de données pour la base de données SQL source

Créez un fichier JSON nommé AzureSqlDatabaseDataset.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant : « tableName » est un nom factice. Plus tard, vous utiliserez la requête SQL dans l’activité de copie pour récupérer des données.

{ "name": "AzureSqlDatabaseDataset", "properties": { "type": "AzureSqlTable", "linkedServiceName": { "referenceName": "AzureSqlDatabaseLinkedService", "type": "LinkedServiceReference" }, "typeProperties": { "tableName": "dummy" } } }Pour créer le jeu de données : AzureSqlDatabaseDataset, exécutez la cmdlet Set-AzDataFactoryV2Dataset.

Set-AzDataFactoryV2Dataset -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureSqlDatabaseDataset" -File ".\AzureSqlDatabaseDataset.json"Voici l'exemple de sortie :

DatasetName : AzureSqlDatabaseDataset ResourceGroupName : <resourceGroupname> DataFactoryName : <dataFactoryName> Structure : Properties : Microsoft.Azure.Management.DataFactory.Models.AzureSqlTableDataset

Créer un jeu de données pour le récepteur Azure Synapse Analytics

Créez un fichier JSON nommé AzureSqlDWDataset.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant : La valeur « tableName » est définie en tant que paramètre. Plus tard, l’activité de copie qui fait référence à ce jeu de données transmet la valeur réelle au jeu de données.

{ "name": "AzureSqlDWDataset", "properties": { "type": "AzureSqlDWTable", "linkedServiceName": { "referenceName": "AzureSqlDWLinkedService", "type": "LinkedServiceReference" }, "typeProperties": { "tableName": { "value": "@{dataset().DWTableName}", "type": "Expression" } }, "parameters":{ "DWTableName":{ "type":"String" } } } }Pour créer le jeu de données : AzureSqlDWDataset, exécutez la cmdlet Set-AzDataFactoryV2Dataset.

Set-AzDataFactoryV2Dataset -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureSqlDWDataset" -File ".\AzureSqlDWDataset.json"Voici l'exemple de sortie :

DatasetName : AzureSqlDWDataset ResourceGroupName : <resourceGroupname> DataFactoryName : <dataFactoryName> Structure : Properties : Microsoft.Azure.Management.DataFactory.Models.AzureSqlDwTableDataset

Créer des pipelines

Dans ce tutoriel, vous allez créer deux pipelines :

Créer le pipeline « IterateAndCopySQLTables »

Ce pipeline prend une liste de tables comme paramètre. Pour chaque table de la liste, il copie les données de la table Azure SQL Database vers Azure Synapse Analytics en utilisant la copie intermédiaire et PolyBase.

Créez un fichier JSON nommé IterateAndCopySQLTables.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant :

{ "name": "IterateAndCopySQLTables", "properties": { "activities": [ { "name": "IterateSQLTables", "type": "ForEach", "typeProperties": { "isSequential": "false", "items": { "value": "@pipeline().parameters.tableList", "type": "Expression" }, "activities": [ { "name": "CopyData", "description": "Copy data from Azure SQL Database to Azure Synapse Analytics", "type": "Copy", "inputs": [ { "referenceName": "AzureSqlDatabaseDataset", "type": "DatasetReference" } ], "outputs": [ { "referenceName": "AzureSqlDWDataset", "type": "DatasetReference", "parameters": { "DWTableName": "[@{item().TABLE_SCHEMA}].[@{item().TABLE_NAME}]" } } ], "typeProperties": { "source": { "type": "SqlSource", "sqlReaderQuery": "SELECT * FROM [@{item().TABLE_SCHEMA}].[@{item().TABLE_NAME}]" }, "sink": { "type": "SqlDWSink", "preCopyScript": "TRUNCATE TABLE [@{item().TABLE_SCHEMA}].[@{item().TABLE_NAME}]", "allowPolyBase": true }, "enableStaging": true, "stagingSettings": { "linkedServiceName": { "referenceName": "AzureStorageLinkedService", "type": "LinkedServiceReference" } } } } ] } } ], "parameters": { "tableList": { "type": "Object" } } } }Pour créer le pipeline : IterateAndCopySQLTables, exécutez la cmdlet Set-AzDataFactoryV2Pipeline.

Set-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "IterateAndCopySQLTables" -File ".\IterateAndCopySQLTables.json"Voici l'exemple de sortie :

PipelineName : IterateAndCopySQLTables ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> Activities : {IterateSQLTables} Parameters : {[tableList, Microsoft.Azure.Management.DataFactory.Models.ParameterSpecification]}

Créer le pipeline « GetTableListAndTriggerCopyData »

Ce pipeline exécute deux étapes :

- Recherche la table système Azure SQL Database pour obtenir la liste des tables à copier.

- Déclenche le pipeline « IterateAndCopySQLTables » pour copier les données.

Créez un fichier JSON nommé GetTableListAndTriggerCopyData.json dans le dossier C:\ADFv2TutorialBulkCopy avec le contenu suivant :

{ "name":"GetTableListAndTriggerCopyData", "properties":{ "activities":[ { "name": "LookupTableList", "description": "Retrieve the table list from Azure SQL database", "type": "Lookup", "typeProperties": { "source": { "type": "SqlSource", "sqlReaderQuery": "SELECT TABLE_SCHEMA, TABLE_NAME FROM information_schema.TABLES WHERE TABLE_TYPE = 'BASE TABLE' and TABLE_SCHEMA = 'SalesLT' and TABLE_NAME <> 'ProductModel'" }, "dataset": { "referenceName": "AzureSqlDatabaseDataset", "type": "DatasetReference" }, "firstRowOnly": false } }, { "name": "TriggerCopy", "type": "ExecutePipeline", "typeProperties": { "parameters": { "tableList": { "value": "@activity('LookupTableList').output.value", "type": "Expression" } }, "pipeline": { "referenceName": "IterateAndCopySQLTables", "type": "PipelineReference" }, "waitOnCompletion": true }, "dependsOn": [ { "activity": "LookupTableList", "dependencyConditions": [ "Succeeded" ] } ] } ] } }Pour créer le pipeline : GetTableListAndTriggerCopyData, exécutez la cmdlet Set-AzDataFactoryV2Pipeline.

Set-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "GetTableListAndTriggerCopyData" -File ".\GetTableListAndTriggerCopyData.json"Voici l'exemple de sortie :

PipelineName : GetTableListAndTriggerCopyData ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> Activities : {LookupTableList, TriggerCopy} Parameters :

Démarrer et surveiller une exécution de pipeline

Démarrez une exécution de pipeline pour le pipeline principal « GetTableListAndTriggerCopyData » et capturez l’ID d’exécution du pipeline pour une analyse ultérieure. Ceci déclenche l’exécution du pipeline « IterateAndCopySQLTables », comme indiqué dans l’activité ExecutePipeline.

$runId = Invoke-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineName 'GetTableListAndTriggerCopyData'Exécutez le script suivant pour vérifier en permanence l’état de l’exécution du pipeline GetTableListAndTriggerCopyData, puis imprimez le résultat final de l’exécution de pipeline et de l’exécution d’activité.

while ($True) { $run = Get-AzDataFactoryV2PipelineRun -ResourceGroupName $resourceGroupName -DataFactoryName $DataFactoryName -PipelineRunId $runId if ($run) { if ($run.Status -ne 'InProgress') { Write-Host "Pipeline run finished. The status is: " $run.Status -ForegroundColor "Yellow" Write-Host "Pipeline run details:" -ForegroundColor "Yellow" $run break } Write-Host "Pipeline is running...status: InProgress" -ForegroundColor "Yellow" } Start-Sleep -Seconds 15 } $result = Get-AzDataFactoryV2ActivityRun -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineRunId $runId -RunStartedAfter (Get-Date).AddMinutes(-30) -RunStartedBefore (Get-Date).AddMinutes(30) Write-Host "Activity run details:" -ForegroundColor "Yellow" $resultVoici la sortie de l’exemple d’exécution :

Pipeline run details: ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> RunId : 0000000000-00000-0000-0000-000000000000 PipelineName : GetTableListAndTriggerCopyData LastUpdated : 9/18/2017 4:08:15 PM Parameters : {} RunStart : 9/18/2017 4:06:44 PM RunEnd : 9/18/2017 4:08:15 PM DurationInMs : 90637 Status : Succeeded Message : Activity run details: ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> ActivityName : LookupTableList PipelineRunId : 0000000000-00000-0000-0000-000000000000 PipelineName : GetTableListAndTriggerCopyData Input : {source, dataset, firstRowOnly} Output : {count, value, effectiveIntegrationRuntime} LinkedServiceName : ActivityRunStart : 9/18/2017 4:06:46 PM ActivityRunEnd : 9/18/2017 4:07:09 PM DurationInMs : 22995 Status : Succeeded Error : {errorCode, message, failureType, target} ResourceGroupName : <resourceGroupName> DataFactoryName : <dataFactoryName> ActivityName : TriggerCopy PipelineRunId : 0000000000-00000-0000-0000-000000000000 PipelineName : GetTableListAndTriggerCopyData Input : {pipeline, parameters, waitOnCompletion} Output : {pipelineRunId} LinkedServiceName : ActivityRunStart : 9/18/2017 4:07:11 PM ActivityRunEnd : 9/18/2017 4:08:14 PM DurationInMs : 62581 Status : Succeeded Error : {errorCode, message, failureType, target}Vous pouvez obtenir l’ID d’exécution du pipeline « IterateAndCopySQLTables », puis vérifier le résultat détaillé de l’exécution d’activité comme suit.

Write-Host "Pipeline 'IterateAndCopySQLTables' run result:" -ForegroundColor "Yellow" ($result | Where-Object {$_.ActivityName -eq "TriggerCopy"}).Output.ToString()Voici la sortie de l’exemple d’exécution :

{ "pipelineRunId": "7514d165-14bf-41fb-b5fb-789bea6c9e58" }$result2 = Get-AzDataFactoryV2ActivityRun -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineRunId <copy above run ID> -RunStartedAfter (Get-Date).AddMinutes(-30) -RunStartedBefore (Get-Date).AddMinutes(30) $result2Connectez-vous à votre récepteur Azure Synapse Analytics et vérifiez que les données ont bien été copiées à partir d’Azure SQL Database.

Contenu connexe

Dans ce tutoriel, vous avez effectué les étapes suivantes :

- Créer une fabrique de données.

- Créez des services liés Azure SQL Database, Azure Synapse Analytics et Stockage Azure.

- Créer des jeux de données Azure SQL Database et Azure Synapse Analytics

- Créer un pipeline pour rechercher les tables à copier et un autre pipeline pour effectuer l’opération de copie.

- Démarrer une exécution de pipeline.

- Surveiller les exécutions de pipeline et d’activité.

Passez au tutoriel suivant pour découvrir comment copier des données de manière incrémentielle d’une source vers une destination :

Commentaires

Bientôt disponible : Tout au long de 2024, nous allons supprimer progressivement GitHub Issues comme mécanisme de commentaires pour le contenu et le remplacer par un nouveau système de commentaires. Pour plus d’informations, consultez https://aka.ms/ContentUserFeedback.

Envoyer et afficher des commentaires pour