Note

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier les répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de changer de répertoire.

Cet article décrit les options pour les ressources de calcul de notebook. Vous pouvez exécuter un notebook sur une ressource de calcul polyvalente, un calcul sans serveur ou, pour les commandes SQL, utiliser un entrepôt SQL, un type de calcul optimisé pour l’analytique SQL. Pour plus d’informations sur les types de calcul, consultez Calcul.

Calcul serverless pour les notebooks

Le calcul serverless vous permet de vous connecter rapidement votre notebook à des ressources informatiques à la demande.

Pour effectuer un attachement au calcul serverless, cliquez sur le menu déroulant Connecter dans le notebook, puis sélectionnez Serverless.

Pour en savoir plus, consultez Calcul serverless pour les notebooks.

Restauration de session automatisée pour les cahiers sans serveur

Avec un arrêt pour inactivité du calcul serverless, vous risquez de perdre le travail en cours, comme les valeurs de variables Python, dans vos notebooks. Pour éviter cela, activez la restauration de session automatisée pour les notebooks serverless.

- Cliquez sur votre nom d’utilisateur en haut à droite de votre espace de travail, puis cliquez sur Paramètres dans la liste déroulante.

- Dans la barre latérale des Paramètres, sélectionnez Développeur.

- Sous Fonctionnalités expérimentales, activez la restauration de session automatisée pour les notebooks sans serveur.

L’activation de ce paramètre permet à Databricks de prendre un instantané de l’état de mémoire du notebook sans serveur avant la cessation d'activité. Lorsque vous revenez à un bloc-notes après une déconnexion inactive, une bannière apparaît en haut de la page. Cliquez sur Reconnecter pour restaurer votre état de travail.

Lorsque vous vous reconnectez, Databricks rétablit l’ensemble de votre environnement de travail, notamment :

- Variables, fonctions et définitions de classes Python : le côté Python de votre notebook est conservé afin que vous n’ayez pas besoin de réimporter ou de redéclarer.

- Trames de données Spark, vues mises en cache et temporaires : les données que vous avez chargées, transformées ou mises en cache (y compris les vues temporaires) sont conservées. Vous évitez donc de recharger ou de recomputer coûteusement.

- État de session Spark : tous vos paramètres de configuration au niveau Spark, les vues temporaires, les modifications de catalogue et les fonctions définies par l’utilisateur sont enregistrés. Vous n’avez donc pas besoin de les réinitialiser.

Cette fonctionnalité présente des limitations et ne prend pas en charge la restauration des éléments suivants :

- États Spark antérieurs à 4 jours

- États Spark supérieurs à 50 Mo

- Données relatives à l’écriture de scripts SQL

- Descripteurs de fichiers

- Verrous et autres primitives de concurrence

- Connexions réseau

Attacher un notebook à une ressource de calcul à usage général

Pour attacher un notebook à une ressource de calcul à usage unique, vous avez besoin de l’autorisation CAN ATTACH TO sur la ressource de calcul.

Important

Tant qu’un bloc-notes est attaché à une ressource de calcul, tout utilisateur disposant de l’autorisation CAN RUN sur le notebook dispose d’une autorisation implicite pour accéder à la ressource de calcul.

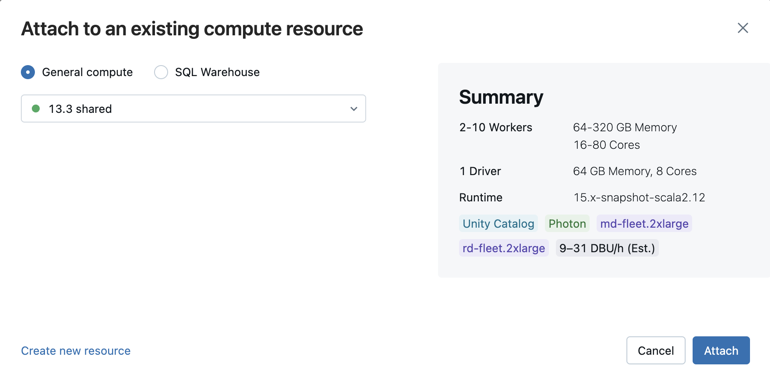

Pour attacher un bloc-notes à une ressource de calcul, cliquez sur le sélecteur de calcul dans la barre d’outils du bloc-notes et sélectionnez la ressource dans le menu déroulant.

Le menu affiche une sélection de calcul à usage unique et d’entrepôts SQL que vous avez utilisés récemment ou qui sont en cours d’exécution.

Pour sélectionner parmi toutes les ressources de calcul disponibles, cliquez sur Plus.... Sélectionnez parmi les entrepôts de calcul généraux ou SQL disponibles.

Vous pouvez également créer une ressource de calcul à usage entier en sélectionnant Créer une ressource... dans le menu déroulant.

Important

Les variables Apache Spark suivantes sont définies pour un notebook attaché.

| Classe | Nom de la variable |

|---|---|

SparkContext |

sc |

SQLContext/HiveContext |

sqlContext |

SparkSession (Spark 2.x) |

spark |

Ne créez pas de SparkSession, SparkContext ou SQLContext. Cela entraînera un comportement incohérent.

Utiliser un notebook avec un entrepôt SQL

Lorsqu’un notebook est attaché à un entrepôt SQL, vous pouvez exécuter des cellules SQL et Markdown. L’exécution d’une cellule dans tout autre langage (comme Python ou R) génère une erreur. Les cellules SQL exécutées sur un entrepôt SQL apparaissent dans l’historique des requêtes de l’entrepôt SQL. L’utilisateur qui a exécuté une requête peut afficher le profil de requête à partir du notebook en cliquant sur la durée écoulée en bas de la sortie.

Les notebooks attachés aux entrepôts SQL prennent en charge les sessions SQL Warehouse, ce qui vous permet de définir des variables, de créer des vues temporaires et de conserver l’état dans plusieurs exécutions de requête. Cela vous permet de générer une logique SQL de manière itérative sans avoir à exécuter toutes les instructions en même temps. Découvrez quelles sont les sessions SQL Warehouse ?.

L’exécution d’un notebook nécessite un entrepôt SQL professionnel ou serverless. Vous devez avoir accès à l’espace de travail et à l’entrepôt SQL.

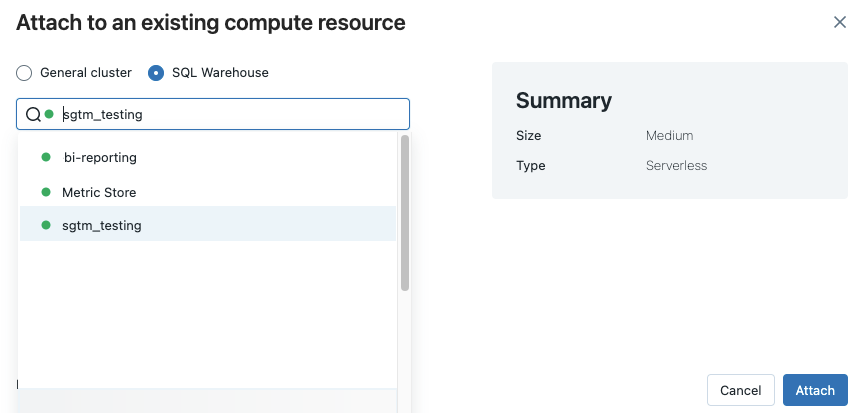

Pour attacher un notebook à un entrepôt SQL, procédez comme suit :

Cliquez sur le sélecteur de calcul dans la barre d’outils du notebook. Le menu déroulant affiche les ressources de calcul en cours d’exécution ou que vous avez utilisées récemment. Les entrepôts SQL sont marqués comme suit :

.

.Dans le menu, sélectionnez un entrepôt SQL.

Pour afficher tous les entrepôts SQL disponibles, sélectionnez Plus... dans le menu déroulant. Une boîte de dialogue indique les ressources de calcul disponibles pour le notebook. Sélectionnez Entrepôt SQL, choisissez l’entrepôt que vous souhaitez utiliser, puis cliquez sur Joindre.

Vous pouvez également sélectionner un entrepôt SQL comme ressource de calcul pour un notebook SQL à la création d’un workflow ou d’un travail planifié.

Limitations des entrepôts SQL

Pour en savoir plus, consultez Limitations connues des notebooks Databricks.