Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Dans ce tutoriel, vous allez ingérer davantage de tables de faits et de dimensions à partir de Wide World Importers (WWI) dans le lakehouse.

Prérequis

- Si vous n’avez pas de lakehouse, vous devez en créer un.

Ingérer des données

Dans cette section, vous allez utiliser l’activité Copier des données du pipeline Data Factory pour ingérer des exemples de données d’un compte de stockage Azure vers la section Fichiers du lakehouse que vous avez créé précédemment.

Sélectionnez Espaces de travail dans le volet de navigation gauche, puis votre nouvel espace de travail dans le menu Espaces de travail. La vue Éléments de votre espace de travail s’affiche.

Dans l’option Nouvel élément du ruban de l’espace de travail, sélectionnez Pipeline.

Dans la boîte de dialogue Nouveau pipeline, spécifiez le nom IngestDataFromSourceToLakehouse, puis sélectionnez Créer.

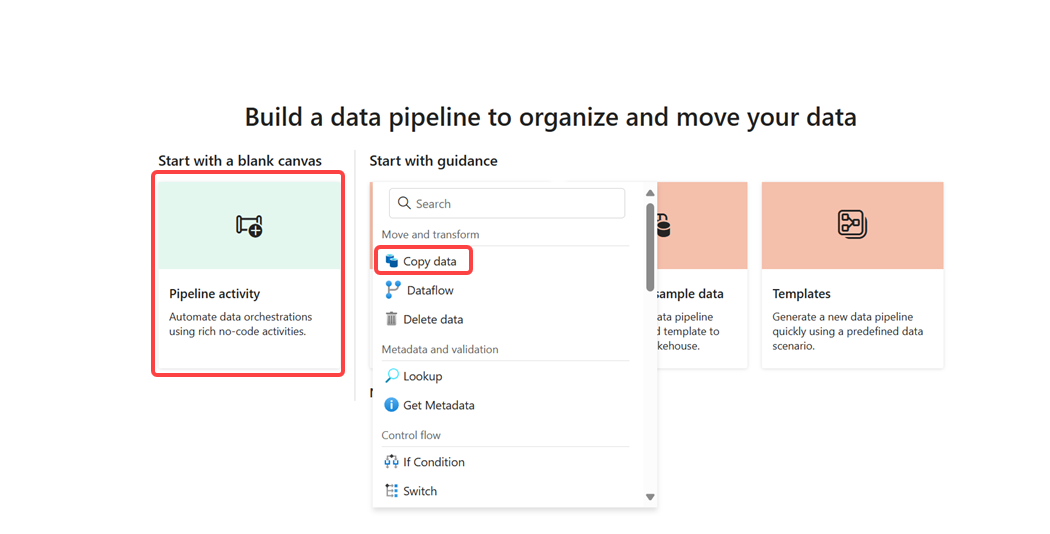

À partir de votre pipeline nouvellement créé, sélectionnez l’activité pipeline pour ajouter une activité au pipeline, puis sélectionnez Copier des données. Cette action ajoute l’activité de copie de données au canevas du pipeline.

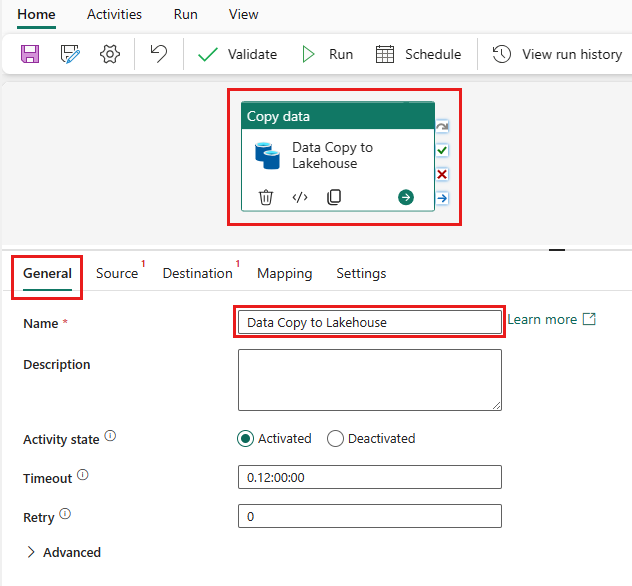

Sélectionnez l’activité de copie de données nouvellement ajoutée dans le canevas. Les propriétés d’activité apparaissent dans un volet sous le canevas (vous devrez peut-être développer le volet vers le haut en faisant glisser le bord supérieur). Dans l’onglet Général du volet propriétés, tapez Copie de données vers Lakehouse dans le champ Nom . Laissez les propriétés restantes à leurs valeurs par défaut.

Sous l’onglet Source de l’activité de copie de données sélectionnée, ouvrez le champ Connexion et sélectionnez Parcourir tout. Choisissez une fenêtre de source de données qui s’affiche, recherche et sélectionne des objets blob Azure. Pour ce tutoriel, tous les exemples de données sont disponibles dans un conteneur public de stockage d’objets blob Azure. Vous vous connectez à ce conteneur pour copier des données à partir de celui-ci.

Entrez les détails suivants dans la fenêtre Paramètres de connexion, puis sélectionnez Se connecter pour créer la connexion à la source de données.

Propriété Valeur Nom ou URL du compte https://fabrictutorialdata.blob.core.windows.net/sampledata/Connexion Créer une connexion Nom de la connexion wwisampledata Type d'authentification Anonyme Une fois la nouvelle connexion créée, revenez à l’onglet Source de l’activité de copie des données et la connexion nouvellement créée est sélectionnée par défaut. Spécifiez les propriétés suivantes avant de passer aux paramètres de destination.

Propriété Valeur Connexion wwisampledata Type de chemin d’accès au fichier Chemins d'accès au fichier Chemins d'accès au fichier Nom du conteneur (première zone de texte) : sampledata

Nom du répertoire (deuxième zone de texte) : WideWorldImportersDW/parquetRécursivement Vérifié Format de fichier Binary Sous l’onglet Destination de l’activité de copie de données sélectionnée, spécifiez les propriétés suivantes :

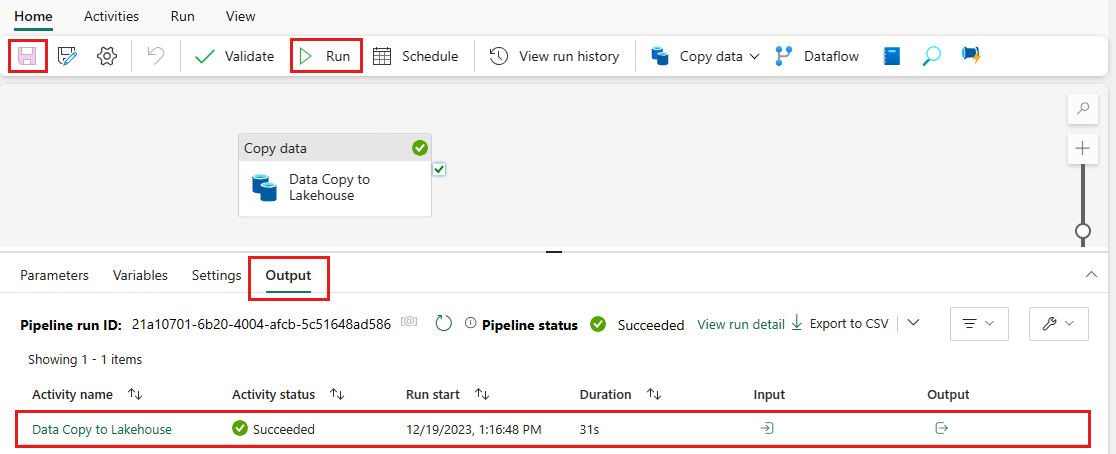

Propriété Valeur Connexion wwilakehouse (choisissez votre lakehouse si vous l’avez nommé différemment) Dossier racine Fichiers Chemins d'accès au fichier Nom du répertoire (première zone de texte) : wwi-raw-data Format de fichier Binary Vous avez configuré l’activité de copie des données. Sélectionnez l’icône Enregistrer dans le ruban supérieur (sous Accueil) pour enregistrer vos modifications, puis sélectionnez Exécuter pour exécuter votre pipeline et son activité. Vous pouvez également planifier des pipelines pour actualiser les données à intervalles définis pour répondre à vos besoins métier. Pour ce didacticiel, nous n’exécutons le pipeline qu’une seule fois en sélectionnant Exécuter.

Cette action déclenche la copie des données de la source de données sous-jacente vers le lakehouse spécifié et peut prendre jusqu’à une minute. Vous pouvez surveiller l’exécution du pipeline et de son activité sous l’onglet Sortie . L’état de l’activité change de File d’attente>En cours>réussi.

Une fois l’activité de copie réussie, ouvrez votre lakehouse (wwilakehouse) pour afficher les données. Actualisez la section Fichiers pour afficher les données ingérées. Un nouveau dossier wwi-raw-data apparaît dans la section fichiers, et les données des tables Blob Azure sont copiées là-bas.