Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

S’applique à :✅ point de terminaison d’analytique SQL et entrepôt dans Microsoft Fabric

Fabric Data Warehouse est un entrepôt relationnel à l’échelle de l’entreprise sur une base de lac de données.

- Les cas d’usage idéaux pour Fabric Data Warehouse sont des schémas en étoile ou flocons, des marts de données d’entreprise organisés, des modèles sémantiques régis pour la décisionnel.

- Les données de l’entrepôt de données Fabric, comme toutes les données Fabric, sont stockées dans des tables Delta, qui sont des fichiers de données Parquet avec un journal des transactions basé sur des fichiers. Basé sur le format de données ouvert Fabric, un entrepôt permet de partager et de collaborer entre les ingénieurs de données et les utilisateurs professionnels sans compromettre la sécurité ou la gouvernance.

- Fabric Data Warehouse est principalement développé avec T-SQL et partage une grande surface d’exposition basée sur le moteur de base de données SQL, avec prise en charge complète des transactions ACID à plusieurs tables, vues matérialisées, fonctions et procédures stockées.

- Le chargement en bloc de Fabric Data Warehouse peut être effectué via des connexions T-SQL et TDS, ou via Spark, avec des données écrites en bloc directement dans les tables Delta.

- L’expérience SaaS facile à utiliser est également étroitement intégrée à Power BI pour faciliter l’analyse et la création de rapports.

Les clients de l’entrepôt de données bénéficient des avantages suivants :

- Les requêtes entre bases de données permettent aux clients d’utiliser plusieurs sources de données pour obtenir des insights rapides et sans duplication de données.

- Ingérer, charger et transformer facilement des données à grande échelle par le biais de pipelines, de flux de données, d’une requête entre bases de données ou de la commande COPY INTO.

- La gestion autonome de la charge de travail avec un moteur de traitement de requêtes distribué à la pointe de l'industrie signifie qu'il n'y a aucun bouton à tourner pour obtenir les meilleures performances de sa catégorie.

- Évoluez presque instantanément pour répondre aux exigences de l'entreprise. Le stockage et le calcul sont séparés.

- Les données sont automatiquement répliquées vers OneLake Files pour l’accès externe.

- Conçu pour n’importe quel niveau de compétence, du développeur citoyen à l’ingénieur DBA ou à l’ingénieur données.

Éléments d’entrepôt de données

Fabric Data Warehouse n’est pas un entrepôt de données d’entreprise traditionnel, il s’agit d’un entrepôt de lac qui prend en charge deux éléments d’entreposage distincts : l’élément d’entrepôt Fabric et l’élément de point de terminaison d’analyse SQL. Les deux éléments sont conçus pour répondre aux besoins métier des clients tout en offrant des performances optimales, en minimisant les coûts et en réduisant les frais administratifs.

Entrepôt de données Fabric

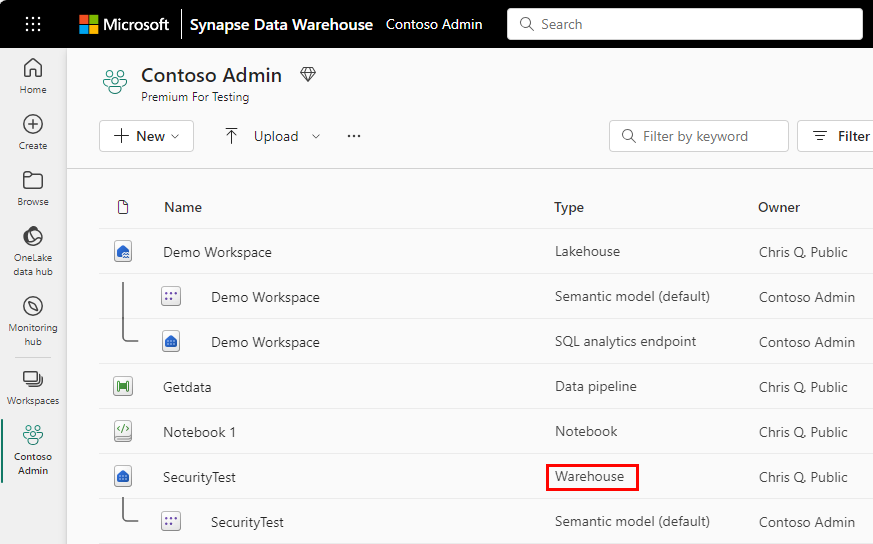

Dans un espace de travail Microsoft Fabric, un entrepôt Fabric est étiqueté en tant qu’entrepôt dans la colonne Type. Lorsque vous avez besoin d’exploiter pleinement la puissance et les capacités transactionnelles (prise en charge des requêtes DDL et DML) d’un entrepôt de données, il s’agit d’une solution rapide et simple.

L’entrepôt peut être rempli par l’une des méthodes d’ingestion de données prises en charge telles que COPY INTO, les pipelines, les flux de données ou les options d’ingestion de bases de données croisées telles que CREATE TABLE AS SELECT (CTAS), INSERT..SELECT ou SELECT INTO.

Pour commencer à utiliser l’entrepôt, consultez :

Point de terminaison d’analytique SQL de Lakehouse

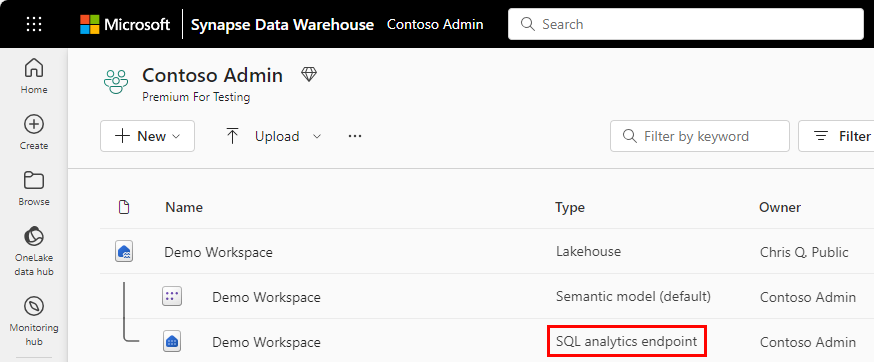

Dans un espace de travail Microsoft Fabric, chaque Lakehouse dispose d’un « point de terminaison d’analytique SQL » généré automatiquement, qui peut être utilisé pour passer de la vue « Lake » du Lakehouse (qui prend en charge l’ingénierie des données et Apache Spark) à la vue « SQL » du même Lakehouse pour créer des vues, des fonctions, des procédures stockées et appliquer la sécurité SQL.

En utilisant une technologie similaire, un entrepôt, une base de données SQL et Fabric OneLake approvisionnent automatiquement un point de terminaison d’analytique SQL lors de la création.

Avec le point de terminaison d’analytique SQL, les commandes T-SQL peuvent définir et interroger des objets de données, mais pas manipuler ou modifier les données. Vous pouvez effectuer les actions suivantes dans le point de terminaison d’analytique SQL :

- Interroger les tables qui référencent des données dans vos dossiers Delta Lake dans le lac.

- Créer des vues, des fonctions à valeurs de tables (TVF) en ligne et des procédures pour encapsuler votre sémantique et votre logique métier dans T-SQL.

- Gérer les autorisations sur les objets. Pour plus d’informations sur la sécurité dans le point de terminaison anlaytique SQL, consultez La sécurité OneLake pour les points de terminaison d’analyse SQL.

Pour commencer à utiliser le point de terminaison d’analytique SQL, consultez :

- Mieux ensemble : le lakehouse et l'entrepôt dans Microsoft Fabric

- Considérations sur les performances des points de terminaison d’analytique SQL

- Interroger le point de terminaison d’analytique SQL ou l’entrepôt dans Microsoft Fabric

Entrepôt ou maison sur le lac

Au moment de choisir entre un entrepôt ou un lakehouse, il est important de prendre en compte vos besoins spécifiques, le contexte de votre gestion des données et vos exigences analytiques.

Choisissez un entrepôt de données lorsque vous avez besoin d’une solution à l’échelle de l’entreprise avec un format standard ouvert, aucune performance à définir et une configuration minimale. Idéal pour les formats de données semi-structurés et structurés, l’entrepôt de données est adapté aux professionnels des données débutants et expérimentés, offrant des expériences simples et intuitives.

Choisissez un lakehouse lorsque vous avez besoin d’un grand référentiel de données hautement non structurées à partir de sources hétérogènes et que vous souhaitez utiliser Spark comme outil de développement principal. Agissant comme un entrepôt de données « léger », vous avez toujours la possibilité d’utiliser le point de terminaison d’analyse SQL et les outils T-SQL pour fournir des scénarios de création de rapports et d’intelligence des données dans votre lakehouse.

Vous avez toujours la possibilité d’ajouter ultérieurement l’un ou l’autre si vos besoins métier changent et quel que soit l’endroit à partir duquel vous commencez, l’entrepôt et le lakehouse utilisent le même moteur SQL puissant pour toutes les requêtes T-SQL.

Pour obtenir des conseils de décision plus détaillés, consultez Guide de décision Microsoft Fabric : choisir entre l’entrepôt de données et le lakehouse.

Migration

Utilisez l’Assistant Migration Fabric pour Data Warehouse pour migrer à partir d’Azure Synapse Analytics, SQL Server et d’autres plateformes de moteur de base de données SQL. Passez en revue les méthodes de planification et de migration pour les pools SQL dédiés Azure Synapse Analytics vers Fabric Data Warehouse.

Pour obtenir des conseils sur la migration dans Microsoft Fabric, consultez les outils et liens dans la vue d’ensemble de la migration de Microsoft Fabric.