Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Dans cet article, vous allez apprendre à obtenir des données à partir du stockage Azure (conteneur ADLS Gen2, conteneur d’objets blob ou objets blob individuels). Vous pouvez ingérer des données dans votre table en continu ou ponctuellement. Une fois ingérées, les données sont disponibles pour les requêtes.

Ingestion continue (aperçu) : l’ingestion continue implique la configuration d’un pipeline d’ingestion qui permet à un système de gestion d'événements d’écouter les événements de stockage Azure. Le pipeline informe le centre d'événements de récupérer des informations lorsque des événements souscrits se produisent. Les événements sont BlobCreated et BlobRenamed.

Important

Cette fonctionnalité est en version préliminaire.

Remarque

Un flux d’ingestion continu peut affecter votre facturation. Pour plus d’informations, consultez Consommation de base de données Eventhouse et KQL.

Ingestion ponctuelle : utilisez cette méthode pour récupérer des données à partir du stockage Azure en tant qu’opération ponctuelle.

Conditions préalables

- Un espace de travail avec une capacité activée par Microsoft Fabric.

- Une base de données KQL avec des autorisations d’édition.

- Un compte de stockage.

Pour l’ingestion continue, vous avez également besoin des éléments suivants :

Une identité d’espace de travail. Mon espace de travail n’est pas pris en charge. Si nécessaire, créez un espace de travail.

Activez l’espace de noms hiérarchique sur le compte de stockage.

Autorisations de rôle Lecteur de données Blob de stockage affectées à l’identité de l’espace de travail.

Conteneur pour contenir les fichiers de données.

Fichier de données chargé dans le conteneur. La structure de fichiers de données est utilisée pour définir le schéma de table. Pour plus d’informations, consultez formats de données pris en charge par Real-Time Intelligence.

Remarque

Vous devez charger un fichier de données :

- Avant la configuration nécessaire pour définir le schéma de la table lors de l'installation.

- Après la configuration pour déclencher l’ingestion continue, pour afficher un aperçu des données et vérifier la connexion.

Ajouter l’attribution de rôle d’identité d’espace de travail au compte de stockage

Dans les paramètres de l’espace de travail dans Fabric, copiez l’ID d’identité de votre espace de travail.

Dans le portail Azure, accédez à votre compte stockage Azure, puis sélectionnez Contrôle d’accès (IAM)>Ajouter une>attribution de rôle.

Sélectionnez Lecteur de données de stockage Blob.

Dans la boîte de dialogue Ajouter une attribution de rôle , sélectionnez + Sélectionner des membres.

Collez l’ID d’identité de l’espace de travail, sélectionnez l’application, puis sélectionnez>Vérifier + affecter.

Créer un conteneur avec un fichier de données

Dans le compte de stockage, sélectionnez Conteneurs.

Sélectionnez + Conteneur, entrez un nom pour le conteneur, puis sélectionnez Enregistrer.

Entrez le conteneur, sélectionnez charger et charger le fichier de données préparé précédemment.

Pour plus d’informations, consultez les formats pris en charge et les compressions prises en charge.

Dans le menu contextuel, [...], sélectionnez Propriétés du conteneur et copiez l’URL à entrer pendant la configuration.

Origine

Définissez la source pour obtenir des données.

Dans votre espace de travail, ouvrez EventHouse, puis sélectionnez la base de données.

Dans le ruban de base de données KQL, sélectionnez Obtenir des données.

Sélectionnez la source de données dans la liste disponible. Dans cet exemple, vous ingérez des données à partir d’un stockage Azure.

Configurer

Sélectionnez une table de destination. Si vous souhaitez ingérer des données dans une nouvelle table, sélectionnez + Nouvelle table et entrez un nom de table.

Remarque

Les noms de tables peuvent comporter jusqu’à 1 024 caractères, y compris des espaces, des caractères alphanumériques, des traits d’union et des tirets bas. Les caractères spéciaux ne sont pas pris en charge.

Dans la configuration de la connexion du stockage Blob Azure, assurez-vous que l’ingestion continue est activée. Elle est activée par défaut.

Configurez la connexion en créant une connexion ou en utilisant une connexion existante.

Pour créer une connexion :

Sélectionnez Se connecter à un compte de stockage.

Utilisez les descriptions suivantes pour vous aider à renseigner les champs.

Paramètre Description du champ Abonnement Abonnement au compte de stockage. Compte de stockage d’objets blob Nom du compte de stockage. Conteneur Conteneur de stockage contenant le fichier que vous souhaitez ingérer. Dans le champ Connexion , ouvrez la liste déroulante et sélectionnez + Nouvelle connexion, puis Enregistrez>fermer. Les paramètres de connexion sont préremplis.

Remarque

La création d’une connexion entraîne un nouveau flux d’événements. Le nom est défini comme <storate_account_name>_eventstream. Veillez à ne pas supprimer le flux d’événements d’ingestion continu de l’espace de travail.

Pour utiliser une connexion existante :

Sélectionnez Sélectionner un compte de stockage existant.

Utilisez les descriptions suivantes pour vous aider à renseigner les champs.

Paramètre Description du champ RTAStorageAccount Flux d’événements connecté à votre compte de stockage à partir de Fabric. Conteneur Conteneur de stockage contenant le fichier que vous souhaitez ingérer. Connexion Ceci est préconfiguré avec la chaîne de connexion Dans le champ Connexion , ouvrez la liste déroulante et sélectionnez la chaîne de connexion existante dans la liste. Sélectionnez Ensuite Enregistrer>fermer.

Si vous le souhaitez, développez les filtres de fichier et spécifiez les filtres suivants :

Paramètre Description du champ Chemin d’accès au dossier Filtre les données pour ingérer des fichiers avec un chemin d’accès de dossier spécifique. Extension de fichier Filtre les données pour ingérer des fichiers avec une extension de fichier spécifique uniquement. Dans la section Paramètres de flux d'événements, vous pouvez sélectionner les événements à surveiller dans les paramètres avancés>types d’événements. Par défaut, le blob créé est sélectionné. Vous pouvez également sélectionner Blob renommé.

Sélectionnez Suivant pour afficher un aperçu des données.

Inspecter

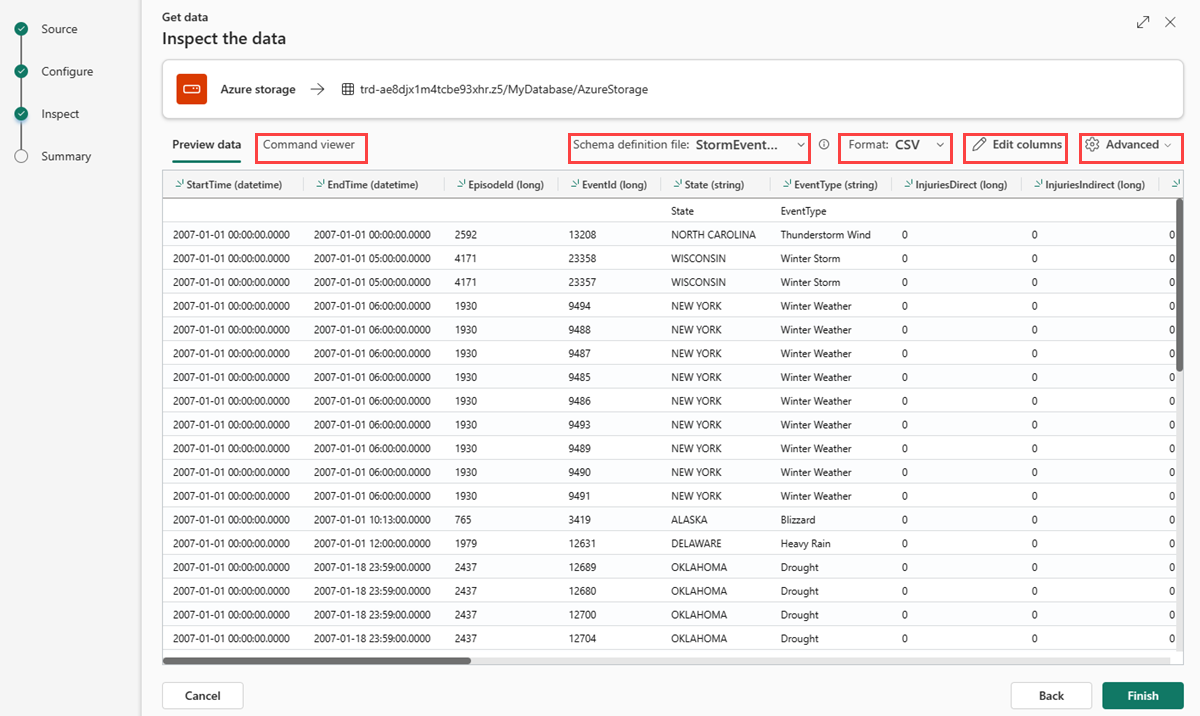

L’onglet Inspecter s’ouvre avec un aperçu des données.

Pour terminer le processus d’ingestion, sélectionnez Terminer.

Remarque

Pour activer l'ingestion continue de données et l'aperçu des données, assurez-vous de charger un nouveau blob de stockage après la configuration.

Optionnellement:

Utilisez la liste déroulante du fichier de définition de schéma pour modifier le fichier à partir duquel le schéma est déduit.

Utilisez la liste déroulante type de fichier pour explorer les options avancées en fonction du type de données.

Utilisez la liste déroulante Table_mapping pour définir un nouveau mappage.

Sélectionnez </> pour ouvrir la visionneuse de commandes pour afficher et copier les commandes automatiques générées à partir de vos entrées. Vous pouvez également ouvrir les commandes dans un ensemble de requêtes

Sélectionnez l’icône de crayon pour modifier les colonnes.

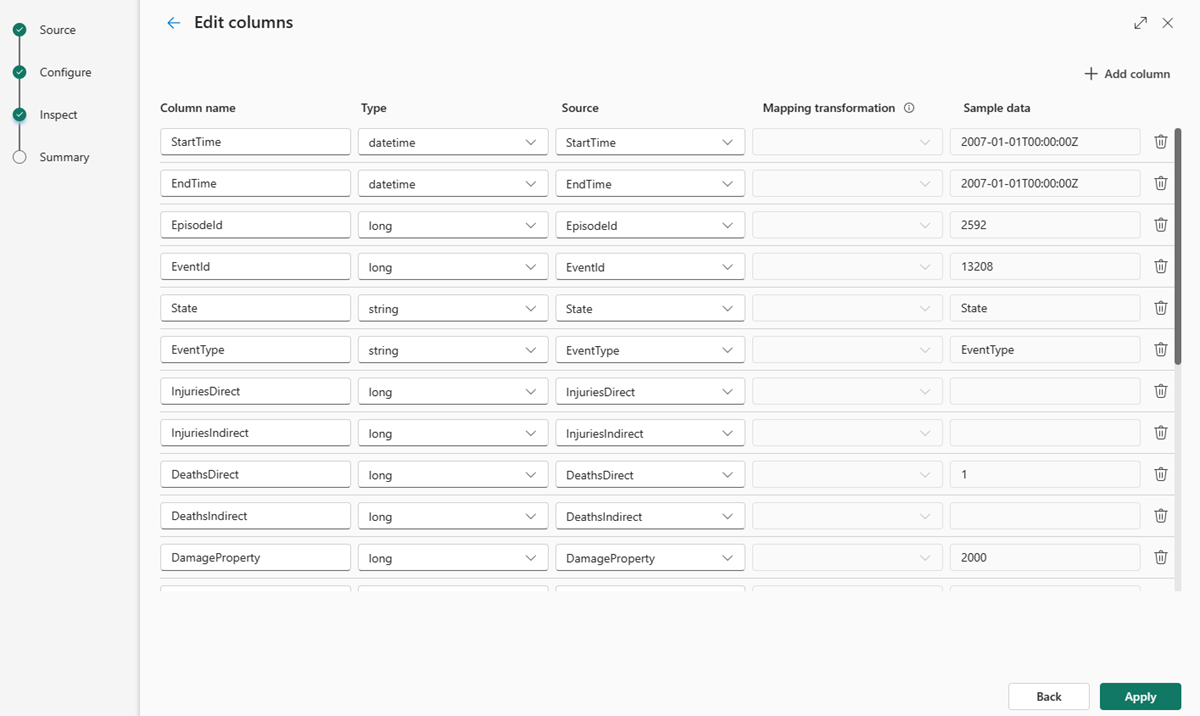

Modifier les colonnes

Remarque

- Pour les formats tabulaires (CSV, TSV, PSV), vous ne pouvez pas mapper une colonne deux fois. Pour mapper à une colonne existante, commencez par supprimer la nouvelle colonne.

- Vous ne pouvez pas modifier un type de colonne existant. Si vous essayez de mapper à une colonne avec un format différent, vous risquez de vous retrouver avec des colonnes vides.

Les modifications que vous pouvez apporter dans une table dépendent des paramètres suivants :

- Le type de la table est nouveau ou existant

- Si le type du mappage est nouveau ou existant

| Type de la table | Type de mappage | Ajustements disponibles |

|---|---|---|

| Nouvelle table | Nouveau mappage | Renommer une colonne, modifier le type de données, modifier la source de données, transformation de mappage, ajouter une colonne, supprimer une colonne |

| Table existante | Nouveau mappage | Ajouter une colonne (sur laquelle vous pouvez ensuite modifier le type de données, renommer et mettre à jour) |

| Table existante | Cartographie existante | aucun |

Transformations de cartographie

Certains mappages de format de données (Parquet, JSON et Avro) permettent des transformations simples lors de l'ingestion. Pour appliquer des transformations de mappage, créez ou mettez à jour une colonne dans la fenêtre Modifier les colonnes.

Les transformations de mappage peuvent être effectuées sur une colonne de type chaîne ou datetime, avec la source ayant un type de données int ou long. Pour plus d’informations, consultez la liste complète des transformations de mappage prises en charge.

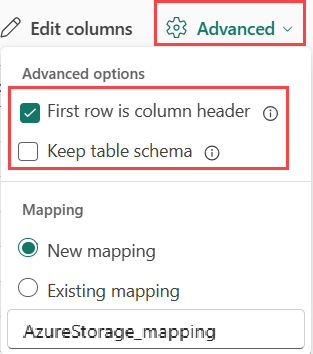

Options avancées basées sur le type de données

Tabulaire (CSV, TSV, PSV) :

Si vous ingérez des formats tabulaires dans une table existante, vous pouvez sélectionner Avancé>Conserver le schéma de table. Les données tabulaires n’incluent pas nécessairement les noms de colonnes utilisés pour mapper les données sources aux colonnes existantes. Lorsque cette option est cochée, le mappage est effectué par ordre et le schéma de table reste le même. Si cette option n’est pas cochée, de nouvelles colonnes sont créées pour les données entrantes, quelle que soit la structure des données.

Les données tabulaires n’incluent pas nécessairement les noms de colonnes utilisés pour mapper les données sources aux colonnes existantes. Pour utiliser la première ligne comme noms de colonnes, sélectionnez La première ligne est l’en-tête de colonne.

Tabulaire (CSV, TSV, PSV) :

Si vous ingestionnez des formats tabulaires dans une table existante, vous pouvez sélectionner Table_mapping>Utiliser un schéma existant. Les données tabulaires n’incluent pas nécessairement les noms de colonnes utilisés pour mapper les données sources aux colonnes existantes. Lorsque cette option est cochée, le mappage est effectué par ordre et le schéma de table reste le même. Si cette option n’est pas cochée, de nouvelles colonnes sont créées pour les données entrantes, quelle que soit la structure des données.

Pour utiliser la première ligne en tant que noms de colonnes, sélectionnez Premier en-tête de ligne.

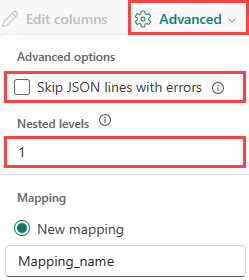

JSON :

Pour déterminer la division de colonnes des données JSON, sélectionnez niveaux imbriqués, de 1 à 100.

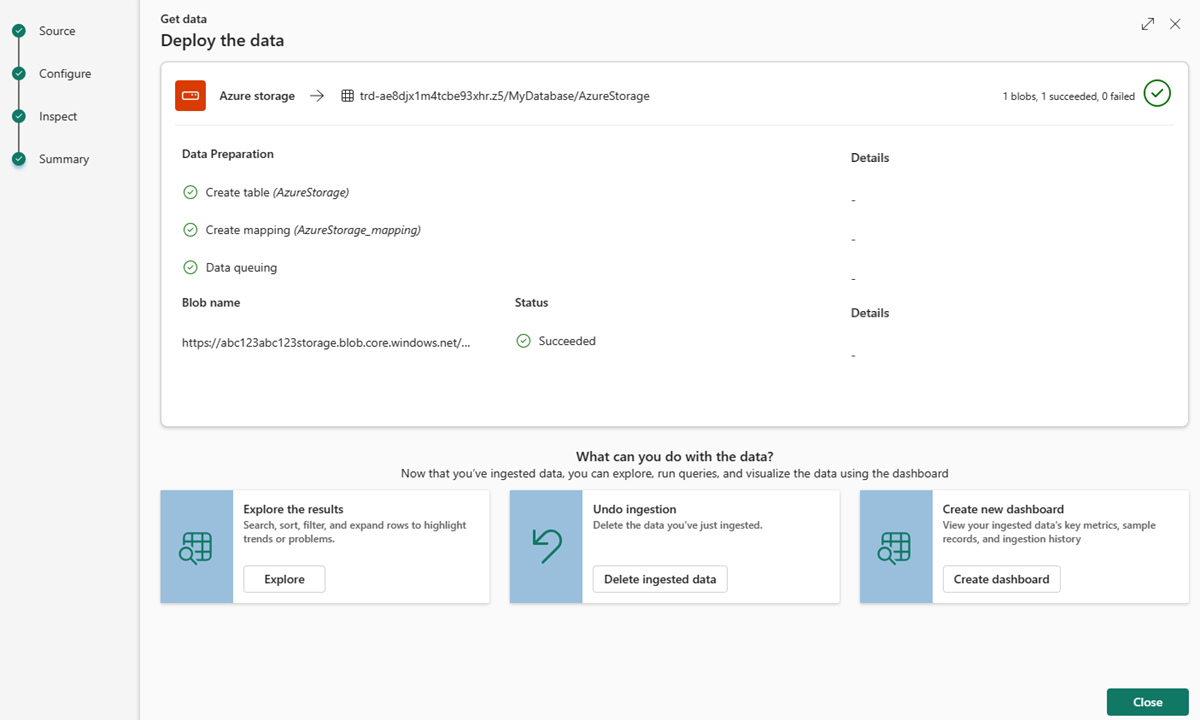

Résumé

Dans la fenêtre Résumé , toutes les étapes sont marquées avec des coches vertes lorsque l’ingestion des données se termine correctement. Vous pouvez sélectionner une carte pour explorer les données, supprimer les données ingérées ou créer un tableau de bord avec des métriques clés.

Lorsque vous fermez la fenêtre, vous pouvez voir la connexion sous l’onglet Explorateur, sous Flux de données. À partir de là, vous pouvez filtrer les flux de données et supprimer un flux de données.

Contenu connexe

- Pour gérer votre base de données, consultez Gérer les données

- Pour créer, stocker et exporter des requêtes, consultez Données de requête dans un ensemble de requêtes KQL