Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

L’utilisation de dataflows avec Microsoft Power Platform facilite la préparation des données et vous permet de réutiliser votre travail de préparation des données dans les rapports, applications et modèles suivants.

Dans le monde des données toujours en expansion, la préparation des données peut être difficile et coûteuse. Il peut consommer jusqu’à 60 à 80 % du temps et du coût d’un projet d’analytique classique. Ces projets peuvent nécessiter des données fragmentées et incomplètes, une intégration complexe du système, des données avec incohérence structurelle et une barrière de jeu de compétences élevée.

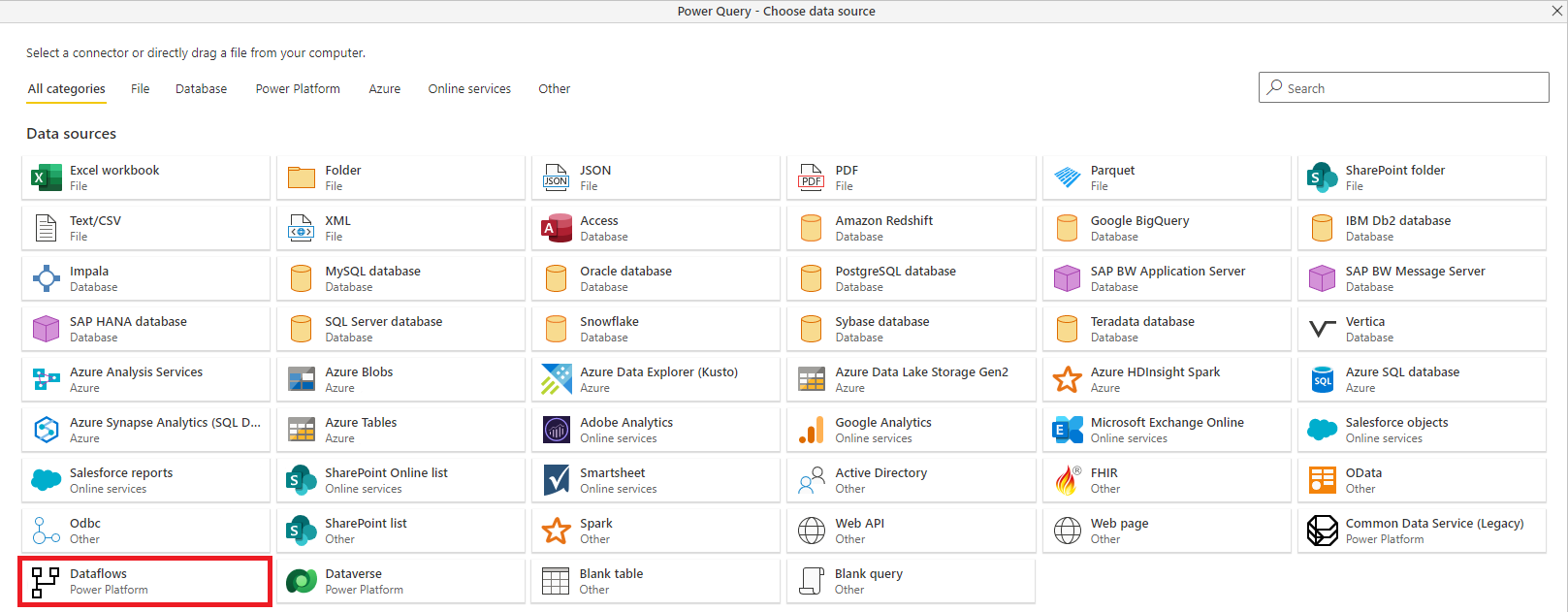

Pour faciliter la préparation des données et vous aider à tirer davantage de valeur de vos données, Power Query et power Platform dataflows ont été créés.

Avec les dataflows, Microsoft apporte les fonctionnalités de préparation des données en libre-service de Power Query dans les services en ligne Power BI et Power Apps, et étend les fonctionnalités existantes de la manière suivante :

Préparation des données en autonomie pour le Big Data avec des dataflows: Les dataflows peuvent être utilisés pour ingérer, nettoyer, transformer, intégrer, enrichir et schématiser des données à partir d’un large éventail de sources transactionnelles et d’observation en englobant toutes les logiques de préparation des données. Auparavant, la logique d’extraction, de transformation, de chargement (ETL) ne pouvait être incluse que dans les modèles sémantiques de Power BI, copiées entre des modèles sémantiques et liées aux paramètres de gestion des modèles sémantiques.

Avec les flux de données, la logique ETL est considérée comme un artefact de premier ordre dans les services de Microsoft Power Platform, et inclut des expériences de création et de gestion dédiées. Les analystes d’entreprise, les professionnels de la décision et les scientifiques des données peuvent utiliser des dataflows pour gérer les défis de préparation des données les plus complexes et s’appuyer sur le travail des uns des autres, grâce à un moteur de calcul révolutionnaire basé sur des modèles. Ce moteur prend en charge toute la transformation et la logique de gestion des dépendances, réduisant le temps, le coût et l'expertise à une fraction de ce qui est traditionnellement requis pour ces tâches. Vous pouvez créer des dataflows à l’aide de l’expérience de préparation des données en libre-service connue de Power Query. Les flux de données sont créés et facilement gérés dans des espaces de travail d’application ou des environnements, dans Power BI ou Power Apps, respectivement, en bénéficiant de toutes les fonctionnalités que ces services ont à offrir, telles que la gestion des autorisations et les actualisations planifiées.

charger des données vers Dataverse ou Azure Data Lake Storage: selon votre cas d’usage, vous pouvez stocker les données préparées par les dataflows Power Platform dans le dataverse ou le compte Azure Data Lake Storage de votre organisation :

Dataverse vous permet de stocker et de gérer en toute sécurité les données utilisées par les applications métier. Les données dans Dataverse sont stockées dans un ensemble de tables. Une table est un ensemble de lignes (anciennement appelées enregistrements) et de colonnes (anciennement appelées champs/attributs). Chaque colonne de la table est conçue pour stocker un certain type de données, par exemple, nom, âge, salaire, et ainsi de suite. Dataverse inclut un ensemble de tables standard qui couvrent des scénarios classiques, mais vous pouvez également créer des tables personnalisées spécifiques à votre organisation et les remplir avec des données à l’aide de dataflows. Les créateurs d’applications peuvent ensuite utiliser Power Apps et Power Automate pour créer des applications enrichies qui utilisent ces données.

azure Data Lake Storage vous permet de collaborer avec des personnes de votre organisation à l’aide de services Power BI, Azure Data et IA, ou d’utiliser des applications métier personnalisées qui lisent des données à partir du lac. Les dataflows qui chargent des données dans un compte Azure Data Lake Storage stockent les données dans les dossiers Common Data Model. Les dossiers Common Data Model contiennent des données et des métadonnées schématisées dans un format standardisé, afin de faciliter l’échange de données et d’activer l’interopérabilité complète entre les services qui produisent ou consomment des données stockées dans le compte Azure Data Lake Storage d’une organisation en tant que couche de stockage partagée.

Advanced Analytics et l’IA avec Azure: les dataflows Power Platform stockent des données dans Dataverse ou Azure Data Lake Storage, ce qui signifie que les données ingérées via des dataflows sont désormais disponibles pour les ingénieurs de données et les scientifiques des données afin d’appliquer la puissance complète d’Azure Data Services, comme Azure Machine Learning, Azure Databricks et Azure Synapse Analytics pour l’analytique avancée et l’IA. Cette disponibilité permet aux analystes d’entreprise, aux ingénieurs données et aux scientifiques des données de collaborer sur les mêmes données au sein de leur organisation.

Prise en charge de Common Data Model: Common Data Model est un ensemble de schémas de données standardisés et d’un système de métadonnées pour permettre la cohérence des données et leur signification entre les applications et les processus métier. Les dataflows prennent en charge le Common Data Model en offrant un mappage facile à partir de toutes les données, quelle que soit leur forme, vers les tables standard du Common Data Model, telles que Compte et Contact. Les flux de données intègrent également les données, à partir des tables standard et personnalisées, sous forme de modèle commun de données schématisé. Les analystes métier peuvent tirer parti du schéma standard et de sa cohérence sémantique, ou personnaliser leurs tables en fonction de leurs besoins uniques. Common Data Model continue d’évoluer dans le cadre de l’initiative Open Data .

Fonctionnalités de dataflow dans les services Microsoft Power Platform

La plupart des fonctionnalités de flux de données sont disponibles dans Power Apps et Power BI. Les flux de données sont disponibles dans le cadre des plans de ces services. Certaines fonctionnalités de dataflow sont spécifiques au produit ou disponibles dans différents plans de produit. Le tableau suivant décrit les fonctionnalités de dataflow et leur disponibilité.

| Fonctionnalité de flux de données | PowerApps | Power BI |

|---|---|---|

| Actualisation planifiée | Jusqu’à 48 par jour | Jusqu’à 48 par jour |

| Durée maximale d’actualisation par table | Jusqu’à 2 heures | Jusqu’à 2 heures |

| Création de flux de données avec Power Query Online | Oui | Oui |

| Gestion des flux de données | Dans le portail d’administration Power Apps | Dans le portail d’administration Power BI |

| Nouveaux connecteurs | Oui | Oui |

| Schéma standardisé/Prise en charge intégrée pour le Common Data Model | Oui | Oui |

| Connecteur de flux de données dans Power BI Desktop | Pour les flux de données avec Azure Data Lake Storage comme destination | Oui |

| Intégration à Azure Data Lake Storage de l’organisation | Oui | Oui |

| Intégration à Dataverse | Oui | Non |

| Tables liées au flux de données | Pour les flux de données avec Azure Data Lake Storage comme destination | Oui |

| Tables calculées (transformations dans le stockage à l’aide de M) | Pour les flux de données avec Azure Data Lake Storage comme destination | Power BI Premium uniquement |

| Actualisation incrémentielle du flux de données | Pour les flux de données avec Azure Data Lake Storage comme destination, nécessite Power Apps Plan2 | Power BI Premium uniquement |

| Exécution sur la capacité Power BI Premium / exécution parallèle des transformations | Non | Oui |

Limitations connues

- La copie de flux de données dans le cadre d’une opération de sauvegarde et de restauration des environnements n’est pas prise en charge.

- La copie de dataflows dans le cadre d’une opération de copie d’environnements Power Platform ne conserve pas son paramètre de notification par e-mail.

- Modifier le propriétaire d’un dataflow avec une connexion et un paramètre de requête modifie également la valeur du paramètre par une valeur précédente (si cette valeur a été définie).

Étapes suivantes

Pour plus d’informations sur les flux de données dans Power Apps :

- Préparation des données libre-service dans PowerApps

- Création et utilisation de dataflows dans Power Apps

- Connecter Azure Data Lake Storage Gen2 pour le stockage de flux de données

- Ajouter des données à une table dans Dataverse à l’aide de Power Query

- Visitez la communauté de flux de données Power Apps et partagez ce que vous faites, posez des questions ou envoyez de nouvelles idées

- Accédez au forum de la communauté Flux de données PowerApps pour partager votre travail, poser des questions ou soumettre de nouvelles idées

Pour plus d’informations sur les flux de données dans Power BI :

- Préparation des données en libre-service dans Power BI

- Créer et utiliser des dataflows dans Power BI

- Livre blanc sur les flux de données

- Vidéo détaillée d'une présentation de flux de données

- Accédez à la communauté Flux de données Power BI pour partager votre travail, poser des questions ou soumettre de nouvelles idées

Les articles suivants décrivent plus en détail les scénarios d’utilisation courants pour les flux de données.

- Utilisation de l’actualisation incrémentielle avec des flux de données

- Création de tables calculées dans des flux de données

- Se connecter à des sources de données pour les flux de données

- Lier des tables entre des dataflows

Pour plus d’informations sur Common Data Model et la norme de dossier Common Data Model, consultez les articles suivants :